Parece que um novo e impressionante modelo de IA é lançado quase toda semana. Para as empresas que tentam descobrir como realmente usar essa tecnologia, é muita coisa para acompanhar. Todo o setor é praticamente dominado por três grandes players no momento: OpenAI, Anthropic e Google. Se você está a pensar em incorporar IA na sua empresa, especialmente para algo tão importante como o apoio ao cliente, escolher a API certa é uma decisão crucial.

Este guia está aqui para ajudá-lo a filtrar o ruído. Vamos comparar estas plataformas com base no que realmente importa para uma empresa: o quão bem funcionam, quanto custam e a dor de cabeça que é configurá-las. Analisaremos o que estes modelos brutos podem fazer por si só e, em seguida, falaremos sobre uma forma mais prática de colocar a IA a trabalhar para si.

Uma visão geral das principais APIs de modelos de IA

Primeiro, vamos esclarecer rapidamente do que estamos a falar. Uma API (Interface de Programação de Aplicações) é basicamente uma ponte que permite aos programadores conectar o seu próprio software a estes poderosos modelos de IA. Portanto, quando se compara a API da OpenAI vs. a API da Anthropic vs. a API Gemini, está-se a olhar para os motores que alimentam milhares de ferramentas de IA diferentes.

O que é a API da OpenAI?

Se já usou o ChatGPT ou viu um programador a elogiar o GitHub Copilot, já viu o trabalho da OpenAI. Eles foram os primeiros a realmente captar a atenção do público, e a sua Plataforma de API é a mais estabelecida e amplamente utilizada. Os seus modelos GPT, como o GPT-4.1 e o GPT-4o, são conhecidos por serem excelentes em tudo, sólidos em raciocínio, programação e conversação geral. Como estão no mercado há mais tempo, existe uma enorme comunidade de programadores, o que significa que pode encontrar um tutorial para praticamente qualquer coisa.

Ativo 1: [Captura de ecrã], O painel da Plataforma de API da OpenAI, mostrando diferentes modelos como GPT-4.1 e GPT-4o.

Título alt: Uma visão geral da plataforma de API da OpenAI vs API da Anthropic vs API Gemini da OpenAI.

Texto alt: Uma captura de ecrã do painel da API da OpenAI, um componente chave na comparação entre a API da OpenAI vs a API da Anthropic vs a API Gemini.

O que é a API da Anthropic?

A Anthropic foi fundada por ex-investigadores da OpenAI que queriam construir IA com a segurança como principal prioridade. Os seus modelos são todos chamados Claude, com o Claude 4 Opus e o Sonnet a serem os mais potentes atualmente. A API da Anthropic tornou-se popular entre as grandes empresas por algumas boas razões: é excelente a assimilar e a refletir sobre documentos longos, foi projetada para ser mais fiável e menos propensa a inventar factos, e as suas funcionalidades de segurança integradas tornam-na uma aposta segura para empresas em setores regulamentados.

Ativo 2: [Captura de ecrã], A página de documentação da API da Anthropic, destacando a família de modelos Claude (Opus, Sonnet).

Título alt: Uma análise da API da Anthropic no debate entre a API da OpenAI vs API da Anthropic vs API Gemini.

Texto alt: A página inicial da API da Anthropic, mostrando os seus modelos como parte do cenário de comparação entre a API da OpenAI vs a API da Anthropic vs a API Gemini.

O que é a API Google Gemini?

A Gemini é a entrada da Google na corrida da IA, e foi construída desde o início para ser "nativamente multimodal". Tudo o que isso significa é que a API Google Gemini não se trata apenas de texto; foi projetada para entender imagens, vídeo e áudio sem esforço. Possui uma janela de contexto massiva (já lá vamos) e está firmemente integrada noutros produtos da Google, como o Google Cloud e o Workspace. É um concorrente muito forte para empresas que já usam as ferramentas da Google ou para aquelas que querem construir algo que vá além das palavras.

Ativo 3: [Captura de ecrã], A página da API Google Gemini, exibindo as suas capacidades multimodais com exemplos de entradas de texto, imagem e áudio.

Título alt: A explorar a API Google Gemini na comparação entre a API da OpenAI vs a API da Anthropic vs a API Gemini.

Texto alt: A página inicial da API Google Gemini, ilustrando as suas funcionalidades multimodais para a discussão sobre a API da OpenAI vs a API da Anthropic vs a API Gemini.

Comparando capacidades e desempenho principais

Ok, chega de definições. Vamos ver como estas APIs se comparam nas funcionalidades que realmente importam para o seu projeto.

Porque é que uma janela de contexto maior nem sempre é melhor

Vai ouvir muito o termo "janela de contexto". É apenas o termo técnico para a quantidade de informação que um modelo pode reter na sua memória de curto prazo durante uma única conversa. É medido em "tokens", onde cerca de 1.000 tokens equivalem a 750 palavras.

Tanto o Google Gemini como os modelos mais recentes da OpenAI afirmam ter janelas de contexto enormes de mais de 1.000.000 de tokens. Parece incrível, certo? Poderia alimentá-los com um livro inteiro. Mas há um senão. O desempenho do modelo nem sempre é estável ao longo de toda essa janela. Testes mostraram que a precisão pode cair a pique quando se está a forçar os limites superiores. É um pouco como tentar ouvir numa sala cheia de gente: quanto mais tenta absorver de uma vez, mais difícil é focar-se no que é importante.

O Claude da Anthropic faz as coisas de forma um pouco diferente. Oferece uma janela de 200.000 tokens, o que ainda é massivo e pode facilmente lidar com um documento de 150.000 palavras. A KEY é que o seu desempenho é notavelmente consistente do início ao fim. Para a maioria das necessidades empresariais, como analisar uma longa conversa de suporte ou um contrato legal, esse tipo de fiabilidade é muito mais útil do que uma janela de contexto recordista, mas por vezes instável.

Ativo 4: [Infográfico], Uma comparação visual das janelas de contexto para OpenAI, Anthropic e Gemini. Deve mostrar três barras: Gemini (1M+ tokens), OpenAI (1M+ tokens) e Anthropic (200k tokens). Adicionar um medidor de "Fiabilidade" abaixo de cada barra, com o medidor da Anthropic cheio, e os outros ligeiramente mais baixos para ilustrar o ponto sobre o desempenho consistente.

Título alt: Fiabilidade da janela de contexto no confronto entre API da OpenAI vs API da Anthropic vs API Gemini.

Texto alt: Um infográfico a comparar as janelas de contexto da OpenAI, Anthropic e Gemini, destacando os compromissos entre tamanho e fiabilidade na comparação entre API da OpenAI vs API da Anthropic vs API Gemini.

Lidar com mais do que apenas texto

Multimodalidade significa simplesmente a capacidade de processar diferentes tipos de informação, não apenas texto. É aqui que o Gemini da Google realmente se destaca. Foi construído para lidar com imagens, áudio e até vídeo. Imagine uma situação de apoio ao cliente onde alguém pudesse simplesmente enviar uma foto de um produto avariado ou um vídeo rápido de um código de erro. O Gemini foi projetado exatamente para isso.

O GPT-4o da OpenAI também se tornou muito bom nesta área e consegue lidar com imagens e áudio bastante bem. A Anthropic, embora esteja a melhorar, historicamente focou-se mais em aperfeiçoar o raciocínio baseado em texto, por isso não costuma ser a primeira escolha para tarefas altamente visuais ou dependentes de áudio.

Chamada de função: Fazer a IA comunicar com os seus sistemas

Esta é provavelmente a funcionalidade mais importante para qualquer uso empresarial no mundo real. A "chamada de função" ou "uso de ferramentas" é o que permite que uma IA realmente faça coisas em vez de apenas falar. É como uma IA pode verificar o estado de uma encomenda no Shopify, atualizar um ticket no Zendesk, ou obter o histórico de pagamentos de um cliente da sua base de dados.

As três APIs podem fazer isto, mas cada uma tem o seu próprio estilo. A OpenAI é ótima a lidar com vários pedidos de uma vez, o que a torna rápida. O Claude é melhor a trabalhar em tarefas de múltiplos passos, um a um, e é particularmente bom a explicar o seu processo de pensamento, o que é útil para a resolução de problemas.

O problema? Configurar isto por conta própria é um grande projeto de engenharia. Tem de definir cada ferramenta, gerir a comunicação de ida e volta, tratar de erros e devolver os resultados ao modelo corretamente. Isto é um trabalho enorme, e é por isso que muitas equipas usam plataformas como a eesel AI que lidam com toda essa complexidade por si através de um construtor de fluxos de trabalho simples.

Ativo 5: [Fluxo de trabalho], Um gráfico mermaid a ilustrar o conceito de chamada de função.

Título alt: Chamada de função explicada no contexto da API da OpenAI vs API da Anthropic vs API Gemini.

Texto alt: Um diagrama de fluxo de trabalho a mostrar como uma IA usa a chamada de função para obter o estado de uma encomenda, uma funcionalidade chave na comparação entre API da OpenAI vs API da Anthropic vs API Gemini para uso empresarial.

A realidade empresarial: Preços e implementação

Ok, agora vamos às duas perguntas que todo o líder empresarial realmente quer saber: "Quanto vai custar?" e "Quão difícil é colocar a funcionar?"

Uma análise detalhada dos preços

Todas as três plataformas cobram com base no número de tokens que utiliza. Paga pelos dados que envia para o modelo (input) e pelos dados que ele gera (output). Parece simples, mas pode tornar a sua fatura mensal muito imprevisível. Um mês movimentado para a sua equipa de suporte pode levar a uma fatura surpreendentemente alta.

Aqui está uma ideia aproximada de como os preços se comparam para os seus modelos mais populares. Estes números mudam, mas as diferenças gerais de custo geralmente permanecem as mesmas.

| Fornecedor | Modelo | Preço de Input (por 1M de tokens) | Preço de Output (por 1M de tokens) | Ideal para |

|---|---|---|---|---|

| OpenAI | GPT-4.1 | $2.00 | $8.00 | Tarefas gerais de alto desempenho |

| GPT-4.1 mini | $0.40 | $1.60 | Equilíbrio entre desempenho e custo | |

| GPT-4.1 nano | $0.10 | $0.40 | Tarefas de alto volume e baixa latência | |

| Anthropic | Claude 4 Opus | $15.00 | $75.00 | Raciocínio complexo, programação |

| Claude 4 Sonnet | $3.00 | $15.00 | Tarefas empresariais equilibradas | |

| Claude 3 Haiku | $0.25 | $1.25 | Tarefas rápidas e de alto volume | |

| Gemini 2.5 Pro | $1.25 | $10.00 | Multimodal avançado, contexto longo | |

| Gemini 2.5 Flash | $0.15 | $0.60 | Tarefas rápidas e económicas |

Preços precisos no final de 2024, com base em dados publicamente disponíveis.

Configuração inicial: O desafio da implementação

Quando se trata de recursos para programadores, a OpenAI tem uma vantagem com imensa documentação e fóruns da comunidade. Se a sua empresa já utiliza o Google Cloud, então conectar-se ao Gemini será natural. A Anthropic está a recuperar terreno rapidamente com uma documentação excelente e clara para a sua API.

Mas aqui está o choque de realidade: para uma equipa de suporte que apenas quer automatizar parte do seu trabalho, nenhuma destas opções é simples. Integrar diretamente com uma API significa que precisa de programadores. Precisa de pessoas para escrever o código, gerir os servidores, ajustar os prompts e garantir que nada falha. É um investimento sério e contínuo de tempo e dinheiro.

A escolha mais inteligente: Porque precisa de uma plataforma

Depois de tudo isto, talvez esteja a perceber que debater os pormenores da API da OpenAI vs. API da Anthropic vs. API Gemini é fazer a pergunta errada. O verdadeiro desafio não é apenas escolher um modelo; é transformar esse modelo numa ferramenta que realmente ajude o seu negócio.

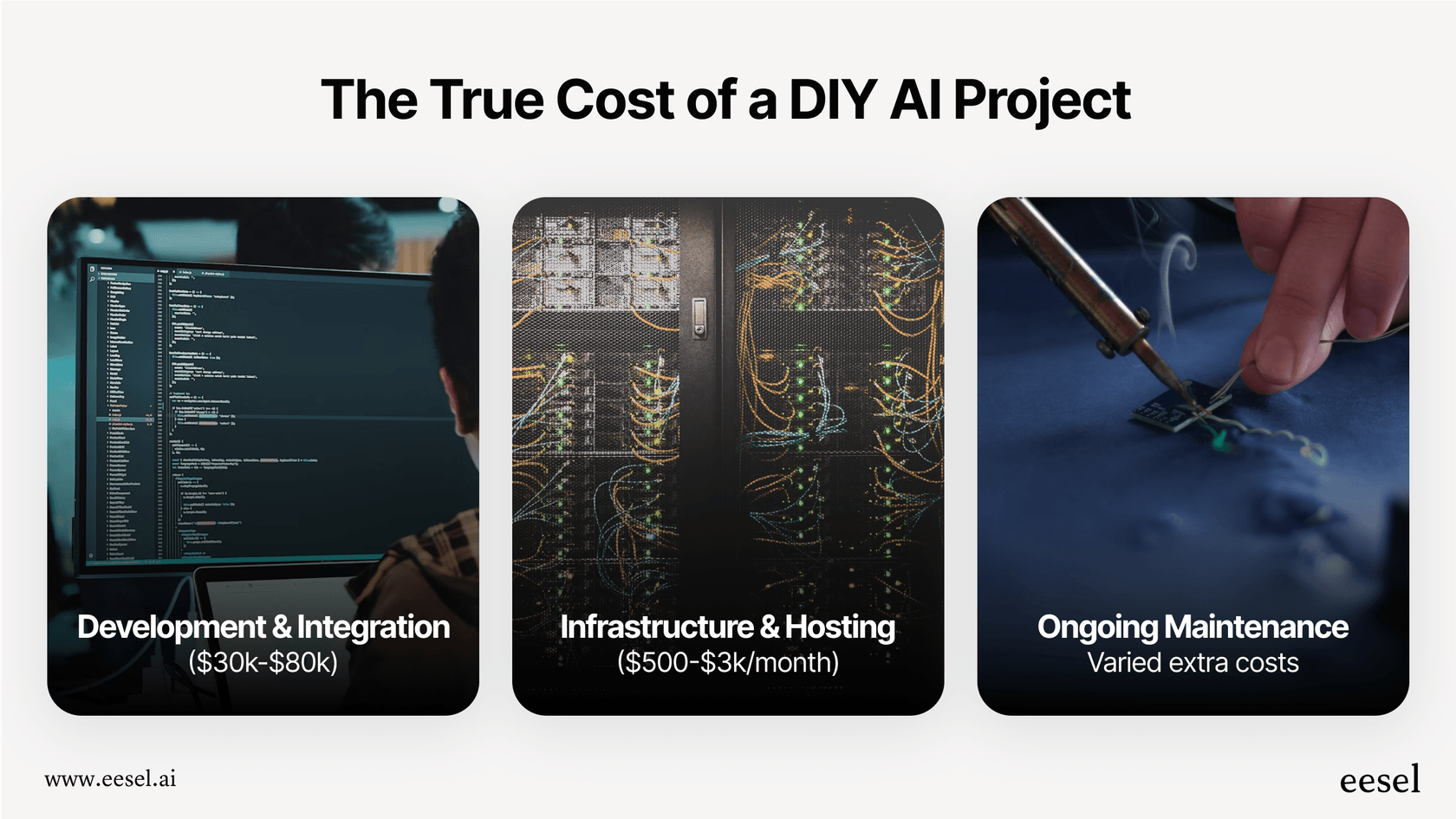

Os custos ocultos de construir por conta própria

A abordagem 'faça você mesmo' parece ótima na teoria, mas está repleta de trabalho e riscos ocultos:

-

Tempo e pessoas: Construir um agente de IA sólido para o seu help desk não é algo que se faz num fim de semana. Pode facilmente levar meses a alguns engenheiros para construir, testar e implementar algo fiável.

-

Muita complexidade: De repente, você é responsável por tudo. Descobrir os prompts certos, sincronizar conhecimento de diferentes locais, construir fluxos de trabalho, projetar uma interface e acompanhar os resultados, tudo fica a seu cargo.

-

Uma aposta arriscada: Como é que sabe se a sua solução personalizada vai funcionar bem? É difícil testá-la em cenários do mundo real antes de a disponibilizar aos seus clientes. Essencialmente, está a construir às cegas.

-

Ficar preso: Se construir todo o seu sistema em torno de uma API, fica preso a ela. O que acontece quando um concorrente lança um modelo melhor ou mais barato? Mudar pode dar quase tanto trabalho como começar do zero.

Como a eesel AI simplifica tudo

Este é exatamente o problema que uma plataforma como a eesel AI foi criada para resolver. Dá-lhe o poder destes modelos de IA sem a enorme dor de cabeça de engenharia.

-

Comece em minutos, não em meses: Não precisa de lidar com longos projetos de desenvolvimento. A eesel AI tem integrações de um clique com help desks como Zendesk e Freshdesk. Pode configurar tudo por conta própria, sem precisar de falar com um vendedor.

-

Controlo total, sem necessidade de código: Obtém a flexibilidade de uma ferramenta personalizada, mas através de uma interface simples. Pode usar o editor de prompts para moldar a personalidade da sua IA, construir fluxos de trabalho personalizados e conectar-se às suas ferramentas com Ações de IA, tudo sem um programador.

-

Teste com confiança: Isto é muito importante. O modo de simulação na eesel AI permite-lhe testar a sua configuração em milhares dos seus próprios tickets de suporte passados. Pode ver exatamente como teria respondido, obter uma previsão da sua taxa de automação e ajustar o seu desempenho antes de falar com um cliente. Elimina todas as incertezas do processo.

-

Preços previsíveis: Em vez da montanha-russa da faturação baseada em tokens, a eesel AI tem planos transparentes. Sabe exatamente o que está a pagar a cada mês, e não há taxas por resolução que o cobram mais por ser bem-sucedido.

Ativo 6: [Captura de ecrã], A plataforma eesel AI mostrando a página de integração de um clique com os logótipos do Zendesk e Freshdesk visíveis.

Título alt: Uma abordagem de plataforma vs. uso direto da API da OpenAI vs API da Anthropic vs API Gemini.

Texto alt: Uma captura de ecrã da página de integrações da eesel AI, demonstrando uma alternativa mais simples ao uso direto da API da OpenAI vs API da Anthropic vs API Gemini.

Foque-se na solução, não na ferramenta

Embora a OpenAI, a Anthropic e a Gemini ofereçam tecnologias incríveis, é isso que elas são: tecnologia. Para a maioria das empresas, ficar preso numa comparação técnica das suas APIs é uma distração do objetivo real.

Se quer resolver os problemas dos clientes mais rapidamente e aliviar a pressão sobre a sua equipa de suporte, a melhor pergunta é como fazer isso com o mínimo de tempo, risco e custo. Uma plataforma de IA lida com a complexidade de escolher e gerir modelos para que se possa focar naquilo em que é bom: desenhar excelentes fluxos de trabalho de suporte e cuidar dos seus clientes.

Pronto para ver como uma plataforma de IA pode ajudar a sua equipa de suporte sem a sobrecarga de engenharia? Configure o seu primeiro agente de IA com a eesel AI em minutos.

Perguntas frequentes

O fator mais crucial não é apenas o desempenho bruto do modelo, mas sim a implementação prática e a fiabilidade. Considere a facilidade com que pode integrar a API, gerir o desenvolvimento contínuo e alcançar resultados consistentes e precisos para os seus fluxos de trabalho empresariais específicos e interações com os clientes.

As três plataformas usam um modelo de preços baseado em tokens, cobrando tanto pelo input como pelo output, o que pode tornar os custos mensais imprevisíveis. A OpenAI oferece taxas geralmente competitivas, o Opus da Anthropic pode ser mais caro pelo seu raciocínio avançado, e o Google Gemini é competitivo, especialmente com o seu modelo económico Flash.

A implementação direta de qualquer uma destas APIs para tarefas empresariais complexas, como automatizar um balcão de apoio ao cliente, requer um esforço de engenharia significativo. Uma equipa pequena enfrentaria desafios substanciais para escrever código, gerir prompts, tratar de erros e integrar-se eficazmente com os sistemas existentes.

O Google Gemini foi projetado para multimodalidade nativa, destacando-se na compreensão de imagens, vídeo e áudio desde o início. O GPT-4o da OpenAI também se tornou muito proficiente em lidar com imagens e áudio. A Anthropic historicamente focou-se mais no raciocínio avançado baseado em texto, embora as suas capacidades multimodais estejam a melhorar.

Embora o Gemini e os modelos mais recentes da OpenAI afirmem ter janelas de contexto muito grandes, a sua precisão pode por vezes degradar-se nos limites mais altos. O Claude da Anthropic, com uma janela de 200.000 tokens, oferece um desempenho notavelmente consistente em toda a sua extensão, tornando-o altamente fiável para assimilar documentos longos sem perder o foco.

Uma plataforma como a eesel AI simplifica todo o processo, abstraindo as complexidades da integração direta de API, engenharia de prompts e gestão de infraestrutura. Isso reduz significativamente o tempo de desenvolvimento, elimina custos ocultos e permite que as empresas implementem soluções de IA robustas rapidamente e com preços previsíveis.

Compartilhe esta postagem

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.