隔週で驚くような新しいAIモデルが登場しているような感覚です。この技術を実際にどう活用するかを模索している企業にとって、そのスピードについていくのは大変なことです。現在、この分野はOpenAI、Anthropic、Googleという3つの主要プレイヤーによってほぼ独占されています。もしあなたの会社でAIの導入を考えているなら、特にカスタマーサポートのような重要な分野では、適切なAPIを選ぶことが非常に重要な決断となります。

このガイドは、そうした雑音の中から本質を見極める手助けをするためにあります。私たちは、ビジネスにとって本当に重要な要素、つまり性能、コスト、および導入の手間という観点から、これらのプラットフォームを比較していきます。まずはこれらの生のモデルが単独で何ができるかを見ていき、その後、AIをより実践的に活用する方法についてお話しします。

主要なAIモデルAPIの概要

まず、私たちが何について話しているのかを簡単に明確にしておきましょう。API(アプリケーション・プログラミング・インターフェース)は、基本的に開発者が自身のソフトウェアをこれらの強力なAIモデルに接続するための橋渡し役です。ですから、OpenAI API、Anthropic API、Gemini APIを比較するということは、何千もの異なるAIツールを動かしているエンジンを見比べているということなのです。

OpenAI APIとは?

ChatGPTを使ったことがある方や、開発者がGitHub Copilotを絶賛しているのを見たことがある方なら、OpenAIの仕事に触れたことがあるはずです。彼らは最初に世間の注目を集めた存在であり、そのAPIプラットフォームは最も確立され、広く利用されています。GPT-4.1やGPT-4oといったGPTモデルは、推論、コーディング、一般的な会話に強い、優れたオールラウンダーとして知られています。最も長く市場にいるため、開発者の巨大なコミュニティが存在し、ほとんどすべてのことについてチュートリアルを見つけることができます。

Anthropic APIとは?

Anthropicは、安全性を最優先事項としてAIを構築したいと考えていた元OpenAIの研究者たちによって設立されました。彼らのモデルはすべてClaudeという名前で、現在はClaude 4 OpusとSonnetが主力です。Anthropic APIが大手企業に人気を博しているのには、いくつかの明確な理由があります。長いドキュメントを読み解き、考察する能力に優れていること、信頼性が高く事実を捏造する可能性が低いように設計されていること、そして組み込みの安全機能により、規制の厳しい分野の企業にとって安全な選択肢となっていることです。

Google Gemini APIとは?

GeminiはGoogleがAI競争に投入したモデルであり、当初から「ネイティブなマルチモーダル」として構築されました。これは、Google Gemini APIがテキストだけでなく、画像、動画、音声を難なく理解するように設計されているということを意味します。巨大なコンテキストウィンドウ(これについては後ほど説明します)を持ち、Google CloudやWorkspaceといったGoogleの他の製品と緊密に連携しています。すでにGoogleのツールを使用している企業や、単なる言葉を超えたものを構築したい企業にとって、非常に強力な候補となります。

中核となる機能とパフォーマンスの比較

さて、定義の話はこれくらいにして、これらのAPIがあなたのプロジェクトにとって重要となる機能面で実際にどのように比較されるかを見ていきましょう。

コンテキストウィンドウは大きければ良いというわけではない理由

「コンテキストウィンドウ」という言葉をよく耳にするでしょう。これは、モデルが一度の会話中に短期記憶として保持できる情報量を指す専門用語です。「トークン」という単位で測定され、約1,000トークンが750語に相当します。

Google Gemini and the latest OpenAI models both claim massive context windows exceeding 1,000,000 tokens. これば素晴らしいことに聞こえますよね?本を丸ごと一冊読み込ませることもできるでしょう。しかし、そこには落とし穴があります。モデルのパフォーマンスは、そのウィンドウ全体で常に安定しているわけではないのです。テストでは、上限ギリギリで利用すると精度が急落する可能性があることが示されています。これは混雑した部屋で聞き耳を立てるようなもので、一度に多くの情報を取り込もうとすればするほど、重要なことに集中するのが難しくなるのです。

AnthropicのClaudeは少し異なるアプローチをとっています。200,000トークンのウィンドウを提供しており、これも依然として巨大で、150,000語のドキュメントを簡単に処理できます。重要なのは、そのパフォーマンスが最初から最後まで驚くほど一貫していることです。長いサポートスレッドや法的契約を分析するようなほとんどのビジネスニーズにとって、その種の信頼性は、記録的ではあるものの時々不安定なコンテキストウィンドウよりもはるかに有用です。

テキスト以外のデータも扱う

マルチモーダリティとは、テキストだけでなく、さまざまな種類の情報を処理する能力を意味します。この点でGoogleのGeminiは本当に際立っています。画像、音声、さらには動画を扱うために構築されました。顧客が壊れた製品の写真を送ったり、エラーコードの短い動画を送ったりできるカスタマーサポートの状況を想像してみてください。Geminiはまさにそのために設計されています。

OpenAIのGPT-4oもこの分野で非常に優れており、画像や音声をうまく処理できます。Anthropicは、改善は進んでいるものの、歴史的にテキストベースの推論を完成させることに重点を置いてきたため、視覚や音声に大きく依存するタスクの第一選択肢には通常なりません。

関数呼び出し:AIを自社システムと連携させる

これはおそらく、実際のビジネス利用において最も重要な機能です。「関数呼び出し(Function calling)」または「ツール使用(tool use)」は、AIがただ話すだけでなく、実際に実行できるようにするものです。これにより、AIはShopifyで注文状況を確認したり、Zendeskでチケットを更新したり、データベースから顧客の支払い履歴を取得したりすることができます。

3つのAPIはすべてこれを実行できますが、それぞれに独自のスタイルがあります。OpenAIは一度に複数のリクエストを処理するのが得意で、そのため高速です。Claudeは複数ステップのタスクを一つずつ処理することに優れており、特に思考プロセスを説明するのが得意なため、トラブルシューティングに役立ちます。

問題は?これを実際に自分で設定するのは、大規模なエンジニアリングプロジェクトだということです。すべてのツールを定義し、双方向の通信を処理し、エラーを管理し、結果をモデルに正しくフィードバックする必要があります。これは非常に大きな負担であり、だからこそ多くのチームは、シンプルなワークフロービルダーを通じてこの複雑さをすべて処理してくれるeesel AIのようなプラットフォームを利用するのです。

ビジネスの現実:価格と導入

さて、すべてのビジネスリーダーが本当に気にする2つの質問に移りましょう。「これにはいくらかかるのか?」そして「稼働させるのはどれくらい難しいのか?」です。

詳細な価格の内訳

3つのプラットフォームはすべて、使用したトークンの量に基づいて課金されます。モデルに送信するデータ(入力)と、モデルが生成するデータ(出力)の両方に対して料金を支払います。これは単純に聞こえますが、月々の請求額が非常に予測不能になる可能性があります。サポートチームが忙しい月には、驚くほど高額な請求書が届くかもしれません。

以下は、最も人気のあるモデルの価格を大まかに比較したものです。これらの数値は変動しますが、一般的なコスト差は通常変わりません。

| プロバイダー | モデル | 入力価格(100万トークンあたり) | 出力価格(100万トークンあたり) | 最適な用途 |

|---|---|---|---|---|

| OpenAI | GPT-4.1 | $2.00 | $8.00 | 高性能、一般的なタスク |

| GPT-4.1 mini | $0.40 | $1.60 | パフォーマンスとコストのバランス | |

| GPT-4.1 nano | $0.10 | $0.40 | 大量、低遅延のタスク | |

| Anthropic | Claude 4 Opus | $15.00 | $75.00 | 複雑な推論、コーディング |

| Claude 4 Sonnet | $3.00 | $15.00 | バランスの取れた企業向けタスク | |

| Claude 3 Haiku | $0.25 | $1.25 | 高速、大量のタスク | |

| Gemini 2.5 Pro | $1.25 | $10.00 | 高度なマルチモーダル、長いコンテキスト | |

| Gemini 2.5 Flash | $0.15 | $0.60 | 高速、コスト効率の高いタスク |

価格は2024年後半時点の公開データに基づいています。

セットアップ:導入の課題

開発者向けリソースに関しては、OpenAIが豊富なドキュメントとコミュニティフォーラムで先行しています。あなたの会社がすでにGoogle Cloudで運用しているなら、Geminiへの接続は自然に感じられるでしょう。Anthropicも、優れた明確なAPIドキュメントで急速に追いついています。

しかし、現実的な話をすると、業務の一部を自動化したいと考えているサポートチームにとって、これらはどれも簡単ではありません。APIと直接統合するということは、開発者が必要だということです。コードを書き、サーバーを管理し、プロンプトを調整し、何も壊れないように確認する人々が必要です。これは時間とお金の両面で、本格的で継続的な投資となります。

より賢い選択:プラットフォームが必要な理由

これらすべてを踏まえると、OpenAI API、Anthropic API、Gemini APIの細かい点を議論することは、問いが間違っていることに気づくかもしれません。本当の課題は単にモデルを選ぶことではなく、そのモデルを実際にビジネスの助けとなるツールに変えることなのです。

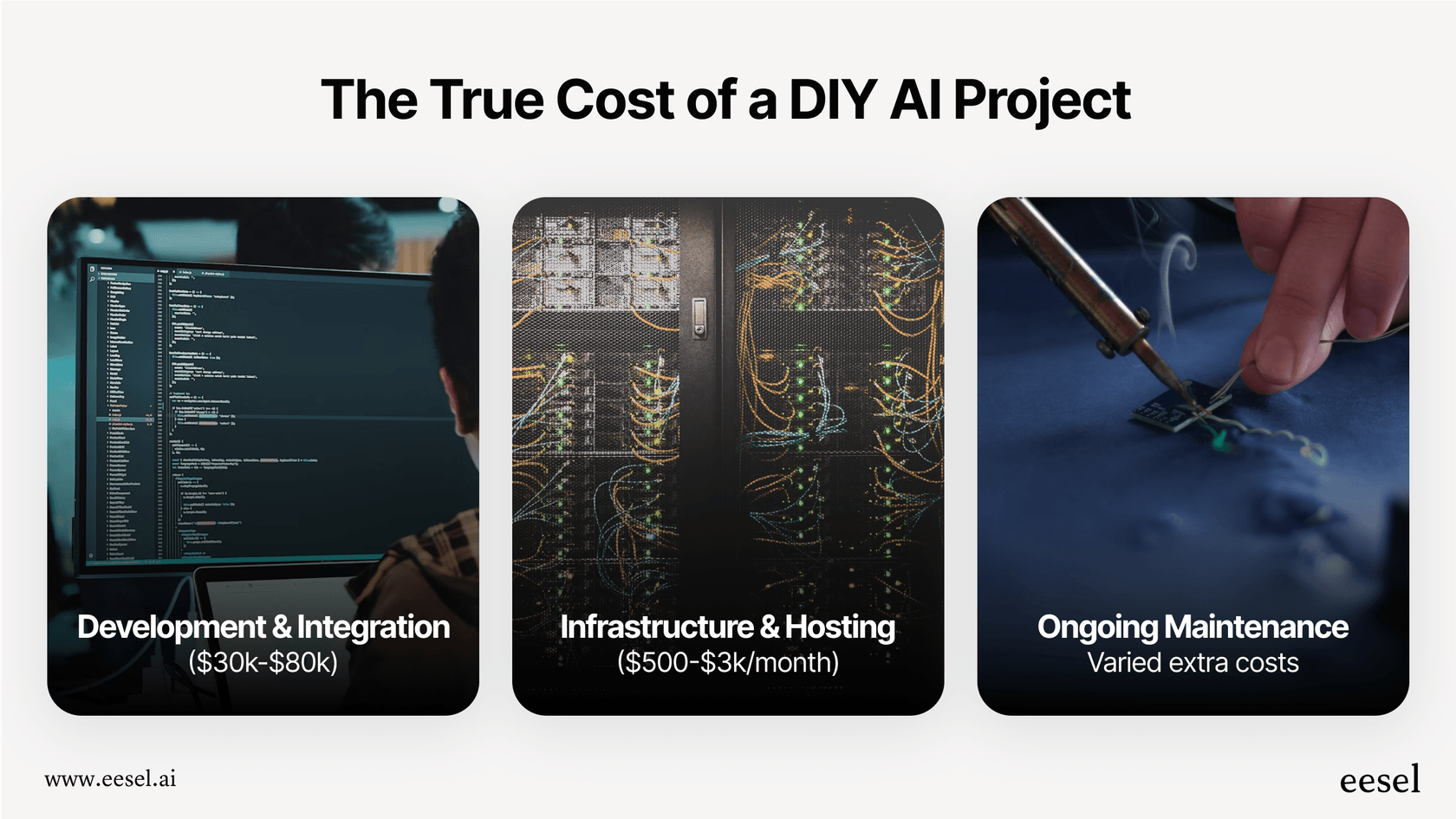

自社開発に潜む隠れたコスト

DIY(自社開発)アプローチは理論上は素晴らしい響きですが、隠れた作業とリスクに満ちています。

-

時間と人材: ヘルプデスク用の堅牢なAIエージェントを構築するのは、週末で片付くようなものではありません。信頼性の高いものを構築、テスト、展開するには、数人のエンジニアが数ヶ月を要することも珍しくありません。

-

非常に高い複雑性: 突然、すべてに責任を負うことになります。適切なプロンプトの考案、さまざまな場所からのナレッジの同期、ワークフローの構築、インターフェースの設計、結果の追跡といったすべてがあなたの肩にかかってきます。

-

リスクの高い賭け: カスタムソリューションがうまく機能するかどうか、どうやってわかるのでしょうか?顧客に公開する前に、実際のシナリオでテストするのは困難です。あなたは基本的に暗闇の中で構築しているようなものです。

-

ロックインされること: システム全体を一つのAPIを中心に構築してしまうと、そこから抜け出せなくなります。競合他社がより優れた、あるいはより安価なモデルをリリースしたらどうしますか?乗り換えることは、ほぼゼロから始めるのと同じくらいの労力がかかる可能性があります。

eesel AIがすべてをシンプルにする方法

eesel AIのようなプラットフォームは、まさにこの問題を解決するために作られました。大規模なエンジニアリングの頭痛の種なしに、これらのAIモデルの力を手に入れることができます。

-

数ヶ月ではなく数分で開始: 長期にわたる開発プロジェクトに取り組む必要はありません。eesel AIはZendeskやFreshdeskなどのヘルプデスクとワンクリックで連携できます。営業担当者と話す必要なく、すべてを自分で設定できます。

-

コード不要で完全にコントロール: カスタム構築ツールのような柔軟性を、シンプルなインターフェースを通じて手に入れることができます。プロンプトエディタを使ってAIの個性を形成し、カスタムワークフローを構築し、AIアクションでツールに接続することが、すべて開発者なしで可能です。

-

自信を持ってテスト: これは非常に重要です。eesel AIのシミュレーションモードでは、過去の何千ものサポートチケットで設定をテストできます。AIがどのように返信したか、自動化率の予測、およびパフォーマンスの調整を、実際に顧客と対話する前に行うことができます。これにより、プロセスからすべての当て推量がなくなります。

-

予測可能な価格設定: トークンベースの請求というジェットコースターのような料金体系の代わりに、eesel AIには透明性のあるプランがあります。毎月支払う金額が正確にわかり、成功するほど料金が高くなるような解決ごとの手数料はありません。

ツールではなく、ソリューションに集中する

OpenAI、Anthropic、Geminiはすべて素晴らしいテクノロジーを提供していますが、それらはあくまでテクノロジーです。ほとんどの企業にとって、APIの技術的な比較に足を取られることは、本来の目標から注意をそらすものとなります。

もし顧客の問題をより迅速に解決し、サポートチームの負担を軽減したいのであれば、より良い問いは、最小限の時間、リスク、コストでそれを実現するにはどうすればよいか、ということです。AIプラットフォームはモデルの選択と管理の複雑さを処理してくれるので、あなたは得意なこと、つまり優れたサポートワークフローの設計と顧客のケアに集中できます。

エンジニアリングのオーバーヘッドなしにAIプラットフォームがあなたのサポートチームをどのように支援できるか見てみませんか?eesel AIで最初のAIエージェントを数分でセットアップしましょう。

よくある質問

最も重要な要素は、単なるモデルの生の性能だけでなく、実践的な導入と信頼性です。APIをどれだけ簡単に統合できるか、継続的な開発を管理できるか、そして特定のビジネスワークフローや顧客とのやり取りで一貫して正確な結果を達成できるかを考慮してください。

3つのプラットフォームはすべてトークンベースの価格モデルを採用しており、入力と出力の両方に課金されるため、月々のコストは予測不能になる可能性があります。OpenAIは一般的に競争力のある料金を提供しており、AnthropicのOpusはその高度な推論能力のために高価になることがあり、Google Geminiは特にコスト効率の良いFlashモデルで競争力があります。

これらのAPIをカスタマーサポートデスクの自動化のような複雑なビジネスタスクに直接導入するには、かなりのエンジニアリング労力が必要です。小規模なチームでは、コードの記述、プロンプトの管理、エラー処理、既存システムとの効果的な統合において、相当な課題に直面するでしょう。

Google Geminiはネイティブなマルチモーダル対応として設計されており、当初から画像、動画、音声の理解に優れています。OpenAIのGPT-4oも画像と音声の扱いに非常に習熟しています。Anthropicは、マルチモーダル機能が向上しているものの、歴史的には高度なテキストベースの推論に重点を置いてきました。

Geminiや新しいOpenAIモデルは非常に大きなコンテキストウィンドウを謳っていますが、その上限では精度が低下することがあります。一方、AnthropicのClaudeは200,000トークンのウィンドウで、その全範囲にわたって驚くほど一貫したパフォーマンスを提供するため、集中力を失うことなく長いドキュメントを読み解く上で非常に信頼性が高いです。

eesel AIのようなプラットフォームは、直接のAPI統合、プロンプトエンジニアリング、インフラ管理といった複雑さを抽象化し、プロセス全体を簡素化します。これにより、開発時間が大幅に短縮され、隠れたコストが排除され、企業は堅牢なAIソリューションを迅速に、予測可能な価格で展開できるようになります。

この記事を共有

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.