Parece que cada dos por tres sale un nuevo y alucinante modelo de IA. Para las empresas que intentan averiguar cómo utilizar realmente esta tecnología, es mucho con lo que hay que mantenerse al día. Actualmente, todo el sector está prácticamente dominado por tres grandes actores: OpenAI, Anthropic y Google. Si estás pensando en incorporar la IA en tu empresa, especialmente para algo tan importante como la atención al cliente, elegir la API adecuada es una decisión crucial.

Esta guía está aquí para ayudarte a aclarar el panorama. Vamos a comparar estas plataformas basándonos en lo que realmente importa para una empresa: su rendimiento, su coste y lo complicado que es configurarlas. Veremos lo que estos modelos brutos pueden hacer por sí solos y luego hablaremos de una forma más práctica de poner la IA a trabajar para ti.

Un vistazo general a las principales API de modelos de IA

Primero, aclaremos rápidamente de qué estamos hablando. Una API (Interfaz de Programación de Aplicaciones) es básicamente un puente que permite a los desarrolladores conectar su propio software a estos potentes modelos de IA. Así que, cuando comparas la API de OpenAI con la de Anthropic y la de Gemini, estás analizando los motores que impulsan miles de herramientas de IA diferentes.

¿Qué es la API de OpenAI?

Si alguna vez has usado ChatGPT o has visto a un desarrollador maravillarse con GitHub Copilot, ya has visto el trabajo de OpenAI. Fueron los primeros en captar realmente la atención del público, y su Plataforma de API es la más consolidada y utilizada. Sus modelos GPT, como GPT-4.1 y GPT-4o, son conocidos por ser excelentes todoterrenos, sólidos en razonamiento, programación y conversación general. Como llevan más tiempo en el mercado, existe una enorme comunidad de desarrolladores, lo que significa que puedes encontrar un tutorial para casi cualquier cosa.

¿Qué es la API de Anthropic?

Anthropic fue fundada por antiguos investigadores de OpenAI que querían construir una IA con la seguridad como máxima prioridad. Todos sus modelos se llaman Claude, siendo Claude 4 Opus y Sonnet los pesos pesados actuales. La API de Anthropic se ha vuelto popular entre las grandes empresas por un par de buenas razones: es excelente para digerir y analizar documentos largos, está diseñada para ser más fiable y menos propensa a inventar hechos, y sus características de seguridad integradas la convierten en una apuesta segura para empresas en sectores regulados.

¿Qué es la API de Google Gemini?

Gemini es la propuesta de Google en la carrera de la IA, y fue construida desde el principio para ser "nativamente multimodal". Todo lo que eso significa es que la API de Google Gemini no se limita al texto; está diseñada para entender imágenes, vídeo y audio sin despeinarse. Tiene una ventana de contexto masiva (enseguida hablaremos de eso) y está estrechamente integrada con otros productos de Google como Google Cloud y Workspace. Es un competidor muy fuerte para las empresas que ya utilizan las herramientas de Google o para aquellas que quieren construir algo que vaya más allá de las palabras.

Comparando capacidades y rendimiento principales

Bien, basta de definiciones. Veamos cómo se comparan realmente estas API en las características que importarán para tu proyecto.

Por qué una ventana de contexto más grande no siempre es mejor

Oirás mucho el término "ventana de contexto". Es simplemente el término técnico para la cantidad de información que un modelo puede retener en su memoria a corto plazo durante una sola conversación. Se mide en "tokens", donde unos 1.000 tokens equivalen a 750 palabras.

Tanto Google Gemini como los modelos más nuevos de OpenAI afirman tener enormes ventanas de contexto de más de 1.000.000 de tokens. Suena increíble, ¿verdad? Podrías darle un libro entero. Pero hay un inconveniente. El rendimiento del modelo no siempre es estable en toda esa ventana. Las pruebas han demostrado que la precisión puede caer en picado cuando se fuerzan los límites superiores. Es un poco como intentar escuchar en una habitación abarrotada: cuanto más intentas absorber a la vez, más difícil es centrarse en lo importante.

Claude de Anthropic hace las cosas de manera un poco diferente. Ofrece una ventana de 200.000 tokens, que sigue siendo masiva y puede manejar fácilmente un documento de 150.000 palabras. La clave es que su rendimiento es notablemente consistente de principio a fin. Para la mayoría de las necesidades empresariales, como analizar un largo hilo de soporte o un contrato legal, ese tipo de fiabilidad es mucho más útil que una ventana de contexto de récord, pero a veces poco fiable.

Manejando más que solo texto

La multimodalidad simplemente significa la capacidad de procesar diferentes tipos de información, no solo texto. Aquí es donde Google Gemini realmente destaca. Fue construido para manejar imágenes, audio e incluso vídeo. Imagina una situación de atención al cliente en la que alguien pudiera simplemente enviar una foto de un producto roto o un vídeo rápido de un código de error. Gemini está diseñado exactamente para eso.

GPT-4o de OpenAI también ha mejorado mucho en esta área y puede manejar imágenes y audio bastante bien. Anthropic, aunque está mejorando, se ha centrado históricamente más en perfeccionar el razonamiento basado en texto, por lo que no suele ser la primera opción para tareas altamente dependientes de lo visual o el audio.

Llamada a funciones: Haciendo que la IA hable con tus sistemas

Esta es probablemente la característica más importante para cualquier uso empresarial real. La "llamada a funciones" o "uso de herramientas" es lo que permite a una IA hacer cosas en lugar de solo hablar. Es cómo una IA puede verificar el estado de un pedido en Shopify, actualizar un ticket en Zendesk o extraer el historial de pagos de un cliente de tu base de datos.

Las tres API pueden hacer esto, pero cada una tiene su propio estilo. OpenAI es excelente para manejar varias solicitudes a la vez, lo que la hace rápida. Claude es mejor para trabajar en tareas de varios pasos una por una y es particularmente bueno explicando su proceso de pensamiento, lo cual es útil para la resolución de problemas.

¿El problema? Configurar esto por tu cuenta es un proyecto de ingeniería de gran envergadura. Tienes que definir cada herramienta, gestionar la comunicación de ida y vuelta, manejar los errores y devolver los resultados al modelo correctamente. Esto es un esfuerzo enorme, por lo que muchos equipos utilizan plataformas como eesel AI que gestionan toda esta complejidad por ti a través de un simple creador de flujos de trabajo.

La realidad empresarial: Precios e implementación

Bien, ahora las dos preguntas que realmente le importan a todo líder empresarial: "¿Cuánto costará esto?" y "¿Qué tan difícil es ponerlo en marcha?"

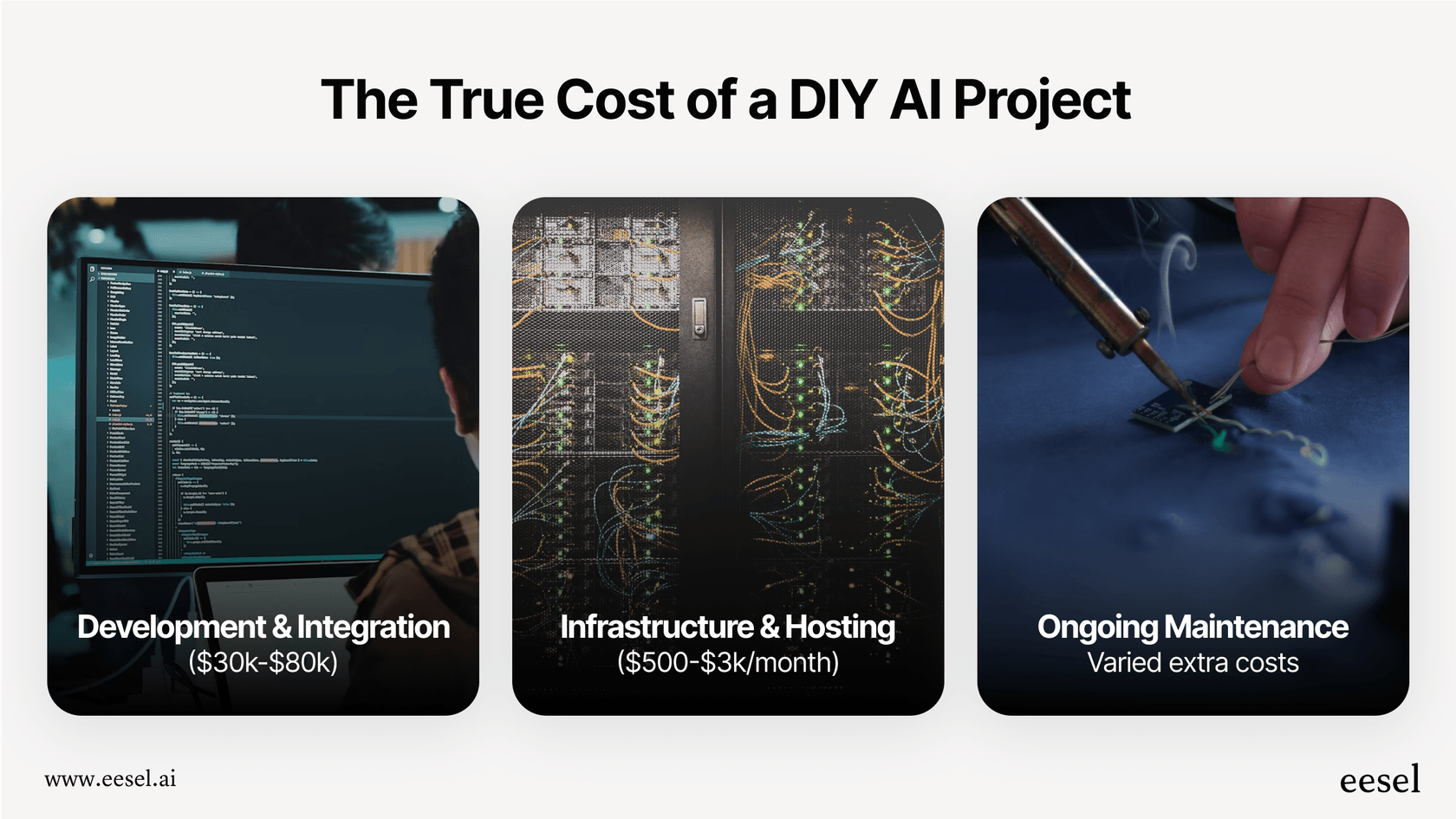

Un desglose detallado de los precios

Las tres plataformas te cobran en función de cuántos tokens utilices. Pagas por los datos que envías al modelo (entrada) y por los datos que genera (salida). Suena sencillo, pero puede hacer que tu factura mensual sea realmente impredecible. Un mes ajetreado para tu equipo de soporte podría resultar en una factura sorprendentemente alta.

Aquí tienes una idea aproximada de cómo se comparan sus precios para sus modelos más populares. Estas cifras cambian, pero las diferencias generales de coste suelen mantenerse.

| Proveedor | Modelo | Precio de entrada (por 1 millón de tokens) | Precio de salida (por 1 millón de tokens) | Ideal para |

|---|---|---|---|---|

| OpenAI | GPT-4.1 | 2,00 $ | 8,00 $ | Tareas generales de alto rendimiento |

| GPT-4.1 mini | 0,40 $ | 1,60 $ | Equilibrio entre rendimiento y coste | |

| GPT-4.1 nano | 0,10 $ | 0,40 $ | Tareas de alto volumen y baja latencia | |

| Anthropic | Claude 4 Opus | 15,00 $ | 75,00 $ | Razonamiento complejo, programación |

| Claude 4 Sonnet | 3,00 $ | 15,00 $ | Tareas empresariales equilibradas | |

| Claude 3 Haiku | 0,25 $ | 1,25 $ | Tareas rápidas y de alto volumen | |

| Gemini 2.5 Pro | 1,25 $ | 10,00 $ | Multimodal avanzado, contexto largo | |

| Gemini 2.5 Flash | 0,15 $ | 0,60 $ | Tareas rápidas y rentables |

Precios exactos a finales de 2024, basados en datos disponibles públicamente.

Puesta en marcha: El reto de la implementación

En cuanto a los recursos para desarrolladores, OpenAI lleva la delantera con una tonelada de documentación y foros comunitarios. Si tu empresa ya funciona con Google Cloud, entonces conectarse a Gemini te resultará natural. Anthropic se está poniendo al día rápidamente con una documentación excelente y clara para su API.

Pero aquí está el golpe de realidad: para un equipo de soporte que solo quiere automatizar parte de su trabajo, ninguna de estas opciones es sencilla. Integrarse directamente con una API significa que necesitas desarrolladores. Necesitas gente que escriba el código, gestione los servidores, ajuste los prompts y se asegure de que nada se rompa. Es una inversión seria y continua tanto de tiempo como de dinero.

La opción más inteligente: Por qué necesitas una plataforma

Después de todo esto, puede que te estés dando cuenta de que debatir los detalles de la API de OpenAI vs. la API de Anthropic vs. la API de Gemini es hacer la pregunta equivocada. El verdadero desafío no es solo elegir un modelo, es convertir ese modelo en una herramienta que realmente ayude a tu negocio.

Los costes ocultos de construirlo tú mismo

El enfoque de 'hazlo tú mismo' suena genial en teoría, pero está lleno de trabajo oculto y riesgos:

-

Tiempo y personal: Construir un agente de IA sólido para tu servicio de asistencia no es algo que se improvisa en un fin de semana. Puede llevarle fácilmente a un par de ingenieros meses construir, probar y desplegar algo fiable.

-

Mucha complejidad: De repente, eres responsable de todo. Descubrir los prompts correctos, sincronizar el conocimiento de diferentes lugares, construir flujos de trabajo, diseñar una interfaz y hacer un seguimiento de los resultados, todo recae sobre tus hombros.

-

Una apuesta arriesgada: ¿Cómo sabes si tu solución personalizada funcionará bien? Es difícil probarla en escenarios del mundo real antes de ponerla en marcha con tus clientes. Básicamente, estás construyendo a ciegas.

-

Quedar atrapado: Si construyes todo tu sistema en torno a una API, te quedas atascado ahí. ¿Qué pasa cuando un competidor lanza un modelo que es mejor o más barato? Cambiar puede ser casi tanto trabajo como empezar de cero.

Cómo eesel AI lo simplifica todo

Este es exactamente el problema para el que se construyó una plataforma como eesel AI. Te da el poder de estos modelos de IA sin el enorme quebradero de cabeza de ingeniería.

-

Empieza en minutos, no en meses: No tienes que lidiar con largos proyectos de desarrollo. eesel AI tiene integraciones de un solo clic con servicios de asistencia como Zendesk y Freshdesk. Puedes configurarlo todo por tu cuenta sin necesidad de hablar con un vendedor.

-

Control total, sin necesidad de código: Obtienes la flexibilidad de una herramienta hecha a medida pero a través de una interfaz sencilla. Puedes usar el editor de prompts para dar forma a la personalidad de tu IA, crear flujos de trabajo personalizados y conectarte a tus herramientas con Acciones de IA, todo sin un desarrollador.

-

Prueba con confianza: Esto es muy importante. El modo de simulación en eesel AI te permite probar tu configuración en miles de tus propios tickets de soporte pasados. Puedes ver exactamente cómo habría respondido, obtener una previsión de tu tasa de automatización y ajustar su rendimiento antes de que hable con un cliente. Elimina todas las conjeturas del proceso.

-

Precios predecibles: En lugar de la montaña rusa de la facturación basada en tokens, eesel AI tiene planes transparentes. Sabes exactamente lo que pagas cada mes, y no hay tarifas por resolución que te cobren más por tener éxito.

Céntrate en la solución, no en la herramienta

Aunque OpenAI, Anthropic y Gemini ofrecen una tecnología asombrosa, eso es lo que son: tecnología. Para la mayoría de las empresas, enredarse en una comparación técnica de sus API es una distracción del objetivo real.

Si quieres resolver los problemas de los clientes más rápido y quitarle algo de presión a tu equipo de soporte, la mejor pregunta es cómo hacerlo con el menor tiempo, riesgo y coste. Una plataforma de IA se encarga de la complejidad de elegir y gestionar los modelos para que tú puedas centrarte en lo que se te da bien: diseñar excelentes flujos de trabajo de soporte y cuidar de tus clientes.

¿Listo para ver cómo una plataforma de IA puede ayudar a tu equipo de soporte sin la carga de ingeniería? Configura tu primer agente de IA con eesel AI en minutos.

Preguntas frecuentes

El factor más crucial no es solo el rendimiento bruto del modelo, sino la implementación práctica y la fiabilidad. Considera con qué facilidad puedes integrar la API, gestionar el desarrollo continuo y lograr resultados consistentes y precisos para tus flujos de trabajo empresariales específicos y las interacciones con los clientes.

Las tres plataformas utilizan un modelo de precios basado en tokens, cobrando tanto por la entrada como por la salida, lo que puede hacer que los costes mensuales sean impredecibles. OpenAI ofrece tarifas generalmente competitivas, Opus de Anthropic puede ser más caro por su razonamiento avanzado, y Google Gemini es competitivo, especialmente con su rentable modelo Flash.

Implementar directamente cualquiera de estas API para tareas empresariales complejas, como automatizar un servicio de atención al cliente, requiere un esfuerzo de ingeniería significativo. Un equipo pequeño enfrentaría desafíos sustanciales al escribir código, gestionar prompts, manejar errores e integrarse eficazmente con los sistemas existentes.

Google Gemini fue diseñado para una multimodalidad nativa, destacando en la comprensión de imágenes, vídeo y audio desde el principio. GPT-4o de OpenAI también se ha vuelto muy competente en el manejo de imágenes y audio. Anthropic se ha centrado históricamente más en el razonamiento avanzado basado en texto, aunque sus capacidades multimodales están mejorando.

Aunque Gemini y los modelos más nuevos de OpenAI presumen de ventanas de contexto muy grandes, su precisión a veces puede disminuir en los límites más altos. Claude de Anthropic, con una ventana de 200.000 tokens, ofrece un rendimiento notablemente consistente en todo su rango, lo que lo hace muy fiable para analizar documentos largos sin perder el enfoque.

Una plataforma como eesel AI simplifica todo el proceso, abstrayendo las complejidades de la integración directa de la API, la ingeniería de prompts y la gestión de la infraestructura. Esto reduce significativamente el tiempo de desarrollo, elimina costes ocultos y permite a las empresas desplegar soluciones de IA robustas rápidamente y con precios predecibles.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.