On a l'impression qu'un nouveau modèle d'IA époustouflant sort toutes les deux semaines. Pour les entreprises qui essaient de comprendre comment réellement utiliser cette technologie, il y a beaucoup à suivre. L'ensemble du secteur est actuellement dominé par trois acteurs majeurs : OpenAI, Anthropic et Google. Si vous envisagez d'intégrer l'IA dans votre entreprise, en particulier pour quelque chose d'aussi important que le support client, choisir la bonne API est une décision capitale.

Ce guide est là pour vous aider à y voir plus clair. Nous allons comparer ces plateformes en nous basant sur ce qui compte vraiment pour une entreprise : leur performance, leur coût et la complexité de leur mise en place. Nous examinerons ce que ces modèles bruts peuvent faire par eux-mêmes, puis nous parlerons d'une manière plus pratique de mettre l'IA au service de votre entreprise.

Un aperçu des principales API de modèles d'IA

Tout d'abord, clarifions rapidement de quoi nous parlons. Une API (Application Programming Interface) est essentiellement un pont qui permet aux développeurs de connecter leurs propres logiciels à ces puissants modèles d'IA. Ainsi, lorsque vous comparez l'API d'OpenAI, celle d'Anthropic et celle de Gemini, vous examinez les moteurs qui alimentent des milliers d'outils d'IA différents.

Qu'est-ce que l'API d'OpenAI ?

Si vous avez déjà utilisé ChatGPT ou vu un développeur s'extasier sur GitHub Copilot, vous avez vu le travail d'OpenAI. Ils ont été les premiers à vraiment capter l'attention du public, et leur plateforme d'API est la plus établie et la plus largement utilisée. Leurs modèles GPT, comme GPT-4.1 et GPT-4o, sont réputés pour être très polyvalents, solides en matière de raisonnement, de codage et de conversation générale. Comme ils sont présents depuis plus longtemps, il existe une immense communauté de développeurs, ce qui signifie que vous pouvez trouver un tutoriel pour à peu près n'importe quoi.

Qu'est-ce que l'API d'Anthropic ?

Anthropic a été fondée par d'anciens chercheurs d'OpenAI qui voulaient construire une IA en faisant de la sécurité une priorité absolue. Leurs modèles sont tous nommés Claude, avec Claude 4 Opus et Sonnet comme poids lourds actuels. L'API d'Anthropic est devenue populaire auprès des grandes entreprises pour plusieurs bonnes raisons : elle excelle à assimiler et à analyser de longs documents, elle est conçue pour être plus fiable et moins susceptible d'inventer des faits, et ses fonctionnalités de sécurité intégrées en font un choix sûr pour les entreprises des secteurs réglementés.

Qu'est-ce que l'API Google Gemini ?

Gemini est l'entrée de Google dans la course à l'IA, et elle a été conçue dès le départ pour être « nativement multimodale ». Tout ce que cela signifie, c'est que l'API Google Gemini ne se limite pas au texte ; elle est conçue pour comprendre les images, la vidéo et l'audio sans la moindre difficulté. Elle dispose d'une fenêtre de contexte immense (nous y reviendrons dans un instant) et est étroitement intégrée aux autres produits de Google comme Google Cloud et Workspace. C'est un concurrent très sérieux pour les entreprises qui utilisent déjà les outils de Google ou celles qui veulent construire quelque chose qui va au-delà des simples mots.

Comparaison des capacités et des performances de base

Bon, assez de définitions. Voyons comment ces API se comparent réellement sur les fonctionnalités qui compteront pour votre projet.

Pourquoi une plus grande fenêtre de contexte n'est pas toujours une meilleure chose

Vous entendrez souvent le terme « fenêtre de contexte ». C'est simplement le terme technique pour désigner la quantité d'informations qu'un modèle peut conserver dans sa mémoire à court terme au cours d'une seule conversation. Elle se mesure en « jetons », où environ 1 000 jetons équivalent à 750 mots.

Google Gemini et les modèles les plus récents d'OpenAI prétendent tous deux avoir d'énormes fenêtres de contexte de plus de 1 000 000 de jetons. Cela semble incroyable, n'est-ce pas ? On pourrait leur donner un livre entier à lire. Mais il y a un hic. Les performances du modèle ne sont pas toujours stables sur l'ensemble de cette fenêtre. Des tests ont montré que la précision peut chuter de manière drastique lorsque vous poussez les limites supérieures. C'est un peu comme essayer d'écouter dans une pièce bondée : plus vous essayez d'absorber d'informations à la fois, plus il est difficile de se concentrer sur ce qui est important.

Le modèle Claude d'Anthropic procède un peu différemment. Il offre une fenêtre de 200 000 jetons, ce qui est encore énorme et peut facilement gérer un document de 150 000 mots. La clé est que sa performance est remarquablement constante sur l'ensemble de sa plage d'utilisation. Pour la plupart des besoins professionnels, comme l'analyse d'un long fil de discussion de support ou d'un contrat juridique, ce type de fiabilité est bien plus utile qu'une fenêtre de contexte record mais parfois peu fiable.

Gérer plus que du simple texte

La multimodalité signifie simplement la capacité à traiter différents types d'informations, pas seulement du texte. C'est là que Gemini de Google se démarque vraiment. Il a été conçu pour gérer les images, l'audio et même la vidéo. Imaginez une situation de support client où quelqu'un pourrait simplement envoyer une photo d'un produit cassé ou une courte vidéo d'un code d'erreur. Gemini est conçu exactement pour cela.

Le modèle GPT-4o d'OpenAI est également devenu très bon dans ce domaine et peut très bien gérer les images et l'audio. Anthropic, bien qu'en progrès, s'est historiquement davantage concentré sur le perfectionnement du raisonnement textuel, ce n'est donc généralement pas le premier choix pour les tâches très visuelles ou dépendantes de l'audio.

Appels de fonctions : faire communiquer l'IA avec vos systèmes

C'est probablement la fonctionnalité la plus importante pour toute utilisation professionnelle concrète. Les « appels de fonctions » ou « l'utilisation d'outils » permettent à une IA de faire réellement des choses au lieu de simplement parler. C'est ainsi qu'une IA peut vérifier le statut d'une commande dans Shopify, mettre à jour un ticket dans Zendesk ou récupérer l'historique de paiement d'un client dans votre base de données.

Les trois API peuvent le faire, mais chacune a son propre style. OpenAI est excellent pour gérer plusieurs requêtes à la fois, ce qui le rend rapide. Claude est meilleur pour exécuter des tâches en plusieurs étapes une par une et est particulièrement doué pour expliquer son processus de pensée, ce qui est utile pour le dépannage.

Le problème ? Mettre cela en place soi-même est un projet d'ingénierie majeur. Vous devez définir chaque outil, gérer la communication aller-retour, traiter les erreurs et renvoyer correctement les résultats au modèle. C'est un travail colossal, c'est pourquoi de nombreuses équipes utilisent des plateformes comme eesel AI qui gèrent toute cette complexité pour vous via un simple créateur de flux de travail.

La réalité commerciale : Tarification et mise en œuvre

Passons maintenant aux deux questions qui préoccupent vraiment tous les chefs d'entreprise : « Combien cela va-t-il coûter ? » et « Est-ce difficile à mettre en place ? »

Une analyse détaillée des tarifs

Les trois plateformes vous facturent en fonction du nombre de jetons que vous utilisez. Vous payez pour les données que vous envoyez au modèle (entrée) et pour les données qu'il génère (sortie). Cela semble simple, mais cela peut rendre votre facture mensuelle très imprévisible. Un mois chargé pour votre équipe de support pourrait entraîner une facture étonnamment élevée.

Voici une idée approximative de la comparaison de leurs tarifs pour leurs modèles les plus populaires. Ces chiffres évoluent, mais les différences de coût générales restent généralement les mêmes.

| Fournisseur | Modèle | Prix d'entrée (par million de jetons) | Prix de sortie (par million de jetons) | Idéal pour |

|---|---|---|---|---|

| OpenAI | GPT-4.1 | 2,00 $ | 8,00 $ | Tâches générales et haute performance |

| GPT-4.1 mini | 0,40 $ | 1,60 $ | Équilibre entre performance et coût | |

| GPT-4.1 nano | 0,10 $ | 0,40 $ | Tâches à grand volume et faible latence | |

| Anthropic | Claude 4 Opus | 15,00 $ | 75,00 $ | Raisonnement complexe, codage |

| Claude 4 Sonnet | 3,00 $ | 15,00 $ | Tâches d'entreprise équilibrées | |

| Claude 3 Haiku | 0,25 $ | 1,25 $ | Tâches rapides et à grand volume | |

| Gemini 2.5 Pro | 1,25 $ | 10,00 $ | Multimodalité avancée, contexte long | |

| Gemini 2.5 Flash | 0,15 $ | 0,60 $ | Tâches rapides et rentables |

Tarifs basés sur les données publiques disponibles de 2024.

La mise en place : Le défi de l'implémentation

En ce qui concerne les ressources pour les développeurs, OpenAI a une longueur d'avance avec une tonne de documentation et de forums communautaires. Si votre entreprise fonctionne déjà sur Google Cloud, alors se connecter à Gemini semblera naturel. Anthropic rattrape rapidement son retard avec une documentation excellente et claire pour son API.

Mais voici le retour à la réalité : pour une équipe de support qui veut simplement automatiser une partie de son travail, aucune de ces solutions n'est simple. Intégrer directement une API signifie que vous avez besoin de développeurs. Vous avez besoin de personnes pour écrire le code, gérer les serveurs, ajuster les prompts et vous assurer que rien ne casse. C'est un investissement sérieux et continu en temps et en argent.

Le choix intelligent : Pourquoi vous avez besoin d'une plateforme

Après tout cela, vous réalisez peut-être que débattre des subtilités des API d'OpenAI, d'Anthropic et de Gemini, c'est se poser la mauvaise question. Le véritable défi n'est pas seulement de choisir un modèle ; c'est de transformer ce modèle en un outil qui aide réellement votre entreprise.

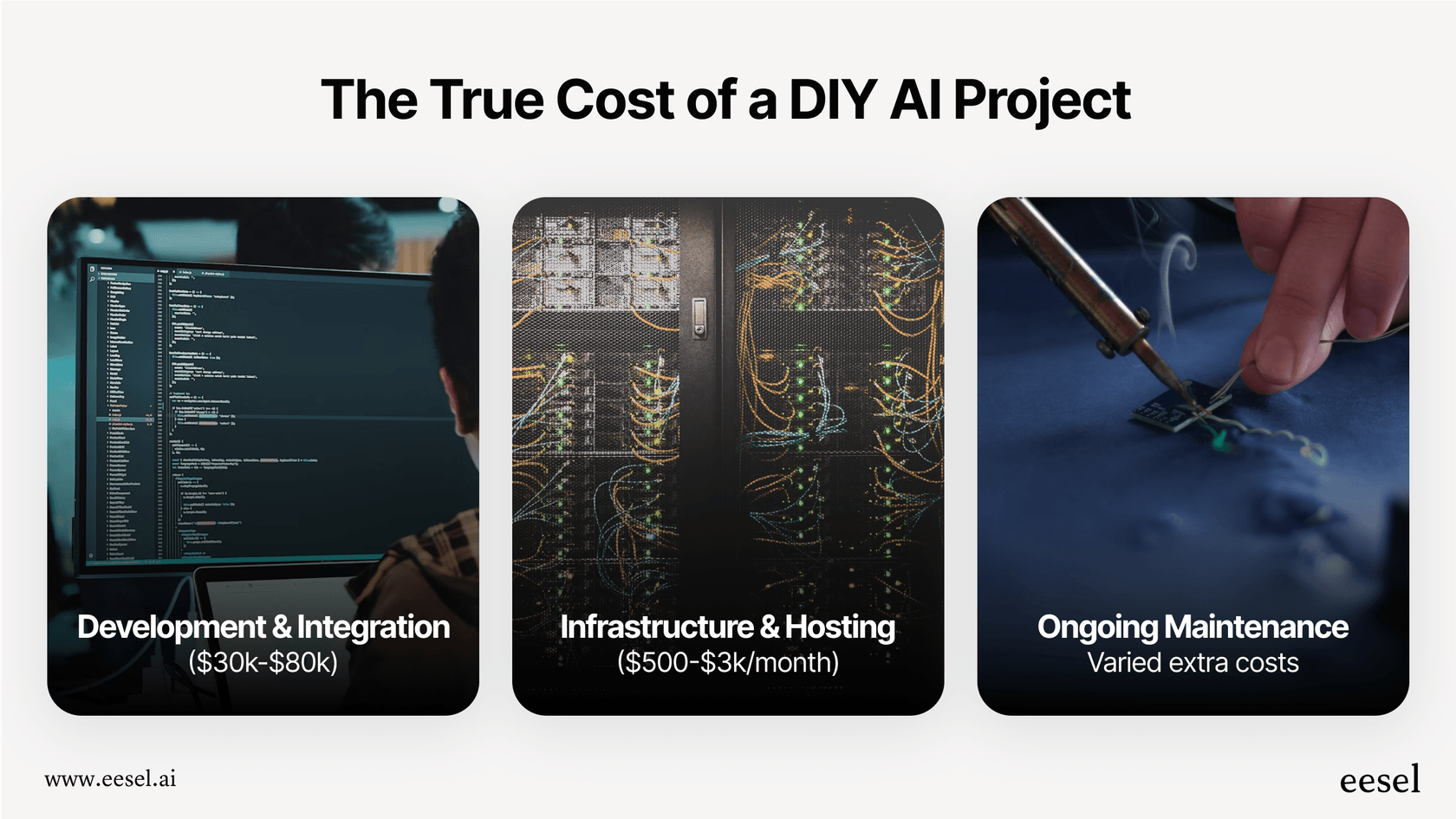

Les coûts cachés du développement en interne

L'approche « fait maison » semble excellente en théorie, mais elle est pleine de travail caché et de risques :

-

Temps et personnel : Construire un agent IA solide pour votre service d'assistance n'est pas quelque chose que l'on boucle en un week-end. Cela peut facilement prendre plusieurs mois à quelques ingénieurs pour construire, tester et déployer quelque chose de fiable.

-

Une complexité énorme : Soudain, vous devenez responsable de tout. Définir les bons prompts, synchroniser les connaissances provenant de différentes sources, construire des flux de travail, concevoir une interface et suivre les résultats, tout cela vous incombe.

-

Un pari risqué : Comment savoir si votre solution personnalisée fonctionnera bien ? Il est difficile de la tester sur des scénarios réels avant de la mettre en service pour vos clients. Vous construisez essentiellement à l'aveugle.

-

Le risque de dépendance : Si vous construisez tout votre système autour d'une seule API, vous y êtes coincé. Que se passe-t-il si un concurrent sort un modèle meilleur ou moins cher ? Changer peut représenter presque autant de travail que de repartir de zéro.

Comment eesel AI simplifie tout

C'est exactement le problème pour lequel une plateforme comme eesel AI a été conçue. Elle vous donne la puissance de ces modèles d'IA sans le casse-tête d'ingénierie massif.

-

Démarrez en quelques minutes, pas en quelques mois : Vous n'avez pas à vous soucier de longs projets de développement. eesel AI dispose d'intégrations en un clic avec des services d'assistance comme Zendesk et Freshdesk. Vous pouvez tout configurer vous-même sans avoir besoin de parler à un commercial.

-

Contrôle total, sans code : Vous bénéficiez de la flexibilité d'un outil sur mesure, mais via une interface simple. Vous pouvez utiliser l'éditeur de prompts pour façonner la personnalité de votre IA, créer des flux de travail personnalisés et vous connecter à vos outils avec les Actions IA, le tout sans l'aide d'un développeur.

-

Testez en toute confiance : C'est un avantage majeur. Le mode de simulation d'eesel AI vous permet de tester votre configuration sur des milliers de vos propres tickets de support passés. Vous pouvez voir exactement comment il aurait répondu, obtenir une prévision de votre taux d'automatisation et ajuster ses performances avant qu'il ne parle à un client. Cela élimine toute part d'incertitude du processus.

-

Tarification prévisible : Au lieu des montagnes russes de la facturation par jeton, eesel AI propose des forfaits transparents. Vous savez exactement ce que vous payez chaque mois, et il n'y a pas de frais par résolution qui vous facturent plus cher lorsque vous réussissez.

Concentrez-vous sur la solution, pas sur l'outil

Bien qu'OpenAI, Anthropic et Gemini offrent tous une technologie incroyable, c'est ce qu'ils sont : une technologie. Pour la plupart des entreprises, s'enliser dans une comparaison technique de leurs API est une distraction de l'objectif réel.

Si vous voulez résoudre les problèmes des clients plus rapidement et soulager votre équipe de support, la meilleure question est de savoir comment y parvenir avec le moins de temps, de risque et de coût possible. Une plateforme d'IA gère la complexité du choix et de la gestion des modèles pour que vous puissiez vous concentrer sur ce que vous faites de mieux : concevoir d'excellents flux de travail de support et prendre soin de vos clients.

Prêt à découvrir comment une plateforme d'IA peut aider votre équipe de support sans la charge de travail d'ingénierie ? Configurez votre premier agent d'IA avec eesel AI en quelques minutes.

Foire aux questions

Le facteur le plus crucial n'est pas seulement la performance brute du modèle, mais la mise en œuvre pratique et la fiabilité. Pensez à la facilité avec laquelle vous pouvez intégrer l'API, gérer le développement continu et obtenir des résultats cohérents et précis pour vos flux de travail spécifiques et les interactions avec les clients.

Les trois plateformes utilisent un modèle de tarification basé sur les jetons, facturant à la fois l'entrée et la sortie, ce qui peut rendre les coûts mensuels imprévisibles. OpenAI propose des tarifs généralement compétitifs, le modèle Opus d'Anthropic peut être plus cher pour son raisonnement avancé, et Google Gemini est compétitif, notamment avec son modèle Flash économique.

L'implémentation directe de l'une de ces API pour des tâches professionnelles complexes, comme l'automatisation d'un service de support client, nécessite un effort d'ingénierie considérable. Une petite équipe serait confrontée à des défis importants pour écrire le code, gérer les prompts, traiter les erreurs et s'intégrer efficacement aux systèmes existants.

Google Gemini a été conçu pour une multimodalité native, excellant dès le départ dans la compréhension des images, des vidéos et de l'audio. Le modèle GPT-4o d'OpenAI est également devenu très compétent dans le traitement des images et de l'audio. Anthropic s'est historiquement davantage concentré sur le raisonnement textuel avancé, bien que ses capacités multimodales s'améliorent.

Alors que Gemini et les modèles plus récents d'OpenAI revendiquent de très grandes fenêtres de contexte, leur précision peut parfois se dégrader aux limites les plus élevées. Le modèle Claude d'Anthropic, avec une fenêtre de 200 000 jetons, offre des performances remarquablement constantes sur toute sa plage, ce qui le rend très fiable pour analyser de longs documents sans perdre sa concentration.

Une plateforme comme eesel AI simplifie l'ensemble du processus, en masquant les complexités de l'intégration directe de l'API, de l'ingénierie des prompts et de la gestion de l'infrastructure. Cela réduit considérablement le temps de développement, élimine les coûts cachés et permet aux entreprises de déployer rapidement des solutions d'IA robustes avec une tarification prévisible.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.