Então, você lançou uma IA de suporte. Isso é um grande passo. Mas agora você provavelmente está se perguntando o que ela está realmente fazendo. Quando um cliente recebe uma resposta lenta ou simplesmente errada, descobrir o porquê pode ser como procurar uma agulha num palheiro. Será que o modelo de linguagem está num dia mau, uma chamada de API está lenta ou há um ponto cego na sua base de conhecimento? Sem uma forma de ver por dentro, a sua IA de suporte é apenas uma caixa-preta.

É aqui que a observabilidade se torna útil. Usando um padrão de código aberto chamado OpenTelemetry, você pode acompanhar cada movimento que a sua IA faz, desde o momento em que pega um ticket até ao envio de uma resposta. Este guia irá orientá-lo através do processo manual de configuração de registro (logging) e rastreamento (tracing) para uma IA de suporte com OpenTelemetry. Abordaremos as ideias principais e os passos práticos para começar.

Serei honesto, este processo exige algum esforço técnico, mas é indispensável para construir uma IA na qual você possa confiar. Claro, se preferir pular o trabalho manual, plataformas como a eesel AI lidam com toda essa complexidade por você, para que possa focar na experiência do cliente em vez de nos seus pipelines de telemetria.

Recurso 1: [Fluxo de Trabalho] , Um diagrama que ilustra como o OpenTelemetry funciona para registro e rastreamento de uma IA de suporte com OpenTelemetry.

O que você precisará para uma configuração manual

Antes de mergulharmos no passo a passo, vamos falar sobre o que uma configuração manual realmente envolve. Este caminho lhe dá controle total, mas exige alguns recursos dedicados.

Aqui está um resumo rápido do que você precisará:

-

Um ambiente de desenvolvimento: Você provavelmente trabalhará em Python, já que é uma escolha popular para aplicativos de IA.

-

SDKs e bibliotecas do OpenTelemetry: Você precisará instalar esses pacotes para que seu código comece a registrar o que está fazendo.

-

Um backend de observabilidade: Esta é uma ferramenta para onde você envia todos os seus dados para serem visualizados e analisados. Pense em ferramentas como Jaeger (que é de código aberto) ou Datadog.

-

Tempo de desenvolvedor: Esta não é uma tarefa que se faz uma vez e pronto. Exige um esforço de engenharia real para implementar, manter e, de fato, extrair sentido dos dados que você está coletando.

Essa sobrecarga técnica é um grande motivo pelo qual muitas equipes simplesmente optam por uma plataforma gerenciada. Uma ferramenta como a eesel AI se conecta diretamente ao seu helpdesk, seja Zendesk ou Freshdesk, em questão de minutos. Ela fornece insights ricos e focados em suporte sem que você precise escrever uma única linha de código.

Um guia passo a passo

Ok, vamos ao que interessa na instrumentação da sua IA de suporte. O principal objetivo aqui é criar um registro detalhado, chamado de "trace" (rastreamento), que acompanha uma única solicitação de cliente do início ao fim.

Passo 1: Configure o ambiente

Primeiro de tudo, você precisa configurar a estrutura básica do OpenTelemetry dentro da sua aplicação. Isso significa configurar três componentes principais:

-

Um Provedor de Tracer (Tracer Provider): Esta é essencialmente a fábrica que cria "tracers" (rastreadores) na sua aplicação. Pense nele como o motor principal que impulsiona toda a sua coleta de dados.

-

Um Exportador (Exporter): Esta parte é responsável por enviar seus dados para o seu backend de observabilidade. É o pipeline que move as informações da sua aplicação para um lugar onde você pode realmente analisá-las.

-

Um Processador de Span (Span Processor): Este componente gerencia o ciclo de vida dos seus "spans" (que são os passos individuais em um trace) e os entrega ao exportador. Ele garante que cada pedaço de dado seja tratado corretamente.

Basicamente, seu código inicializará esses componentes para que sua aplicação esteja sempre pronta para capturar e enviar dados de telemetria. Você também pode configurar um Coletor OpenTelemetry (OpenTelemetry Collector), um serviço separado que coleta, processa e exporta dados. Isso pode deixar o código da sua aplicação um pouco mais limpo, tirando parte do trabalho de processamento de dados dele.

Passo 2: Instrumente o fluxo de trabalho

Com seu ambiente pronto, é hora de começar a adicionar rastreamento (tracing) à lógica da sua IA. Um trace representa toda a jornada de um ticket de suporte, e um span representa um único passo dentro dessa jornada. Imagine-o como uma linha do tempo com eventos específicos e rotulados.

Por exemplo, vamos acompanhar uma solicitação de suporte clássica: "Qual é o status do meu pedido?"

Sua IA pode passar por alguns passos para responder a isso:

-

Receber e entender o ticket recebido.

-

Identificar que a intenção do usuário é "consulta de status do pedido".

-

Chamar uma API interna para buscar os detalhes do pedido.

-

Usar um Modelo de Linguagem Grande (LLM) para escrever uma resposta amigável e com som humano.

-

Atualizar o ticket com a resposta e fechá-lo.

Cada uma dessas ações deve ser encapsulada em seu próprio span. Isso cria uma estrutura clara de pai-filho que permite visualizar todo o fluxo de trabalho e ver exatamente quanto tempo cada passo levou. Ao dividir o processo dessa forma, você pode identificar imediatamente onde as coisas estão lentas ou falhando.

Recurso 2: [Fluxo de Trabalho], Um gráfico mermaid mostrando um trace com múltiplos spans para uma solicitação de ticket de suporte.

Passo 3: Capture atributos e métricas

Apenas rastrear o fluxo de trabalho é um bom começo, mas não é o suficiente. Para obter valor real, você precisa adicionar contexto aos seus spans com dados conhecidos como atributos. Felizmente, existem algumas convenções semânticas emergentes para GenAI do OpenTelemetry que fornecem uma maneira padrão de nomear essas coisas. Para uma IA de suporte, você vai querer rastrear tanto detalhes técnicos quanto informações relevantes para o negócio.

Aqui estão alguns atributos chave que você deve capturar:

-

Parâmetros do modelo: "llm.model.name", "llm.temperature"

-

Uso de tokens: "llm.usage.prompt_tokens", "llm.usage.completion_tokens" (este é importantíssimo para ficar de olho nos custos)

-

Chamadas de ferramentas: "tool.name", "tool.input", "tool.output"

-

Contexto de negócio: "customer.id", "ticket.id", "ticket.tags"

Quando você captura esse tipo de dado, pode passar do simples monitoramento de desempenho para responder a perguntas de negócio importantes. Em vez de apenas saber se uma resposta foi lenta, você pode entender por que foi lenta e o que isso significa para seus clientes.

| Atributo Técnico | Pergunta de Negócio que Responde |

|---|---|

| "llm.usage.total_tokens" | Quanto estamos gastando em média para resolver um ticket? |

| "tool.call.duration" | As nossas próprias APIs internas são a razão pela qual as respostas de suporte são lentas? |

| "response.success" (personalizado) | Com que frequência a IA está realmente resolvendo problemas em vez de apenas escalá-los? |

| "knowledge.source.used" (personalizado) | Quais dos nossos artigos de ajuda são genuinamente úteis e quais não são? |

Passo 4: Use os dados de rastreamento para melhorar sua IA

Assim que seus dados estiverem fluindo para sua ferramenta de observabilidade, você pode começar a investigar para diagnosticar problemas e encontrar maneiras de melhorar. É aqui que a configuração realmente compensa.

-

Depurando Respostas Lentas: Um trace longo torna óbvio qual span é o gargalo. Se o span "tool.call:lookup_order" está levando cinco segundos, você sabe que o problema não é o LLM, mas sim o seu sistema interno de pedidos. Agora você sabe exatamente onde concentrar seus esforços.

-

Investigando Respostas Incorretas: Ao olhar os atributos "llm.prompt" e "llm.completion", você pode ver a informação exata que a IA recebeu e o que ela gerou. Você pode descobrir que o contexto que ela extraiu da sua base de conhecimento estava desatualizado, fazendo-a "alucinar". Isso permite que você corrija a causa raiz em vez de apenas remediar os sintomas.

-

Encontrando Lacunas de Conhecimento: Se você registrar toda vez que a IA não consegue encontrar uma resposta, poderá identificar tendências rapidamente. Vários registros relacionados a "como obter um reembolso" é um sinal claro de que você precisa escrever ou melhorar sua documentação sobre esse tópico. Sua IA de suporte se torna uma ferramenta que ajuda proativamente a melhorar seus recursos de autoatendimento.

Dicas profissionais e erros comuns a evitar

Configurar o registro e rastreamento para IA de suporte com OpenTelemetry pode ser um pouco complicado. Aqui estão algumas dicas para ajudar e algumas armadilhas comuns a serem observadas.

-

Erro Comum #1: Rastrear Apenas a Latência. É fácil ficar hiperfocado na velocidade, mas a precisão e a eficácia são o que realmente importa. Crie atributos personalizados para rastrear coisas como sucesso na resolução, taxas de escalonamento e até pontuações de satisfação do cliente ligadas às interações da IA. O objetivo é um suporte melhor, não apenas respostas mais rápidas.

-

Erro Comum #2: Subestimar a Complexidade. Uma configuração manual do OpenTelemetry não é algo que você pode simplesmente configurar e abandonar. Ela precisa de manutenção regular à medida que sua aplicação de IA cresce e muda. O verdadeiro trabalho não é apenas coletar os dados; é construir os painéis e alertas que transformam esses dados em algo que você pode, de fato, usar para agir.

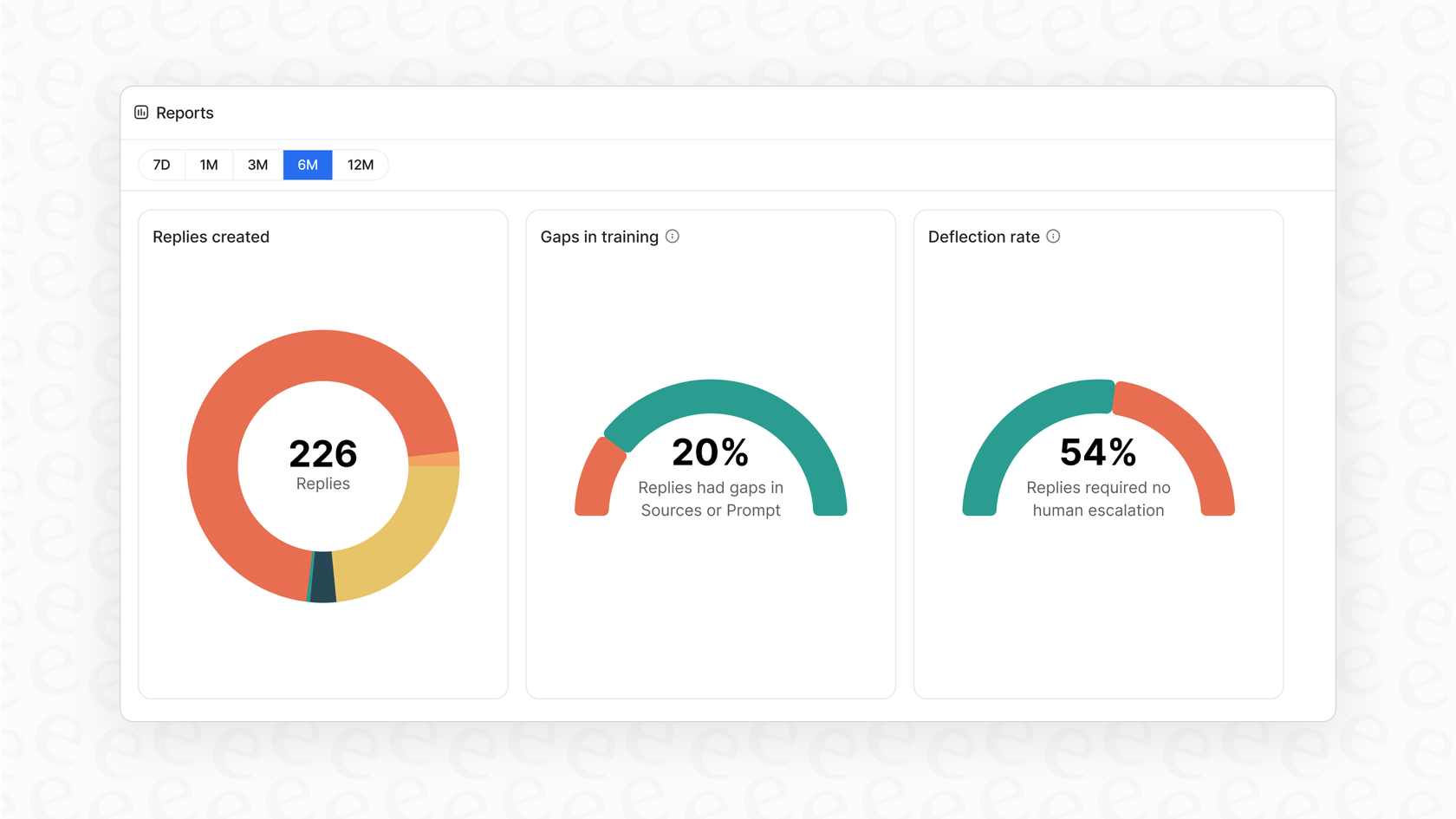

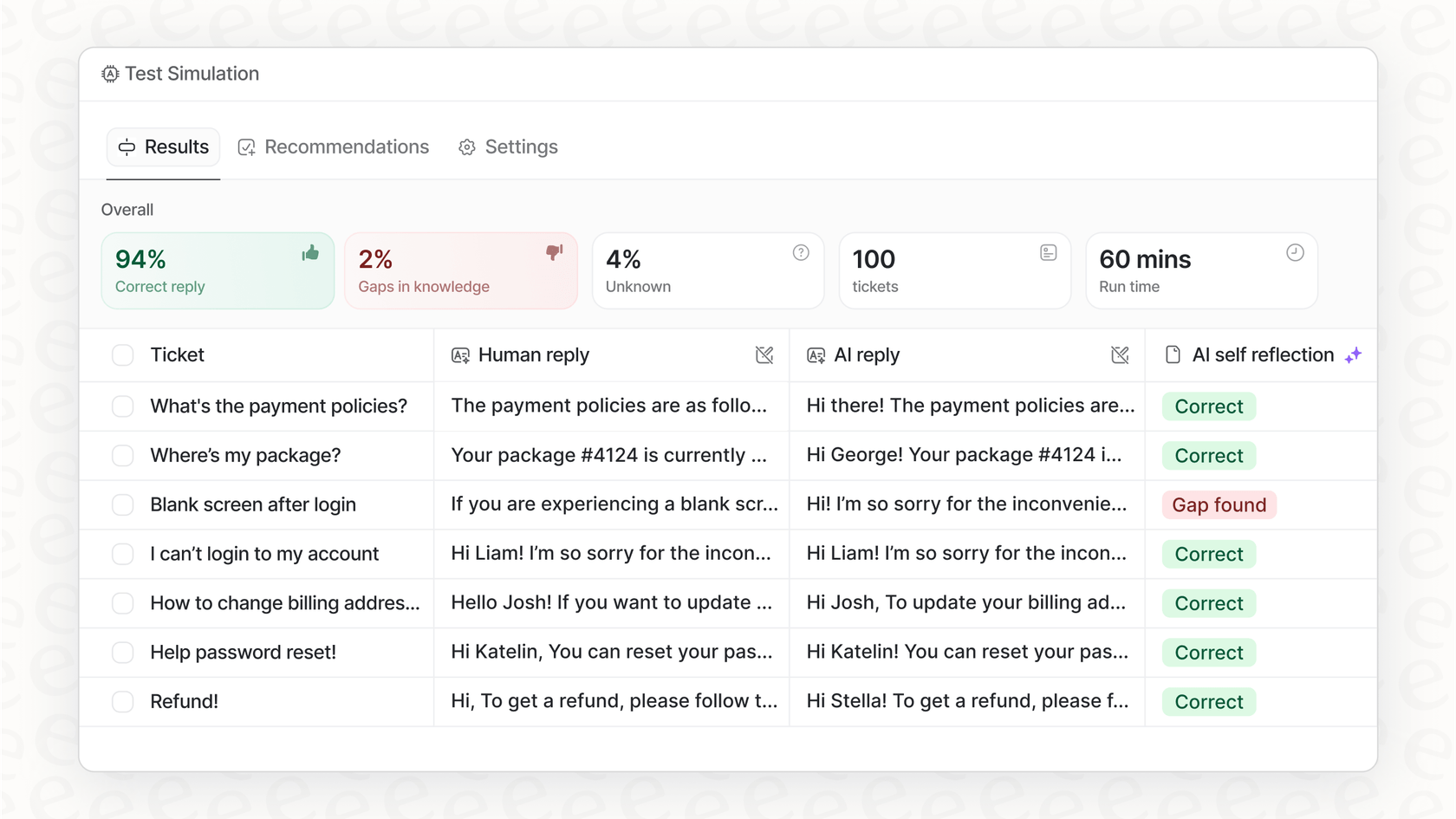

É aqui que uma plataforma gerenciada oferece um valor imenso. Soluções como a eesel AI já vêm configuradas para capturar os dados mais importantes específicos de suporte. Em vez de construir painéis do zero, você obtém relatórios que apontam automaticamente lacunas de conhecimento e mostram as melhores oportunidades para automação.

De dados complexos a insights claros

Implementar o OpenTelemetry é uma ótima maneira de abrir a caixa-preta da sua IA de suporte. Permite rastrear cada solicitação, medir o desempenho, controlar os custos e, em última análise, construir um sistema mais confiável e eficaz. Mas, como vimos, fazer tudo isso por conta própria é um investimento sério em tempo de engenharia e manutenção contínua.

Obtenha observabilidade de IA pronta para uso com a eesel AI

Se você quer todos os benefícios de uma observabilidade profunda de IA sem a dor de cabeça, a eesel AI foi feita para você. Nossa plataforma vem com registro e rastreamento abrangentes já integrados, projetados especificamente para equipes de suporte ao cliente. Você pode simular o desempenho em tickets históricos para ver seu potencial ROI, obter relatórios acionáveis sobre lacunas de conhecimento e entrar em produção em minutos, não em meses.

Pronto para ver do que sua IA de suporte é realmente capaz? Comece seu teste gratuito hoje.

Perguntas frequentes

Isso transforma sua IA de suporte de uma caixa-preta em um sistema transparente, permitindo que você entenda suas ações. Essa visibilidade é crucial para depurar problemas, identificar gargalos e garantir um desempenho confiável e eficiência de custos.

Você precisará principalmente de um Provedor de Tracer (Tracer Provider) para criar tracers, um Exportador (Exporter) para enviar dados ao seu backend de observabilidade e um Processador de Span (Span Processor) para gerenciar os ciclos de vida dos spans. Um Coletor OpenTelemetry opcional também pode otimizar o processamento de dados.

Além dos traces básicos do fluxo de trabalho, capture atributos como parâmetros do modelo LLM, uso de tokens, chamadas de ferramentas e contexto de negócio (por exemplo, ID do cliente, tags do ticket). Eles fornecem um contexto crucial para uma análise e compreensão mais aprofundadas.

Permite que você depure respostas lentas identificando gargalos, investigue respostas incorretas revisando prompts e conclusões, e identifique lacunas de conhecimento rastreando interações de IA malsucedidas. Esses dados permitem melhorias direcionadas e baseadas em dados.

Uma configuração manual requer um tempo significativo de desenvolvedor para a implementação inicial, manutenção contínua e construção de painéis personalizados para análise. Dá a você controle total, mas exige um esforço de engenharia dedicado e contínuo.

Sim, plataformas gerenciadas como a eesel AI oferecem observabilidade integrada projetada especificamente para IA de suporte. Elas lidam com a complexidade subjacente, fornecendo insights e relatórios prontos para uso, sem a necessidade de configuração manual ou código personalizado.

Compartilhe esta postagem

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.