Alors, vous avez lancé une IA de support. C’est une grande étape. Mais maintenant, vous vous demandez probablement ce qu'elle fait vraiment. Lorsqu'un client obtient une réponse lente ou tout simplement erronée, comprendre pourquoi peut donner l'impression de chercher une aiguille dans une botte de foin. Est-ce le modèle de langage qui n'est pas dans un bon jour, un appel API lent ou un angle mort dans votre base de connaissances ? Sans un moyen de voir à l'intérieur, votre IA de support n'est qu'une boîte noire.

C'est là que l'observabilité s'avère utile. En utilisant un standard open-source appelé OpenTelemetry, vous pouvez suivre chaque mouvement de votre IA, depuis le moment où elle prend en charge un ticket jusqu'à l'envoi d'une réponse. Ce guide vous expliquera le processus manuel de configuration de la journalisation et du traçage pour l'IA de support avec OpenTelemetry. Nous aborderons les concepts principaux et les étapes pratiques pour vous lancer.

Pour être honnête, ce processus demande un peu d'huile de coude technique, mais c'est une étape indispensable pour construire une IA fiable. Bien sûr, si vous préférez éviter le travail manuel, des plateformes comme eesel AI gèrent toute cette complexité pour vous, afin que vous puissiez vous concentrer sur l'expérience de vos clients plutôt que sur vos pipelines de télémétrie.

Ce dont vous aurez besoin pour une configuration manuelle

Avant de nous lancer dans le vif du sujet, voyons ce qu'implique réellement une configuration manuelle. Cette approche vous donne un contrôle total, mais elle nécessite des ressources dédiées.

Voici un bref aperçu de ce dont vous aurez besoin :

-

Un environnement de développement : Vous travaillerez probablement en Python, car c'est un choix populaire pour les applications d'IA.

-

Des SDK et bibliothèques OpenTelemetry : Vous devrez installer ces paquets pour que votre code commence à enregistrer ce qu'il fait.

-

Un backend d'observabilité : C'est un outil où vous envoyez toutes vos données pour les visualiser et les analyser. Pensez à des outils comme Jaeger (qui est open-source) ou Datadog.

-

Du temps de développement : Ce n'est pas une tâche que l'on fait une fois pour toutes. Il faut un réel effort d'ingénierie pour mettre en œuvre, maintenir et véritablement donner un sens aux données que vous collectez.

Cette charge technique est une raison majeure pour laquelle de nombreuses équipes optent simplement pour une plateforme gérée. Un outil comme eesel AI se connecte directement à votre service d'assistance, que ce soit Zendesk ou Freshdesk, en quelques minutes seulement. Il vous fournit des informations riches et axées sur le support sans que vous ayez à écrire une seule ligne de code.

Un guide étape par étape

Très bien, entrons dans les détails techniques de l'instrumentation de votre IA de support. L'objectif principal ici est de créer un enregistrement détaillé, appelé une "trace", qui suit une seule demande client du tout début à la toute fin.

Étape 1 : Configurer l'environnement

Tout d'abord, vous devez configurer le framework OpenTelemetry de base au sein de votre application. Cela signifie mettre en place trois composants principaux :

-

Un Tracer Provider : C'est essentiellement l'usine qui crée des "traceurs" dans votre application. Considérez-le comme le moteur principal qui alimente toute votre collecte de données.

-

Un Exporter : Cette partie est responsable de l'envoi de vos données à votre backend d'observabilité. C'est le pipeline qui déplace les informations de votre application vers un endroit où vous pouvez réellement les consulter.

-

Un Span Processor : Ce composant gère le cycle de vie de vos "spans" (qui sont les étapes individuelles d'une trace) et les transmet à l'exportateur. Il garantit que chaque donnée est traitée correctement.

En gros, votre code initialisera ces composants afin que votre application soit toujours prête à capturer et à envoyer des données de télémétrie. Vous pouvez également configurer un Collecteur OpenTelemetry, un service distinct qui collecte, traite et exporte les données. Cela peut rendre le code de votre application un peu plus propre en lui retirant une partie du travail de traitement des données.

Étape 2 : Instrumenter le flux de travail

Une fois votre environnement prêt, il est temps de commencer à ajouter le traçage à la logique de votre IA. Une trace représente le parcours complet d'un ticket de support, et un span représente une étape unique au sein de ce parcours. Imaginez-le comme une chronologie avec des événements spécifiques et étiquetés.

Par exemple, suivons une demande de support classique : "Quel est le statut de ma commande ?"

Votre IA pourrait passer par quelques étapes pour répondre à cela :

-

Recevoir et comprendre le ticket entrant.

-

Déterminer que l'intention de l'utilisateur est une "demande de statut de commande".

-

Appeler une API interne pour récupérer les détails de la commande.

-

Utiliser un Grand Modèle de Langage (LLM) pour rédiger une réponse amicale et humaine.

-

Mettre à jour le ticket avec la réponse et le fermer.

Chacune de ces actions devrait être enveloppée dans son propre span. Cela crée une structure parent-enfant claire qui vous permet de visualiser l'ensemble du flux de travail et de voir exactement combien de temps chaque étape a pris. En décomposant le processus de cette manière, vous pouvez immédiatement repérer les points de ralentissement ou de rupture.

Étape 3 : Capturer les attributs et les métriques

Le simple traçage du flux de travail est un bon début, mais ce n'est pas suffisant. Pour en tirer une réelle valeur, vous devez ajouter du contexte à vos spans avec des données appelées attributs. Heureusement, il existe des conventions sémantiques émergentes pour la GenAI d'OpenTelemetry qui vous donnent une manière standard de nommer ces choses. Pour une IA de support, vous voulez suivre à la fois les détails techniques et les informations pertinentes pour l'entreprise.

Voici quelques attributs clés que vous devriez capturer :

-

Paramètres du modèle : "llm.model.name", "llm.temperature"

-

Utilisation des jetons : "llm.usage.prompt_tokens", "llm.usage.completion_tokens" (celui-ci est énorme pour garder un œil sur les coûts)

-

Appels d'outils : "tool.name", "tool.input", "tool.output"

-

Contexte métier : "customer.id", "ticket.id", "ticket.tags"

Lorsque vous capturez ce type de données, vous passez de la simple surveillance des performances à la réponse à des questions commerciales importantes. Au lieu de savoir simplement si une réponse a été lente, vous pouvez comprendre pourquoi elle a été lente et ce que cela signifie pour vos clients.

| Attribut technique | Question commerciale à laquelle il répond |

|---|---|

| "llm.usage.total_tokens" | Combien dépensons-nous en moyenne pour résoudre un ticket ? |

| "tool.call.duration" | Nos propres API internes sont-elles la cause de la lenteur des réponses du support ? |

| "response.success" (personnalisé) | À quelle fréquence l'IA résout-elle réellement les problèmes au lieu de simplement les escalader ? |

| "knowledge.source.used" (personnalisé) | Lesquels de nos articles d'aide sont vraiment utiles, et lesquels ne le sont pas ? |

Étape 4 : Utiliser les données de traçage pour améliorer votre IA

Une fois que vos données affluent dans votre outil d'observabilité, vous pouvez commencer à creuser pour diagnostiquer les problèmes et trouver des moyens de vous améliorer. C'est là que la configuration porte vraiment ses fruits.

-

Débogage des réponses lentes : Une longue trace rend évident quel span est le goulot d'étranglement. Si le span "tool.call:lookup_order" prend cinq secondes, vous savez que le problème n'est pas le LLM, mais votre système de commande interne. Vous maintenant exactement où concentrer vos efforts.

-

Enquête sur les réponses incorrectes : En examinant les attributs "llm.prompt" et "llm.completion", vous pouvez voir les informations exactes qui ont été données à l'IA et ce qu'elle a produit. Vous pourriez découvrir que le contexte qu'elle a tiré de votre base de connaissances était obsolète, ce qui l'a amenée à "halluciner". Cela vous permet de corriger la cause profonde au lieu de simplement panser les symptômes.

-

Trouver les lacunes dans les connaissances : Si vous enregistrez chaque fois que l'IA ne trouve pas de réponse, vous pouvez repérer les tendances assez rapidement. Un tas de logs liés à "comment obtenir un remboursement" est un signal clair que vous devez rédiger ou améliorer votre documentation sur ce sujet. Votre IA de support devient un outil qui vous aide de manière proactive à améliorer vos ressources de libre-service.

Conseils de pro et erreurs courantes à éviter

La mise en place de la journalisation et du traçage pour l'IA de support avec OpenTelemetry peut être un peu délicate. Voici quelques conseils pour vous aider et quelques pièges courants à surveiller.

-

Erreur courante n°1 : Suivre uniquement la latence. Il est facile de se focaliser sur la vitesse, mais la précision et l'efficacité sont ce qui compte vraiment. Créez des attributs personnalisés pour suivre des éléments tels que le succès de la résolution, les taux d'escalade et même les scores de satisfaction client liés aux interactions de l'IA. L'objectif est un meilleur support, pas seulement des réponses plus rapides.

-

Erreur courante n°2 : Sous-estimer la complexité. Une configuration manuelle d'OpenTelemetry n'est pas quelque chose que l'on peut simplement mettre en place et oublier. Elle nécessite une maintenance régulière à mesure que votre application d'IA grandit et évolue. Le vrai travail ne consiste pas seulement à collecter les données ; il s'agit de créer les tableaux de bord et les alertes qui transforment ces données en quelque chose sur lequel vous pouvez réellement agir.

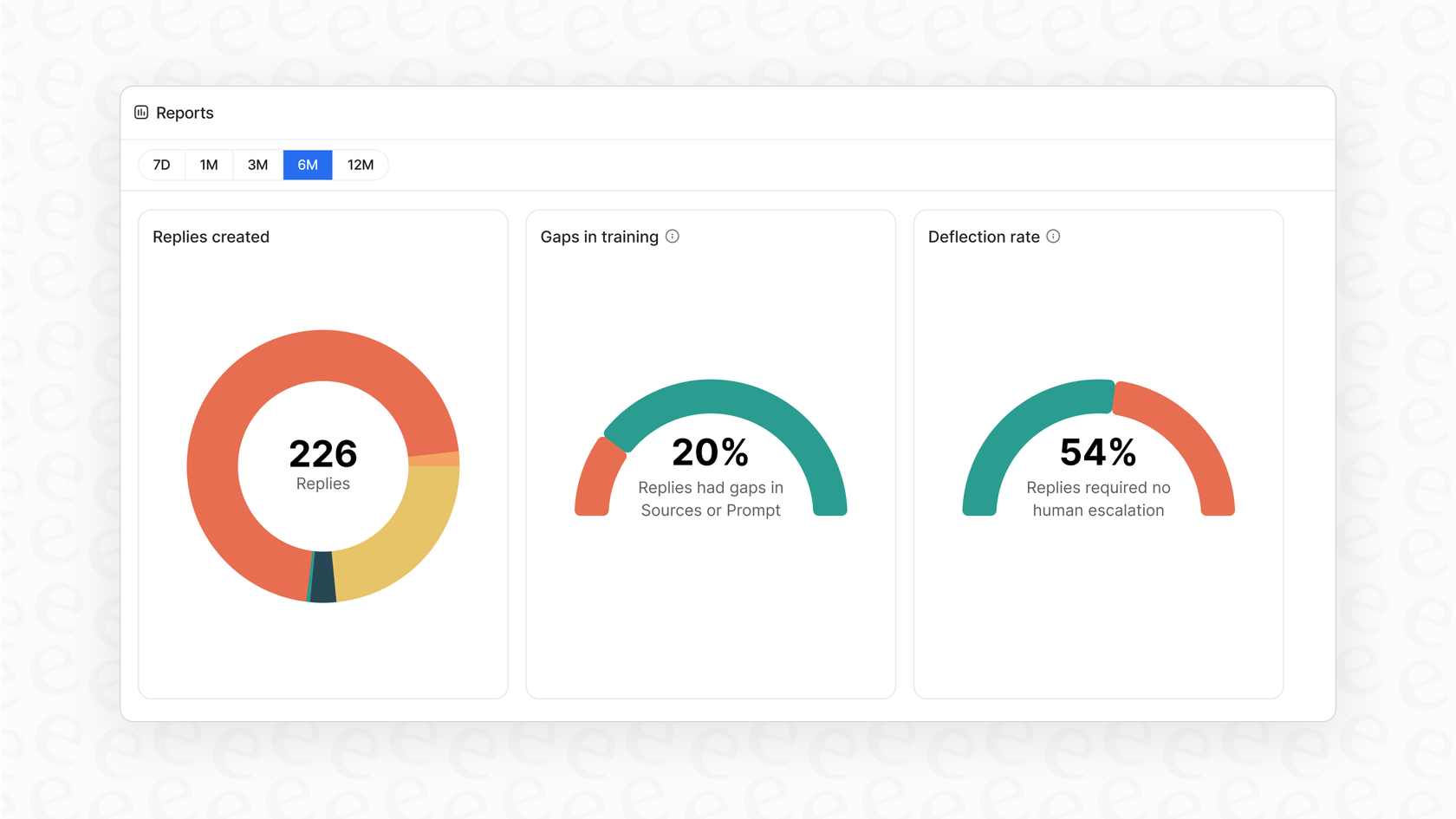

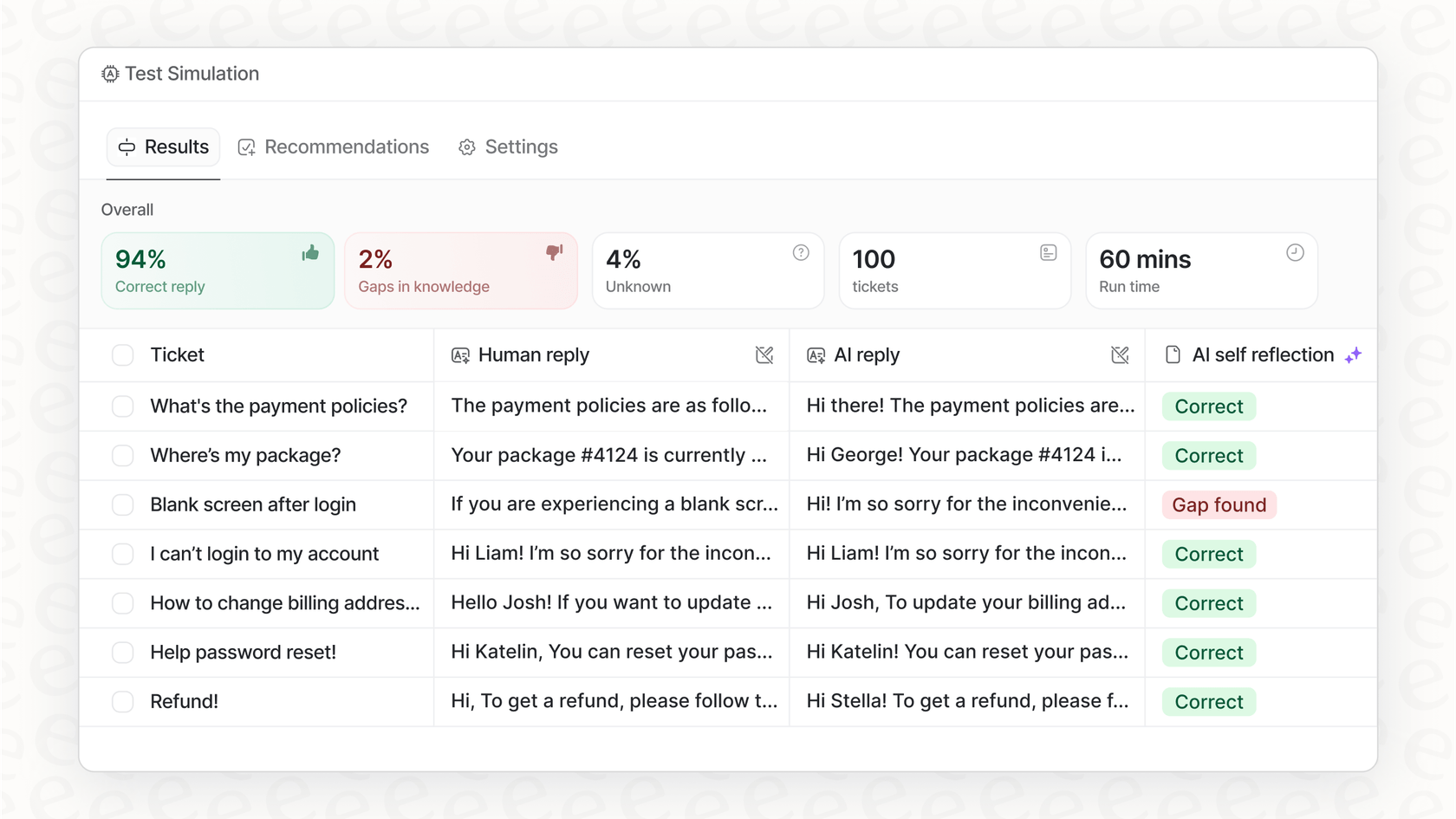

C'est là qu'une plateforme gérée offre une tonne de valeur. Des solutions comme eesel AI sont déjà configurées pour capturer les données les plus importantes spécifiques au support. Au lieu de créer des tableaux de bord à partir de zéro, vous obtenez des rapports qui signalent automatiquement les lacunes dans les connaissances et vous montrent les meilleures opportunités d'automatisation.

Des données complexes aux informations claires

Mettre en place OpenTelemetry est un excellent moyen d'ouvrir la boîte noire de votre IA de support. Cela vous permet de tracer chaque demande, de mesurer les performances, de maîtriser les coûts et, finalement, de construire un système plus fiable et efficace. Mais, comme nous l'avons vu, le faire soi-même représente un investissement sérieux en temps d'ingénierie et en maintenance continue.

Obtenez une observabilité IA prête à l'emploi avec eesel AI

Si vous voulez tous les avantages d'une observabilité IA approfondie sans les maux de tête, eesel AI a été conçu pour vous. Notre plateforme est livrée avec une journalisation et un traçage complets intégrés, spécialement conçus pour les équipes de support client. Vous pouvez simuler les performances sur des tickets historiques pour voir votre retour sur investissement potentiel, obtenir des rapports exploitables sur les lacunes dans les connaissances et être opérationnel en quelques minutes, pas en quelques mois.

Prêt à voir de quoi votre IA de support est vraiment capable ? Commencez votre essai gratuit dès aujourd'hui.

Questions fréquemment posées

Cela transforme votre IA de support d'une boîte noire en un système transparent, vous permettant de comprendre ses actions. Cette visibilité est cruciale pour déboguer les problèmes, identifier les goulots d'étranglement et garantir des performances fiables et une rentabilité.

Vous aurez principalement besoin d'un Tracer Provider pour créer des traceurs, d'un Exporter pour envoyer les données à votre backend d'observabilité, et d'un Span Processor pour gérer le cycle de vie des spans. Un Collecteur OpenTelemetry optionnel peut également simplifier le traitement des données.

Au-delà des traces de flux de travail de base, capturez des attributs tels que les paramètres du modèle LLM, l'utilisation des jetons, les appels d'outils et le contexte métier (par exemple, l'ID client, les étiquettes de ticket). Ceux-ci fournissent un contexte crucial pour une analyse et une compréhension plus approfondies.

Cela vous permet de déboguer les réponses lentes en identifiant les goulots d'étranglement, d'enquêter sur les réponses incorrectes en examinant les prompts et les complétions, et de repérer les lacunes dans les connaissances en suivant les interactions infructueuses de l'IA. Ces données permettent des améliorations ciblées et basées sur les données.

Une configuration manuelle nécessite un temps de développement considérable pour la mise en œuvre initiale, la maintenance continue et la création de tableaux de bord personnalisés pour l'analyse. Elle vous donne un contrôle total mais exige un effort d'ingénierie dédié et soutenu.

Oui, les plateformes gérées comme eesel AI offrent une observabilité intégrée spécialement conçue pour l'IA de support. Elles gèrent la complexité sous-jacente, fournissant des informations et des rapports prêts à l'emploi sans nécessiter de configuration manuelle ou de code personnalisé.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.