Así que has lanzado una IA de soporte. Es un gran paso. Pero ahora probablemente te estés preguntando qué está haciendo realmente. Cuando un cliente obtiene una respuesta lenta o simplemente incorrecta, descubrir por qué puede ser como buscar una aguja en un pajar. ¿Es el modelo de lenguaje teniendo un mal día, una llamada a la API lenta o un punto ciego en tu base de conocimientos? Sin una forma de ver su interior, tu IA de soporte es solo una caja negra.

Aquí es donde la observabilidad resulta útil. Usando un estándar de código abierto llamado OpenTelemetry, puedes seguir cada movimiento que hace tu IA, desde el momento en que toma un ticket hasta que envía una respuesta. Esta guía te explicará el proceso manual para configurar el registro y el seguimiento (logging and tracing) para una IA de soporte con OpenTelemetry. Cubriremos las ideas principales y los pasos prácticos para que puedas empezar.

Seré honesto, este proceso requiere bastante trabajo técnico, pero es indispensable para construir una IA en la que puedas confiar. Por supuesto, si prefieres saltarte el trabajo manual, plataformas como eesel AI se encargan de toda esta complejidad por ti, para que puedas centrarte en la experiencia de tus clientes en lugar de en tus pipelines de telemetría.

Recurso 1: [Flujo de trabajo], un diagrama que ilustra cómo funciona OpenTelemetry para el registro y seguimiento de una IA de soporte con OpenTelemetry.

Lo que necesitarás para una configuración manual

Antes de pasar a la parte práctica, hablemos de lo que realmente implica una configuración manual. Esta ruta te da un control total, pero requiere algunos recursos dedicados.

Aquí tienes un resumen rápido de lo que necesitarás:

-

Un entorno de desarrollo: Probablemente trabajarás en Python, ya que es una opción popular para las aplicaciones de IA.

-

SDKs y bibliotecas de OpenTelemetry: Necesitarás instalar estos paquetes para que tu código comience a registrar lo que está haciendo.

-

Un backend de observabilidad: Esta es una herramienta a la que envías todos tus datos para ser visualizados y analizados. Piensa en herramientas como Jaeger (que es de código abierto) o Datadog.

-

Tiempo de desarrollo: Esta no es una tarea que se hace una vez y ya está. Requiere un esfuerzo de ingeniería real para implementar, mantener y realmente dar sentido a los datos que estás recopilando.

Esa sobrecarga técnica es una gran razón por la que muchos equipos simplemente optan por una plataforma gestionada. Una herramienta como eesel AI se conecta directamente a tu helpdesk, ya sea Zendesk o Freshdesk, en cuestión de minutos. Te proporciona información valiosa y centrada en el soporte sin que tengas que escribir una sola línea de código.

Una guía paso a paso

Muy bien, entremos en materia sobre cómo instrumentar tu IA de soporte. El objetivo principal aquí es crear un registro detallado, llamado "traza" (trace), que sigue una única solicitud de un cliente desde el principio hasta el final.

Paso 1: Configurar el entorno

Lo primero es lo primero, necesitas configurar el marco básico de OpenTelemetry dentro de tu aplicación. Esto significa configurar tres componentes principales:

-

Un Proveedor de Trazas (Tracer Provider): Esencialmente, es la fábrica que crea "trazadores" (tracers) en tu aplicación. Piénsalo como el motor principal que impulsa toda tu recopilación de datos.

-

Un Exportador (Exporter): Esta parte es responsable de enviar tus datos a tu backend de observabilidad. Es el pipeline que mueve la información desde tu aplicación a un lugar donde realmente puedas verla.

-

Un Procesador de Spans (Span Processor): Este componente gestiona el ciclo de vida de tus "spans" (que son los pasos individuales en una traza) y los entrega al exportador. Se asegura de que cada pieza de datos se maneje correctamente.

Básicamente, tu código inicializará estos componentes para que tu aplicación esté siempre lista para capturar y enviar datos de telemetría. También puedes configurar un Recolector de OpenTelemetry (OpenTelemetry Collector), un servicio separado que recopila, procesa y exporta datos. Esto puede hacer que el código de tu aplicación sea un poco más limpio al quitarle parte del trabajo de procesamiento de datos.

Paso 2: Instrumentar el flujo de trabajo

Con tu entorno listo, es hora de empezar a añadir el seguimiento a la lógica de tu IA. Una traza (trace) representa el recorrido completo de un ticket de soporte, y un span representa un único paso dentro de ese recorrido. Imagínalo como una línea de tiempo con eventos específicos y etiquetados.

Por ejemplo, sigamos una solicitud de soporte clásica: "¿Cuál es el estado de mi pedido?"

Tu IA podría pasar por varios pasos para responder a esto:

-

Recibir y entender el ticket entrante.

-

Determinar que la intención del usuario es "consulta de estado del pedido".

-

Llamar a una API interna para obtener los detalles del pedido.

-

Usar un Modelo de Lenguaje Grande (LLM) para escribir una respuesta amigable y con un tono humano.

-

Actualizar el ticket con la respuesta y cerrarlo.

Cada una de estas acciones debería estar envuelta en su propio span. Esto crea una estructura clara de padre-hijo que te permite visualizar todo el flujo de trabajo y ver exactamente cuánto tiempo tardó cada paso. Al desglosar el proceso de esta manera, puedes detectar inmediatamente dónde las cosas se están ralentizando o fallando.

Recurso 2: [Flujo de trabajo], un gráfico de Mermaid que muestra una traza con múltiples spans para una solicitud de ticket de soporte.

Paso 3: Capturar atributos y métricas

Solo trazar el flujo de trabajo es un buen comienzo, pero no es suficiente. Para obtener un valor real, necesitas añadir contexto a tus spans con datos conocidos como atributos. Afortunadamente, existen algunas convenciones semánticas emergentes para GenAI de OpenTelemetry que te dan una forma estándar de nombrar estas cosas. Para una IA de soporte, querrás rastrear tanto los detalles técnicos como la información que sea relevante para el negocio.

Aquí tienes algunos atributos clave que deberías estar capturando:

-

Parámetros del modelo:

llm.model.name,llm.temperature -

Uso de tokens:

llm.usage.prompt_tokens,llm.usage.completion_tokens(este es muy importante para vigilar los costos) -

Llamadas a herramientas:

tool.name,tool.input,tool.output -

Contexto de negocio:

customer.id,ticket.id,ticket.tags

Cuando capturas este tipo de datos, puedes pasar de simplemente monitorear el rendimiento a responder preguntas de negocio importantes. En lugar de solo saber si una respuesta fue lenta, puedes entender por qué fue lenta y qué significa eso para tus clientes.

| Atributo Técnico | Pregunta de Negocio que Responde |

|---|---|

llm.usage.total_tokens | ¿Cuánto estamos gastando en promedio para resolver un ticket? |

tool.call.duration | ¿Son nuestras propias APIs internas la razón por la que las respuestas de soporte son lentas? |

response.success (personalizado) | ¿Con qué frecuencia la IA realmente resuelve problemas en lugar de simplemente escalarlos? |

knowledge.source.used (personalizado) | ¿Cuáles de nuestros artículos de ayuda son realmente útiles y cuáles no? |

Paso 4: Usar los datos de seguimiento para mejorar tu IA

Una vez que tus datos fluyen hacia tu herramienta de observabilidad, puedes empezar a investigar para diagnosticar problemas y encontrar formas de mejorar. Aquí es donde la configuración realmente vale la pena.

-

Depurar Respuestas Lentas: Una traza larga hace evidente qué span es el cuello de botella. Si el span

tool.call:lookup_orderestá tardando cinco segundos, sabes que el problema no es el LLM, es tu sistema interno de pedidos. Ahora sabes exactamente dónde centrar tus esfuerzos. -

Investigar Respuestas Incorrectas: Al observar los atributos

llm.promptyllm.completion, puedes ver la información exacta que se le dio a la IA y lo que generó. Podrías descubrir que el contexto que extrajo de tu base de conocimientos estaba desactualizado, lo que la hizo "alucinar". Esto te permite solucionar la causa raíz en lugar de simplemente parchear los síntomas. -

Encontrar Brechas de Conocimiento: Si registras cada vez que la IA no puede encontrar una respuesta, puedes detectar tendencias rápidamente. Un montón de registros relacionados con "cómo obtener un reembolso" es una señal clara de que necesitas escribir o mejorar tu documentación sobre ese tema. Tu IA de soporte se convierte en una herramienta que te ayuda proactivamente a mejorar tus recursos de autoservicio.

Consejos profesionales y errores comunes a evitar

Configurar el registro y el seguimiento para una IA de soporte con OpenTelemetry puede ser un poco complicado. Aquí tienes un par de consejos para ayudarte y algunos errores comunes que debes evitar.

-

Error Común #1: Solo rastrear la latencia. Es fácil obsesionarse con la velocidad, pero la precisión y la eficacia son lo que realmente importa. Crea atributos personalizados para rastrear cosas como el éxito en la resolución, las tasas de escalado e incluso las puntuaciones de satisfacción del cliente vinculadas a las interacciones de la IA. El objetivo es un mejor soporte, no solo respuestas más rápidas.

-

Error Común #2: Subestimar la complejidad. Una configuración manual de OpenTelemetry no es algo que puedas configurar y olvidar. Necesita un mantenimiento regular a medida que tu aplicación de IA crece y cambia. El verdadero trabajo no es solo recopilar los datos, sino construir los paneles y alertas que convierten esos datos en algo sobre lo que realmente puedes actuar.

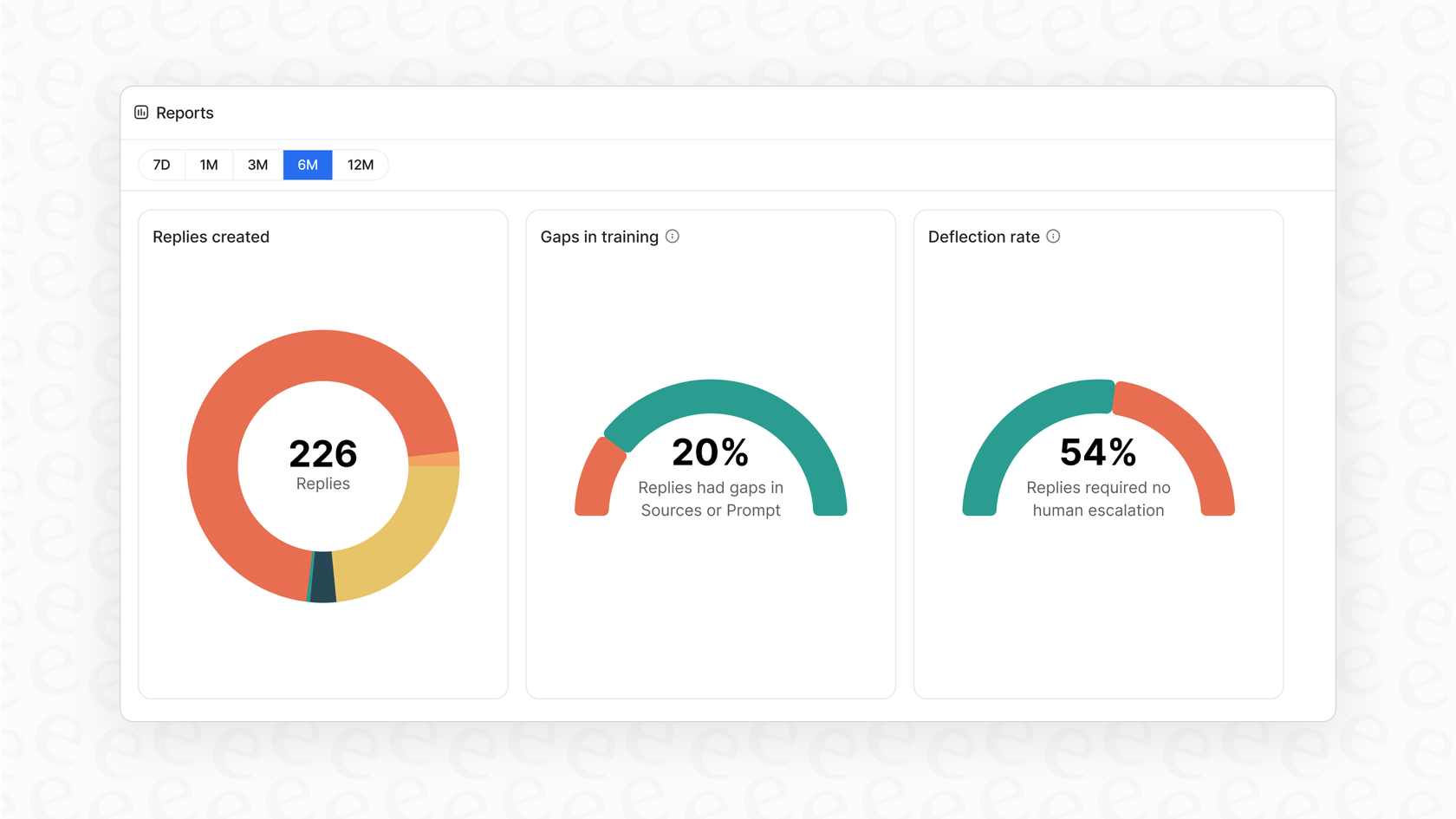

Aquí es donde una plataforma gestionada ofrece un gran valor. Soluciones como eesel AI ya están configuradas para capturar los datos más importantes específicos del soporte. En lugar de construir paneles desde cero, obtienes informes que señalan automáticamente las brechas de conocimiento y te muestran las mejores oportunidades para la automatización.

De datos complejos a información clara

Implementar OpenTelemetry es una excelente manera de abrir la caja negra de tu IA de soporte. Te permite rastrear cada solicitud, medir el rendimiento, mantener los costos bajo control y, en última instancia, construir un sistema más fiable y eficaz. Pero, como hemos visto, hacerlo todo por tu cuenta es una inversión seria en tiempo de ingeniería y mantenimiento continuo.

Obtén observabilidad de IA lista para usar con eesel AI

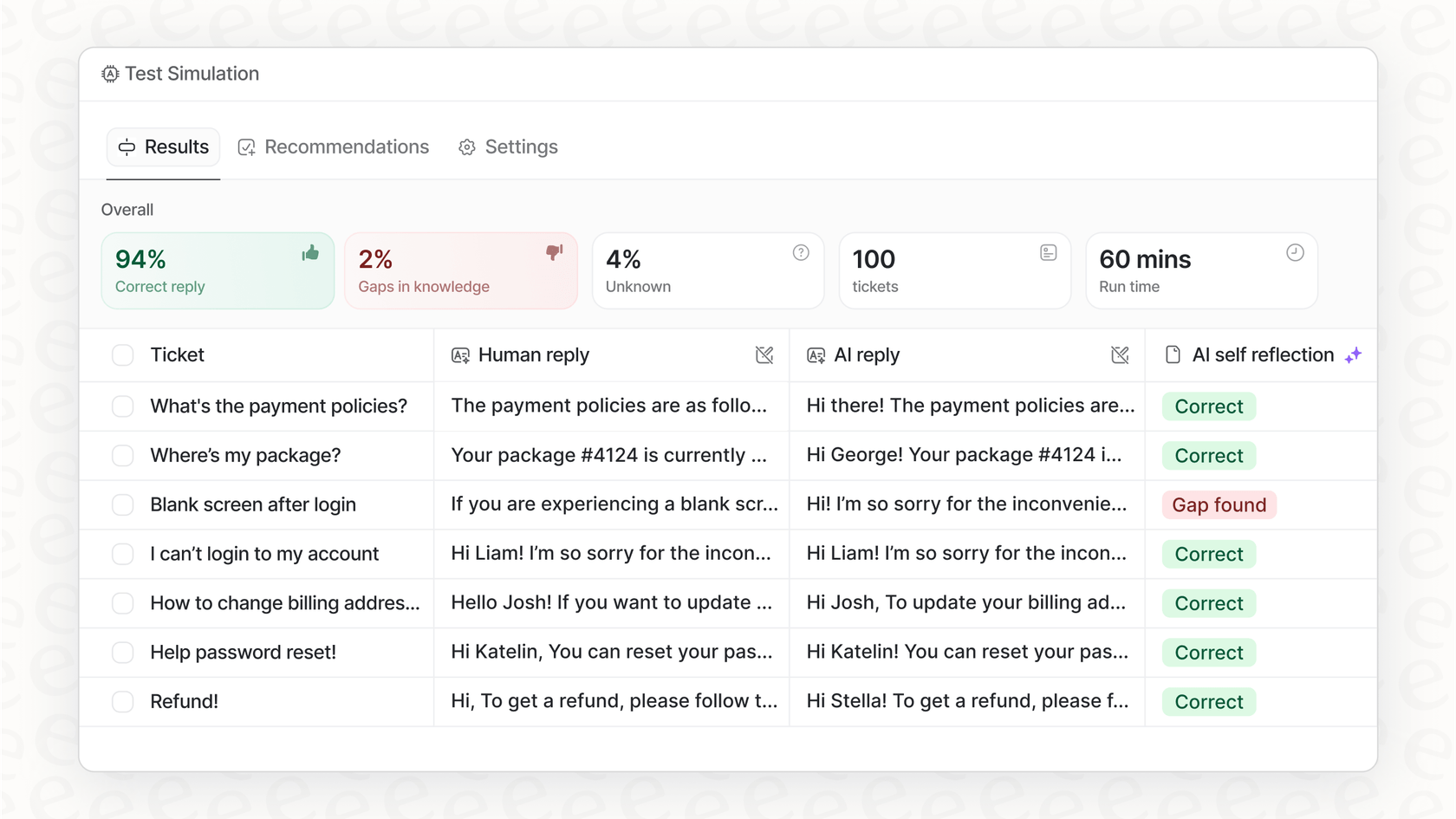

Si quieres todos los beneficios de una profunda observabilidad de IA sin el dolor de cabeza, eesel AI fue creado para ti. Nuestra plataforma viene con un completo sistema de registro y seguimiento integrado, diseñado específicamente para equipos de soporte al cliente. Puedes simular el rendimiento en tickets históricos para ver tu potencial ROI, obtener informes procesables sobre brechas de conocimiento y lanzar en minutos, no en meses.

¿Listo para ver de lo que es realmente capaz tu IA de soporte? Comienza tu prueba gratuita hoy.

Preguntas frecuentes

Transforma tu IA de soporte de una caja negra en un sistema transparente, permitiéndote entender sus acciones. Esta visibilidad es crucial para depurar problemas, identificar cuellos de botella y asegurar un rendimiento fiable y una eficiencia de costos.

Principalmente necesitarás un Proveedor de Trazas (Tracer Provider) para crear trazadores, un Exportador (Exporter) para enviar datos a tu backend de observabilidad, y un Procesador de Spans (Span Processor) para gestionar los ciclos de vida de los spans. Un Recolector de OpenTelemetry (OpenTelemetry Collector) opcional también puede simplificar el procesamiento de datos.

Más allá de las trazas básicas del flujo de trabajo, captura atributos como los parámetros del modelo LLM, el uso de tokens, las llamadas a herramientas y el contexto de negocio (por ejemplo, ID de cliente, etiquetas de ticket). Estos proporcionan un contexto crucial para un análisis y una comprensión más profundos.

Te permite depurar respuestas lentas identificando cuellos de botella, investigar respuestas incorrectas revisando las indicaciones (prompts) y las finalizaciones (completions), y detectar brechas de conocimiento rastreando las interacciones fallidas de la IA. Estos datos permiten mejoras específicas y basadas en datos.

Una configuración manual requiere un tiempo de desarrollo significativo para la implementación inicial, el mantenimiento continuo y la creación de paneles personalizados para el análisis. Te da control total, pero exige un esfuerzo de ingeniería dedicado y sostenido.

Sí, las plataformas gestionadas como eesel AI ofrecen observabilidad integrada diseñada específicamente para la IA de soporte. Se encargan de la complejidad subyacente, proporcionando información e informes listos para usar sin necesidad de configuración manual o código personalizado.

Compartir esta entrada

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.