Sejamos honestos, o burburinho em torno da IA generativa está por toda a parte. Mas, para a maioria das empresas, essa empolgação pára abruptamente quando chega a hora de construir algo de verdade. Transformar um protótipo de IA interessante numa aplicação real em que os clientes possam confiar é um salto enorme. De repente, passa a preocupar-se com o desempenho, a fiabilidade e os custos que podem disparar sem aviso.

Construir e escalar uma aplicação de IA não é apenas complicado; requer uma base especializada para funcionar corretamente. Este é exatamente o problema que a Fireworks AI foi criada para resolver. É uma plataforma projetada para lidar com todo o trabalho pesado do lado da infraestrutura, para que os programadores possam parar de lutar com servidores e focar-se em criar excelentes produtos de IA.

Neste artigo, vamos guiá-lo por tudo o que precisa de saber sobre a Fireworks AI. Analisaremos as suas funcionalidades principais, explicaremos os seus preços e falaremos sobre a quem realmente se destina. Também abordaremos as suas limitações e exploraremos por que, para algumas equipas, um tipo de ferramenta de IA completamente diferente pode ser uma opção muito melhor.

O que é a Fireworks AI?

No seu âmago, a Fireworks AI é uma plataforma para construir e executar aplicações de IA generativa numa biblioteca massiva de modelos de código aberto. Pense nela como o motor de alto desempenho de uma aplicação de IA. Ela trata de toda a infraestrutura complicada nos bastidores, para que os programadores se possam concentrar no que a sua aplicação realmente faz.

O historial da empresa diz muito sobre a sua competência técnica. Foi fundada por alguns dos inovadores originais da Meta AI que ajudaram a criar o PyTorch, uma das frameworks de IA de código aberto mais populares do mundo. De acordo com um artigo no blogue da Google Cloud, os fundadores sabiam que as empresas teriam dificuldades em implementar IA em grande escala e viram uma oportunidade para ajudar.

A principal proposta da Fireworks AI é fornecer "o motor de inferência de IA generativa mais rápido e eficiente até à data". Em linguagem simples, eles fornecem a velocidade e a potência brutas necessárias para executar modelos de IA complexos sem fazer os seus utilizadores esperar. É importante lembrar que a Fireworks AI é uma camada de infraestrutura, não um produto final. Os programadores usam a sua API para potenciar as suas próprias ferramentas, seja um bot de apoio ao cliente, um assistente de programação ou um motor de busca para toda a empresa.

Funcionalidades principais da Fireworks AI

A plataforma Fireworks AI baseia-se em três ideias principais que suportam toda a jornada de um modelo de IA, desde uma simples experiência até servir milhões de pessoas.

Um motor de inferência ultrarrápido

Então, o que é exatamente um "motor de inferência"? É o sistema que pega num modelo de IA treinado e o executa para gerar uma resposta, como responder a uma pergunta ou criar uma imagem. A velocidade desse motor é tudo para uma aplicação em tempo real. Ninguém quer usar um chatbot que demora dez segundos a responder.

A Fireworks AI construiu a sua reputação com base na rapidez (baixa latência) e na capacidade de lidar com uma grande quantidade de pedidos ao mesmo tempo (alto débito). Eles processam mais de 140 mil milhões de tokens todos os dias e mantêm um tempo de atividade da API de 99,99%, o que significa que as aplicações dos seus clientes são consistentemente responsivas e fiáveis. Conseguem isto com software altamente otimizado a correr no hardware mais recente, como GPUs NVIDIA de topo de gama.

Uma enorme biblioteca de modelos de código aberto

Uma das melhores coisas da Fireworks AI é o seu compromisso com a comunidade de código aberto. Em vez de o prenderem ao seu próprio modelo proprietário, dão-lhe acesso instantâneo a uma biblioteca massiva de modelos populares de código aberto. Isto dá aos programadores a liberdade de escolher o modelo perfeito para o seu projeto, ajustá-lo e evitar ficar preso a um único fornecedor.

Pode encontrar modelos conhecidos como o Llama 3 da Meta, o Gemma da Google, o Mixtral 8x22B e o Qwen, todos prontos a usar com uma simples chamada de API. Isto poupa-lhe a enorme dor de cabeça de descarregar, configurar e gerir as potentes GPUs necessárias para executar estes modelos por si mesmo.

Gestão completa do ciclo de vida do modelo de IA

A Fireworks AI oferece ferramentas para cada passo do processo de construção:

-

Construir: Os programadores podem passar de uma ideia a um modelo funcional em apenas alguns minutos. A plataforma configura toda a infraestrutura de GPU, para que possa começar a experimentar prompts e a obter resultados imediatamente.

-

Ajustar: Pode usar um processo chamado fine-tuning para treinar um modelo base com os seus próprios dados. Isto ajuda a IA a aprender a gíria específica da sua empresa, a voz da marca ou o conhecimento interno, o que leva a respostas muito melhores e mais relevantes.

-

Escalar: À medida que a sua aplicação se torna mais popular, a Fireworks AI trata da escalabilidade por si. Não importa se tem dez ou dez milhões de utilizadores; a infraestrutura adiciona automaticamente mais recursos para lidar com picos de tráfego sem que tenha de fazer nada.

Preços da Fireworks AI explicados

A Fireworks AI tem um modelo de preços bastante flexível, baseado no uso, que funciona para todos, desde um programador a solo a experimentar num fim de semana até uma grande empresa com sérias necessidades de IA. Os seus preços, que retirámos da sua página oficial de preços, dividem-se em três tipos principais.

Preços de inferência Serverless

Este é um plano de pagamento por utilização direto, onde é cobrado por "token" (um pedaço de texto, com cerca de quatro caracteres) que a IA processa. É uma ótima maneira de começar, construir protótipos ou executar aplicações com tráfego imprevisível, porque paga apenas pelo que utiliza.

Aqui está uma visão rápida dos seus preços serverless para alguns modelos populares:

| Categoria de Modelo Base | Preço por 1M de Tokens |

|---|---|

| Menos de 4B de parâmetros | $0.10 |

| 4B - 16B de parâmetros | $0.20 |

| Mais de 16B de parâmetros | $0.90 |

| MoE 56.1B - 176B de parâmetros | $1.20 |

| Meta Llama 3.1 405B | $3.00 |

| Kimi K2 Instruct | $0.60 de entrada, $2.50 de saída |

É bom saber que, para alguns dos modelos mais avançados, o preço dos tokens de entrada (o que envia para a IA) pode ser diferente do preço dos tokens de saída (o que a IA envia de volta).

Preços de fine-tuning

Este preço aplica-se quando quer personalizar um modelo com os seus próprios dados. É cobrado com base no número de tokens utilizados durante o trabalho de treino. Depois de o seu modelo ser ajustado (fine-tuned), paga a mesma taxa para o executar que pagaria pelo modelo base original.

| Tamanho do Modelo Base | Preço por 1M de Tokens de Treino |

|---|---|

| Até 16B de parâmetros | $0.50 |

| 16.1B - 80B de parâmetros | $3.00 |

| >300B de parâmetros | $10.00 |

Preços On-Demand

Para aplicações que precisam de um desempenho consistente e intenso, a opção on-demand é geralmente a mais económica. Em vez de pagar por token, paga por segundo pelo acesso dedicado a uma GPU. Isto é perfeito para aplicações de alto volume, porque normalmente oferece melhor desempenho e custos mais baixos do que o plano serverless.

| Tipo de GPU | Preço por Hora (faturado por segundo) |

|---|---|

| GPU A100 80 GB | $2.90 |

| GPU H100 80 GB | $4.00 |

| GPU H200 141 GB | $6.00 |

Para quem é a Fireworks AI? (E para quem não é)

A Fireworks AI é uma plataforma seriamente poderosa, mas o seu foco intenso na infraestrutura significa que foi projetada para um público muito específico. Saber se pertence a esse grupo é a chave para decidir se é a escolha certa para si.

O utilizador ideal: Programadores de IA e empresas

O utilizador-alvo da Fireworks AI é bastante claro: startups focadas em IA, grandes empresas com equipas dedicadas de machine learning e qualquer programador que esteja a construir uma aplicação de IA personalizada de raiz.

A sua plataforma foi feita para potenciar coisas como:

-

Chatbots avançados e IA de apoio ao cliente

-

Ferramentas de geração de código e assistência ao programador

-

Pesquisa interna sofisticada e resumo de documentos

-

Agentes de IA complexos e com múltiplos passos

Estes utilizadores precisam do controlo detalhado, do desempenho bruto e da escalabilidade que uma plataforma como a Fireworks AI oferece. Eles sentem-se à vontade a trabalhar com APIs, a fazer fine-tuning de modelos e a ligar um motor de IA potente a um produto maior e construído à medida.

A principal limitação: Não é uma ferramenta pronta a usar para equipas de negócios

Esta é provavelmente a coisa mais importante a entender: a Fireworks AI é um motor, não um carro acabado. Dá-lhe toda a potência que poderia desejar, mas tem de construir o resto do veículo por si mesmo.

Isto significa que precisa de muita experiência técnica, tempo de desenvolvimento e orçamento para manutenção contínua. Um gestor de apoio ao cliente ou um líder de TI não pode simplesmente carregar num botão e ter a Fireworks AI a resolver os seus problemas. Simplesmente não foi construída para isso. É uma plataforma para programadores, não uma aplicação de negócios.

Para equipas de negócios que precisam de uma solução de IA agora, sem contratar um esquadrão de engenheiros, uma plataforma pronta a usar como a eesel AI é um caminho muito mais direto. Estas ferramentas foram construídas para um trabalho totalmente diferente: resolver problemas de negócios específicos logo à partida.

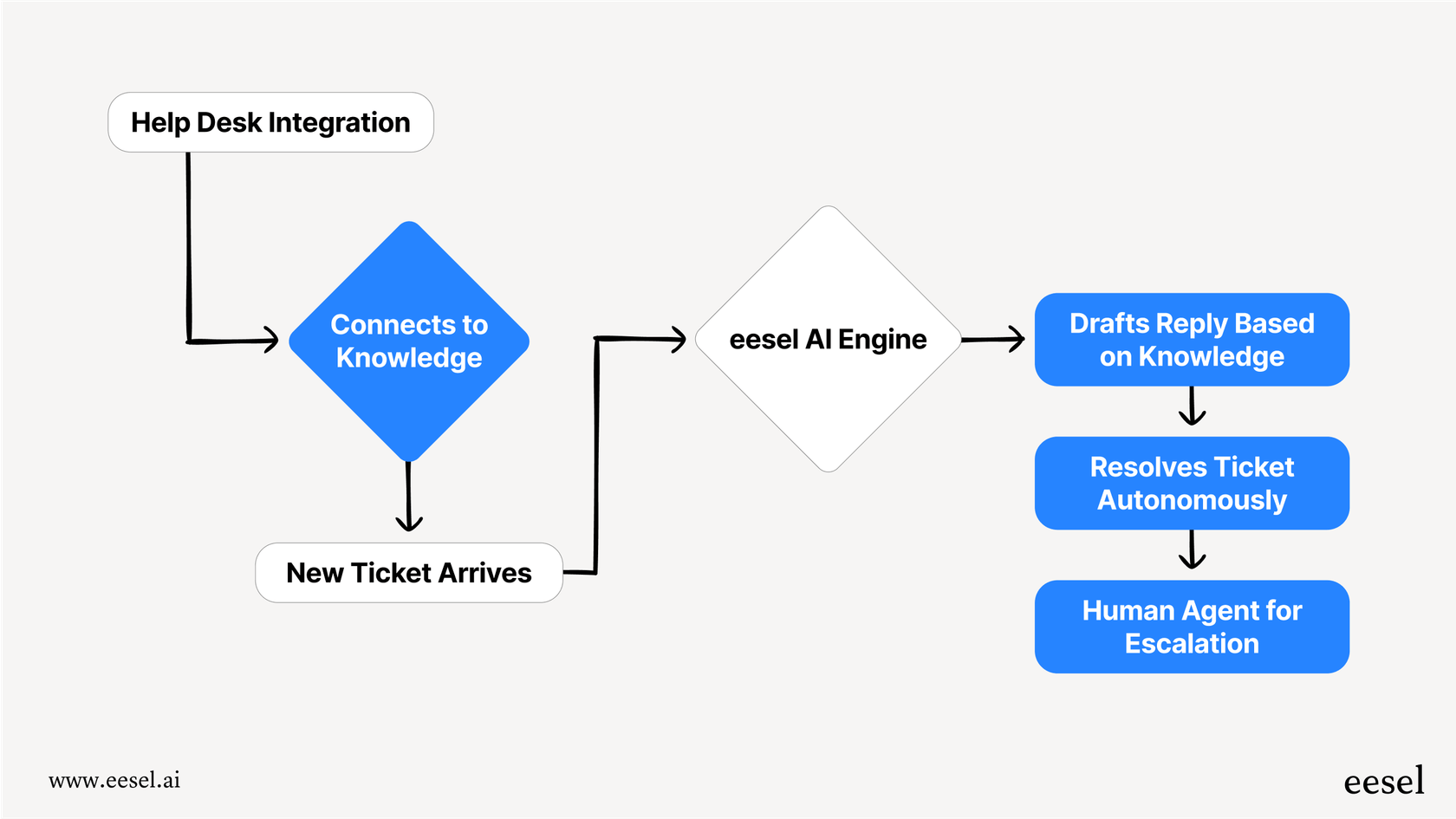

É aqui que uma ferramenta como a eesel AI se destaca:

-

Entre em funcionamento em minutos, não em meses. A eesel AI é totalmente self-service e tem integrações de um clique com as ferramentas que a sua equipa já utiliza, como Zendesk, Freshdesk e Slack. Pode ter um agente de IA funcional a responder a perguntas reais de clientes no tempo que leva a ler a documentação de uma API.

-

Não precisa de substituir tudo. Em vez de o forçar a construir algo novo, a eesel AI integra-se diretamente no seu help desk e fluxos de trabalho atuais. Apenas torna mais inteligentes as ferramentas que a sua equipa já sabe usar.

-

Concebida para utilizadores de negócios. A eesel AI foi criada especificamente para o serviço ao cliente e o suporte interno. Aprende automaticamente com os seus tickets de suporte anteriores, artigos do centro de ajuda e bases de conhecimento como o Confluence ou o Google Docs para dar respostas precisas e relevantes desde o primeiro dia.

Todo o processo é diferente. Com a Fireworks AI, um programador constrói uma aplicação personalizada usando uma API. Com a eesel AI, um gestor de suporte usa um painel simples para conectar as suas ferramentas e ligar a IA.

O nosso veredicto final sobre a Fireworks AI

A Fireworks AI é, sem dúvida, uma plataforma de infraestrutura de IA de primeira linha. Cumpre absolutamente a sua promessa de velocidade, escalabilidade e flexibilidade. Para programadores e empresas que constroem produtos de IA personalizados, é uma escolha fantástica.

Este vídeo explica como a Fireworks AI alcança a sua alta velocidade para aplicações de IA generativa.

Se tem uma equipa de engenharia e uma visão para uma ferramenta única alimentada por IA, a Fireworks AI dá-lhe o melhor motor da categoria para a concretizar. O seu desempenho e a sua biblioteca de modelos oferecem tudo o que precisa para construir algo especial.

No entanto, não é uma solução plug-and-play para departamentos de negócios como o apoio ao cliente ou TI. A complexidade e a perícia necessárias tornam-na a ferramenta errada para equipas que apenas querem automatizar o seu trabalho. Não compraria um motor de avião só para ir ao supermercado.

A conclusão é esta: escolha a Fireworks AI se está a construir o futuro da IA. Mas para resolver os seus problemas de negócios com IA hoje, procure uma ferramenta construída para o seu fluxo de trabalho específico.

Comece hoje com IA para apoio ao cliente

Escolher a ferramenta de IA certa depende apenas do seu objetivo. Se está a construir produtos de IA fundamentais que moldarão o mercado nos próximos anos, um motor como a Fireworks AI é indispensável.

Mas se o seu objetivo é automatizar o apoio ao cliente, ajudar os seus agentes e proporcionar aos seus clientes uma experiência melhor agora mesmo, então precisa de uma solução construída para esse fim. Para isso, a eesel AI foi concebida de raiz para lhe dar resultados sem escrever uma única linha de código.

Pode usar o seu modo de simulação para ver exatamente quantos dos seus tickets anteriores poderiam ter sido resolvidos automaticamente. Pode conectar todas as suas fontes de conhecimento dispersas em poucos cliques. E pode entrar em funcionamento com um agente de IA totalmente funcional que trabalha dentro do seu help desk existente em minutos, não em meses.

Perguntas frequentes

A Fireworks AI é uma plataforma de infraestrutura de alto desempenho concebida para construir e executar aplicações de IA generativa. Aborda as complexidades da implementação e escalonamento de modelos de IA, permitindo que os programadores se concentrem na criação da lógica da aplicação em vez de gerirem servidores.

A Fireworks AI fornece acesso a uma enorme biblioteca de modelos populares de código aberto, incluindo o Llama 3 da Meta, o Gemma da Google, o Mixtral 8x22B e o Qwen. Este compromisso com o código aberto dá aos programadores flexibilidade na escolha e personalização de modelos para os seus projetos.

A Fireworks AI utiliza um motor de inferência ultrarrápido, otimizado com software altamente eficiente e GPUs NVIDIA de topo de gama. Esta arquitetura garante baixa latência e alto débito, permitindo respostas em tempo real e o processamento de milhares de milhões de tokens diariamente.

Não, a Fireworks AI é principalmente uma camada de infraestrutura concebida para programadores de IA e equipas de machine learning empresariais. Requer conhecimentos técnicos para ser integrada através de APIs e para construir aplicações personalizadas, tornando-a inadequada para utilizadores de negócios não técnicos que procuram soluções prontas a usar.

A Fireworks AI oferece preços flexíveis baseados no uso, divididos em três modelos principais: inferência serverless (pague por token), fine-tuning (pague por token de treino) e on-demand (pague por segundo para acesso dedicado a GPUs). A melhor opção depende do seu volume de utilização e necessidades específicas.

Os programadores beneficiam de uma implementação significativamente mais rápida, acesso instantâneo a uma vasta biblioteca de modelos de código aberto e capacidades de escalonamento automático. A Fireworks AI abstrai as complexidades da gestão de GPUs e infraestrutura, permitindo que as equipas se concentrem puramente na inovação em IA.

Compartilhe esta postagem

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.