正直なところ、生成AIをめぐる話題はどこにでもあります。しかし、ほとんどの企業にとって、実際に何かを構築する段階になると、その興奮は急停止してしまいます。クールなAIのプロトタイプを、顧客が信頼して使える実際のアプリケーションに変えるのは、非常に大きな飛躍です。パフォーマンス、信頼性、そして警告なしに膨れ上がる可能性のあるコストについて、突然心配になるのです。

AIアプリの構築とスケーリングは、単にトリッキーなだけではありません。正しく機能させるためには、専門的な基盤が必要です。これこそが、Fireworks AIが解決するために作られた問題です。これは、インフラ側の面倒な作業をすべて処理するように設計されたプラットフォームであり、開発者はサーバーと格闘するのをやめて、優れたAI製品の作成に集中できます。

この記事では、Fireworks AIについて知っておくべきことすべてを解説します。そのコア機能を分解し、価格設定を理解し、本当に誰のためのものなのかについて話します。また、その限界にも触れ、一部のチームにとっては、まったく異なるタイプのAIツールがはるかに適している理由を探ります。

Fireworks AIとは?

Fireworks AIの核心は、オープンソースモデルの巨大なライブラリ上で生成AIアプリケーションを構築し、実行するためのプラットフォームです。AIアプリの高性能エンジンだと考えてください。舞台裏の複雑なインフラをすべて処理してくれるので、開発者はアプリが実際に何をするかに集中できます。

同社のバックグラウンドは、その技術力を物語っています。世界で最も人気のあるオープンソースAIフレームワークの1つであるPyTorchの作成に貢献した、Meta AIのオリジナルのイノベーターたちによって設立されました。Google Cloudのブログ投稿によると、創業者たちは企業がAIを大規模に展開するのに苦労することを知っており、手助けするチャンスを見出したのです。

Fireworks AIの主な売り文句は、「これまでで最速かつ最も効率的な生成AI推論エンジン」を提供することです。平たく言えば、ユーザーを待たせることなく複雑なAIモデルを実行するために必要な、生のスピードとパワーを提供します。Fireworks AIはインフラ層であり、完成品ではないことを覚えておくことが重要です。開発者はそのAPIを使用して、カスタマーサポートボット、コーディングアシスタント、または全社的な検索エンジンなど、独自のツールを動かします。

Fireworks AIの主な機能

Fireworks AIプラットフォームは、AIモデルの単純な実験から何百万人もの人々へのサービス提供まで、その全行程をサポートする3つの主要なアイデアに基づいています。

超高速な推論エンジン

では、「推論エンジン」とは一体何でしょうか?これは、訓練済みのAIモデルを受け取り、質問に答えたり画像を生成したりするなど、応答を生成するために実行するシステムです。そのエンジンの速度は、リアルタイムアプリにとってすべてです。返答に10秒もかかるチャットボットを使いたい人はいません。

Fireworks AIは、高速(低レイテンシー)であることと、一度に大量のリクエストを処理できること(高スループット)で名を馳せています。彼らは毎日1,400億以上のトークンを処理し、99.99%のAPI稼働率を維持しています。これは、顧客のアプリが一貫して応答性が高く、信頼できることを意味します。これを実現するために、最先端のハードウェア(最高級のNVIDIA GPUなど)上で高度に最適化されたソフトウェアを実行しています。

オープンソースモデルの巨大なライブラリ

Fireworks AIの最も優れた点の1つは、オープンソースコミュニティへのコミットメントです。独自のプロプライエタリモデルにユーザーを縛り付けるのではなく、人気のオープンソースモデルの巨大なライブラリへの即時アクセスを提供します。これにより、開発者は自分のプロジェクトに最適なモデルを自由に選び、微調整し、単一のベンダーに縛られるのを避けることができます。

MetaのLlama 3、GoogleのGemma、Mixtral 8x22B、Qwenといった有名なモデルが、簡単なAPIコールですぐに利用できます。これにより、これらのモデルを自分で実行するために必要な強力なGPUをダウンロード、設定、管理するという大きな手間を省くことができます。

完全なAIモデルライフサイクル管理

Fireworks AIは、構築プロセスのあらゆるステップに対応するツールを提供します。

-

構築(Build): 開発者は、アイデアから数分で機能するモデルを作成できます。プラットフォームがすべてのGPUインフラを設定するため、すぐにプロンプトをいじり始めて結果を得ることができます。

-

調整(Tune): ファインチューニングと呼ばれるプロセスを使用して、独自のデータでベースモデルをトレーニングできます。これにより、AIが自社の専門用語、ブランドの声、または社内ナレッジを学習し、より良く、より関連性の高い回答につながります。

-

拡張(Scale): アプリの人気が高まるにつれて、Fireworks AIがスケーリングを処理します。ユーザーが10人であろうと1000万人であろうと、インフラはトラフィックの急増に対応するために自動的にリソースを追加し、あなたが何もしなくても大丈夫です。

Fireworks AIの価格設定を解説

Fireworks AIには、週末に趣味で開発する個人開発者から、本格的なAIニーズを持つ大企業まで、誰にでも対応できる非常に柔軟な使用量ベースの価格モデルがあります。彼らの公式価格ページから引用した価格は、主に3つのタイプに分かれています。

サーバーレス推論の価格

これは、AIが処理する「トークン」(テキストの一部で、おおよそ4文字)ごとに課金される、わかりやすい従量課金プランです。使用した分だけ支払うため、最初のステップとして、プロトタイプを構築したり、トラフィックが予測不可能なアプリを実行したりするのに最適な方法です。

以下は、いくつかの人気モデルのサーバーレス価格の概要です。

| ベースモデルのカテゴリ | 100万トークンあたりの価格 |

|---|---|

| 4Bパラメータ未満 | $0.10 |

| 4B - 16Bパラメータ | $0.20 |

| 16Bパラメータ超 | $0.90 |

| MoE 56.1B - 176Bパラメータ | $1.20 |

| Meta Llama 3.1 405B | $3.00 |

| Kimi K2 Instruct | 入力$0.60、出力$2.50 |

一部の高性能モデルでは、入力トークン(AIに送信するもの)の価格と出力トークン(AIが返すもの)の価格が異なる場合があることを知っておくと良いでしょう。

ファインチューニングの価格

この価格は、独自のデータでモデルをカスタマイズしたい場合に適用されます。トレーニングジョブ中に使用されたトークンの数に基づいて課金されます。モデルがファインチューニングされた後、それを実行するための料金は、元のベースモデルと同じレートで支払います。

| ベースモデルのサイズ | 100万トレーニングトークンあたりの価格 |

|---|---|

| 最大16Bパラメータ | $0.50 |

| 16.1B - 80Bパラメータ | $3.00 |

| 300Bパラメータ超 | $10.00 |

オンデマンド価格

一貫してヘビーデューティーなパフォーマンスが必要なアプリには、通常、オンデマンドオプションが最も経済的です。トークンごとに支払うのではなく、GPUへの専用アクセスのために秒単位で支払います。これにより、通常はサーバーレスプランよりも優れたパフォーマンスと低いコストが得られるため、大量のアプリケーションに最適です。

| GPUタイプ | 1時間あたりの価格(秒単位で請求) |

|---|---|

| A100 80 GB GPU | $2.90 |

| H100 80 GB GPU | $4.00 |

| H200 141 GB GPU | $6.00 |

Fireworks AIは誰のためのものか?(そして誰のためのものではないか)

Fireworks AIは非常に強力なプラットフォームですが、インフラに強く焦点を当てているため、非常に特定の層向けに設計されています。自分がそのグループに属しているかどうかを知ることが、それがあなたにとって正しい選択であるかどうかを判断する鍵となります。

理想的なユーザー:AI開発者と企業

Fireworks AIの対象ユーザーは非常に明確です。AIに焦点を当てたスタートアップ、専門の機械学習チームを持つ大企業、そしてカスタムAIアプリケーションをゼロから構築するすべての開発者です。

彼らのプラットフォームは、次のようなものを動かすために作られています。

-

高度なチャットボットとカスタマーサポートAI

-

コード生成と開発者支援ツール

-

高度な社内検索とドキュメント要約

-

複雑で多段階のAIエージェント

これらのユーザーは、Fireworks AIのようなプラットフォームが提供する、きめ細かな制御、生のパフォーマンス、およびスケーラビリティを必要としています。彼らはAPIの操作、モデルのファインチューニング、そして強力なAIエンジンをより大規模なカスタムビルド製品に組み込むことに慣れています。

主要な制限:ビジネスチーム向けの既製ツールではない

これが恐らく最も重要な点です。Fireworks AIはエンジンであり、完成した車ではありません。望む限りの馬力を提供してくれますが、車の残りの部分は自分で作らなければなりません。

これは、多くの技術的専門知識、開発時間、そして継続的なメンテナンスのための予算が必要であることを意味します。カスタマーサポートマネージャーやITリーダーが、スイッチを一つ切り替えるだけでFireworks AIに問題を解決させることはできません。それは単にそのようには作られていません。これは開発者プラットフォームであり、ビジネスアプリケーションではありません。

エンジニアのチームを雇うことなく、今すぐAIソリューションを必要とするビジネスチームにとっては、eesel AIのようなすぐに使えるプラットフォームがはるかに直接的なルートです。これらのツールは、全く異なる仕事のために作られています。つまり、特定のビジネス問題をすぐに解決するためです。

eesel AIのようなツールが際立つ点は次のとおりです。

-

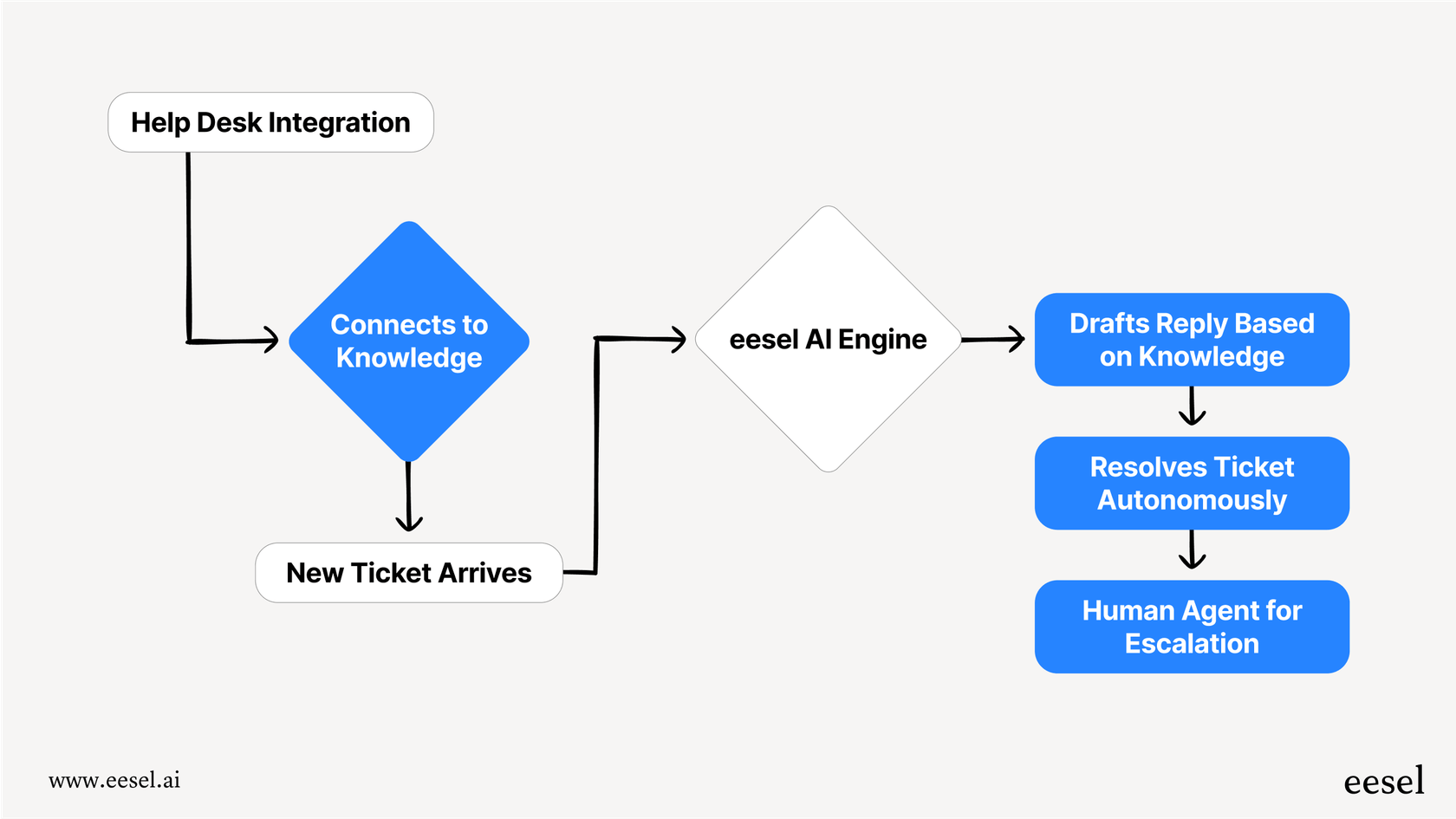

数ヶ月ではなく数分で稼働開始。 eesel AIは完全にセルフサービスで、Zendesk、Freshdesk、Slackなど、チームがすでに利用しているツールとワンクリックで連携できます。APIドキュメントを読む時間で、実際の顧客の質問を処理するAIエージェントを稼働させることができます。

-

既存システムの置き換えは不要。 新しいものを構築することを強制するのではなく、eesel AIは現在のヘルプデスクやワークフローに直接接続します。チームがすでに使い方を知っているツールを、よりスマートにするだけです。

-

ビジネスユーザー向けに設計。 eesel AIは、カスタマーサービスと社内サポートのために特別に作られています。過去のサポートチケット、ヘルプセンターの記事、ConfluenceやGoogle Docsのようなナレッジベースから自動的に学習し、初日から正確で関連性の高い回答を提供します。

プロセス全体が異なります。Fireworks AIでは、開発者がAPIを使ってカスタムアプリを構築します。eesel AIでは、サポートマネージャーがシンプルなダッシュボードを使ってツールを接続し、AIをオンにします。

Fireworks AIに関する最終的な評価

Fireworks AIは、間違いなくトップクラスのAIインフラプラットフォームです。スピード、スケーラビリティ、柔軟性という約束を完全に果たしています。カスタムAI製品を構築する開発者や企業にとっては、素晴らしい選択肢です。

この動画では、Fireworks AIが生成AIアプリケーションでどのように高速性を実現しているかを説明しています。

もしあなたがエンジニアリングチームを抱え、独自のAI搭載ツールのビジョンを持っているなら、Fireworks AIはそれを実現するためのクラス最高のエンジンを提供します。そのパフォーマンスとモデルライブラリは、特別なものを構築するために必要なすべてを提供します。

しかし、これはカスタマーサポートやITのようなビジネス部門向けのプラグアンドプレイソリューションではありません。要求される複雑さと専門知識から、単に仕事を自動化したいチームにとっては不適切なツールです。食料品の買い物に行くためにジェットエンジンを買うようなものです。

結論はこうです。AIの未来を築いているなら、Fireworks AIを選びましょう。しかし、今日のビジネス問題をAIで解決するためには、特定のワークフローのために作られたツールを探してください。

今日から始めるカスタマーサポート向けAI

適切なAIツールを選ぶことは、本当にあなたの目標次第です。今後何年にもわたって市場を形成するような基盤となるAI製品を構築しているなら、Fireworks AIのようなエンジンは必須です。

しかし、あなたの目標がカスタマーサポートを自動化し、エージェントを助け、顧客により良い体験を今すぐ提供することであれば、目的に特化して作られたソリューションが必要です。そのために、eesel AIは、一行のコードも書かずに結果を出せるようにゼロから設計されています。

シミュレーションモードを使えば、過去のチケットのうちどれだけが自動的に解決できたかを正確に確認できます。散在するすべてのナレッジソースを数クリックで接続できます。そして、既存のヘルプデスク内で機能する、完全に機能的なAIエージェントを数ヶ月ではなく数分で稼働させることができます。

よくある質問

Fireworks AIは、生成AIアプリケーションの構築と実行のために設計された高性能なインフラプラットフォームです。AIモデルのデプロイとスケーリングの複雑さに取り組み、開発者がサーバー管理ではなくアプリケーションロジックの作成に集中できるようにします。

Fireworks AIは、MetaのLlama 3、GoogleのGemma、Mixtral 8x22B、Qwenなど、人気のオープンソースモデルの巨大なライブラリへのアクセスを提供します。このオープンソースへのコミットメントにより、開発者はプロジェクトに合わせてモデルを柔軟に選択し、カスタマイズすることができます。

Fireworks AIは、高効率のソフトウェアと最高級のNVIDIA GPUで最適化された超高速の推論エンジンを使用しています。このアーキテクチャにより、低レイテンシーと高スループットが保証され、リアルタイムの応答と1日あたり数十億のトークンの処理が可能になります。

いいえ、Fireworks AIは主にAI開発者および企業の機械学習チーム向けに設計されたインフラ層です。APIを介して統合し、カスタムアプリケーションを構築するには技術的な専門知識が必要であり、すぐに使えるソリューションを求める非技術系のビジネスユーザーには不向きです。

Fireworks AIは、サーバーレス推論(トークンごとの支払い)、ファインチューニング(トレーニングトークンごとの支払い)、オンデマンド(専用GPUアクセスに対する秒単位の支払い)の3つの主要モデルで、柔軟な使用量ベースの価格設定を提供しています。最適なオプションは、使用量と特定のニーズによって異なります。

開発者は、大幅に高速なデプロイ、広範なオープンソースモデルライブラリへの即時アクセス、および自動スケーリング機能から恩恵を受けます。Fireworks AIはGPU管理とインフラの複雑さを抽象化し、チームが純粋にAIイノベーションに集中できるようにします。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.