Tentar escolher a IA certa para o seu negócio pode parecer avassalador. De um lado, tem estas plataformas de nicho, tudo-em-um, que prometem uma solução rápida. Do outro, tem modelos incrivelmente poderosos que parecem conseguir fazer tudo, mas que também vêm com um manual de instruções enorme que vai precisar de uma equipa de engenheiros para ler.

Tantas vezes parece que está preso a escolher entre uma ferramenta demasiado simples e um motor que é demasiado complexo.

A escolha entre uma ferramenta especializada como o AgentKit e modelos fundacionais como o GPT-4 Turbo e o Gemini 1.5 é um exemplo perfeito deste problema. Neste artigo, vamos analisar o que eles realmente podem fazer, como os pode pôr a funcionar e quanto custam na realidade. No final, terá uma ideia muito mais clara do que faz sentido para a sua equipa de suporte.

AgentKit vs GPT-4 Turbo vs Gemini 1.5: O que são estas ferramentas de IA?

Primeiro, ajuda saber que comparar o AgentKit com o GPT-4 Turbo e o Gemini 1.5 é um pouco como comparar um kart pré-montado com um par de motores V8 de alto desempenho. Um é um produto finalizado, desenhado para uma pista específica, enquanto os outros são peças potentes que pode usar para construir praticamente qualquer coisa, assumindo que tem uma equipa de mecânicos completa e um diploma em engenharia.

O que é o AgentKit?

O AgentKit é uma plataforma especializada, tudo-em-um, construída para um grupo muito específico: corretores de seguros norte-americanos. O seu único propósito é ajudá-los a gerir leads e a tratar do seu marketing nas redes sociais.

A plataforma dá aos corretores ferramentas para criar as suas próprias páginas iniciais, uma biblioteca de conteúdo pré-escrito para publicar online e um sistema para acompanhar potenciais clientes. Pense nele como um kit de ferramentas de marketing e vendas feito para uma única indústria. Não é uma IA geral que pode ajustar para o apoio ao cliente; é uma ferramenta focada com uma função muito específica.

O que é o GPT-4 Turbo?

O GPT-4 Turbo é um dos grandes modelos de linguagem de peso pesado (LLMs) da OpenAI. É o "motor" que funciona nos bastidores de muitas das aplicações de IA mais avançadas que existem, incluindo algumas versões do ChatGPT. Na verdade, não se "usa" o GPT-4 Turbo isoladamente. Em vez disso, os programadores aproveitam o seu poder através de uma API para construir as suas próprias soluções personalizadas. Os seus pontos fortes estão no seu raciocínio complexo, nas suas capacidades de programação e numa base massiva de conhecimento geral, o que o torna incrivelmente flexível.

O que é o Gemini 1.5?

O Gemini 1.5 é o LLM de topo da Google e um concorrente direto do GPT-4 Turbo. É também um modelo fundacional, o que significa que é outro motor potente ao qual se acede através de uma API ou dos serviços na nuvem da Google.

A grande vantagem do Gemini 1.5 é a sua janela de contexto absolutamente massiva. Consegue processar até 1 milhão de tokens (cerca de 750.000 palavras) de uma só vez. Isto torna-o fantástico para analisar enormes quantidades de informação de uma vez, como analisar a base de código de uma empresa inteira, resumir um romance ou até compreender o que está a acontecer num vídeo longo.

Comparando capacidades

Quando se procura IA para o apoio ao cliente, na verdade, só nos preocupamos com algumas coisas: consegue perceber o problema do cliente? Consegue lembrar-se da conversa? E consegue dar uma resposta correta e útil? Vamos ver como estes três se comparam.

Desempenho e precisão das tarefas

O desempenho do AgentKit está limitado ao que foi construído para fazer. Pode ajudar um agente de seguros a criar rapidamente uma publicação nas redes sociais ou a acompanhar um lead, mas não consegue responder à pergunta de um cliente sobre um erro de faturação estranho ou guiá-lo através de um problema técnico. A sua "precisão" resume-se, na verdade, à qualidade dos seus modelos de marketing.

O GPT-4 Turbo e o Gemini 1.5, no entanto, são construídos para compreender e responder a uma vasta gama de linguagem humana. Conseguem lidar tanto com FAQs simples como com a resolução de problemas complexos e de vários passos. Conseguem redigir respostas empáticas e ponderadas que parecem surpreendentemente humanas.

Mas aqui está o grande senão: o desempenho destes modelos brutos depende completamente de como os configura. Sem engenharia de prompts de nível especializado, ligações profundas às suas bases de conhecimento e um sistema bem desenhado, podem facilmente cuspir respostas genéricas, inúteis ou simplesmente erradas.

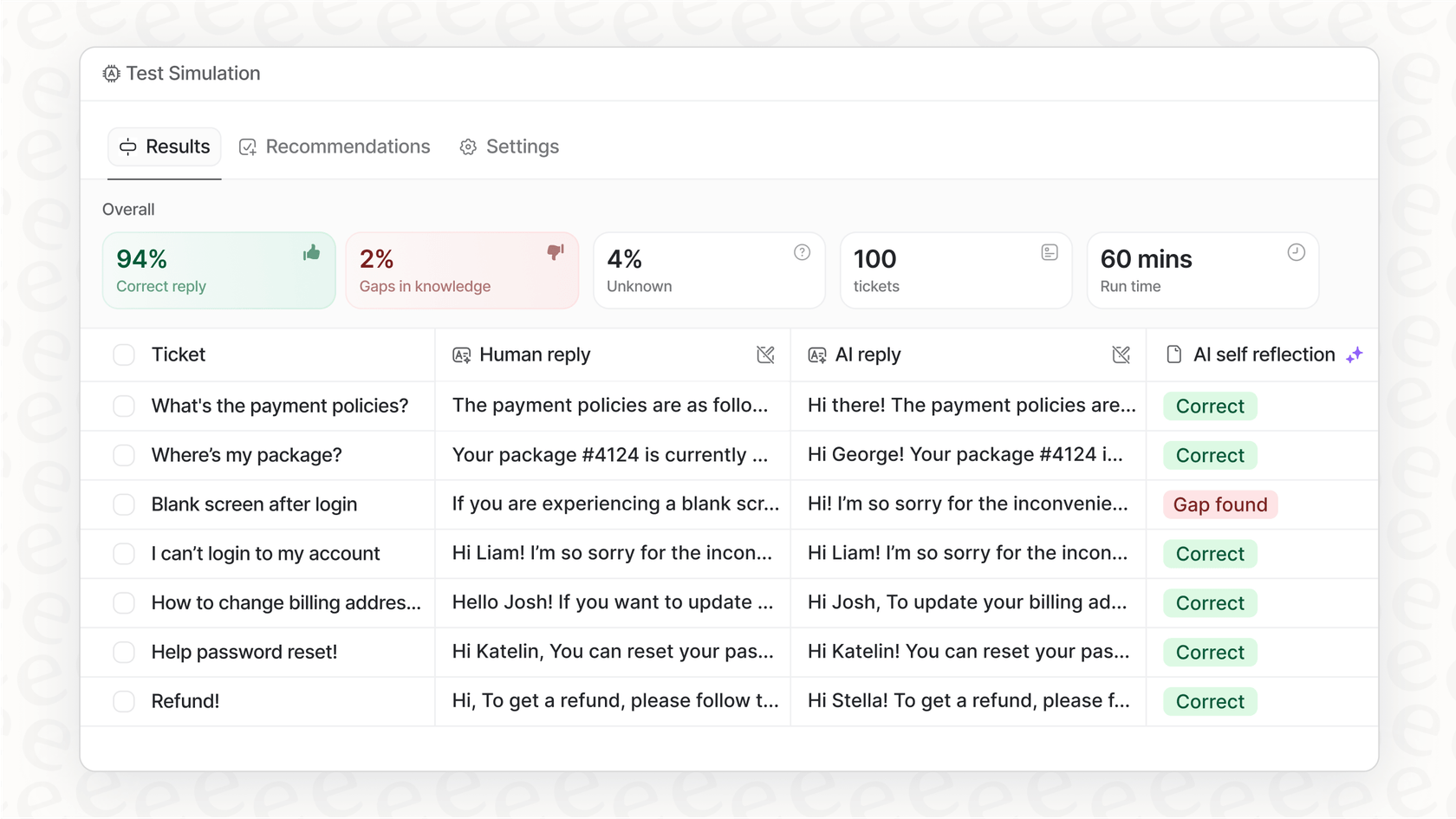

É aqui que uma plataforma desenhada especificamente para suporte, como a eesel AI, muda o jogo. A eesel AI usa o poder de modelos de topo como o GPT-4, mas já vem pré-construída para o serviço ao cliente. Liga-se ao seu helpdesk e começa imediatamente a aprender com os tickets passados da sua equipa, artigos de ajuda e documentos internos. Isto significa que, desde o primeiro dia, as suas respostas são precisas, específicas para o seu negócio e correspondem à voz da sua marca.

Diferenças na janela de contexto

No suporte, o contexto é tudo. Uma IA tem de se lembrar do que um cliente disse há cinco mensagens para proporcionar uma experiência coerente e não frustrante.

O AgentKit não foi desenhado para conversas, pelo que a ideia de uma "janela de contexto" não se aplica realmente. O único contexto que acompanha são os dados no seu sistema de gestão de leads.

O GPT-4 Turbo tem uma janela de contexto de 128.000 tokens, o que é mais do que suficiente para lidar com quase qualquer chat de apoio ao cliente sem esquecer detalhes importantes.

O Gemini 1.5 Pro é o campeão indiscutível aqui com a sua janela de contexto de 1 milhão de tokens. É ideal para aqueles casos de suporte incrivelmente longos e complicados onde um agente pode precisar de vasculhar meses de histórico de chat ou vários manuais técnicos para encontrar uma solução.

Mas, mais uma vez, há um obstáculo prático. Ter apenas uma grande janela de contexto não é suficiente. Os seus programadores têm de construir todo o sistema para passar o histórico da conversa de um lado para o outro cada vez que uma mensagem é enviada. Isso é um desafio técnico sério que necessita de trabalho constante para ser mantido.

| Característica | AgentKit | GPT-4 Turbo | Gemini 1.5 Pro |

|---|---|---|---|

| Janela de Contexto Máxima | N/A (Específico da Aplicação) | 128.000 tokens | 1.000.000 tokens |

| Ideal para | Acompanhamento de leads | Conversas de suporte padrão | Problemas complexos e com muito histórico |

Implementação e facilidade de uso

Uma ferramenta de IA não vale nada se não a conseguir pôr a funcionar. A jornada desde a inscrição até vê-la realmente a ajudar os clientes é muito diferente para estas opções.

Complexidade da configuração

Para um agente de seguros, configurar o AgentKit é bastante simples. Inscreve-se, preenche um perfil e começa a usar as funcionalidades. Obtém valor rapidamente, mas esse valor está limitado ao que a plataforma oferece.

Começar com o GPT-4 Turbo ou o Gemini 1.5 é exatamente o oposto. É um projeto enorme que requer uma equipa de programadores qualificados. Tem de gerir chaves de API, construir uma interface, configurar a infraestrutura e escrever todo o código para gerir conversas e ligar-se às suas outras ferramentas. O tempo que leva para ver algum valor real não se mede em horas, mede-se em meses, e custa uma fortuna em salários e recursos antes de ter respondido a um único ticket.

É aqui que uma plataforma como a eesel AI se destaca realmente. A eesel foi construída para ser completamente self-service. Pode ligar o seu helpdesk, como o Zendesk ou o Freshdesk, com um único clique e ter um agente de IA a funcionar em minutos. Sem demonstrações obrigatórias, sem longas chamadas de vendas. O melhor de tudo é que pode executar simulações em milhares dos seus tickets passados para ver exatamente como a IA se vai comportar antes de a deixar falar com um cliente real, o que elimina todo o risco do processo.

Personalização

O AgentKit é uma caixa fechada. Pode alterar o seu perfil e escolher que conteúdo partilhar, mas não pode mudar a forma como funciona. Não se vai ligar ao seu helpdesk porque nunca foi feito para isso.

O GPT-4 Turbo e o Gemini 1.5 são infinitamente personalizáveis, o que é tanto a sua maior força como a sua maior fraqueza. Tem a liberdade de construir qualquer coisa que consiga imaginar, mas também tem a responsabilidade de construir tudo do zero. Cada fluxo de trabalho, cada integração, cada pequena ação personalizada tem de ser programada de raiz.

Este é um ponto forte central da eesel AI. Dá-lhe controlo total com um motor de fluxo de trabalho poderoso e totalmente personalizável, mas nunca precisa de escrever uma única linha de código. A partir de um painel de controlo fácil de usar, pode definir o tom de voz exato da sua IA, criar ações personalizadas (como fazê-la verificar o estado de uma encomenda no Shopify) e configurar regras detalhadas para decidir quais tickets são automatizados e quais vão para um humano. É o poder de uma solução feita à medida com a facilidade de uma ferramenta pronta a usar.

Preços e custo total de propriedade

No final de contas, a decisão muitas vezes resume-se ao dinheiro. Mas é muito importante olhar para além do preço de tabela e pensar no custo total de possuir e operar a ferramenta.

Preços do AgentKit

O AgentKit não lista os seus preços no seu site. Isto é bastante comum para software de nicho, mas significa que tem de falar com um vendedor só para saber o custo. É provável que seja uma subscrição mensal ou anual fixa, o que é previsível, mas começa com uma barreira de vendas.

Preços da API do GPT-4 Turbo e Gemini 1.5

O preço para estes grandes modelos é completamente diferente. Paga à medida que usa, com base em "tokens", que são pequenos pedaços de palavras. Cada pedaço de texto que envia para o modelo (input) e cada pedaço que ele envia de volta (output) custa um pouco de dinheiro.

Este modelo é super flexível, mas também pode ser perigosamente imprevisível. Um aumento súbito de tickets de apoio ao cliente pode deixá-lo com uma conta surpreendentemente grande no final do mês. Mais importante, essas taxas de API são apenas a ponta do iceberg. O custo real tem de incluir os salários dos programadores que constroem e mantêm o sistema, os custos de alojamento na nuvem e o orçamento para ajustes e correções contínuas.

| Modelo | Custo de Input (por 1M de tokens) | Custo de Output (por 1M de tokens) |

|---|---|---|

| GPT-4 Turbo | $10.00 | $30.00 |

| Gemini 1.5 Pro | $3.50 (para contexto ## A forma mais inteligente de usar IA para suporte |

Então, qual é a escolha certa? Vamos recapitular rapidamente.

-

AgentKit é uma ferramenta de marketing para uma indústria específica. Para qualquer equipa de apoio ao cliente geral, simplesmente não é a ferramenta certa para o trabalho.

-

GPT-4 Turbo e Gemini 1.5 são motores incrivelmente potentes. Mas transformá-los numa ferramenta de suporte fiável e acessível é um projeto enorme que custa muito tempo, dinheiro e horas de programação, com o risco constante de uma fatura surpresa.

O melhor caminho para a maioria das equipas é encontrar uma solução que ofereça o poder destes modelos de classe mundial sem a dor de cabeça e o custo de construir do zero. É aqui que uma plataforma de integração de IA se torna a escolha óbvia.

A eesel AI foi construída para ser essa solução. Combina a inteligência dos melhores LLMs com uma plataforma simples e self-service que se liga diretamente às ferramentas que já usa. Obtém o melhor dos dois mundos: o controlo total de um sistema personalizado sem os meses de desenvolvimento e a faturação imprevisível. Pode começar a automatizar o seu suporte em minutos, não em trimestres.

Pronto para ver como pode ser fácil? Comece o seu teste gratuito com a eesel AI hoje.

Perguntas frequentes

O AgentKit é uma plataforma de marketing de nicho, tudo-em-um, concebida especificamente para corretores de seguros norte-americanos. O GPT-4 Turbo e o Gemini 1.5 são modelos de IA poderosos e de uso geral que servem como motores fundacionais que exigem um desenvolvimento extensivo para criar aplicações personalizadas. Eles atendem a necessidades muito diferentes.

O AgentKit oferece uma configuração simples, mas não se destina a funções de apoio ao cliente. Construir uma solução funcional com GPT-4 Turbo ou Gemini 1.5 envolve um projeto de desenvolvimento significativo, muitas vezes demorando meses e recursos consideráveis. Uma plataforma especializada como a eesel AI oferece uma configuração muito mais rápida e self-service para suporte.

O AgentKit provavelmente tem uma taxa de subscrição fixa e previsível. Em contraste, o GPT-4 Turbo e o Gemini 1.5 usam preços de API imprevisíveis baseados em tokens, que podem flutuar. O custo real para estes modelos fundacionais também inclui salários substanciais de programadores, alojamento na nuvem e manutenção contínua, ultrapassando em muito apenas as taxas de API.

O AgentKit é uma plataforma fechada com opções de personalização muito limitadas. O GPT-4 Turbo e o Gemini 1.5 oferecem um potencial de personalização infinito, mas isso requer a construção de cada fluxo de trabalho e integração do zero através de programação. Soluções como a eesel AI oferecem uma personalização extensiva através de um painel de controlo intuitivo sem necessidade de qualquer código.

Não totalmente. O AgentKit é uma ferramenta de marketing e não foi concebido para conversas com clientes ou tarefas de suporte geral. Embora o GPT-4 Turbo e o Gemini 1.5 sejam motores de IA conversacional potentes, são modelos brutos que exigem um esforço de engenharia significativo para se transformarem numa solução de serviço ao cliente eficaz e fiável.

O AgentKit não gere contexto conversacional, pois não foi construído para diálogos. O GPT-4 Turbo e o Gemini 1.5 possuem grandes janelas de contexto (128.000 e 1.000.000 de tokens, respetivamente), mas utilizá-los eficazmente para conversas de suporte contínuas requer um desenvolvimento complexo para passar consistentemente o histórico da conversa.

Compartilhe esta postagem

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.