Die Auswahl der richtigen KI für Ihr Unternehmen kann überwältigend sein. Auf der einen Seite gibt es diese Nischenplattformen, die als Komplettlösung eine schnelle Abhilfe versprechen. Auf der anderen Seite stehen unglaublich leistungsstarke Modelle, die scheinbar alles können, aber auch mit einer riesigen Bedienungsanleitung geliefert werden, für deren Lektüre man ein ganzes Team von Ingenieuren benötigt.

Oft hat man das Gefühl, zwischen einem zu einfachen Werkzeug und einem viel zu komplexen System entscheiden zu müssen.

Die Wahl zwischen einem spezialisierten Tool wie AgentKit und grundlegenden Modellen wie GPT-4 Turbo und Gemini 1.5 ist ein perfektes Beispiel für dieses Problem. In diesem Beitrag werden wir aufschlüsseln, was sie wirklich können, wie man sie zum Laufen bringt und was sie tatsächlich kosten. Am Ende werden Sie eine viel klarere Vorstellung davon haben, was für Ihr Support-Team sinnvoll ist.

AgentKit vs. GPT-4 Turbo vs. Gemini 1.5: Was sind diese KI-Tools?

Zunächst einmal ist es hilfreich zu wissen, dass der Vergleich von AgentKit mit GPT-4 Turbo und Gemini 1.5 ein bisschen so ist, als würde man ein vorgefertigtes Go-Kart mit ein paar leistungsstarken V8-Motoren vergleichen. Das eine ist ein fertiges Produkt, das für eine bestimmte Strecke entwickelt wurde, während die anderen leistungsstarke Komponenten sind, mit denen man so ziemlich alles bauen könnte – vorausgesetzt, man hat eine komplette Boxencrew und einen Ingenieurabschluss.

Was ist AgentKit?

AgentKit ist eine spezialisierte All-in-One-Plattform, die für eine ganz bestimmte Zielgruppe entwickelt wurde: nordamerikanische Versicherungsmakler. Ihr gesamter Zweck besteht darin, sie bei der Verwaltung von Leads und der Abwicklung ihres Social-Media-Marketings zu unterstützen.

Die Plattform bietet Maklern Werkzeuge zur Erstellung eigener Homepages, eine Bibliothek mit vorgefertigten Inhalten für Online-Posts und ein System zur Nachverfolgung potenzieller Kunden. Stellen Sie es sich wie ein Marketing- und Vertriebs-Toolkit vor, das für eine einzige Branche entwickelt wurde. Es ist keine allgemeine KI, die man für den Kundensupport anpassen kann; es ist ein fokussiertes Werkzeug mit einer sehr eng gefassten Aufgabe.

Was ist GPT-4 Turbo?

GPT-4 Turbo ist eines der leistungsstärksten großen Sprachmodelle (LLMs) von OpenAI. Es ist der „Motor“, der hinter den Kulissen vieler der fortschrittlichsten KI-Apps läuft, einschließlich einiger Versionen von ChatGPT. Man „nutzt“ GPT-4 Turbo nicht wirklich allein. Stattdessen greifen Entwickler über eine API auf seine Leistung zu, um ihre eigenen maßgeschneiderten Lösungen zu entwickeln. Seine Stärken liegen in seinem komplexen Denkvermögen, seinen Programmierfähigkeiten und einer riesigen Basis an Allgemeinwissen, was es unglaublich flexibel macht.

Was ist Gemini 1.5?

Gemini 1.5 ist Googles Spitzen-LLM und ein direkter Konkurrent von GPT-4 Turbo. Es ist ebenfalls ein grundlegendes Modell, was bedeutet, dass es sich um einen weiteren leistungsstarken Motor handelt, auf den man über eine API oder die Cloud-Dienste von Google zugreift.

Das Besondere an Gemini 1.5 ist sein absolut riesiges Kontextfenster. Es kann bis zu 1 Million Token (das sind etwa 750.000 Wörter) auf einmal verarbeiten. Das macht es hervorragend darin, riesige Mengen an Informationen auf einmal zu durchsuchen, wie zum Beispiel die Analyse des gesamten Quellcodes eines Unternehmens, die Zusammenfassung eines Romans oder sogar das Verständnis dessen, was in einem langen Video passiert.

Ein Vergleich der Fähigkeiten

Wenn man sich KI für den Kundensupport ansieht, sind eigentlich nur wenige Dinge wichtig: Kann sie das Problem des Kunden verstehen? Kann sie sich an das Gespräch erinnern? Und kann sie eine korrekte, hilfreiche Antwort geben? Schauen wir uns an, wie diese drei abschneiden.

Aufgabenleistung und Genauigkeit

Die Leistung von AgentKit ist auf das beschränkt, wofür es entwickelt wurde. Es kann einem Versicherungsvertreter helfen, schnell einen Social-Media-Beitrag zu erstellen oder einen Lead zu verfolgen, aber es kann keine Kundenfrage zu einem seltsamen Abrechnungsfehler beantworten oder ihn durch ein technisches Problem führen. Seine „Genauigkeit“ hängt eigentlich nur davon ab, wie gut seine Marketingvorlagen sind.

GPT-4 Turbo und Gemini 1.5 hingegen sind darauf ausgelegt, eine riesige Bandbreite menschlicher Sprache zu verstehen und darauf zu reagieren. Sie können einfache FAQs ebenso gut bewältigen wie komplexe, mehrstufige Fehlerbehebungen. Sie können einfühlsame, durchdachte Antworten verfassen, die sich überraschend menschlich anfühlen.

Aber hier ist der große Haken: Die Leistung dieser rohen Modelle hängt vollständig davon ab, wie man sie einrichtet. Ohne professionelles Prompt-Engineering, tiefe Verbindungen zu Ihren Wissensdatenbanken und ein gut konzipiertes System können sie leicht allgemeine, wenig hilfreiche oder schlichtweg falsche Antworten ausspucken.

Genau hier verändert eine speziell für den Support entwickelte Plattform wie eesel AI die Spielregeln. eesel AI nutzt die Leistung von Spitzenmodellen wie GPT-4, ist aber bereits für den Kundenservice vorkonfiguriert. Es verbindet sich mit Ihrem Helpdesk und beginnt sofort, aus den bisherigen Tickets, Hilfeartikeln und internen Dokumenten Ihres Teams zu lernen. Das bedeutet, dass seine Antworten vom ersten Tag an genau, spezifisch für Ihr Unternehmen und auf den Tonfall Ihrer Marke abgestimmt sind.

Unterschiede beim Kontextfenster

Im Support ist der Kontext alles. Eine KI muss sich daran erinnern, was ein Kunde vor fünf Nachrichten gesagt hat, um ein kohärentes und nicht frustrierendes Erlebnis zu bieten.

AgentKit wurde nicht für Konversationen entwickelt, daher passt die Idee eines „Kontextfensters“ nicht wirklich. Der einzige Kontext, den es verfolgt, sind die Daten in seinem Lead-Management-System.

GPT-4 Turbo hat ein Kontextfenster von 128.000 Token, was mehr als genug ist, um fast jeden Kundensupport-Chat zu bewältigen, ohne wichtige Details zu vergessen.

Gemini 1.5 Pro ist hier mit seinem 1-Millionen-Token-Kontextfenster der unangefochtene Champion. Es ist ideal für unglaublich lange und komplizierte Supportfälle, bei denen ein Mitarbeiter möglicherweise monatelange Chatverläufe oder mehrere technische Handbücher durchsuchen muss, um eine Lösung zu finden.

Aber auch hier gibt es eine praktische Hürde. Ein großes Kontextfenster allein reicht nicht aus. Ihre Entwickler müssen das gesamte System so aufbauen, dass der Gesprächsverlauf bei jeder einzelnen gesendeten Nachricht hin und her übergeben wird. Das ist eine ernsthafte technische Herausforderung, die ständige Wartungsarbeit erfordert.

| Merkmal | AgentKit | GPT-4 Turbo | Gemini 1.5 Pro |

|---|---|---|---|

| Max. Kontextfenster | N/A (Anwendungsspezifisch) | 128.000 Token | 1.000.000 Token |

| Am besten geeignet für | Lead-Tracking | Standard-Supportgespräche | Komplexe, historienlastige Probleme |

Implementierung und Benutzerfreundlichkeit

Ein KI-Tool ist wertlos, wenn man es nicht zum Laufen bekommt. Der Weg von der Anmeldung bis zur tatsächlichen Unterstützung von Kunden ist bei diesen Optionen völlig unterschiedlich.

Komplexität der Einrichtung

Für einen Versicherungsvertreter ist die Einrichtung von AgentKit ziemlich einfach. Man meldet sich an, füllt ein Profil aus und beginnt, die Funktionen zu nutzen. Man erhält schnell einen Mehrwert, aber dieser Mehrwert ist auf das beschränkt, was die Plattform bietet.

Der Einstieg in GPT-4 Turbo oder Gemini 1.5 ist das genaue Gegenteil. Es ist ein riesiges Projekt, das ein Team von erfahrenen Entwicklern erfordert. Man muss API-Schlüssel verwalten, eine Benutzeroberfläche erstellen, die Infrastruktur einrichten und den gesamten Code schreiben, um Gespräche zu führen und eine Verbindung zu anderen Tools herzustellen. Die Zeit, die es dauert, einen echten Nutzen zu sehen, wird nicht in Stunden, sondern in Monaten gemessen, und es kostet eine Menge an Gehältern und Ressourcen, bevor auch nur ein einziges Ticket beantwortet wurde.

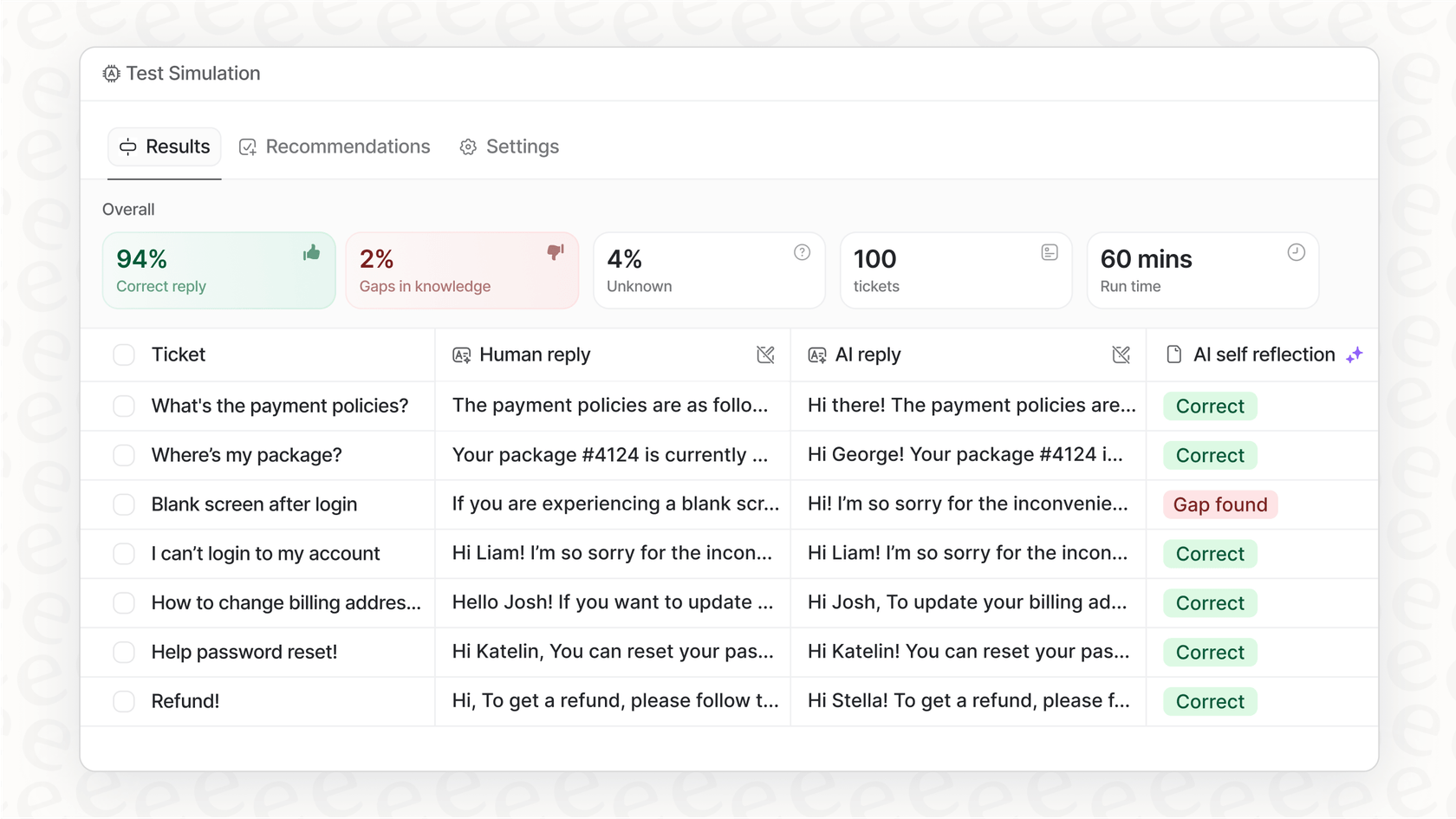

Genau hier sticht eine Plattform wie eesel AI wirklich heraus. eesel ist als vollständig self-service-fähig konzipiert. Sie können Ihren Helpdesk wie Zendesk oder Freshdesk mit einem einzigen Klick verbinden und haben in wenigen Minuten einen funktionierenden KI-Agenten. Keine obligatorischen Demos, keine langwierigen Verkaufsgespräche. Das Beste daran ist, dass Sie Simulationen mit Tausenden Ihrer früheren Tickets durchführen können, um genau zu sehen, wie die KI funktionieren wird, bevor Sie sie jemals mit einem echten Kunden sprechen lassen. Das nimmt jegliches Risiko aus dem Prozess.

Anpassungsmöglichkeiten

AgentKit ist eine geschlossene Box. Sie können Ihr Profil ändern und auswählen, welche Inhalte Sie teilen möchten, aber Sie können nicht ändern, wie es funktioniert. Es wird sich nicht mit Ihrem Helpdesk verbinden, weil es nie dafür gedacht war.

GPT-4 Turbo und Gemini 1.5 sind endlos anpassbar, was sowohl ihre größte Stärke als auch ihre größte Schwäche ist. Sie haben die Freiheit, alles zu bauen, was Sie sich vorstellen können, aber Sie haben auch die Verantwortung, alles von Grund auf zu bauen. Jeder Workflow, jede Integration, jede kleine benutzerdefinierte Aktion muss von Grund auf neu programmiert werden.

Dies ist eine Kernstärke von eesel AI. Es gibt Ihnen die volle Kontrolle mit einer leistungsstarken, vollständig anpassbaren Workflow-Engine, ohne dass Sie jemals eine einzige Zeile Code schreiben müssen. Über ein benutzerfreundliches Dashboard können Sie den exakten Tonfall Ihrer KI definieren, benutzerdefinierte Aktionen erstellen (z. B. den Bestellstatus in Shopify überprüfen lassen) und detaillierte Regeln festlegen, um zu entscheiden, welche Tickets automatisiert werden und welche an einen Menschen gehen. Es ist die Leistung einer maßgeschneiderten Lösung mit der Einfachheit eines Standard-Tools.

Preise und Gesamtbetriebskosten

Letztendlich geht es oft ums Geld. Aber es ist wirklich wichtig, über den Listenpreis hinauszuschauen und die Gesamtkosten für den Besitz und Betrieb der Sache zu bedenken.

Preise von AgentKit

AgentKit listet seine Preise nicht auf seiner Website. Das ist bei Nischensoftware ziemlich üblich, bedeutet aber, dass Sie mit einem Vertriebsmitarbeiter sprechen müssen, nur um die Kosten zu erfahren. Wahrscheinlich handelt es sich um ein festes monatliches oder jährliches Abonnement, das zwar planbar ist, aber mit einer Verkaufshürde beginnt.

API-Preise für GPT-4 Turbo und Gemini 1.5

Die Preisgestaltung für diese großen Modelle ist völlig anders. Sie zahlen nach Verbrauch, basierend auf „Token“, also kleinen Wortteilen. Jeder Text, den Sie an das Modell senden (Input), und jeder Teil, den es zurücksendet (Output), kostet ein kleines bisschen Geld.

Dieses Modell ist super flexibel, kann aber auch gefährlich unvorhersehbar sein. Ein plötzlicher Ansturm von Kundensupport-Tickets könnte Ihnen am Ende des Monats eine überraschend hohe Rechnung bescheren. Noch wichtiger ist, dass diese API-Gebühren nur die Spitze des Eisbergs sind. Die wahren Kosten müssen die Gehälter der Entwickler, die das System bauen und warten, die Cloud-Hosting-Kosten und das Budget für laufende Anpassungen und Korrekturen beinhalten.

| Modell | Input-Kosten (pro 1 Mio. Token) | Output-Kosten (pro 1 Mio. Token) |

|---|---|---|

| GPT-4 Turbo | $10.00 | $30.00 |

| Gemini 1.5 Pro | $3.50 (für ## Der smarte Weg, KI im Support einzusetzen |

Also, welche ist die richtige Wahl? Fassen wir kurz zusammen.

-

AgentKit ist ein Marketing-Tool für eine bestimmte Branche. Für jedes allgemeine Kundensupport-Team ist es einfach nicht das richtige Werkzeug für die Aufgabe.

-

GPT-4 Turbo und Gemini 1.5 sind unglaublich leistungsstarke Motoren. Aber sie in ein zuverlässiges und erschwingliches Support-Tool zu verwandeln, ist ein riesiges Projekt, das viel Zeit, Geld und Entwicklerstunden kostet, mit dem ständigen Risiko einer überraschenden Rechnung.

Der beste Weg für die meisten Teams ist es, eine Lösung zu finden, die die Leistung dieser erstklassigen Modelle ohne den Aufwand und die Kosten des Eigenbaus bietet. Hier wird eine KI-Integrationsplattform zur offensichtlichen Wahl.

eesel AI wurde entwickelt, um genau diese Lösung zu sein. Es kombiniert die Intelligenz der besten LLMs mit einer einfachen Self-Service-Plattform, die sich direkt in die Tools einfügt, die Sie bereits verwenden. Sie erhalten das Beste aus beiden Welten: die volle Kontrolle eines maßgeschneiderten Systems ohne monatelange Entwicklung und unvorhersehbare Abrechnungen. Sie können mit der Automatisierung Ihres Supports in Minuten beginnen, nicht in Quartalen.

Bereit zu sehen, wie einfach es sein kann? Starten Sie noch heute Ihre kostenlose Testversion mit eesel AI.

Häufig gestellte Fragen

AgentKit ist eine spezialisierte All-in-One-Marketingplattform, die speziell für nordamerikanische Versicherungsmakler entwickelt wurde. GPT-4 Turbo und Gemini 1.5 sind leistungsstarke, allgemeine KI-Modelle, die als grundlegende Engines dienen und umfangreiche Entwicklungsarbeit erfordern, um benutzerdefinierte Anwendungen zu erstellen. Sie bedienen sehr unterschiedliche Bedürfnisse.

AgentKit bietet eine einfache Einrichtung, ist aber nicht für Kundensupport-Funktionen vorgesehen. Der Aufbau einer funktionalen Lösung mit GPT-4 Turbo oder Gemini 1.5 ist ein bedeutendes Entwicklungsprojekt, das oft Monate und erhebliche Ressourcen erfordert. Eine spezialisierte Plattform wie eesel AI bietet eine wesentlich schnellere Self-Service-Einrichtung für den Support.

AgentKit hat wahrscheinlich eine planbare, feste Abonnementgebühr. Im Gegensatz dazu verwenden GPT-4 Turbo und Gemini 1.5 unvorhersehbare, tokenbasierte API-Preise, die schwanken können. Die wahren Kosten für diese grundlegenden Modelle umfassen auch erhebliche Entwicklergehälter, Cloud-Hosting und laufende Wartung, die weit über die reinen API-Gebühren hinausgehen.

AgentKit ist eine geschlossene Plattform mit sehr begrenzten Anpassungsmöglichkeiten. GPT-4 Turbo und Gemini 1.5 bieten endloses Anpassungspotenzial, was jedoch erfordert, dass jeder Workflow und jede Integration von Grund auf neu programmiert werden muss. Lösungen wie eesel AI bieten umfangreiche Anpassungen über ein intuitives Dashboard, ohne dass Code erforderlich ist.

Nicht ganz. AgentKit ist ein Marketing-Tool und nicht für Kundengespräche oder allgemeine Support-Aufgaben konzipiert. Während GPT-4 Turbo und Gemini 1.5 leistungsstarke Konversations-KI-Engines sind, handelt es sich um rohe Modelle, die einen erheblichen technischen Aufwand erfordern, um sie zu einer effektiven und zuverlässigen Kundenservice-Lösung auszubauen.

AgentKit verwaltet keinen Konversationskontext, da es nicht für Dialoge entwickelt wurde. GPT-4 Turbo und Gemini 1.5 besitzen große Kontextfenster (128.000 bzw. 1.000.000 Token), aber um diese effektiv für fortlaufende Support-Gespräche zu nutzen, ist eine komplexe Entwicklung erforderlich, um den Gesprächsverlauf konsistent zu übergeben.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.