Ein schönes Design aus Figma in funktionierenden, lauffähigen Code zu verwandeln, war schon immer eines dieser klassischen Kopfzerbrechen für Produktteams. Es ist ein Prozess voller manueller Übersetzungen, endlosem Hin und Her zwischen Designern und Entwicklern und dem nagenden Gefühl, dass alles so viel schneller gehen könnte. Der Traum ist natürlich, dass KI-Tools wie OpenAI Codex einfach eine Figma-Datei ansehen und perfekten Code ausspucken könnten.

Und bis zu einem gewissen Grad rückt dieser Traum näher. Aber was braucht es wirklich, um ihn zu verwirklichen?

Dieser Leitfaden ist ein praktischer, schnörkelloser Blick auf die Integrationen von OpenAI Codex mit Figma. Wir werden die offizielle „Anleitung“ durchgehen, aber noch wichtiger ist, dass wir in das reale Chaos eintauchen, das die Dokumentation normalerweise überspringt. Wir werden uns ansehen, was es braucht, um einen wirklich reibungslosen Arbeitsablauf aufzubauen, der nicht nur beim Code aufhört, sondern bis hin zur Unterstützung Ihrer Kunden reicht.

Was sind OpenAI Codex und Figma?

Bevor wir uns damit befassen, wie man sie verbindet, sollten wir uns über die beiden Hauptakteure in dieser Geschichte einig werden.

Was ist OpenAI Codex?

Sie haben wahrscheinlich schon von OpenAI Codex als dem KI-Modell gehört, das GitHub Copilot antreibt, dem Tool, das sich anfühlt, als würde es Ihre Gedanken lesen, während Sie programmieren. Im Kern ist Codex ein KI-System von OpenAI, das unglaublich gut darin ist, natürliche Sprache, also einfaches Englisch, in Code in Dutzenden von Sprachen umzuwandeln.

Jetzt ein kurzer, aber wichtiger Hinweis: Die ursprünglichen Modelle mit dem Namen „Codex“ wurden tatsächlich im März 2023 eingestellt. Heutzutage wird der Begriff „Codex“ oft verwendet, um sich auf das breitere Set von Entwickler-Tools von OpenAI zu beziehen, das eine Kommandozeilenschnittstelle (CLI) und Erweiterungen für Code-Editoren umfasst. Diese modernen Tools verwenden neuere, leistungsfähigere GPT-Modelle, um die Arbeit zu erledigen. Wenn wir also über die Integration mit Figma sprechen, meinen wir die Anbindung an dieses aktuelle Toolset.

Was ist Figma?

Wenn Sie in der Produkt- oder Designwelt zu Hause sind, kennen Sie Figma mit ziemlicher Sicherheit. Es ist das kollaborative, cloudbasierte Designtool, das so ziemlich zum Industriestandard für alles geworden ist, von frühen Wireframes bis hin zu vollwertigen, interaktiven Prototypen und riesigen Designsystemen.

Für Entwickler war eine der bahnbrechendsten Ergänzungen der Dev Mode. Es ist ein spezieller Arbeitsbereich in Figma, der entwickelt wurde, um die Übergabe vom Design zur Entwicklung weniger schmerzhaft zu gestalten. Er gibt Entwicklern direkten Zugriff auf Maße, CSS-Spezifikationen, herunterladbare Assets und sogar kopierfertige Code-Schnipsel. Dieser Fokus auf die Überbrückung der Lücke zwischen Design und Entwicklung macht es zu einem perfekten Kandidaten für die Kombination mit einem KI-Programmierassistenten.

Der offizielle Ansatz: Wie Integrationen von OpenAI Codex mit Figma funktionieren

Also, wie bringt man diese beiden mächtigen Werkzeuge dazu, miteinander zu kommunizieren? Die technische Magie dahinter beruht auf einer gemeinsamen Sprache, die beide sprechen können.

Das Model Context Protocol (MCP) verstehen

Das Ganze basiert auf etwas, das sich Model Context Protocol (MCP) nennt. Es ist ein offener Standard, der im Grunde wie ein universeller Adapter für KI fungiert.

Stellen Sie es sich wie einen USB-Anschluss für KI-Modelle vor. Ein USB-Anschluss ermöglicht es Ihnen, alle möglichen verschiedenen Geräte anzuschließen – eine Tastatur, eine Maus, eine Festplatte – und Ihr Computer weiß einfach, was er damit tun soll. MCP macht dasselbe für KI. Es bietet eine Standardmethode, um verschiedene Informationsquellen „anzuschließen“ (wie eine Figma-Datei, einen Webbrowser oder eine Datenbank), um einem KI-Modell frischen Echtzeit-Kontext zu geben. Anstatt nur zu wissen, worauf es vor Monaten trainiert wurde, kann die KI nun Live-Informationen aus anderen Tools sehen und verwenden.

Die Rolle des Figma MCP-Servers

Um seine Designdaten einer KI zur Verfügung zu stellen, betreibt Figma einen sogenannten „MCP-Server“. Dieser Server ist das Gateway, das es jedem MCP-kompatiblen Tool, wie den Codex-Entwickler-Tools, ermöglicht, Informationen direkt aus Ihren Figma-Dateien abzurufen. So bekommt die KI Ihre Designs zu „sehen“.

Laut der Dokumentation von Figma gibt es verschiedene Möglichkeiten, sich mit diesem Server zu verbinden:

-

Desktop MCP-Server: Dieser läuft lokal auf Ihrem Rechner über die Figma-Desktop-App. Er ist perfekt für einen Arbeitsablauf, bei dem Sie auf eine Komponente in Figma klicken und die KI dann bitten, sie in Ihrem Code-Editor zu erstellen.

-

Remote MCP-Server: Dies ist eine gehostete Webadresse („https://mcp.figma.com/mcp“), die es cloudbasierten Tools und Diensten ermöglicht, sich direkt zu verbinden, ohne dass die Desktop-App laufen muss.

Das Endziel ist ziemlich einfach: Geben Sie der KI direkten Zugriff auf Ihre Design-Frames, Komponenten, Farbvariablen und Layout-Spezifikationen. Mit diesem Kontext kann sie Code generieren, der nicht nur funktional ist, sondern auch perfekt auf Ihr etabliertes Designsystem abgestimmt ist.

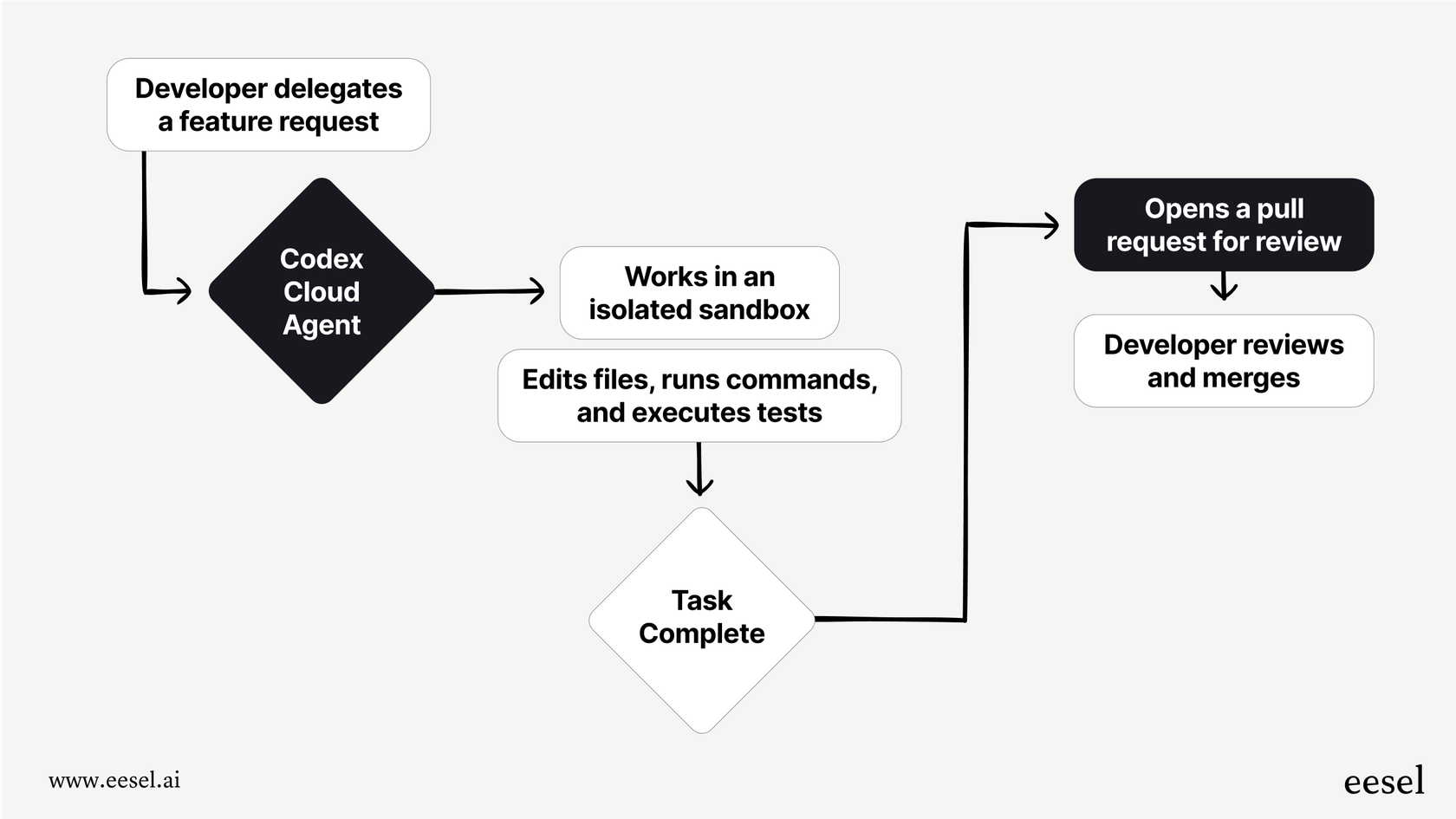

Der beabsichtigte Arbeitsablauf

Auf dem Papier klingt der Prozess wie ein Traum. Ein Entwickler verbindet sein Codex-Tool (wahrscheinlich in einem Editor wie VS Code) mit dem MCP-Server von Figma. Er schnappt sich einen Link zu einem bestimmten Frame in einer Figma-Datei, fügt ihn in seinen Editor ein und schreibt einen Prompt wie: „Erstelle mir eine React-Komponente basierend auf diesem Design und mache sie pixelgenau.“

Da die KI auf den Designkontext über den MCP-Server zugreifen kann, kann sie die Komponentennamen sehen, die exakten Hex-Codes für Ihre Markenfarben abrufen, die richtigen Schriftgrößen verwenden und den Abstand verstehen – all das führt zu unglaublich genauem Code. Zumindest ist das die Theorie. Die offizielle Dokumentation dazu finden Sie auf der Entwicklerseite von OpenAI.

Dieses Video bietet eine Schritt-für-Schritt-Anleitung zum Hinzufügen von MCP-Servern zur Codex-CLI von OpenAI und gibt Ihnen einen genaueren Einblick in die technische Einrichtung.

Die Realität der Integrationen von OpenAI Codex mit Figma: Warum sie komplex sind

Während der offizielle Arbeitsablauf sauber und einfach klingt, ist die Realität vor Ort … nun ja, um einiges unordentlicher. Dieses Setup ist weit von einer Ein-Klick-Installation entfernt und wirklich nur für Entwickler zugänglich, die sich sehr wohl dabei fühlen, unter der Haube zu arbeiten.

Ein Blick auf den realen Einrichtungsprozess

Wenn Sie sich in Community-Foren umsehen, werden Sie schnell die Diskrepanz zwischen der offiziellen Dokumentation und der realen Erfahrung erkennen. Ein großartiges Beispiel ist dieser Reddit-Thread, in dem Entwickler die Hürden teilen, mit denen sie konfrontiert waren. Der Prozess ist nicht nur „einschalten“; er beinhaltet oft eine Reihe nicht offensichtlicher Schritte, die in den Hauptanleitungen nicht erwähnt werden:

-

Manuelle Konfiguration: Sie müssen eine Konfigurationsdatei namens „config.toml“ auf Ihrem Rechner finden und manuell bearbeiten, nur um dem Codex-Tool mitzuteilen, dass der Figma-Server überhaupt existiert.

-

CLI zur Authentifizierung: Selbst wenn Sie nur die praktische VS Code-Erweiterung verwenden möchten, geht das nicht. Sie müssen zuerst Ihr Terminal öffnen und die Kommandozeilenschnittstelle (CLI) verwenden, um Ihr Konto zu authentifizieren.

-

Token-Verwaltung: Sie müssen auch in Ihre Figma-Einstellungen gehen, ein persönliches Zugriffstoken generieren (im Grunde ein einzigartiges Passwort für Apps) und dann herausfinden, wie Sie es als Umgebungsvariable einrichten, damit die Tools eine sichere Verbindung herstellen können.

Dies ist weit entfernt von der einfachen, benutzerfreundlichen Erfahrung, die man erwarten könnte. Es erfordert ein hohes Maß an Vertrautheit mit der Kommandozeile, dem Bearbeiten von Konfigurationsdateien und dem Umgang mit API-Schlüsseln, was es für die meisten Designer, Produktmanager und sogar einige Entwickler sofort unerreichbar macht.

Die Grenzen eines reinen Code-Ansatzes

Nehmen wir an, Sie kämpfen sich durch die knifflige Einrichtung und bekommen es zum Laufen. Das ist ein riesiger Erfolg! Aber es löst nur einen sehr spezifischen Teil des Produktentwicklungspuzzles: die Umwandlung eines statischen Designs in den ersten Code. Es hilft bei nichts, was danach kommt.

-

Laufender Support: Das Feature ist live und Kunden beginnen, es zu nutzen. Was passiert, wenn sie Fragen haben? Ihr Support-Team steht jetzt an vorderster Front, hat aber keine direkte Verbindung zum Design- oder Entwicklungskontext.

-

Internes Wissen: Wie bringen Sie Ihre internen Teams auf den neuesten Stand? Ihre Kundensupport-Mitarbeiter, Vertriebsingenieure und das Marketingteam müssen alle verstehen, wie das neue Feature funktioniert, aber sie werden nicht durch Code oder Figma-Dateien wühlen, um das herauszufinden.

-

Zugänglichkeit: Dieser gesamte Arbeitsablauf ist von Entwicklern für Entwickler gemacht. Er lässt Produktmanager, Support-Leiter und Designer, die einen enormen Mehrwert aus KI-Automatisierung ziehen könnten, aber nicht ihre Tage in einem Code-Editor verbringen, komplett außen vor.

Ein besserer Weg: Wissen über die Designdatei hinaus vereinheitlichen

Ein effizienter Arbeitsablauf benötigt eine KI, die den gesamten Produktlebenszyklus versteht, nicht nur eine einzelne Figma-Datei. Während die Codex-Integration darauf abzielt, ein Design in Code umzuwandeln, ist eine Plattform wie eesel AI darauf ausgelegt, den Support und das interne Wissensmanagement zu automatisieren, das nachdem das Feature erstellt wurde, stattfindet.

Anstatt sich nur mit einem Designtool zu verbinden, schließt sich eesel AI an das gesamte Gehirn Ihres Unternehmens an:

-

Helpdesks: Es kann aus jahrelangen früheren Gesprächen in Zendesk, Freshdesk und [Intercom] lernen.

-

Interne Wikis: Es nimmt sofort Ihre gesamte Dokumentation aus Orten wie Confluence, Google Docs und Notion auf.

-

Chat-Tools: Sie können hilfreiche KI-Assistenten direkt dort einsetzen, wo Ihre Teams (und Kunden) bereits sind, wie in Slack oder Microsoft Teams.

Hier wird der Unterschied wirklich deutlich. Die komplexe, entwicklerlastige Einrichtung für Codex und Figma ist das genaue Gegenteil der Self-Service-Plattform von eesel AI, auf der ein nicht-technischer Support-Manager in wenigen Minuten einen leistungsstarken KI-Agenten erstellen, testen und starten kann. Kein Programmieren, keine Konfigurationsdateien.

Preise und Verfügbarkeit

Okay, sprechen wir darüber, was es kostet, Zugang zu diesen Tools zu erhalten. Das Verständnis der Preise und der Plananforderungen ist ziemlich wichtig, um zu entscheiden, ob diese Integration überhaupt für Ihr Team geeignet ist.

Preise für OpenAI Codex

Dieser Punkt ist etwas unklar. OpenAI hat keinen öffentlichen, eigenständigen Preis für das Codex-Entwickler-Tool selbst. Der Zugang ist normalerweise in andere Dienste integriert. Zum Beispiel ist es Teil dessen, was GitHub Copilot zum Laufen bringt (das ein eigenes monatliches Abonnement hat), oder seine Nutzung wird über Ihre allgemeinen API-Credits abgerechnet, wenn Sie die zugrunde liegenden Modelle direkt verwenden.

Figma-Preise

Bei Figma sind die Dinge viel klarer. Um den MCP-Server sinnvoll nutzen zu können, benötigen Sie einen kostenpflichtigen Plan mit einem Dev- oder Full-Seat. Benutzer des kostenlosen Plans sind auf nur sechs Tool-Aufrufe pro Monat beschränkt, was im Grunde nichts ist, wenn Sie ernsthafte Entwicklungsarbeit leisten wollen.

Hier ist eine kurze Übersicht über die relevanten Figma-Pläne:

| Plan | Preis (pro Editor/Monat, jährliche Abrechnung) | Wichtige Funktionen für Entwickler |

|---|---|---|

| Professional | $12 | Volle Design- und Prototyping-Funktionen. |

| Organization | $45 | Designsysteme, erweiterte Sicherheit und Admin-Kontrollen. |

| Enterprise | $75 | Skalierbare Sicherheit, dedizierter Support und Kontrollen. |

Das Fazit hier ist, dass die Möglichkeit, Figma mit einem KI-Programmierassistenten zu verbinden, eine Premium-Funktion ist, die zahlenden Kunden der höheren Pläne vorbehalten ist.

Vom Design-zum-Code zum Design-zum-Support

Integrationen von OpenAI Codex mit Figma stellen eine faszinierende, leistungsstarke, aber sehr technische Grenze in der KI-gestützten Entwicklung dar. Für Entwickler, die bereit sind, die Ärmel hochzukrempeln, ist die direkte MCP-Verbindung ein vielversprechendes Werkzeug, das den anfänglichen Programmierprozess definitiv beschleunigen kann. Es ist jedoch immer noch komplex einzurichten und adressiert nur einen kleinen Teil der viel größeren Herausforderung des Produktlebenszyklus.

Die Zukunft dieses Bereichs besteht nicht nur darin, schneller Code zu generieren. Es geht darum, ein vernetztes Ökosystem aufzubauen, in dem Wissen nahtlos von einer Designdatei zum Editor des Entwicklers und schließlich zum Kundensupport-Team fließt, das echten Menschen bei der Nutzung des Endprodukts hilft. Für Teams, die diese gesamte Kette automatisieren möchten, ohne Entwicklerzeit für diese Aufgabe aufzuwenden, ist ein anderer Ansatz erforderlich.

Der intelligentere Weg zur Workflow-Automatisierung

Anstatt Tage damit zu verbringen, sich mit Kommandozeilen-Tools und obskuren „.toml“-Dateien herumzuschlagen, was wäre, wenn Sie den Kundensupport automatisieren für Ihr neues Feature in der Zeit könnten, die es braucht, um einen Kaffee zu trinken?

eesel AI bietet eine radikal einfachere Self-Service-Plattform, die genau das tut. Sie verbindet all Ihre verstreuten Wissensquellen, um KI-Agenten zu betreiben, die Supportanfragen an vorderster Front bearbeiten, Ihre menschlichen Agenten unterstützen bei komplexen Problemen und automatisch eingehende Tickets triagieren. Das Beste daran ist, dass es einen leistungsstarken Simulationsmodus gibt, mit dem Sie Ihre KI an Tausenden Ihrer eigenen historischen Support-Tickets testen können. Sie können genau sehen, wie hoch die Lösungsrate wäre, bevor Sie sie jemals für Kunden aktivieren. Es geht um selbstbewusste, risikofreie Automatisierung.

Bereit, mehr als nur Code zu automatisieren? Testen Sie eesel AI kostenlos und sehen Sie, wie einfach es ist, einen KI-Agenten zu erstellen, der Ihr gesamtes Unternehmen versteht.

Häufig gestellte Fragen

Integrationen von OpenAI Codex mit Figma zielen darauf ab, den Prozess der Umwandlung von Designdateien in funktionsfähigen Code zu automatisieren. Sie lösen die übliche Herausforderung der manuellen Übersetzung und des Hin und Hers zwischen Designern und Entwicklern und beschleunigen so die anfängliche Codegenerierung aus Figma-Designs.

Technisch gesehen nutzen Integrationen von OpenAI Codex mit Figma das Model Context Protocol (MCP). Figma stellt einen MCP-Server zur Verfügung, der es den Codex-Entwickler-Tools ermöglicht, direkt auf Designdaten aus Figma-Dateien zuzugreifen. Dies gibt der KI Echtzeit-Kontext aus den Designs, um entsprechenden Code zu generieren.

In der Praxis erfordert die Einrichtung von Integrationen von OpenAI Codex mit Figma eine erhebliche manuelle Konfiguration. Benutzer müssen oft Konfigurationsdateien bearbeiten, eine Kommandozeilenschnittstelle zur Authentifizierung verwenden und persönliche Zugriffstoken aus den Figma-Einstellungen verwalten. Dies erfordert Vertrautheit mit fortgeschrittenen Entwickler-Tools.

Die Haupteinschränkung besteht darin, dass sich Integrationen von OpenAI Codex mit Figma ausschließlich auf die Generierung von anfänglichem Code aus Designs konzentrieren. Sie befassen sich nicht mit breiteren Aspekten des Produktlebenszyklus, wie z. B. laufendem Kundensupport, internem Wissensmanagement oder der Zugänglichkeit für Nicht-Entwickler.

Für die Codex-Tools von OpenAI ist die Preisgestaltung in der Regel an API-Nutzungsguthaben gebunden oder in Diensten wie GitHub Copilot enthalten. Für Figma erfordert die Nutzung des MCP-Servers für diese Integrationen einen kostenpflichtigen Plan mit einem Dev- oder Full-Seat, da der kostenlose Plan nur sehr begrenzte Tool-Aufrufe bietet.

Obwohl die ursprünglichen „Codex“-Modelle eingestellt wurden, nutzen aktuelle Integrationen von OpenAI Codex mit Figma das breitere Set an Entwickler-Tools von OpenAI. Diese modernen Tools verwenden jetzt neuere, leistungsfähigere GPT-Modelle, um natürliche Sprache in Code umzuwandeln, wodurch die Funktionalität relevant bleibt.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.