Transformer un superbe design Figma en code fonctionnel a toujours été l'un des casse-tête classiques des équipes produit. C'est un processus rempli de traductions manuelles, d'échanges interminables entre designers et développeurs, et de ce sentiment persistant que les choses pourraient aller beaucoup plus vite. Le rêve, bien sûr, serait que des outils d'IA comme OpenAI Codex puissent simplement analyser un fichier Figma et générer un code parfait.

Et dans une certaine mesure, ce rêve se rapproche. Mais que faut-il vraiment pour y parvenir ?

Ce guide est un aperçu pratique et sans superflu des intégrations d'OpenAI Codex avec Figma. Nous allons parcourir le « mode d'emploi » officiel, mais surtout, nous allons nous plonger dans les complexités du monde réel que la documentation omet généralement. Nous verrons ce qu'il faut pour construire un flux de travail vraiment fluide qui ne s'arrête pas au code, mais qui va jusqu'au support de vos clients.

Que sont OpenAI Codex et Figma ?

Avant de nous lancer dans leur connexion, mettons-nous d'accord sur les deux principaux acteurs de cette histoire.

Qu'est-ce qu'OpenAI Codex ?

Vous avez probablement entendu parler d'OpenAI Codex comme le modèle d'IA qui alimente GitHub Copilot, l'outil qui donne l'impression de lire dans vos pensées pendant que vous codez. À la base, Codex est un système d'IA d'OpenAI qui est incroyablement doué pour transformer le langage naturel, l'anglais courant, en code dans des dizaines de langages.

Maintenant, une information rapide mais importante : les modèles originaux nommés « Codex » ont en fait été abandonnés en mars 2023. Aujourd'hui, le terme « Codex » est souvent utilisé pour désigner l'ensemble plus large des outils de développement d'OpenAI, qui comprend une interface de ligne de commande (CLI) et des extensions pour les éditeurs de code. Ces outils modernes utilisent des modèles GPT plus récents et plus puissants pour accomplir leur tâche. Ainsi, lorsque nous parlons d'intégration avec Figma, nous parlons de nous connecter à cet ensemble d'outils actuel.

Qu'est-ce que Figma ?

Si vous travaillez dans le monde du produit ou du design, vous connaissez presque certainement Figma. C'est l'outil de design collaboratif basé sur le cloud qui est devenu quasiment la norme de l'industrie pour tout, des premières maquettes filaires aux prototypes interactifs complets et aux systèmes de design massifs.

Pour les développeurs, l'un des ajouts les plus révolutionnaires a été le Dev Mode. C'est un espace de travail spécifique dans Figma, conçu pour rendre la transition du design au développement moins pénible. Il donne aux développeurs un accès direct aux mesures, aux spécifications CSS, aux ressources téléchargeables et même à des extraits de code prêts à être copiés. Cet accent mis sur la réduction du fossé entre le design et le développement en fait un candidat idéal pour être associé à un assistant de codage IA.

L'approche officielle : Comment fonctionnent les intégrations d'OpenAI Codex avec Figma

Alors, comment faire en sorte que ces deux outils puissants communiquent entre eux ? La magie technique derrière tout cela repose sur un langage commun qu'ils peuvent tous deux parler.

Comprendre le Model Context Protocol (MCP)

Le tout est basé sur quelque chose appelé le Model Context Protocol (MCP). C'est un standard ouvert qui agit essentiellement comme un adaptateur universel pour l'IA.

Imaginez-le comme un port USB pour les modèles d'IA. Un port USB vous permet de brancher toutes sortes d'appareils différents, un clavier, une souris, un disque dur, et votre ordinateur sait simplement quoi en faire. Le MCP fait la même chose pour l'IA. Il fournit un moyen standard de « brancher » différentes sources d'informations (comme un fichier Figma, un navigateur web ou une base de données) pour donner à un modèle d'IA un contexte frais et en temps réel. Au lieu de ne connaître que ce sur quoi il a été entraîné il y a des mois, l'IA peut désormais voir et utiliser des informations en direct provenant d'autres outils.

Le rôle du serveur MCP de Figma

Pour rendre ses données de design accessibles à une IA, Figma exécute ce qu'on appelle un « serveur MCP ». Ce serveur est la passerelle qui permet à tout outil compatible MCP, comme les outils de développement Codex, de récupérer des informations directement depuis vos fichiers Figma. C'est ainsi que l'IA peut « voir » vos designs.

Selon la documentation de Figma, il existe plusieurs façons de se connecter à ce serveur :

-

Serveur MCP de bureau : Il s'exécute localement sur votre machine via l'application de bureau Figma. C'est parfait pour un flux de travail où vous pourriez cliquer sur un composant dans Figma puis demander à l'IA de le construire dans votre éditeur de code.

-

Serveur MCP distant : Il s'agit d'une adresse web hébergée (« https://mcp.figma.com/mcp ») qui permet aux outils et services basés sur le cloud de se connecter directement sans avoir besoin que l'application de bureau soit en cours d'exécution.

L'objectif final est assez simple : donner à l'IA un accès direct à vos cadres de conception, composants, variables de couleur et spécifications de mise en page. Avec ce contexte, elle peut générer un code qui n'est pas seulement fonctionnel, mais qui est aussi parfaitement aligné avec votre système de design établi.

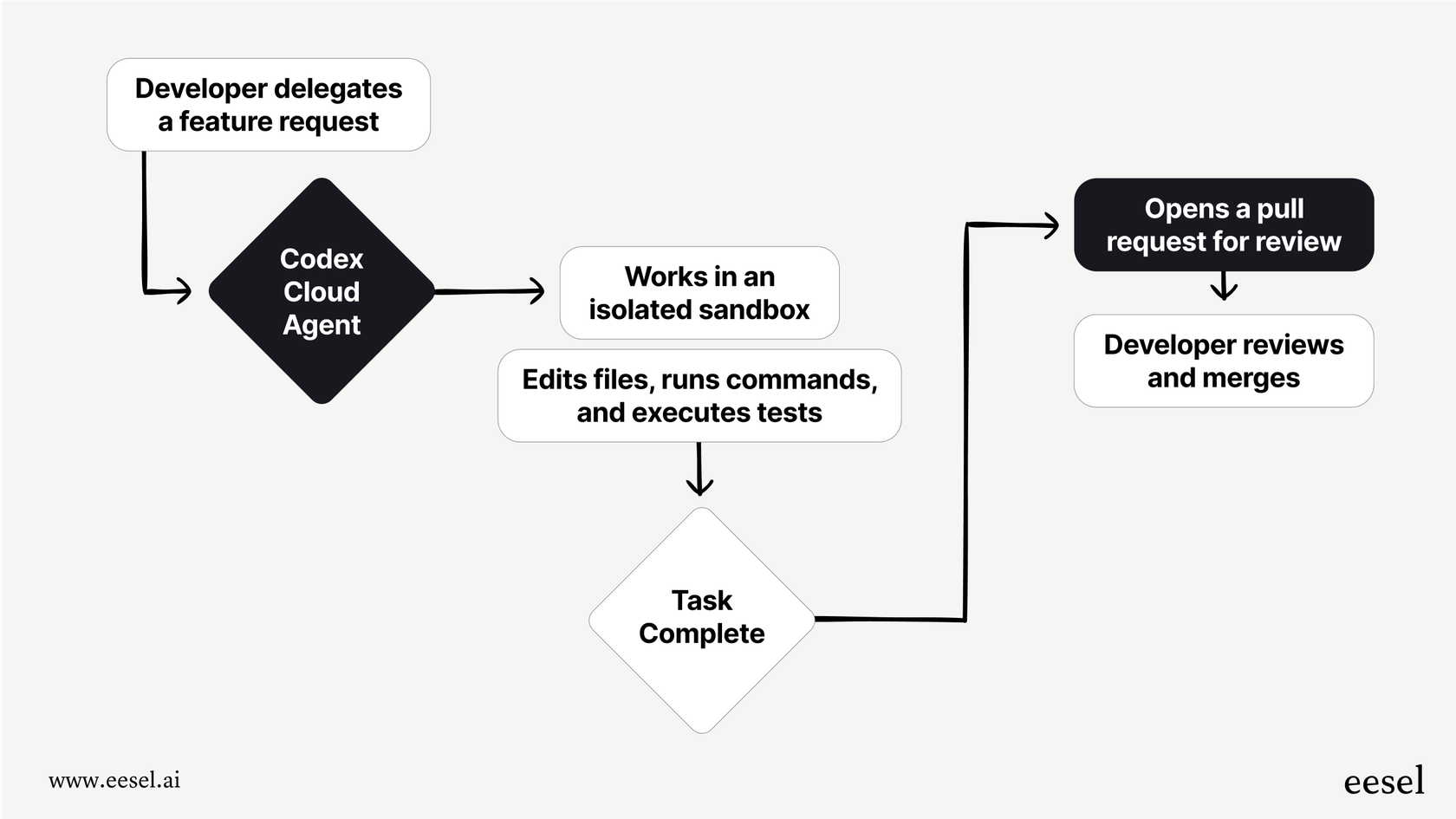

Le flux de travail prévu

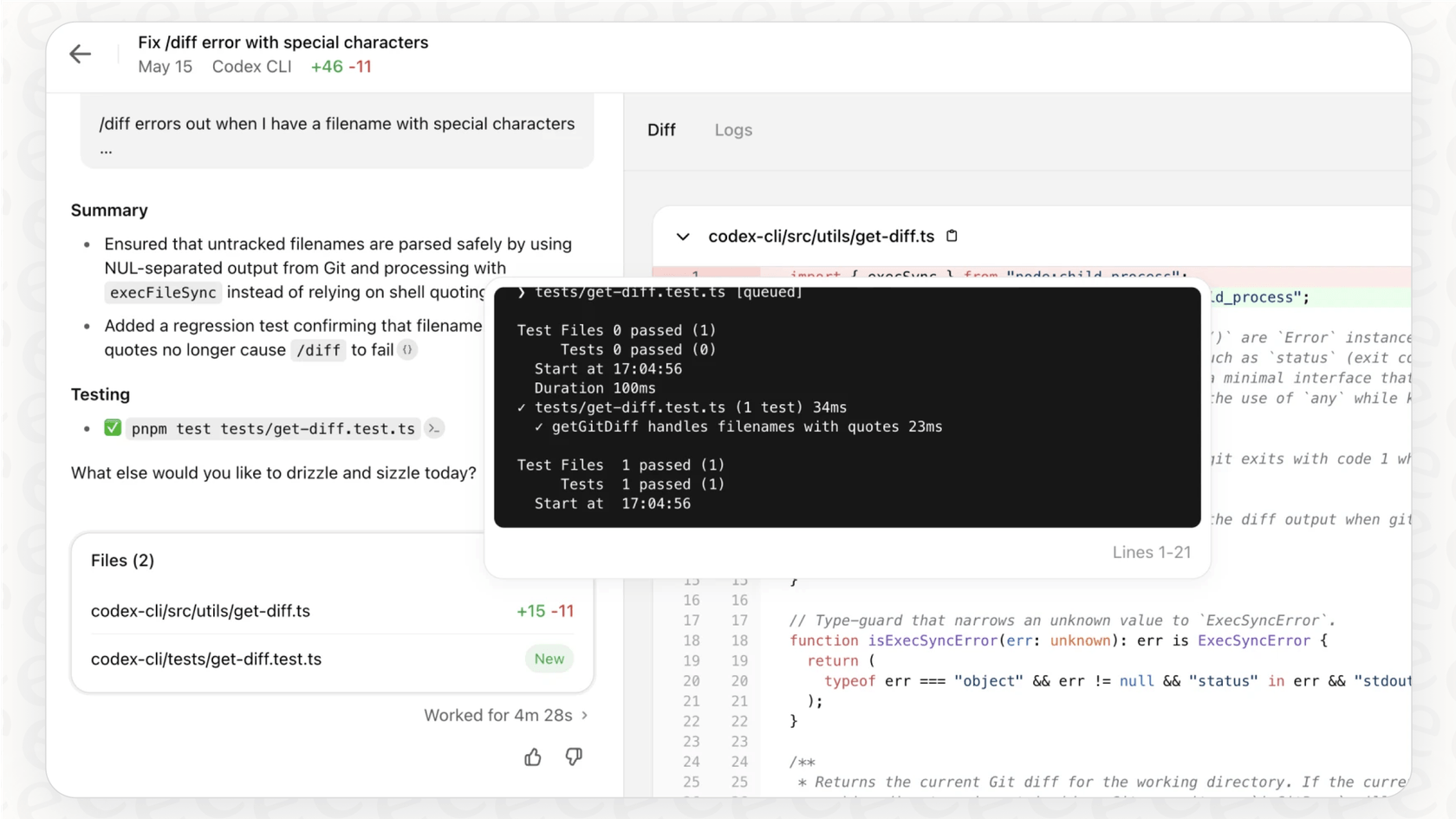

Sur le papier, le processus semble idyllique. Un développeur connecte son outil Codex (probablement exécuté dans un éditeur comme VS Code) au serveur MCP de Figma. Il récupère un lien vers un cadre spécifique dans un fichier Figma, le colle dans son éditeur et écrit une instruction comme : « Construis-moi un composant React basé sur ce design, et fais en sorte qu'il soit au pixel près. »

Comme l'IA peut accéder au contexte de conception via le serveur MCP, elle peut voir les noms des composants, récupérer les codes hexadécimaux exacts de vos couleurs de marque, utiliser les bonnes tailles de police et comprendre l'espacement, ce qui conduit à un code incroyablement précis. Du moins, c'est la théorie. Vous pouvez trouver la documentation officielle à ce sujet sur le site des développeurs d'OpenAI.

Cette vidéo fournit un guide étape par étape sur la façon d'ajouter des serveurs MCP à la CLI Codex d'OpenAI, vous donnant un aperçu plus détaillé de la configuration technique.

La réalité des intégrations d'OpenAI Codex avec Figma : Pourquoi elles sont complexes

Bien que le flux de travail officiel semble propre et simple, la réalité sur le terrain est... eh bien, beaucoup plus compliquée. Cette configuration est loin d'être une installation en un clic et n'est vraiment accessible qu'aux développeurs qui sont très à l'aise pour travailler en coulisses.

Un aperçu du processus de configuration réel

Si vous explorez les forums communautaires, vous verrez rapidement le décalage entre la documentation officielle et l'expérience réelle. Un excellent exemple est ce fil de discussion Reddit où les développeurs partagent les obstacles qu'ils ont rencontrés. Le processus ne se résume pas à « l'activer » ; il implique souvent une série d'étapes non évidentes qui ne sont pas mentionnées dans les guides principaux :

-

Configuration manuelle : Vous devez trouver et modifier manuellement un fichier de configuration appelé « config.toml » sur votre machine juste pour indiquer à l'outil Codex que le serveur Figma existe.

-

CLI pour l'authentification : Même si vous voulez simplement utiliser l'extension pratique de VS Code, vous ne pouvez pas. Vous devez d'abord ouvrir votre terminal et utiliser l'interface de ligne de commande (CLI) pour authentifier votre compte.

-

Gestion des jetons : Vous devrez également vous rendre dans vos paramètres Figma, générer un jeton d'accès personnel (essentiellement un mot de passe unique pour les applications), puis comprendre comment le configurer en tant que variable d'environnement pour que les outils puissent se connecter en toute sécurité.

C'est loin de l'expérience simple et conviviale à laquelle on pourrait s'attendre. Cela nécessite un solide niveau de confort avec la ligne de commande, l'édition de fichiers de configuration et la gestion des clés API, ce qui la met immédiatement hors de portée de la plupart des designers, chefs de produit et même de certains développeurs.

Les limites d'une approche uniquement axée sur le code

Disons que vous surmontez la configuration délicate et que vous la faites fonctionner. C'est une grande victoire ! Mais cela ne résout qu'une partie très spécifique du puzzle du développement de produits : transformer un design statique en code initial. Cela n'aide en rien pour tout ce qui vient après.

-

Support continu : La fonctionnalité est en ligne et les clients commencent à l'utiliser. Que se passe-t-il lorsqu'ils ont des questions ? Votre équipe de support est maintenant en première ligne, mais elle n'a pas de lien direct avec le contexte de conception ou de développement.

-

Connaissance interne : Comment mettez-vous vos équipes internes à niveau ? Vos agents de support client, vos ingénieurs commerciaux et votre équipe marketing doivent tous comprendre comment fonctionne la nouvelle fonctionnalité, mais ils ne vont pas fouiller dans le code ou les fichiers Figma pour le savoir.

-

Accessibilité : Tout ce flux de travail est conçu par des développeurs, pour des développeurs. Il laisse complètement de côté les chefs de produit, les responsables du support et les designers qui pourraient tirer une valeur énorme de l'automatisation par l'IA mais qui ne passent pas leurs journées dans un éditeur de code.

Une meilleure approche : Unifier les connaissances au-delà du fichier de design

Un flux de travail efficace nécessite une IA qui comprend le cycle de vie entier du produit, pas seulement un seul fichier Figma. Alors que l'intégration Codex est ultra-focalisée sur la transformation d'un design en code, une plateforme comme eesel AI est conçue pour automatiser le support et la gestion des connaissances internes qui se produisent après la création de la fonctionnalité.

Au lieu de se connecter uniquement à un outil de design, eesel AI se branche sur l'ensemble du cerveau de votre entreprise :

-

Services d'assistance : Elle peut apprendre de plusieurs années de conversations passées dans Zendesk et Freshdesk.

-

Wikis internes : Elle absorbe instantanément toute votre documentation provenant de plateformes comme Confluence, Google Docs et Notion.

-

Outils de chat : Vous pouvez déployer des assistants IA utiles directement là où vos équipes (et vos clients) se trouvent déjà, comme dans Slack ou Microsoft Teams.

C'est là que la différence devient vraiment claire. La configuration complexe et gourmande en ressources de développement pour Codex et Figma est à l'opposé de la plateforme en libre-service d'eesel AI, où un responsable du support non technique peut construire, tester et lancer un agent IA puissant en quelques minutes. Pas de codage, pas de fichiers de configuration.

Tarifs et disponibilité

Ok, parlons de ce que coûte l'accès à ces outils. Comprendre les tarifs et les exigences des forfaits est assez important pour décider si cette intégration est même un bon choix pour votre équipe.

Tarifs d'OpenAI Codex

Celui-ci est un peu flou. OpenAI n'a pas de prix public et autonome pour l'outil de développement Codex lui-même. L'accès est généralement inclus avec d'autres services. Par exemple, il fait partie de ce qui fait fonctionner GitHub Copilot (qui a son propre abonnement mensuel), ou son utilisation est facturée sur vos crédits API généraux si vous utilisez directement les modèles sous-jacents.

Tarifs de Figma

Pour Figma, les choses sont beaucoup plus claires. Pour utiliser le serveur MCP de manière significative, vous aurez besoin d'un forfait payant avec un siège Dev ou Full. Les utilisateurs du forfait gratuit sont limités à seulement six appels d'outils par mois, ce qui n'est pratiquement rien si vous essayez de faire du vrai travail de développement.

Voici un aperçu rapide des forfaits Figma pertinents :

| Formule | Prix (par éditeur/mois, facturation annuelle) | Fonctionnalités clés pour les développeurs |

|---|---|---|

| Professionnel | 12 $ | Fonctionnalités complètes de design et de prototypage. |

| Organisation | 45 $ | Systèmes de design, sécurité avancée et contrôles d'administration. |

| Entreprise | 75 $ | Sécurité évolutive, support dédié et contrôles. |

Ce qu'il faut retenir, c'est que la possibilité de connecter Figma à un assistant de codage IA est une fonctionnalité premium, réservée aux clients payants des forfaits supérieurs.

Du design-au-code au design-au-support

Les intégrations d'OpenAI Codex avec Figma représentent une frontière fascinante, puissante, mais très technique dans le développement assisté par l'IA. Pour les développeurs prêts à retrousser leurs manches, la connexion MCP directe est un outil prometteur qui peut certainement accélérer le processus de codage initial. Cependant, sa mise en place reste complexe et ne concerne qu'une petite partie du défi beaucoup plus vaste du cycle de vie du produit.

L'avenir de ce domaine ne consiste pas seulement à générer du code plus rapidement. Il s'agit de construire un écosystème connecté où la connaissance circule de manière transparente d'un fichier de design à l'éditeur du développeur, et enfin, à l'équipe de support client qui aide les vraies personnes à utiliser le produit final. Pour les équipes qui veulent automatiser toute cette chaîne sans y consacrer du temps de développement, une approche différente est nécessaire.

La voie la plus intelligente vers l'automatisation des flux de travail

Au lieu de passer des jours à vous battre avec des outils en ligne de commande et des fichiers « .toml » obscurs, et si vous pouviez automatiser le support client pour votre nouvelle fonctionnalité le temps de boire un café ?

eesel AI propose une plateforme radicalement plus simple et en libre-service qui fait exactement cela. Elle connecte toutes vos sources de connaissances dispersées pour alimenter des agents IA capables de gérer les questions de support de première ligne, d'assister vos agents humains pour les problèmes complexes et de trier automatiquement les tickets entrants. Mieux encore, elle dispose d'un puissant mode de simulation, qui vous permet de tester votre IA sur des milliers de vos propres tickets de support historiques. Vous pouvez voir exactement quel serait son taux de résolution avant même de l'activer pour les clients. Tout est question d'automatisation confiante et sans risque.

Prêt à automatiser plus que du code ? Essayez eesel AI gratuitement et découvrez à quel point il est facile de créer un agent IA qui comprend l'ensemble de votre entreprise.

Questions fréquentes

Les intégrations d'OpenAI Codex avec Figma visent à automatiser le processus de conversion des fichiers de design en code fonctionnel. Elles s'attaquent au défi courant de la traduction manuelle et des allers-retours entre designers et développeurs, accélérant la génération initiale de code à partir des designs Figma.

Techniquement, les intégrations d'OpenAI Codex avec Figma utilisent le Model Context Protocol (MCP). Figma fournit un serveur MCP qui permet aux outils de développement Codex d'accéder directement aux données de design des fichiers Figma. Cela donne à l'IA un contexte en temps réel à partir des designs pour générer le code correspondant.

En réalité, la configuration des intégrations d'OpenAI Codex avec Figma implique une configuration manuelle importante. Les utilisateurs doivent souvent modifier des fichiers de configuration, utiliser une interface de ligne de commande pour l'authentification et gérer les jetons d'accès personnels depuis les paramètres de Figma. Cela nécessite une aisance avec les outils de développement avancés.

La principale limite est que les intégrations d'OpenAI Codex avec Figma se concentrent uniquement sur la génération de code initial à partir des designs. Elles ne traitent pas les aspects plus larges du cycle de vie du produit, tels que le support client continu, la gestion des connaissances internes ou l'accessibilité pour les non-développeurs.

Pour les outils Codex d'OpenAI, la tarification est généralement liée aux crédits d'utilisation de l'API ou incluse dans des services comme GitHub Copilot. Pour Figma, l'utilisation du serveur MCP pour ces intégrations nécessite une formule payante avec un siège Dev ou Full, car la formule gratuite offre un nombre très limité d'appels à l'outil.

Bien que les modèles « Codex » originaux aient été abandonnés, les intégrations d'OpenAI Codex avec Figma s'appuient sur l'ensemble plus lourd des outils de développement d'OpenAI. Ces outils modernes utilisent désormais des modèles GPT plus récents et plus puissants pour convertir le langage naturel en code, garantissant ainsi que la fonctionnalité reste pertinente.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.