Essayer de choisir le bon modèle d'IA pour votre entreprise peut s'apparenter à un travail à plein temps. D'un côté, il y a GPT-4 Turbo d'OpenAI et de l'autre, Llama 3 de Meta, et les spécifications techniques peuvent vous donner le tournis.

Pour la plupart d'entre nous, en particulier dans le support client, la vraie question ne concerne pas les benchmarks abstraits. Il s'agit de savoir ce qui fonctionnera réellement, ce qui ne fera pas sauter la banque, et ce que vous pouvez mettre en place sans embaucher une équipe de développeurs. Ce guide est une comparaison directe entre GPT-4 Turbo et Llama 3, axée sur ce qui compte vraiment pour votre entreprise : leurs performances dans le monde réel, leur coût réel et là où ils peuvent faire une vraie différence.

Qu'est-ce que GPT-4 Turbo ?

Commençons par celui dont vous avez probablement le plus entendu parler : GPT-4 Turbo. C'est le grand modèle d'OpenAI, l'entreprise qui nous a donné ChatGPT. Vous pouvez le considérer comme le moteur haut de gamme et premium de l'espace IA. C'est un modèle "propriétaire" ou "à code source fermé", ce qui signifie simplement que vous ne pouvez pas jeter un œil sous le capot pour voir comment il fonctionne. Mais ce que vous voyez, ce sont ses performances vraiment impressionnantes.

Voici ce que vous devez savoir à son sujet :

-

Performances de premier ordre : Lorsqu'il s'agit de raisonnement complexe, de problèmes mathématiques et de compréhension de différentes langues, GPT-4 Turbo est souvent le modèle à battre. Il est particulièrement doué pour démêler les problèmes délicats et nuancés.

-

Une mémoire immense : Il dispose d'une fenêtre de contexte massive (jusqu'à 128 000 tokens). Pour le dire simplement, c'est comme s'il pouvait lire et se souvenir d'un livre de 300 pages en une seule fois. Cela lui permet de comprendre l'ensemble d'un long document ou de fils de discussion de support complexes sans se perdre.

-

Accessible via une API : Les entreprises interagissent généralement avec GPT-4 Turbo via l'API d'OpenAI. Cela signifie que vous avez besoin de développeurs pour l'intégrer à vos outils existants. C'est le moteur qui tourne en coulisses de nombreuses applications d'IA, mais il ne fonctionne pas de manière autonome.

Qu'est-ce que Llama 3 ?

De l'autre côté du ring se trouve Llama 3 de Meta AI. Cette famille de modèles fait des vagues car elle est open-source, et c'est un avantage considérable. Cela donne aux entreprises beaucoup plus de flexibilité dans la manière dont elles utilisent le modèle, y compris la possibilité de l'exécuter sur leurs propres serveurs pour plus de confidentialité et de contrôle.

Voici ce qui le distingue :

-

Différentes tailles pour différentes tâches : Llama 3 est disponible en plusieurs tailles, les modèles à 8 milliards et 70 milliards de paramètres étant les plus courants. C'est une excellente fonctionnalité car vous pouvez choisir un modèle qui vous offre les performances dont vous avez besoin sans payer pour une puissance que vous n'utiliserez pas. Vous n'avez pas toujours besoin de l'outil le plus cher pour faire le travail.

-

Des performances très compétitives : Ne vous laissez pas tromper par l'étiquette "open-source". Le modèle Llama 3 70B est un poids lourd. Dans de nombreux tests, il obtient des résultats équivalents, et parfois même meilleurs, que les versions précédentes de GPT-4. C'est la preuve solide que les modèles open-source peuvent rivaliser avec les modèles propriétaires.

-

Conçu pour l'efficacité : Llama 3 a été conçu pour être puissant sans être surchargé. Cela en fait un choix populaire pour les entreprises et les développeurs qui veulent une IA de premier ordre plus abordable par token. Vous y accédez généralement via des fournisseurs de cloud ou en l'hébergeant vous-même.

Performances et benchmarks : une comparaison directe

Très bien, regardons les chiffres. Bien que ces tests ne racontent pas toute l'histoire, ils nous donnent une bonne base de référence sur la façon dont ces deux modèles "pensent" et où chacun a un avantage naturel.

Connaissances générales et raisonnement

En ce qui concerne les questions générales de type académique, GPT-4 Turbo a généralement une légère avance. Sur des tests comme le MMLU (qui est rempli de questions de niveau supérieur sur divers sujets), sa formation approfondie lui confère un léger avantage.

Cela dit, Llama 3 70B est juste sur ses talons. Il bat souvent les anciens modèles GPT-4 et comble rapidement l'écart. Pour le type de questions de connaissances générales que votre entreprise est susceptible de rencontrer, vous ne pourriez probablement pas faire la différence entre eux. Les deux sont largement assez intelligents.

Capacités en codage et en mathématiques

C'est là que les différences commencent à devenir un peu plus évidentes.

-

Codage : Sur des tests comme HumanEval, qui mesure la capacité d'un modèle à écrire du code, les deux sont très forts. GPT-4 Turbo a tendance à être un peu meilleur pour résoudre des défis de programmation complexes en plusieurs étapes. D'un autre côté, certains développeurs ont constaté que Llama 3 est fantastique pour suivre des instructions de formatage très précises, ce qui est un avantage énorme lorsque vous avez besoin d'une sortie de code prévisible.

-

Mathématiques : GPT-4 Turbo est le grand gagnant en ce qui concerne les tests de raisonnement mathématique. Son architecture le rend plus fiable pour les tâches qui nécessitent des calculs exacts et une logique étape par étape. Si les chiffres occupent une grande place dans votre cas d'utilisation, GPT-4 Turbo est probablement le choix le plus fiable.

Une comparaison rapide des benchmarks

| Benchmark | Tâche | GPT-4 Turbo (Score approx.) | Llama 3 70B (Score approx.) | Point clé |

|---|---|---|---|---|

| MMLU | Connaissances générales | ~86% | ~82% | GPT-4 a un léger avantage en matière de connaissances académiques générales. |

| HumanEval | Génération de code | ~87% | ~82% | Les deux sont très capables, mais GPT-4 est souvent meilleur pour la logique complexe. |

| MATH | Résolution de problèmes mathématiques | ~73% | ~50-60% | GPT-4 est le grand gagnant pour le raisonnement mathématique. |

Applications commerciales pratiques et cas d'utilisation

Bon, assez de théorie. Comment tout cela vous aide-t-il réellement à accomplir votre travail ? Un modèle d'IA en soi n'est qu'un cerveau dans un bocal ; il n'est utile que lorsque vous le connectez à vos problèmes commerciaux spécifiques et lui donnez les bonnes informations pour travailler.

Automatisation du support client

Les deux modèles sont excellents pour gérer les tâches de support. Ils peuvent résumer de longs historiques de tickets, aider les agents à rédiger des réponses réfléchies et répondre aux questions fréquemment posées. Leurs grandes fenêtres de contexte leur permettent de traiter des conversations compliquées pour aller au cœur du problème.

Mais voici ce qu'on ne vous dit pas toujours : ces modèles ne savent rien de votre entreprise. Une IA ne peut pas répondre à une question sur votre politique de retour si elle ne l'a jamais vue. Elle doit être connectée aux connaissances de votre entreprise pour être efficace.

Création et résumé de contenu

Dans ce domaine, les deux modèles ont des atouts différents. Les retours d'utilisateurs et divers tests ont montré que Llama 3 est particulièrement bon pour le résumé. Il peut prendre un long document et le condenser en un résumé clair et précis, ce qui est idéal pour des choses comme les rapports internes ou la transmission d'un ticket à un autre agent.

GPT-4 Turbo, cependant, a tendance à être meilleur pour générer du contenu créatif plus long. Si vous avez besoin d'aide pour rédiger un article de blog, trouver des idées marketing ou écrire des descriptions de produits détaillées à partir de quelques notes, c'est probablement la meilleure option.

Gestion des connaissances internes

L'un ou l'autre modèle peut être utilisé pour créer un bot de questions-réponses interne pour vos employés. Imaginez simplement votre équipe posant des questions sur les politiques de l'entreprise, le dépannage informatique ou les mises à jour de projets et obtenant une réponse immédiate et correcte.

Le principal obstacle n'est pas de choisir le modèle ; c'est d'amener votre équipe à l'utiliser. Un nouveau bot est inutile si les gens doivent ouvrir encore une autre application. L'outil doit vivre là où votre équipe se trouve déjà. Une plateforme comme le Chat Interne IA d'eesel AI s'intègre directement dans Slack ou Microsoft Teams. Il apprend de vos documents internes et donne à votre équipe des réponses instantanées dans les outils de chat qu'ils utilisent toute la journée.

Coût, accessibilité et personnalisation

Pour la plupart d'entre elles, c'est là que la décision se prend vraiment. Le "meilleur" modèle n'a pas d'importance s'il est trop cher, trop difficile à mettre en place ou trop rigide pour répondre à vos besoins.

Le coût réel de chaque modèle

-

GPT-4 Turbo : Vous payez OpenAI pour chaque bit d'information que vous envoyez et recevez, sur la base de "tokens". C'est le choix premium, et les coûts peuvent s'accumuler rapidement et être difficiles à prévoir, surtout si vous avez une augmentation soudaine des questions de clients.

-

Llama 3 : Parce qu'il est open-source, Llama 3 est beaucoup moins cher par token lorsque vous l'utilisez via un service d'hébergement.

Mais le prix par token n'est qu'une partie de l'histoire. Le coût total inclut également le temps que vos ingénieurs passent à la configuration, à l'intégration, à la correction des bugs et à la maintenance continue. C'est pourquoi de nombreuses entreprises optent pour une plateforme avec une tarification simple et prévisible. Par exemple, eesel AI propose des forfaits mensuels clairs qui ne vous facturent pas par ticket résolu. Votre facture reste la même même pendant vos mois les plus chargés, vous offrant des coûts prévisibles sans les maux de tête cachés de l'ingénierie.

Accessibilité et facilité de configuration

L'utilisation directe de l'un de ces modèles nécessite beaucoup de compétences techniques. Vous avez besoin de développeurs qui peuvent travailler avec l'API d'OpenAI ou qui peuvent gérer l'hébergement et le déploiement complexes de Llama 3. C'est un énorme obstacle pour la plupart des équipes de support et d'informatique qui veulent simplement une solution qui fonctionne.

En revanche, des plateformes comme eesel AI sont conçues pour que tout le monde puisse les utiliser. Vous pouvez connecter votre service d'assistance, comme Zendesk, en quelques clics et commencer en quelques minutes, pas en mois, le tout sans écrire une seule ligne de code.

Personnalisation : Fine-tuning vs. moteur de workflow

Parce que Llama 3 est open-source, vous pouvez le personnaliser en profondeur grâce à un processus appelé "fine-tuning". Cependant, c'est un projet très complexe et coûteux qui nécessite des experts en IA spécialisés et d'énormes quantités de données. Pour 99% des entreprises, ce n'est tout simplement pas une option réaliste.

Une voie beaucoup plus pratique consiste à utiliser une plateforme dotée d'un moteur de workflow simple et sans code. eesel AI vous donne un contrôle total depuis un tableau de bord facile à utiliser. Vous pouvez définir la personnalité et le ton de votre IA, lui dire quelles sources de connaissances utiliser, et même créer des actions personnalisées, comme lui faire rechercher une commande dans Shopify ou faire remonter un ticket, le tout sans avoir besoin d'un développeur.

Le moteur contre la voiture

Alors, quelle est la conclusion ici ? La façon la plus simple de penser au choix entre GPT-4 Turbo et Llama 3 est de les comparer à des moteurs de voiture.

-

GPT-4 Turbo est le moteur premium et haute performance d'une marque de luxe. Il est incroyablement puissant et fiable, mais il a un prix plus élevé et nécessite des mécaniciens experts (vos développeurs) pour l'installer et l'entretenir.

-

Llama 3 est comme un moteur polyvalent et très efficace d'un fournisseur de premier plan. Il est beaucoup plus abordable et offre une flexibilité incroyable, mais vous devez toujours construire le reste de la voiture autour vous-même.

Pour la plupart des entreprises, débattre de quel moteur est légèrement meilleur passe à côté de l'essentiel. La vraie valeur réside dans le véhicule complet : une plateforme facile à prendre en main, qui se connecte à tous vos outils, qui est sûre à tester et qui donne des résultats dès le premier jour.

Mettez la meilleure IA du monde au travail en quelques minutes

Au lieu de vous embourber dans un projet complexe et coûteux à faire vous-même, vous pouvez lancer un agent IA puissant, sécurisé et entièrement personnalisé avec eesel AI.

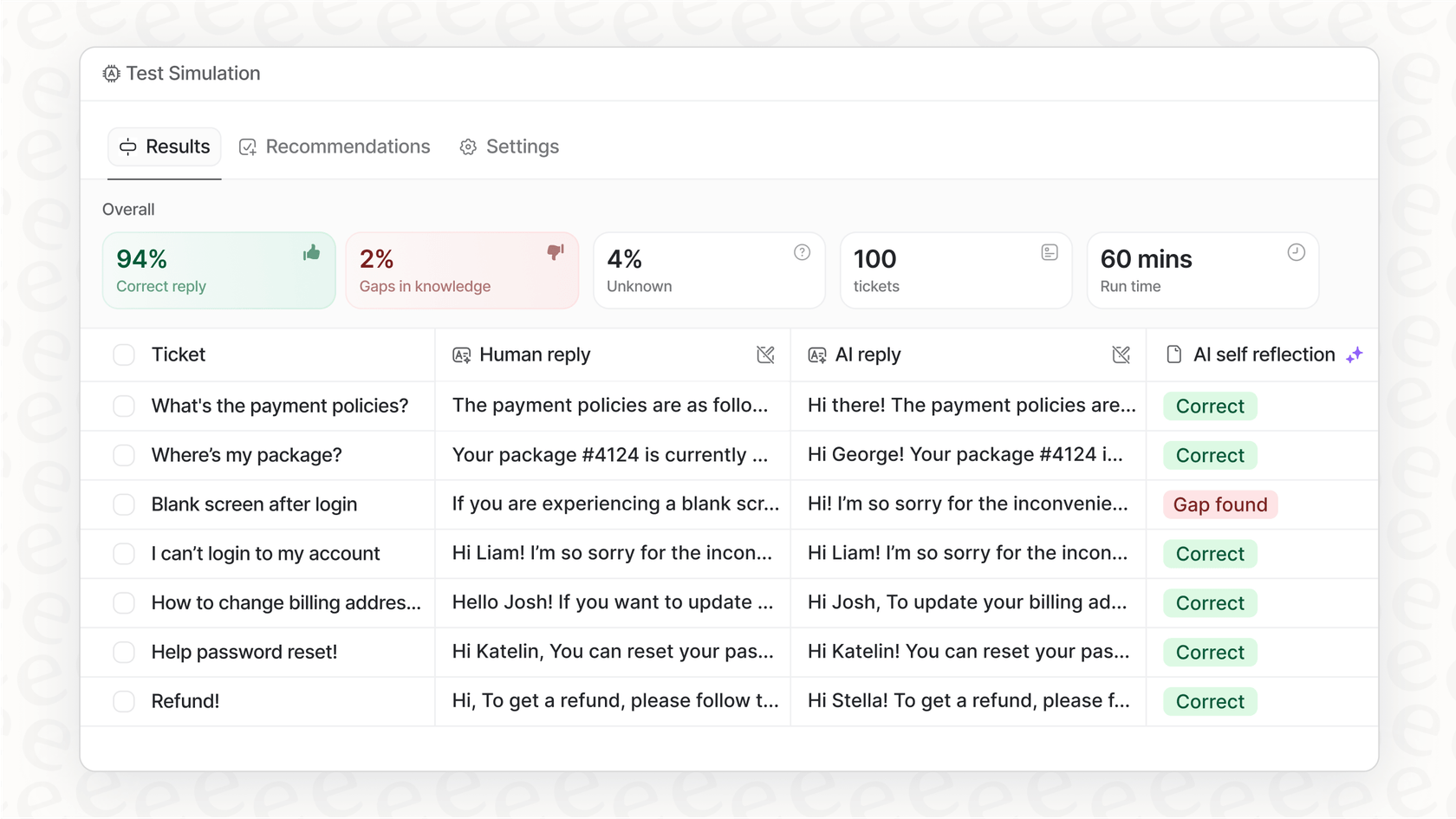

eesel AI est conçu pour utiliser les meilleurs modèles comme GPT-4, mais il gère toutes les parties compliquées pour vous. Il se connecte à vos outils, apprend de vos conversations de support passées pour correspondre à la voix de votre marque, et vous donne même un mode de simulation pour que vous puissiez tout tester en toute confiance avant que vos clients ne le voient.

Prêt à voir à quel point une IA puissante peut être simple ? Commencez votre essai gratuit d'eesel AI dès aujourd'hui.

Foire aux questions

GPT-4 Turbo est un modèle premium facturé par token d'OpenAI, ce qui peut entraîner des coûts plus élevés et moins prévisibles. Llama 3 est généralement plus abordable par token, mais le coût global doit tenir compte des efforts d'ingénierie pour l'intégration et la maintenance. Des plateformes comme eesel AI peuvent offrir une tarification mensuelle prévisible, éliminant les frais par token et les coûts d'ingénierie cachés.

GPT-4 Turbo a généralement une légère avance dans les benchmarks académiques généraux comme MMLU en raison de sa formation approfondie. Cependant, Llama 3 70B est très compétitif et il est souvent impossible de le distinguer de GPT-4 Turbo pour les tâches de connaissances générales que la plupart des entreprises rencontrent. Les deux modèles sont très performants pour le raisonnement quotidien.

GPT-4 Turbo excelle généralement dans le raisonnement mathématique complexe et les défis de codage en plusieurs étapes, ce qui en fait un choix fiable pour les cas d'utilisation riches en chiffres. Llama 3 est également performant en codage et est particulièrement apprécié par certains développeurs pour sa capacité à suivre des instructions de formatage précises pour une sortie de code prévisible.

La nature open-source de Llama 3 offre aux entreprises une plus grande flexibilité, y compris la possibilité de l'exécuter sur leurs propres serveurs pour une confidentialité et un contrôle accrus. GPT-4 Turbo, étant propriétaire, offre des performances de premier ordre via une API mais limite la visibilité directe ou la modification de son fonctionnement interne.

L'utilisation de GPT-4 Turbo via son API ou le déploiement direct de Llama 3 nécessite une expertise technique et des ressources de développement importantes pour la configuration, l'intégration et la maintenance continue. En revanche, des plateformes comme eesel AI simplifient considérablement ce processus, permettant aux entreprises d'intégrer des solutions d'IA en quelques minutes sans écrire de code.

Bien que Llama 3 offre une personnalisation approfondie grâce au fine-tuning en raison de sa nature open-source, il s'agit d'un projet très complexe et gourmand en ressources pour la plupart des entreprises. Une approche beaucoup plus pratique consiste à utiliser une plateforme dotée d'un moteur de workflow sans code, comme eesel AI, qui vous permet de définir facilement la personnalité, le ton et les actions spécifiques de l'IA à partir d'un tableau de bord convivial.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.