Der Versuch, das richtige KI-Modell für Ihr Unternehmen auszuwählen, kann sich wie ein Vollzeitjob anfühlen. Auf der einen Seite haben Sie GPT-4 Turbo von OpenAI und auf der anderen Seite Llama 3 von Meta, und die technischen Spezifikationen können einem den Kopf verdrehen.

Für die meisten von uns, insbesondere im Kundensupport, lautet die eigentliche Frage nicht, wie abstrakte Benchmarks aussehen. Es geht darum, was tatsächlich funktioniert, was das Budget nicht sprengt und was man einrichten kann, ohne ein Team von Entwicklern einstellen zu müssen. Dieser Leitfaden ist ein direkter Vergleich von GPT-4 Turbo vs. Llama 3 und konzentriert sich auf das, was für Ihr Unternehmen wirklich zählt: wie sie sich in der Praxis bewähren, wie viel sie tatsächlich kosten und wo sie einen echten Unterschied machen können.

Was ist GPT-4 Turbo?

Beginnen wir mit dem Modell, von dem Sie wahrscheinlich am meisten gehört haben: GPT-4 Turbo. Dies ist das große Modell von OpenAI, dem Unternehmen, das uns ChatGPT gebracht hat. Sie können es sich als den hochwertigen Premium-Motor im KI-Bereich vorstellen. Es ist ein „proprietäres“ oder „Closed-Source“-Modell, was einfach bedeutet, dass Sie nicht unter die Haube schauen können, um zu sehen, wie es funktioniert. Aber was Sie sehen, ist seine wirklich beeindruckende Leistung.

Das müssen Sie darüber wissen:

-

Spitzenleistung: Wenn es um komplexes logisches Denken, mathematische Probleme und das Verständnis verschiedener Sprachen geht, ist GPT-4 Turbo oft das Maß aller Dinge. Es ist besonders gut darin, knifflige, nuancierte Probleme zu entwirren.

-

Ein riesiges Gedächtnis: Es hat ein massives Kontextfenster (bis zu 128.000 Token). Im Klartext bedeutet das, dass es ein 300-seitiges Buch auf einmal lesen und sich daran erinnern kann. Dadurch kann es den gesamten Kontext langer Dokumente oder komplizierter Support-Threads verstehen, ohne den Faden zu verlieren.

-

Zugriff über API: Unternehmen interagieren normalerweise über die OpenAI-API mit GPT-4 Turbo. Das bedeutet, dass Sie Entwickler benötigen, um es in Ihre bestehenden Tools zu integrieren. Es ist der Motor, der hinter unzähligen KI-Anwendungen läuft, aber es funktioniert nicht von allein.

Was ist Llama 3?

Auf der anderen Seite des Rings steht Llama 3 von Meta AI. Diese Modellfamilie schlägt Wellen, weil sie Open-Source ist, und das ist eine große Sache. Es gibt Unternehmen viel mehr Flexibilität bei der Nutzung des Modells, einschließlich der Möglichkeit, es auf eigenen Servern zu betreiben, um mehr Datenschutz und Kontrolle zu haben.

Das zeichnet es aus:

-

Verschiedene Größen für verschiedene Aufgaben: Llama 3 ist in verschiedenen Größen erhältlich, wobei die 8B- und 70B-Parametermodelle am gebräuchlichsten sind. Das ist eine großartige Funktion, denn Sie können ein Modell wählen, das Ihnen die benötigte Leistung bietet, ohne für Leistung zu bezahlen, die Sie nicht nutzen werden. Man braucht nicht immer das teuerste Werkzeug für die Arbeit.

-

Sehr wettbewerbsfähige Leistung: Lassen Sie sich nicht vom „Open-Source“-Label täuschen. Das Llama 3 70B-Modell ist ein Kraftpaket. In vielen Tests leistet es gleichwertig und manchmal sogar besser als frühere Versionen von GPT-4. Es ist ein solider Beweis dafür, dass Open-Source-Modelle mit proprietären Modellen mithalten können.

-

Auf Effizienz ausgelegt: Llama 3 wurde entwickelt, um leistungsstark zu sein, ohne aufgebläht zu wirken. Dies macht es zu einer beliebten Wahl für Unternehmen und Entwickler, die erstklassige KI suchen, die pro Token erschwinglicher ist. Man greift im Allgemeinen über Cloud-Anbieter darauf zu oder hostet es selbst.

Leistung und Benchmarks: Ein direkter Vergleich

Okay, schauen wir uns die Zahlen an. Obwohl diese Tests nicht die ganze Geschichte erzählen, geben sie uns eine gute Grundlage dafür, wie diese beiden Modelle „denken“ und wo jedes einzelne einen natürlichen Vorteil hat.

Allgemeinwissen und logisches Denken

Wenn es um breite, akademische Fragen geht, hat GPT-4 Turbo normalerweise einen kleinen Vorsprung. Bei Tests wie MMLU (der voller Fragen auf Graduiertenniveau zu verschiedenen Themen ist), verschafft ihm sein umfangreiches Training einen leichten Vorteil.

Allerdings ist Llama 3 70B ihm dicht auf den Fersen. Es schlägt oft ältere GPT-4-Modelle und holt schnell auf. Bei der Art von Allgemeinwissensfragen, die Ihr Unternehmen wahrscheinlich antreffen wird, könnten Sie wahrscheinlich keinen Unterschied zwischen ihnen feststellen. Beide sind mehr als klug genug.

Programmier- und mathematische Fähigkeiten

Hier werden die Unterschiede etwas deutlicher.

-

Programmierung: Bei Tests wie HumanEval, der die Fähigkeit eines Modells misst, Code zu schreiben, sind beide sehr stark. GPT-4 Turbo neigt dazu, bei der Lösung komplexer, mehrstufiger Programmierherausforderungen etwas besser zu sein. Andererseits haben einige Entwickler festgestellt, dass Llama 3 fantastisch darin ist, sehr präzise Formatierungsanweisungen zu befolgen, was ein großer Vorteil ist, wenn Sie eine vorhersagbare Codeausgabe benötigen.

-

Mathematik: GPT-4 Turbo ist der klare Gewinner bei Tests zum mathematischen Denken. Seine Architektur macht es zuverlässiger für Aufgaben, die exakte Berechnungen und schrittweise Logik erfordern. Wenn Zahlen ein großer Teil Ihres Anwendungsfalls sind, ist GPT-4 Turbo wahrscheinlich die zuverlässigere Wahl.

Ein schneller Vergleich der Benchmarks

| Benchmark | Aufgabe | GPT-4 Turbo (ca. Punktzahl) | Llama 3 70B (ca. Punktzahl) | Wichtigste Erkenntnis |

|---|---|---|---|---|

| MMLU | Allgemeinwissen | ~86 % | ~82 % | GPT-4 hat einen leichten Vorteil bei breitem, akademischem Wissen. |

| HumanEval | Code-Generierung | ~87 % | ~82 % | Beide sind sehr fähig, aber GPT-4 ist oft besser für komplexe Logik. |

| MATH | Lösung mathematischer Probleme | ~73 % | ~50-60 % | GPT-4 ist der klare Gewinner beim mathematischen Denken. |

Praktische Geschäftsanwendungen und Anwendungsfälle

Okay, genug der Theorie. Wie hilft Ihnen dieses Zeug tatsächlich bei der Arbeit? Ein KI-Modell allein ist nur ein Gehirn im Glas; es ist nur nützlich, wenn Sie es mit Ihren spezifischen Geschäftsproblemen verbinden und ihm die richtigen Informationen zur Verfügung stellen.

Automatisierung des Kundensupports

Beide Modelle eignen sich hervorragend für die Bearbeitung von Support-Aufgaben. Sie können lange Ticket-Historien zusammenfassen, Agenten beim Verfassen durchdachter Antworten helfen und häufig gestellte Fragen beantworten. Ihre großen Kontextfenster ermöglichen es ihnen, komplizierte Gespräche zu verarbeiten, um zum Kern des Problems vorzudringen.

Aber hier ist die Sache, die man Ihnen nicht immer sagt: Diese Modelle wissen nichts über Ihr Unternehmen. Eine KI kann keine Frage zu Ihrer Rückgaberichtlinie beantworten, wenn sie sie nie gesehen hat. Sie muss mit dem Wissen Ihres Unternehmens verbunden sein, um effektiv zu sein.

Inhaltserstellung und Zusammenfassung

In diesem Bereich haben die beiden Modelle unterschiedliche Stärken. Benutzerfeedback und verschiedene Tests haben gezeigt, dass Llama 3 besonders gut im Zusammenfassen ist. Es kann ein langes Dokument nehmen und es auf eine klare und genaue Zusammenfassung reduzieren, was sich hervorragend für Dinge wie interne Berichte oder die Weitergabe eines Tickets an einen anderen Agenten eignet.

GPT-4 Turbo neigt jedoch dazu, bei der Erstellung von längerem, kreativem Inhalt besser zu sein. Wenn Sie Hilfe beim Entwerfen eines Blog-Beitrags, bei der Entwicklung von Marketingideen oder beim Schreiben detaillierter Produktbeschreibungen aus wenigen Notizen benötigen, ist es wahrscheinlich die bessere Option.

Internes Wissensmanagement

Beide Modelle können verwendet werden, um einen internen Q&A-Bot für Ihre Mitarbeiter zu erstellen. Stellen Sie sich einfach vor, Ihr Team fragt nach Unternehmensrichtlinien, IT-Fehlerbehebung oder Projekt-Updates und erhält eine sofortige, korrekte Antwort.

Die Haupthürde ist nicht die Wahl des Modells, sondern Ihr Team dazu zu bringen, es zu benutzen. Ein neuer Bot ist nutzlos, wenn die Leute noch eine weitere App öffnen müssen. Das Tool muss dort leben, wo Ihr Team bereits ist. Eine Plattform wie der AI Internal Chat von eesel AI integriert sich direkt in Slack oder Microsoft Teams. Er lernt aus Ihren internen Dokumenten und gibt Ihrem Team sofortige Antworten in den Chat-Tools, die sie den ganzen Tag nutzen.

Kosten, Zugänglichkeit und Anpassung

Für die meisten Unternehmen wird hier die Entscheidung wirklich getroffen. Das „beste“ Modell spielt keine Rolle, wenn es zu teuer, zu schwierig einzurichten oder zu starr ist, um Ihre Anforderungen zu erfüllen.

Die wahren Kosten jedes Modells

-

GPT-4 Turbo: Sie bezahlen OpenAI für jede Information, die Sie senden und empfangen, basierend auf „Tokens“. Es ist die Premium-Wahl, und die Kosten können sich schnell summieren und schwer vorhersagbar sein, besonders wenn Sie einen plötzlichen Anstieg an Kundenanfragen haben.

-

Llama 3: Da es Open-Source ist, ist Llama 3 pro Token viel billiger, wenn Sie es über einen Hosting-Dienst nutzen.

Aber der Preis pro Token ist nur ein Teil der Geschichte. Die Gesamtkosten umfassen auch die Zeit, die Ihre Ingenieure für die Einrichtung, Integration, Fehlerbehebung und laufende Wartung aufwenden. Deshalb entscheiden sich viele Unternehmen für eine Plattform mit einfachen, vorhersagbaren Preisen. Zum Beispiel bietet eesel AI unkomplizierte Monatspläne, bei denen Ihnen keine Gebühren pro gelöstem Ticket berechnet werden. Ihre Rechnung bleibt auch in den geschäftigsten Monaten gleich, was Ihnen vorhersagbare Kosten ohne versteckte technische Kopfschmerzen bietet.

Zugänglichkeit und einfache Einrichtung

Die direkte Nutzung eines dieser Modelle erfordert viel technisches Geschick. Sie benötigen Entwickler, die mit der OpenAI-API arbeiten können oder die das komplexe Hosting und die Bereitstellung von Llama 3 verwalten können. Das ist eine riesige Hürde für die meisten Support- und IT-Teams, die einfach nur eine Lösung wollen, die funktioniert.

Im Gegensatz dazu sind Plattformen wie eesel AI so konzipiert, dass jeder sie nutzen kann. Sie können Ihren Helpdesk, wie Zendesk, mit nur wenigen Klicks verbinden und in Minuten statt Monaten loslegen, ganz ohne eine einzige Zeile Code zu schreiben.

Anpassung: Feinabstimmung vs. Workflow-Engine

Da Llama 3 Open-Source ist, können Sie es durch einen Prozess namens „Feinabstimmung“ tiefgreifend anpassen. Dies ist jedoch ein sehr komplexes und teures Projekt, das spezialisierte KI-Experten und riesige Datenmengen erfordert. Für 99 % der Unternehmen ist es einfach keine realistische Option.

Ein viel praktischerer Weg ist die Nutzung einer Plattform mit einer einfachen, codefreien Workflow-Engine. eesel AI gibt Ihnen die volle Kontrolle über ein einfach zu bedienendes Dashboard. Sie können die Persönlichkeit und den Tonfall Ihrer KI festlegen, ihr sagen, welche Wissensquellen sie verwenden soll, und sogar benutzerdefinierte Aktionen erstellen, wie z. B. das Nachschlagen einer Bestellung in Shopify oder das Eskalieren eines Tickets, alles ohne einen Entwickler zu benötigen.

Der Motor vs. das Auto

Also, was ist das Fazit hier? Der einfachste Weg, über die Wahl zwischen GPT-4 Turbo und Llama 3 nachzudenken, ist, sie mit Automotoren zu vergleichen.

-

GPT-4 Turbo ist der Premium-Hochleistungsmotor einer Luxusmarke. Er ist unglaublich leistungsstark und zuverlässig, hat aber einen höheren Preis und erfordert erfahrene Mechaniker (Ihre Entwickler) für die Installation und Wartung.

-

Llama 3 ist wie ein vielseitiger, hocheffizienter Motor von einem erstklassigen Zulieferer. Er ist viel erschwinglicher und bietet erstaunliche Flexibilität, aber Sie müssen den Rest des Autos immer noch selbst darum herum bauen.

Für die meisten Unternehmen verfehlt die Debatte, welcher Motor etwas besser ist, den eigentlichen Punkt. Der wahre Wert liegt im kompletten Fahrzeug: einer Plattform, die einfach zu starten ist, sich mit all Ihren Tools verbindet, sicher zu testen ist und vom ersten Tag an Ergebnisse liefert.

Setzen Sie die weltbeste KI in Minuten ein

Anstatt sich in einem komplexen und teuren Selbstbauprojekt zu verzetteln, können Sie mit eesel AI einen leistungsstarken, sicheren und vollständig angepassten KI-Agenten starten.

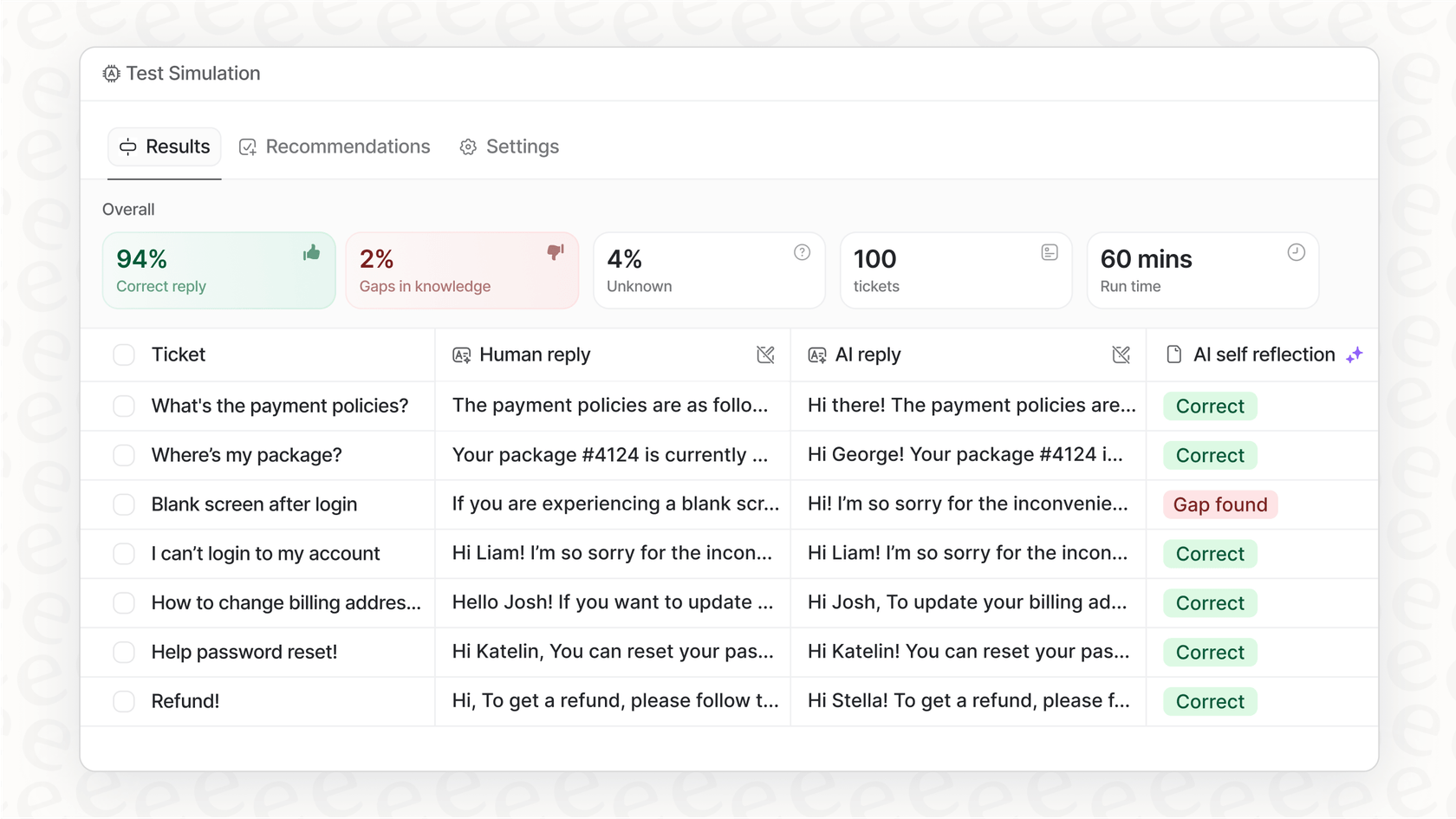

eesel AI ist darauf ausgelegt, die besten Modelle wie GPT-4 zu verwenden, aber es erledigt alle komplizierten Teile für Sie. Es verbindet sich mit Ihren Tools, lernt aus Ihren vergangenen Support-Gesprächen, um der Stimme Ihrer Marke zu entsprechen, und bietet Ihnen sogar einen Simulationsmodus, damit Sie alles mit Zuversicht testen können, bevor Ihre Kunden es sehen.

Bereit zu sehen, wie einfach leistungsstarke KI sein kann? Starten Sie noch heute Ihre kostenlose Testversion von eesel AI.

Häufig gestellte Fragen

GPT-4 Turbo ist ein Premium-Modell von OpenAI mit Abrechnung pro Token, was zu potenziell höheren und weniger vorhersagbaren Kosten führen kann. Llama 3 ist im Allgemeinen pro Token erschwinglicher, aber die Gesamtkosten müssen den Entwicklungsaufwand für Integration und Wartung berücksichtigen. Plattformen wie eesel AI können vorhersagbare monatliche Preise bieten, wodurch Gebühren pro Token und versteckte Entwicklungskosten entfallen.

GPT-4 Turbo hat in breiten, akademischen Benchmarks wie MMLU aufgrund seines umfangreichen Trainings typischerweise einen leichten Vorsprung. Llama 3 70B ist jedoch sehr wettbewerbsfähig und oft nicht von GPT-4 Turbo zu unterscheiden, wenn es um die allgemeinen Wissensaufgaben geht, mit denen die meisten Unternehmen konfrontiert sind. Beide Modelle sind für alltägliche logische Aufgaben sehr leistungsfähig.

GPT-4 Turbo zeichnet sich im Allgemeinen durch komplexes mathematisches Denken und mehrstufige Programmierherausforderungen aus, was es zu einer zuverlässigen Wahl für zahlenintensive Anwendungsfälle macht. Llama 3 ist ebenfalls stark im Programmieren und wird von einigen Entwicklern besonders für seine Fähigkeit gelobt, präzise Formatierungsanweisungen für eine vorhersagbare Code-Ausgabe zu befolgen.

Die Open-Source-Natur von Llama 3 bietet Unternehmen größere Flexibilität, einschließlich der Möglichkeit, es auf eigenen Servern zu betreiben, um den Datenschutz und die Kontrolle zu verbessern. GPT-4 Turbo, als proprietäres Modell, bietet Spitzenleistung über eine API, schränkt jedoch den direkten Einblick oder die Änderung seiner internen Funktionsweise ein.

Die Nutzung von GPT-4 Turbo über seine API oder die direkte Bereitstellung von Llama 3 erfordert erhebliches technisches Fachwissen und Entwicklerressourcen für Einrichtung, Integration und laufende Wartung. Im Gegensatz dazu vereinfachen Plattformen wie eesel AI diesen Prozess dramatisch und ermöglichen es Unternehmen, KI-Lösungen in wenigen Minuten zu integrieren, ohne Code schreiben zu müssen.

Während Llama 3 aufgrund seiner Open-Source-Natur eine tiefgreifende Anpassung durch Feinabstimmung ermöglicht, ist dies für die meisten Unternehmen ein sehr komplexes und ressourcenintensives Unterfangen. Ein praktischerer Ansatz ist die Verwendung einer Plattform mit einer No-Code-Workflow-Engine wie eesel AI, mit der Sie die Persönlichkeit, den Ton und spezifische Aktionen der KI einfach über ein benutzerfreundliches Dashboard einstellen können.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.