Intentar elegir el modelo de IA adecuado para tu negocio puede parecer un trabajo a tiempo completo. Por un lado, tienes el GPT-4 Turbo de OpenAI y, por otro, el Llama 3 de Meta, y las especificaciones técnicas pueden hacerte dar vueltas la cabeza.

Para la mayoría de nosotros, especialmente en el ámbito del soporte al cliente, la verdadera pregunta no se trata de métricas abstractas. Se trata de lo que realmente funcionará, lo que no te dejará en la ruina y lo que puedes configurar sin contratar a un equipo de desarrolladores. Esta guía es una comparación directa entre GPT-4 Turbo y Llama 3, centrándose en lo que realmente importa para tu negocio: cómo se desempeñan en el mundo real, cuánto cuestan realmente y dónde pueden marcar una diferencia real.

¿Qué es GPT-4 Turbo?

Empecemos con el que probablemente más has oído hablar: GPT-4 Turbo. Este es el grande de OpenAI, la empresa que nos dio ChatGPT. Puedes pensar en él como el motor premium de gama alta en el espacio de la IA. Es un modelo "propietario" o de "código cerrado", lo que simplemente significa que no puedes mirar bajo el capó para ver cómo funciona. Pero lo que sí ves es su rendimiento realmente impresionante.

A continuación, lo que necesitas saber sobre él:

-

Rendimiento de primer nivel: Cuando se trata de razonamiento complejo, problemas matemáticos y comprensión de diferentes idiomas, GPT-4 Turbo suele ser el modelo a batir. Es particularmente bueno para desenredar problemas complicados y con matices.

-

Una memoria enorme: Tiene una ventana de contexto masiva (hasta 128,000 tokens). En lenguaje sencillo, es como si pudiera leer y recordar un libro de 300 páginas de una sola vez. Esto le permite comprender el panorama completo de documentos largos o hilos de soporte complicados sin perderse.

-

Acceso a través de API: Las empresas suelen interactuar con GPT-4 Turbo a través de la API de OpenAI. Esto significa que necesitas desarrolladores para integrarlo en tus herramientas existentes. Es el motor que funciona detrás de escena en innumerables aplicaciones de IA, pero no funciona por sí solo.

¿Qué es Llama 3?

Al otro lado del ring está Llama 3 de Meta AI. Esta familia de modelos está causando sensación porque es de código abierto, y eso es un gran avance. Ofrece a las empresas mucha más flexibilidad en cómo usan el modelo, incluida la opción de ejecutarlo en sus propios servidores para una mayor privacidad y control.

Esto es lo que lo hace destacar:

-

Diferentes tamaños para diferentes trabajos: Llama 3 está disponible en varios tamaños, siendo los modelos de 8B y 70B parámetros los más comunes. Esta es una gran característica porque puedes elegir un modelo que te dé el rendimiento que necesitas sin pagar por potencia que no usarás. No siempre necesitas la herramienta más cara para el trabajo.

-

Rendimiento muy competitivo: No dejes que la etiqueta de "código abierto" te engañe. El modelo Llama 3 70B es una potencia. En muchas pruebas, se desempeña a la par, y a veces incluso mejor, que las versiones anteriores de GPT-4. Es una prueba sólida de que los modelos de código abierto pueden competir de igual a igual con los propietarios.

-

Diseñado para la eficiencia: Llama 3 fue creado para ser potente sin ser excesivo. Esto lo convierte en una opción popular para empresas y desarrolladores que desean una IA de primer nivel que sea más asequible por token. Generalmente, se accede a él a través de proveedores en la nube o alojándolo tú mismo.

Rendimiento y benchmarks: una comparación cara a cara

Bien, veamos los números. Si bien estas pruebas no cuentan toda la historia, nos dan una buena base de cómo estos dos modelos "piensan" y dónde cada uno tiene una ventaja natural.

Conocimiento general y razonamiento

Cuando se trata de preguntas amplias de tipo académico, GPT-4 Turbo generalmente tiene una pequeña ventaja. En pruebas como MMLU (que está llena de preguntas de nivel de posgrado sobre diversas materias), su extenso entrenamiento le da una ligera ventaja.

Dicho esto, Llama 3 70B está justo detrás. A menudo supera a los modelos GPT-4 más antiguos y está cerrando la brecha rápidamente. Para el tipo de preguntas de conocimiento general que probablemente encontrará tu empresa, probablemente no podrías notar la diferencia entre ellos. Ambos son más que suficientemente inteligentes.

Habilidades de codificación y matemáticas

Aquí es donde las diferencias comienzan a ser un poco más obvias.

-

Codificación: En pruebas como HumanEval, que mide la capacidad de un modelo para escribir código, ambos son muy fuertes. GPT-4 Turbo tiende a ser un poco mejor para resolver desafíos de programación complejos y de varios pasos. Por otro lado, algunos desarrolladores han descubierto que Llama 3 es fantástico para seguir instrucciones de formato muy precisas, lo cual es un gran beneficio cuando necesitas una salida de código predecible.

-

Matemáticas: GPT-4 Turbo es el claro ganador cuando se trata de pruebas de razonamiento matemático. Su arquitectura lo hace más fiable para tareas que requieren cálculos exactos y lógica paso a paso. Si los números son una parte importante de tu caso de uso, GPT-4 Turbo es probablemente la opción más fiable.

Una rápida comparación de benchmarks

| Benchmark | Tarea | GPT-4 Turbo (Puntuación Aprox.) | Llama 3 70B (Puntuación Aprox.) | Conclusión Clave |

|---|---|---|---|---|

| MMLU | Conocimiento General | ~86% | ~82% | GPT-4 tiene una ligera ventaja en conocimientos amplios y académicos. |

| HumanEval | Generación de Código | ~87% | ~82% | Ambos son muy capaces, pero GPT-4 suele ser mejor para la lógica compleja. |

| MATH | Resolución de Problemas Matemáticos | ~73% | ~50-60% | GPT-4 es el claro ganador en razonamiento matemático. |

Aplicaciones prácticas de negocio y casos de uso

Vale, basta de teoría. ¿Cómo te ayuda esto realmente a hacer el trabajo? Un modelo de IA por sí solo es solo un cerebro en un frasco; solo es útil cuando lo conectas a los problemas específicos de tu negocio y le das la información correcta para trabajar.

Automatización del soporte al cliente

Ambos modelos son excelentes para gestionar tareas de soporte. Pueden resumir largos historiales de tickets, ayudar a los agentes a redactar respuestas bien pensadas y responder a preguntas frecuentes. Sus grandes ventanas de contexto les permiten procesar conversaciones complicadas para llegar al meollo del asunto.

Pero aquí está lo que no siempre te dicen: estos modelos no saben nada sobre tu negocio. Una IA no puede responder a una pregunta sobre tu política de devoluciones si nunca la ha visto. Tiene que estar conectada al conocimiento de tu empresa para ser efectiva.

Creación y resumen de contenido

En esta área, los dos modelos tienen diferentes puntos fuertes. Los comentarios de los usuarios y diversas pruebas han demostrado que Llama 3 es particularmente bueno para resumir. Puede tomar un documento largo y reducirlo a un resumen claro y preciso, lo cual es genial para cosas como informes internos o para pasar un ticket a otro agente.

GPT-4 Turbo, sin embargo, tiende a ser mejor para generar contenido creativo de formato más largo. Si necesitas ayuda para redactar una entrada de blog, proponer ideas de marketing o escribir descripciones de productos detalladas a partir de unas pocas notas, probablemente sea la mejor opción.

Gestión del conocimiento interno

Cualquiera de los dos modelos puede usarse para construir un bot interno de preguntas y respuestas para tus empleados. Imagina a tu equipo preguntando sobre políticas de la empresa, solución de problemas de TI o actualizaciones de proyectos y obteniendo una respuesta inmediata y correcta.

El principal obstáculo no es elegir el modelo; es lograr que tu equipo lo use. Un nuevo bot es inútil si la gente tiene que abrir otra aplicación más. La herramienta necesita vivir donde tu equipo ya está. Una plataforma como el Chat Interno con IA de eesel AI se integra directamente en Slack o Microsoft Teams. Aprende de tus documentos internos y le da a tu equipo respuestas instantáneas dentro de las herramientas de chat que usan todo el día.

Costo, accesibilidad y personalización

Para la mayoría de las empresas, aquí es donde realmente se toma la decisión. El "mejor" modelo no importa si es demasiado caro, demasiado difícil de configurar o demasiado rígido para satisfacer tus necesidades.

El verdadero costo de cada modelo

-

GPT-4 Turbo: Le pagas a OpenAI por cada fragmento de información que envías y recibes, basado en "tokens". Es la opción premium, y los costos pueden acumularse rápidamente y ser difíciles de predecir, especialmente si tienes un aumento repentino en las preguntas de los clientes.

-

Llama 3: Al ser de código abierto, Llama 3 es mucho más barato por token cuando lo usas a través de un servicio de alojamiento.

Pero el precio por token es solo una parte de la historia. El costo total también incluye el tiempo que tus ingenieros dedican a la configuración, integración, corrección de errores y mantenimiento continuo. Es por eso que muchas empresas optan por una plataforma con precios simples y predecibles. Por ejemplo, eesel AI ofrece planes mensuales sencillos que no te cobran por ticket resuelto. Tu factura se mantiene igual incluso durante tus meses más ocupados, lo que te da costos predecibles sin los dolores de cabeza de ingeniería ocultos.

Accesibilidad y facilidad de configuración

Usar cualquiera de estos modelos directamente requiere mucha habilidad técnica. Necesitas desarrolladores que puedan trabajar con la API de OpenAI o que puedan gestionar el complejo alojamiento y despliegue de Llama 3. Esa es una barrera enorme para la mayoría de los equipos de soporte y TI que solo quieren una solución que funcione.

En contraste, plataformas como eesel AI están diseñadas para que cualquiera pueda usarlas. Puedes conectar tu centro de ayuda, como Zendesk, con solo unos pocos clics y empezar en minutos, no en meses, todo sin escribir una sola línea de código.

Personalización: ajuste fino vs. un motor de flujos de trabajo

Debido a que Llama 3 es de código abierto, puedes personalizarlo profundamente a través de un proceso llamado "ajuste fino" (fine-tuning). Sin embargo, este es un proyecto muy complejo y costoso que requiere expertos en IA especializados y enormes cantidades de datos. Para el 99% de las empresas, simplemente no es una opción realista.

Una ruta mucho más práctica es usar una plataforma que tenga un motor de flujos de trabajo simple y sin código. eesel AI te da control total desde un panel de control fácil de usar. Puedes establecer la personalidad y el tono de voz de tu IA, decirle qué fuentes de conocimiento usar e incluso crear acciones personalizadas, como hacer que busque un pedido en Shopify o escale un ticket, todo sin necesidad de un desarrollador.

El motor vs. el coche

Entonces, ¿cuál es la conclusión aquí? La forma más fácil de pensar en la elección entre GPT-4 Turbo y Llama 3 es compararlos con motores de coche.

-

GPT-4 Turbo es el motor premium de alto rendimiento de una marca de lujo. Es increíblemente potente y fiable, pero tiene un precio más alto y requiere mecánicos expertos (tus desarrolladores) para instalarlo y mantenerlo.

-

Llama 3 es como un motor versátil y altamente eficiente de un proveedor de primer nivel. Es mucho más asequible y ofrece una flexibilidad asombrosa, pero aún tienes que construir el resto del coche a su alrededor tú mismo.

Para la mayoría de las empresas, debatir qué motor es ligeramente mejor es perder el punto. El verdadero valor está en el vehículo completo: una plataforma que es fácil de empezar a usar, se conecta a todas tus herramientas, es segura para probar y ofrece resultados desde el primer día.

Pon a trabajar la mejor IA del mundo en minutos

En lugar de empantanarte en un proyecto complejo y costoso de "hazlo tú mismo", puedes lanzar un agente de IA potente, seguro y totalmente personalizado con eesel AI.

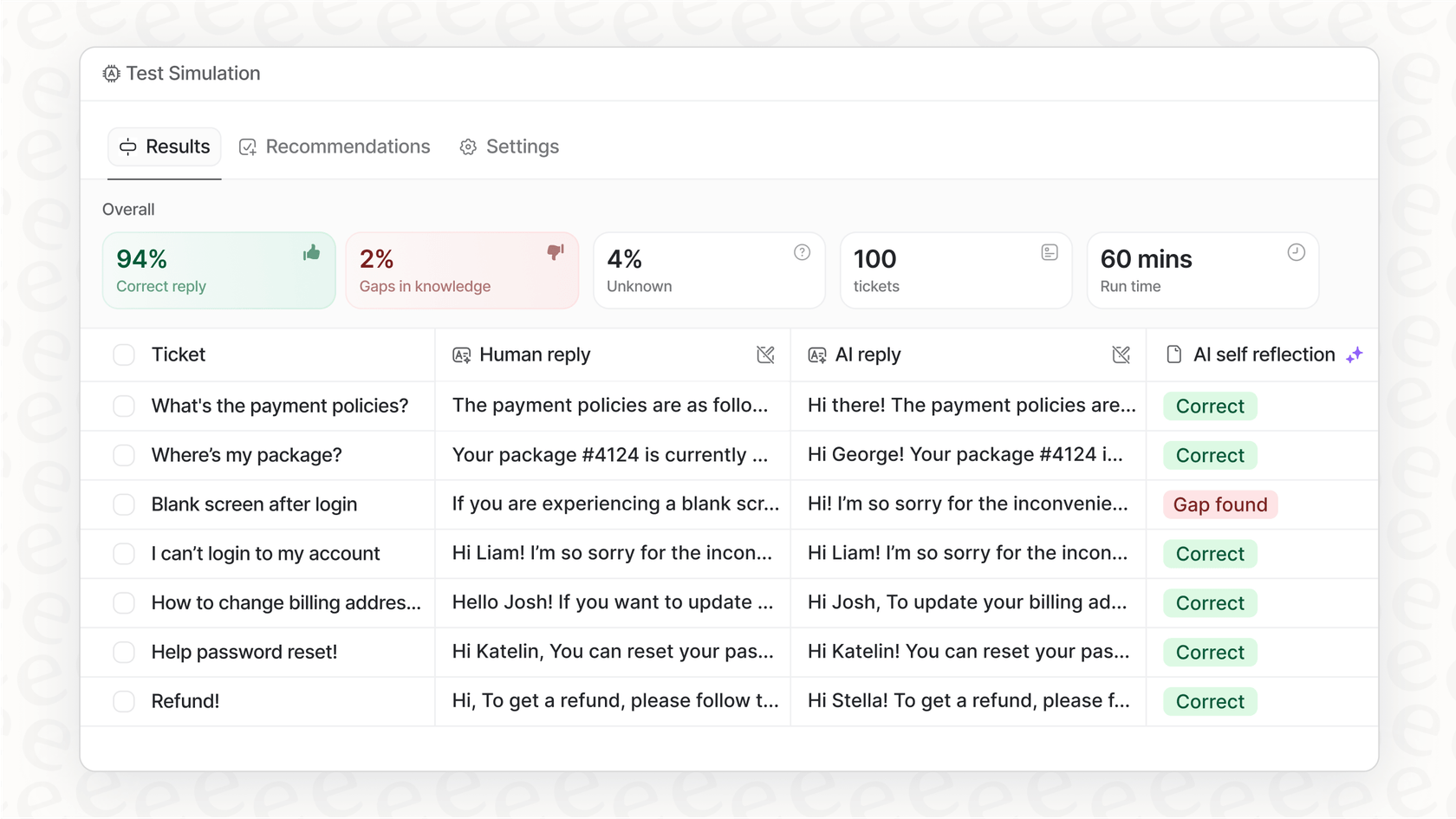

eesel AI está diseñado para usar los mejores modelos como GPT-4, pero se encarga de todas las partes complicadas por ti. Se conecta a tus herramientas, aprende de tus conversaciones de soporte pasadas para coincidir con la voz de tu marca, e incluso te da un modo de simulación para que puedas probar todo con confianza antes de que tus clientes lo vean.

¿Listo para ver lo simple que puede ser una IA potente? Comienza tu prueba gratuita de eesel AI hoy mismo.

Preguntas frecuentes

GPT-4 Turbo es un modelo premium de OpenAI que cobra por token, lo que puede llevar a costos más altos y menos predecibles. Llama 3 es generalmente más asequible por token, pero el costo total debe tener en cuenta el esfuerzo de ingeniería para la integración y el mantenimiento. Plataformas como eesel AI pueden ofrecer precios mensuales predecibles, eliminando los cargos por token y los costos de ingeniería ocultos.

GPT-4 Turbo generalmente muestra una ligera ventaja en benchmarks académicos amplios como MMLU debido a su extenso entrenamiento. Sin embargo, Llama 3 70B se desempeña de manera muy competitiva y a menudo es indistinguible de GPT-4 Turbo para las tareas de conocimiento general que la mayoría de las empresas enfrentan. Ambos modelos son altamente capaces para el razonamiento cotidiano.

GPT-4 Turbo generalmente sobresale en razonamiento matemático complejo y desafíos de codificación de varios pasos, lo que lo convierte en una opción fiable para casos de uso con muchos números. Llama 3 también es fuerte en codificación y algunos desarrolladores lo destacan por su capacidad para seguir instrucciones de formato precisas para una salida de código predecible.

La naturaleza de código abierto de Llama 3 ofrece a las empresas una mayor flexibilidad, incluida la opción de ejecutarlo en sus propios servidores para mejorar la privacidad y el control. GPT-4 Turbo, al ser propietario, proporciona un rendimiento de primer nivel a través de una API, pero limita la visión directa o la modificación de su funcionamiento interno.

Usar GPT-4 Turbo a través de su API o implementar Llama 3 directamente requiere una experiencia técnica y recursos de desarrollo significativos para la configuración, integración y mantenimiento continuo. En contraste, plataformas como eesel AI simplifican este proceso drásticamente, permitiendo a las empresas integrar soluciones de IA en minutos sin escribir código.

Si bien Llama 3 ofrece una personalización profunda a través del "ajuste fino" (fine-tuning) debido a su naturaleza de código abierto, esta es una tarea muy compleja e intensiva en recursos para la mayoría de las empresas. Un enfoque más práctico es usar una plataforma con un motor de flujos de trabajo sin código, como eesel AI, que te permite configurar fácilmente la personalidad, el tono y las acciones específicas de la IA desde un panel de control fácil de usar.

Compartir esta entrada

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.