Si estás construyendo cualquier cosa con los modelos de OpenAI, probablemente has tenido un momento en el que solo querías una cosa: que la IA te diera la misma respuesta dos veces. Obtener resultados predecibles y repetibles es fundamental para las pruebas, el control de calidad y, simplemente, para ofrecer una experiencia de usuario que no sea errática. OpenAI nos dio el parámetro "seed" (semilla) y la "system_fingerprint" (huella digital del sistema) para intentar ayudar con esto, prometiendo una forma de obtener respuestas de IA más deterministas.

El problema es que muchos desarrolladores están descubriendo que estas herramientas no siempre funcionan como se anuncian. El resultado suele ser frustración y un comportamiento de la IA realmente impredecible. Esta guía desglosará qué es la huella digital del sistema de OpenAI, por qué se supone que es tan importante y la frustrante realidad de usarla. Y lo que es más importante, te mostraremos una mejor manera de construir y desplegar agentes de IA fiables, incluso cuando las herramientas subyacentes son un poco inestables.

¿Qué es la huella digital del sistema de OpenAI?

La huella digital del sistema de OpenAI es básicamente una identificación única para la configuración específica del backend que OpenAI utilizó para generar una respuesta. Piénsalo menos como un número de versión para el modelo y más como uno para todo el sistema que lo ejecuta en ese momento exacto. Según la propia documentación de OpenAI, está destinado a ser utilizado junto con el parámetro "seed" (semilla).

Esta es la idea básica:

-

Prompt: Esta es la entrada que le das al modelo.

-

Semilla (Seed): Esto es solo un número que eliges para darle al modelo un punto de partida para su proceso semi-aleatorio. Usar la misma semilla debería, en teoría, iniciar las cosas desde el mismo punto cada vez.

-

Huella digital del sistema (System Fingerprint): Este es un código que OpenAI te envía de vuelta. Se supone que confirma que la configuración de hardware y software subyacente no ha cambiado.

Cuando haces una llamada a la API con el mismo prompt y la misma semilla, y recibes la misma huella digital del sistema, deberías obtener un resultado idéntico. Esta es toda la magia detrás de las "salidas reproducibles."

La promesa de la huella digital del sistema de OpenAI: por qué las respuestas de IA consistentes son tan importantes

Para cualquier empresa que integre la IA en sus operaciones diarias, especialmente en algo como la atención al cliente, un modelo impredecible no es solo una característica peculiar; es un riesgo genuino. La capacidad de obtener la misma respuesta para la misma pregunta es vital por algunas razones clave.

Pruebas y control de calidad fiables

Si vas a dejar que una IA hable con tus clientes, tienes que poder probarla a fondo. Los resultados reproducibles te permiten establecer una base estable. Puedes ejecutar tus pruebas una y otra vez, sabiendo que cualquier cambio que veas se debe a tus ajustes (como una nueva instrucción o una fuente de conocimiento actualizada), no porque al modelo simplemente le apeteciera decir algo diferente. Sin eso, estás intentando acertar a un blanco en movimiento, lo que hace casi imposible saber si realmente estás mejorando las cosas.

Una experiencia de cliente consistente

Imagina esto: un cliente hace una pregunta simple, obtiene una respuesta, y luego hace exactamente la misma pregunta una hora más tarde solo para obtener una respuesta completamente diferente. Ese tipo de cosas mata la confianza y simplemente crea confusión. La IA determinista se asegura de que una pregunta específica obtenga una respuesta específica, cada vez. Esto es innegociable para cosas como políticas de la empresa, información factual o guías paso a paso.

Depuración y correcciones más sencillas

Cuando una IA da una respuesta extraña o simplemente incorrecta, tu equipo tiene que intervenir y averiguar por qué. Si el resultado cambia cada vez que intentan recrear el problema, la depuración se convierte en una pesadilla total. Cuando puedes obtener la misma respuesta incorrecta cada vez, tu equipo puede identificar el problema exacto, analizar el resultado y descubrir cómo arreglar la instrucción o la base de conocimiento que está causando el problema.

La realidad: por qué la huella digital del sistema de OpenAI a menudo no da en el clavo

Aunque la lógica detrás de la "semilla" y la "huella digital del sistema" tiene sentido, su uso en la práctica ha sido una decepción para muchos. Si buscas en los foros de la comunidad de OpenAI, encontrarás a muchos desarrolladores que informan que la huella digital del sistema cambia constantemente y sin previo aviso, incluso cuando todas las demás configuraciones están bloqueadas.

Un usuario incluso realizó un experimento con 100 pruebas y descubrió que el modelo "gpt-4-turbo" devolvía cuatro huellas digitales diferentes. Ninguna de ellas apareció siquiera la mayoría de las veces.

Esta inestabilidad prácticamente anula todo el propósito de la función. Si lo único que se supone que garantiza un resultado estable es inestable en sí mismo, realmente no puedes contar con ello para obtener resultados consistentes.

¿Qué causa la inestabilidad de la huella digital del sistema de OpenAI?

OpenAI dice que la huella digital puede cambiar cuando actualizan sus sistemas de backend. Eso es comprensible, pero estos cambios parecen ocurrir con mucha más frecuencia de lo que nadie esperaba. Sugiere que las solicitudes a la API podrían estar siendo enviadas a diferentes configuraciones de servidor o que se están implementando pequeños ajustes no anunciados todo el tiempo.

El resultado final es que incluso con una semilla fija, puedes obtener diferentes respuestas a la misma instrucción con solo unos minutos de diferencia. Esto hace que sea increíblemente difícil construir los flujos de trabajo de IA fiables y comprobables que las empresas necesitan. No construirías una casa sobre arena movediza, y no puedes construir un sistema de automatización de soporte sólido sobre una base impredecible.

El impacto empresarial de una huella digital del sistema de OpenAI poco fiable

Cuando la huella digital del sistema de OpenAI no cumple su promesa, tiene consecuencias en el mundo real:

-

Pérdida de tiempo de los desarrolladores: los equipos pueden pasar horas intentando depurar un comportamiento "inconsistente" de la IA que en realidad es causado por cambios en el backend sobre los que no tienen control.

-

Falta de confianza en la implementación: ¿cómo puedes sentirte seguro al automatizar el 30% de tus tickets de soporte si no puedes estar seguro de que la IA actuará de la misma manera mañana que en tus pruebas de hoy?

-

Análisis sesgados: es imposible medir el ROI de tu IA o el impacto de tus mejoras si ni siquiera puedes establecer una base estable de su rendimiento.

Aquí es donde tienes que cambiar tu estrategia. En lugar de luchar por una consistencia perfecta con una herramienta que no puede proporcionarla, necesitas una plataforma que te dé una forma sólida de probar y desplegar en torno a la variabilidad natural del modelo.

Un enfoque mejor: prueba con confianza usando la simulación

Dado que no puedes forzar totalmente al modelo a ser determinista, lo mejor es tener una buena manera de predecir su comportamiento y reducir el riesgo de ponerlo frente a los clientes. Aquí es donde una plataforma de soporte de IA dedicada como eesel AI se vuelve tan valiosa. En lugar de cruzar los dedos por una huella digital del sistema de OpenAI estable, puedes tomar el control con un sólido motor de simulación e implementación.

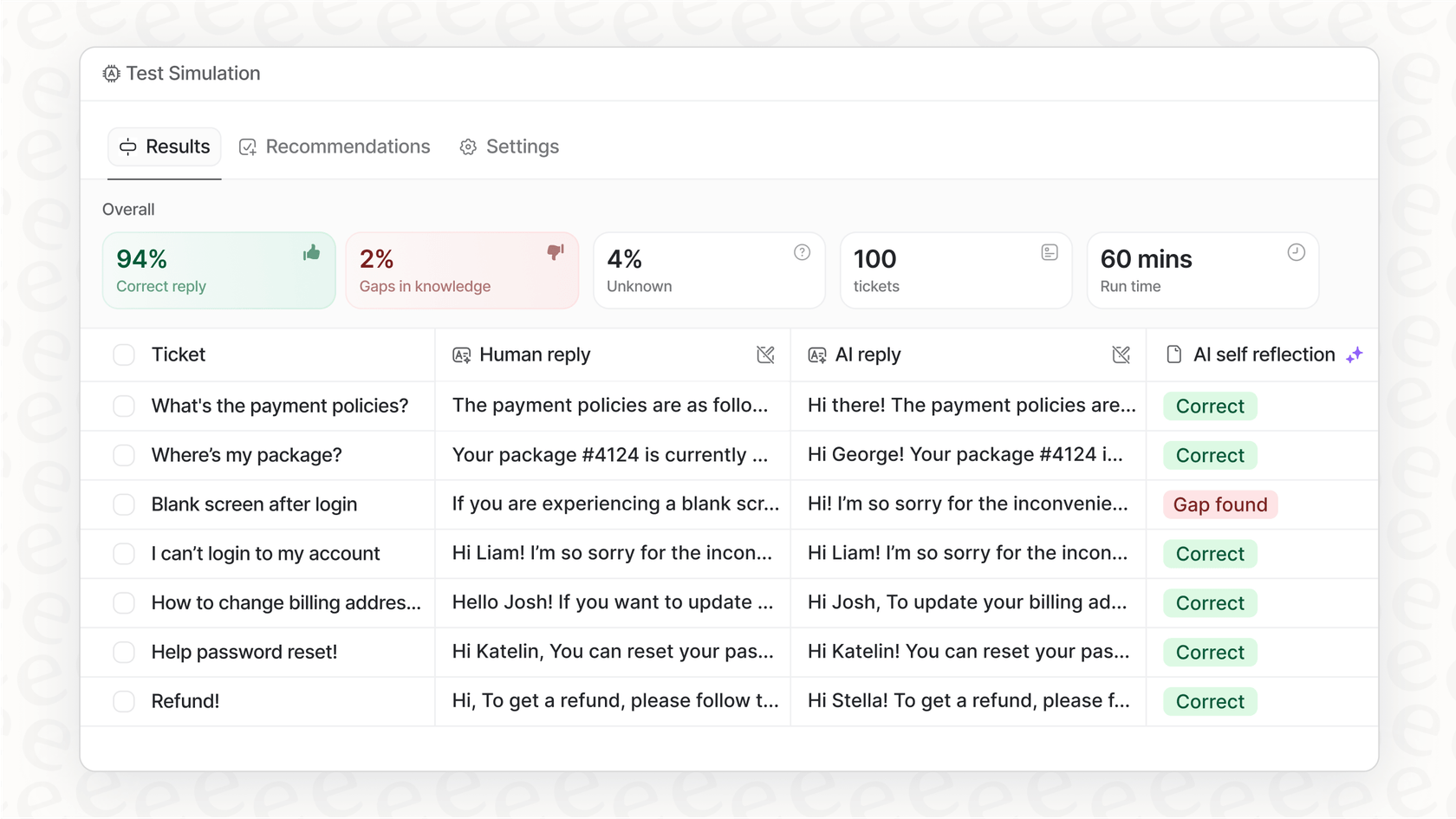

Simula antes de activar

El mayor temor con una IA impredecible es lo que podría decirle a un cliente real. El modo de simulación en eesel AI aborda esto de frente. Te permite probar tu agente de IA en miles de tus tickets pasados reales en un espacio seguro y sin conexión.

-

Pronostica tu tasa de automatización: ve exactamente cuántos tickets tu IA habría sido capaz de resolver por sí sola.

-

Revisa cada una de las respuestas: puedes revisar las respuestas generadas por la IA para asegurarte de que sean precisas y coincidan con el tono de tu empresa.

-

Detecta lagunas de conocimiento: el panel de simulación señala las preguntas con las que la IA tuvo problemas, mostrándote exactamente dónde tu base de conocimiento necesita un poco de atención.

Este tipo de pruebas sin riesgo te da un nivel de confianza que simplemente no puedes obtener de otras plataformas que carecen de este tipo de simulación profunda. Sabrás exactamente cómo es probable que se comporte tu agente antes de que interactúe con un solo cliente.

Implementa gradualmente y con control total

Una vez que estés satisfecho con su rendimiento en la simulación, no tienes que simplemente pulsar un interruptor y rezar. eesel AI te da un control detallado sobre cómo lo pones en marcha.

-

Sé selectivo con la automatización: puedes empezar permitiendo que la IA maneje solo ciertos tipos de preguntas simples y repetitivas.

-

Delimita su conocimiento: puedes limitar la IA a fuentes de conocimiento específicas para asegurarte de que no intente responder preguntas para las que no está preparada.

-

Crea vías de escape claras: establece reglas sencillas para cuando la IA deba pasar una conversación a un agente humano.

Este método te permite construir confianza en tu automatización con el tiempo. Puedes ampliar sus funciones a medida que ves cómo se desempeña en el mundo real, todo mientras tu equipo mantiene el control total.

Huella digital del sistema de OpenAI: resumen de precios de la API

Los parámetros "seed" y "system_fingerprint" están disponibles en una variedad de modelos de OpenAI, desde GPT-3.5 Turbo hasta GPT-4o. El precio de la API generalmente se basa en la cantidad de tokens que utilizas, con diferentes costos para la entrada (tu prompt) y la salida (la finalización del modelo).

| Plan/Modelo | Estructura de precios típica | Características clave para desarrolladores |

|---|---|---|

| Gratis | Acceso limitado para explorar capacidades. | Acceso a GPT-5, búsqueda web, GPTs personalizados. |

| Plus/Pro | Suscripción mensual (20-200 $/mes). | Acceso extendido/ilimitado a los últimos modelos, límites más altos. |

| Business/Enterprise | Tarifa por usuario al mes o precios personalizados. | Espacio de trabajo dedicado, seguridad mejorada, controles de administrador. |

Solo un aviso: para obtener la información de precios más reciente, siempre es mejor consultar la página oficial de precios de ChatGPT.

Aunque puedes acceder a esta función en la mayoría de los planes de pago, su falta de fiabilidad significa que pagar más por un modelo más sofisticado no soluciona el problema de consistencia subyacente. El riesgo real no está en la factura de la API, sino en el costo operativo de desplegar un agente en el que no puedes confiar plenamente.

Huella digital del sistema de OpenAI: céntrate en lo que puedes controlar

Seamos realistas, lograr que un modelo de lenguaje grande sea 100% predecible sigue siendo un hueso duro de roer, y la huella digital del sistema de OpenAI ha resultado ser una herramienta menos que perfecta para el trabajo. Para las empresas que dependen de la consistencia, esto es más que una pequeña molestia, es un verdadero obstáculo para automatizar con confianza.

En lugar de empantanarte tratando de forzar el determinismo del propio modelo, la jugada más inteligente es construir un proceso operativo sólido en torno a la IA. Al usar una plataforma que te ofrece una simulación potente, opciones de implementación gradual y controles detallados, puedes gestionar los riesgos que conlleva un poco de imprevisibilidad y desplegar agentes de IA que sean tanto útiles como fiables.

¿Listo para dejar de adivinar y empezar a probar? Con eesel AI, puedes simular tu agente de IA con tus propios datos históricos y ver exactamente cómo se desempeñará en solo unos minutos. Comienza tu prueba gratuita hoy y construye tu automatización de soporte sobre una base en la que realmente puedas confiar.

Preguntas frecuentes

La huella digital del sistema de OpenAI es un identificador único que se devuelve con cada respuesta de la API e indica la configuración de backend específica utilizada para generar esa salida. Su objetivo principal, junto con el parámetro "seed" (semilla), es ayudar a lograr respuestas de IA reproducibles para la misma entrada.

A pesar de su propósito previsto, muchos desarrolladores han informado que la huella digital del sistema de OpenAI cambia con frecuencia y de manera impredecible, incluso con entradas y valores de "seed" (semilla) consistentes. Esta inestabilidad hace que sea difícil confiar en ella para obtener resultados de IA consistentes.

Una huella digital del sistema de OpenAI inestable provoca una pérdida de tiempo para los desarrolladores que depuran comportamientos inconsistentes, una falta de confianza al implementar agentes de IA y análisis sesgados al intentar medir las mejoras de rendimiento. Socava la capacidad de establecer una base estable para las pruebas.

Teóricamente, si la huella digital del sistema de OpenAI se mantuviera estable, permitiría a los desarrolladores reproducir resultados problemáticos específicos, facilitando la depuración. Sin embargo, su falta de fiabilidad actual a menudo le impide ofrecer este beneficio de manera consistente, convirtiendo la depuración en un desafío mayor.

OpenAI afirma que la huella digital del sistema de OpenAI puede cambiar debido a actualizaciones del sistema de backend. Los desarrolladores sospechan que las solicitudes pueden ser dirigidas a diferentes configuraciones de servidor o que se implementan con frecuencia pequeños ajustes no anunciados, lo que conduce a una inestabilidad percibida.

En lugar de depender únicamente de la huella digital del sistema de OpenAI para el determinismo, un mejor enfoque implica el uso de plataformas de soporte de IA dedicadas. Estas plataformas ofrecen entornos de simulación robustos y capacidades de implementación controlada para predecir y gestionar el comportamiento de la IA con confianza.

Sí, la huella digital del sistema de OpenAI y el parámetro "seed" (semilla) están generalmente disponibles en una variedad de modelos de OpenAI, incluidos GPT-3.5 Turbo y GPT-4o, independientemente del plan de API de pago específico. Sin embargo, su disponibilidad no garantiza su fiabilidad.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.