Se está a construir algo com os modelos da OpenAI, provavelmente já passou por um momento em que só queria uma coisa: que a IA lhe desse a mesma resposta duas vezes. Obter resultados previsíveis e repetíveis é um grande trunfo para testes, controlo de qualidade e simplesmente para oferecer uma experiência de utilizador que não seja inconsistente. A OpenAI deu-nos o parâmetro "seed" e o "system_fingerprint" para tentar ajudar com isto, prometendo uma forma de obter respostas de IA mais determinísticas.

O problema é que muitos programadores estão a descobrir que estas ferramentas nem sempre funcionam como anunciado. O resultado é, muitas vezes, frustração e um comportamento da IA seriamente imprevisível. Este guia irá explicar o que é o OpenAI System Fingerprint, porque é que deveria ser tão importante e a realidade frustrante de o utilizar. Mais importante ainda, vamos guiá-lo por uma forma melhor de construir e implementar agentes de IA fiáveis, mesmo quando as ferramentas subjacentes são um pouco instáveis.

O que é o OpenAI System Fingerprint?

O OpenAI System Fingerprint é basicamente um ID único para a configuração de backend específica que a OpenAI usou para gerar uma resposta. Pense nele menos como um número de versão para o modelo e mais como um para todo o sistema que o executa naquele exato momento. De acordo com a própria documentação da OpenAI, ele deve ser usado em conjunto com o parâmetro "seed".

Eis a ideia básica:

-

Prompt: Este é o input que dá ao modelo.

-

Seed: Este é apenas um número que escolhe para dar ao modelo um ponto de partida para o seu processo semi-aleatório. Usar o mesmo seed deveria, em teoria, iniciar as coisas do mesmo ponto de partida todas as vezes.

-

System Fingerprint: Este é um código que a OpenAI lhe envia de volta. Supostamente, confirma que a configuração de hardware e software subjacente não mudou.

Quando faz uma chamada à API com o mesmo prompt e o mesmo seed, e recebe de volta o mesmo system fingerprint, deveria obter um resultado idêntico. Esta é toda a magia por trás dos "resultados reprodutíveis."

A promessa do OpenAI System Fingerprint: por que respostas de IA consistentes são importantes

Para qualquer empresa que integre IA nas suas operações diárias, especialmente em algo como apoio ao cliente, um modelo imprevisível não é apenas uma característica peculiar; é um risco genuíno. A capacidade de obter a mesma resposta para a mesma pergunta é vital por algumas razões cruciais.

Testes e controlo de qualidade confiantes

Se vai deixar uma IA falar com os seus clientes, tem de ser capaz de a testar exaustivamente. Resultados reprodutíveis permitem-lhe definir uma base estável. Pode executar os seus testes repetidamente, sabendo que quaisquer alterações que veja são devido aos seus ajustes (como um novo prompt ou uma fonte de conhecimento atualizada), e não porque o modelo simplesmente decidiu dizer algo diferente. Sem isso, está a tentar acertar num alvo em movimento, o que torna quase impossível saber se está realmente a melhorar as coisas.

Uma experiência de cliente consistente

Imagine isto: um cliente faz uma pergunta simples, recebe uma resposta e, uma hora depois, faz exatamente a mesma pergunta e obtém uma resposta completamente diferente. Esse tipo de coisa destrói a confiança e gera confusão. A IA determinística garante que uma pergunta específica recebe uma resposta específica, sempre. Isto não é negociável para coisas como políticas da empresa, informações factuais ou guias passo a passo.

Depuração e correções mais fáceis

Quando uma IA dá uma resposta estranha ou simplesmente errada, a sua equipa tem de intervir e descobrir porquê. Se o resultado mudar cada vez que tentam recriar o problema, a depuração torna-se um pesadelo total. Quando consegue obter a mesma resposta errada todas as vezes, a sua equipa pode identificar o problema exato, analisar o resultado e descobrir como corrigir o prompt ou a base de conhecimento que está a causar o problema.

A realidade: por que o OpenAI System Fingerprint muitas vezes falha o alvo

Apesar de a lógica por trás do "seed" e do "system_fingerprint" fazer sentido, a sua utilização na prática tem sido uma desilusão para muitos. Se procurar nos fóruns da comunidade da OpenAI, encontrará muitos programadores a relatar que o system fingerprint muda constantemente e sem aviso, mesmo quando todas as outras configurações estão bloqueadas.

Um utilizador chegou a realizar uma experiência com 100 tentativas e descobriu que o modelo "gpt-4-turbo" devolveu quatro fingerprints diferentes. Nenhum deles apareceu sequer na maioria das vezes.

Esta instabilidade praticamente anula todo o propósito da funcionalidade. Se a única coisa que deveria garantir um resultado estável é, por si só, instável, não pode realmente contar com ela para obter resultados consistentes.

O que causa a instabilidade do OpenAI System Fingerprint?

A OpenAI afirma que o fingerprint pode mudar quando atualizam os seus sistemas de backend. Isso é compreensível, mas estas mudanças parecem acontecer com muito mais frequência do que qualquer um esperaria. Sugere que os pedidos à API podem estar a ser enviados para diferentes configurações de servidor ou que pequenos ajustes não anunciados estão a ser implementados constantemente.

O resultado final é que, mesmo com um seed fixo, pode obter respostas diferentes para o mesmo prompt com apenas minutos de diferença. Isto torna incrivelmente difícil construir os fluxos de trabalho de IA fiáveis e testáveis de que as empresas precisam. Não se constrói uma casa em areia movediça, e não se pode construir um sistema de automação de suporte sólido sobre uma base imprevisível.

O impacto empresarial de um OpenAI System Fingerprint não fiável

Quando o OpenAI System Fingerprint não cumpre o que promete, há consequências no mundo real:

-

Tempo de desenvolvimento desperdiçado: as equipas podem perder horas a tentar depurar comportamentos de IA "inconsistentes" que, na verdade, são causados por alterações de backend sobre as quais não têm controlo.

-

Falta de confiança na implementação: como pode sentir-se confiante em automatizar 30% dos seus tickets de suporte se não pode ter a certeza de que a IA se comportará da mesma forma amanhã como nos seus testes de hoje?

-

Análises distorcidas: é impossível medir o ROI da sua IA ou o impacto das suas melhorias se não consegue sequer estabelecer uma base estável para o seu desempenho.

É aqui que tem de mudar a sua estratégia. Em vez de lutar pela consistência perfeita de uma ferramenta que não a pode fornecer, precisa de uma plataforma que lhe dê uma forma sólida de testar e implementar contornando a variabilidade natural do modelo.

Uma abordagem melhor: teste com confiança usando simulação

Como não pode forçar totalmente o modelo a ser determinístico, a melhor alternativa é ter uma ótima maneira de prever o seu comportamento e mitigar os riscos de o colocar em contacto com os clientes. É aqui que uma plataforma dedicada de suporte por IA como a eesel AI se torna tão valiosa. Em vez de cruzar os dedos por um OpenAI System Fingerprint estável, pode assumir o controlo com um motor sólido de simulação e implementação.

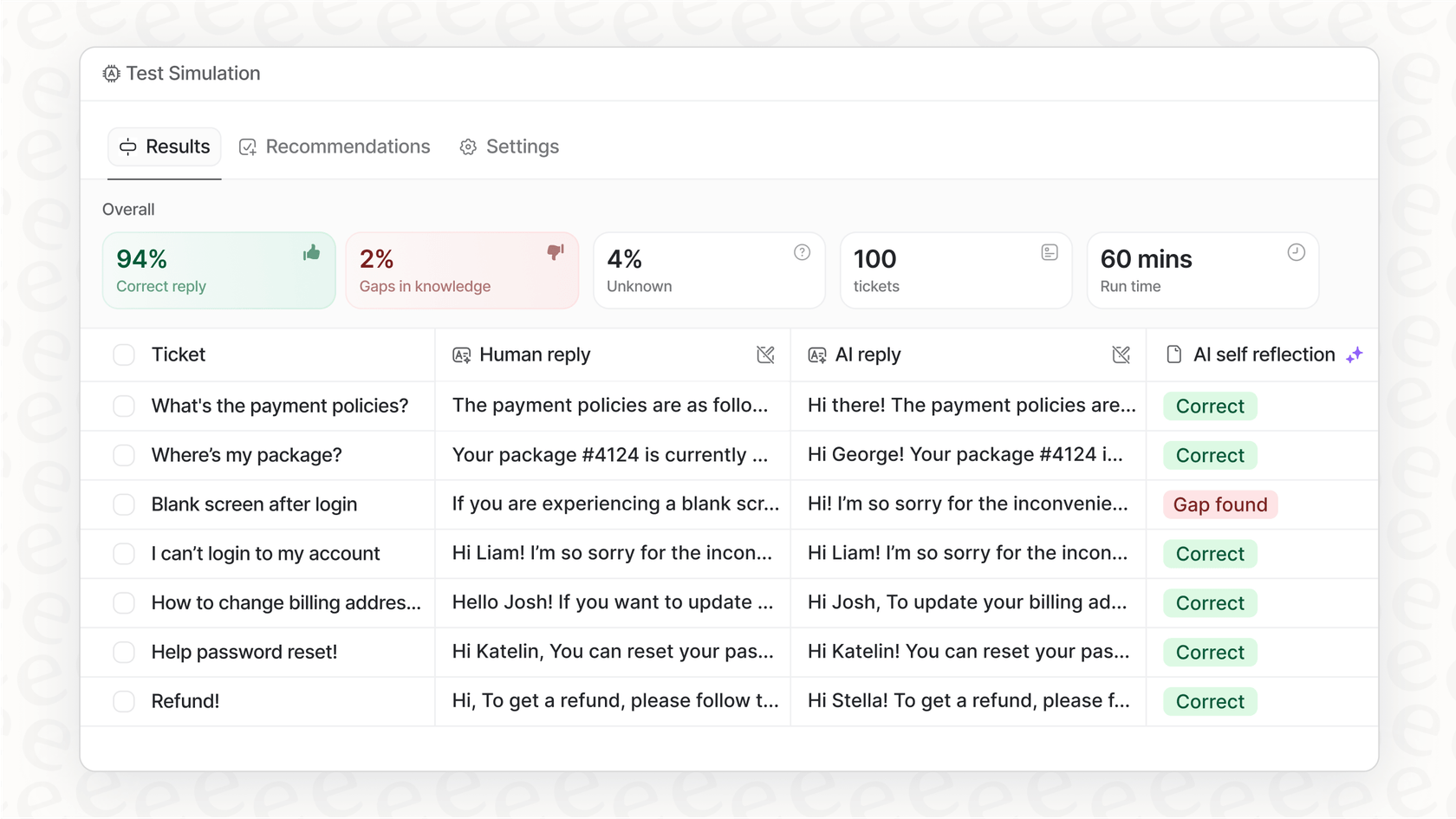

Simule antes de ativar

O maior receio com uma IA imprevisível é o que ela pode dizer a um cliente real. O modo de simulação na eesel AI aborda este problema de frente. Permite-lhe testar o seu agente de IA em milhares dos seus tickets passados reais, num ambiente seguro e offline.

-

Preveja a sua taxa de automação: veja exatamente quantos tickets a sua IA teria conseguido resolver por conta própria.

-

Verifique cada resposta: pode rever as respostas geradas pela IA para garantir que são precisas e correspondem ao tom da sua empresa.

-

Identifique lacunas de conhecimento: o painel de simulação aponta as perguntas em que a IA teve dificuldades, mostrando-lhe exatamente onde a sua base de conhecimento precisa de um pouco de atenção.

Este tipo de teste sem riscos dá-lhe um nível de confiança que simplesmente não consegue obter de outras plataformas que não possuem este tipo de simulação aprofundada. Saberá exatamente como o seu agente se irá comportar antes de interagir com um único cliente.

Implemente gradualmente e com controlo total

Quando estiver satisfeito com o desempenho na simulação, não precisa simplesmente de carregar num botão e rezar. A eesel AI dá-lhe um controlo detalhado sobre como faz a implementação.

-

Seja seletivo com a automação: pode começar por deixar a IA tratar apenas de certos tipos de perguntas simples e repetitivas.

-

Delimite o seu conhecimento: pode limitar a IA a fontes de conhecimento específicas para garantir que não tenta responder a perguntas para as quais não está preparada.

-

Crie rotas de fuga claras: configure regras simples para quando a IA deve transferir uma conversa para um agente humano.

Este método permite-lhe construir confiança na sua automação ao longo do tempo. Pode expandir as suas funções à medida que observa o seu desempenho no mundo real, tudo enquanto a sua equipa permanece completamente no controlo.

OpenAI System Fingerprint: visão geral dos preços da API

Os parâmetros "seed" e "system_fingerprint" estão disponíveis numa variedade de modelos da OpenAI, desde o GPT-3.5 Turbo até ao GPT-4o. O preço da API é normalmente baseado no número de tokens que utiliza, com custos diferentes para input (o seu prompt) e output (a conclusão do modelo).

| Plano/Modelo | Estrutura de Preços Típica | Funcionalidades Chave para Programadores |

|---|---|---|

| Gratuito | Acesso limitado para explorar capacidades. | Acesso ao GPT-5, pesquisa na web, GPTs personalizados. |

| Plus/Pro | Subscrição mensal (20€-200€/mês). | Acesso alargado/ilimitado aos modelos mais recentes, limites mais altos. |

| Business/Enterprise | Taxa por utilizador, por mês ou preços personalizados. | Espaço de trabalho dedicado, segurança melhorada, controlos de administrador. |

Atenção: Para informações de preços mais recentes, é sempre melhor consultar a página de preços oficial do ChatGPT.

Apesar de poder aceder a esta funcionalidade na maioria dos planos pagos, a sua falta de fiabilidade significa que pagar mais por um modelo mais avançado não resolve o problema subjacente de consistência. O risco real não está na fatura da API; está no custo operacional de implementar um agente em quem não pode confiar totalmente.

OpenAI System Fingerprint: foque-se no que pode controlar

Vamos ser sinceros, conseguir que um modelo de linguagem grande seja 100% previsível ainda é um osso duro de roer, e o OpenAI System Fingerprint revelou-se uma ferramenta menos que perfeita para a tarefa. Para empresas que dependem da consistência, isto é mais do que um pequeno incómodo, é um verdadeiro obstáculo para automatizar com confiança.

Em vez de se prender a tentar forçar o determinismo do próprio modelo, a jogada mais inteligente é construir um processo operacional sólido em torno da IA. Ao usar uma plataforma que lhe oferece simulação poderosa, opções de implementação gradual e controlos detalhados, pode gerir os riscos que vêm com um pouco de imprevisibilidade e implementar agentes de IA que são úteis e dignos de confiança.

Pronto para deixar de adivinhar e começar a testar? Com a eesel AI, pode simular o seu agente de IA com os seus próprios dados históricos e ver exatamente como ele se irá comportar em apenas alguns minutos. Comece o seu teste gratuito hoje e construa a sua automação de suporte sobre uma base em que pode realmente confiar.

Perguntas Frequentes

O OpenAI System Fingerprint é um identificador único devolvido com cada resposta da API, indicando a configuração de backend específica usada para gerar esse resultado. O seu objetivo principal, juntamente com o parâmetro "seed", é ajudar a alcançar respostas de IA reprodutíveis para o mesmo input.

Apesar do seu propósito, muitos programadores relataram que o OpenAI System Fingerprint muda com frequência e de forma imprevisível, mesmo com inputs consistentes e valores de "seed". Esta instabilidade torna difícil confiar nele para obter resultados de IA consistentes.

Um OpenAI System Fingerprint instável leva a tempo de desenvolvimento desperdiçado a depurar comportamentos inconsistentes, à falta de confiança na implementação de agentes de IA e a análises distorcidas ao tentar medir melhorias de desempenho. Mina a capacidade de estabelecer uma base estável para testes.

Teoricamente, se o OpenAI System Fingerprint permanecesse estável, permitiria aos programadores reproduzir resultados problemáticos específicos, facilitando a depuração. No entanto, a sua atual falta de fiabilidade impede-o frequentemente de oferecer este benefício de forma consistente, tornando a depuração um desafio ainda maior.

A OpenAI afirma que o OpenAI System Fingerprint pode mudar devido a atualizações do sistema de backend. Os programadores suspeitam que os pedidos podem ser encaminhados para diferentes configurações de servidor ou que pequenos ajustes não anunciados são implementados com frequência, levando à instabilidade percebida.

Em vez de depender exclusivamente do OpenAI System Fingerprint para o determinismo, uma abordagem melhor envolve o uso de plataformas de suporte de IA dedicadas. Estas plataformas oferecem ambientes de simulação robustos e capacidades de implementação controlada para prever e gerir o comportamento da IA com confiança.

Sim, o OpenAI System Fingerprint e o parâmetro "seed" estão geralmente disponíveis numa variedade de modelos da OpenAI, incluindo o GPT-3.5 Turbo e o GPT-4o, independentemente do plano de API pago específico. No entanto, a sua disponibilidade não garante a sua fiabilidade.

Compartilhe esta postagem

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.