Wenn Sie irgendetwas mit den Modellen von OpenAI entwickeln, hatten Sie wahrscheinlich schon einmal den Moment, in dem Sie nur eines wollten: dass die KI Ihnen zweimal die gleiche Antwort gibt. Vorhersehbare, wiederholbare Ergebnisse zu erzielen, ist für Tests, Qualitätskontrolle und einfach für die Bereitstellung einer Benutzererfahrung, die nicht völlig chaotisch ist, von enormer Bedeutung. OpenAI hat uns den Parameter „seed“ und den „system_fingerprint“ gegeben, um dabei zu helfen, und versprach eine Möglichkeit, deterministischere KI-Antworten zu erhalten.

Das Problem ist, dass viele Entwickler feststellen, dass diese Tools nicht immer wie beworben funktionieren. Das Ergebnis sind oft Frustration und ein ernsthaft unvorhersehbares KI-Verhalten. Dieser Leitfaden erklärt, was der OpenAI System Fingerprint ist, warum er so wichtig sein soll und wie die frustrierende Realität bei seiner Verwendung aussieht. Noch wichtiger ist, dass wir einen besseren Weg aufzeigen, um zuverlässige KI-Agenten zu erstellen und bereitzustellen, selbst wenn die darunter liegenden Tools etwas wackelig sind.

Was ist der OpenAI System Fingerprint?

Der OpenAI System Fingerprint ist im Grunde eine eindeutige ID für die spezifische Backend-Konfiguration, die OpenAI zur Generierung einer Antwort verwendet hat. Stellen Sie ihn sich weniger wie eine Versionsnummer für das Modell vor, sondern eher wie eine für das gesamte System, das es in diesem genauen Moment ausführt. Laut der eigenen Dokumentation von OpenAI soll er zusammen mit dem „seed“-Parameter verwendet werden.

Hier ist die Grundidee:

-

Prompt: Das ist die Eingabe, die Sie dem Modell geben.

-

Seed: Dies ist einfach eine Zahl, die Sie auswählen, um dem Modell einen Ausgangspunkt für seinen quasi-zufälligen Prozess zu geben. Die Verwendung desselben Seeds sollte theoretisch jedes Mal vom selben Punkt aus starten.

-

System Fingerprint: Dies ist ein Code, den OpenAI an Sie zurücksendet. Er soll bestätigen, dass sich die zugrunde liegende Hardware- und Softwarekonfiguration nicht geändert hat.

Wenn Sie einen API-Aufruf mit demselben Prompt und demselben Seed machen und denselben System-Fingerprint zurückbekommen, sollten Sie eine identische Ausgabe erhalten. Das ist die ganze Magie hinter „reproduzierbaren Ausgaben“.

Das Versprechen des OpenAI System Fingerprint: Warum konsistente KI-Antworten so wichtig sind

Für jedes Unternehmen, das KI in seine täglichen Abläufe integriert, insbesondere in Bereichen wie dem Kundensupport, ist ein unvorhersehbares Modell nicht nur eine eigenwillige Eigenschaft, sondern ein echtes Risiko. Die Fähigkeit, auf dieselbe Frage dieselbe Antwort zu erhalten, ist aus mehreren wichtigen Gründen von entscheidender Bedeutung.

Zuverlässiges Testen und QS

Wenn Sie eine KI mit Ihren Kunden sprechen lassen wollen, müssen Sie sie gründlich testen können. Reproduzierbare Ausgaben ermöglichen es Ihnen, eine stabile Grundlage zu schaffen. Sie können Ihre Tests immer wieder durchführen und wissen, dass alle Änderungen, die Sie sehen, auf Ihre Anpassungen zurückzuführen sind (wie ein neuer Prompt oder eine aktualisierte Wissensquelle), und nicht darauf, dass das Modell einfach Lust hatte, etwas anderes zu sagen. Ohne das versuchen Sie, ein bewegliches Ziel zu treffen, was es fast unmöglich macht zu wissen, ob Sie die Dinge tatsächlich verbessern.

Ein konsistentes Kundenerlebnis

Stellen Sie sich vor: Ein Kunde stellt eine einfache Frage, erhält eine Antwort und stellt genau dieselbe Frage eine Stunde später erneut, nur um eine völlig andere Antwort zu bekommen. So etwas zerstört das Vertrauen und schafft nur Verwirrung. Deterministische KI stellt sicher, dass eine bestimmte Frage jedes einzelne Mal eine bestimmte Antwort erhält. Dies ist für Dinge wie Unternehmensrichtlinien, sachliche Informationen oder Schritt-für-Schritt-Anleitungen nicht verhandelbar.

Einfacheres Debugging und Fehlerbehebungen

Wenn eine KI eine seltsame oder einfach nur falsche Antwort gibt, muss Ihr Team eingreifen und herausfinden, warum. Wenn sich die Ausgabe bei jedem Versuch, das Problem zu reproduzieren, ändert, wird das Debugging zu einem Albtraum. Wenn Sie jedes Mal dieselbe falsche Antwort erhalten können, kann Ihr Team das genaue Problem lokalisieren, die Ausgabe analysieren und herausfinden, wie der Prompt oder die Wissensdatenbank, die das Problem verursacht, behoben werden kann.

Die Realität: Warum der OpenAI System Fingerprint oft sein Ziel verfehlt

Obwohl die Logik hinter „seed“ und „system_fingerprint“ sinnvoll ist, war die tatsächliche Anwendung für viele eine Enttäuschung. Wenn Sie sich in den OpenAI-Community-Foren umsehen, finden Sie viele Entwickler, die berichten, dass sich der System-Fingerprint ständig und ohne Vorwarnung ändert, selbst wenn alle anderen Einstellungen festgeschrieben sind.

Ein Benutzer führte sogar ein Experiment mit 100 Versuchen durch und fand heraus, dass das Modell „gpt-4-turbo“ vier verschiedene Fingerprints zurückgab. Keiner von ihnen trat auch nur in der Mehrheit der Fälle auf.

Diese Instabilität macht den ganzen Zweck der Funktion zunichte. Wenn das eine, was ein stabiles Ergebnis garantieren soll, selbst instabil ist, kann man sich nicht wirklich darauf verlassen, konsistente Ausgaben zu erhalten.

Was verursacht die Instabilität des OpenAI System Fingerprint?

OpenAI gibt an, dass sich der Fingerprint ändern kann, wenn sie ihre Backend-Systeme aktualisieren. Das ist verständlich, aber diese Änderungen scheinen weitaus häufiger vorzukommen, als irgendjemand erwartet hätte. Dies deutet darauf hin, dass API-Anfragen möglicherweise an verschiedene Serverkonfigurationen gesendet werden oder dass ständig kleine, unangekündigte Optimierungen ausgerollt werden.

Das Endergebnis ist, dass Sie selbst mit einem festen Seed nur wenige Minuten später unterschiedliche Antworten auf denselben Prompt erhalten können. Dies macht es unglaublich schwierig, die Art von zuverlässigen, testbaren KI-Workflows zu erstellen, die Unternehmen benötigen. Man würde kein Haus auf Treibsand bauen, und man kann kein solides Support-Automatisierungssystem auf einem unvorhersehbaren Fundament errichten.

Die geschäftlichen Auswirkungen eines unzuverlässigen OpenAI System Fingerprint

Wenn der OpenAI System Fingerprint nicht liefert, was er verspricht, hat das reale Konsequenzen:

-

Verschwendete Entwicklerzeit: Teams können Stunden damit verbringen, „inkonsistentes“ KI-Verhalten zu debuggen, das tatsächlich durch Backend-Änderungen verursacht wird, über die sie keine Kontrolle haben.

-

Mangelndes Vertrauen bei der Bereitstellung: Wie können Sie sich gut dabei fühlen, 30 % Ihrer Support-Tickets zu automatisieren, wenn Sie nicht sicher sein können, dass sich die KI morgen genauso verhält wie heute in Ihren Tests?

-

Verzerrte Analysen: Es ist unmöglich, den ROI Ihrer KI oder die Auswirkungen Ihrer Verbesserungen zu messen, wenn Sie nicht einmal eine stabile Basis für ihre Leistung festlegen können.

An dieser Stelle müssen Sie Ihre Strategie ändern. Anstatt um perfekte Konsistenz von einem Werkzeug zu kämpfen, das sie nicht bieten kann, benötigen Sie eine Plattform, die Ihnen eine solide Möglichkeit bietet, um die natürliche Variabilität des Modells herum zu testen und bereitzustellen.

Ein besserer Ansatz: Mit Simulationen zuverlässig testen

Da Sie das Modell nicht vollständig zur Determiniertheit zwingen können, ist das Nächstbeste, eine großartige Möglichkeit zu haben, sein Verhalten vorherzusagen und das Risiko zu minimieren, es Kunden vorzusetzen. Hier wird eine dedizierte KI-Support-Plattform wie eesel AI so wertvoll. Anstatt die Daumen für einen stabilen OpenAI System Fingerprint zu drücken, können Sie mit einer soliden Simulations- und Rollout-Engine die Kontrolle übernehmen.

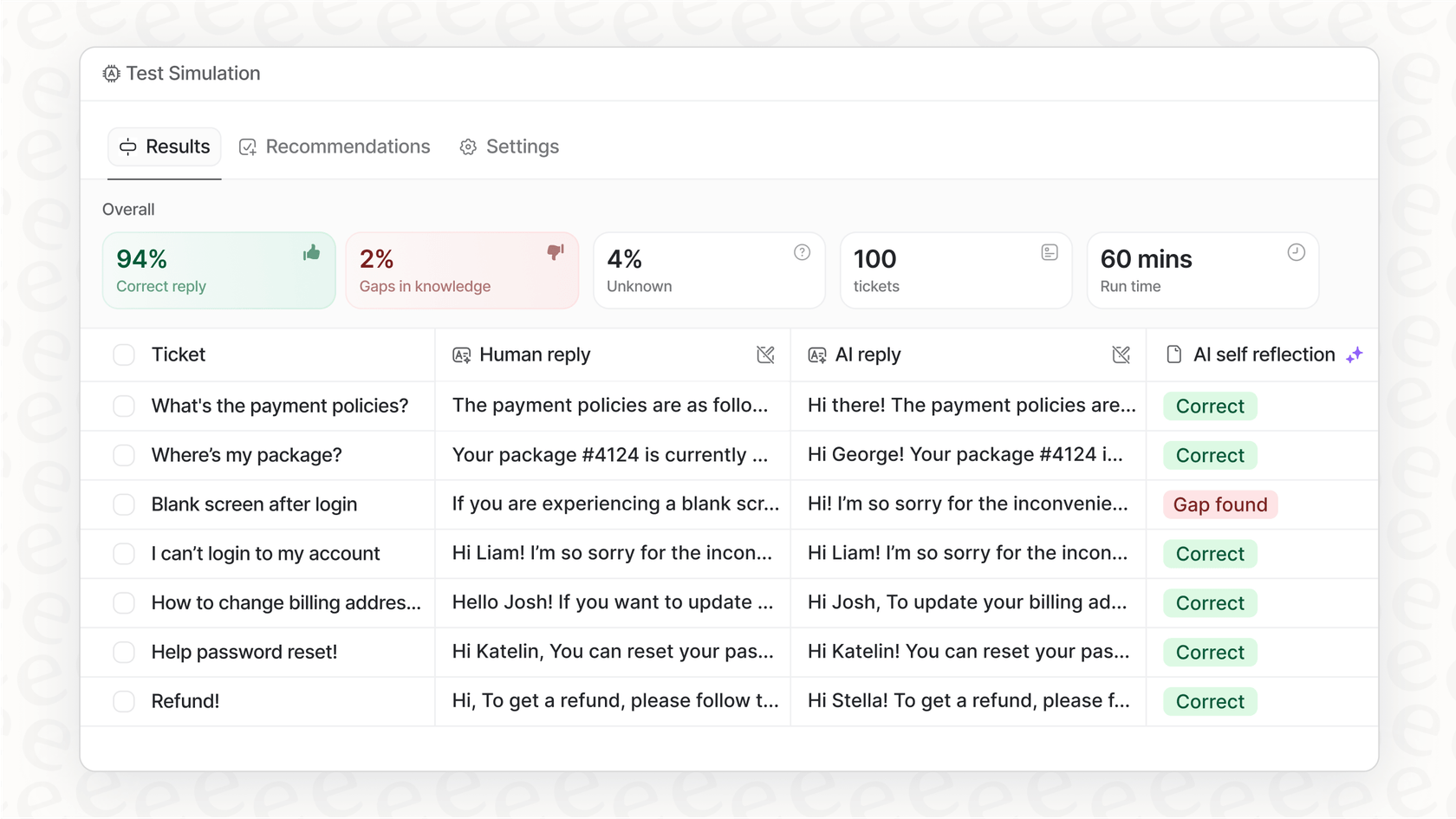

Simulieren vor dem Aktivieren

Die größte Angst bei einer unvorhersehbaren KI ist, was sie einem echten Kunden sagen könnte. Der Simulationsmodus in eesel AI geht dieses Problem direkt an. Er ermöglicht es Ihnen, Ihren KI-Agenten an Tausenden Ihrer tatsächlichen vergangenen Tickets in einer sicheren, Offline-Umgebung zu testen.

-

Prognostizieren Sie Ihre Automatisierungsrate: Sehen Sie genau, wie viele Tickets Ihre KI allein hätte lösen können.

-

Überprüfen Sie jede einzelne Antwort: Sie können die von der KI generierten Antworten durchgehen, um sicherzustellen, dass sie korrekt sind und dem Ton Ihres Unternehmens entsprechen.

-

Wissenslücken aufdecken: Das Simulations-Dashboard zeigt die Fragen auf, bei denen die KI Schwierigkeiten hatte, und zeigt Ihnen genau, wo Ihre Wissensdatenbank ein wenig Pflege benötigt.

Diese Art des risikofreien Testens gibt Ihnen ein Maß an Vertrauen, das Sie von anderen Plattformen ohne eine solch tiefgehende Simulation einfach nicht bekommen können. Sie werden genau wissen, wie sich Ihr Agent wahrscheinlich verhalten wird, bevor er jemals mit einem einzigen Kunden interagiert.

Langsame und vollständig kontrollierte Einführung

Sobald Sie mit der Leistung in der Simulation zufrieden sind, müssen Sie nicht einfach einen Schalter umlegen und hoffen. eesel AI gibt Ihnen eine feingranulare Kontrolle darüber, wie Sie live gehen.

-

Seien Sie bei der Automatisierung selektiv: Sie können damit beginnen, die KI nur bestimmte Arten von einfachen, sich wiederholenden Fragen bearbeiten zu lassen.

-

Beschränken Sie ihr Wissen: Sie können die KI auf bestimmte Wissensquellen beschränken, um sicherzustellen, dass sie nicht versucht, Fragen zu beantworten, für die sie nicht bereit ist.

-

Schaffen Sie klare Ausstiegsmöglichkeiten: Richten Sie einfache Regeln ein, wann die KI ein Gespräch an einen menschlichen Agenten übergeben soll.

Diese Methode ermöglicht es Ihnen, im Laufe der Zeit Vertrauen in Ihre Automatisierung aufzubauen. Sie können ihre Aufgaben erweitern, während Sie ihre Leistung in der realen Welt beobachten, und Ihr Team behält dabei stets die volle Kontrolle.

OpenAI System Fingerprint: API-Preisübersicht

Die Parameter „seed“ und „system_fingerprint“ sind für eine Reihe von OpenAI-Modellen verfügbar, von GPT-3.5 Turbo bis hin zu GPT-4o. Die API-Preise basieren in der Regel auf der Anzahl der verwendeten Token, mit unterschiedlichen Kosten für die Eingabe (Ihr Prompt) und die Ausgabe (die Vervollständigung des Modells).

| Plan/Modell | Typische Preisstruktur | Wichtige Funktionen für Entwickler |

|---|---|---|

| Kostenlos | Begrenzter Zugang zum Erkunden der Fähigkeiten. | Zugang zu GPT-5, Websuche, benutzerdefinierten GPTs. |

| Plus/Pro | Monatliches Abonnement (20–200 $/Monat). | Erweiterter/unbegrenzter Zugang zu den neuesten Modellen, höhere Limits. |

| Business/Enterprise | Pro Benutzer, pro Monat oder individuelle Preise. | Dedizierter Arbeitsbereich, erhöhte Sicherheit, Admin-Kontrollen. |

Nur ein Hinweis: Für die aktuellsten Preisinformationen ist es immer am besten, die offizielle ChatGPT-Preisseite zu überprüfen.

Obwohl Sie auf diese Funktion in den meisten kostenpflichtigen Plänen zugreifen können, bedeutet ihre Unzuverlässigkeit, dass mehr für ein ausgefalleneres Modell zu bezahlen, das zugrunde liegende Konsistenzproblem nicht löst. Das wahre Risiko liegt nicht in der API-Rechnung, sondern in den Betriebskosten für den Einsatz eines Agenten, dem Sie nicht vollständig vertrauen können.

OpenAI System Fingerprint: Konzentrieren Sie sich auf das, was Sie kontrollieren können

Sehen Sie, ein großes Sprachmodell zu 100 % vorhersagbar zu machen, ist immer noch eine harte Nuss, und der OpenAI System Fingerprint hat sich als ein weniger als perfektes Werkzeug für diese Aufgabe erwiesen. Für Unternehmen, die auf Konsistenz angewiesen sind, ist dies mehr als nur ein kleines Ärgernis, es ist ein echtes Hindernis für eine zuversichtliche Automatisierung.

Anstatt sich damit aufzuhalten, dem Modell selbst Determiniertheit aufzuzwingen, ist es der klügere Schritt, einen soliden operativen Prozess um die KI herum aufzubauen. Durch die Verwendung einer Plattform, die Ihnen leistungsstarke Simulationen, schrittweise Einführungsoptionen und detaillierte Kontrollen bietet, können Sie die Risiken managen, die mit einer gewissen Unvorhersehbarkeit einhergehen, und KI-Agenten einsetzen, die sowohl hilfreich als auch vertrauenswürdig sind.

Bereit, mit dem Raten aufzuhören und mit dem Testen zu beginnen? Mit eesel AI können Sie Ihren KI-Agenten mit Ihren eigenen historischen Daten simulieren und in nur wenigen Minuten genau sehen, wie er sich verhalten wird. Starten Sie noch heute Ihre kostenlose Testversion und bauen Sie Ihre Support-Automatisierung auf einem Fundament auf, dem Sie wirklich vertrauen können.

Häufig gestellte Fragen

Der OpenAI System Fingerprint ist eine eindeutige Kennung, die mit jeder API-Antwort zurückgegeben wird und die spezifische Backend-Konfiguration angibt, die zur Generierung dieser Ausgabe verwendet wurde. Sein Hauptziel ist es, zusammen mit dem „seed“-Parameter dabei zu helfen, reproduzierbare KI-Antworten für dieselbe Eingabe zu erzielen.

Trotz seines beabsichtigten Zwecks haben viele Entwickler berichtet, dass sich der OpenAI System Fingerprint häufig und unvorhersehbar ändert, selbst bei konsistenten Eingaben und „seed“-Werten. Diese Instabilität macht es schwierig, sich für konsistente KI-Ausgaben darauf zu verlassen.

Ein instabiler OpenAI System Fingerprint führt zu verschwendeter Entwicklerzeit beim Debuggen von inkonsistentem Verhalten, einem Mangel an Vertrauen bei der Bereitstellung von KI-Agenten und verzerrten Analysen bei dem Versuch, Leistungsverbesserungen zu messen. Er untergräbt die Fähigkeit, eine stabile Grundlage für Tests zu schaffen.

Theoretisch würde ein stabiler OpenAI System Fingerprint Entwicklern ermöglichen, spezifische problematische Ausgaben zu reproduzieren, was das Debugging erleichtern würde. Seine derzeitige Unzuverlässigkeit verhindert jedoch oft, dass er diesen Nutzen konsistent liefert, was das Debugging zu einer größeren Herausforderung macht.

OpenAI gibt an, dass sich der OpenAI System Fingerprint aufgrund von Updates des Backend-Systems ändern kann. Entwickler vermuten, dass Anfragen möglicherweise an verschiedene Serverkonfigurationen weitergeleitet werden oder dass häufig kleine, unangekündigte Anpassungen ausgerollt werden, was zu der wahrgenommenen Instabilität führt.

Anstatt sich ausschließlich auf den OpenAI System Fingerprint für die Determiniertheit zu verlassen, ist ein besserer Ansatz die Verwendung dedizierter KI-Support-Plattformen. Diese Plattformen bieten robuste Simulationsumgebungen und kontrollierte Rollout-Funktionen, um das Verhalten der KI zuverlässig vorherzusagen und zu steuern.

Ja, der OpenAI System Fingerprint und der „seed“-Parameter sind im Allgemeinen für eine Reihe von OpenAI-Modellen verfügbar, einschließlich GPT-3.5 Turbo und GPT-4o, unabhängig vom spezifischen kostenpflichtigen API-Plan. Seine Verfügbarkeit garantiert jedoch nicht seine Zuverlässigkeit.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.