Si vous développez quoi que ce soit avec les modèles d'OpenAI, vous avez probablement déjà souhaité une seule chose : que l'IA vous donne deux fois la même réponse. Obtenir des résultats prévisibles et reproductibles est essentiel pour les tests, le contrôle qualité et simplement pour offrir une expérience utilisateur qui ne soit pas complètement aléatoire. OpenAI nous a donné le paramètre "seed" et le "system_fingerprint" pour tenter de nous aider, promettant un moyen d'obtenir des réponses d'IA plus déterministes.

Le problème, c'est que de nombreux développeurs constatent que ces outils ne fonctionnent pas toujours comme prévu. Le résultat est souvent de la frustration et un comportement de l'IA sérieusement imprévisible. Ce guide expliquera ce qu'est le System Fingerprint d'OpenAI, pourquoi il est censé être si important, et la réalité frustrante de son utilisation. Plus important encore, nous verrons une meilleure façon de créer et de déployer des agents d'IA fiables, même lorsque les outils sous-jacents sont un peu instables.

Qu'est-ce que le System Fingerprint d'OpenAI ?

Le System Fingerprint d'OpenAI est essentiellement un identifiant unique pour la configuration backend spécifique qu'OpenAI a utilisée pour générer une réponse. Considérez-le moins comme un numéro de version pour le modèle et plus comme un numéro de version pour l'ensemble du système qui l'exécute à ce moment précis. Selon la propre documentation d'OpenAI, il est destiné à être utilisé avec le paramètre "seed".

Voici l'idée de base :

-

Prompt : C'est l'entrée que vous donnez au modèle.

-

Seed : C'est simplement un nombre que vous choisissez pour donner au modèle un point de départ pour son processus quasi-aléatoire. Utiliser la même seed devrait, en théorie, lancer les choses depuis le même point à chaque fois.

-

System Fingerprint : C'est un code qu'OpenAI vous renvoie. Il est censé confirmer que la configuration matérielle et logicielle sous-jacente n'a pas changé.

Lorsque vous effectuez un appel API avec le même prompt et la même seed, et que vous recevez le même system fingerprint, vous devriez obtenir une sortie identique. C'est toute la magie derrière les "résultats reproductibles."

La promesse du System Fingerprint d'OpenAI : pourquoi des réponses d'IA cohérentes sont si importantes

Pour toute entreprise intégrant l'IA dans ses opérations quotidiennes, en particulier pour des tâches comme le support client, un modèle imprévisible n'est pas seulement une bizarrerie, c'est un véritable risque. La capacité d'obtenir la même réponse à la même question est vitale pour plusieurs raisons clés.

Des tests et une assurance qualité en toute confiance

Si vous comptez laisser une IA parler à vos clients, vous devez pouvoir la tester de manière approfondie. Des résultats reproductibles vous permettent d'établir une base de référence stable. Vous pouvez exécuter vos tests encore et encore, en sachant que tout changement que vous observez est dû à vos ajustements (comme un nouveau prompt ou une source de connaissances mise à jour), et non parce que le modèle a eu envie de dire autre chose. Sans cela, vous essayez d'atteindre une cible mouvante, ce qui rend presque impossible de savoir si vous améliorez réellement les choses.

Une expérience client cohérente

Imaginez ceci : un client pose une question simple, obtient une réponse, puis pose exactement la même question une heure plus tard pour recevoir une réponse complètement différente. Ce genre de situation anéantit la confiance et ne fait que créer de la confusion. Une IA déterministe garantit qu'une question spécifique obtient une réponse spécifique, à chaque fois. C'est non négociable pour des éléments comme les politiques de l'entreprise, les informations factuelles ou les guides étape par étape.

Un débogage et des corrections plus faciles

Quand une IA donne une réponse étrange ou tout simplement incorrecte, votre équipe doit intervenir pour comprendre pourquoi. Si le résultat change à chaque fois qu'elle essaie de reproduire le problème, le débogage devient un véritable cauchemar. Lorsque vous pouvez obtenir la même mauvaise réponse à chaque fois, votre équipe peut identifier le problème exact, analyser le résultat et trouver comment corriger le prompt ou la base de connaissances qui en est la cause.

La réalité : pourquoi le System Fingerprint d'OpenAI rate souvent sa cible

Bien que la logique derrière le "seed" et le "system_fingerprint" soit sensée, son utilisation pratique a été une déception pour beaucoup. Si vous regardez sur les forums de la communauté OpenAI, vous trouverez de nombreux développeurs signalant que le system fingerprint change constamment et sans avertissement, même lorsque tous les autres paramètres sont verrouillés.

Un utilisateur a même mené une expérience avec 100 essais et a constaté que le modèle "gpt-4-turbo" renvoyait quatre fingerprints différents. Aucun d'entre eux n'est même apparu majoritairement.

Cette instabilité va à l'encontre de l'objectif même de la fonctionnalité. Si la seule chose censée garantir un résultat stable est elle-même instable, vous ne pouvez pas vraiment compter sur elle pour obtenir des sorties cohérentes.

Qu'est-ce qui cause l'instabilité du System Fingerprint d'OpenAI ?

OpenAI indique que le fingerprint peut changer lorsqu'ils mettent à jour leurs systèmes backend. C'est tout à fait juste, mais ces changements semblent se produire bien plus souvent que prévu. Cela suggère que les requêtes API pourraient être envoyées à différentes configurations de serveurs ou que de petites modifications non annoncées sont déployées en permanence.

Le résultat final est que même avec une seed fixe, vous pouvez obtenir des réponses différentes au même prompt à quelques minutes d'intervalle. Cela rend incroyablement difficile la création de flux de travail d'IA fiables et testables dont les entreprises ont besoin. On ne construit pas une maison sur du sable mouvant, et on ne peut pas construire un solide système d'automatisation du support sur une base imprévisible.

L'impact commercial d'un System Fingerprint d'OpenAI peu fiable

Lorsque le System Fingerprint d'OpenAI ne tient pas ses promesses, cela a des conséquences réelles :

-

Du temps de développement perdu : les équipes peuvent passer des heures à essayer de déboguer un comportement "incohérent" de l'IA qui est en réalité causé par des changements de backend sur lesquels elles n'ont aucun contrôle.

-

Un manque de confiance dans le déploiement : comment pouvez-vous être serein à l'idée d'automatiser 30 % de vos tickets de support si vous n'êtes pas sûr que l'IA se comportera demain de la même manière que lors de vos tests aujourd'hui ?

-

Des analyses faussées : il est impossible de mesurer le retour sur investissement de votre IA ou l'impact de vos améliorations si vous ne pouvez même pas établir une base de référence stable pour ses performances.

C'est là que vous devez changer de stratégie. Au lieu de vous battre pour obtenir une cohérence parfaite d'un outil qui ne peut pas la fournir, vous avez besoin d'une plateforme qui vous offre un moyen solide de tester et de déployer autour de la variabilité naturelle du modèle.

Une meilleure approche : testez en toute confiance grâce à la simulation

Comme vous ne pouvez pas totalement forcer le modèle à être déterministe, la meilleure alternative est d'avoir un excellent moyen de prédire son comportement et de réduire les risques avant de le mettre en contact avec les clients. C'est là qu'une plateforme de support IA dédiée comme eesel AI devient si précieuse. Au lieu de croiser les doigts pour obtenir un System Fingerprint d'OpenAI stable, vous pouvez prendre les choses en main avec un moteur de simulation et de déploiement solide.

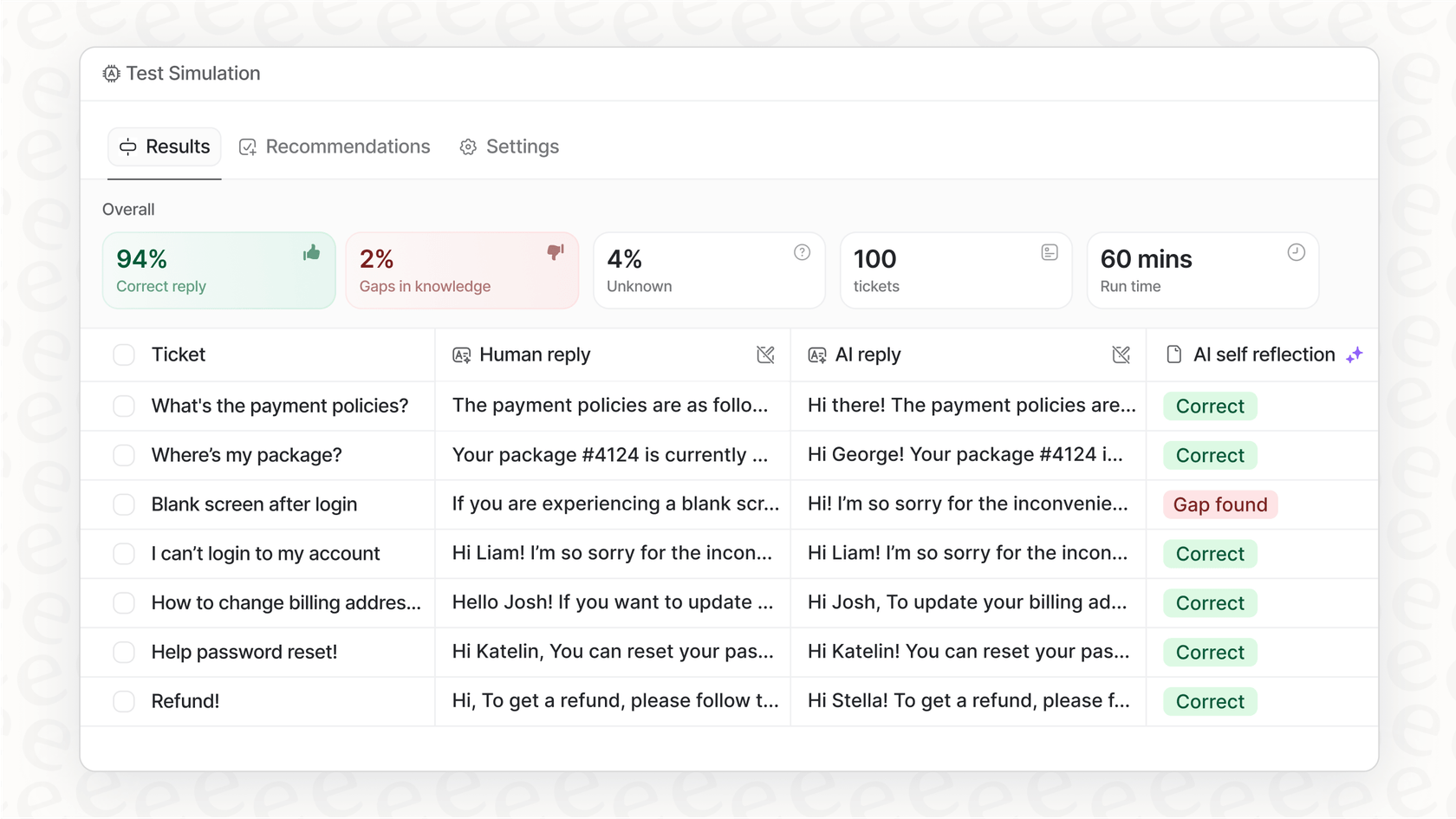

Simulez avant d'activer

La plus grande crainte avec une IA imprévisible est ce qu'elle pourrait dire à un vrai client. Le mode de simulation d'eesel AI s'attaque à ce problème de front. Il vous permet de tester votre agent d'IA sur des milliers de vos anciens tickets réels dans un espace sûr et hors ligne.

-

Prévoyez votre taux d'automatisation : voyez exactement combien de tickets votre IA aurait pu résoudre seule.

-

Vérifiez chaque réponse : vous pouvez passer en revue les réponses générées par l'IA pour vous assurer qu'elles sont exactes et correspondent au ton de votre entreprise.

-

Identifiez les lacunes dans les connaissances : le tableau de bord de la simulation met en évidence les questions sur lesquelles l'IA a buté, vous montrant exactement où votre base de connaissances a besoin d'être améliorée.

Ce type de test sans risque vous donne un niveau de confiance que vous ne pouvez tout simplement pas obtenir avec d'autres plateformes qui ne disposent pas de ce type de simulation approfondie. Vous saurez exactement comment votre agent est susceptible de se comporter avant même qu'il n'interagisse avec un seul client.

Déployez progressivement et avec un contrôle total

Une fois que vous êtes satisfait des résultats de la simulation, vous n'avez pas à appuyer sur un bouton et à prier. eesel AI vous donne un contrôle précis sur la manière de passer en production.

-

Soyez sélectif avec l'automatisation : vous pouvez commencer par laisser l'IA ne traiter que certains types de questions simples et répétitives.

-

Délimitez ses connaissances : vous pouvez limiter l'IA à des sources de connaissances spécifiques pour vous assurer qu'elle n'essaie pas de répondre à des questions pour lesquelles elle n'est pas prête.

-

Créez des issues de secours claires : définissez des règles simples pour les cas où l'IA doit transmettre une conversation à un agent humain.

Cette méthode vous permet de développer la confiance dans votre automatisation au fil du temps. Vous pouvez étendre ses fonctions à mesure que vous observez ses performances dans le monde réel, tout en gardant votre équipe entièrement aux commandes.

System Fingerprint d'OpenAI : aperçu des tarifs de l'API

Les paramètres "seed" et "system_fingerprint" sont disponibles sur une gamme de modèles OpenAI, de GPT-3.5 Turbo jusqu'à GPT-4o. La tarification de l'API est généralement basée sur le nombre de jetons que vous utilisez, avec des coûts différents pour l'entrée (votre prompt) et la sortie (la réponse du modèle).

| Forfait/Modèle | Structure tarifaire typique | Fonctionnalités clés pour les développeurs |

|---|---|---|

| Gratuit | Accès limité pour explorer les capacités. | Accès à GPT-5, recherche web, GPTs personnalisés. |

| Plus/Pro | Abonnement mensuel (20-200 $/mois). | Accès étendu/illimité aux derniers modèles, limites plus élevées. |

| Business/Entreprise | Frais par utilisateur, par mois ou tarification personnalisée. | Espace de travail dédié, sécurité renforcée, contrôles d'administration. |

Juste un rappel : pour les informations tarifaires les plus récentes, il est toujours préférable de consulter la page officielle des tarifs de ChatGPT.

Bien que vous puissiez accéder à cette fonctionnalité sur la plupart des forfaits payants, son manque de fiabilité signifie que payer plus pour un modèle plus sophistiqué ne résout pas le problème de cohérence sous-jacent. Le véritable risque ne réside pas dans la facture de l'API, mais dans le coût opérationnel du déploiement d'un agent en qui vous ne pouvez pas avoir entièrement confiance.

System Fingerprint d'OpenAI : concentrez-vous sur ce que vous pouvez contrôler

Soyons clairs, obtenir d'un grand modèle de langage qu'il soit 100 % prévisible reste un défi de taille, et le System Fingerprint d'OpenAI s'est avéré être un outil moins que parfait pour cette tâche. Pour les entreprises qui dépendent de la cohérence, ce n'est pas seulement un petit désagrément, c'est un véritable obstacle à l'automatisation en toute confiance.

Au lieu de vous enliser à essayer de forcer le déterminisme du modèle lui-même, la démarche la plus intelligente est de construire un processus opérationnel solide autour de l'IA. En utilisant une plateforme qui vous offre une simulation puissante, des options de déploiement progressif et des contrôles détaillés, vous pouvez gérer les risques liés à une certaine imprévisibilité et déployer des agents d'IA qui sont à la fois utiles et dignes de confiance.

Prêt à arrêter de deviner et à commencer à tester ? Avec eesel AI, vous pouvez simuler votre agent d'IA sur vos propres données historiques et voir exactement comment il se comportera en quelques minutes seulement. Commencez votre essai gratuit dès aujourd'hui et construisez votre automatisation du support sur une base en laquelle vous pouvez réellement avoir confiance.

Foire aux questions

Le System Fingerprint d'OpenAI est un identifiant unique renvoyé avec chaque réponse de l'API, indiquant la configuration backend spécifique utilisée pour générer cette sortie. Son objectif principal, en conjonction avec le paramètre "seed", est d'aider à obtenir des réponses d'IA reproductibles pour une même entrée.

Malgré son objectif initial, de nombreux développeurs ont signalé que le System Fingerprint d'OpenAI changeait fréquemment et de manière imprévisible, même avec des entrées et des valeurs de "seed" constantes. Cette instabilité rend difficile de s'y fier pour obtenir des résultats d'IA cohérents.

Un System Fingerprint d'OpenAI instable entraîne une perte de temps pour les développeurs qui déboguent des comportements incohérents, un manque de confiance dans le déploiement des agents d'IA, et des analyses faussées lorsqu'on essaie de mesurer les améliorations de performance. Il compromet la capacité à établir une base de référence stable pour les tests.

Théoriquement, si le System Fingerprint d'OpenAI restait stable, il permettrait aux développeurs de reproduire des résultats problématiques spécifiques, facilitant ainsi le débogage. Cependant, son manque de fiabilité actuel l'empêche souvent de fournir cet avantage de manière cohérente, transformant le débogage en un défi encore plus grand.

OpenAI déclare que le System Fingerprint peut changer en raison des mises à jour du système backend. Les développeurs soupçonnent que les requêtes pourraient être acheminées vers différentes configurations de serveurs ou que de petites modifications non annoncées sont fréquemment déployées, ce qui entraîne une instabilité perçue.

Au lieu de se fier uniquement au System Fingerprint d'OpenAI pour le déterminisme, une meilleure approche consiste à utiliser des plateformes de support IA dédiées. Ces plateformes offrent des environnements de simulation robustes et des capacités de déploiement contrôlé pour prédire et gérer le comportement de l'IA en toute confiance.

Oui, le System Fingerprint d'OpenAI et le paramètre "seed" sont généralement disponibles sur une gamme de modèles OpenAI, y compris GPT-3.5 Turbo et GPT-4o, quel que soit le plan API payant spécifique. Cependant, sa disponibilité ne garantit pas sa fiabilité.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.