Si estás desarrollando cualquier cosa con IA, ya sea un bot de atención al cliente o una herramienta interna de preguntas y respuestas, probablemente hayas tenido este pensamiento: "¿Y si alguien dice algo... malo?".

Es una preocupación válida. Mantener tu plataforma segura de contenido dañino o inapropiado no es solo algo bueno de tener; es esencial para proteger a tus usuarios y tu marca.

Para esto es exactamente para lo que sirve la API de Moderación de OpenAI. Es una herramienta práctica que te ayuda a detectar y filtrar una amplia gama de cosas desagradables tanto en texto como en imágenes. En esta guía, repasaremos todo lo que necesitas saber sobre ella, desde sus características y precios hasta sus limitaciones en el mundo real. También veremos lo que se necesita para pasar de simplemente marcar contenido a construir un sistema de moderación completo que realmente funcione.

¿Qué es la API de Moderación de OpenAI?

Piensa en la API de Moderación de OpenAI como una verificación rápida de seguridad de contenido. Le envías un texto o una imagen, y te dice si el contenido es potencialmente dañino marcándolo según las políticas de uso de OpenAI.

Básicamente, es tu primera línea de defensa. El objetivo es detectar contenido problemático a tiempo para que puedas decidir qué hacer a continuación, ya sea filtrar un mensaje, bloquear a un usuario o enviarlo a un humano para una revisión más detallada.

¿Y quizás la mejor parte? Es completamente gratuita. Eso la convierte en un punto de partida súper accesible para cualquier desarrollador que busque añadir una capa de seguridad a su aplicación sin preocuparse por los costos.

Características clave de la API de Moderación de OpenAI

La API ha mejorado mucho desde su lanzamiento, y los últimos modelos son más potentes y precisos que nunca. Aquí tienes algunas de las características principales que destacan.

Clasificación multimodal para texto e imágenes

Con el nuevo modelo "omni-moderation-latest", basado en GPT-4o, la API de Moderación de OpenAI ahora puede analizar tanto texto como imágenes en una sola pasada. Esto es un gran avance para las aplicaciones que manejan medios mixtos, como foros comunitarios o chats de soporte donde la gente sube capturas de pantalla.

Actualmente, esta función de texto e imagen funciona para tres categorías principales:

-

Violencia ("violence" y "violence/graphic")

-

Autolesiones ("self-harm", "self-harm/intent" y "self-harm/instruction")

-

Contenido sexual ("sexual")

Las otras categorías siguen siendo solo de texto por ahora, pero es un gran paso para cubrir todas las bases, sin importar el tipo de contenido.

Categorías de contenido exhaustivas

La API no solo busca un tipo de contenido malo; escanea un espectro completo de problemas. Los modelos más nuevos incluso han añadido clasificaciones más matizadas. Aquí tienes un resumen rápido de lo que puede detectar:

| Categoría | Descripción | Entradas |

|---|---|---|

| "harassment" | Lenguaje que expresa, incita o promueve el acoso. | Solo texto |

| "hate" | Contenido que promueve el odio basado en raza, género, etnia, religión, etc. | Solo texto |

| "self-harm" | Cualquier cosa que aliente o muestre actos de autolesión como suicidio o cortes. | Texto e imágenes |

| "sexual" | Contenido destinado a ser sexualmente excitante o que promueve servicios sexuales. | Texto e imágenes |

| "violence" | Contenido que muestra muerte, violencia o lesiones físicas graves. | Texto e imágenes |

| "illicit" | Contenido que da instrucciones sobre cómo hacer cosas ilegales (p. ej., "cómo robar en una tienda"). | Solo texto |

Precisión mejorada y puntuaciones calibradas

El modelo "omni-moderation-latest" también es mucho más preciso, especialmente con idiomas distintos del inglés. Las propias pruebas de OpenAI mostraron que era un 42% mejor en un conjunto de pruebas multilingüe que la versión anterior.

Otro buen detalle es que las puntuaciones del modelo ahora están "calibradas". En términos simples, esto significa que la puntuación de confianza que obtienes (un número de 0 a 1) es un reflejo más realista de las posibilidades de que el contenido realmente esté violando una política. Esto te permite establecer tus propios umbrales de filtrado con mucha más confianza.

Cuando haces una solicitud, la API te devuelve un objeto JSON con tres campos importantes:

-

"flagged": Un simple "true" o "false" que te indica si algo fue marcado.

-

"categories": Una lista de las categorías específicas que fueron marcadas como "true".

-

"category_scores": Las puntuaciones de confianza detalladas para cada categoría.

Cómo usar la API de Moderación de OpenAI

Aunque la API en sí es potente, hacer que funcione bien en tu aplicación requiere un poco de configuración técnica y planificación. Aquí tienes un vistazo rápido de lo que implica.

Primeros pasos

Lo primero es lo primero, necesitarás una cuenta de OpenAI y una clave de API, que puedes obtener de tu página de configuración de la organización. La buena noticia es que, a diferencia de otras API, tienes acceso al endpoint de moderación de inmediato. No hay que esperar.

Hacer una solicitud de moderación

Una vez que tengas tu clave, solo necesitas enviar una solicitud POST al endpoint "/v1/moderations". Realmente solo necesitas dos cosas: el "input" (el texto o la URL de la imagen que quieres verificar) y el "model" que quieres usar.

curl https://api.openai.com/v1/moderations \

-X POST \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"input": "Quiero matarlos.",

"model": "omni-moderation-latest"

}'

La API devolverá un objeto JSON con los resultados. Para una verificación rápida, puedes simplemente mirar el campo "flagged" para ver si es "true" o "false".

graph TD A[Usuario envía contenido] --> B{Llamar a la API de Moderación de OpenAI}; B --> C{¿Contenido marcado?}; C -- Sí --> D[Lógica de flujo de trabajo personalizada]; D --> E[Bloquear usuario]; D --> F[Escalar a un humano]; D --> G[Enviar advertencia]; C -- No --> H[Contenido aprobado];

subgraph Desafíos direction LR I((Latencia)) J((Reglas personalizadas)) K((Carga de ingeniería)) end D --> I; D --> J; D --> K;

Los desafíos de construir un flujo de trabajo de moderación completo

Hacer la llamada a la API es fácil. La parte difícil es lo que viene después. La API de Moderación de OpenAI te dice si el contenido es dañino, pero no te dice qué hacer al respecto. Esto deja a tu equipo con algunos obstáculos que superar.

Tienes que construir la lógica del flujo de trabajo. Necesitarás escribir todo el código que decide qué sucede cuando se marca el contenido. ¿Debería bloquearse al usuario? ¿Debería escalarse el ticket a un agente humano? ¿Debería enviarse una advertencia automática? Cada una de estas acciones necesita ser construida a medida.

La latencia puede ser un problema. Llamar a otra API por cada mensaje puede ralentizar tu aplicación. Para mantener una experiencia de usuario ágil, es posible que necesites construir un sistema asíncrono que ejecute la verificación de moderación en segundo plano, lo que añade otra capa de complejidad.

Las reglas personalizadas corren por tu cuenta. Las categorías de la API son fijas. Si necesitas filtrar contenido basado en las directrices de tu propia marca (como evitar temas políticos, solicitudes de reembolso o menciones de competidores), tienes que construir un sistema completamente separado para eso. Esto generalmente significa otra llamada a un LLM, lo que añade más costo y carga de ingeniería.

Precios de la API de Moderación de OpenAI

Esta es la parte fácil. Una de las mejores cosas de la API de Moderación de OpenAI es el precio: es gratis. Según la página oficial de precios de OpenAI, los modelos "omni-moderation" no cuestan nada.

Esto la convierte en una opción obvia para proyectos de cualquier tamaño, desde pequeñas startups hasta grandes empresas. Aunque algunas personas en foros de la comunidad piensan que está destinada a ser utilizada junto con otras API de pago de OpenAI, eso cubre a casi todos los que construyen en el ecosistema de OpenAI de todos modos.

Más allá de la API de Moderación de OpenAI: un flujo de trabajo integrado de moderación y automatización

La API gratuita es un punto de partida fantástico, pero si estás gestionando una operación de soporte al cliente en el mundo real, necesitas más que solo una marca de contenido. Necesitas un sistema que conecte esa marca a una acción inmediata e inteligente. Aquí es donde una plataforma dedicada de soporte con IA realmente marca la diferencia.

Pasa de la detección a la resolución en minutos

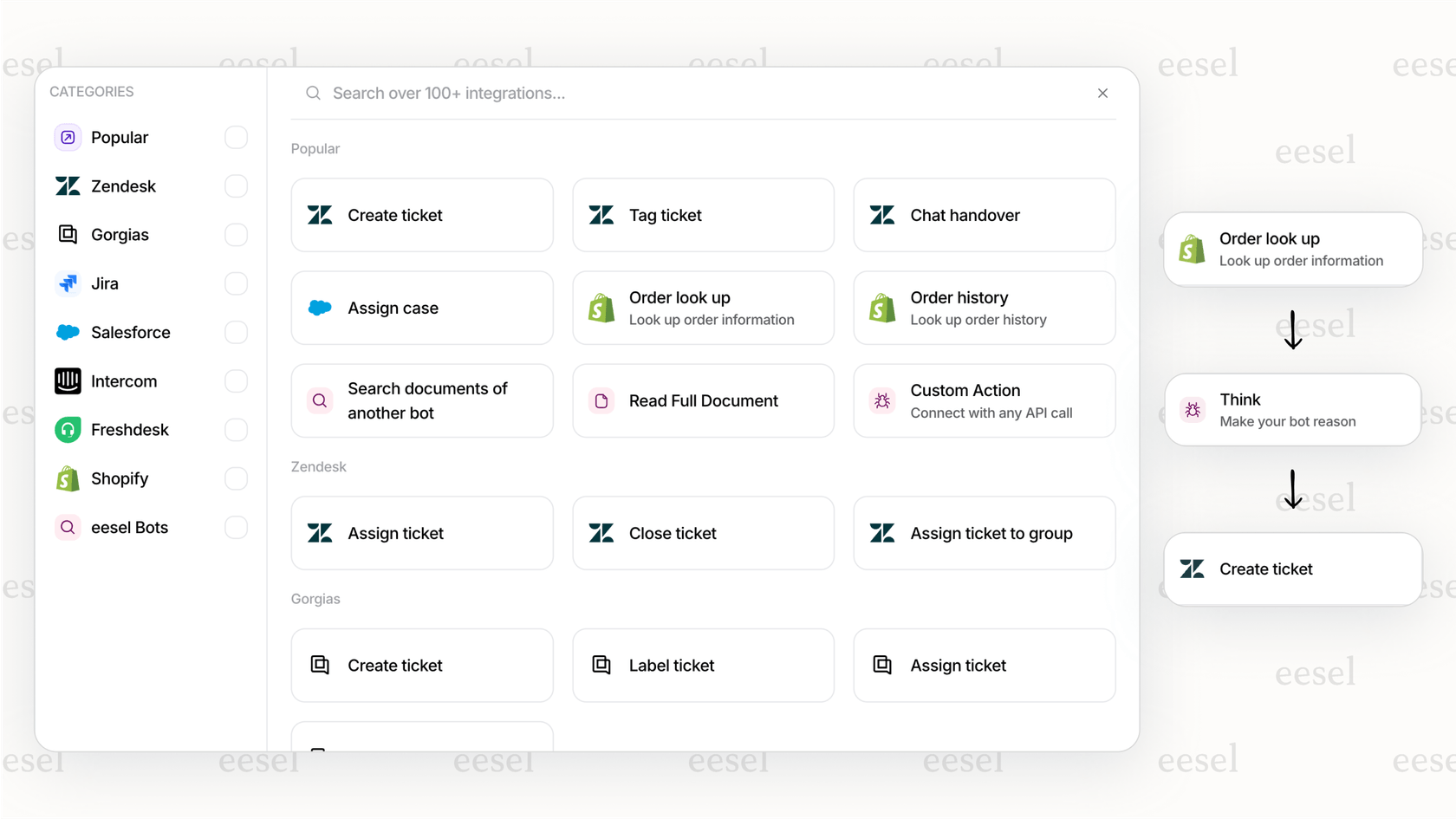

Con un enfoque de "hazlo tú mismo", tienes que codificar cada paso del flujo de trabajo. Una plataforma como eesel AI cambia las reglas del juego con lógica preconstruida e integraciones con un solo clic para los servicios de asistencia que ya usas, como Zendesk o Freshdesk.

En lugar de solo detectar un problema, puedes actuar sobre él al instante. Por ejemplo, podrías configurar un agente de eesel AI para que vea una marca de moderación, detenga inmediatamente su propia respuesta y escale automáticamente el ticket a un humano con una etiqueta de "revisión urgente". Puedes construir todo ese flujo de trabajo en unos pocos minutos sin tocar una sola línea de código.

Combina la seguridad del contenido con reglas de negocio personalizadas

Las categorías fijas de la API de Moderación de OpenAI no pueden manejar las reglas específicas de tu marca. Una plataforma integrada soluciona esto dándote un motor de flujo de trabajo totalmente personalizable. Con el editor de prompts de eesel AI, puedes definir la personalidad de tu IA y añadir capas de reglas de moderación personalizadas que van mucho más allá de la red de seguridad estándar.

Una marca de comercio electrónico, por ejemplo, podría usar la API de moderación estándar para bloquear contenido dañino, mientras que también usa las instrucciones personalizadas de eesel AI para evitar que la IA haga promesas sobre tiempos de envío o hable de la competencia.

Simula y despliega tu flujo de trabajo con confianza

Lanzar un sistema de moderación que construiste tú mismo puede parecer una apuesta. ¿Son tus umbrales demasiado estrictos, lo que lleva a falsas alarmas? ¿O son demasiado laxos, dejando pasar contenido malo?

eesel AI elimina las conjeturas con un potente modo de simulación. Antes de lanzarlo, puedes ejecutar toda tu configuración de automatización y moderación contra miles de tus tickets de soporte pasados. Esto te da una imagen clara de cómo se comportará tu IA en el mundo real, para que puedas ajustar tus reglas y desplegar sabiendo que funcionará como se espera.

Reflexiones finales sobre la API de Moderación de OpenAI

La API de Moderación de OpenAI es una herramienta fantástica. Es gratuita, potente y una excelente manera de añadir una línea base de seguridad de contenido a cualquier aplicación que estés construyendo. Con su nuevo modelo multimodal, es más útil que nunca y definitivamente debería estar en tu conjunto de herramientas de desarrollador.

Pero marcar contenido es solo el primer paso. El verdadero trabajo es convertir esa marca en un proceso de negocio fluido, fiable y personalizado. Construir estos flujos de trabajo desde cero es un trabajo pesado que requiere mucho tiempo de ingeniería, mantenimiento continuo y pruebas cuidadosas.

Para los equipos que necesitan moverse rápido sin tomar atajos, una plataforma integrada como eesel AI ofrece el paquete completo. Combina el poder de la moderación de OpenAI con un constructor de flujos de trabajo sin código, integraciones profundas y herramientas de prueba sólidas. Te permite pasar de la simple detección a la automatización completa en minutos, no en meses.

Construye flujos de trabajo de soporte más inteligentes y seguros con eesel AI

¿Listo para construir un sistema de soporte que no solo sea seguro, sino también inteligente y eficiente? Prueba eesel AI gratis y descubre lo fácil que es automatizar tus flujos de trabajo de soporte en minutos.

Preguntas frecuentes

Sí, según los precios oficiales de OpenAI, los modelos "omni-moderation" son completamente gratuitos. Esto hace que la API de Moderación de OpenAI sea una herramienta muy accesible para añadir una capa básica de seguridad de contenido a aplicaciones de cualquier tamaño.

El modelo "omni-moderation-latest" puede detectar violencia, autolesiones y contenido sexual tanto en texto como en imágenes. Otras categorías como acoso, odio y contenido ilícito actualmente solo son compatibles con entradas de texto.

Aunque la API de Moderación de OpenAI es excelente para identificar contenido dañino, principalmente marca problemas sin proporcionar una lógica de flujo de trabajo. Para un sistema de moderación completo que automatice respuestas o escaladas, normalmente necesita integrarse con soluciones adicionales personalizadas o una plataforma de soporte con IA dedicada.

El modelo "omni-moderation-latest" presume de una precisión mejorada, incluyendo una mejora del 42% en conjuntos de pruebas multilingües en comparación con versiones anteriores. Sus puntuaciones calibradas también proporcionan una indicación de confianza más fiable para las violaciones de políticas en diferentes idiomas.

Para empezar, necesitarás una cuenta de OpenAI y una clave de API de la configuración de tu organización. Una vez que tengas la clave, puedes enviar solicitudes POST al endpoint "/v1/moderations" con tu contenido de entrada y el modelo deseado.

La API de Moderación de OpenAI proporciona categorías de contenido predefinidas. No admite de forma nativa reglas personalizadas y específicas de la marca (p. ej., bloquear menciones de competidores o políticas de productos específicas). Para tales requisitos a medida, es necesario integrarla con una plataforma que ofrezca un motor de flujo de trabajo personalizable, como eesel AI.

Compartir esta entrada

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.