Si vous développez quoi que ce soit avec l'IA, que ce soit un robot de support client ou un outil de questions-réponses interne, vous vous êtes probablement déjà posé cette question : « Et si quelqu'un disait quelque chose... de malveillant ? »

C'est une préoccupation légitime. Protéger votre plateforme contre les contenus préjudiciables ou inappropriés n'est pas seulement un plus ; c'est essentiel pour protéger vos utilisateurs et votre marque.

C'est exactement à cela que sert l'API de Modération d'OpenAI. C'est un outil pratique qui vous aide à repérer et à filtrer toute une gamme de contenus indésirables, tant dans le texte que dans les images. Dans ce guide, nous passerons en revue tout ce que vous devez savoir à ce sujet, de ses fonctionnalités et sa tarification à ses limites dans le monde réel. Nous verrons également ce qu'il faut faire pour passer du simple signalement de contenu à la création d'un système de modération complet qui fonctionne réellement.

Qu'est-ce que l'API de Modération d'OpenAI ?

Considérez l'API de Modération d'OpenAI comme un outil de vérification rapide de la sécurité du contenu. Vous lui envoyez du texte ou une image, et elle vous indique si le contenu est potentiellement préjudiciable en le signalant par rapport aux politiques d'utilisation d'OpenAI.

C'est essentiellement votre première ligne de défense. L'objectif est de détecter les contenus problématiques à un stade précoce afin que vous puissiez décider de la marche à suivre, que ce soit filtrer un message, bloquer un utilisateur ou l'envoyer à un humain pour un examen plus approfondi.

Et le meilleur dans tout ça ? C'est entièrement gratuit. Cela en fait un point de départ très accessible pour tout développeur cherchant à ajouter une couche de sécurité à son application sans se soucier des coûts.

Principales fonctionnalités de l'API de Modération d'OpenAI

L'API s'est beaucoup améliorée depuis son lancement, et les derniers modèles sont plus puissants et précis que jamais. Voici quelques-unes des fonctionnalités principales qui se démarquent.

Classification multimodale pour le texte et les images

Avec le nouveau modèle « omni-moderation-latest », basé sur GPT-4o, l'API de Modération d'OpenAI peut désormais analyser à la fois le texte et les images en une seule fois. C'est un avantage considérable pour les applications qui gèrent des médias mixtes, comme les forums communautaires ou les chats de support où les gens téléchargent des captures d'écran.

Actuellement, cette fonctionnalité texte-image fonctionne pour trois catégories principales :

-

Violence (« violence » et « violence/graphic »)

-

Automutilation (« self-harm », « self-harm/intent » et « self-harm/instruction »)

-

Contenu sexuel (« sexual »)

Les autres catégories ne concernent que le texte pour le moment, mais c'est un grand pas en avant pour couvrir tous les cas de figure, quel que soit le type de contenu.

Catégories de contenu complètes

L'API ne se contente pas de rechercher un seul type de contenu indésirable ; elle balaie un large éventail de problèmes. Les modèles plus récents ont même ajouté des classifications plus nuancées. Voici un bref aperçu de ce qu'elle peut détecter :

| Catégorie | Description | Entrées |

|---|---|---|

| "harassment" | Langage qui exprime, incite ou promeut le harcèlement. | Texte uniquement |

| "hate" | Contenu promouvant la haine basée sur la race, le genre, l'ethnicité, la religion, etc. | Texte uniquement |

| "self-harm" | Tout ce qui encourage ou montre des actes d'automutilation comme le suicide ou la scarification. | Texte et images |

| "sexual" | Contenu destiné à être sexuellement excitant ou qui promeut des services sexuels. | Texte et images |

| "violence" | Contenu montrant la mort, la violence ou des blessures physiques graves. | Texte et images |

| "illicit" | Contenu donnant des instructions sur la manière de faire des choses illégales (par exemple, « comment voler à l'étalage »). | Texte uniquement |

Précision améliorée et scores calibrés

Le modèle « omni-moderation-latest » est également beaucoup plus précis, en particulier avec les langues autres que l'anglais. Les propres tests d'OpenAI ont montré qu'il était 42 % plus performant sur un ensemble de tests multilingues que la version précédente.

Une autre amélioration appréciable est que les scores du modèle sont désormais « calibrés ». En termes simples, cela signifie que le score de confiance que vous obtenez (un nombre de 0 à 1) reflète de manière plus réaliste la probabilité que le contenu enfreigne réellement une politique. Cela vous permet de définir vos propres seuils de filtrage avec beaucoup plus de confiance.

Lorsque vous effectuez une requête, l'API vous renvoie un objet JSON avec trois champs importants :

-

"flagged" : Un simple "true" ou "false" vous indiquant si quelque chose a été signalé.

-

"categories" : Une liste des catégories spécifiques qui ont été signalées comme "true".

-

"category_scores" : Les scores de confiance détaillés pour chaque catégorie.

Comment utiliser l'API de Modération d'OpenAI

Bien que l'API elle-même soit puissante, la faire fonctionner correctement dans votre application nécessite une certaine configuration technique et de la planification. Voici un bref aperçu de ce que cela implique.

Pour commencer

Tout d'abord, vous aurez besoin d'un compte OpenAI et d'une clé API, que vous pouvez obtenir depuis votre page des paramètres de l'organisation. La bonne nouvelle est que, contrairement à d'autres API, vous avez immédiatement accès au point de terminaison de modération. Aucune attente n'est requise.

Effectuer une requête de modération

Une fois que vous avez votre clé, il vous suffit d'envoyer une requête POST au point de terminaison "/v1/moderations". Vous n'avez vraiment besoin que de deux choses : l'"input" (le texte ou l'URL de l'image que vous voulez vérifier) et le "model" que vous voulez utiliser.

curl https://api.openai.com/v1/moderations \

-X POST \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"input": "Je veux les tuer.",

"model": "omni-moderation-latest"

}'

L'API vous renverra un objet JSON avec les résultats. Pour une vérification rapide, vous pouvez simplement regarder le champ "flagged" pour voir s'il est "true" ou "false".

graph TD A[L'utilisateur soumet du contenu] --> B{Appel à l'API de Modération d'OpenAI}; B --> C{Contenu signalé ?}; C -- Oui --> D[Logique de flux de travail personnalisée]; D --> E[Bloquer l'utilisateur]; D --> F[Transférer à un humain]; D --> G[Envoyer un avertissement]; C -- Non --> H[Contenu approuvé];

subgraph Défis direction LR I((Latence)) J((Règles personnalisées)) K((Charge de travail d'ingénierie)) end D --> I; D --> J; D --> K;

Les défis de la création d'un flux de travail de modération complet

Faire l'appel à l'API est facile. Le plus difficile, c'est ce qui vient après. L'API de Modération d'OpenAI vous dit si un contenu est préjudiciable, mais elle ne vous dit pas quoi faire à ce sujet. Cela laisse à votre équipe quelques obstacles à surmonter.

Vous devez construire la logique du flux de travail. Vous devrez écrire tout le code qui décide de ce qui se passe lorsqu'un contenu est signalé. L'utilisateur doit-il être bloqué ? Le ticket doit-il être transmis à un agent humain ? Un avertissement automatisé doit-il être envoyé ? Chacune de ces actions doit être développée sur mesure.

La latence peut être un problème. Appeler une autre API pour chaque message peut ralentir votre application. Pour maintenir une expérience utilisateur fluide, vous pourriez avoir besoin de construire un système asynchrone qui exécute la vérification de modération en arrière-plan, ce qui ajoute une autre couche de complexité.

Les règles personnalisées sont à votre charge. Les catégories de l'API sont gravées dans le marbre. Si vous devez filtrer du contenu en fonction de vos propres directives de marque (comme éviter les discussions politiques, les demandes de remboursement ou les mentions de concurrents), vous devez construire un système entièrement distinct pour cela. Cela implique généralement un autre appel LLM, ce qui ajoute des coûts et une charge de travail d'ingénierie supplémentaires.

Tarification de l'API de Modération d'OpenAI

C'est la partie la plus simple. L'un des meilleurs atouts de l'API de Modération d'OpenAI est son prix : elle est gratuite. Selon la page de tarification officielle d'OpenAI, les modèles "omni-moderation" ne coûtent rien à utiliser.

Cela en fait un choix évident pour les projets de toutes tailles, des petites startups aux grandes entreprises. Bien que certaines personnes sur les forums communautaires pensent qu'elle est destinée à être utilisée avec d'autres API payantes d'OpenAI, cela couvre de toute façon la quasi-totalité des personnes qui développent dans l'écosystème OpenAI.

Au-delà de l'API de Modération d'OpenAI : un flux de travail de modération et d'automatisation intégré

L'API gratuite est un excellent point de départ, mais si vous gérez une opération de support client dans le monde réel, vous avez besoin de plus qu'un simple signalement de contenu. Vous avez besoin d'un système qui associe ce signalement à une action immédiate et intelligente. C'est là qu'une plateforme de support IA dédiée fait vraiment la différence.

Passez de la détection à la résolution en quelques minutes

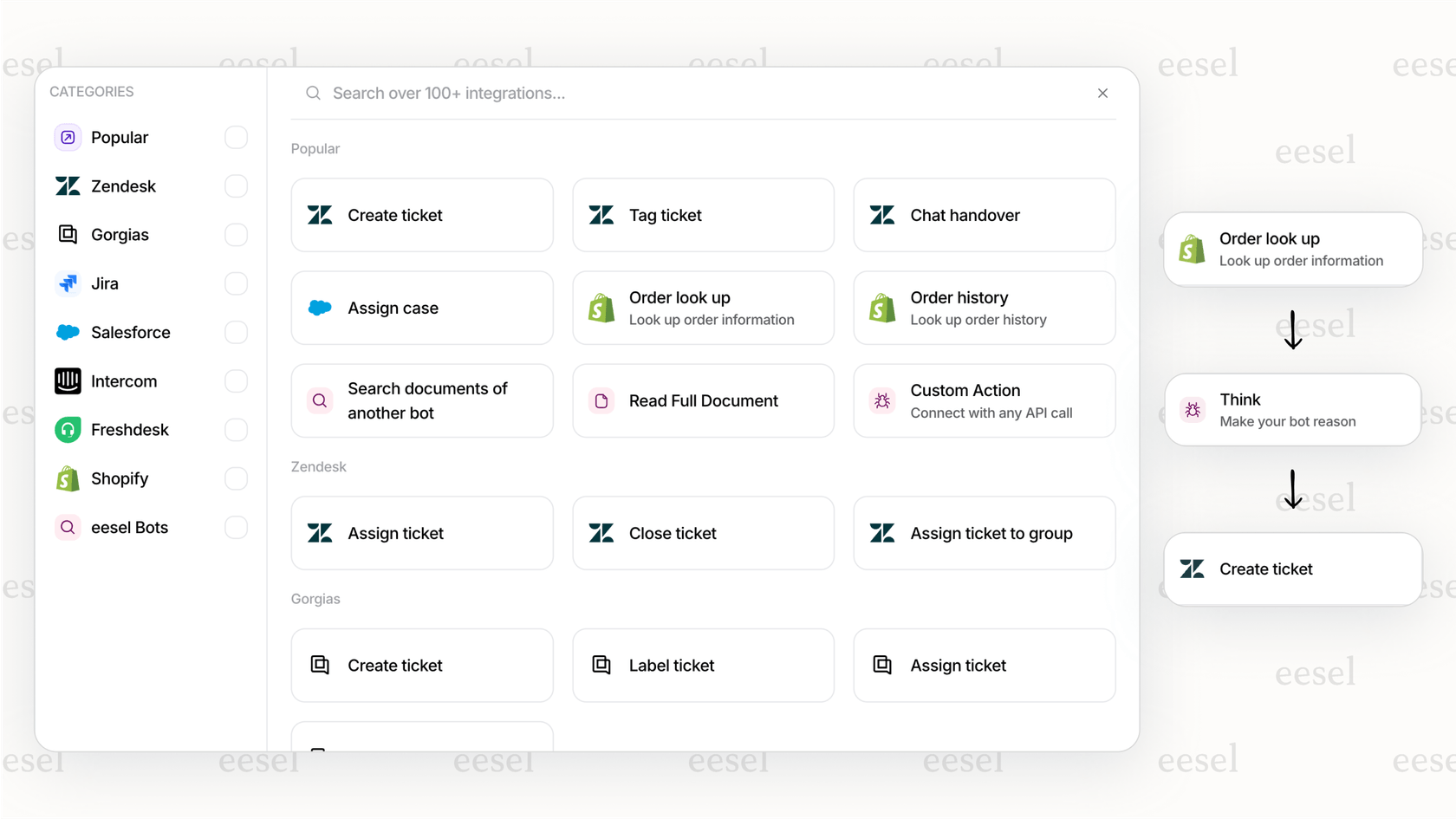

Avec une approche DIY, vous devez coder vous-même chaque étape du flux de travail. Une plateforme comme eesel AI change la donne avec une logique préconfigurée et des intégrations en un clic avec les services d'assistance que vous utilisez déjà, comme Zendesk ou Freshdesk.

Au lieu de simplement repérer un problème, vous pouvez agir instantanément. Par exemple, vous pourriez configurer un agent eesel AI pour qu'il voie un signalement de modération, arrête immédiatement sa propre réponse et transmette automatiquement le ticket à un humain avec une étiquette « examen urgent ». Vous pouvez construire ce flux de travail complet en quelques minutes sans toucher à une seule ligne de code.

Combinez la sécurité du contenu avec des règles métier personnalisées

Les catégories fixes de l'API de Modération d'OpenAI ne peuvent pas gérer vos règles spécifiques à votre marque. Une plateforme intégrée résout ce problème en vous offrant un moteur de flux de travail entièrement personnalisable. Avec l'éditeur de prompts d'eesel AI, vous pouvez définir la personnalité de votre IA et superposer des règles de modération personnalisées qui vont bien au-delà du filet de sécurité standard.

Une marque de e-commerce, par exemple, pourrait utiliser l'API de modération standard pour bloquer les contenus préjudiciables, tout en utilisant les instructions personnalisées d'eesel AI pour empêcher l'IA de faire des promesses sur les délais de livraison ou de parler des concurrents.

Simulez et déployez votre flux de travail en toute confiance

Déployer un système de modération que vous avez construit vous-même peut sembler un pari risqué. Vos seuils sont-ils trop stricts, entraînant de fausses alertes ? Ou sont-ils trop laxistes, laissant passer des contenus indésirables ?

eesel AI élimine les incertitudes avec un puissant mode de simulation. Avant de mettre en production, vous pouvez exécuter l'ensemble de votre configuration d'automatisation et de modération sur des milliers de vos anciens tickets de support. Cela vous donne une image claire de la façon dont votre IA se comportera en conditions réelles, afin que vous puissiez ajuster vos règles et déployer en sachant que tout fonctionnera comme prévu.

Dernières réflexions sur l'API de Modération d'OpenAI

L'API de Modération d'OpenAI est un outil fantastique. Elle est gratuite, puissante et constitue un excellent moyen d'ajouter une base de sécurité de contenu à toute application que vous développez. Avec son nouveau modèle multimodal, elle est plus utile que jamais et devrait absolument faire partie de votre boîte à outils de développeur.

Mais signaler du contenu n'est que la première étape. Le vrai travail consiste à transformer ce signalement en un processus métier fluide, fiable et personnalisé. Construire ces flux de travail à partir de zéro est un travail colossal qui demande beaucoup de temps d'ingénierie, une maintenance continue et des tests minutieux.

Pour les équipes qui ont besoin d'avancer rapidement sans faire de compromis, une plateforme intégrée comme eesel AI offre une solution complète. Elle combine la puissance de la modération d'OpenAI avec un créateur de flux de travail sans code, des intégrations profondes et des outils de test solides. Elle vous permet de passer de la simple détection à l'automatisation complète en quelques minutes, et non en plusieurs mois.

Créez des flux de travail de support plus intelligents et plus sûrs avec eesel AI

Prêt à construire un système de support qui est non seulement sûr, mais aussi intelligent et efficace ? Essayez eesel AI gratuitement et découvrez à quel point il est facile d'automatiser vos flux de travail de support en quelques minutes.

Foire aux questions

Oui, selon la tarification officielle d'OpenAI, les modèles « omni-moderation » sont entièrement gratuits. Cela fait de l'API de Modération d'OpenAI un outil très accessible pour ajouter une couche de sécurité de base à des applications de toutes tailles.

Le modèle « omni-moderation-latest » peut détecter la violence, l'automutilation et le contenu sexuel dans le texte et les images. D'autres catégories comme le harcèlement, la haine et les contenus illicites sont actuellement prises en charge uniquement pour les entrées de texte.

Bien que l'API de Modération d'OpenAI soit excellente pour identifier les contenus préjudiciables, elle se contente principalement de signaler les problèmes sans fournir de logique de flux de travail. Pour un système de modération complet qui automatise les réponses ou les transferts, elle doit généralement être intégrée à des solutions personnalisées supplémentaires ou à une plateforme de support IA dédiée.

Le modèle « omni-moderation-latest » offre une précision améliorée, y compris une amélioration de 42 % sur des ensembles de tests multilingues par rapport aux versions précédentes. Ses scores calibrés fournissent également une indication de confiance plus fiable pour les violations de politique dans différentes langues.

Pour commencer, vous aurez besoin d'un compte OpenAI et d'une clé API que vous trouverez dans les paramètres de votre organisation. Une fois que vous avez la clé, vous pouvez envoyer des requêtes POST au point de terminaison « /v1/moderations » avec votre contenu en entrée et le modèle souhaité.

L'API de Modération d'OpenAI fournit des catégories de contenu prédéfinies. Elle ne prend pas en charge nativement les règles personnalisées spécifiques à une marque (par exemple, bloquer les mentions de concurrents ou des politiques de produits spécifiques). L'intégrer à une plateforme offrant un moteur de flux de travail personnalisable, comme eesel AI, est nécessaire pour de telles exigences sur mesure.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.