AIを使って何かを開発しているなら、それがカスタマーサポートボットであれ、社内Q&Aツールであれ、きっとこんな風に考えたことがあるでしょう。「もし誰かが…不適切なことを言ったらどうしよう?」と。

これはもっともな懸念です。プラットフォームを有害または不適切なコンテンツから安全に保つことは、単なる付加価値ではなく、ユーザーとブランドを守るために不可欠です。

まさにこの目的のためにあるのが、OpenAI Moderation APIです。これは、テキストと画像の両方におけるさまざまな不快なコンテンツを特定し、フィルタリングするのに役立つ便利なツールです。このガイドでは、その機能や価格設定から、実際の使用における限界まで、知っておくべきすべてのことを解説します。また、単にコンテンツにフラグを立てるだけでなく、実際に機能する本格的なモデレーションシステムを構築するために何が必要かについても見ていきます。

OpenAI Moderation APIとは?

OpenAI Moderation APIは、迅速なコンテンツの安全性チェックツールだと考えてください。テキストや画像を送信すると、そのコンテンツがOpenAIの利用ポリシーに照らして潜在的に有害であるかどうかをフラグを立てて教えてくれます。

これは基本的に、あなたの最初の防衛線です。問題のあるコンテンツを早期に検出し、メッセージをフィルタリングする、ユーザーをブロックする、または人間の目で詳しく確認するためにエスカレーションするなど、次に行うべきことを決定できるようにすることが目的です。

そして、おそらく最大の利点は、完全に無料であることです。これにより、コストを気にすることなくアプリケーションに安全性のレイヤーを追加したいと考えているすべての開発者にとって、非常にアクセスしやすい出発点となります。

OpenAI Moderation APIの主な機能

このAPIは最初のリリース以来、大幅に改善されており、最新のモデルはこれまで以上に強力で正確です。ここでは、際立っている主要な機能をいくつか紹介します。

テキストと画像のマルチモーダル分類

GPT-4oをベースに構築された新しい「omni-moderation-latest」モデルにより、OpenAI Moderation APIはテキストと画像の両方を一度に分析できるようになりました。これは、コミュニティフォーラムや、ユーザーがスクリーンショットをアップロードするサポートチャットなど、混合メディアを扱うアプリにとって非常に大きな進歩です。

現在、このテキストと画像の機能は、主に3つのカテゴリで機能します。

-

暴力 (「violence」および「violence/graphic」)

-

自傷行為 (「self-harm」、「self-harm/intent」、および「self-harm/instruction」)

-

性的コンテンツ (「sexual」)

他のカテゴリは今のところテキストのみですが、コンテンツの種類に関係なくすべての基盤をカバーするための大きな一歩です。

包括的なコンテンツカテゴリ

このAPIは、1種類の不適切なコンテンツだけを探すのではなく、幅広い問題をスキャンします。新しいモデルでは、さらに微妙な分類が追加されています。検出できる内容の概要は次のとおりです。

| カテゴリー | 説明 | 入力 |

|---|---|---|

| 「harassment」 | ハラスメントを表現、扇動、または助長する言葉。 | テキストのみ |

| 「hate」 | 人種、性別、民族、宗教などに基づく憎悪を助長するコンテンツ。 | テキストのみ |

| 「self-harm」 | 自殺や自傷など、自傷行為を助長または示すもの。 | テキストと画像 |

| 「sexual」 | 性的に興奮させることを意図した、または性的サービスを宣伝するコンテンツ。 | テキストと画像 |

| 「violence」 | 死、暴力、または深刻な身体的傷害を示すコンテンツ。 | テキストと画像 |

| 「illicit」 | 違法行為の方法を教えるコンテンツ(例:「万引きの方法」)。 | テキストのみ |

精度の向上と較正済みスコア

「omni-moderation-latest」モデルは、特に英語以外の言語で非常に精度が向上しています。OpenAI独自のテストでは、多言語テストセットで以前のバージョンよりも42%優れていることが示されました。

もう一つの素晴らしい点は、モデルのスコアが「較正済み」であることです。簡単に言うと、これは得られる信頼度スコア(0から1の数値)が、コンテンツが実際にポリシーに違反している可能性をより現実的に反映していることを意味します。これにより、より自信を持って独自のフィルタリング閾値を設定できます。

リクエストを行うと、APIは3つの重要なフィールドを持つJSONオブジェクトを返します。

-

「flagged」:何かがフラグ付けされたかどうかを示す単純な「true」または「false」。

-

「categories」:「true」としてフラグ付けされた特定のカテゴリのリスト。

-

「category_scores」:すべてのカテゴリに対する詳細な信頼度スコア。

OpenAI Moderation APIの使い方

API自体は強力ですが、アプリでうまく機能させるには、少し技術的な設定と計画が必要です。ここでは、関連する作業の概要を簡単に見ていきます。

はじめに

まず、OpenAIアカウントとAPIキーが必要です。これらは組織設定ページから取得できます。幸いなことに、他のAPIとは異なり、モデレーションエンドポイントにはすぐにアクセスできます。待つ必要はありません。

モデレーションリクエストの作成

キーを取得したら、「/v1/moderations」エンドポイントにPOSTリクエストを送信するだけです。必要なのは、「input」(チェックしたいテキストまたは画像のURL)と、使用したい「model」の2つだけです。

curl https://api.openai.com/v1/moderations \

-X POST \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"input": "I want to kill them.",

"model": "omni-moderation-latest"

}'

APIは結果を含むJSONオブジェクトを返します。簡単なチェックであれば、「flagged」フィールドを見て「true」か「false」かを確認するだけです。

graph TD A[ユーザーがコンテンツを送信] --> B{OpenAI Moderation APIを呼び出し}; B --> C{コンテンツにフラグが立ったか?}; C -- Yes --> D[カスタムワークフローロジック]; D --> E[ユーザーをブロック]; D --> F[人間へエスカレーション]; D --> G[警告を送信]; C -- No --> H[コンテンツを承認];

subgraph Challenges direction LR I((レイテンシ)) J((カスタムルール)) K((エンジニアリングのオーバーヘッド)) end D --> I; D --> J; D --> K;

完全なモデレーションワークフロー構築の課題

API呼び出しは簡単です。難しいのはその次です。OpenAI Moderation APIは、コンテンツが有害であるかどうかを教えてくれますが、それに対して何をすべきかは教えてくれません。これにより、あなたのチームはいくつかのハードルを乗り越える必要があります。

ワークフローロジックを構築する必要がある。 コンテンツにフラグが立てられたときに何が起こるかを決定するすべてのコードを記述する必要があります。ユーザーをブロックすべきか? チケットを人間のエージェントにエスカレーションすべきか? 自動警告を送信すべきか? これらのアクションはすべて、カスタムで構築する必要があります。

レイテンシが問題になる可能性がある。 すべてのメッセージに対して別のAPIを呼び出すと、アプリケーションが遅くなる可能性があります。ユーザーエクスペリエンスを軽快に保つためには、モデレーションチェックをバックグラウンドで実行する非同期システムを構築する必要があるかもしれず、これがさらに複雑さを増します。

カスタムルールはあなた次第。 APIのカテゴリは固定されています。独自のブランドガイドライン(政治的な話題、返金要求、競合他社の言及などを避けるなど)に基づいてコンテンツをフィルタリングする必要がある場合、まったく別のシステムを構築する必要があります。これは通常、別のLLM呼び出しを意味し、さらなるコストとエンジニアリングのオーバーヘッドを追加します。

OpenAI Moderation APIの価格

これは簡単な部分です。OpenAI Moderation APIの最も優れた点の一つは、その価格です。無料です。OpenAIの公式価格ページによると、「omni-moderation」モデルの使用には費用がかかりません。

これにより、小規模なスタートアップから大企業まで、あらゆる規模のプロジェクトにとって当然の選択肢となります。コミュニティフォーラムの一部の意見では、他の有料OpenAI APIと併用することを意図していると考えられていますが、これはOpenAIエコシステムで開発しているほとんどすべての人をカバーしています。

OpenAI Moderation APIを超えて:統合されたモデレーションと自動化ワークフロー

無料のAPIは素晴らしい出発点ですが、実際のカスタマーサポート業務を運営している場合、コンテンツにフラグを立てるだけでは不十分です。そのフラグを即座のスマートなアクションに結びつけるシステムが必要です。ここで、専用のAIサポートプラットフォームが真価を発揮します。

検出から解決までを数分で

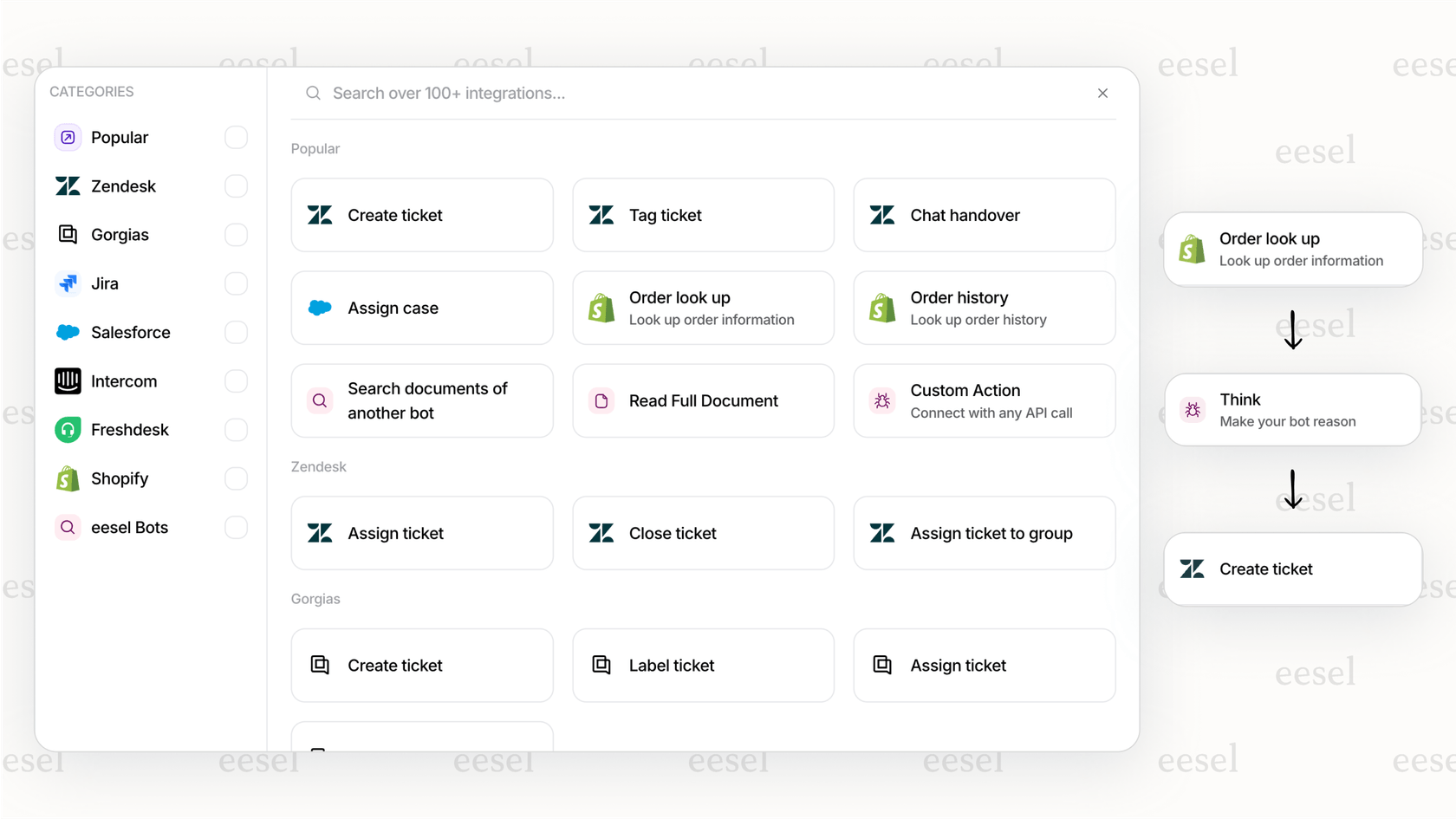

DIYアプローチでは、ワークフローのすべてのステップを自分でコーディングする必要があります。eesel AIのようなプラットフォームは、事前に構築されたロジックと、ZendeskやFreshdeskなど、すでに使用しているツールへのワンクリックヘルプデスク連携で、ゲームを変えます。

問題を単に特定するだけでなく、即座に行動できます。例えば、eesel AIエージェントがモデレーションフラグを検出し、自身の返信を即座に停止し、「緊急レビュー」タグを付けてチケットを自動的に人間にエスカレーションするように設定できます。このワークフロー全体を、一行のコードも書かずに数分で構築できます。

コンテンツの安全性とカスタムビジネスルールを組み合わせる

OpenAI Moderation APIの固定カテゴリは、ブランド固有のルールに対応できません。統合プラットフォームは、完全にカスタマイズ可能なワークフローエンジンを提供することで、この問題を解決します。eesel AIのプロンプトエディタを使用すると、AIの個性を定義し、標準的なセーフティネットをはるかに超えるカスタムモデレーションルールを重ねることができます。

例えば、eコマースブランドは、標準のモデレーションAPIを使用して有害なコンテンツをブロックしつつ、eesel AIのカスタム指示を使用して、AIが配送時間について約束したり、競合他社について話したりするのを防ぐことができます。

自信を持ってワークフローをシミュレートし、デプロイする

自分で構築したモデレーションシステムを導入するのは、賭けのように感じられることがあります。閾値が厳しすぎて誤検知を招いていないか? それとも緩すぎて不適切なコンテンツがすり抜けていないか?

eesel AIは、強力なシミュレーションモードでその当て推量を排除します。本番稼働する前に、自動化とモデレーションのセットアップ全体を、過去の何千ものサポートチケットに対して実行できます。これにより、AIが実際の現場でどのように振る舞うかを明確に把握できるため、ルールを微調整し、期待どおりに機能することを確認してデプロイできます。

OpenAI Moderation APIに関する最終的な考察

OpenAI Moderation APIは素晴らしいツールです。無料で強力、そして構築中のあらゆるアプリケーションにコンテンツの安全性のベースラインを追加する優れた方法です。新しいマルチモーダルモデルにより、これまで以上に有用になり、開発者のツールキットにぜひ加えるべきです。

しかし、コンテンツにフラグを立てることは最初のステップにすぎません。本当の作業は、そのフラグをスムーズで信頼性が高く、カスタマイズされたビジネスプロセスに変えることです。これらのワークフローをゼロから構築するには、多くのエンジニアリング時間、継続的なメンテナンス、そして慎重なテストが必要な大変な作業です。

手抜きをせずに迅速に動く必要があるチームにとって、eesel AIのような統合プラットフォームは完全なパッケージを提供します。OpenAIのモデレーションの力と、ノーコードのワークフロービルダー、深い統合、そして堅実なテストツールをバンドルしています。これにより、単純な検出から完全な自動化まで、数ヶ月ではなく数分で移行できます。

eesel AIで、よりスマートで安全なサポートワークフローを構築する

安全なだけでなく、スマートで効率的なサポートシステムを構築する準備はできましたか? eesel AIを無料で試して、サポートワークフローを数分で自動化するのがいかに簡単かをご覧ください。

よくある質問

はい、OpenAIの公式価格設定によると、「omni-moderation」モデルは完全に無料で使用できます。これにより、OpenAI Moderation APIは、あらゆる規模のアプリケーションにコンテンツの安全性の基本レイヤーを追加するための非常にアクセスしやすいツールとなっています。

「omni-moderation-latest」モデルは、テキストと画像の両方で暴力、自傷行為、性的コンテンツを検出できます。ハラスメント、ヘイト、違法コンテンツなどの他のカテゴリは、現在テキスト入力のみでサポートされています。

OpenAI Moderation APIは有害なコンテンツを特定するのに優れていますが、主に問題をフラグ付けするだけで、ワークフローロジックは提供しません。応答やエスカレーションを自動化する完全なモデレーションシステムには、通常、追加のカスタムビルドソリューションや専用のAIサポートプラットフォームとの統合が必要です。

「omni-moderation-latest」モデルは精度の向上を誇り、多言語テストセットでは以前のバージョンと比較して42%の改善が見られます。また、その較正済みスコアは、さまざまな言語にわたるポリシー違反の信頼度をより信頼性の高い指標として提供します。

始めるには、OpenAIアカウントと組織設定からのAPIキーが必要です。キーを取得したら、コンテンツ入力と希望のモデルを付けて「/v1/moderations」エンドポイントにPOSTリクエストを送信できます。

OpenAI Moderation APIは、事前定義されたコンテンツカテゴリを提供します。ブランド固有のカスタムルール(例:競合他社の言及や特定の製品ポリシーのブロック)をネイティブにサポートしていません。そのような特注の要件には、eesel AIのようなカスタマイズ可能なワークフローエンジンを提供するプラットフォームとの統合が必要です。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.