Um guia prático para as melhores práticas de avaliação OpenAI para equipes de suporte

Stevia Putri

Katelin Teen

Last edited 14 novembro 2025

Expert Verified

Então, você trouxe um agente de suporte de IA para a equipe. É um grande passo. Mas como você sabe realmente se ele está ajudando seus clientes ou apenas criando mais dores de cabeça para os agentes humanos? Agir com base na sua "intuição" ou verificar algumas conversas aleatoriamente não será suficiente. Sem uma forma sólida de medir o desempenho, você está essencialmente voando às cegas. Você precisa de dados reais para ter confiança de que sua IA é precisa, útil e se mantém alinhada à marca.

Este guia está aqui para esclarecer a confusão em torno das Melhores Práticas de Avaliação da OpenAI. Vamos traduzir os conceitos complexos para desenvolvedores em uma estrutura que realmente faça sentido para líderes de negócios e de suporte. Abordaremos as ideias centrais da avaliação de IA e, em seguida, mostraremos uma maneira muito mais prática de testar e implantar a IA com confiança, diretamente do seu helpdesk.

O que são as melhores práticas de avaliação da OpenAI?

Vamos simplificar. "Avaliações" (ou "Evals") são apenas testes estruturados para ver o quão bem um modelo de IA está executando uma tarefa específica. Pense nisso como um boletim de notas para a sua IA, avaliando-a em quesitos como precisão, relevância e confiabilidade.

De acordo com a própria documentação da OpenAI, executar essas avaliações é essencial para melhorar qualquer aplicativo que use um modelo de linguagem grande (LLM). É assim que você impede que a IA envie respostas estranhas ou erradas aos clientes, mantém a qualidade consistente e acompanha se as coisas estão melhorando com o tempo, especialmente quando os modelos subjacentes são atualizados.

Mas a questão é a seguinte: frameworks como a API de Avaliações da OpenAI são construídos para desenvolvedores. Eles envolvem escrever código, formatar dados em arquivos especiais (como JSONL) e analisar os resultados com scripts. Para um líder de negócios, o objetivo não é aprender a programar. É passar de "Eu acho que está funcionando" para "Eu tenho os dados que provam que nossa IA está atingindo nossas metas e mantendo os clientes satisfeitos."

O processo central de avaliação

Se você observar as diretrizes de empresas como a OpenAI e a Microsoft, um bom processo de avaliação geralmente tem quatro etapas principais. Seguir este ciclo ajuda a garantir que seus testes sejam realmente úteis e levem a melhorias reais.

Recurso 1: [Fluxo de trabalho], um gráfico mermaid ilustrando o ciclo de quatro etapas das melhores práticas de avaliação da OpenAI.

graph TD A[1. Defina o Objetivo] --> B[2. Colete os Dados]; B --> C[3. Escolha as Métricas]; C --> D[4. Teste e Itere]; D --> A;

1. Defina seu objetivo

Primeiro, você precisa decidir o que significa "sucesso" para uma tarefa específica. E você precisa ser específico. "Responder bem às perguntas" é muito vago. Um objetivo melhor seria: "A IA deve explicar com precisão nossa política de devolução de 30 dias, referenciando o artigo oficial da central de ajuda." Agora sim, isso é algo que você pode realmente medir.

2. Colete seus dados

Para testar sua IA, você precisa de um conjunto de dados de "verdade fundamental" (ground truth). Este é apenas um termo técnico para uma coleção de perguntas combinadas com respostas perfeitas e aprovadas por especialistas. Esses dados devem se assemelhar às perguntas reais que seus clientes fazem, cobrindo os tópicos comuns, os casos mais específicos e tudo o que estiver no meio.

3. Escolha suas métricas

Como você vai pontuar as respostas da IA? Pode ser um simples aprovado/reprovado sobre se a informação está correta, uma classificação de quão bem ela corresponde ao tom de voz da sua marca, ou verificar se ela fez algo específico, como etiquetar um ticket corretamente. O que quer que você escolha, deve estar diretamente ligado ao objetivo que você definiu na primeira etapa.

4. Teste, verifique e repita

A última etapa é executar seus testes, analisar os resultados e usar o que você aprendeu para ajustar sua IA. Talvez você precise ajustar um prompt, direcioná-la para uma fonte de conhecimento melhor ou alterar uma regra de fluxo de trabalho. A avaliação não é algo que você faz uma vez; é um ciclo de testes e melhorias que mantém sua IA com o melhor desempenho.

Estratégias e métricas de avaliação chave

Existem algumas maneiras diferentes de avaliar o desempenho de uma IA, e cada uma tem suas vantagens e desvantagens. Conhecer as opções ajuda você a escolher a ferramenta certa para o trabalho.

Avaliação humana

Este é o padrão ouro para qualidade. Você tem um especialista humano que lê a resposta da IA e a avalia com base em um conjunto de critérios. É fantástico para julgar aspectos sutis como empatia ou tom, mas também é incrivelmente lento, caro e difícil de escalar. Para o uso diário, simplesmente não é prático.

Avaliação tradicional baseada em métricas (ROUGE/BLEU)

São sistemas automatizados que pontuam a resposta de uma IA comparando seu texto com uma resposta de referência "perfeita". Eles basicamente contam quantas palavras e frases se sobrepõem.

O problema: Como muitos na indústria apontam, essas métricas não são ótimas para entender o significado. Uma IA pode dar uma resposta perfeitamente correta usando palavras diferentes, mas um teste ROUGE ou BLEU a reprovaria. Essa rigidez as torna menos úteis para avaliar IA conversacional.

LLM-como-juiz

Esta é uma abordagem mais recente em que você usa um modelo de IA poderoso (como o GPT-4) para atuar como um "juiz" e avaliar o resultado da sua IA de suporte. É mais rápido e mais barato do que usar pessoas, e entende o contexto muito melhor do que ferramentas simples de correspondência de texto.

O problema: Este método pode ter seus próprios vieses (por exemplo, às vezes prefere respostas mais longas sem um bom motivo) e ainda precisa de uma configuração cuidadosa para funcionar bem. É uma melhoria definitiva, mas não é uma solução mágica e muitas vezes ainda precisa de um olhar técnico.

| Método de Avaliação | Velocidade | Custo | Escalabilidade | Sutileza |

|---|---|---|---|---|

| Avaliação Humana | Lenta | Alto | Baixa | Alta |

| Baseada em Métricas (ROUGE) | Rápida | Baixo | Alta | Baixa |

| LLM-como-Juiz | Rápida | Médio | Alta | Média |

Limitações práticas da avaliação OpenAI focada em desenvolvedores

Embora a teoria por trás das Melhores Práticas de Avaliação da OpenAI seja sólida, as ferramentas em si muitas vezes não são adequadas para uma equipe de suporte ocupada. É aqui que a abordagem teórica tende a falhar no mundo real.

Requer conhecimento de desenvolvedor

Para executar avaliações com os frameworks padrão, você precisa estar confortável com APIs, ferramentas de linha de comando e formatação de dados em JSONL. Isso simplesmente não é realista para a maioria dos líderes de suporte, que precisam de ferramentas que possam gerenciar sozinhos, sem precisar abrir um ticket com a equipe de engenharia e esperar.

O processo é lento e desconectado

O fluxo de trabalho típico envolve extrair dados do seu helpdesk, executar testes em um local completamente separado e, em seguida, tentar entender os resultados. É desajeitado e não fornece feedback onde você realmente trabalha: dentro do seu helpdesk. Isso cria uma lacuna entre os testes e a execução real das suas operações de suporte.

Os conjuntos de dados de teste são muitas vezes muito pequenos ou genéricos

Construir um bom conjunto de dados de teste é difícil. Muitas equipes acabam testando com base em um punhado de exemplos que elas mesmas escreveram ou usando benchmarks genéricos da indústria. Nenhuma das opções captura realmente a variedade única e muitas vezes confusa de suas conversas reais com clientes, o que pode lhe dar uma falsa sensação de segurança.

Uma abordagem melhor: avaliação focada em negócios com a eesel AI

Em vez de fazer você aprender um kit de ferramentas de desenvolvedor, algumas plataformas integram a avaliação diretamente em um fluxo de trabalho simples que qualquer pessoa pode usar. A eesel AI foi projetada desde o início para resolver esses problemas práticos para as equipes de suporte.

Comece em minutos: Avaliação sem código

Esqueça as configurações complicadas. A eesel AI é uma plataforma verdadeiramente de autoatendimento com integrações de helpdesk de um clique. Você pode conectar seu conhecimento de lugares como Zendesk ou Confluence e começar a avaliar o potencial da sua IA sem escrever uma única linha de código ou assistir a uma demonstração de vendas.

Teste com confiança: Use tickets passados para avaliação

É aqui que fica realmente poderoso. O modo de simulação da eesel AI pode executar sua configuração de IA em milhares de seus tickets reais e históricos. Isso lhe dá uma previsão precisa e baseada em dados de como sua IA teria se saído em problemas reais dos clientes. Chega de adivinhações e chega de construir conjuntos de dados de teste manualmente.

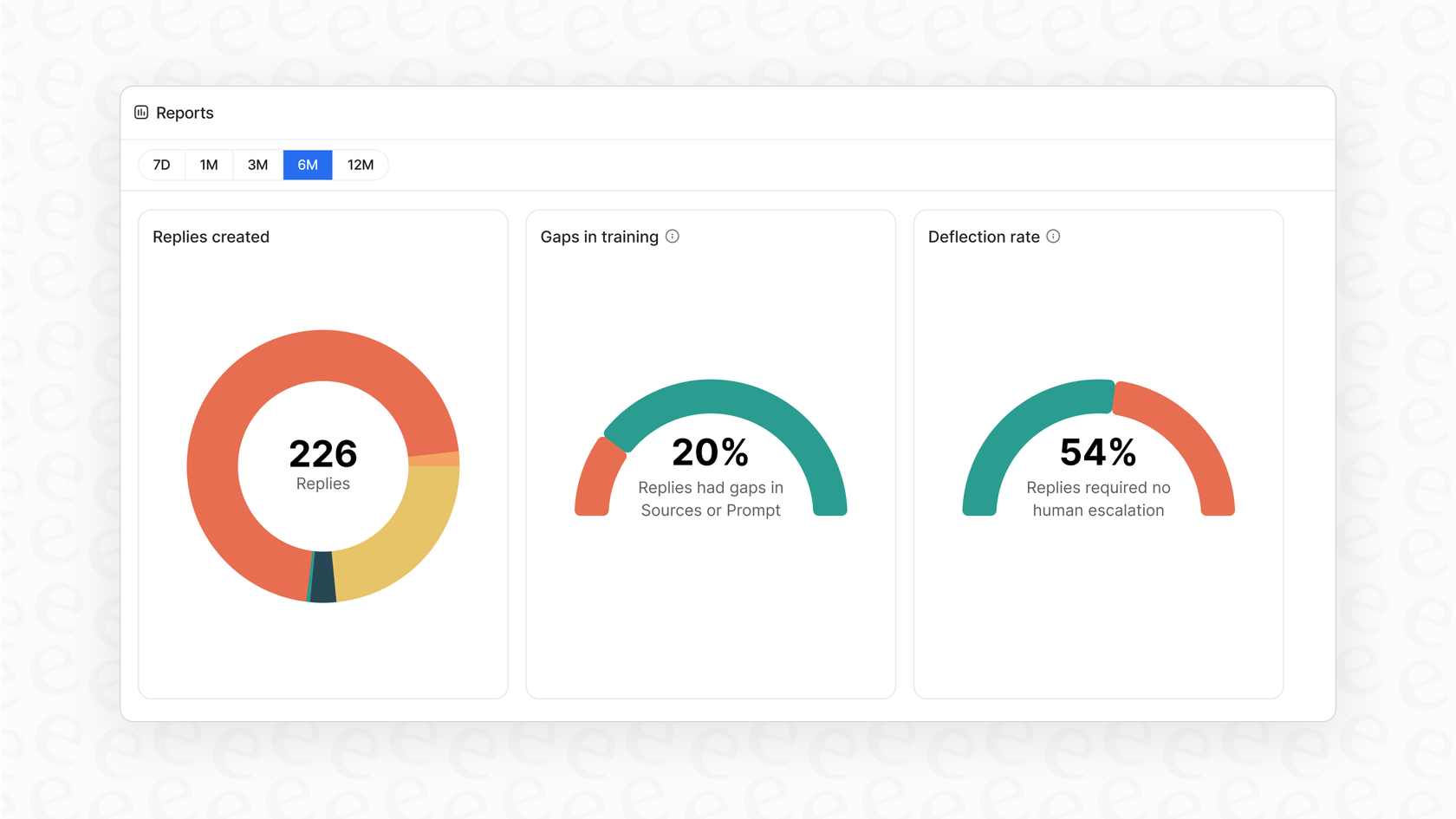

Obtenha próximos passos claros, não apenas uma pontuação

Os relatórios acionáveis da eesel AI fazem mais do que dar uma nota de aprovado/reprovado. Eles analisam a simulação para mostrar quais tópicos são ideais para automação. Melhor ainda, eles apontam as lacunas em sua base de conhecimento, fornecendo uma lista clara de tarefas sobre quais artigos de ajuda escrever a seguir, tudo baseado em perguntas reais dos clientes.

Implemente de forma gradual e segura

Com a eesel AI, você pode lançar sem riscos. Após executar uma simulação, você pode optar por automatizar apenas uma pequena fatia dos tickets, como apenas as consultas sobre "status do pedido". Você pode observar o desempenho em tempo real e expandir o escopo à medida que se sentir mais confortável. Esse tipo de controle cuidadoso proporciona uma implementação suave e segura que você simplesmente não consegue com plataformas que exigem uma abordagem de tudo ou nada.

Pare de adivinhar, comece a medir

Colocar a IA para trabalhar no suporte ao cliente não é mais uma questão de se, mas de como. Uma grande parte do "como" é ter uma maneira confiável de avaliá-la. Embora os conceitos por trás das Melhores Práticas de Avaliação da OpenAI nos apontem na direção certa, as ferramentas padrão são muitas vezes muito técnicas e desconectadas para as equipes de negócios.

A plataforma certa torna a avaliação sofisticada uma parte simples e integrada de suas operações. Ao incorporar simulação e relatórios diretamente em um fluxo de trabalho de autoatendimento, a eesel AI permite que você teste com seus próprios dados e implante com confiança. Você pode finalmente parar de esperar que sua IA funcione e começar a provar que ela funciona.

Perguntas frequentes

As Melhores Práticas de Avaliação da OpenAI referem-se a testes estruturados usados para medir o desempenho de um modelo de IA em tarefas específicas, como responder a perguntas de clientes. Elas são cruciais para garantir que seu agente de suporte de IA seja preciso, confiável e consistente, evitando experiências ruins para o cliente e construindo confiança.

Embora muitos frameworks sejam focados em desenvolvedores, plataformas como a eesel AI oferecem soluções sem código. Essas ferramentas se integram diretamente ao seu helpdesk, permitindo que você simule o desempenho da IA em tickets históricos e obtenha insights acionáveis sem conhecimento técnico.

As Melhores Práticas de Avaliação da OpenAI padrão geralmente exigem habilidades de programação, envolvem fluxos de trabalho lentos e desconectados e dependem de conjuntos de dados de teste potencialmente pequenos ou genéricos. Essas limitações as tornam desafiadoras para equipes de suporte ocupadas sem recursos de desenvolvimento dedicados.

Para aplicar as Melhores Práticas de Avaliação da OpenAI, você precisa de um conjunto de dados de "verdade fundamental" (ground truth). Ele consiste em perguntas reais de clientes combinadas com respostas perfeitas e aprovadas por especialistas, refletindo as diversas dúvidas que seus clientes costumam ter.

Sim, a avaliação humana é o padrão ouro dentro das Melhores Práticas de Avaliação da OpenAI para julgamentos sutis como tom ou empatia. No entanto, é lenta, cara e difícil de escalar para testes contínuos e de grande volume.

O LLM-como-Juiz é um método contemporâneo dentro das Melhores Práticas de Avaliação da OpenAI em que uma IA poderosa avalia o resultado da sua IA de suporte. É mais rápido e entende o contexto melhor do que as métricas tradicionais, embora possa ter vieses e exija uma configuração cuidadosa.

Compartilhe esta postagem

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.