Una guía práctica sobre las mejores prácticas de evaluación de OpenAI para equipos de soporte

Stevia Putri

Stanley Nicholas

Last edited 14 noviembre 2025

Expert Verified

Así que has incorporado un agente de soporte con IA a tu equipo. Es un gran paso. Pero, ¿cómo sabes realmente si está ayudando a tus clientes o simplemente creando más quebraderos de cabeza para los agentes humanos? Dejarte llevar por tu "intuición" o revisar unas cuantas conversaciones al azar no es suficiente. Sin una forma sólida de medir el rendimiento, estás volando a ciegas. Necesitas datos reales para tener la certeza de que tu IA es precisa, útil y se mantiene fiel a la marca.

Esta guía está aquí para aclarar la confusión en torno a las Mejores Prácticas de Evaluación de OpenAI. Traduciremos los conceptos más técnicos para desarrolladores a un marco que realmente tenga sentido para los líderes de negocio y soporte. Repasaremos las ideas centrales de la evaluación de IA y luego te mostraremos una forma mucho más práctica de probar e implementar la IA con confianza, directamente desde tu helpdesk.

¿Qué son las mejores prácticas de evaluación de OpenAI?

Vamos a desglosarlo. Las "evaluaciones" (o "evals") son simplemente pruebas estructuradas para ver qué tan bien está haciendo un modelo de IA un trabajo específico. Piensa en ello como un boletín de notas para tu IA, calificándola en aspectos como la precisión, la relevancia y la fiabilidad.

Según la propia documentación de OpenAI, realizar estas evaluaciones es esencial para mejorar cualquier aplicación que utilice un modelo de lenguaje grande (LLM). Es la forma de evitar que la IA envíe respuestas extrañas o incorrectas a los clientes, mantener una calidad constante y hacer un seguimiento de si las cosas mejoran con el tiempo, especialmente cuando se actualizan los modelos subyacentes.

Pero aquí está el detalle: los marcos como la API de Evaluaciones de OpenAI están diseñados para desarrolladores. Implican escribir código, formatear datos en archivos especiales (como JSONL) y analizar los resultados con scripts. Para un líder de negocio, el objetivo no es aprender a programar. Es pasar de "creo que está funcionando" a "tengo los datos que demuestran que nuestra IA está alcanzando nuestros objetivos y manteniendo a los clientes satisfechos".

El proceso de evaluación central

Si observas las directrices de gente como OpenAI y Microsoft, un buen proceso de evaluación suele tener cuatro pasos principales. Seguir este ciclo ayuda a asegurar que tus pruebas sean realmente útiles y conduzcan a mejoras reales.

graph TD A[1. Definir el objetivo] --> B[2. Recopilar datos]; B --> C[3. Elegir métricas]; C --> D[4. Probar e iterar]; D --> A;

1. Define tu objetivo

Primero, necesitas decidir qué significa el "éxito" para una tarea específica. Y tienes que ser específico. "Responde bien a las preguntas" es demasiado vago. Un objetivo mejor sería: "La IA debe explicar con precisión nuestra política de devoluciones de 30 días haciendo referencia al artículo oficial del centro de ayuda". Eso sí es algo que puedes medir.

2. Recopila tus datos

Para probar tu IA, necesitas un conjunto de datos de "verdad fundamental" (ground truth). Este es solo un término elegante para una colección de preguntas emparejadas con respuestas perfectas y aprobadas por expertos. Estos datos deben parecerse a las preguntas reales que hacen tus clientes, cubriendo los temas comunes, los casos atípicos y todo lo demás.

3. Elige tus métricas

¿Cómo vas a calificar las respuestas de la IA? Podría ser un simple aprobado/suspenso sobre si la información es correcta, una calificación de qué tan bien se ajusta al tono de voz de tu marca, o verificar si hizo algo específico, como etiquetar un ticket correctamente. Lo que elijas debe estar directamente relacionado con el objetivo que estableciste en el primer paso.

4. Prueba, verifica y repite

El último paso es ejecutar tus pruebas, analizar los resultados y usar lo que aprendes para ajustar tu IA. Quizás necesites modificar un prompt, dirigirla a una mejor fuente de conocimiento o cambiar una regla de flujo de trabajo. La evaluación no es algo que se hace una sola vez; es un ciclo de pruebas y mejoras que mantiene a tu IA funcionando a su máximo nivel.

Estrategias y métricas clave de evaluación

Hay varias formas diferentes de calificar el rendimiento de una IA, y cada una tiene sus ventajas y desventajas. Conocer las opciones te ayuda a elegir la herramienta adecuada para el trabajo.

Evaluación humana

Este es el estándar de oro en cuanto a calidad. Un experto humano lee la respuesta de la IA y la califica según un conjunto de criterios. Es fantástico para juzgar aspectos sutiles como la empatía o el tono, pero también es increíblemente lento, costoso y difícil de escalar. Para el uso diario, simplemente no es práctico.

Evaluación tradicional basada en métricas (ROUGE/BLEU)

Estos son sistemas automatizados que califican la respuesta de una IA comparando su texto con una respuesta de referencia "perfecta". Básicamente, cuentan cuántas palabras y frases coinciden.

El problema: Como muchos en la industria señalan, estas métricas no son muy buenas para entender el significado. Una IA podría dar una respuesta perfectamente correcta usando palabras diferentes, pero una prueba de ROUGE o BLEU la calificaría como incorrecta. Esa rigidez las hace menos útiles para juzgar la IA conversacional.

LLM-como-juez

Este es un enfoque más nuevo en el que utilizas un modelo de IA potente (como GPT-4) para que actúe como un "juez" y califique el resultado de tu IA de soporte. Es más rápido y económico que usar personas, y entiende el contexto mucho mejor que las simples herramientas de comparación de texto.

El problema: Este método puede tener sus propios sesgos (por ejemplo, a veces prefiere respuestas más largas sin una buena razón) y aún necesita una configuración cuidadosa para funcionar bien. Es una mejora definitiva, pero no es una solución mágica y a menudo todavía necesita la supervisión de un experto técnico.

| Método de evaluación | Velocidad | Costo | Escalabilidad | Matices |

|---|---|---|---|---|

| Evaluación humana | Lenta | Alto | Baja | Alta |

| Basada en métricas (ROUGE) | Rápida | Bajo | Alta | Baja |

| LLM-como-juez | Rápida | Medio | Alta | Media |

Limitaciones prácticas de la evaluación de OpenAI centrada en desarrolladores

Aunque la teoría detrás de las Mejores Prácticas de Evaluación de OpenAI es sólida, las herramientas en sí mismas a menudo no son adecuadas para un equipo de soporte ocupado. Aquí es donde el enfoque teórico tiende a fallar en el mundo real.

Requiere experiencia de desarrollador

Para realizar evaluaciones con los marcos estándar, debes sentirte cómodo con las API, las herramientas de línea de comandos y el formateo de datos en JSONL. Esto simplemente no es realista para la mayoría de los líderes de soporte, que necesitan herramientas que puedan gestionar por sí mismos sin tener que abrir un ticket con el equipo de ingeniería y esperar.

El proceso es lento y está desconectado

El flujo de trabajo típico implica extraer datos de tu helpdesk, ejecutar pruebas en un lugar completamente diferente y luego tratar de dar sentido a los resultados. Es engorroso y no te proporciona retroalimentación donde realmente trabajas: dentro de tu helpdesk. Esto crea una brecha entre las pruebas y la gestión real de tus operaciones de soporte.

Los conjuntos de datos de prueba suelen ser demasiado pequeños o genéricos

Crear un buen conjunto de datos de prueba es difícil. Muchos equipos terminan probando con un puñado de ejemplos que ellos mismos escribieron o usando benchmarks genéricos de la industria. Ninguno de los dos captura realmente la variedad única, y a menudo desordenada, de tus conversaciones reales con los clientes, lo que puede darte una falsa sensación de seguridad.

Un mejor enfoque: evaluación centrada en el negocio con eesel AI

En lugar de hacerte aprender un conjunto de herramientas de desarrollador, algunas plataformas integran la evaluación directamente en un flujo de trabajo simple que cualquiera puede usar. eesel AI fue diseñado desde cero para resolver estos problemas prácticos para los equipos de soporte.

Empieza en minutos: evaluación sin código

Olvídate de las configuraciones complicadas. eesel AI es una plataforma verdaderamente autoservicio con integraciones de helpdesk en un solo clic. Puedes conectar tu conocimiento desde lugares como Zendesk o Confluence y comenzar a evaluar el potencial de tu IA sin escribir una sola línea de código ni pasar por una demostración de ventas.

Prueba con confianza: utiliza tickets anteriores para la evaluación

Aquí es donde se vuelve realmente poderoso. El modo de simulación de eesel AI puede ejecutar tu configuración de IA en miles de tus tickets históricos reales. Esto te proporciona un pronóstico preciso y respaldado por datos de cómo habría funcionado tu IA en problemas reales de los clientes. Se acabaron las conjeturas y la creación manual de conjuntos de datos de prueba.

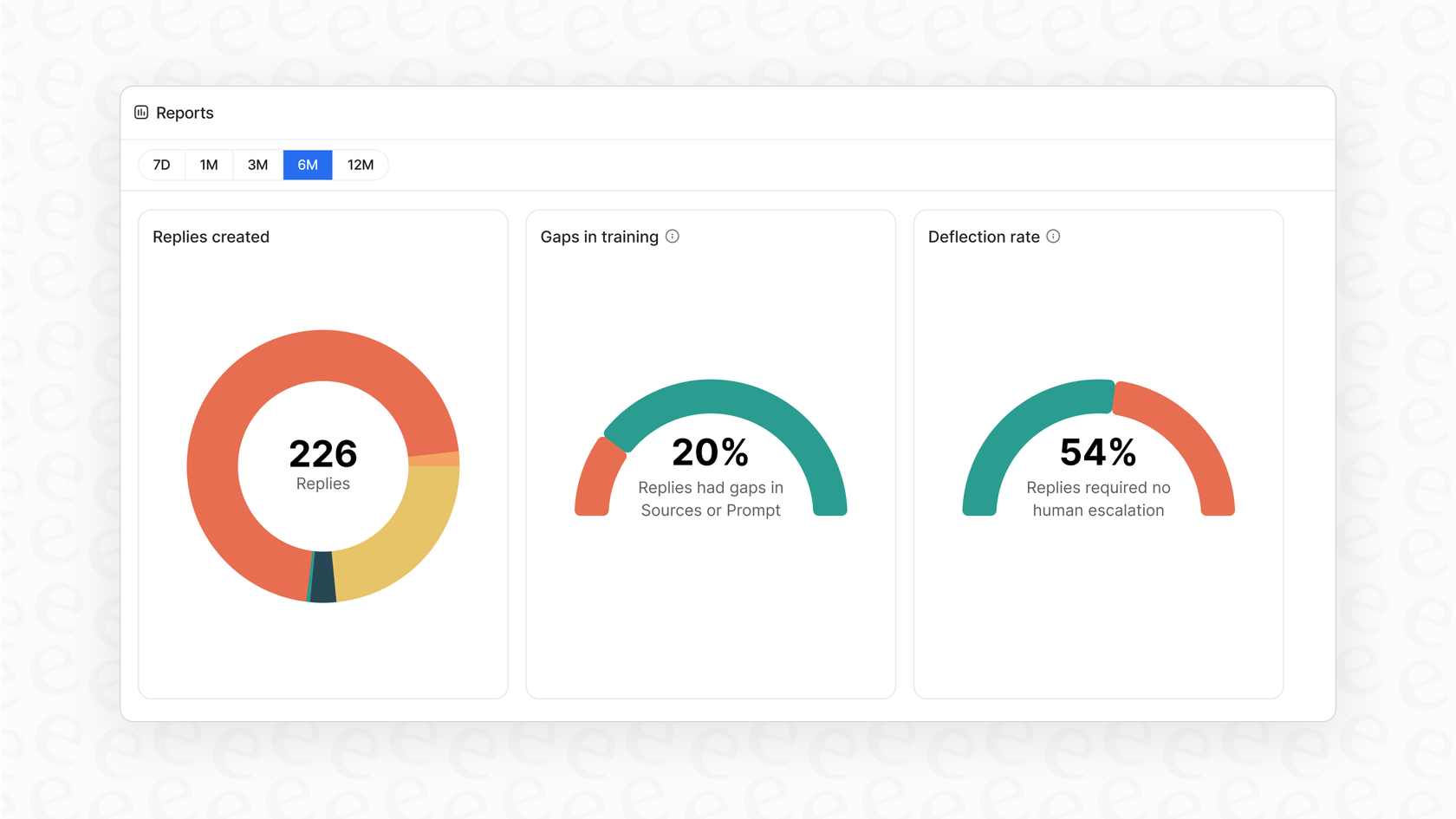

Obtén pasos claros a seguir, no solo una puntuación

Los informes accionables de eesel AI hacen más que darte una calificación de aprobado/suspenso. Analizan la simulación para mostrarte qué temas son ideales para la automatización. Aún mejor, señalan las lagunas en tu base de conocimientos, dándote una lista clara de tareas sobre qué artículos de ayuda escribir a continuación, todo basado en preguntas reales de los clientes.

Despliega de forma gradual y segura

Con eesel AI, puedes lanzar sin riesgos. Después de ejecutar una simulación, puedes optar por automatizar solo una pequeña parte de los tickets, como únicamente las consultas sobre el "estado del pedido". Puedes observar su rendimiento en tiempo real y ampliar el alcance a medida que te sientas más cómodo. Este tipo de control cuidadoso te brinda un despliegue suave y seguro que simplemente no puedes obtener con plataformas que exigen un enfoque de todo o nada.

Deja de adivinar, empieza a medir

Poner la IA a trabajar en el soporte al cliente ya no es una cuestión de si se hará, sino de cómo. Una gran parte del "cómo" es tener una forma fiable de evaluarla. Si bien los conceptos detrás de las Mejores Prácticas de Evaluación de OpenAI nos señalan la dirección correcta, las herramientas estándar a menudo son demasiado técnicas y están desconectadas para los equipos de negocio.

La plataforma adecuada hace que la evaluación sofisticada sea una parte simple e integrada de tus operaciones. Al incorporar la simulación y los informes directamente en un flujo de trabajo de autoservicio, eesel AI te permite probar con tus propios datos y desplegar con confianza. Finalmente puedes dejar de esperar que tu IA funcione y empezar a demostrarlo.

Preguntas frecuentes

Las Mejores Prácticas de Evaluación de OpenAI se refieren a pruebas estructuradas utilizadas para medir el rendimiento de un modelo de IA en tareas específicas, como responder a las preguntas de los clientes. Son cruciales para garantizar que tu agente de soporte de IA sea preciso, fiable y consistente, evitando malas experiencias para los clientes y generando confianza.

Aunque muchos marcos están enfocados en desarrolladores, plataformas como eesel AI ofrecen soluciones sin código. Estas herramientas se integran directamente con tu helpdesk, permitiéndote simular el rendimiento de la IA en tickets históricos y obtener información procesable sin necesidad de experiencia técnica.

Las Mejores Prácticas de Evaluación de OpenAI estándar a menudo requieren habilidades de programación, implican flujos de trabajo lentos y desconectados, y dependen de conjuntos de datos de prueba potencialmente pequeños o genéricos. Estas limitaciones las convierten en un desafío para los equipos de soporte ocupados que no cuentan con recursos de desarrollo dedicados.

Para aplicar las Mejores Prácticas de Evaluación de OpenAI, necesitas un conjunto de datos de "verdad fundamental" (ground truth). Este consiste en preguntas reales de clientes emparejadas con respuestas perfectas y aprobadas por expertos, que reflejen la diversidad de consultas que tus clientes suelen hacer.

Sí, la evaluación humana es el estándar de oro dentro de las Mejores Prácticas de Evaluación de OpenAI para juicios matizados como el tono o la empatía. Sin embargo, es lenta, costosa y difícil de escalar para pruebas continuas y de gran volumen.

El "LLM-como-juez" es un método contemporáneo dentro de las Mejores Prácticas de Evaluación de OpenAI donde una IA potente califica el resultado de tu IA de soporte. Es más rápido y entiende el contexto mejor que las métricas tradicionales, aunque puede tener sesgos y requiere una configuración cuidadosa.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.