Un guide pratique des meilleures pratiques d'évaluation d'OpenAI pour les équipes de support

Stevia Putri

Katelin Teen

Last edited 14 novembre 2025

Expert Verified

Alors, vous avez intégré un agent de support IA à votre équipe. C'est une étape importante. Mais comment savoir vraiment si elle aide vos clients ou si elle ne fait que créer plus de maux de tête pour vos agents humains ? Se fier à son intuition ou vérifier quelques conversations au hasard ne suffira pas. Sans une méthode solide pour mesurer la performance, vous naviguez essentiellement à l'aveugle. Vous avez besoin de données réelles pour être sûr que votre IA est précise, utile et qu'elle respecte l'image de votre marque.

Ce guide est là pour dissiper la confusion autour des meilleures pratiques d'évaluation d'OpenAI. Nous allons traduire les concepts très techniques pour les développeurs en un cadre qui a réellement du sens pour les chefs d'entreprise et les responsables du support. Nous passerons en revue les idées fondamentales de l'évaluation de l'IA, puis nous vous montrerons une manière beaucoup plus pratique de tester et de déployer l'IA en toute confiance, directement depuis votre service d'assistance.

Que sont les meilleures pratiques d'évaluation d'OpenAI ?

Décortiquons tout ça. Les « évals » sont simplement des tests structurés pour voir à quel point un modèle d'IA s'acquitte d'une tâche spécifique. Considérez cela comme un bulletin de notes pour votre IA, l'évaluant sur des critères comme la précision, la pertinence et la fiabilité.

Selon la propre documentation d'OpenAI, effectuer ces évaluations est essentiel pour améliorer toute application qui utilise un grand modèle de langage (LLM). C'est ainsi que vous empêchez l'IA d'envoyer des réponses étranges ou incorrectes aux clients, que vous maintenez une qualité constante et que vous suivez les améliorations au fil du temps, surtout lorsque les modèles sous-jacents sont mis à jour.

Mais voici le problème : les cadres comme l'API Evals d'OpenAI sont conçus pour les développeurs. Ils impliquent d'écrire du code, de formater des données dans des fichiers spéciaux (comme JSONL) et d'analyser les résultats avec des scripts. Pour un dirigeant d'entreprise, l'objectif n'est pas d'apprendre à coder. Il s'agit de passer de « Je pense que ça marche » à « J'ai les données qui prouvent que notre IA atteint nos objectifs et satisfait nos clients. »

Le processus d'évaluation de base

Si vous consultez les directives de sociétés comme OpenAI et Microsoft, un bon processus d'évaluation comporte généralement quatre étapes principales. Suivre ce cycle permet de s'assurer que vos tests sont réellement utiles et qu'ils mènent à de véritables améliorations.

graph TD A[1. Définir l'objectif] --> B[2. Collecter les données]; B --> C[3. Choisir les métriques]; C --> D[4. Tester & Itérer]; D --> A;

1. Définissez votre objectif

D'abord, vous devez décider à quoi ressemble le « succès » pour une tâche spécifique. Et vous devez être précis. « répond bien aux questions » est trop vague. Un meilleur objectif serait : « L'IA doit expliquer avec précision notre politique de retour de 30 jours en se référant à l'article officiel du centre d'aide. » Ça, c'est quelque chose que vous pouvez réellement mesurer.

2. Collectez vos données

Pour tester votre IA, vous avez besoin d'un ensemble de données de « vérité terrain ». C'est juste un terme sophistiqué pour une collection de questions associées à des réponses parfaites et approuvées par des experts. Ces données doivent ressembler aux vraies questions que vos clients posent, couvrant les cas courants, les cas limites étranges et tout ce qui se trouve entre les deux.

3. Choisissez vos métriques

Comment allez-vous noter les réponses de l'IA ? Il pourrait s'agir d'un simple succès/échec sur la base de l'exactitude des informations, d'une note sur sa correspondance avec le ton de votre marque, ou de vérifier si elle a fait quelque chose de spécifique, comme étiqueter un ticket correctement. Quoi que vous choisissiez, cela doit être directement lié à l'objectif que vous avez défini à la première étape.

4. Testez, vérifiez et répétez

La dernière étape consiste à exécuter vos tests, à examiner les résultats et à utiliser ce que vous apprenez pour peaufiner votre IA. Peut-être devez-vous ajuster une invite, la diriger vers une meilleure source de connaissances ou modifier une règle de flux de travail. L'évaluation n'est pas quelque chose que l'on fait une seule fois ; c'est une boucle de tests et d'améliorations qui maintient les performances de votre IA à leur meilleur niveau.

Stratégies et métriques d'évaluation clés

Il existe différentes manières de noter la performance d'une IA, et chacune a ses avantages et ses inconvénients. Connaître les options vous aide à choisir le bon outil pour la tâche.

Évaluation humaine

C'est la référence absolue en matière de qualité. Un expert humain lit la réponse de l'IA et la note par rapport à un ensemble de critères. C'est fantastique pour juger des aspects nuancés comme l'empathie ou le ton, mais c'est aussi incroyablement lent, coûteux et difficile à mettre à l'échelle. Pour une utilisation quotidienne, ce n'est tout simplement pas pratique.

Évaluation traditionnelle basée sur des métriques (ROUGE/BLEU)

Ce sont des systèmes automatisés qui notent la réponse d'une IA en comparant son texte à une réponse de référence « parfaite ». Ils comptent essentiellement le nombre de mots et de phrases qui se chevauchent.

Le hic : Comme beaucoup dans le secteur le soulignent, ces métriques ne sont pas très douées pour comprendre le sens. Une IA peut donner une réponse parfaitement correcte en utilisant des mots différents, mais un test ROUGE ou BLEU la considérerait comme un échec. Cette rigidité les rend moins utiles pour juger l'IA conversationnelle.

LLM en tant que juge

C'est une nouvelle approche où vous utilisez un modèle d'IA puissant (comme GPT-4) pour agir comme un « juge » et noter les résultats de votre IA de support. C'est plus rapide et moins cher que de faire appel à des humains, et il comprend le contexte bien mieux que les simples outils de comparaison de texte.

Le hic : Cette méthode peut avoir ses propres biais (par exemple, elle préfère parfois les réponses plus longues sans bonne raison) et nécessite encore une configuration minutieuse pour bien fonctionner. C'est une nette amélioration, mais ce n'est pas une solution miracle et nécessite souvent encore un œil technique.

| Méthode d'évaluation | Vitesse | Coût | Scalabilité | Nuance |

|---|---|---|---|---|

| Évaluation humaine | Lente | Élevé | Faible | Élevée |

| Basée sur des métriques (ROUGE) | Rapide | Faible | Élevée | Faible |

| LLM en tant que juge | Rapide | Moyen | Élevée | Moyenne |

Limites pratiques de l'évaluation OpenAI axée sur les développeurs

Bien que la théorie derrière les meilleures pratiques d'évaluation d'OpenAI soit solide, les outils eux-mêmes sont souvent mal adaptés à une équipe de support très occupée. Voici où l'approche théorique a tendance à échouer dans le monde réel.

Nécessite une expertise de développeur

Pour effectuer des évaluations avec les cadres standard, vous devez être à l'aise avec les API, les outils en ligne de commande et le formatage des données en JSONL. Ce n'est tout simplement pas réaliste pour la plupart des responsables du support, qui ont besoin d'outils qu'ils peuvent gérer eux-mêmes sans créer un ticket auprès de l'équipe d'ingénierie et attendre.

Le processus est lent et déconnecté

Le flux de travail typique consiste à extraire les données de votre service d'assistance, à effectuer des tests dans un endroit complètement séparé, puis à essayer de donner un sens aux résultats. C'est laborieux et ne vous donne pas de retour là où vous travaillez réellement : à l'intérieur de votre service d'assistance. Cela crée un fossé entre les tests et la gestion réelle de vos opérations de support.

Les ensembles de données de test sont souvent trop petits ou génériques

Construire un bon ensemble de données de test est difficile. Beaucoup d'équipes finissent soit par tester sur une poignée d'exemples qu'elles ont écrits elles-mêmes, soit par utiliser des benchmarks génériques de l'industrie. Aucune de ces approches ne capture vraiment la variété unique, et souvent désordonnée, de vos vraies conversations avec les clients, ce qui peut vous donner un faux sentiment de sécurité.

Une meilleure approche : L'évaluation axée sur l'entreprise avec eesel AI

Au lieu de vous obliger à apprendre la boîte à outils d'un développeur, certaines plateformes intègrent l'évaluation directement dans un flux de travail simple que tout le monde peut utiliser. eesel AI a été conçu dès le départ pour résoudre ces problèmes pratiques pour les équipes de support.

Démarrez en quelques minutes : Évaluation sans code

Oubliez les configurations compliquées. eesel AI est une plateforme véritablement en libre-service avec des intégrations en un clic avec les services d'assistance. Vous pouvez connecter vos connaissances depuis des plateformes comme Zendesk ou Confluence et commencer à évaluer le potentiel de votre IA sans écrire une seule ligne de code ni assister à une démonstration de vente.

Testez en toute confiance : Utilisez les anciens tickets pour l'évaluation

C'est là que ça devient vraiment puissant. Le mode simulation d'eesel AI peut exécuter votre configuration d'IA sur des milliers de vos vrais tickets historiques. Cela vous donne une prévision précise, basée sur des données, de la performance qu'aurait eue votre IA sur de vrais problèmes de clients. Fini les devinettes et la création manuelle d'ensembles de données de test.

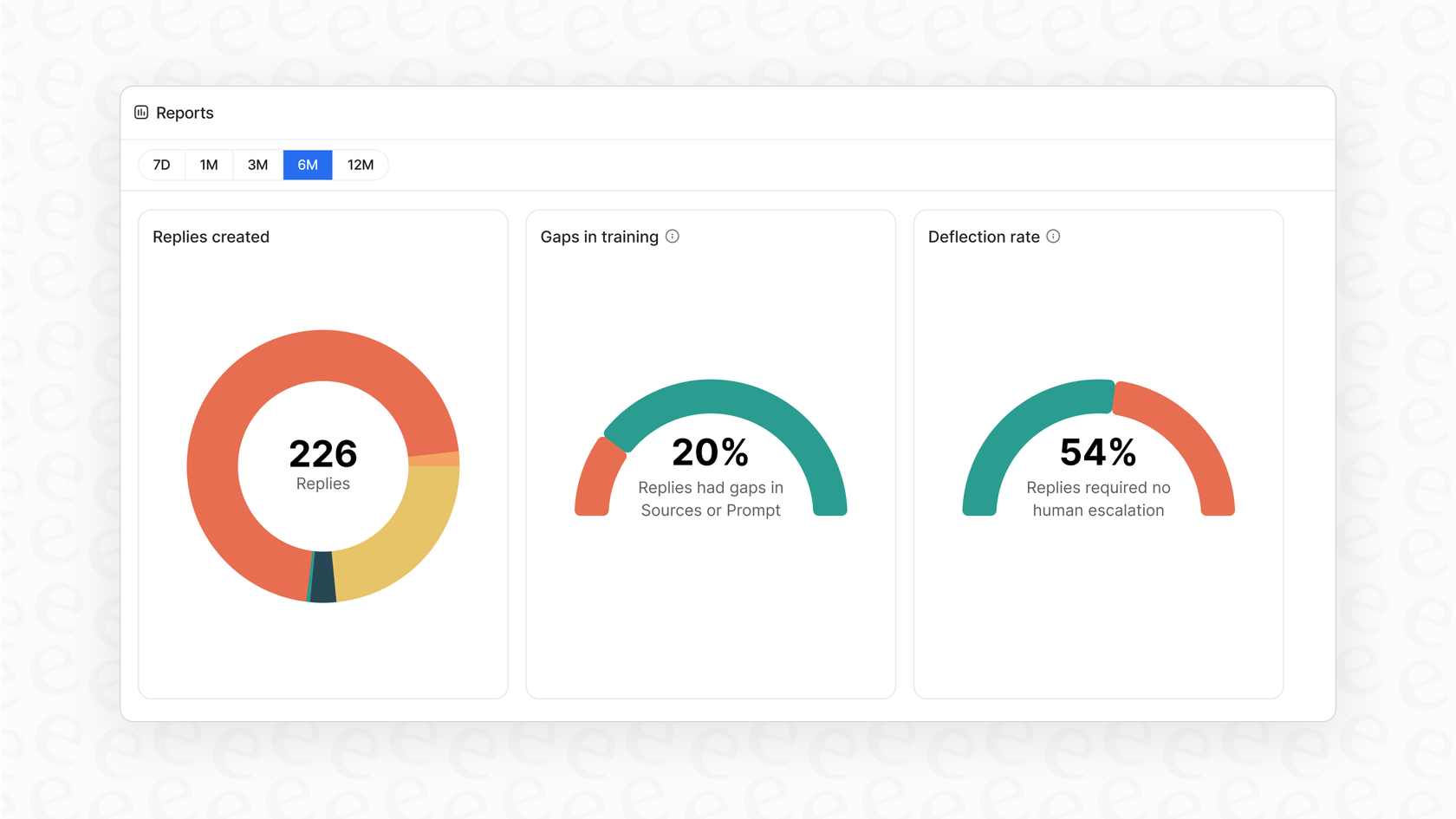

Obtenez des prochaines étapes claires, pas seulement un score

Les rapports exploitables dans eesel AI font plus que vous donner une note de réussite ou d'échec. Ils analysent la simulation pour vous montrer quels sujets sont mûrs pour l'automatisation. Mieux encore, ils signalent les lacunes de votre base de connaissances, vous donnant une liste de tâches claire sur les articles d'aide à rédiger ensuite, le tout basé sur de vraies questions de clients.

Déployez progressivement et en toute sécurité

Avec eesel AI, vous pouvez vous lancer sans risque. Après avoir exécuté une simulation, vous pouvez choisir d'automatiser seulement une petite partie des tickets, comme uniquement les demandes concernant le « statut de la commande ». Vous pouvez observer ses performances en temps réel et élargir le champ d'application à mesure que vous êtes plus à l'aise. Ce type de contrôle minutieux vous offre un déploiement fluide et sûr que vous ne pouvez tout simplement pas obtenir avec des plateformes qui exigent une approche du tout ou rien.

Arrêtez de deviner, commencez à mesurer

Mettre l'IA au service du support client n'est plus une question de si, mais de comment. Une grande partie du « comment » consiste à avoir un moyen fiable de l'évaluer. Bien que les concepts derrière les meilleures pratiques d'évaluation d'OpenAI nous orientent dans la bonne direction, les outils standard sont souvent trop techniques et déconnectés pour les équipes commerciales.

La bonne plateforme fait de l'évaluation sophistiquée une partie simple et intégrée de vos opérations. En intégrant la simulation et les rapports directement dans un flux de travail en libre-service, eesel AI vous permet de tester sur vos propres données et de déployer en toute confiance. Vous pouvez enfin arrêter d'espérer que votre IA fonctionne et commencer à le prouver.

Foire aux questions

Les meilleures pratiques d'évaluation d'OpenAI font référence à des tests structurés utilisés pour mesurer la performance d'un modèle d'IA sur des tâches spécifiques, comme répondre aux questions des clients. Elles sont cruciales pour garantir que votre agent de support IA est précis, fiable et constant, prévenant ainsi les mauvaises expériences client et renforçant la confiance.

Bien que de nombreux cadres soient axés sur les développeurs, des plateformes comme eesel AI offrent des solutions sans code. Ces outils s'intègrent directement à votre service d'assistance, vous permettant de simuler la performance de l'IA sur des tickets historiques et d'obtenir des informations exploitables sans expertise technique.

Les meilleures pratiques d'évaluation d'OpenAI standard nécessitent souvent des compétences en codage, impliquent des flux de travail lents et déconnectés, et reposent sur des ensembles de données de test potentiellement petits ou génériques. Ces limitations les rendent difficiles à appliquer pour les équipes de support occupées sans ressources de développement dédiées.

Pour appliquer les meilleures pratiques d'évaluation d'OpenAI, vous avez besoin d'un ensemble de données de « vérité terrain ». Celui-ci se compose de vraies questions de clients associées à des réponses parfaites et approuvées par des experts, reflétant la diversité des demandes que vos clients posent habituellement.

Oui, l'évaluation humaine est la référence absolue dans le cadre des meilleures pratiques d'évaluation d'OpenAI pour les jugements nuancés comme le ton ou l'empathie. Cependant, elle est lente, coûteuse et difficile à mettre à l'échelle pour des tests continus et à grand volume.

Le « LLM en tant que juge » est une méthode contemporaine dans le cadre des meilleures pratiques d'évaluation d'OpenAI où une IA puissante évalue les résultats de votre IA de support. C'est plus rapide et cela comprend mieux le contexte que les métriques traditionnelles, bien que cela puisse présenter des biais et nécessite une configuration minutieuse.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.