Ein praktischer Leitfaden zu den Best Practices der OpenAI-Evaluierung für Support-Teams

Stevia Putri

Katelin Teen

Last edited November 14, 2025

Expert Verified

Sie haben also einen KI-Support-Agenten ins Team geholt. Das ist ein großer Schritt. Aber woher wissen Sie wirklich, ob er Ihren Kunden hilft oder Ihren menschlichen Agenten nur mehr Kopfschmerzen bereitet? Sich auf Ihr "Bauchgefühl" zu verlassen oder nur ein paar Gespräche stichprobenartig zu prüfen, wird nicht ausreichen. Ohne eine solide Methode zur Leistungsmessung tappen Sie im Grunde im Dunkeln. Sie benötigen echte Daten, um sicher zu sein, dass Ihre KI präzise und hilfreich ist und Ihre Markenidentität wahrt.

Dieser Leitfaden soll die Verwirrung um die Best Practices für die OpenAI-Evaluierung beseitigen. Wir übersetzen die stark entwicklerorientierten Konzepte in ein Framework, das für Geschäfts- und Support-Führungskräfte tatsächlich sinnvoll ist. Wir werden die Grundideen der KI-Evaluierung durchgehen und Ihnen dann einen wesentlich praxisnäheren Weg zeigen, wie Sie KI direkt von Ihrem Helpdesk aus sicher testen und einsetzen können.

Was sind die Best Practices für die OpenAI-Evaluierung?

Lassen Sie es uns aufschlüsseln. "Evals" sind einfach strukturierte Tests, um zu sehen, wie gut ein KI-Modell eine bestimmte Aufgabe erfüllt. Stellen Sie es sich wie ein Zeugnis für Ihre KI vor, das sie nach Kriterien wie Genauigkeit, Relevanz und Zuverlässigkeit benotet.

Laut der eigenen Dokumentation von OpenAI ist die Durchführung dieser Evals unerlässlich, um jede Anwendung zu verbessern, die ein großes Sprachmodell (LLM) verwendet. So verhindern Sie, dass die KI seltsame oder falsche Antworten an Kunden sendet, halten die Qualität konstant und verfolgen, ob sich die Dinge im Laufe der Zeit verbessern, insbesondere wenn die zugrunde liegenden Modelle aktualisiert werden.

Aber die Sache ist die: Frameworks wie die OpenAI Evals API sind für Entwickler konzipiert. Sie beinhalten das Schreiben von Code, das Formatieren von Daten in speziellen Dateien (wie JSONL) und die Analyse der Ergebnisse mit Skripten. Für eine Führungskraft ist das Ziel nicht, programmieren zu lernen. Es geht darum, von "Ich glaube, es funktioniert" zu "Ich habe die Daten, die beweisen, dass unsere KI unsere Ziele erreicht und die Kunden zufriedenstellt" zu gelangen.

Der Kernprozess der Evaluierung

Wenn man sich die Richtlinien von Leuten wie OpenAI und Microsoft ansieht, hat ein guter Evaluierungsprozess normalerweise vier Hauptschritte. Das Befolgen dieses Zyklus hilft sicherzustellen, dass Ihre Tests tatsächlich nützlich sind und zu echten Verbesserungen führen.

graph TD A[1. Ziel definieren] --> B[2. Daten sammeln]; B --> C[3. Metriken auswählen]; C --> D[4. Testen & Iterieren]; D --> A;

1. Definieren Sie Ihr Ziel

Zuerst müssen Sie entscheiden, wie "Erfolg" für eine bestimmte Aufgabe aussieht. Und Sie müssen spezifisch sein. "Fragen gut beantworten" ist zu vage. Ein besseres Ziel wäre: "Die KI sollte unsere 30-tägige Rückgaberichtlinie genau erklären, indem sie sich auf den offiziellen Hilfeartikel bezieht." Das ist etwas, das man tatsächlich messen kann.

2. Sammeln Sie Ihre Daten

Um Ihre KI zu testen, benötigen Sie einen "Ground-Truth"-Datensatz. Dies ist nur ein schicker Begriff für eine Sammlung von Fragen, gepaart mit perfekten, von Experten geprüften Antworten. Diese Daten sollten wie die echten Fragen Ihrer Kunden aussehen und die üblichen Dinge, die seltsamen Sonderfälle und alles dazwischen abdecken.

3. Wählen Sie Ihre Metriken

Wie werden Sie die Antworten der KI bewerten? Es könnte ein einfaches Bestanden/Nicht bestanden sein, je nachdem, ob die Information korrekt ist, eine Bewertung, wie gut sie zum Tonfall Ihrer Marke passt, oder die Überprüfung, ob sie etwas Bestimmtes getan hat, wie ein Ticket korrekt zu verschlagworten. Was auch immer Sie wählen, es sollte direkt mit dem Ziel verknüpft sein, das Sie in Schritt eins festgelegt haben.

4. Testen, prüfen und wiederholen

Der letzte Schritt besteht darin, Ihre Tests durchzuführen, die Ergebnisse zu betrachten und das Gelernte zu nutzen, um Ihre KI anzupassen. Vielleicht müssen Sie eine Eingabeaufforderung (Prompt) anpassen, sie auf eine bessere Wissensquelle verweisen oder eine Workflow-Regel ändern. Die Evaluierung ist nichts, was man einmal macht; es ist eine Schleife aus Testen und Verbessern, die Ihre KI auf Höchstleistung hält.

Wichtige Evaluierungsstrategien und Metriken

Es gibt verschiedene Möglichkeiten, die Leistung einer KI zu bewerten, und jede hat ihre Vor- und Nachteile. Die Optionen zu kennen, hilft Ihnen, das richtige Werkzeug für die Aufgabe auszuwählen.

Menschliche Evaluierung

Dies ist der Goldstandard für Qualität. Ein menschlicher Experte liest die Antwort der KI und bewertet sie anhand einer Reihe von Kriterien. Es ist fantastisch, um nuancierte Dinge wie Empathie oder Tonfall zu beurteilen, aber es ist auch unglaublich langsam, teuer und mühsam zu skalieren. Für den täglichen Gebrauch ist es einfach nicht praktikabel.

Traditionelle metrikbasierte Evaluierung (ROUGE/BLEU)

Dies sind automatisierte Systeme, die die Antwort einer KI bewerten, indem sie ihren Text mit einer "perfekten" Referenzantwort vergleichen. Sie zählen im Grunde, wie viele Wörter und Phrasen sich überschneiden.

Der Haken: Wie viele in der Branche betonen, sind diese Metriken nicht gut darin, Bedeutung zu verstehen. Eine KI könnte eine vollkommen korrekte Antwort mit anderen Worten geben, aber ein ROUGE- oder BLEU-Test würde sie durchfallen lassen. Diese Starrheit macht sie weniger nützlich für die Beurteilung von Konversations-KI.

LLM-as-a-Judge

Dies ist ein neuerer Ansatz, bei dem Sie ein leistungsstarkes KI-Modell (wie GPT-4) als "Richter" einsetzen, um die Ausgabe Ihrer Support-KI zu bewerten. Es ist schneller und billiger als der Einsatz von Menschen und versteht den Kontext weitaus besser als einfache Textvergleichstools.

Der Haken: Diese Methode kann ihre eigenen Voreingenommenheiten haben (zum Beispiel bevorzugt sie manchmal längere Antworten ohne guten Grund) und erfordert immer noch eine sorgfältige Einrichtung, um gut zu funktionieren. Es ist eine deutliche Verbesserung, aber kein Allheilmittel und erfordert oft immer noch ein technisches Auge.

| Evaluierungsmethode | Geschwindigkeit | Kosten | Skalierbarkeit | Nuancierung |

|---|---|---|---|---|

| Menschliche Evaluierung | Langsam | Hoch | Niedrig | Hoch |

| Metrikbasiert (ROUGE) | Schnell | Niedrig | Hoch | Niedrig |

| LLM-as-a-Judge | Schnell | Mittel | Hoch | Mittel |

Praktische Einschränkungen der entwicklerfokussierten OpenAI-Evaluierung

Obwohl die Theorie hinter den Best Practices für die OpenAI-Evaluierung solide ist, sind die Werkzeuge selbst oft ungeeignet für ein vielbeschäftigtes Support-Team. Hier bricht der lehrbuchmäßige Ansatz in der realen Welt oft zusammen.

Erfordert Entwickler-Expertise

Um Evals mit den Standard-Frameworks durchzuführen, müssen Sie mit APIs, Kommandozeilen-Tools und der Formatierung von Daten in JSONL vertraut sein. Das ist für die meisten Support-Leiter einfach nicht realistisch, die Werkzeuge benötigen, die sie selbst verwalten können, ohne ein Ticket beim Engineering-Team einreichen und warten zu müssen.

Der Prozess ist langsam und unzusammenhängend

Der typische Arbeitsablauf besteht darin, Daten aus Ihrem Helpdesk zu ziehen, Tests an einem völlig separaten Ort durchzuführen und dann zu versuchen, die Ergebnisse zu verstehen. Es ist umständlich und gibt Ihnen kein Feedback dort, wo Sie tatsächlich arbeiten: in Ihrem Helpdesk. Dies schafft eine Lücke zwischen dem Testen und dem tatsächlichen Betrieb Ihrer Support-Operationen.

Testdatensätze sind oft zu klein oder zu allgemein

Einen guten Satz an Testdaten zu erstellen, ist schwierig. Viele Teams testen entweder an einer Handvoll selbst geschriebener Beispiele oder verwenden allgemeine Branchen-Benchmarks. Keines von beiden erfasst wirklich die einzigartige und oft unordentliche Vielfalt Ihrer echten Kundengespräche, was Ihnen ein falsches Gefühl der Sicherheit geben kann.

Ein besserer Ansatz: Geschäftsorientierte Evaluierung mit eesel AI

Anstatt Sie zu zwingen, das Toolkit eines Entwicklers zu lernen, bauen einige Plattformen die Evaluierung direkt in einen einfachen Workflow ein, den jeder nutzen kann. eesel AI wurde von Grund auf entwickelt, um diese praktischen Probleme für Support-Teams zu lösen.

In wenigen Minuten startklar: Evaluierung ohne Code

Vergessen Sie komplizierte Setups. eesel AI ist eine wirklich Self-Service-Plattform mit Ein-Klick-Helpdesk-Integrationen. Sie können Ihr Wissen aus Quellen wie Zendesk oder Confluence verbinden und mit der Evaluierung des Potenzials Ihrer KI beginnen, ohne eine einzige Zeile Code zu schreiben oder an einer Verkaufsdemo teilzunehmen.

Sicher testen: Bisherige Tickets für die Evaluierung nutzen

Hier wird es wirklich leistungsstark. Der Simulationsmodus von eesel AI kann Ihr KI-Setup auf Tausenden Ihrer echten, historischen Tickets ausführen. Dies gibt Ihnen eine genaue, datengestützte Prognose, wie Ihre KI bei echten Kundenproblemen abgeschnitten hätte. Kein Raten mehr und kein manuelles Erstellen von Testdatensätzen.

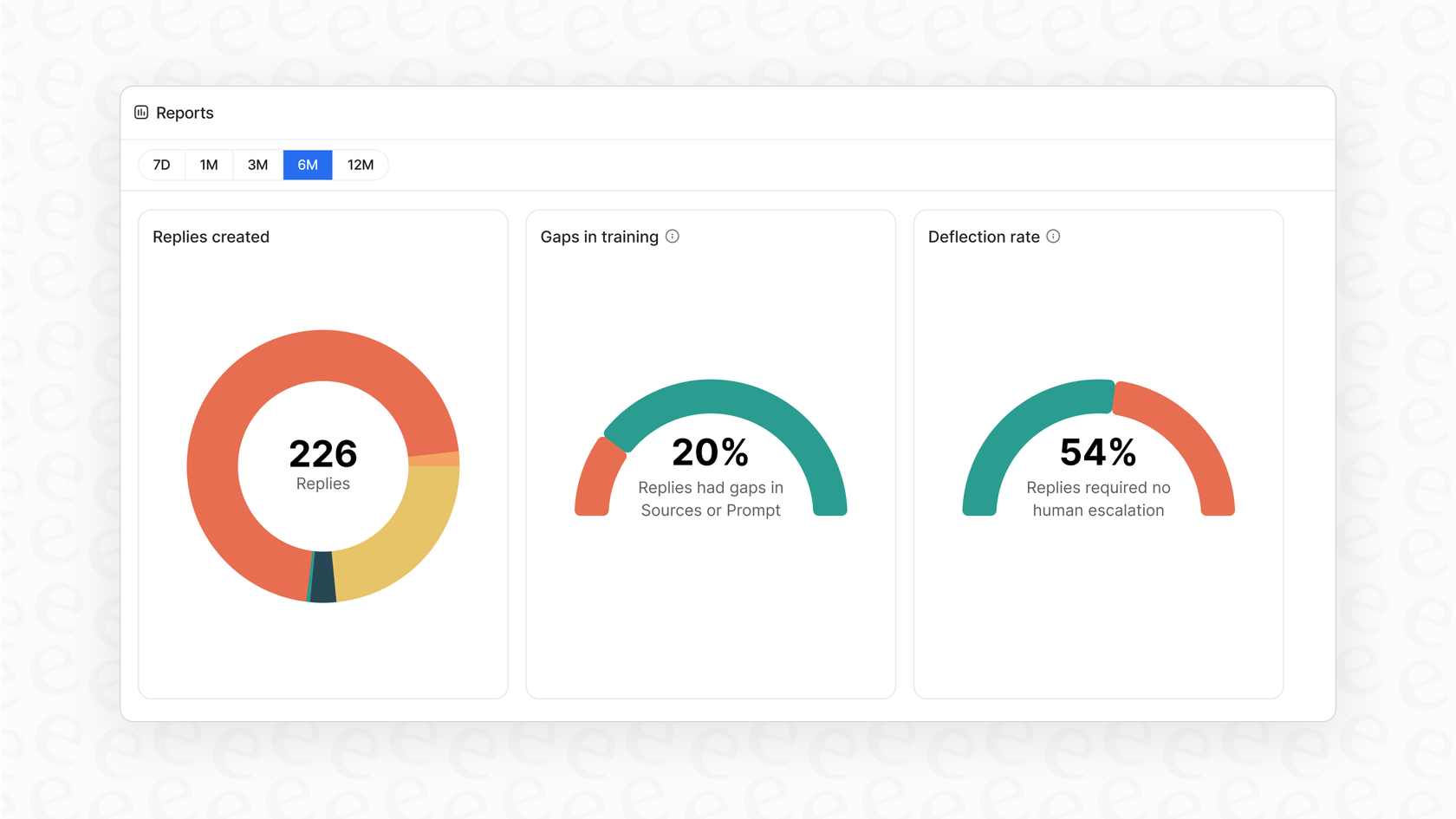

Erhalten Sie klare nächste Schritte, nicht nur eine Punktzahl

Das handlungsorientierte Reporting in eesel AI gibt Ihnen mehr als nur eine Bestanden/Nicht-bestanden-Note. Es analysiert die Simulation, um Ihnen zu zeigen, welche Themen sich am besten für die Automatisierung eignen. Noch besser: Es zeigt die Lücken in Ihrer Wissensdatenbank auf und gibt Ihnen eine klare To-do-Liste, welche Hilfeartikel als Nächstes zu schreiben sind, alles basierend auf echten Kundenfragen.

Schrittweise und sicher einführen

Mit eesel AI können Sie ohne Risiko starten. Nach einer Simulation können Sie wählen, nur einen kleinen Teil der Tickets zu automatisieren, wie zum Beispiel nur Anfragen zum "Bestellstatus". Sie können in Echtzeit beobachten, wie es funktioniert, und den Umfang erweitern, wenn Sie sich wohler fühlen. Diese Art von sorgfältiger Kontrolle ermöglicht Ihnen eine reibungslose, sichere Einführung, die Sie mit Plattformen, die einen Alles-oder-Nichts-Ansatz fordern, einfach nicht bekommen.

Hören Sie auf zu raten, fangen Sie an zu messen

Der Einsatz von KI im Kundensupport ist keine Frage des Ob mehr, sondern des Wie. Ein großer Teil des "Wie" ist eine verlässliche Methode zur Evaluierung. Während die Konzepte hinter den Best Practices für die OpenAI-Evaluierung uns in die richtige Richtung weisen, sind die Standard-Tools oft zu technisch und unzusammenhängend für Business-Teams.

Die richtige Plattform macht anspruchsvolle Evaluierung zu einem einfachen, integrierten Teil Ihres Betriebs. Durch die Einbettung von Simulation und Reporting direkt in einen Self-Service-Workflow ermöglicht Ihnen eesel AI, auf Ihren eigenen Daten zu testen und mit Vertrauen zu implementieren. Sie können endlich aufhören zu hoffen, dass Ihre KI funktioniert, und anfangen, es zu beweisen.

Häufig gestellte Fragen

Die Best Practices für die OpenAI-Evaluierung beziehen sich auf strukturierte Tests, mit denen die Leistung eines KI-Modells bei bestimmten Aufgaben, wie der Beantwortung von Kundenfragen, gemessen wird. Sie sind entscheidend, um sicherzustellen, dass Ihr KI-Support-Agent präzise, zuverlässig und konsistent ist, um schlechte Kundenerlebnisse zu vermeiden und Vertrauen aufzubauen.

Während viele Frameworks auf Entwickler ausgerichtet sind, bieten Plattformen wie eesel AI No-Code-Lösungen. Diese Tools integrieren sich direkt in Ihren Helpdesk und ermöglichen es Ihnen, die KI-Leistung auf Basis historischer Tickets zu simulieren und handlungsorientierte Einblicke ohne technisches Fachwissen zu erhalten.

Die standardmäßigen Best Practices für die OpenAI-Evaluierung erfordern oft Programmierkenntnisse, beinhalten langsame und unzusammenhängende Arbeitsabläufe und stützen sich auf potenziell kleine oder allgemeine Testdatensätze. Diese Einschränkungen machen sie für vielbeschäftigte Support-Teams ohne dedizierte Entwicklerressourcen zu einer Herausforderung.

Um die Best Practices für die OpenAI-Evaluierung anzuwenden, benötigen Sie einen "Ground-Truth"-Datensatz. Dieser besteht aus echten Kundenfragen, gepaart mit von Experten geprüften, perfekten Antworten, die die vielfältigen Anfragen Ihrer Kunden widerspiegeln.

Ja, die menschliche Evaluierung ist der Goldstandard innerhalb der Best Practices für die OpenAI-Evaluierung für nuancierte Beurteilungen wie Tonfall oder Empathie. Sie ist jedoch langsam, teuer und für kontinuierliche Tests mit hohem Volumen schwer zu skalieren.

LLM-as-a-Judge ist eine zeitgemäße Methode innerhalb der Best Practices für die OpenAI-Evaluierung, bei der eine leistungsstarke KI die Ausgabe Ihrer Support-KI bewertet. Sie ist schneller und versteht den Kontext besser als herkömmliche Metriken, kann jedoch Voreingenommenheiten aufweisen und erfordert eine sorgfältige Einrichtung.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.