サポートチーム向けOpenAI評価ベストプラクティス実践ガイド

Kenneth Pangan

Katelin Teen

Last edited 2025 11月 14

Expert Verified

チームにAIサポートエージェントを導入したのですね。これは大きな一歩です。しかし、それが本当にお客様の助けになっているのか、それとも人間のエージェントの頭痛の種を増やしているだけなのか、どうすれば本当にわかるのでしょうか?「直感」に頼ったり、いくつかの会話を抜き打ちでチェックしたりするだけでは不十分です。パフォーマンスを測定する確固たる方法がなければ、実質的に目隠しで飛んでいるようなものです。AIが正確で、役に立ち、ブランドイメージを維持していると確信するためには、実際のデータが必要です。

このガイドは、OpenAI評価のベストプラクティスに関する混乱を解消するためにあります。開発者向けの難解な概念を、ビジネスリーダーやサポートリーダーにとって実際に意味のあるフレームワークに翻訳します。AI評価の核となる考え方を順を追って説明し、その後、ヘルプデスクから直接、自信を持ってAIをテストし、展開するための、はるかに実用的な方法をご紹介します。

OpenAI評価のベストプラクティスとは?

詳しく見ていきましょう。「Evals(評価)」とは、AIモデルが特定の仕事をどれだけうまくこなしているかを確認するための、体系化されたテストのことです。AIの成績表のようなもので、正確さ、関連性、信頼性といった項目で採点するものだと考えてください。

OpenAI自身のドキュメントによると、これらの評価を実行することは、大規模言語モデル(LLM)を使用するアプリを改善するために不可欠です。これにより、AIが奇妙な回答や間違った回答を顧客に送るのを防ぎ、品質の一貫性を保ち、特に基盤となるモデルが更新されたときに、時間の経過とともによくなっているかどうかを追跡できます。

しかし、問題は、OpenAI Evals APIのようなフレームワークは開発者向けに作られているということです。これには、コードの記述、特別なファイル(JSONLなど)でのデータフォーマット、スクリプトによる結果の分析などが伴います。ビジネスリーダーにとっての目標は、コーディングを学ぶことではありません。「たぶんうまくいっていると思う」という状態から、「AIが目標を達成し、顧客を満足させていることを証明するデータがある」という状態に移行することです。

評価プロセスの核となるステップ

OpenAIやMicrosoftのような企業からのガイドラインを見ると、優れた評価プロセスには通常4つの主要なステップがあります。このサイクルに従うことで、テストが実際に役立ち、真の改善につながるようになります。

graph TD A[1. Define Goal] --> B[2. Gather Data]; B --> C[3. Choose Metrics]; C --> D[4. Test & Iterate]; D --> A;

1. 目標を定義する

まず、特定のタスクにおいて「成功」がどのような状態かを決める必要があります。そして、具体的にする必要があります。「質問にうまく答える」では曖昧すぎます。より良い目標は、「AIは、公式ヘルプセンターの記事を参照して、当社の30日間返品ポリシーを正確に説明すべきである」といったものです。これなら実際に測定できます。

2. データを収集する

AIをテストするには、「正解データ」セットが必要です。これは、専門家が承認した完璧な回答とペアになった質問のコレクションを指す専門用語です。このデータは、お客様が実際に尋ねる質問に似ている必要があり、よくある質問、珍しいエッジケース、そしてその間のすべてをカバーしているべきです。

3. 指標を選択する

AIの回答をどのように採点しますか?情報が正しいかどうかの単純な合否判定、ブランドのトーンにどれだけ合っているかの評価、あるいはチケットを正しくタグ付けしたかのような特定の行動をチェックすることもできます。何を選ぶにしても、それはステップ1で設定した目標に直接結びついているべきです。

4. テスト、確認、そして改善を繰り返す

最後のステップは、テストを実行し、結果を確認し、学んだことを使ってAIを調整することです。プロンプトを調整したり、より良いナレッジソースを指示したり、ワークフローのルールを変更したりする必要があるかもしれません。評価は一度やれば終わりではありません。AIが最高のパフォーマンスを維持するための、テストと改善のループなのです。

主要な評価戦略と指標

AIのパフォーマンスを評価する方法はいくつかあり、それぞれに長所と短所があります。選択肢を知ることで、状況に適したツールを選ぶことができます。

人による評価

これは品質におけるゴールドスタンダードです。人間の専門家がAIの応答を読み、一連の基準に照らして評価します。共感やトーンのようなニュアンスを判断するには素晴らしい方法ですが、信じられないほど時間がかかり、コストも高く、スケールさせるのが大変です。日常的に使用するには、実用的ではありません。

従来の指標ベースの評価(ROUGE/BLEU)

これらは、AIの回答テキストを「完璧な」参照回答と比較してスコアを付ける自動システムです。基本的には、どれだけの単語やフレーズが重複しているかを数えます。

注意点: 業界の多くの人が指摘するように、これらの指標は意味を理解するのが得意ではありません。AIが異なる言葉を使って完全に正しい答えを出したとしても、ROUGEやBLEUのテストでは不合格になる可能性があります。その硬直性のため、対話型AIの評価にはあまり役立ちません。

審査員としてのLLM

これは、強力なAIモデル(GPT-4など)を「審査員」として使い、サポートAIの出力を評価させる新しいアプローチです。人間を使うよりも速くて安く、単純なテキストマッチングツールよりもはるかに文脈を理解します。

注意点: この方法には独自のバイアスがある可能性があり(例えば、正当な理由なく長い回答を好むことがある)、うまく機能させるには依然として慎重な設定が必要です。これは明確な改善ですが、万能薬ではなく、多くの場合、技術的な監視が必要です。

| 評価方法 | 速度 | コスト | 拡張性 | ニュアンスの理解度 |

|---|---|---|---|---|

| 人による評価 | 遅い | 高い | 低い | 高い |

| 指標ベース (ROUGE) | 速い | 低い | 高い | 低い |

| 審査員としてのLLM | 速い | 中程度 | 高い | 中程度 |

開発者向けOpenAI評価の実用上の限界

OpenAI評価ベストプラクティスの理論はしっかりしていますが、ツール自体は多忙なサポートチームには合わないことが多いです。ここでは、教科書的なアプローチが現実世界でうまくいかなくなる点について説明します。

開発者の専門知識が必要

標準的なフレームワークで評価を実行するには、API、コマンドラインツール、JSONLでのデータフォーマットに精通している必要があります。これは、エンジニアリングチームにチケットを発行して待つことなく、自分たちで管理できるツールを必要とするほとんどのサポートリーダーにとって現実的ではありません。

プロセスが遅く、分断されている

典型的なワークフローでは、ヘルプデスクからデータを引き出し、まったく別の場所でテストを実行し、その結果を解釈しようとします。これは扱いにくく、実際に作業する場所、つまりヘルプデスク内でフィードバックを得ることができません。これにより、テストと実際のサポート業務との間にギャップが生まれます。

テストデータセットが小さすぎる、または一般的すぎる

優れたテストデータセットを構築するのは困難です。多くのチームは、自分たちで書いた少数の例でテストするか、一般的な業界ベンチマークを使用することになります。どちらも、実際の顧客との会話のユニークでしばしば乱雑な多様性を捉えることができず、誤った安心感を与えてしまう可能性があります。

より良いアプローチ:eesel AIによるビジネス視点の評価

開発者向けのツールキットを学ぶ代わりに、誰でも使えるシンプルなワークフローに評価機能を組み込んでいるプラットフォームもあります。eesel AIは、サポートチームが抱えるこれらの実用的な問題を解決するために、ゼロから設計されました。

数分で開始:ノーコード評価

複雑なセットアップは忘れてください。eesel AIは、ワンクリックのヘルプデスク連携を備えた完全セルフサービス型のプラットフォームです。ZendeskやConfluenceのような場所からナレッジを接続し、一行のコードも書くことなく、また営業デモを受けることもなく、AIの可能性の評価を開始できます。

自信を持ってテスト:過去のチケットを評価に利用

ここからが本当に強力な点です。eesel AIのシミュレーションモードは、何千もの実際の過去のチケットに対してAIセットアップを実行できます。これにより、実際の顧客の問題に対してAIがどのように機能したかについて、正確でデータに基づいた予測が得られます。もう推測する必要も、手作業でテストデータセットを構築する必要もありません。

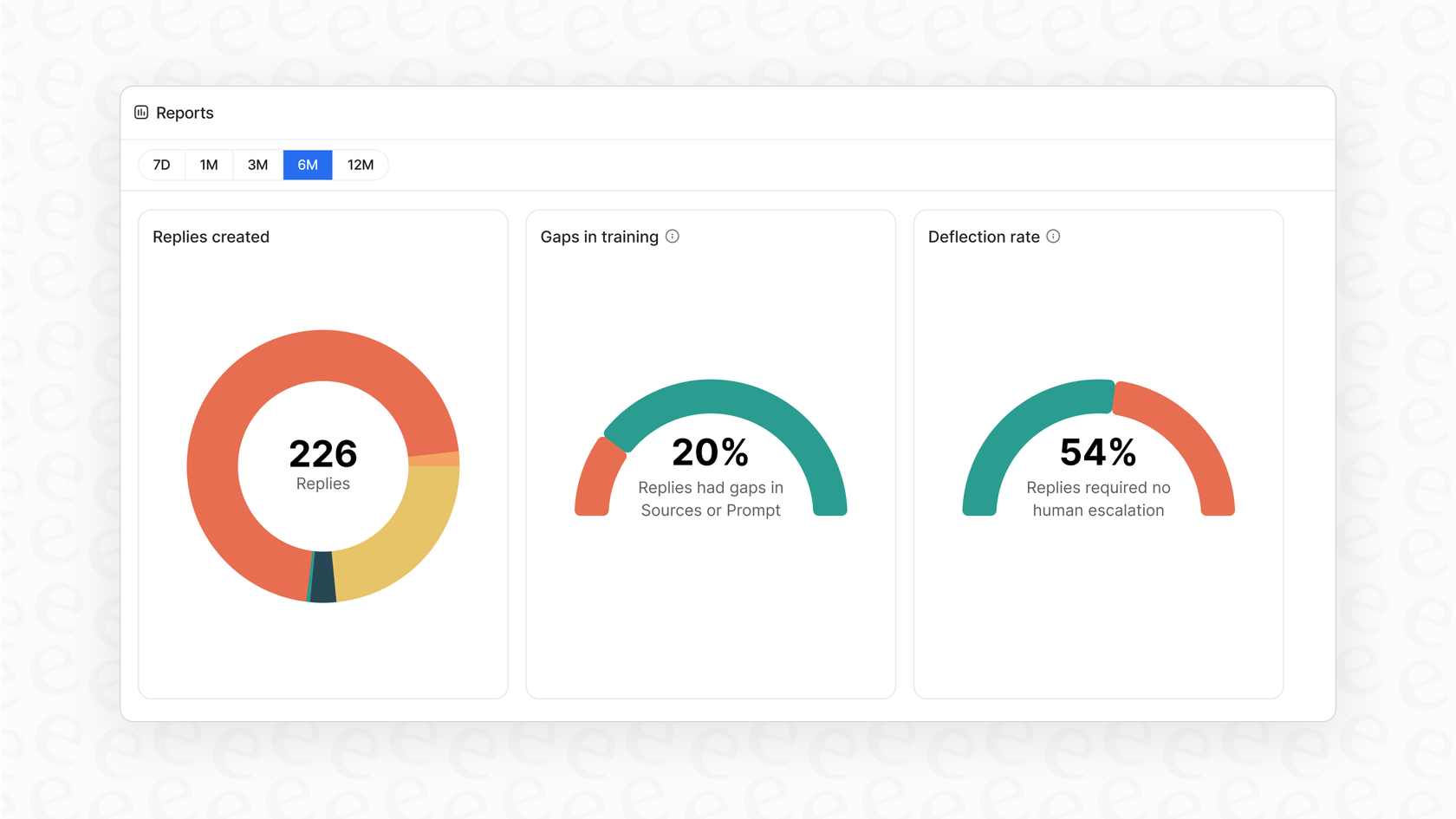

単なるスコアではなく、明確な次のステップを提示

eesel AIの実用的なレポートは、合否の評価を与えるだけではありません。シミュレーションを分析して、どのトピックが自動化に適しているかを示します。さらに良いことに、ナレッジベースのギャップを指摘し、実際の顧客の質問に基づいて、次にどのヘルプ記事を書くべきかについての明確なTo-Doリストを提供します。

段階的かつ安全な展開

eesel AIを使えば、リスクなく導入できます。シミュレーションを実行した後、「注文状況」に関する問い合わせのみなど、チケットのごく一部だけを自動化することを選択できます。リアルタイムでパフォーマンスを監視し、慣れてきたら範囲を拡大できます。このような慎重な管理は、オールオアナッシングのアプローチを要求するプラットフォームでは得られない、スムーズで安全な展開を可能にします。

推測はやめて、測定を始めよう

カスタマーサポートにAIを導入することは、もはやもしの問題ではなく、どのようにの問題です。「どのように」の大部分は、それを評価するための信頼できる方法を持つことです。OpenAI評価ベストプラクティスの背後にある概念は正しい方向を示していますが、標準的なツールはしばしば技術的すぎ、ビジネスチームにとっては分断されています。

適切なプラットフォームは、高度な評価を業務のシンプルで組み込みの一部にします。シミュレーションとレポートをセルフサービスワークフローに直接埋め込むことで、eesel AIは、自身のデータでテストし、自信を持って展開することを可能にします。ついに、AIが機能することを期待するのをやめ、それを証明することができるのです。

よくある質問

OpenAI評価ベストプラクティスとは、顧客の質問に答えるといった特定のタスクに対するAIモデルのパフォーマンスを測定するために使用される、体系化されたテストのことです。AIサポートエージェントが正確で、信頼でき、一貫していることを保証し、悪い顧客体験を防ぎ、信頼を築くために不可欠です。

多くのフレームワークは開発者向けですが、eesel AIのようなプラットフォームはノーコードソリューションを提供しています。これらのツールはヘルプデスクと直接統合し、技術的な専門知識なしで過去のチケットに対するAIのパフォーマンスをシミュレートし、実用的な洞察を得ることができます。

標準的なOpenAI評価ベストプラクティスは、しばしばコーディングスキルを必要とし、遅くて分断されたワークフローを伴い、潜在的に小さいか一般的なテストデータセットに依存します。これらの限界は、専任の開発者リソースを持たない多忙なサポートチームにとって困難なものにします。

OpenAI評価ベストプラクティスを適用するためには、「正解データ」セットが必要です。これは、顧客が通常尋ねる多様な問い合わせを反映した、専門家が承認した完璧な回答とペアになった実際の顧客の質問で構成されます。

はい、人による評価は、トーンや共感といったニュアンスの判断において、OpenAI評価ベストプラクティスにおけるゴールドスタンダードです。しかし、継続的で大量のテストには、時間がかかり、コストが高く、スケールさせることが困難です。

審査員としてのLLMは、OpenAI評価ベストプラクティスにおける現代的な手法であり、強力なAIがあなたのサポートAIの出力を評価します。従来の指標よりも速く、文脈をよりよく理解しますが、バイアスを持つ可能性があり、慎重な設定が必要です。

この記事を共有

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.