音声であらゆるものを操作するのが当たり前の時代になりました。メモを取ってくれる会議アシスタントから、買い物リストを管理する音声コマンドまで、その用途は様々です。しかし、その背後にある技術は、まるでアルファベットのスープのように複雑に感じられるかもしれません。OpenAIのWhisperとText-to-Speech(TTS)APIという言葉をよく耳にしますが、これらは関連しているように見えて、実は正反対の役割を担っています。

この違いを理解することは、音声機能を備えたアプリを開発したい人や、AIを使ってビジネスを少しでも円滑に進めたいと考えている人にとって非常に重要です。このガイドでは、WhisperとTTS APIが具体的に何をするのか、どう違うのか、どのように連携するのかを詳しく解説し、どちらが本当に必要なのかを判断する手助けをします。

Whisper APIとTTS APIの核心:音声認識 vs 音声合成

直接的な比較に入る前に、基本を押さえておきましょう。これら2つの技術は、いわばコインの裏表の関係にあります。一方は「聞く」ため、もう一方は「話す」ためのものです。

OpenAI Whisperとは?

OpenAI Whisperは、音声認識(speech-to-text)モデルとして知られています。その役割は、話し言葉の音声を書き言葉のテキストに変換すること。ただそれだけです。

ウェブ上から集められた68万時間もの膨大な音声データでトレーニングされており、そのため、さまざまなアクセントの理解、背景ノイズの除去、さらには専門用語の聞き取りにも非常に優れています。98の異なる言語を文字起こしでき、その多くを英語に翻訳することも可能です。オープンソースモデルとして自身のハードウェアで実行することも、プロジェクトに組み込みやすい有料のAPIを利用することもできます。

基本的に、WhisperはAIシステムの「耳」の役割を果たします。

TTS APIとは?

Text-to-Speech(TTS)APIは、全く逆の働きをします。書き言葉のテキストを、話し言葉の音声に変換するのです。OpenAIにも独自のTTS APIがあり、テキストブロックから非常に人間らしい音声を作り出すことができます。これらのシステムは、人が話すような自然なリズムやトーンで聞こえるように設計されています。

TTS APIは、AIシステムの「声」と考えることができます。カーナビが経路を案内したり、スマートフォンが記事を読み上げたり、AIアシスタントが口頭で答えたりするのを可能にしているのが、この技術です。

WhisperとTTS APIの連携の仕組み

「WhisperかTTS APIか」という議論で多くの人が誤解している重要な点があります。それは、どちらか一方を選ぶのではないということです。両者は協力関係にあるのです。完全な会話のループを作り出すために、プロセスの異なる段階でそれぞれが使用されます。

例えば、あなたが音声アシスタントを開発しているとしましょう。2つの技術は次のように連携します。

-

あなたが話す:「営業時間は何時ですか?」のように質問します。

-

**Whisperが聞く:**システムが音声をキャプチャし、Whisperがそれを「営業時間は何時ですか?」という単純なテキスト文字列に変換します。

-

**アプリが考える:**あなたのアプリケーション(あるいは大規模言語モデル)がそのテキストを受け取り、意図を理解して答えを見つけます。答えもまたテキストです:「営業時間は月曜日から金曜日の午前9時から午後5時までです。」

-

**TTS APIが話す:**最後に、TTS APIがそのテキストの応答を受け取り、合成音声が言葉を話す音声ファイルに変換します。これであなたは答えを聞くことができます。

ご覧の通り、これらは一連の流れで動作します。互換性はありません。音声がテキストになり、そのテキストが処理され、そしてテキストの応答が再び音声になるのです。

本当の課題はどちらかを選ぶことではなく、これらをスムーズに統合し、その間のロジックをすべて構築することです。これには通常、多くの開発時間と継続的なメンテナンスが必要で、AIが何かを誤解したり、間違った答えをでっち上げたりするエラーや「ハルシネーション」にも注意しなければなりません。

目的に合ったツールの選択

音声を使った何かを構築しようとする際には、いくつかの重要な点を検討する必要があります。Whisperは音声認識の分野で最高クラスの選択肢ですが、世の中にはDeepgramやGoogle、Amazonといった他のプレイヤーも存在します。

考慮すべき要素は以下の通りです。

-

**精度:**モデルが話されている内容をどれだけ正確に理解できるか。これはしばしば「単語誤り率」(WER)で測定され、スコアが低いほど優れています。Whisperは非常に精度が高いことで知られていますが、100%完璧なものはありません。いくつかの単語が間違っているだけで、アプリケーションが完全に混乱してしまう可能性があります。

-

**速度:**どれだけ早く応答を得られるか。リアルタイムの会話では、非常に低いレイテンシ(遅延)が求められます。しかし、長時間の会議録音を後から文字起こしするだけなら、速度はそれほど重要ではありません。

-

**コスト:**APIの価格は通常、処理する音声の分数ごとに計算されます。しかし、「隠れたコスト」も忘れてはいけません。Whisperをオープンソースで利用する場合、強力なサーバー、それを維持する担当者、そして開発者の時間が必要となり、これらが積み重なるとかなりの額になる可能性があります。

-

**追加機能:**話者識別、リアルタイム文字起こし、業界特有の専門用語に対応するカスタム語彙などの機能が必要ですか?基本的なAPIには、これらの機能が含まれていない場合があります。

ここで、ゼロから構築することが本当に頭の痛い問題になり得ます。多くのビジネス、特にカスタマーサポートの分野では、主な目標は顧客の質問により迅速に答えることです。カスタムボイスボットはその一つの方法ですが、それは巨大で長期的なプロジェクトになります。

より直接的な方法は、多くの場合、急な学習曲線を必要とせずに実際のビジネス課題を解決するプラットフォームを利用することです。例えば、eesel AIのようなツールは、あなたがすでに使用しているヘルプデスクやナレッジベースに直接接続することで、サポートを自動化するために作られています。ほとんどのサポートチケットがテキストベースであるという点に着目し、STT/TTSパイプライン全体の煩雑さを回避します。これにより、数ヶ月ではなく数分で稼働させることができます。

| 機能 | 生のAPI(Whisper/TTS)で構築する場合 | eesel AIのようなプラットフォームを使用する場合 |

|---|---|---|

| セットアップ時間 | 数週間から数ヶ月の開発期間 | 数分、ワンクリックでの連携 |

| ナレッジソース | 各ソースごとにカスタムコーディングが必要 | ヘルプデスクやドキュメントなどに即座に接続 |

| メンテナンス | 継続的な開発者の時間とサーバーコスト | プラットフォーム側で管理 |

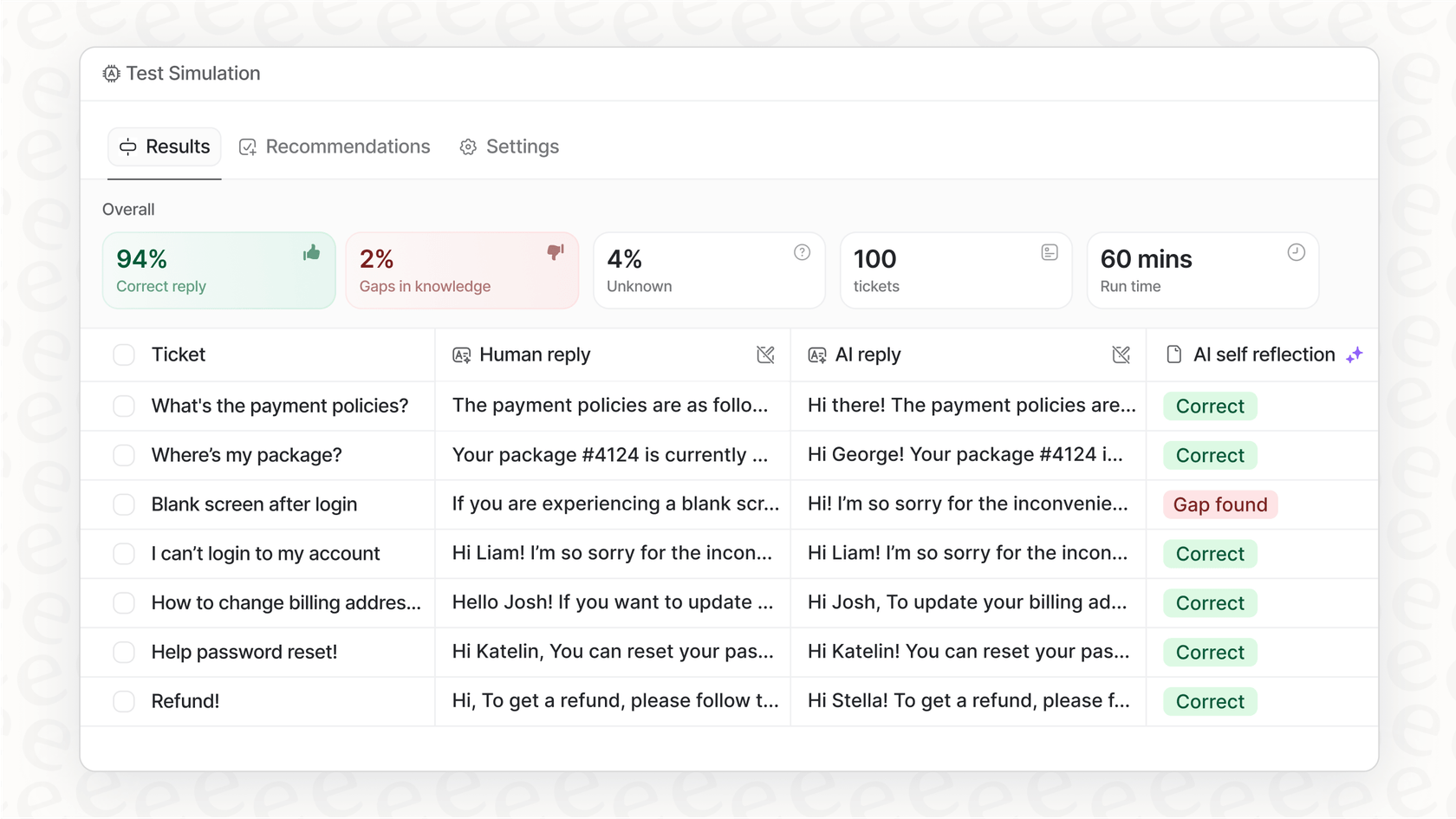

| テスト | 実世界のパフォーマンスのシミュレーションが困難 | 過去のチケットに基づいた堅牢なシミュレーション |

| 主な焦点 | 音声I/Oの技術的実装 | ビジネス課題の解決(サポートの自動化) |

WhisperとTTS APIの実世界での使用例

WhisperとTTS APIは、私たちがすでに日常的に使用している多くのツールの原動力となっています。

-

**会議の文字起こし:**通話や会議の議事録を自動的に作成する。

-

**動画の字幕生成:**動画に字幕を生成し、アクセシビリティを向上させる。

-

**音声アシスタント:**スマートスピーカーやアプリ内音声コマンドの頭脳。

-

**カスタマーサポート用ボイスボット:**実際に人々を理解し応答できる自動電話システム。

しかし、時には派手なボイスボットに集中するあまり、より大きく、より簡単な成功の機会を逃してしまうことがあります。ほとんどのカスタマーサポートは、依然としてメールやライブチャットで行われています。これらのテキストベースのチャネルを自動化することで、人々が迅速かつ正確な回答を得るという全く同じ問題を解決しながら、はるかに速い投資対効果を得ることができます。

複雑な音声システムをゼロから構築する代わりに、eesel AIのようなプラットフォームを使えば、チームや顧客がすでにいる場所でAIを活用できます。

- 即座にあなたのビジネスを理解します: eesel AIは、過去のサポートチケット、ヘルプセンターの記事、そしてConfluenceやGoogle Docsのような場所にある社内ドキュメントでトレーニングします。初日からあなたのブランドの声や解決策を学習します。これはカスタムボットを構築するのに何年もかかるようなことです。

- 安全にテストできます: AIを顧客との対話に使う前に、その性能を確かめたいと思うのは当然です。eesel AIにはシミュレーションモードがあり、過去の何千ものチケットでテストすることができるため、どれだけのパフォーマンスを発揮するかを正確に確認できます。

- 常に管理下にあります: どの質問をAIに処理させ、いつ人間に会話を引き継ぐかを決めることができます。これにより、段階的に展開し、優れた顧客体験を維持することができます。

OpenAI WhisperとTTS APIの価格

もしAPIを直接使用することが正しい選択だと判断した場合は、その費用を知っておくことが重要です。OpenAIの価格はすべて従量課金制です。

-

Whisper APIの価格: Whisper APIの料金は、音声1分あたり$0.006で、秒単位で切り上げられます。したがって、1時間の会議を文字起こしすると約$0.36かかります。

-

TTS APIの価格: Text-to-Speech APIは、標準モデルで1,000文字あたり$0.015、高品質のHDモデルで1,000文字あたり$0.030です。

これらの料金は低く見えますが、トラフィックが多い場合はコストが膨らむ可能性があります。さらに重要なのは、この価格には、答えを導き出すためのAIモデルの呼び出しコストや、すべてを稼働させ続けるための開発者やサーバーのコストが含まれていないことです。

技術だけでなく、解決策に焦点を当てる

以上です。Whisper(音声認識)とTTS(音声合成)は、連携して音声インターフェースを実現する強力なツールです。Whisperが聞き、TTSが話す。これらは競合するものではなく、一つの全体を構成する2つの部分なのです。

しかし、これらの生の部品からビジネスソリューションを構築するのは、本格的なプロジェクトです。それには多くの技術的スキル、継続的な維持管理、そして開発時間への大きな投資が必要です。

カスタマーサポートの改善だけを目指す企業にとっては、もっと直接的な道筋があることが多いです。チームがすでにほとんどの時間を費やしているテキストベースの会話を自動化することで、カスタム音声システムの煩わしさなしに大きな成果を得ることができます。

eesel AIのようなプラットフォームは、既存のツールに接続し、会社のナレッジから学習し、正しい方法でサポートを自動化するために必要なコントロールを提供する、すぐに使えるソリューションを提供します。

この仕事のために構築されたAIサポートプラットフォームの能力を確かめてみませんか?eesel AIを無料でお試しいただければ、数分で運用を開始できます。

よくある質問

根本的な違いは方向性です。Whisperは話し言葉の音声を書き言葉のテキストに変換し(音声認識)、システムの「耳」として機能します。逆に、TTS APIは書き言葉のテキストを話し言葉の音声に変換し(音声合成)、システムの「声」として機能します。

これらは競合するものではなく、正反対の補完的な機能を果たします。通常、完全な双方向の音声対話のためには両方を組み合わせて使用し、Whisperが入力、TTS APIが出力を担当します。

主な要素には、精度(例:単語誤り率)、速度(リアルタイムアプリケーションのための遅延)、コスト(API価格に加えて隠れたインフラおよび開発費用)、そして話者識別やカスタム語彙などの追加機能が含まれます。

はい、目的に応じて単独で使用することができます。例えば、Whisper単体は会議の録音を文字起こしするのに最適ですし、TTS APIは記事を読み上げるために単独で使用できます。しかし、完全な対話型音声アシスタントには両方が必要です。

会議の文字起こし、動画の字幕生成、対話型音声アシスタント(例:スマートスピーカー)、自動化されたカスタマーサポート用ボイスボットなどのアプリケーションを支えています。これらは、人間のような音声を理解し生成する必要があるあらゆるシステムの核となります。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.