Tout ce qui est à commande vocale semble être la nouvelle norme, des assistants de réunion qui prennent des notes pour vous aux commandes vocales qui gèrent votre liste de courses. Mais la technologie derrière tout cela peut ressembler à un véritable casse-tête d'acronymes. Vous entendrez souvent parler des API Whisper et Text-to-Speech (TTS) d'OpenAI, et bien qu'elles semblent liées, elles font en réalité des tâches opposées.

Comprendre la différence est assez important pour quiconque souhaite créer des applications avec des fonctionnalités vocales ou simplement rendre son entreprise un peu plus fluide grâce à l'IA. Ce guide expliquera exactement ce que font les API Whisper et TTS, en quoi elles sont différentes, comment elles fonctionnent ensemble, et vous aidera à déterminer celle dont vous avez réellement besoin.

Le cœur du débat Whisper vs API TTS : Reconnaissance vocale vs synthèse vocale

Avant d'entrer dans une comparaison directe, posons les bases. Ces deux technologies sont en réalité les deux faces d'une même pièce : l'une sert à écouter, l'autre à parler.

Qu'est-ce que Whisper d'OpenAI ?

Whisper d'OpenAI est ce qu'on appelle un modèle de reconnaissance vocale (speech-to-text). Son unique tâche est de prendre de l'audio parlé et de le transformer en texte écrit. C'est aussi simple que cela.

Il a été entraîné sur 680 000 heures massives d'audio provenant de tout le web, c'est pourquoi il est si performant pour comprendre différents accents, filtrer le bruit de fond et même saisir le jargon technique. Il peut transcrire 98 langues différentes et même en traduire beaucoup en anglais. Vous pouvez l'obtenir en tant que modèle open-source à exécuter sur votre propre matériel ou utiliser l'API payante, qui est beaucoup plus facile à intégrer dans vos projets.

En gros, Whisper représente les « oreilles » d'un système d'IA.

Qu'est-ce qu'une API TTS ?

Une API de synthèse vocale (Text-to-Speech, ou TTS) fait tout le contraire. Elle prend du texte écrit et le transforme en audio parlé. OpenAI a sa propre API TTS qui peut créer des voix très humaines à partir d'un bloc de texte. Ces systèmes sont conçus pour paraître naturels, avec le bon rythme et le ton que l'on attendrait d'une personne.

Vous pouvez considérer une API TTS comme la « voix » d'un système d'IA. C'est la technologie qui permet à votre GPS de vous donner des instructions virage par virage, à votre téléphone de lire un article à voix haute, ou à un assistant IA de vous donner une réponse verbale.

Comment les API Whisper et TTS fonctionnent ensemble

Voici le principal point que les gens ne comprennent pas dans le débat « Whisper vs API TTS » : on ne choisit pas l'un au détriment de l'autre. Ce sont des collaborateurs. On les utilise à différentes étapes d'un processus pour créer une boucle de conversation complète.

Imaginons que vous développiez un assistant vocal. Voici comment les deux collaboreraient :

-

Vous parlez : Vous posez une question, comme : « Quelles sont vos heures d'ouverture ? »

-

Whisper écoute : Le système capture l'audio et Whisper le transcrit en une simple chaîne de texte : « Quelles sont vos heures d'ouverture ? »

-

L'application réfléchit : Votre application (ou un grand modèle de langage) reçoit ce texte, comprend ce que vous voulez et trouve la réponse. La réponse est également du texte : « Nous sommes ouverts de 9h à 17h, du lundi au vendredi. »

-

L'API TTS parle : Enfin, l'API TTS prend cette réponse textuelle et la transforme en un fichier audio d'une voix de synthèse prononçant les mots, afin que vous puissiez entendre la réponse.

Comme vous pouvez le voir, ils fonctionnent en séquence. Ils ne sont pas interchangeables. L'audio devient du texte, le texte est traité, puis la réponse textuelle redevient de l'audio.

Le vrai défi n'est pas de choisir entre les deux, mais de les intégrer harmonieusement et de construire toute la logique intermédiaire. Cela prend généralement beaucoup de temps de développement, une maintenance continue, et il faut faire attention aux erreurs ou aux « hallucinations » où l'IA comprend mal quelque chose ou invente simplement une mauvaise réponse.

Choisir le bon outil pour la tâche

Lorsque vous cherchez à construire quelque chose avec la voix, vous devez examiner quelques éléments clés. Bien que Whisper soit un choix de premier ordre pour la reconnaissance vocale, il existe d'autres acteurs comme Deepgram, Google et Amazon.

Voici les facteurs auxquels vous voudrez réfléchir :

-

Précision : À quel point le modèle comprend-il réellement ce qui est dit ? Ceci est souvent mesuré par le « Taux d'Erreur de Mot » (Word Error Rate, ou WER), et un score plus bas est meilleur. Whisper est réputé pour être très précis, mais rien n'est parfait à 100 %. Quelques mots erronés peuvent complètement dérouter votre application.

-

Vitesse : En combien de temps obtenez-vous une réponse ? Pour une conversation en temps réel, vous avez besoin d'une latence très faible. Mais si vous transcrivez simplement un long enregistrement de réunion après coup, la vitesse n'est pas aussi critique.

-

Coût : La tarification de l'API est généralement calculée par minute d'audio que vous traitez. Mais n'oubliez pas les « coûts cachés ». Si vous optez pour la voie open-source avec Whisper, vous aurez besoin de serveurs puissants, de quelqu'un pour les maintenir, et d'heures de développement, ce qui peut rapidement s'additionner.

-

Fonctionnalités supplémentaires : Avez-vous besoin de choses comme l'identification de différents locuteurs, la transcription en temps réel, ou un vocabulaire personnalisé pour le jargon de votre secteur ? Les API de base pourraient ne pas les avoir.

C'est là que construire à partir de zéro peut vraiment devenir un casse-tête. Pour de nombreuses entreprises, en particulier dans le support client, l'objectif principal est simplement de répondre plus rapidement aux questions des clients. Un robot vocal personnalisé est une façon de le faire, mais c'est un projet énorme et à long terme.

Une voie plus directe consiste souvent à utiliser une plateforme qui résout le problème commercial réel sans la courbe d'apprentissage abrupte. Par exemple, un outil comme eesel AI est conçu pour automatiser le support en se connectant directement au service d'assistance et aux bases de connaissances que vous utilisez déjà. Il contourne tout le désordre du pipeline STT/TTS en se concentrant sur le texte, où se trouvent de toute façon la plupart des tickets de support. Cela vous permet d'être opérationnel en quelques minutes, pas en quelques mois.

| Caractéristique | Création avec des API brutes (Whisper/TTS) | Utilisation d'une plateforme comme eesel AI |

|---|---|---|

| Temps de configuration | De semaines à des mois de développement | Minutes, avec des intégrations en un clic |

| Source de connaissances | Nécessite un codage personnalisé pour chaque source | Se connecte instantanément aux services d'assistance, documents, etc. |

| Maintenance | Temps de développement continu et coûts de serveur | Gérée par la plateforme |

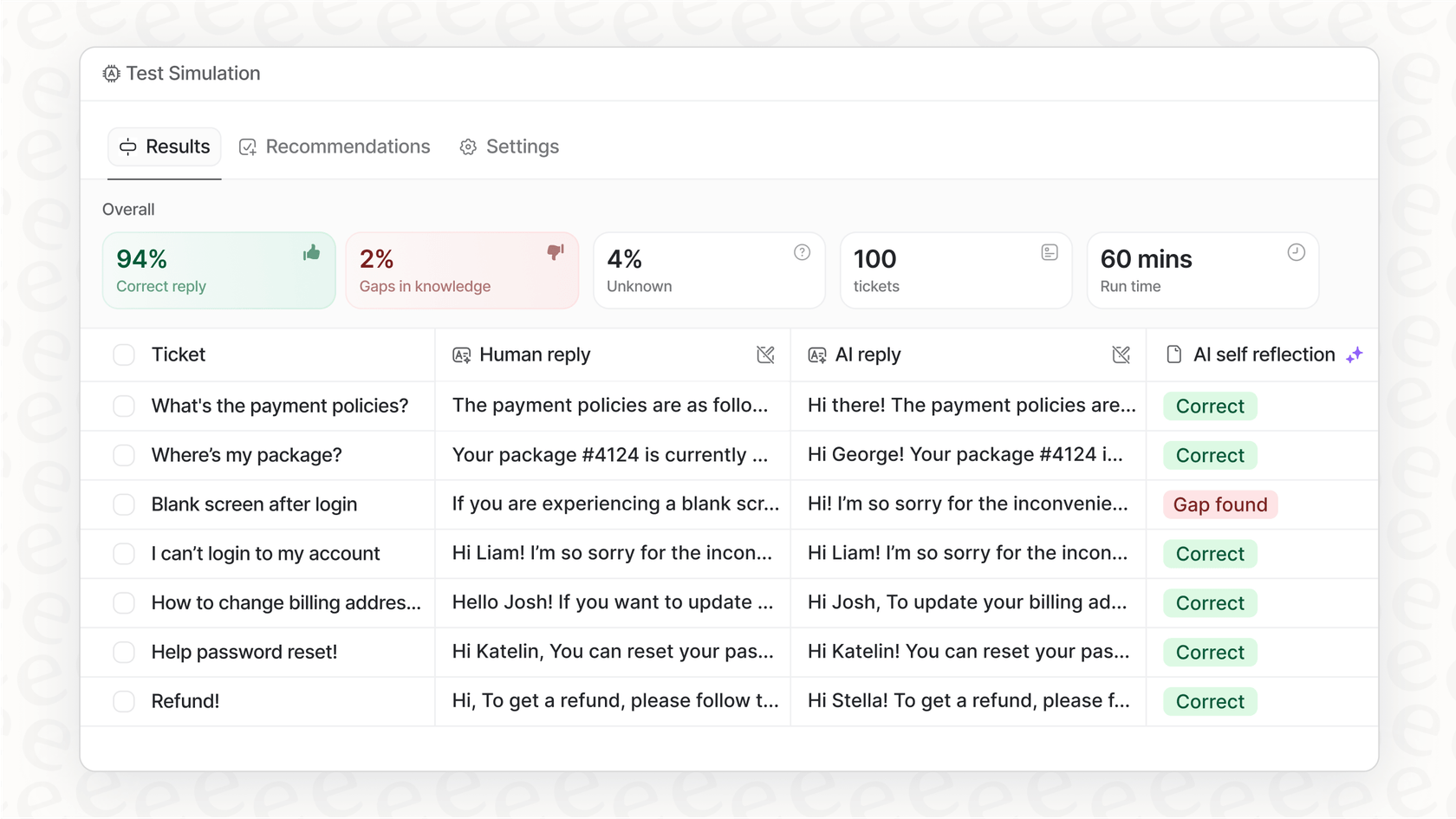

| Tests | Difficile de simuler les performances en conditions réelles | Simulation robuste sur les tickets historiques |

| Objectif principal | Implémentation technique des E/S vocales | Résolution du problème commercial (automatisation du support) |

Exemples concrets d'utilisation des API Whisper et TTS

Les API Whisper et TTS sont les moteurs de nombreux outils que nous utilisons déjà tous les jours :

-

Transcription de réunions : Créer automatiquement un résumé écrit des appels et des réunions.

-

Sous-titrage de vidéos : Générer des sous-titres pour les vidéos afin de les rendre plus accessibles.

-

Assistants vocaux : Le cerveau derrière les enceintes intelligentes et les commandes vocales intégrées aux applications.

-

Bots vocaux pour le support client : Des systèmes téléphoniques automatisés qui peuvent réellement comprendre et répondre aux gens.

Mais parfois, se concentrer sur un robot vocal sophistiqué signifie que l'on passe à côté d'une victoire plus grande et plus facile. La plupart du support client se fait encore par e-mail et par chat en direct. L'automatisation de ces canaux textuels peut vous offrir un retour sur investissement beaucoup plus rapide tout en résolvant exactement le même problème : fournir aux gens des réponses rapides et précises.

Au lieu de construire un système vocal compliqué à partir de zéro, une plateforme comme eesel AI vous permet d'utiliser l'IA là où votre équipe et vos clients se trouvent déjà.

- Il connaît instantanément votre domaine : eesel AI s'entraîne sur vos anciens tickets de support, articles de centre d'aide et documents internes dans des endroits comme Confluence ou Google Docs. Il adopte la voix et les solutions de votre marque dès le premier jour, quelque chose qui prendrait une éternité à intégrer dans un bot personnalisé.

- Vous pouvez le tester en toute sécurité : Vous voulez absolument savoir si une IA fonctionne avant de la laisser parler à vos clients. eesel AI dispose d'un mode de simulation qui vous permet de la tester sur des milliers de vos tickets passés, afin que vous puissiez voir exactement comment elle se comportera.

- Vous gardez toujours le contrôle : Vous décidez des questions que l'IA traite et quand il est temps de passer une conversation à un humain. Cela vous permet de la déployer progressivement et de maintenir une excellente expérience client.

Tarifs des API Whisper et TTS d'OpenAI

Si vous décidez que l'utilisation directe des API est la bonne solution, il est bon de savoir combien cela coûtera. La tarification d'OpenAI est entièrement basée sur l'utilisation.

-

Tarif de l'API Whisper : L'API Whisper coûte 0,006 $ par minute d'audio, arrondi à la seconde la plus proche. Ainsi, la transcription d'une réunion d'une heure vous coûterait environ 0,36 $.

-

Tarif de l'API TTS : L'API de synthèse vocale coûte 0,015 $ par 1 000 caractères pour le modèle standard et 0,030 $ par 1 000 caractères pour le modèle HD de qualité supérieure.

Bien que ces tarifs semblent bas, les coûts peuvent s'accumuler si vous avez beaucoup de trafic. Plus important encore, cette tarification n'inclut pas le coût des appels au modèle d'IA pour trouver les réponses, ni les coûts de développement et de serveur pour maintenir le tout en fonctionnement.

Concentrez-vous sur la solution, pas seulement sur la technologie

Voilà, vous savez tout. Whisper (reconnaissance vocale) et TTS (synthèse vocale) sont des outils puissants qui travaillent ensemble pour donner vie aux interfaces vocales. Whisper écoute, et TTS parle. Ce sont deux parties d'un même tout, pas des concurrents.

Mais construire une solution d'entreprise à partir de ces éléments bruts est un projet sérieux. Cela demande beaucoup de compétences techniques, une maintenance continue et un investissement important en temps de développement.

Pour les entreprises qui cherchent simplement à améliorer leur support client, il existe souvent une voie beaucoup plus directe. En automatisant les conversations textuelles où votre équipe passe déjà le plus clair de son temps, vous pouvez obtenir d'excellents résultats sans les tracas d'un système vocal personnalisé.

Des plateformes comme eesel AI offrent une solution prête à l'emploi qui se connecte à vos outils existants, apprend des connaissances de votre entreprise et vous donne le contrôle dont vous avez besoin pour automatiser le support de la bonne manière.

Prêt à voir ce qu'une plateforme de support IA conçue pour cette tâche peut faire ? Essayez eesel AI gratuitement et vous pourrez être opérationnel en quelques minutes.

Foire aux questions

La différence fondamentale est leur directionnalité : Whisper convertit l'audio parlé en texte écrit (reconnaissance vocale), agissant comme les « oreilles » du système. Inversement, une API TTS transforme le texte écrit en audio parlé (synthèse vocale), servant de « voix » au système.

Elles collaborent séquentiellement pour créer une boucle conversationnelle. Whisper transcrit d'abord la parole de l'utilisateur en texte, qu'une application traite ensuite pour formuler une réponse textuelle. Enfin, l'API TTS reconvertit cette réponse textuelle en audio parlé pour l'utilisateur.

Ce ne sont pas des concurrents et elles remplissent des fonctions opposées et complémentaires. Vous utilisez généralement les deux conjointement pour une interaction vocale bidirectionnelle complète, Whisper gérant l'entrée et une API TTS gérant la sortie.

Les facteurs clés incluent la précision (par ex., le taux d'erreur de mot), la vitesse (latence pour les applications en temps réel), le coût (tarification de l'API plus les dépenses cachées d'infrastructure et de développement), et des fonctionnalités supplémentaires comme l'identification du locuteur ou les vocabulaires personnalisés.

Oui, vous pouvez les utiliser indépendamment selon votre objectif. Par exemple, Whisper seul est parfait pour transcrire des enregistrements de réunion, tandis qu'une API TTS peut être utilisée seule pour lire des articles à voix haute. Un assistant vocal conversationnel complet, cependant, nécessite les deux.

Elles alimentent des applications comme la transcription de réunions, le sous-titrage de vidéos, les assistants vocaux interactifs (par ex., les enceintes intelligentes) et les robots vocaux automatisés pour le support client. Elles constituent le cœur de tout système qui a besoin de comprendre et de générer une parole de type humain.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.