Haben Sie schon einmal eine Frage in einen KI-Chatbot eingegeben und diese leichte, unangenehme Pause gespürt, bevor er beginnt, eine Antwort auszuspucken? Es ist eine winzige Verzögerung, aber sie reicht aus, um Sie daran zu erinnern, dass Sie mit einer Maschine sprechen. Ein Unternehmen namens Groq hat es sich zur Aufgabe gemacht, diese Pause vollständig zu beseitigen und KI-Interaktionen so flüssig und natürlich wie ein Gespräch mit einem Menschen zu gestalten.

Während sich viele Unternehmen in der KI-Welt darauf konzentrieren, größere und komplexere Modelle zu entwickeln, widmet sich Groq einem anderen, ebenso wichtigen Problem: der Geschwindigkeit. Sie machen KI nicht nur ein bisschen schneller; sie streben ein Leistungsniveau an, das verändert, was mit Echtzeit-KI überhaupt möglich ist.

Wenn Sie den Namen schon einmal gesehen und sich gefragt haben, was es mit der ganzen Aufregung auf sich hat, sind Sie hier genau richtig. Wir werden aufschlüsseln, was Groq ist, wie seine einzigartige Technologie funktioniert, für wen sie gedacht ist und welche realen Einschränkungen Sie kennen sollten.

Was ist Groq?

Klären wir zunächst die Grundlagen. Groq ist ein amerikanisches KI-Chip-Unternehmen, das von Jonathan Ross gegründet wurde, einem der Köpfe hinter Googles eigenem KI-Chip, der Tensor Processing Unit (TPU). Anstatt zu versuchen, alles zu machen, konzentriert sich Groq auf eine bestimmte Sache: die Entwicklung von Hardware für die KI-Inferenz.

Was ist also diese „Inferenz“, auf die sie sich so sehr konzentrieren? Stellen Sie es sich als den „leistenden“ Teil der KI vor. Nachdem ein riesiges KI-Modell mit Unmengen von Daten trainiert wurde, ist die Inferenz der Prozess, dieses Modell tatsächlich zu nutzen, um eine Antwort zu erhalten. Jedes Mal, wenn Sie einem Chatbot eine Frage stellen oder eine KI-gestützte Empfehlung erhalten, ist das eine Inferenzaufgabe.

Und nein, bevor Sie fragen, das hat nichts mit Elon Musks „Grok“-KI-Modell zu tun. Andere Schreibweise, völlig unterschiedliche Unternehmen. Das ist eine häufige Verwechslung, also lassen Sie uns das gleich aus dem Weg räumen. Groqs Ziel ist es, die KI-Inferenz unglaublich schnell und erschwinglich zu machen, was die Tür zu einer ganz neuen Welle von Echtzeit-KI-Tools öffnen könnte.

Die Technologie hinter Groq: Wie sie rekordverdächtige Geschwindigkeiten erreicht

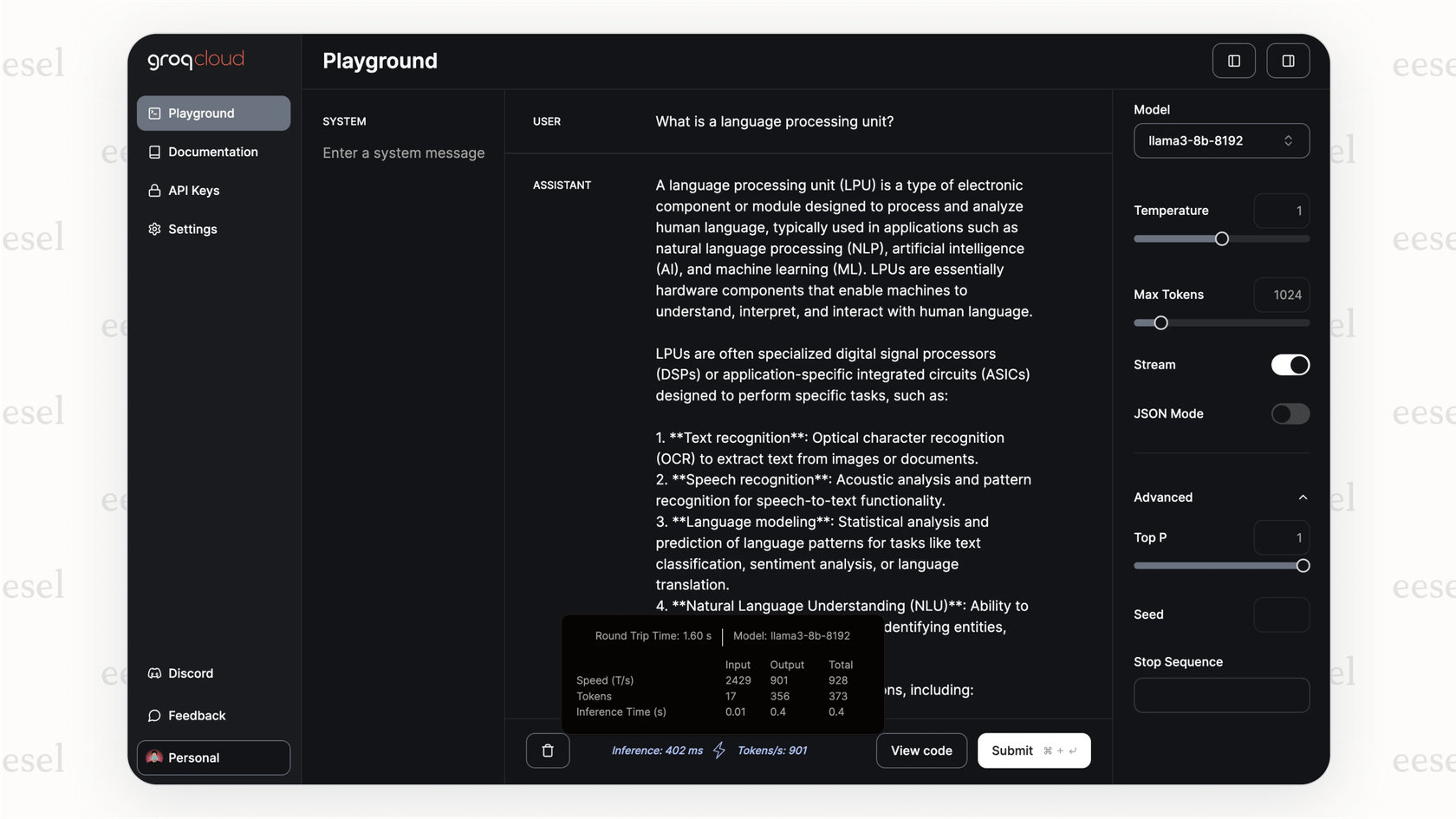

Wie also schafft Groq diese unglaubliche Geschwindigkeit? Es handelt sich nicht nur um eine geringfügige Anpassung bestehender Technologie; es ist eine völlig andere Denkweise über das Problem. Die Magie liegt in ihrem speziell entwickelten Chip, der Language Processing Unit oder LPU.

Im Gegensatz zu einer GPU (Graphics Processing Unit), die eher ein leistungsstarkes Allzweckwerkzeug ist, das für KI angepasst wurde, wurde die LPU von Anfang an für einen einzigen Zweck entwickelt: Sprachmodelle so schnell wie menschenmöglich auszuführen.

Der eigentliche Trick liegt darin, wie sie den Speicher handhaben. Die meisten Chips, mit denen Sie vertraut sind, wie GPUs, verwenden einen Speichertyp namens DRAM. Stellen Sie sich DRAM wie ein riesiges Bibliotheksregal vor. Es kann eine Menge Bücher (Daten) aufnehmen, aber Sie müssen hingehen, um zu holen, was Sie brauchen, was ein wenig Zeit in Anspruch nimmt.

Groq entschied sich für einen anderen Weg und verwendet etwas namens SRAM. SRAM ist, als hätten Sie genau das Buch, das Sie brauchen, direkt auf Ihrem Schreibtisch geöffnet. Der Zugriff ist sofortig, aber Ihr Schreibtisch kann nur wenige Bücher gleichzeitig aufnehmen. Dies ist derselbe superschnelle Speicher, der für winzige Caches auf dem Hauptprozessor Ihres Computers verwendet wird. Er ist unglaublich schnell, was bedeutet, dass die LPU fast nie auf Daten warten muss.

graph TD subgraph Traditional GPU A[GPU Core] -->|Request Data| B(DRAM Memory); B -->|Data Retrieval with Latency| A; end subgraph Groq LPU C[LPU Core] -->|Instant Data Access| D(SRAM Memory); D -->|No Latency| C; end style B fill:#f9f,stroke:#333,stroke-width:2px style D fill:#ccf,stroke:#333,stroke-width:2px

Aber, wie bei den meisten Dingen im Leben, gibt es einen Haken. Einen großen. SRAM ist unglaublich teuer und speichert nicht viele Daten. Während eine einzelne High-End-GPU einen großen Teil eines KI-Modells in ihrem Speicher ablegen kann, kann eine LPU nur einen winzigen Bruchteil aufnehmen. Um ein modernes Sprachmodell auszuführen, muss Groq Hunderte, manchmal Tausende dieser LPU-Chips miteinander verketten. Diese Anordnung verleiht ihrer Hardware ihre blitzschnellen Inferenzfähigkeiten, macht es aber auch wahnsinnig teuer, sie selbst zu bauen.

Anwendungsfälle und Vorteile: Für wen ist Groq?

Okay, es ist also lächerlich schnell. Aber wer braucht diese Art von Geschwindigkeit wirklich? Es stellt sich heraus, eine Menge Leute. Überall dort, wo eine Verzögerung das Erlebnis ruinieren kann, hat Groq einen Platz.

Hier sind einige Bereiche, in denen diese Geschwindigkeit einen riesigen Unterschied macht:

-

Echtzeit-Kundensupport: Anstelle eines Chatbots, der sich anfühlt, als würden Sie ein langsames Webformular ausfüllen, erhalten Sie einen, der mit einem echten Gespräch mithalten kann. Dies eliminiert die frustrierenden Pausen, die Kunden dazu bringen, aufzugeben und nach einem menschlichen Mitarbeiter zu fragen.

-

Live-Datenanalyse: Denken Sie an Hochdruckbereiche wie das Finanzwesen oder sogar die Formel 1, wo Groq eine Partnerschaft mit McLaren hat. Wenn Sie Daten analysieren und in Sekundenbruchteilen Entscheidungen treffen müssen, ist diese sofortige Reaktionszeit ein ernsthafter Vorteil.

-

Interaktive Anwendungen: Für jeden, der KI-gestützte Programmierassistenten oder kreative Werkzeuge verwendet, ist die Geschwindigkeit des Feedbacks alles. Wenn die KI mit Ihrem Gedankengang Schritt halten kann, fühlt sie sich weniger wie ein Werkzeug und mehr wie ein Mitarbeiter an.

Für Unternehmen und Entwickler, die ihre API nutzen, sind die Vorteile ziemlich einfach:

-

Unglaubliche Geschwindigkeit: Groq kann Hunderte von Tokens pro Sekunde generieren und so einen Gesprächsfluss erzeugen, der anderswo kaum zu finden ist.

-

Potenzial für niedrigere Kosten bei großem Umfang: Während der Kauf der Hardware für die meisten unerreichbar ist, könnte die Effizienz der LPU zu niedrigeren Kosten pro Anfrage führen, wenn Ihr Unternehmen eine sehr große Anzahl von KI-Anfragen stellt.

-

Einfach zu übernehmen: Sie haben ihre API mit den Standards von OpenAI kompatibel gemacht, was ein kluger Schachzug war. Das bedeutet, dass Entwickler ihre Apps oft durch Ändern von nur wenigen Codezeilen auf Groq umstellen können.

Aber rohe Geschwindigkeit ist nur die halbe Miete. Eine schnelle KI, die die falsche Antwort gibt, ist nur ein schneller Weg, um Kunden zu frustrieren. Für etwas wie den Kundensupport braucht diese Geschwindigkeit Intelligenz und Führung. Hier kommt eine Plattform wie eesel AI ins Spiel. Sie fungiert als das Gehirn, das dem superschnellen Motor sagt, was er tun soll, indem es ihn mit den richtigen Informationen verbindet und seine Aktionen lenkt.

Einschränkungen und Überlegungen zur Verwendung von Groq

Nun ist nicht alles Gold, was glänzt. Groqs Ansatz ist hochspezialisiert, und das bringt einige ernsthafte Dinge mit sich, die man bedenken sollte, bevor man einsteigt.

Der hohe Preis der Groq-Hardware

Das ist die größte Hürde. Sofern Sie nicht ihre Cloud-API verwenden, sind die Kosten für die Einrichtung Ihrer eigenen Groq-Hardware schwindelerregend. Wir reden hier nicht von ein wenig teuer; wir reden von „Sie brauchen ein Multi-Millionen-Dollar-Budget“, nur um anzufangen. Dies macht das Self-Hosting für fast jeden außer den größten Unternehmen praktisch unerreichbar.

Begrenzte Modellauswahl auf GroqCloud

Wenn Sie die GroqCloud-API verwenden, müssen Sie aus den Modellen wählen, die sie unterstützen. Sie können nicht einfach Ihr Lieblings-Open-Source-Modell nehmen und es auf ihrem System ausführen. Dies ist ein entscheidender Unterschied zur Verwendung von Allzweck-Cloud-GPUs, die Ihnen viel mehr Freiheit zum Experimentieren geben.

Groq ist für Inferenz, und nur für Inferenz

Diese LPU-Chips sind für eine Aufgabe gebaut: KI-Modelle schnell auszuführen. Sie sind nicht dafür konzipiert, ein neues Modell von Grund auf zu trainieren oder gar ein bestehendes zu optimieren. Das bedeutet, dass jedes Unternehmen, das Groq verwendet, immer noch Zugang zu traditioneller GPU-Hardware für seine Modellentwicklung benötigt, was es zu einem spezialisierten Werkzeug in einem größeren Werkzeugkasten macht, nicht zu einem vollständigen Ersatz.

Dies unterstreicht, warum es klug ist, Ihre KI-Tools auf einer flexibleren Plattform aufzubauen. Sie möchten nicht an einen einzigen Motor gebunden sein. Stellen Sie es sich so vor: Während Groq der Formel-1-Motor sein mag, den Sie für die Geschwindigkeit verwenden, ist eine Plattform wie eesel AI das Auto selbst. Sie ermöglicht es Ihnen, sich mit Ihrem Helpdesk wie Zendesk oder [Intercom] zu verbinden, Wissen aus Quellen wie Confluence zu ziehen und gibt Ihnen die Steuerelemente, um die Persönlichkeit und das Verhalten der KI zu lenken. Sie können es sogar an vergangenen Support-Tickets testen, um zu sehen, wie es sich verhalten würde, bevor es jemals mit einem echten Kunden spricht.

Groq-Preise: API vs. On-Premise

Also, wie viel kostet das alles? Groq hat zwei Hauptzahlungsmodelle, und sie sind Welten voneinander entfernt.

Die GroqCloud API

Dies ist der Weg, den die meisten Leute einschlagen werden. Sie zahlen nach Verbrauch, basierend auf der Anzahl der verarbeiteten Tokens (Wortteile). Es ist das Standardmodell für KI-APIs.

| Modell | Eingabepreis (pro 1 Mio. Tokens) | Ausgabepreis (pro 1 Mio. Tokens) |

|---|---|---|

| Llama3-8b-8192 | 0,05 $ | 0,10 $ |

| Llama3-70b-8192 | 0,59 $ | 0,79 $ |

| Mixtral-8x7b-32768 | 0,24 $ | 0,24 $ |

| Gemma-7b-it | 0,10 $ | 0,10 $ |

Hinweis: Die Preise können sich ändern, daher ist es immer am besten, die offizielle Groq-Preisseite für die aktuellsten Raten zu überprüfen.

On-Premise-Bereitstellung von Groq

Dies ist die „Wenn Sie fragen müssen, können Sie es sich wahrscheinlich nicht leisten“-Option. Sie ist für riesige Unternehmen mit sehr spezifischen Sicherheits- oder Leistungsanforderungen gedacht, die den Aufbau eines eigenen Groq-Clusters rechtfertigen. Obwohl es keine öffentliche Preisliste gibt, deuten Branchengerüchte darauf hin, dass Sie mit Millionen von Dollar für eine Basiseinrichtung rechnen müssen, wobei groß angelegte Implementierungen noch viel, viel mehr kosten.

Dieses Video zeigt, wie man mit dem wahnsinnig schnellen Llama-3-Modell über die Groq-API startet.

Groq: Geschwindigkeit ist nur der Anfang

Also, was ist das Fazit zu Groq? Sie haben ein sehr spezifisches Problem gefunden, die Geschwindigkeit der KI-Inferenz, und alles darangesetzt, es zu lösen. Ihre LPU-Chips mit ihrem reinen SRAM-Design sind eine Klasse für sich, wenn es um Echtzeit-Antworten geht. Für jede App, die sich wirklich gesprächig anfühlen muss, ist Groq ein Name, den man kennen sollte.

Aber es ist kein Wundermittel für jedes KI-Problem. Die hohen Kosten für den Kauf der Hardware und die begrenzte Modellauswahl in ihrer API bedeuten, dass es ein spezialisiertes Werkzeug für eine spezialisierte Aufgabe ist. Für die meisten von uns wird Groq der Motor hinter einer bestimmten Funktion sein, die blitzschnell sein muss.

Dennoch wird der Bedarf an sofortiger KI nur noch größer werden, da sie sich in immer mehr unserer Werkzeuge einarbeitet. Groq ist definitiv ein Unternehmen, das man im Auge behalten sollte, aber um diese Geschwindigkeit effektiv zu nutzen, braucht es mehr als nur einen schnellen Chip.

Nutzen Sie die Geschwindigkeit von Groq mit einem intelligenteren KI-Agenten

Schnelle Hardware ist großartig, aber im Kundensupport ist das eigentliche Ziel, schnelle, präzise Antworten zu erhalten, die tatsächlich Probleme lösen. Sie benötigen ein System, das diese rohe Geschwindigkeit aufnehmen und in etwas wirklich Hilfreiches kanalisieren kann.

Genau dafür haben wir eesel AI entwickelt. Es ist eine Plattform, die es Ihnen ermöglicht, Ihre Wissensquellen zu verbinden, das Verhalten Ihres KI-Agenten fein abzustimmen und ihn in Minuten statt Monaten einsatzbereit zu machen. Wir geben Ihnen die Kontrolle und die Testwerkzeuge, die Sie benötigen, um rohe KI-Geschwindigkeit in messbare Ergebnisse umzuwandeln, wie zufriedenere Kunden und weniger Support-Tickets.

Bereit, einen KI-Support-Agenten zu bauen, der sowohl unglaublich schnell als auch vollständig unter Ihrer Kontrolle ist? Starten Sie noch heute Ihre kostenlose Testversion mit eesel AI.

Häufig gestellte Fragen

Groq ist ein amerikanisches KI-Chip-Unternehmen, das sich auf die Herstellung von Hardware für extrem schnelle KI-Inferenz spezialisiert hat. Seine Mission ist es, die Latenz (Pause) bei KI-Interaktionen zu eliminieren, damit sie sich augenblicklich und natürlich anfühlen.

Groq erreicht seine Geschwindigkeit durch seine speziell entwickelte Language Processing Unit (LPU), die speziell für Sprachmodelle konzipiert wurde. Im Gegensatz zu GPUs verwenden LPUs superschnellen SRAM-Speicher für sofortigen Datenzugriff, wodurch Wartezeiten minimiert und die Verarbeitungsgeschwindigkeit maximiert wird.

Groq ist am vorteilhaftesten für Anwendungen, die Echtzeit-KI-Antworten erfordern, wie z.B. interaktiver Kundensupport, Live-Datenanalyse in kritischen Bereichen wie dem Finanzwesen und flüssige KI-gestützte kreative Werkzeuge. Seine Geschwindigkeit eliminiert frustrierende Verzögerungen und lässt die KI wie einen nahtlosen Mitarbeiter wirken.

Nein, Groq (mit einem 'q') ist ein völlig anderes Unternehmen als Elon Musks „Grok“-KI-Modell. Groq ist ein KI-Chip-Unternehmen, das sich auf Hardware für schnelle Inferenz konzentriert, während „Grok“ ein KI-Chatbot-Modell ist.

Zu den wesentlichen Einschränkungen gehören die extrem hohen Kosten für On-Premise-Groq-Hardware, was ihre Zugänglichkeit für die meisten Unternehmen einschränkt. Außerdem sind Sie bei Verwendung der GroqCloud-API auf die unterstützten Modelle beschränkt, und die Chips sind ausschließlich für die Inferenz und nicht für das Training von KI-Modellen vorgesehen.

Groq bietet zwei Hauptoptionen: die GroqCloud-API, bei der Sie nach Verbrauch basierend auf den verarbeiteten Tokens zahlen, was im Allgemeinen zugänglich ist. Für On-Premise-Lösungen von Groq sind die Kosten erheblich höher, oft im Millionen-Dollar-Bereich, und sind großen Unternehmen mit spezifischen Anforderungen vorbehalten.

Nein, die LPU-Chips von Groq sind speziell für die KI-Inferenz konzipiert und optimiert, also den Prozess der Verwendung eines trainierten Modells zur Generierung von Antworten. Sie sind nicht für das Training neuer Modelle von Grund auf oder für die Feinabstimmung bestehender Modelle gebaut; diese Aufgaben erfordern weiterhin traditionelle GPU-Hardware.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.