¿Alguna vez has escrito una pregunta a un chatbot de IA y has sentido esa ligera e incómoda pausa antes de que empiece a soltar una respuesta? Es un retraso mínimo, pero suficiente para recordarte que estás hablando con una máquina. Una empresa llamada Groq tiene la misión de eliminar esa pausa por completo, haciendo que las interacciones con la IA se sientan tan fluidas y naturales como hablar con una persona.

Mientras que muchas empresas en el mundo de la IA se centran en construir modelos más grandes y complejos, Groq está abordando un problema diferente pero igualmente importante: la velocidad. No solo están haciendo que la IA sea un poco más rápida; su objetivo es un nivel de rendimiento que cambia lo que es posible con la IA en tiempo real.

Si has visto aparecer el nombre y te has preguntado a qué se debe tanto alboroto, estás en el lugar correcto. Vamos a desglosar qué es Groq, cómo funciona su tecnología única, para quién es y algunas de las limitaciones del mundo real que deberías conocer.

¿Qué es Groq?

Vamos a lo básico. Groq es una empresa estadounidense de chips de IA fundada por Jonathan Ross, una de las mentes detrás del chip de IA personalizado de Google, la Unidad de Procesamiento Tensorial (TPU). En lugar de intentar hacerlo todo, Groq se centra en una cosa específica: construir hardware para la inferencia de IA.

Entonces, ¿qué es esto de la "inferencia" en lo que están tan centrados? Piénsalo como la parte de "ejecución" de la IA. Después de que un modelo de IA masivo ha sido entrenado con toneladas de datos, la inferencia es el proceso de usar realmente ese modelo para obtener una respuesta. Cada vez que le haces una pregunta a un chatbot o recibes una recomendación impulsada por IA, eso es una tarea de inferencia.

Y no, antes de que preguntes, esto no tiene nada que ver con el modelo de IA "Grok" de Elon Musk. Se escriben diferente y son empresas completamente distintas. Es una confusión común, así que aclaremos eso de una vez. El objetivo de Groq es hacer que la inferencia de IA sea increíblemente rápida y asequible, lo que podría abrir la puerta a una nueva ola de herramientas de IA en tiempo real.

La tecnología detrás de Groq: cómo alcanza una velocidad récord

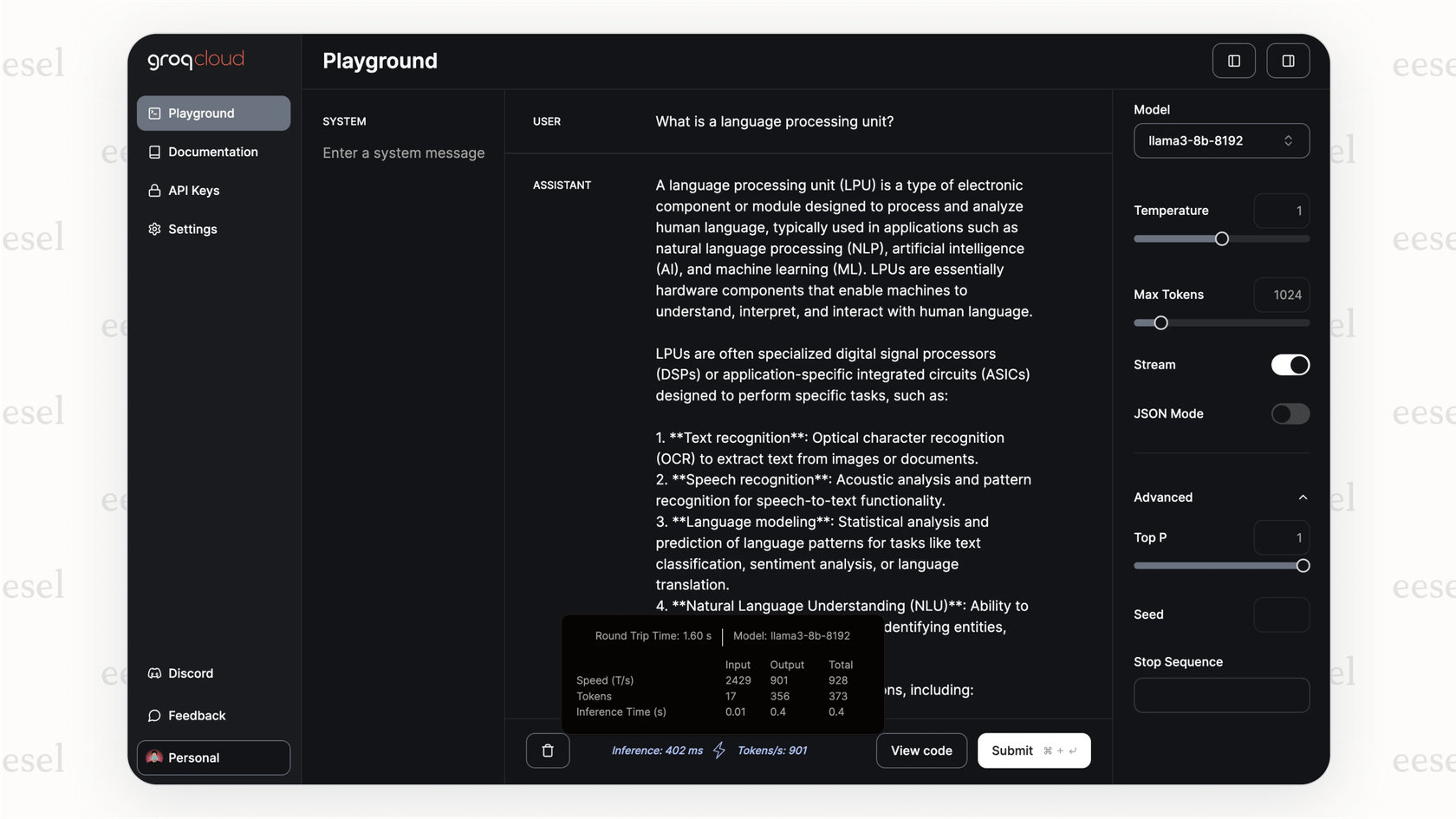

Entonces, ¿cómo logra Groq esta increíble velocidad? No es solo un pequeño ajuste a la tecnología existente; es una forma completamente diferente de pensar sobre el problema. La magia está en su chip diseñado a medida, la Unidad de Procesamiento de Lenguaje, o LPU.

A diferencia de una GPU (Unidad de Procesamiento Gráfico), que es una herramienta potente y de propósito general que se ha adaptado para la IA, la LPU fue diseñada desde el primer día con un único propósito: ejecutar modelos de lenguaje lo más rápido humanamente posible.

El verdadero truco está en cómo manejan la memoria. La mayoría de los chips con los que estás familiarizado, como las GPU, utilizan un tipo de memoria llamada DRAM. Piensa en la DRAM como una enorme estantería de biblioteca. Puede contener un montón de libros (datos), pero tienes que caminar hasta ella para coger lo que necesitas, lo que lleva un poco de tiempo.

Groq decidió tomar un camino diferente, usando algo llamado SRAM. La SRAM es como tener el libro exacto que necesitas abierto justo en tu escritorio. El acceso es instantáneo, pero tu escritorio solo puede albergar unos pocos libros a la vez. Esta es la misma memoria superrápida que se usa para los pequeños cachés en el procesador principal de tu ordenador. Es increíblemente rápida, lo que significa que la LPU casi nunca tiene que esperar por los datos.

graph TD subgraph Traditional GPU A[GPU Core] -->|Request Data| B(DRAM Memory); B -->|Data Retrieval with Latency| A; end subgraph Groq LPU C[LPU Core] -->|Instant Data Access| D(SRAM Memory); D -->|No Latency| C; end style B fill:#f9f,stroke:#333,stroke-width:2px style D fill:#ccf,stroke:#333,stroke-width:2px

Pero, como con la mayoría de las cosas en la vida, hay una trampa. Una grande. La SRAM es increíblemente cara y no almacena muchos datos. Mientras que una sola GPU de gama alta puede almacenar una gran parte de un modelo de IA en su memoria, una LPU solo puede contener una fracción mínima. Para ejecutar un modelo de lenguaje moderno, Groq tiene que encadenar cientos, a veces miles, de estos chips LPU. Esta configuración es lo que le da a su hardware sus capacidades de inferencia ultrarrápidas, pero también hace que sea increíblemente caro construirlo tú mismo.

Casos de uso y beneficios: ¿para quién es Groq?

Vale, es ridículamente rápido. Pero, ¿quién necesita realmente este tipo de velocidad? Resulta que mucha gente. En cualquier lugar donde un retraso pueda arruinar la experiencia, Groq tiene su lugar.

Aquí hay algunos ámbitos donde esta velocidad marca una gran diferencia:

-

Soporte al cliente en tiempo real: En lugar de un chatbot que se siente como si estuvieras rellenando un formulario web lento, obtienes uno que puede seguir el ritmo de una conversación real. Esto elimina las pausas frustrantes que hacen que los clientes se rindan y pidan hablar con un agente humano.

-

Análisis de datos en vivo: Piensa en campos de alta presión como las finanzas o incluso las carreras de Fórmula 1, donde Groq tiene una asociación con McLaren. Cuando necesitas analizar datos y tomar decisiones en una fracción de segundo, ese tiempo de respuesta instantáneo es una ventaja muy importante.

-

Aplicaciones interactivas: Para cualquiera que use asistentes de codificación o herramientas creativas impulsadas por IA, la velocidad de la retroalimentación lo es todo. Cuando la IA puede seguir tu hilo de pensamiento, se siente menos como una herramienta y más como un colaborador.

Para las empresas y los desarrolladores que utilizan su API, las ventajas son bastante claras:

-

Velocidad increíble: Groq puede generar cientos de tokens por segundo, creando un flujo conversacional difícil de encontrar en otro lugar.

-

Potencial de menores costos a escala: Aunque comprar el hardware está fuera del alcance de la mayoría, si tu empresa realiza una gran cantidad de solicitudes de IA, la eficiencia de la LPU podría traducirse en un menor costo por cada una.

-

Fácil de adoptar: Hicieron su API compatible con los estándares de OpenAI, lo cual fue una jugada inteligente. Significa que los desarrolladores a menudo pueden cambiar sus aplicaciones a Groq modificando solo unas pocas líneas de código.

Pero la velocidad bruta es solo la mitad de la historia. Una IA rápida que da la respuesta incorrecta es solo una forma rápida de frustrar a los clientes. Para algo como el soporte al cliente, esa velocidad necesita inteligencia y dirección. Ahí es donde entra en juego una plataforma como eesel AI. Actúa como el cerebro, diciéndole al motor superrápido qué hacer, conectándolo a la información correcta y guiando sus acciones.

Limitaciones y consideraciones del uso de Groq

Ahora bien, no todo es color de rosa. El enfoque de Groq es altamente especializado, y eso conlleva algunas cosas serias a tener en cuenta antes de lanzarse.

El alto precio del hardware de Groq

Este es el mayor obstáculo. A menos que estés utilizando su API en la nube, el costo de configurar tu propio hardware de Groq es asombroso. No estamos hablando de un poco caro; estamos hablando de que "necesitas un presupuesto multimillonario" solo para empezar. Esto efectivamente pone el autoalojamiento fuera del alcance de casi todos, excepto las corporaciones más grandes.

Selección limitada de modelos en GroqCloud

Si estás usando la API de GroqCloud, tienes que elegir entre los modelos que ellos han decidido soportar. No puedes simplemente coger tu modelo de código abierto favorito y ejecutarlo en su sistema. Esta es una diferencia clave en comparación con el uso de GPU de propósito general en la nube, que te dan mucha más libertad para experimentar.

Groq es para inferencia, y solo para inferencia

Estos chips LPU están construidos para un solo trabajo: ejecutar modelos de IA rápidamente. No están diseñados para entrenar un nuevo modelo desde cero ni para ajustar uno existente. Esto significa que cualquier empresa que use Groq todavía necesitará acceso a hardware de GPU tradicional para el desarrollo de sus modelos, lo que lo convierte en una herramienta especializada dentro de un conjunto de herramientas más grande, no en un reemplazo completo.

Esto resalta por qué es inteligente construir tus herramientas de IA en una plataforma más flexible. No quieres quedarte atrapado en un solo motor. Piénsalo de esta manera: mientras que Groq podría ser el motor de Fórmula 1 que usas para la velocidad, una plataforma como eesel AI es el coche en sí. Te permite conectar a tu servicio de ayuda como Zendesk, extrae conocimiento de lugares como Confluence y te da los controles para dirigir la personalidad y el comportamiento de la IA. Incluso puedes probarlo con tickets de soporte anteriores para ver cómo se desempeñaría, todo antes de que hable con un cliente real.

Precios de Groq: API vs. local (on-premise)

Entonces, ¿cuánto cuesta todo esto? Groq tiene dos formas principales de pago, y están a años luz de distancia.

La API de GroqCloud

Este es el camino que la mayoría de la gente tomará. Pagas sobre la marcha en función de cuántos tokens (fragmentos de palabras) procesas. Es el modelo estándar para las API de IA.

| Modelo | Precio de entrada (por 1M de tokens) | Precio de salida (por 1M de tokens) |

|---|---|---|

| Llama3-8b-8192 | 0,05 $ | 0,10 $ |

| Llama3-70b-8192 | 0,59 $ | 0,79 $ |

| Mixtral-8x7b-32768 | 0,24 $ | 0,24 $ |

| Gemma-7b-it | 0,10 $ | 0,10 $ |

Nota: los precios pueden cambiar, por lo que siempre es mejor consultar la página oficial de precios de Groq para conocer las tarifas más actuales.

Implementación local de Groq (on-premise)

Esta es la opción de "si tienes que preguntar, probablemente no te lo puedes permitir". Es para grandes empresas con necesidades de seguridad o rendimiento muy específicas que justifican la construcción de su propio clúster de Groq. Aunque no hay una lista de precios pública, los rumores del sector sugieren que estamos hablando de millones de dólares para una configuración básica, con implementaciones a gran escala que cuestan mucho, mucho más.

Este vídeo demuestra cómo empezar a usar el increíblemente rápido modelo Llama-3 en la API de Groq.

Groq: la velocidad es solo el principio

Entonces, ¿cuál es la conclusión sobre Groq? Han encontrado un problema muy específico, la velocidad de inferencia de la IA, y han puesto todo su empeño en resolverlo. Sus chips LPU, con su diseño basado completamente en SRAM, están en una categoría propia para respuestas en tiempo real. Para cualquier aplicación que necesite sentirse verdaderamente conversacional, Groq es un nombre a tener en cuenta.

Pero no es una solución mágica para todos los problemas de IA. El alto costo de comprar el hardware tú mismo y la selección limitada de modelos en su API significan que es una herramienta especializada para un trabajo especializado. Para la mayoría de nosotros, Groq será el motor detrás de una función específica que necesita ser ultrarrápida.

Aun así, la necesidad de una IA instantánea solo va a crecer a medida que se abre paso en más de nuestras herramientas. Groq es definitivamente una empresa a la que seguir de cerca, pero aprovechar esa velocidad de manera efectiva requiere más que solo un chip rápido.

Pon la velocidad de Groq a trabajar con un agente de IA más inteligente

Un hardware rápido es genial, pero para el soporte al cliente, el objetivo real es obtener respuestas rápidas y precisas que realmente resuelvan problemas. Necesitas un sistema que pueda tomar esa velocidad bruta y canalizarla en algo genuinamente útil.

Para eso construimos eesel AI. Es una plataforma que te permite conectar tus fuentes de conocimiento, ajustar cómo se comporta tu agente de IA y ponerlo en funcionamiento en minutos, no en meses. Te damos el control y las herramientas de prueba necesarias para convertir la velocidad bruta de la IA en resultados que puedes medir, como clientes más felices y menos tickets de soporte.

¿Listo para construir un agente de soporte de IA que sea increíblemente rápido y esté completamente bajo tu control? Comienza tu prueba gratuita de eesel AI hoy mismo.

Preguntas frecuentes

Groq es una empresa estadounidense de chips de IA que se especializa en construir hardware para una inferencia de IA extremadamente rápida. Su misión es eliminar la latencia (pausa) en las interacciones con la IA, haciendo que se sientan instantáneas y naturales.

Groq logra su velocidad a través de su Unidad de Procesamiento de Lenguaje (LPU) diseñada a medida, específicamente para modelos de lenguaje. A diferencia de las GPU, las LPU utilizan memoria SRAM superrápida para un acceso instantáneo a los datos, minimizando los tiempos de espera y maximizando la velocidad de procesamiento.

Groq es más beneficioso para aplicaciones que requieren respuestas de IA en tiempo real, como el soporte al cliente interactivo, el análisis de datos en vivo en campos críticos como las finanzas y las herramientas creativas fluidas impulsadas por IA. Su velocidad elimina retrasos frustrantes, haciendo que la IA se sienta como un colaborador perfecto.

No, Groq (con 'q') es una empresa completamente diferente al modelo de IA "Grok" de Elon Musk. Groq es una empresa de chips de IA centrada en hardware para inferencia rápida, mientras que "Grok" es un modelo de chatbot de IA.

Las limitaciones clave incluyen el costo extremadamente alto del hardware de Groq para instalaciones locales (on-premise), lo que limita su accesibilidad para la mayoría de las empresas. Además, si se utiliza la API de GroqCloud, estás limitado a los modelos que ellos soportan, y los chips son únicamente para inferencia, no para entrenar modelos de IA.

Groq ofrece dos opciones principales: la API de GroqCloud, donde pagas sobre la marcha según los tokens procesados, que es generalmente accesible. Para las soluciones locales (on-premise) de Groq, el costo es significativamente más alto, a menudo en millones de dólares, reservado para grandes corporaciones con necesidades específicas.

No, los chips LPU de Groq están diseñados y optimizados específicamente para la inferencia de IA, el proceso de usar un modelo entrenado para generar respuestas. No están construidos para entrenar nuevos modelos desde cero ni para ajustar los existentes; esas tareas todavía requieren hardware de GPU tradicional.

Compartir esta entrada

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.