AIチャットボットに質問を入力したとき、答えが出始める前の、あのわずかで気まずい間を感じたことはありませんか?ほんのわずかな遅延ですが、自分が機械と話していることを思い出させるには十分です。Groqという会社は、その間を完全になくし、AIとの対話を人間と話すのと同じくらいスムーズで自然なものにすることを使命としています。

AI業界の多くの企業が、より大規模で複雑なモデルの構築に注力している一方で、Groqは別の、しかし同様に重要な問題、つまり「スピード」に取り組んでいます。彼らは単にAIを少し速くするだけでなく、リアルタイムAIで何が可能になるかを変えるほどのパフォーマンスレベルを目指しているのです。

もしこの名前が話題になっているのを見て、何がそんなに騒がれているのか疑問に思っていたなら、この記事はまさにうってつけです。Groqとは何か、その独自の技術はどのように機能するのか、誰のためのものなのか、そして知っておくべき現実的な制約について解説していきます。

Groqとは?

まず基本を押さえましょう。Groqは、Google独自のAIチップであるTensor Processing Unit(TPU)の開発者の一人であったJonathan Ross氏によって設立されたアメリカのAIチップ企業です。Groqは、すべてをこなそうとするのではなく、AI推論用のハードウェアを構築するという一つの特定のことに集中しています。

では、彼らが非常に注力しているこの「推論」とは何でしょうか?これはAIの「パフォーマンス」の部分と考えてください。大規模なAIモデルが膨大なデータでトレーニングされた後、実際にそのモデルを使って答えを得るプロセスが推論です。チャットボットに質問したり、AIによるおすすめを受け取ったりするたびに、それは推論タスクなのです。

そして、念のため言っておきますが、これはイーロン・マスクの「Grok」AIモデルとは何の関係もありません。スペルも違えば、全く別の会社です。よくある混同なので、最初に明確にしておきましょう。Groqの目標は、AI推論を驚くほど速く、手頃な価格にすることであり、これによりリアルタイムAIツールの全く新しい波が生まれる可能性があります。

Groqを支える技術:記録的なスピードをいかにして達成するか

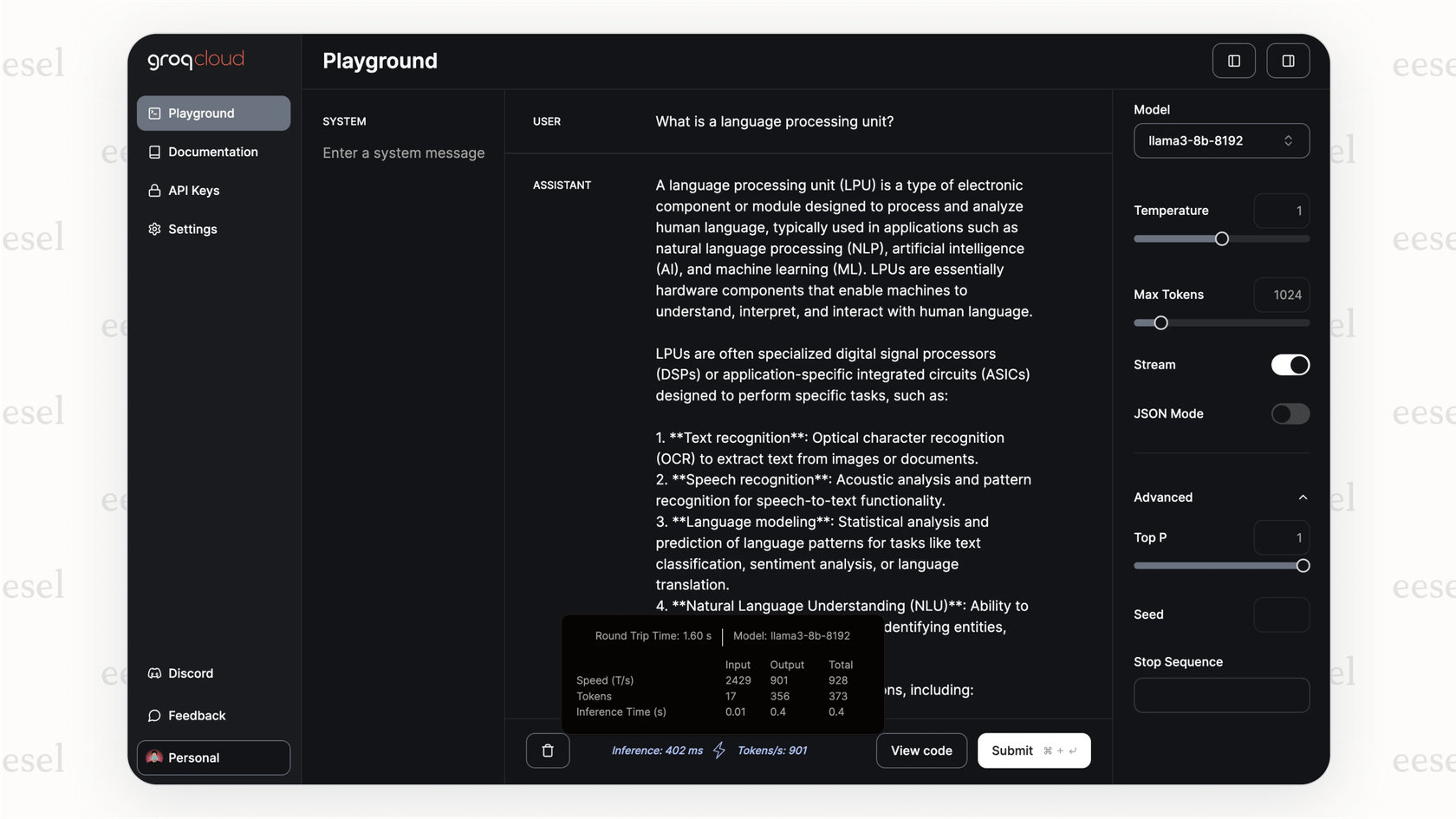

では、Groqはどのようにしてこの驚異的なスピードを実現しているのでしょうか?それは既存技術のマイナーな調整ではなく、問題に対する全く異なる考え方に基づいています。その魔法は、彼らが独自に構築したチップ、Language Processing Unit、略してLPUにあります。

GPU(Graphics Processing Unit)がAI向けに転用されたより汎用的な強力なツールであるのに対し、LPUは言語モデルを可能な限り高速に実行するという単一の目的のために、最初から設計されています。

本当の秘訣は、メモリの扱いです。GPUなど、おなじみのほとんどのチップはDRAMという種類のメモリを使用しています。DRAMは巨大な図書館の本棚のようなものだと考えてください。たくさんの本(データ)を収容できますが、必要なものを取りに行くには少し時間がかかります。

GroqはSRAMというものを使う、別のルートを選びました。SRAMは、必要な本が机の上に開いて置いてあるようなものです。アクセスは瞬時ですが、机の上には一度に数冊しか置けません。これは、コンピュータのメインプロセッサ上の小さなキャッシュに使われるのと同じ超高速メモリです。信じられないほど速いため、LPUはデータを待つことがほとんどありません。

graph TD subgraph 従来のGPU A[GPUコア] -->|データ要求| B(DRAMメモリ); B -->|遅延を伴うデータ取得| A; end subgraph Groq LPU C[LPUコア] -->|瞬時のデータアクセス| D(SRAMメモリ); D -->|遅延なし| C; end style B fill:#f9f,stroke:#333,stroke-width:2px style D fill:#ccf,stroke:#333,stroke-width:2px

しかし、人生のほとんどのことと同様、これには落とし穴があります。しかも大きなものです。SRAMは非常に高価で、多くのデータを保持できません。ハイエンドGPU1つでAIモデルの大部分をメモリに保存できるのに対し、1つのLPUはごくわずかな部分しか保持できません。現代の言語モデルを実行するために、Groqは何百、時には何千ものLPUチップを連結させなければなりません。この構成が、彼らのハードウェアに稲妻のような推論能力を与えているのですが、同時に自前で構築するにはとてつもなく高価なものにもなっています。

ユースケースとメリット:Groqは誰のためのものか?

なるほど、とてつもなく速いことはわかりました。しかし、実際にこの種のスピードを必要とするのは誰なのでしょうか?実は、多くの人々です。遅延が体験を台無しにする可能性がある場所ならどこでも、Groqには活躍の場があります。

このスピードが大きな違いを生むいくつかの例を挙げます。

-

リアルタイムのカスタマーサポート: 遅いウェブフォームに入力しているような感覚のチャットボットではなく、実際の会話についてこられるチャットボットを手に入れることができます。これにより、顧客が諦めて人間のエージェントを要求する原因となる、イライラするような間がなくなります。

-

ライブデータ分析: Groqがマクラーレンと提携している金融やF1レースのような、高いプレッシャーがかかる分野を考えてみてください。データを分析し、一瞬で意思決定を下す必要がある場合、その即時の応答時間は大きなアドバンテージとなります。

-

インタラクティブなアプリケーション: AI搭載のコーディングアシスタントやクリエイティブツールを使用する人にとって、フィードバックの速さがすべてです。AIがあなたの思考の速度についてこられると、それはツールというよりは協力者のように感じられます。

APIを使用する企業や開発者にとって、利点は非常に明確です。

-

信じられないほどのスピード: Groqは1秒あたり数百トークンを生成でき、他では見つけにくい会話のような流れを作り出します。

-

大規模利用でのコスト削減の可能性: ハードウェアの購入はほとんどの人にとって手の届かないものですが、企業が大量のAIリクエストを行う場合、LPUの効率性により、リクエストあたりのコストが低くなる可能性があります。

-

導入の容易さ: 彼らはAPIをOpenAIの標準と互換性があるように作りました。これは賢明な判断でした。これにより、開発者は多くの場合、数行のコードを変更するだけでアプリをGroqに切り替えることができます。

しかし、生のスピードは話の半分にすぎません。間違った答えを出す速いAIは、顧客をイライラさせる速い方法にすぎません。カスタマーサポートのようなものでは、そのスピードには知性と方向性が必要です。そこでeesel AIのようなプラットフォームが登場します。それは脳として機能し、超高速エンジンを正しい情報に接続し、その行動を導くことで、何をすべきかを指示します。

Groqを使用する上での制約と考慮事項

さて、すべてが順風満帆というわけではありません。Groqのアプローチは高度に専門化されており、飛び込む前に心に留めておくべき重大な事項がいくつかあります。

Groqハードウェアの高価格

これが最大のハードルです。彼らのクラウドAPIを使用しない限り、独自のGroqハードウェアをセットアップするコストは驚異的です。少し高価というレベルではありません。始めるだけで「数百万ドルの予算が必要」というレベルです。これにより、事実上、最大手の企業を除いて、ほとんどの人が自己ホスティングを断念せざるを得ません。

GroqCloudでのモデル選択の制限

GroqCloud APIを使用する場合、彼らがサポートすることに決めたモデルの中から選ばなければなりません。お気に入りのオープンソースモデルを持ってきて、彼らのシステムで実行することはできません。これは、実験の自由度がはるかに高い汎用クラウドGPUを使用する場合との重要な違いです。

Groqは推論専用

これらのLPUチップは、AIモデルを高速に実行するという一つの仕事のために作られています。新しいモデルをゼロからトレーニングしたり、既存のモデルをファインチューニングしたりするために設計されてはいません。つまり、Groqを使用する企業は、モデル開発のために従来のGPUハードウェアへのアクセスが依然として必要であり、完全な代替品ではなく、より大きなツールキットの中の専門的なツールの一つとなります。

これは、より柔軟なプラットフォーム上にAIツールを構築することが賢明である理由を浮き彫りにします。単一のエンジンに縛られたくはないはずです。このように考えてみてください。Groqはスピードのために使用するF1エンジンかもしれませんが、eesel AIのようなプラットフォームは車そのものです。これにより、Zendeskのようなヘルプデスクに接続し、Confluenceのような場所から知識を取り込み、AIの個性や振る舞いを操作するコントロールを提供します。実際の顧客と話す前に、過去のサポートチケットでテストして、どのように機能するかを確認することさえできます。

Groqの価格:API vs オンプレミス

では、これらすべてにいくらかかるのでしょうか?Groqには主に2つの支払い方法があり、それらは全く異なります。

GroqCloud API

これはほとんどの人が選ぶ道です。処理したトークン(単語の一部)の数に基づいて従量課金で支払います。これはAI APIの標準的なモデルです。

| モデル | 入力価格(100万トークンあたり) | 出力価格(100万トークンあたり) |

|---|---|---|

| Llama3-8b-8192 | $0.05 | $0.10 |

| Llama3-70b-8192 | $0.59 | $0.79 |

| Mixtral-8x7b-32768 | $0.24 | $0.24 |

| Gemma-7b-it | $0.10 | $0.10 |

注:価格は変更される可能性があるため、最新の料金についてはGroqの公式価格ページで常に確認することをお勧めします。

オンプレミスのGroq導入

これは、「聞かなければならないなら、おそらく払えない」という選択肢です。独自のGroqクラスタを構築することを正当化できる、非常に特定のセキュリティまたはパフォーマンスのニーズを持つ大企業向けです。公的な価格表はありませんが、業界の噂では、基本的なセットアップで数百万ドル、大規模な導入ではさらにずっと高額になると言われています。

このビデオでは、Groq APIで非常に高速なLlama-3モデルを使い始める方法を紹介しています。

Groq:スピードは始まりに過ぎない

では、Groqの結論は何でしょうか?彼らはAI推論の速度という非常に具体的な問題を見つけ、その解決に全力を注いできました。オールSRAM設計のLPUチップは、リアルタイム応答において他に類を見ません。真に会話的に感じられる必要があるアプリにとって、Groqは知っておくべき名前です。

しかし、これはすべてのAI問題に対する万能薬ではありません。ハードウェアを自前で購入する高コストと、APIでのモデル選択の制限は、これが専門的な仕事のための専門的なツールであることを意味します。私たちのほとんどにとって、Groqは稲妻のような速さが必要な特定の機能の背後にあるエンジンとなるでしょう。

それでも、AIが私たちのツールにもっと浸透していくにつれて、即時AIの必要性はますます大きくなるでしょう。Groqは間違いなく注目すべき企業ですが、そのスピードを効果的に活用するには、単なる高速チップ以上のものが必要です。

Groqのスピードを、よりスマートなAIエージェントで活用する

高速なハードウェアは素晴らしいですが、カスタマーサポートにおいては、真の目標は、実際に問題を解決する、速く正確な回答を得ることです。その生のスピードを受け取り、本当に役立つものに変換できるシステムが必要です。

それが、私たちがeesel AIを構築した理由です。これは、ナレッジソースを接続し、AIエージェントの振る舞いを微調整し、数ヶ月ではなく数分で稼働させることができるプラットフォームです。私たちは、生のAIスピードを、顧客満足度の向上やサポートチケットの削減といった測定可能な結果に変えるために必要なコントロールとテストツールを提供します。

信じられないほど速く、かつ完全にあなたのコントロール下にあるAIサポートエージェントを構築する準備はできましたか?今すぐeesel AIの無料トライアルを開始しましょう。

よくある質問

Groqは、非常に高速なAI推論用のハードウェア構築に特化したアメリカのAIチップ企業です。その使命は、AIとの対話における遅延(間)をなくし、瞬時で自然な感覚にすることです。

Groqは、言語モデル専用に設計された、独自開発のLanguage Processing Unit(LPU)によってその速度を実現しています。GPUとは異なり、LPUは超高速のSRAMメモリを使用して瞬時にデータにアクセスし、待機時間を最小限に抑え、処理速度を最大化します。

Groqは、インタラクティブなカスタマーサポート、金融のような重要な分野でのライブデータ分析、スムーズなAI搭載クリエイティブツールなど、リアルタイムのAI応答を必要とするアプリケーションに最も有益です。その速度は、イライラするような遅延をなくし、AIをシームレスな協力者のように感じさせます。

いいえ、Groq('q'が付く方)はイーロン・マスクの「Grok」AIモデルとは全く別の会社です。Groqは高速推論用のハードウェアに焦点を当てたAIチップ企業であり、「Grok」はAIチャットボットモデルです。

主な制約としては、オンプレミスのGroqハードウェアが非常に高価であるため、ほとんどの企業にとってアクセスが困難であることが挙げられます。さらに、GroqCloud APIを使用する場合、サポートされているモデルに限定され、チップはAIモデルのトレーニングではなく推論専用です。

Groqは主に2つのオプションを提供しています。一般的にアクセスしやすいのは、処理されたトークンに基づいて従量課金で支払うGroqCloud APIです。オンプレミスのGroqソリューションの場合、コストは著しく高く、特定のニーズを持つ大企業向けで、しばしば数百万ドルに達します。

いいえ、GroqのLPUチップは、トレーニング済みのモデルを使用して応答を生成するプロセスであるAI推論のために特別に設計・最適化されています。ゼロから新しいモデルをトレーニングしたり、既存のモデルをファインチューニングしたりするためには作られておらず、これらのタスクには依然として従来のGPUハードウェアが必要です。

この記事を共有

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.