Avez-vous déjà posé une question à un chatbot IA et ressenti cette légère pause gênante avant qu'il ne commence à cracher une réponse ? C'est un minuscule délai, mais suffisant pour vous rappeler que vous parlez à une machine. Une entreprise nommée Groq s'est donné pour mission d'effacer complètement cette pause, rendant les interactions avec l'IA aussi fluides et naturelles que de parler à une personne.

Alors que de nombreuses entreprises du monde de l'IA se concentrent sur la création de modèles plus grands et plus complexes, Groq s'attaque à un problème différent mais tout aussi important : la vitesse. Ils ne se contentent pas de rendre l'IA un peu plus rapide ; ils visent un niveau de performance qui change ce qui est même possible avec l'IA en temps réel.

Si vous avez vu ce nom apparaître et que vous vous demandiez d'où venait tout cet engouement, vous êtes au bon endroit. Nous allons décortiquer ce qu'est Groq, comment sa technologie unique fonctionne, à qui elle s'adresse, et certaines des limitations réelles que vous devriez connaître.

Qu'est-ce que Groq ?

Commençons par les bases. Groq est une entreprise américaine de puces d'IA fondée par Jonathan Ross, l'un des cerveaux derrière la propre puce d'IA personnalisée de Google, le Tensor Processing Unit (TPU). Au lieu d'essayer de tout faire, Groq se concentre sur une chose spécifique : la construction de matériel pour l'inférence IA.

Alors, qu'est-ce que cette « inférence » sur laquelle ils se concentrent tant ? Pensez-y comme la partie « performance » de l'IA. Après qu'un modèle d'IA massif a été entraîné sur des tonnes de données, l'inférence est le processus d'utilisation réelle de ce modèle pour obtenir une réponse. Chaque fois que vous posez une question à un chatbot ou que vous obtenez une recommandation alimentée par l'IA, c'est une tâche d'inférence.

Et non, avant que vous ne le demandiez, cela n'a rien à voir avec le modèle d'IA « Grok » d'Elon Musk. Orthographe différente, entreprises complètement différentes. C'est une confusion courante, alors mettons cela au clair. L'objectif de Groq est de rendre l'inférence IA incroyablement rapide et abordable, ce qui pourrait ouvrir la voie à une toute nouvelle vague d'outils d'IA en temps réel.

La technologie derrière Groq : comment elle atteint une vitesse record

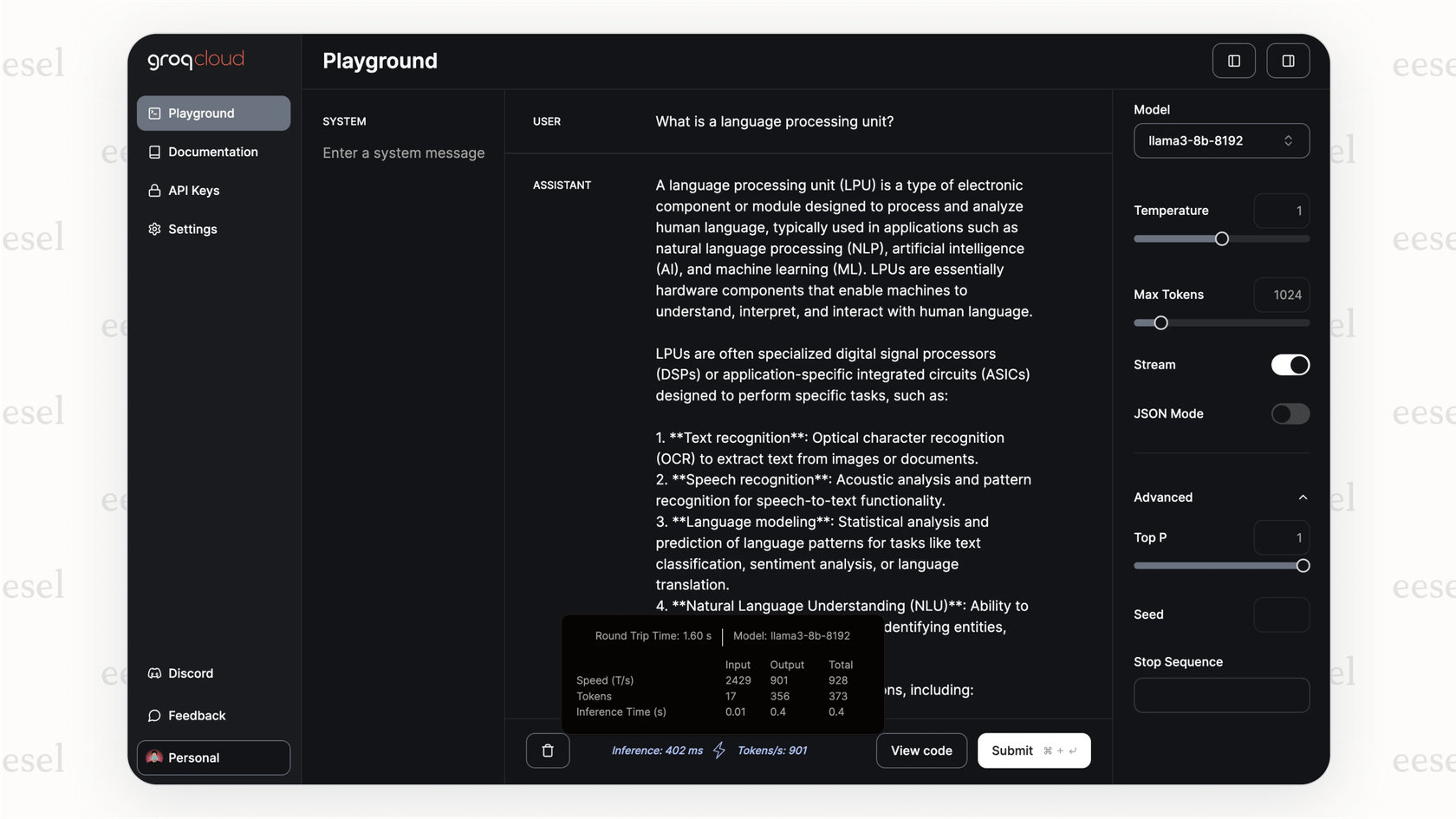

Alors, comment Groq réussit-il cette vitesse incroyable ? Ce n'est pas juste une petite modification de la technologie existante ; c'est une toute autre façon de penser le problème. La magie réside dans leur puce conçue sur mesure, le Language Processing Unit, ou LPU.

Contrairement à un GPU (Graphics Processing Unit), qui est un outil puissant et polyvalent adapté pour l'IA, le LPU a été conçu dès le départ avec un seul objectif : exécuter des modèles de langage aussi rapidement que possible.

Le véritable secret réside dans la gestion de la mémoire. La plupart des puces que vous connaissez, comme les GPU, utilisent un type de mémoire appelé DRAM. Imaginez la DRAM comme une immense bibliothèque. Elle peut contenir une tonne de livres (données), mais vous devez vous déplacer pour obtenir ce dont vous avez besoin, ce qui prend un peu de temps.

Groq a décidé d'emprunter une autre voie, en utilisant quelque chose appelé SRAM. La SRAM, c'est comme avoir le livre exact dont vous avez besoin ouvert juste sur votre bureau. L'accès est instantané, mais votre bureau ne peut contenir que quelques livres à la fois. C'est la même mémoire ultra-rapide utilisée pour les minuscules caches du processeur principal de votre ordinateur. Elle est incroyablement rapide, ce qui signifie que le LPU n'a presque jamais à attendre les données.

graph TD subgraph GPU Traditionnel A[Noyau GPU] -->|Demande de données| B(Mémoire DRAM); B -->|Récupération de données avec latence| A; end subgraph LPU Groq C[Noyau LPU] -->|Accès instantané aux données| D(Mémoire SRAM); D -->|Aucune latence| C; end style B fill:#f9f,stroke:#333,stroke-width:2px style D fill:#ccf,stroke:#333,stroke-width:2px

Mais, comme pour la plupart des choses dans la vie, il y a un hic. Et un gros. La SRAM est incroyablement chère et ne contient pas beaucoup de données. Alors qu'un seul GPU haut de gamme peut stocker une grande partie d'un modèle d'IA dans sa mémoire, un LPU ne peut en contenir qu'une infime fraction. Pour exécuter un modèle de langage moderne, Groq doit enchaîner des centaines, parfois des milliers, de ces puces LPU. Cette configuration confère à leur matériel ses capacités d'inférence ultra-rapides, mais elle rend également sa construction extrêmement coûteuse.

Cas d'utilisation et avantages : à qui s'adresse Groq ?

Ok, c'est ridiculement rapide. Mais qui a vraiment besoin d'une telle vitesse ? Il s'avère que beaucoup de gens. Partout où un délai peut ruiner l'expérience, Groq a sa place.

Voici quelques domaines où cette vitesse fait une énorme différence :

-

Support client en temps réel: Au lieu d'un chatbot qui donne l'impression de remplir un formulaire web lent, vous en avez un qui peut suivre une vraie conversation. Cela élimine les pauses frustrantes qui poussent les clients à abandonner et à demander un agent humain.

-

Analyse de données en direct : Pensez à des domaines à haute pression comme la finance ou même la Formule 1, où Groq a un partenariat avec McLaren. Lorsque vous devez analyser des données et prendre des décisions en une fraction de seconde, ce temps de réponse instantané est un avantage considérable.

-

Applications interactives : Pour quiconque utilise des assistants de codage ou des outils créatifs alimentés par l'IA, la vitesse du retour est essentielle. Quand l'IA peut suivre votre fil de pensée, elle ressemble moins à un outil et plus à un collaborateur.

Pour les entreprises et les développeurs qui utilisent leur API, les avantages sont assez simples :

-

Vitesse incroyable : Groq peut générer des centaines de jetons par seconde, créant un flux conversationnel difficile à trouver ailleurs.

-

Potentiel de coûts réduits à grande échelle : Bien que l'achat du matériel soit hors de portée pour la plupart, si votre entreprise effectue un grand nombre de requêtes IA, l'efficacité du LPU pourrait entraîner un coût inférieur pour chacune d'entre elles.

-

Facile à adopter : Ils ont rendu leur API compatible avec les standards d'OpenAI, ce qui était une décision intelligente. Cela signifie que les développeurs peuvent souvent basculer leurs applications vers Groq en changeant seulement quelques lignes de code.

Mais la vitesse brute n'est que la moitié de l'histoire. Une IA rapide qui donne la mauvaise réponse n'est qu'un moyen rapide de frustrer les clients. Pour quelque chose comme le support client, cette vitesse a besoin d'intelligence et de direction. C'est là qu'une plateforme comme eesel AI entre en jeu. Elle agit comme le cerveau, disant au moteur ultra-rapide quoi faire en le connectant aux bonnes informations et en guidant ses actions.

Limitations et considérations de l'utilisation de Groq

Maintenant, tout n'est pas rose. L'approche de Groq est très spécialisée, et cela s'accompagne de quelques points sérieux à garder à l'esprit avant de vous lancer.

Le prix élevé du matériel Groq

C'est le plus gros obstacle. À moins que vous n'utilisiez leur API cloud, le coût de mise en place de votre propre matériel Groq est stupéfiant. Nous ne parlons pas d'un peu cher ; nous parlons d'un budget de plusieurs millions de dollars rien que pour commencer. Cela met effectivement l'auto-hébergement hors de portée de presque tout le monde, à l'exception des plus grandes entreprises.

Sélection de modèles limitée sur GroqCloud

Si vous utilisez l'API GroqCloud, vous devez choisir parmi les modèles qu'ils ont décidé de prendre en charge. Vous ne pouvez pas simplement prendre votre modèle open-source préféré et le faire fonctionner sur leur système. C'est une différence clé par rapport à l'utilisation de GPU cloud à usage général, qui vous donnent beaucoup plus de liberté pour expérimenter.

Groq est pour l'inférence, et seulement l'inférence

Ces puces LPU sont conçues pour une seule tâche : exécuter rapidement des modèles d'IA. Elles ne sont pas conçues pour entraîner un nouveau modèle à partir de zéro ou même pour affiner un modèle existant. Cela signifie que toute entreprise utilisant Groq aura toujours besoin d'accéder à du matériel GPU traditionnel pour le développement de ses modèles, ce qui en fait un outil spécialisé dans une boîte à outils plus large, pas un remplacement complet.

Cela souligne pourquoi il est judicieux de construire vos outils d'IA sur une plateforme plus flexible. Vous ne voulez pas être enfermé dans un seul moteur. Pensez-y de cette façon : alors que Groq pourrait être le moteur de Formule 1 que vous utilisez pour la vitesse, une plateforme comme eesel AI est la voiture elle-même. Elle vous permet de vous connecter à votre service d'assistance comme Zendesk, de puiser des connaissances dans des endroits comme Confluence, et vous donne les commandes pour diriger la personnalité et le comportement de l'IA. Vous pouvez même la tester sur d'anciens tickets de support pour voir comment elle se comporterait, tout cela avant même qu'elle ne parle à un vrai client.

Tarification de Groq : API vs. sur site

Alors, combien tout cela coûte-t-il ? Groq propose deux principales façons de payer, et elles sont radicalement différentes.

L'API GroqCloud

C'est la voie que la plupart des gens emprunteront. Vous payez à l'utilisation en fonction du nombre de jetons (morceaux de mots) que vous traitez. C'est le modèle standard pour les API d'IA.

| Modèle | Prix d'entrée (par million de jetons) | Prix de sortie (par million de jetons) |

|---|---|---|

| Llama3-8b-8192 | 0,05 $ | 0,10 $ |

| Llama3-70b-8192 | 0,59 $ | 0,79 $ |

| Mixtral-8x7b-32768 | 0,24 $ | 0,24 $ |

| Gemma-7b-it | 0,10 $ | 0,10 $ |

Note : Les prix peuvent changer, il est donc toujours préférable de consulter la page de tarification officielle de Groq pour les tarifs les plus actuels.

Déploiement Groq sur site

C'est l'option « si vous devez demander, c'est que vous ne pouvez probablement pas vous le permettre ». Elle est destinée aux grandes entreprises ayant des besoins de sécurité ou de performance très spécifiques qui justifient la construction de leur propre cluster Groq. Bien qu'il n'y ait pas de liste de prix publique, les rumeurs du secteur suggèrent que vous envisagez des millions de dollars pour une configuration de base, les déploiements à grande échelle coûtant beaucoup, beaucoup plus cher.

Cette vidéo montre comment démarrer avec le modèle Llama-3 incroyablement rapide sur l'API Groq.

Groq : la vitesse n'est qu'un début

Alors, quel est le bilan sur Groq ? Ils ont identifié un problème très spécifique, la vitesse d'inférence de l'IA, et ont tout mis en œuvre pour le résoudre. Leurs puces LPU, avec leur conception entièrement SRAM, sont dans une catégorie à part pour les réponses en temps réel. Pour toute application qui a besoin de se sentir vraiment conversationnelle, Groq est un nom à connaître.

Mais ce n'est pas une solution miracle pour tous les problèmes d'IA. Le coût élevé de l'achat du matériel et la sélection limitée de modèles sur leur API en font un outil spécialisé pour un travail spécialisé. Pour la plupart d'entre nous, Groq sera le moteur derrière une fonctionnalité spécifique qui doit être ultra-rapide.

Néanmoins, le besoin d'une IA instantanée ne fera que croître à mesure qu'elle s'intègre dans de plus en plus de nos outils. Groq est sans aucun doute une entreprise à suivre, mais exploiter cette vitesse efficacement nécessite plus qu'une simple puce rapide.

Mettez la vitesse de Groq au service d'un agent IA plus intelligent

Un matériel rapide, c'est bien, mais pour le support client, le véritable objectif est d'obtenir des réponses rapides et précises qui résolvent réellement les problèmes. Vous avez besoin d'un système capable de prendre cette vitesse brute et de la canaliser vers quelque chose de vraiment utile.

C'est pour cela que nous avons créé eesel AI. C'est une plateforme qui vous permet de connecter vos sources de connaissances, d'affiner le comportement de votre agent IA, et de le rendre opérationnel en quelques minutes, pas en quelques mois. Nous vous donnons le contrôle et les outils de test nécessaires pour transformer la vitesse brute de l'IA en résultats mesurables, comme des clients plus satisfaits et moins de tickets de support.

Prêt à créer un agent de support IA à la fois incroyablement rapide et entièrement sous votre contrôle ? Commencez votre essai gratuit avec eesel AI dès aujourd'hui.

Questions fréquentes

Groq est une entreprise américaine de puces d'IA spécialisée dans la construction de matériel pour une inférence IA extrêmement rapide. Sa mission est d'éliminer la latence (pause) dans les interactions avec l'IA, les rendant instantanées et naturelles.

Groq atteint sa vitesse grâce à son unité de traitement du langage (LPU) conçue sur mesure, spécialement pour les modèles de langage. Contrairement aux GPU, les LPU utilisent une mémoire SRAM ultra-rapide pour un accès instantané aux données, minimisant les temps d'attente et maximisant la vitesse de traitement.

Groq est le plus bénéfique pour les applications nécessitant des réponses IA en temps réel, telles que le support client interactif, l'analyse de données en direct dans des domaines critiques comme la finance, et les outils créatifs fluides alimentés par l'IA. Sa vitesse élimine les délais frustrants, donnant l'impression que l'IA est un collaborateur transparent.

Non, Groq (avec un 'q') est une entreprise complètement différente du modèle d'IA « Grok » d'Elon Musk. Groq est une entreprise de puces d'IA axée sur le matériel pour l'inférence rapide, tandis que « Grok » est un modèle de chatbot IA.

Les principales limitations incluent le coût extrêmement élevé du matériel Groq sur site, ce qui limite son accessibilité pour la plupart des entreprises. De plus, si vous utilisez l'API GroqCloud, vous êtes limité aux modèles qu'ils prennent en charge, et les puces sont uniquement destinées à l'inférence, pas à l'entraînement de modèles d'IA.

Groq propose deux options principales : l'API GroqCloud, où vous payez à l'utilisation en fonction des jetons traités, ce qui est généralement accessible. Pour les solutions Groq sur site, le coût est nettement plus élevé, souvent de l'ordre de plusieurs millions de dollars, réservé aux grandes entreprises ayant des besoins spécifiques.

Non, les puces LPU de Groq sont spécifiquement conçues et optimisées pour l'inférence IA, le processus d'utilisation d'un modèle entraîné pour générer des réponses. Elles ne sont pas conçues pour entraîner de nouveaux modèles à partir de zéro ou pour affiner des modèles existants ; ces tâches nécessitent toujours du matériel GPU traditionnel.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.