Die Idee, einen KI-Coding-Partner direkt in einem Jupyter-Notebook zu haben, fühlt sich für Datenwissenschaftler und Entwickler schon seit einer Weile wie der heilige Gral an. Als Tools wie GitHub Copilot anfingen, Wellen zu schlagen, wurde der Wunsch nach der gleichen Leistungsfähigkeit direkt in den Notebooks nur noch größer. Die Engine hinter diesen frühen Tools war OpenAI Codex, ein Modell, das versprach, einfaches Englisch in funktionierenden Code zu verwandeln.

Dieser Leitfaden führt Sie durch die Geschichte von Codex und seiner Reise mit Jupyter, beleuchtet die modernen Werkzeuge, die seinen Platz eingenommen haben, und argumentiert, warum die wahren Produktivitätsgewinne darin liegen, über das Notebook hinauszuschauen und eine KI zu nutzen, die die gesamte Wissensdatenbank Ihres Teams versteht.

Was war OpenAI Codex?

OpenAI Codex war ein KI-System, das natürliche Sprachbefehle aufnehmen und Code ausgeben konnte. Es war ein Ableger von GPT-3, trainiert auf einer riesigen Menge an Text und Milliarden von Zeilen öffentlichen Codes. Dies war die Grundlage für die erste Version von GitHub Copilot.

Codex war ziemlich vielseitig und beherrschte über ein Dutzend Sprachen wie Python, JavaScript und Ruby. Es tat mehr als nur Autocomplete; es konnte erklären, was ein Codeabschnitt bewirkt, Code zwischen Sprachen übersetzen und sogar beim Refactoring Ihrer Arbeit helfen.

Aber hier ist ein entscheidendes Puzzleteil: Die ursprünglichen OpenAI Codex-Modelle wurden offiziell im März 2023 eingestellt. Während die zugrunde liegende Technologie weiterentwickelt wurde und ihre Nachfolger nun in die neueren Modelle von OpenAI integriert sind, ist die spezifische Codex-API, auf der all die frühen Integrationen aufgebaut waren, verschwunden. Diese eine Änderung hat die gesamte Landschaft für KI-Tools in Jupyter so gut wie neu geformt.

Der Vorstoß der Community für OpenAI Codex in Jupyter

Noch bevor es offizielle Tools gab, arbeitete die Entwicklergemeinschaft bereits hart daran, KI in ihre bevorzugte Notebook-Umgebung zu bringen. Viele Datenwissenschaftler und ML-Ingenieure leben in Jupyter, und der iterative, zellenweise Arbeitsablauf entspricht genau ihrer Denkweise. Der Wechsel zu VS Code nur um Copilot zu nutzen, fühlte sich wie eine "umständliche" und klobige Unterbrechung an.

Frühe von der Community entwickelte Lösungen

Diese Frustration löste eine Reihe von Open-Source-Projekten aus. Tools wie "gpt-jupyterlab" und "jupyterlab-codex" tauchten auf und ermöglichten es Entwicklern, den Inhalt einer Notebook-Zelle an die OpenAI-API zu senden. Die Einrichtung war in der Regel recht einfach: Ein Paket mit "pip install" installieren, den OpenAI-API-Schlüssel in die JupyterLab-Einstellungen einfügen, und schon hatte man einen neuen Button zum Generieren von Code. Diese Tools waren ein großartiges Beispiel dafür, wie die Community das baute, was sie brauchte.

Herausforderungen und Grenzen früher Integrationen

So vielversprechend sie auch waren, diese frühen Integrationen hatten ihre Tücken, die es schwierig machten, sich langfristig auf sie zu verlassen:

-

Probleme bei der Einrichtung: Benutzer stießen bei der Installation häufig auf Hindernisse, insbesondere auf Remote-Servern. Viele dieser Plugins erforderten einen vollständigen Neustart des JupyterLab-Servers, um zu funktionieren, und herauszufinden, warum die eigene Konfiguration nicht funktionierte, konnte einen guten Teil des Nachmittags in Anspruch nehmen.

-

Veraltete Modelle: Die meisten dieser Tools wurden speziell für die ursprünglichen Codex-Modelle entwickelt. Als diese eingestellt wurden, funktionierten die Erweiterungen im Grunde nicht mehr, es sei denn, sie wurden komplett überarbeitet, um neuere (und anders bepreiste) OpenAI-Modelle zu verwenden.

-

Der größte blinde Fleck: kein Kontext: Das grundlegendste Problem war, dass diese Tools in einem Vakuum arbeiteten. Sie konnten den Code in einer Zelle sehen, hatten aber keinerlei Zugriff auf die Projektdokumentation in Confluence, die Spezifikationen in Google Docs oder die eine wichtige Klärung, die Ihr Manager in Slack gepostet hatte. Die KI konnte Code schreiben, aber sie wusste nicht, warum sie ihn schrieb.

Die moderne Landschaft

Die Dinge haben sich seit den Tagen der einfachen Codex-Plugins definitiv weiterentwickelt. Der Fokus hat sich von Hacks für einzelne Modelle zu solideren, flexibleren Frameworks verlagert, die eine Verbindung zu einer Reihe verschiedener KI-Anbieter herstellen können.

Der Aufstieg von "jupyter-ai"

Der Hauptakteur heute ist "jupyter-ai", ein offizielles Projekt des Jupyter-Teams. Es integriert generative KI direkt in JupyterLab und Jupyter Notebooks. Anstatt an ein altes Modell gebunden zu sein, ist "jupyter-ai" eher ein universeller Adapter für eine ganze Reihe moderner Modelle von Anbietern wie OpenAI, Anthropic, Cohere und sogar Open-Source-Modellen von Hugging Face.

Es verfügt über eine integrierte Chat-Benutzeroberfläche, in der Sie Fragen zu Ihrem Code stellen können, sowie über praktische "%%ai" "Magic Commands." Mit diesen können Sie Code generieren, Fehler beheben oder sogar ganze Funktionen aus einer einfachen Anweisung in einer Notebook-Zelle erstellen.

Überlegungen zu Preisen und Einrichtung

Obwohl "jupyter-ai" Open-Source ist, sind die leistungsstarken Modelle, mit denen es sich verbindet, nicht kostenlos. Sie benötigen einen API-Schlüssel von einem Anbieter wie OpenAI oder Anthropic, und die Nutzung wird Ihnen in Rechnung gestellt, in der Regel basierend auf "Tokens" (den Wortteilen, die die KI verarbeitet). Die Zeiten der kostenlosen Betas sind vorbei; der Zugang zu Modellen, die gut genug für das Programmieren sind, ist heute ein kostenpflichtiger Dienst. Zum Beispiel sind die neuesten Modelle von OpenAI über ihre API oder als Teil von Plänen wie ChatGPT Team oder Enterprise verfügbar.

| Anbieter | Beispielmodelle | Am besten geeignet für |

|---|---|---|

| OpenAI | "gpt-4o", "gpt-3.5-turbo" | Allzweck-Codeerstellung, Erklärungen |

| Anthropic | "claude-3-sonnet" | Komplexes Schlussfolgern, Verarbeitung großer Kontexte |

| Hugging Face | Verschiedene Open-Source-Modelle | Spezialisierte Aufgaben, Betrieb auf eigener Infrastruktur |

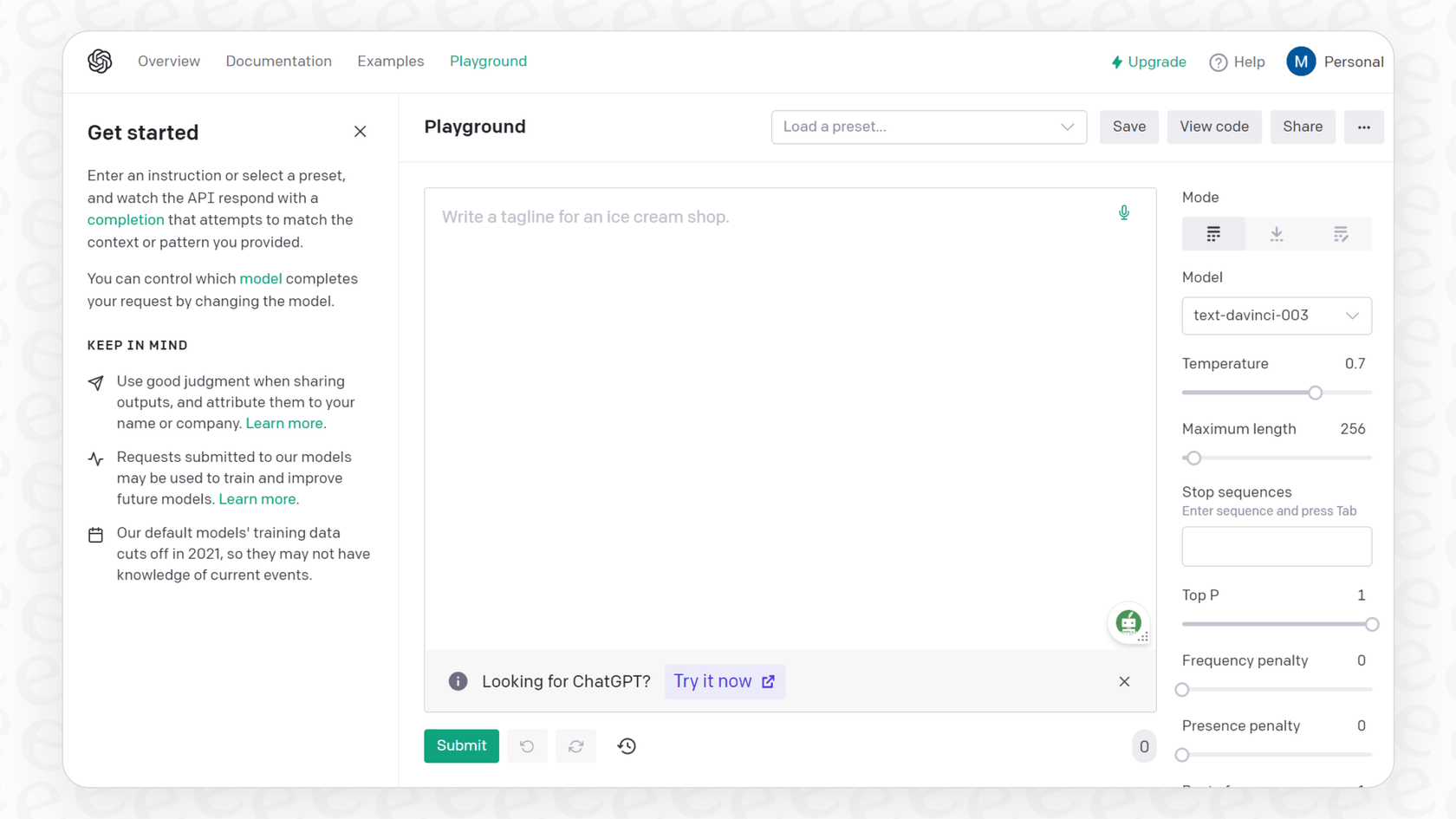

Dieses Video vom Entwickler von Jupyter AI demonstriert, wie das Werkzeug generative KI-Funktionen direkt in die vertraute Notebook-Umgebung bringt.

Jenseits der Code-Vervollständigung: Die Grenzen von KI im Notebook

Selbst mit einem eleganten Werkzeug wie "jupyter-ai" gibt es immer noch eine große Einschränkung: Die KI ist in der Programmierumgebung des Entwicklers gefangen. Ein guter Entwickler schreibt nicht nur Code. Er muss Geschäftsziele verstehen, technische Spezifikationen lesen und mit seinem Team kommunizieren. Ein KI-Assistent, der keine dieser Informationen sehen kann, löst nur die Hälfte des Problems.

Denken Sie darüber nach, wie viel Zeit ein Entwickler damit verbringt, den Kontext zu wechseln. Sie sind tief in einem Notebook vertieft, dann müssen Sie aufhören, einen neuen Tab öffnen, Confluence nach API-Dokumentationen durchsuchen, durch einen Slack-Kanal scrollen, um eine Entscheidung zu finden, die jemand getroffen hat, oder ein Google Doc aufrufen, um ein Design zu überprüfen. Jede dieser kleinen Unterbrechungen stört Ihre Konzentration und verlangsamt Sie.

Vereinheitlichen Sie Ihre Werkzeuge mit einem internen KI-Assistenten

An dieser Stelle müssen wir größer denken als nur an einen Programmierassistenten und an eine wissensbewusste KI-Plattform denken. Während "jupyter-ai" ein Modell in Ihr Notebook bringt, bringt ein Tool wie eesel AI das gesamte verstreute Wissen Ihres Unternehmens zur KI.

Mit dem internen Chat von eesel AI können Sie einen Assistenten einrichten, der auf den eigenen Daten Ihrer Organisation trainiert ist. Er verbindet sich direkt mit den Tools, auf die Ihr Team bereits angewiesen ist, wie Notion, SharePoint und Microsoft Teams.

Stellen Sie sich vor, ein Entwickler arbeitet in Jupyter und hat eine Frage zu einem Datenschema. Anstatt alles stehen und liegen zu lassen, um in der Dokumentation zu wühlen, kann er einfach den eesel AI Bot in Slack fragen: "Was sind die erforderlichen Felder für die Tabelle "user_profiles"?" Der Bot gibt ihm eine sofortige, genaue Antwort, die direkt aus den offiziellen Dokumenten des Teams stammt. Das ist es, was die Vereinheitlichung Ihres Wissens bewirkt: Sie reduziert den ständigen Kontextwechsel und ermöglicht es Entwicklern, sich auf ihre Arbeit zu konzentrieren.

Erste Schritte: Der Übergang zu einem wissensbewussten Arbeitsablauf

Der Weg von den ersten OpenAI Codex-Integrationen mit Jupyter bis zu unserem heutigen Stand zeigt ein klares Muster. Wir haben uns von einfachen Plugins zu flexiblen Assistenten im Notebook entwickelt. Der nächste logische Schritt ist ein vollständig vernetzter, wissensbewusster KI-Arbeitsablauf. Die Zukunft der Entwicklerproduktivität liegt nicht nur darin, schneller Code zu produzieren, sondern Entwicklern zu helfen, bessere Entscheidungen mit weniger Aufwand zu treffen.

Und dafür brauchen Sie kein riesiges, monatelanges Projekt. Mit einer Plattform, die auf Einfachheit ausgelegt ist, können Sie schnell loslegen. Zum Beispiel ist eesel AI so konzipiert, dass es radikal selbstbedienbar ist, was bedeutet, dass Sie in Minuten live gehen können, nicht in Monaten. Sie können Ihre Wissensquellen verbinden und einen internen KI-Assistenten für Ihr Team einführen, ohne endlose Demos oder individuelle Implementierungsprojekte durchlaufen zu müssen.

Intelligenter bauen, nicht nur schneller

KI-gestützte Code-Vervollständigung in Jupyter ist ein fantastisches Werkzeug, das die Arbeitsweise vieler von uns verändert hat. Aber es glänzt wirklich, wenn die KI das Gesamtbild hat – den Kontext aus der Dokumentation, den Gesprächen und den Geschäftszielen Ihres Teams. Indem Sie all Ihr internes Wissen verbinden, können Sie einen Assistenten schaffen, der nicht nur Code schreibt, sondern Ihren Entwicklern hilft, den richtigen Code schneller zu erstellen.

Sind Sie bereit, Ihren Entwicklern eine KI zu geben, die Ihr Geschäft wirklich versteht? Testen Sie eesel AI, um Ihr Wissen zu vereinheitlichen und der Produktivität Ihres Teams einen echten Schub zu geben.

Häufig gestellte Fragen

Die ursprünglichen OpenAI Codex-Modelle, die frühe Integrationen antrieben, wurden im März 2023 offiziell eingestellt. Obwohl ihre zugrunde liegende Technologie in neuere OpenAI-Modelle weiterentwickelt wurde, ist die spezifische Codex-API nicht mehr verfügbar, was direkte „OpenAI Codex-Integrationen mit Jupyter“ für neue Projekte veraltet macht.

Die wichtigste moderne Alternative ist „jupyter-ai“. Dieses offizielle Jupyter-Projekt fungiert als universeller Adapter, der JupyterLab und Jupyter Notebooks mit einer Reihe aktueller generativer KI-Modelle von Anbietern wie OpenAI, Anthropic und Hugging Face verbindet.

Frühe Integrationen litten oft unter komplizierten Einrichtungen, veralteten schnell, als die Codex-Modelle eingestellt wurden, und hatten kritischerweise keinen Zugriff auf einen breiteren Projektkontext wie Dokumentationen oder Teamdiskussionen, sodass sie in einem Wissensvakuum operierten.

Ja, während „jupyter-ai“ selbst Open-Source ist, erfordern die leistungsstarken KI-Modelle, mit denen es sich verbindet, in der Regel einen API-Schlüssel von einem Anbieter (z. B. OpenAI, Anthropic) und verursachen nutzungsabhängige Kosten, die normalerweise nach „Tokens“ abgerechnet werden.

Um Kontextbeschränkungen zu überwinden, benötigen Sie eine wissensbewusste KI-Plattform, die alle verstreuten Informationen Ihres Teams aus Tools wie Confluence, Slack und Google Docs vereinheitlicht. Dies ermöglicht der KI, Antworten und Unterstützung auf der Grundlage der gesamten Wissensdatenbank Ihrer Organisation zu geben, die über den reinen Code in einem Notebook hinausgeht.

Der Übergang zu einem wissensbewussten KI-Workflow reduziert den Kontextwechsel erheblich, hilft Entwicklern, bessere Entscheidungen zu treffen, indem er sofortigen Zugriff auf organisatorisches Wissen bietet, und steigert letztendlich die Gesamtproduktivität über die reine schnellere Codegenerierung hinaus.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.