ここしばらく、Jupyterノートブック内でAIコーディングパートナーを持つというアイデアは、データサイエンティストや開発者にとって究極の目標のように感じられてきました。GitHub Copilotのようなツールが大きな話題を呼び始めると、誰もがその同じ力をノートブックの中でも使いたいとさらに強く思うようになりました。これらの初期のツールの背後にあったエンジンは、OpenAI Codexという、平易な英語を機能するコードに変えることを約束したモデルでした。

このガイドでは、CodexとJupyterの物語、その地位を継いだ現代のツールを紹介し、生産性の真の向上は、ノートブックの枠を超え、チーム全体のナレッジベースを理解するAIに目を向けることにあると論じます。

OpenAI Codexとは?

OpenAI Codexは、自然言語のプロンプトを受け取り、コードを生成できるAIシステムでした。これはGPT-3のスピンオフであり、膨大な量のテキストと数十億行の公開コードでトレーニングされていました。これが、GitHub Copilotの最初のバージョンを支えていたものです。

Codexは非常に多機能で、Python、JavaScript、Rubyなど十数種類の言語に対応していました。単なるオートコンプリートだけでなく、コードの塊が何をしているかを説明したり、言語間でコードを翻訳したり、リファクタリングを手伝ったりすることもできました。

しかし、ここで重要な点があります。オリジナルのOpenAI Codexモデルは、2023年3月に正式に廃止されました。基盤となる技術は進化し、その後継機は現在OpenAIの新しいモデルに組み込まれていますが、初期のインテグレーションがすべて構築されていた特定のCodex APIはなくなりました。この一つの変更が、JupyterにおけるAIツールの状況全体を大きく変えたのです。

JupyterへのOpenAI Codex導入に向けたコミュニティの動き

公式ツールが登場する前から、開発者コミュニティはすでにお気に入りのノートブック環境にAIを導入しようと懸命に活動していました。多くのデータサイエンティストやMLエンジニアはJupyterを中心に活動しており、セルごとの反復的なワークフローは彼らの思考方法そのものです。Copilotを使うためだけにVS Codeに切り替えることは、「面倒」で煩わしい中断だと感じられていました。

初期にコミュニティが構築したソリューション

この不満が、多くのオープンソースプロジェクトを生み出しました。「gpt-jupyterlab」や「jupyterlab-codex」のようなツールが登場し、開発者はノートブックのセルの内容をOpenAI APIに送信できるようになりました。セットアップは通常非常にシンプルで、パッケージを「pip install」し、OpenAI APIキーをJupyterLabの設定に貼り付けるだけで、コードを生成する新しいボタンが表示されました。これらのツールは、コミュニティが必要なものを自ら作り上げた素晴らしい例でした。

初期インテグレーションの課題と限界

これらは有望でしたが、初期のインテグレーションには長期的に頼るには難しい問題点がいくつかありました。

-

セットアップの煩雑さ: ユーザーは、特にリモートサーバーでのインストール中に頻繁に行き詰まりました。これらのプラグインの多くは、動作するためにJupyterLabサーバーの完全な再起動が必要で、設定がなぜ機能しないのかを突き止めるのに午後のかなりの時間を費やすこともありました。

-

時代遅れのモデル: これらのツールのほとんどは、オリジナルのCodexモデル専用に作られていました。それらが廃止されると、拡張機能は、より新しく(そして価格体系も異なる)OpenAIモデルを使用するように完全に作り直されない限り、基本的に機能しなくなりました。

-

最大の盲点:コンテキストの欠如: 最も根本的な問題は、これらのツールが孤立して動作していたことでした。一つのセル内のコードは見ることができましたが、Confluenceにあるプロジェクトのドキュメントや、Google Docsにある仕様書、あるいはマネージャーがSlackに投稿した重要な明確化にはまったくアクセスできませんでした。AIはコードを書くことはできましたが、なぜそれを書いているのかは理解していませんでした。

現在の状況

単純なCodexプラグインの時代から、状況は確実に成熟しました。焦点は単一モデルに特化したハックから、さまざまなAIプロバイダーに接続できる、より堅牢で柔軟なフレームワークへと移っています。

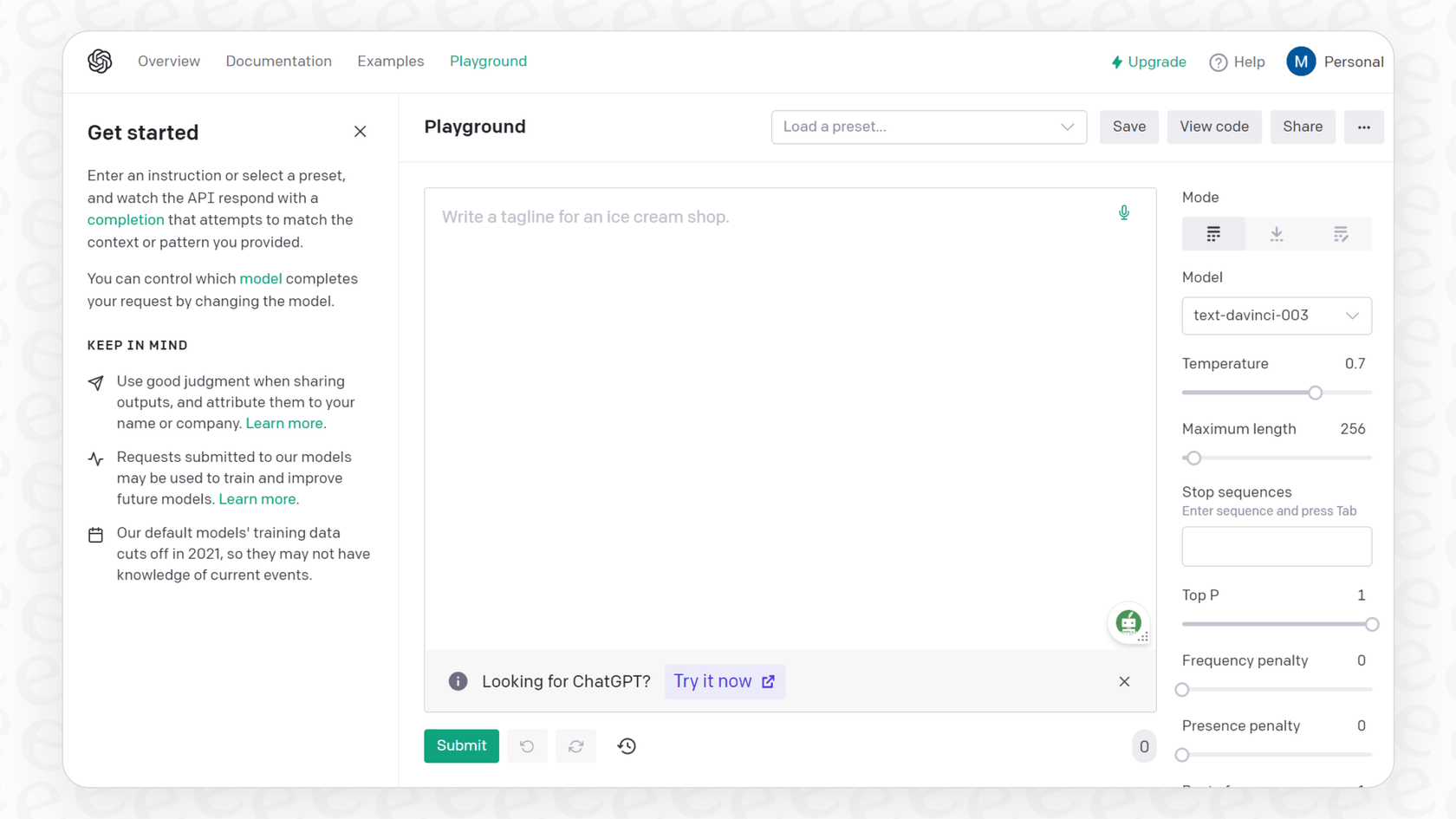

「jupyter-ai」の台頭

現在の主要なプレーヤーは、Jupyterチームによる公式プロジェクトである「jupyter-ai」です。これは、JupyterLabとJupyter Notebookに直接生成AIを組み込みます。「jupyter-ai」は一つの古いモデルに縛られるのではなく、OpenAI、Anthropic、Cohere、さらにはHugging Faceのオープンソースモデルなど、さまざまなプロバイダーの最新モデルに対応する汎用的なアダプターのようなものです。

これには、コードについて質問できる組み込みのチャットUIに加え、便利な「%%ai」「マジックコマンド」が付属しています。これらを使用すると、ノートブックのセル内で簡単なプロンプトからコードを生成したり、エラーを修正したり、関数全体を作成したりすることができます。

価格とセットアップに関する考慮事項

「jupyter-ai」はオープンソースですが、それが接続する強力なモデルは無料ではありません。OpenAIやAnthropicのようなプロバイダーからAPIキーを取得する必要があり、使用量に応じて、通常は「トークン」(AIが処理する単語の断片)に基づいて請求されます。無料ベータの時代は終わり、コーディングに十分な性能を持つモデルへのアクセスは有料サービスとなりました。例えば、OpenAIの最新モデルはAPI経由で、またはChatGPT TeamやEnterpriseのようなプランの一部として利用できます。

| プロバイダー | モデル例 | 最適な用途 |

|---|---|---|

| OpenAI | 「gpt-4o」、「gpt-3.5-turbo」 | 汎用的なコード生成、説明 |

| Anthropic | 「claude-3-sonnet」 | 複雑な推論、大規模なコンテキストの処理 |

| Hugging Face | 様々なオープンソースモデル | 特化したタスク、自社インフラでの実行 |

Jupyter AIの開発者によるこの動画は、このツールがどのようにして使い慣れたノートブック環境に直接生成AI機能をもたらすかを実演しています。

コード補完の先へ:ノートブック内AIの限界

「jupyter-ai」のような洗練されたツールを使っても、まだ大きな限界があります。それは、AIが開発者のコーディング環境の中に閉じ込められていることです。優れた開発者はコードを書くだけではありません。ビジネス目標を理解し、技術仕様を読み、チームと対話する必要があります。そうした情報を一切見ることができないAIアシスタントは、問題の半分しか解決していません。

開発者の一日がどれだけコンテキストの切り替えに費やされているか考えてみてください。ノートブックに集中している最中に、作業を中断して新しいタブを開き、ConfluenceでAPIドキュメントを検索し、Slackチャンネルをスクロールして誰かが下した決定を見つけ、Googleドキュメントを開いてデザインを確認する。こうした小さな中断の一つ一つが集中力を途切れさせ、作業を遅らせるのです。

社内AIアシスタントでツールを統合

ここで私たちは、単なるコーディングアシスタントを超え、ナレッジを認識するAIプラットフォームについて考える必要があります。「jupyter-ai」がモデルをノートブックに持ち込むのに対し、eesel AIのようなツールは、会社に散在するすべてのナレッジをAIに提供します。

eesel AIの社内チャットを使えば、組織独自のデータでトレーニングされたアシスタントをセットアップできます。Notion、SharePoint、Microsoft Teamsなど、チームがすでに依存しているツールと直接連携します。

開発者がJupyterで作業中にデータスキーマについて質問があると想像してみてください。すべてを中断してドキュメントを探し回る代わりに、Slackのeesel AIボットに尋ねるだけです。「user_profilesテーブルの必須フィールドは何ですか?」ボットは、チームの公式ドキュメントから直接引き出した、即時かつ正確な回答を提供します。これがナレッジを統合するということの真価であり、絶え間ないコンテキストの切り替えを減らし、開発者が自分の仕事に集中できるようにするのです。

はじめに:ナレッジ対応ワークフローへの移行

最初のJupyterとOpenAI Codexのインテグレーションから今日に至るまでの道のりは、明確なパターンを示しています。私たちは基本的なプラグインから、柔軟なノートブック内アシスタントへと進化しました。次の論理的なステップは、完全に接続された、ナレッジを認識するAIワークフローです。開発者の生産性の未来は、単にコードを速く生成することだけではありません。開発者がより少ない手間で、より良い意思決定を下せるように支援することです。

そして、それを実現するのに大規模で数ヶ月にわたるプロジェクトは必要ありません。シンプルに設計されたプラットフォームを使えば、すぐに始めることができます。例えば、eesel AIは徹底的にセルフサービス型に作られているため、**数ヶ月ではなく数分で本番稼働できます。**延々と続くデモやカスタム実装プロジェクトを待つことなく、ナレッジソースを接続し、チーム向けの社内AIアシスタントを展開できます。

より速く、だけでなく、より賢く開発する

JupyterにおけるAIによるコード補完は、私たちの多くが仕事のやり方を変える素晴らしいツールです。しかし、AIがチームのドキュメント、会話、ビジネス目標からのコンテキスト、つまり全体像を把握しているときに、その真価が発揮されます。社内のすべてのナレッジを接続することで、単にコードを書くだけでなく、開発者が正しいコードをより速く構築するのを助けるアシスタントを作成できます。

あなたのビジネスを本当に理解するAIを開発者に提供する準備はできましたか?ナレッジを統合し、チームの生産性を真に向上させるために、eesel AIをお試しください。

よくある質問

初期のインテグレーションを支えていたオリジナルのOpenAI Codexモデルは、2023年3月に正式に廃止されました。その基盤技術は新しいOpenAIモデルに引き継がれましたが、特定のCodex APIはもはや利用できないため、Jupyterとの直接的な「OpenAI Codexインテグレーション」は新しいプロジェクトには時代遅れです。

現代の主要な代替手段は「jupyter-ai」です。この公式のJupyterプロジェクトは汎用的なアダプターとして機能し、JupyterLabとJupyter NotebookをOpenAI、Anthropic、Hugging Faceなどのプロバイダーが提供する最新の生成AIモデルに接続します。

初期のインテグレーションは、セットアップが複雑であること、Codexモデルが廃止されるとすぐに時代遅れになること、そして決定的に、ドキュメントやチームの議論といったより広いプロジェクトのコンテキストにアクセスできず、知識の空白地帯で動作していたことなどが問題点として挙げられます。

はい、「jupyter-ai」自体はオープンソースですが、それが接続する強力なAIモデルは通常、プロバイダー(例:OpenAI、Anthropic)からのAPIキーを必要とし、通常は「トークン」単位で課金される使用量ベースのコストが発生します。

コンテキストの限界を克服するには、Confluence、Slack、Google Docsなどのツールから散在するチームのすべての情報を統合する、ナレッジ対応のAIプラットフォームが必要です。これにより、AIは単にノートブック内のコードだけでなく、組織全体のナレッジベースに基づいて回答や支援を提供できるようになります。

ナレッジ対応のAIワークフローに移行することで、コンテキストの切り替えが大幅に減少し、組織の知識への即時アクセスを提供することで開発者がより良い意思決定を下すのを助け、最終的には単なるコード生成の高速化を超えて全体的な生産性を向上させます。

この記事を共有

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.