Die Wahl der richtigen Large Language Model (LLM) API für Ihr Projekt fühlt sich wie eine riesige Verpflichtung an, denn, nun ja, das ist es auch. Die API, auf der Sie aufbauen, wird die Leistung Ihres Produkts, Ihre monatliche Rechnung und die Meinung Ihrer Nutzer direkt beeinflussen.

Momentan sind die beiden Namen, die jedem im Kopf herumschwirren, OpenAI und Anthropic. Beide spielen an der Spitze mit, aber sie gehen KI aus ziemlich unterschiedlichen Blickwinkeln an, jeder mit eigenen technischen Stärken und Philosophien.

Dieser Leitfaden soll Ihnen helfen, die Optionen zu sortieren. Wir geben Ihnen einen unkomplizierten Vergleich der OpenAI API vs. Anthropic API und betrachten alles von der Entwicklererfahrung über die Leistung bis hin zu den Preisen. Wir werden auch untersuchen, warum sich für viele Unternehmen, insbesondere im Kundenservice, die Frage von mit welcher API man bauen soll zu was ist der schnellste Weg, dies zum Laufen zu bringen verschiebt.

Was ist die OpenAI API?

OpenAI ist das Unternehmen, das die ganze generative KI-Party erst so richtig ins Rollen gebracht hat. Sie sind berühmt für die Entwicklung leistungsstarker und vielseitiger Modelle, die die Aufmerksamkeit aller auf sich gezogen haben.

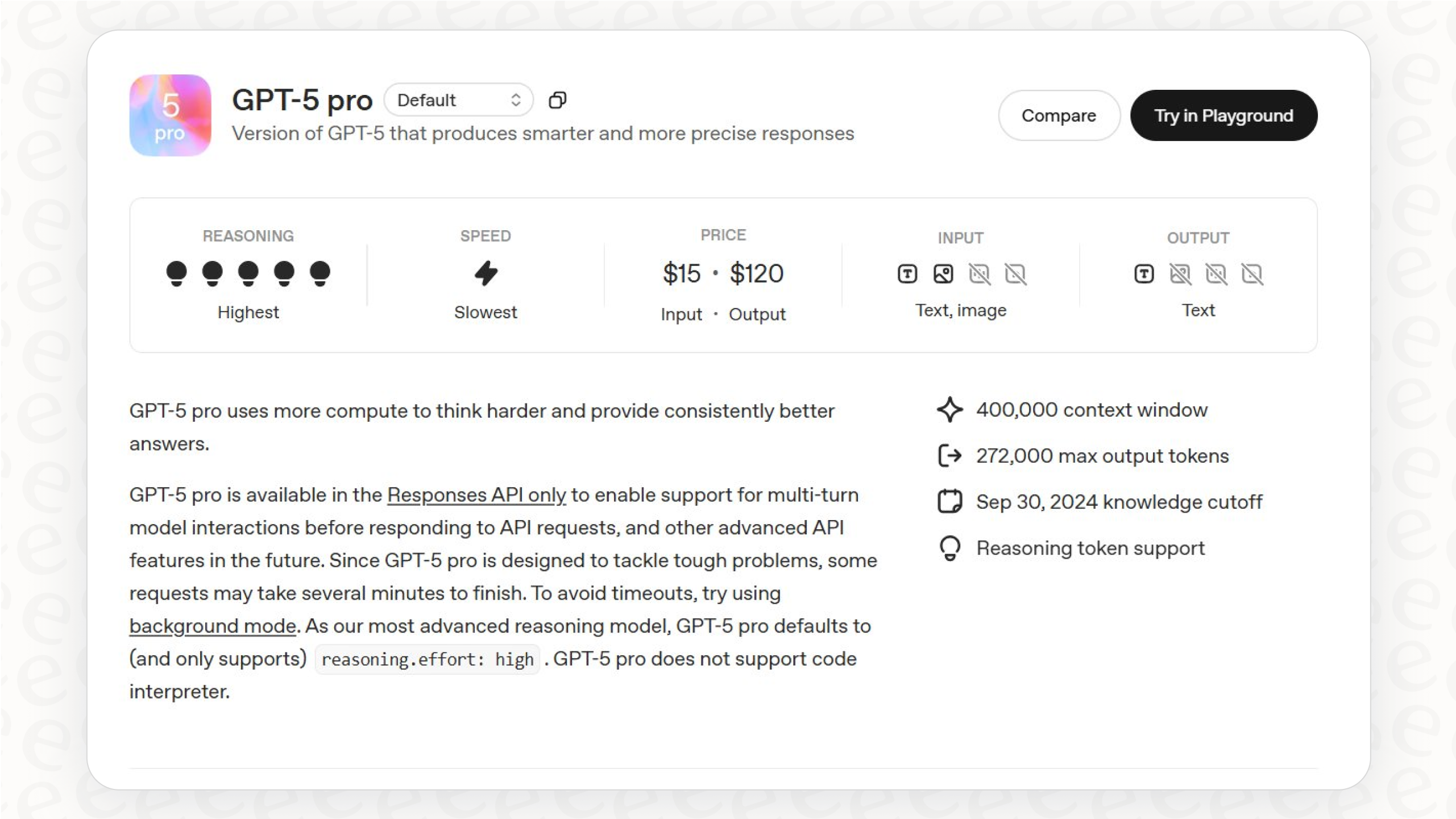

Ihre Spitzenmodelle, wie die GPT-Serie (einschließlich des neuesten GPT-4o), sind dafür bekannt, großartige Alleskönner zu sein. Sie sind solide im allgemeinen logischen Denken, im kreativen Schreiben und werden immer besser darin, Text, Bilder und Audio gleichzeitig zu verarbeiten. Die OpenAI API ist so konzipiert, dass sie von so vielen Menschen wie möglich schnell erlernt und genutzt werden kann, und gibt Entwicklern die Werkzeuge an die Hand, um alles von einfachen Content-Tools bis hin zu komplexen Agenten zu bauen, die tatsächlich Aufgaben erledigen können. Für viele ist sie die Standardwahl für eine flexible, leistungsstarke und praxiserprobte Grundlage.

Was ist die Anthropic API?

Anthropic tauchte 2021 auf, gegründet von einer Gruppe ehemaliger OpenAI-Forscher, die sich stark auf die Sicherheit von KI konzentrieren wollten. Ihre Mission ist es, KI-Systeme zu bauen, die zuverlässig, vorhersagbar und leichter zu steuern sind, was ein etwas anderes Ziel ist als nur die Jagd nach reiner Leistung.

Ihre Hauptmodellfamilie ist Claude, wobei Claude 3.5 Sonnet der aktuelle Star ist. Es ist bekannt für sein riesiges Kontextfenster (was bedeutet, dass es sehr lange Dokumente lesen und sich merken kann), seine gute Leistung bei geschäftsorientierten Aufgaben und seine von Anfang an integrierte Sicherheit. Sie verwenden eine Methode, die sie „Konstitutionelle KI“ nennen, bei der das Modell darauf trainiert wird, sich an eine Reihe ethischer Prinzipien zu halten. Dies macht die Anthropic API zu einer soliden Wahl für Unternehmen in regulierten Branchen oder in jeder Situation, in der man sich absolut darauf verlassen muss, dass sich die KI vorhersagbar verhält.

Ein detaillierter Vergleich: OpenAI API vs. Anthropic API

Obwohl beide Plattformen Spitzenmodelle haben, kann die tatsächliche Erfahrung beim Entwickeln mit ihren APIs völlig unterschiedlich sein. Schauen wir uns die Details an, die Ihnen als Entwickler oder Teamleiter wirklich auffallen werden.

Entwicklererfahrung und API-Funktionen

Verbringt man ein wenig Zeit in Entwicklerforen, zeichnet sich ein klares Bild ab: Beide APIs sind leistungsstark, aber sie haben ihre Eigenheiten, die ein Projekt zum Erfolg oder Misserfolg führen können. Die kleinen Details in ihrem Design sind wirklich entscheidend.

Wie sie Nachrichten strukturieren

-

OpenAI: Die API ist bekannt für ihre enorme Flexibilität. Sie können Systemnachrichten an jeder Stelle einer Konversation hinzufügen und sogar aufeinanderfolgende Nachrichten von derselben „Person“ haben (wie zwei Benutzernachrichten hintereinander). Das mag unbedeutend klingen, ist aber eine große Hilfe, um komplexe Chats zu simulieren oder Workflows zu erstellen, bei denen eine KI mehrere Tools verwenden muss, bevor sie ihre endgültige Antwort gibt.

-

Anthropic: Hier sind die Dinge viel strenger. Es erzwingt ein „Benutzer“ -> „Assistent“ -> „Benutzer“-Muster und erlaubt nur eine einzige Systemanweisung ganz am Anfang. Das macht die API zwar vorhersagbar, kann aber wirklich lästig sein, wenn man versucht, dynamischere Apps zu erstellen, wie zum Beispiel eine, die eine Konversation mit neuen Informationen wieder aufnehmen muss.

Wie sie mit Tools umgehen (Function Calling)

-

OpenAI: Dies ist eine echte Stärke von OpenAI. Die API verfügt über solides Function Calling, einschließlich der Fähigkeit, mehrere Tools gleichzeitig aufzurufen. Dadurch kann die KI entscheiden, dass sie mehrere Dinge tun muss, wie zum Beispiel eine Bestellung nachschlagen und einen Hilfeartikel überprüfen, und alles auf einmal anfordern. Das ist einfach effizienter und fühlt sich weniger roboterhaft an.

-

Anthropic: Die Tool-Nutzung fühlt sich hier etwas umständlicher und schrittweiser an. Entwickler haben festgestellt, dass man das Modell durch eine starre Hin- und Her-Konversation führen muss, wenn es mehrere Tools verwenden soll. Dies führt zu Verzögerungen, kostet mehr Tokens und macht die Entwicklung komplizierter. Es gibt auch einen überraschend hohen Token-Overhead, nur um die Funktion zu aktivieren.

Arbeiten mit Bildern und Audio

Beide Unternehmen machen große Fortschritte im Bereich Vision und ermöglichen ihren Modellen das Verstehen von Bildern. Dennoch fühlt sich das Ökosystem von OpenAI im Moment etwas vollständiger an. Mit Werkzeugen wie Whisper für Sprache-zu-Text und DALL·E für die Bilderzeugung unter einem Dach bietet es einfach ein umfassenderes Multimedia-Toolkit direkt einsatzbereit.

Das Fazit für Entwickler

Direkt auf einer dieser APIs zu bauen bedeutet, dass Sie sich darauf einlassen, mit ihren spezifischen Eigenheiten umzugehen. Für etwas wie den Kundenservice kann es sich so anfühlen, als würden Sie dasselbe bauen, was alle anderen schon gebaut haben. Eine Plattform wie eesel AI nimmt Ihnen all diese kniffligen Dinge ab. Sie müssen nicht mit Nachrichtenstrukturen oder Tool-Nutzungsbeschränkungen kämpfen; Sie verbinden einfach Ihre Wissensdokumente, beschreiben in einfachem Englisch, was der Agent tun soll, und lassen die Plattform die unordentlichen Implementierungsdetails herausfinden.

Leistung, Anwendungsfälle und Sicherheit

Das „beste“ Modell hängt wirklich nur davon ab, was Sie versuchen zu tun.

Wofür sie gut sind

-

OpenAI: Seine Flexibilität und kreativen Fähigkeiten machen es zu einer großartigen Wahl für breite, verbraucherorientierte Apps, die Erstellung von Inhalten und alles, was erstklassige allgemeine Intelligenz erfordert. Wenn Sie etwas Neues bauen und Ideen schnell testen möchten, ist die API von OpenAI oft der schnellere Weg zum Ziel.

-

Anthropic: Claude schneidet im Geschäftskontext wirklich gut ab. Es ist perfekt für Aufgaben, bei denen es darum geht, lange Dokumente zu durchforsten, wie z.B. die Überprüfung von Rechtsverträgen, die Zusammenfassung von Finanzberichten oder die Bearbeitung detaillierter Kundensupport-Tickets, bei denen Sie es sich nicht leisten können, falsch zu liegen.

Ihr Ansatz zu Ethik und Kontrolle

-

OpenAI: Das Unternehmen setzt stark auf eine Technik namens Reinforcement Learning from Human Feedback (RLHF). Das bedeutet im Grunde, dass menschliche Prüfer die Antworten des Modells bewerten, wodurch es im Laufe der Zeit lernt, hilfreicher und weniger schädlich zu sein. Das funktioniert, aber es kann manchmal die subtilen Vorurteile seiner menschlichen Trainer aufgreifen.

-

Anthropic: Ihre "Konstitutionelle KI" ist das, was sie auszeichnet. Das Modell wird mit einer Reihe von Grundprinzipien (seiner „Verfassung“) trainiert und lernt, seine eigenen Antworten an diesen Prinzipien zu messen. Die Idee ist, ein Modell zu schaffen, das von Natur aus vorhersagbarer ist und weniger wahrscheinlich etwas Abwegiges sagt, ohne ständige menschliche Betreuung zu benötigen.

Für Unternehmen läuft es oft darauf hinaus: Benötigen Sie die rohe, flexible Kraft von OpenAI oder die beständige, vorhersagbare Sicherheit von Anthropic?

Plattformen wie eesel AI bieten einen anderen Weg. Durch die Verwendung leistungsstarker Modelle im Hintergrund bietet Ihnen eesel AI das Beste aus beiden Welten. Sie erhalten die Intelligenz eines Spitzenmodells, aber mit vollständiger Kontrolle über eine einfache Benutzeroberfläche. Sie können eine benutzerdefinierte KI-Persönlichkeit festlegen, ihr Wissen auf Ihre genehmigten Dokumente beschränken und einen leistungsstarken Simulationsmodus verwenden, um sicherzustellen, dass sie sich genau so verhält, wie Sie es erwarten, bevor ein Kunde jemals mit ihr spricht.

Preise und Geschäftsmodelle

Sowohl OpenAI als auch Anthropic haben eine ähnliche Preisstruktur. Sie bieten monatliche Abonnements für ihre Chatbots (ChatGPT Plus und Claude Pro) und dann ein Pay-as-you-go-Modell für ihre APIs an.

Diese API-Preisgestaltung basiert auf „Tokens“, was einfach kleine Wortteile sind (ein Token entspricht etwa drei Vierteln eines Wortes). Sie zahlen für die Tokens, die Sie einsenden (Input), und die Tokens, die Sie zurückbekommen (Output). Das ist für den Anfang in Ordnung, aber es kann Ihre Kosten wirklich schwer vorhersagbar machen. Wenn Ihr Support-Team in einem Monat mit Tickets überflutet wird, könnte Ihre API-Rechnung ohne Vorwarnung in die Höhe schnellen.

Hier ist ein kurzer Blick darauf, wie sich ihre API-Preise vergleichen für einige ihrer beliebten Modelle.

| Modell | Anbieter | Eingabepreis (pro 1 Mio. Tokens) | Ausgabepreis (pro 1 Mio. Tokens) |

|---|---|---|---|

| GPT-4o | OpenAI | $2.50 | $10.00 |

| Claude 3.5 Sonnet | Anthropic | $3.00 | $15.00 |

| Claude 3 Opus | Anthropic | $15.00 | $75.00 |

| Claude 3 Haiku | Anthropic | $0.25 | $1.25 |

Die Preise basieren auf öffentlichen Informationen von Ende 2024 und können sich ändern.

Der größte Kopfschmerz bei der tokenbasierten Preisgestaltung ist der Versuch, dafür ein Budget zu erstellen. Wie prognostizieren Sie Ihre Kosten, wenn diese direkt davon abhängen, wie viele Kunden Sie kontaktieren? Hier kann ein anderer Ansatz viel sinnvoller sein. Im Gegensatz dazu ist die Preisgestaltung von eesel AI klar und vorhersagbar. Die Pläne basieren auf einer festen Anzahl von KI-Konversationen pro Monat, ohne zusätzliche Gebühren pro gelöstem Ticket. Dies ermöglicht es Ihnen, Ihre Support-Automatisierung zu skalieren, ohne sich am Ende des Monats um eine überraschende Rechnung sorgen zu müssen.

Die Lösung: Über die API-Debatte hinausdenken

Also, hier ist die eigentliche Frage: Wenn Ihr Ziel darin besteht, den Kundensupport zu automatisieren, ist es dann wirklich sinnvoll, dass Ihre Ingenieure Monate damit verbringen, eine maßgeschneiderte Lösung auf einer rohen API zu entwickeln und zu warten? Für die meisten Unternehmen lautet die Antwort wahrscheinlich nein.

Eine KI-Integrationsplattform ist der klügere und schnellere Weg.

-

Startklar in Minuten, nicht Monaten: Mit einem Tool wie eesel AI können Sie Ihren Helpdesk, wie Zendesk oder Freshdesk, und all Ihre Wissensquellen, Confluence, Google Docs oder sogar frühere Support-Tickets, mit nur wenigen Klicks verbinden. Es ist eine Self-Service-Plattform, die Welten entfernt ist von der langwierigen Entwicklungsarbeit, die beim Bau von Grund auf anfällt.

-

Führen Sie Ihr gesamtes Wissen zusammen: Anstatt mit einer generischen KI zu beginnen, lernt eesel AI sofort vom tatsächlichen Wissen Ihres Unternehmens. Es liest Ihre früheren Tickets, internen Wikis und Help-Center-Dokumente, um Antworten zu geben, die genau, auf Sie zugeschnitten und in der Stimme Ihrer Marke sind.

-

Testen ohne Risiko: Das ist ein riesiger Vorteil. Die Simulations-Engine von eesel AI ermöglicht es Ihnen, Ihren KI-Agenten an Tausenden Ihrer früheren Tickets in einer sicheren Umgebung zu testen. Sie erhalten eine genaue Prognose darüber, wie gut er funktionieren wird, bevor Sie ihn jemals für echte Kunden einschalten, was einen Großteil des Risikos aus der Gleichung nimmt.

Die richtige Wahl für Ihr Ziel treffen

Wenn Sie sich zwischen OpenAI und Anthropic entscheiden, hängt die richtige Wahl wirklich davon ab, wohin Sie wollen.

-

Entscheiden Sie sich für die OpenAI API, wenn Sie maximale Flexibilität, die neuesten Multimedia-Funktionen und eine Grundlage für die Entwicklung aller Arten von Allzweck-Apps benötigen.

-

Entscheiden Sie sich für die Anthropic API, wenn Sie Zuverlässigkeit auf Unternehmensniveau, erstklassige Sicherheit und ein Modell benötigen, das bei der Analyse langer, komplexer Dokumente unschlagbar ist.

Aber für die meisten Unternehmen, die versuchen, ein spezifisches Problem wie die Automatisierung des Kundensupports zu lösen, ist die Frage „Build vs. Buy“ weitaus wichtiger als die Frage „OpenAI vs. Anthropic“. Von Grund auf neu zu bauen ist ein langer, teurer und riskanter Weg.

Plattformen wie eesel AI bieten Ihnen einen direkten Weg zu Ergebnissen. Sie bieten die schnellste, zuverlässigste und kostengünstigste Möglichkeit, leistungsstarke KI in einem geschäftlichen Umfeld einzusetzen, sodass Sie sich darauf konzentrieren können, Ihre Kunden glücklich zu machen, anstatt die API-Infrastruktur zu verwalten.

Sind Sie bereit zu sehen, wie einfach KI-gestützter Support sein kann? Starten Sie in wenigen Minuten mit eesel AI und erleben Sie, wie es Ihre Kundenservice-Abläufe verändern kann.

Häufig gestellte Fragen

OpenAI konzentriert sich auf die Entwicklung leistungsstarker, vielseitiger Allzweckmodelle wie GPT-4o und legt Wert auf breite Anwendbarkeit und Flexibilität für vielfältige Aufgaben. Anthropic hingegen priorisiert mit seinen Claude-Modellen die Sicherheit, Vorhersagbarkeit und Einhaltung ethischer Prinzipien durch sein „Constitutional AI“-Training.

Die API von OpenAI bietet mehr Flexibilität in der Nachrichtenstruktur und robustes Multi-Tool-Calling für komplexe Arbeitsabläufe. Die API von Anthropic ist mit ihren „Benutzer“ -> „Assistent“-Nachrichtenmustern strenger, und ihre Tool-Nutzung kann sich starrer und tokenintensiver anfühlen, was oft eine sequenziellere Führung erfordert.

Obwohl OpenAI sehr vielseitig ist, zeichnen sich die Claude-Modelle von Anthropic besonders im Geschäftskontext aus. Sie sind ideal für Aufgaben, die umfangreiche Dokumentenanalysen oder detaillierten Kundensupport erfordern, bei denen Vorhersagbarkeit, ein großes Kontextfenster und eingebaute Sicherheitsfunktionen entscheidend sind.

Beide Plattformen verwenden hauptsächlich eine tokenbasierte Pay-as-you-go-Preisstruktur für ihre APIs, bei der sowohl für Eingabe- als auch für Ausgabetokens Gebühren anfallen. Dieses Modell ist zwar üblich, kann die Budgetierung jedoch erschweren, da die Kosten direkt mit dem Nutzungsvolumen schwanken, was zu potenziell unvorhersehbaren monatlichen Rechnungen führen kann.

Für Unternehmen, die spezifische Funktionen wie den Kundensupport automatisieren möchten, kann eine Integrationsplattform wie eesel AI eine schnellere und kostengünstigere Wahl sein. Sie kümmert sich um die API-Komplexität, integriert verschiedene Wissensquellen und bietet vorhersehbare Preise, sodass Sie sich auf Geschäftsergebnisse statt auf die Infrastruktur konzentrieren können.

OpenAI verwendet Reinforcement Learning from Human Feedback (RLHF), um Modelle an menschliche Werte anzugleichen, was manchmal subtile Vorurteile der menschlichen Trainer widerspiegeln kann. Anthropic setzt auf „Constitutional AI“ und trainiert Modelle mit expliziten ethischen Prinzipien, um ein vorhersagbareres und von Natur aus sichereres Verhalten ohne ständige menschliche Eingriffe zu erreichen.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.