Einen wirklich effektiven KI-Agenten zu entwickeln, kann sich für viele Teams wie die nächste große Hürde anfühlen. Die Begeisterung ist definitiv da, aber seien wir ehrlich, die Herausforderungen sind es auch. Sobald Sie anfangen, sich damit zu befassen, werden Sie mit einer schwindelerregenden Auswahl an Frameworks und Tools konfrontiert. Zwei Namen, die ständig auftauchen, sind LangChain und LangGraph. Die Wahl zwischen ihnen fühlt sich wie eine wichtige Weggabelung an, die darüber entscheidet, wie Sie Ihre KI entwickeln, starten und warten.

Das Problem ist, dass beide dieser leistungsstarken Frameworks eine erhebliche Investition in Zeit, technisches Know-how und laufende Wartung erfordern, um von einem coolen Prototyp zu einem zuverlässigen, produktionsreifen Agenten zu gelangen. Dieser Leitfaden soll Klarheit schaffen. Wir werden die wirklichen Unterschiede in der Debatte LangChain vs. LangGraph aufschlüsseln, untersuchen, wo sie glänzen (und wo nicht), und Ihnen einen direkteren Weg zeigen, um leistungsstarke KI-Agenten für den Kundensupport und interne Helpdesks zu starten.

Was ist LangChain?

LangChain ist ein Open-Source-Framework, das entwickelt wurde, um die Erstellung von Anwendungen zu vereinfachen, die auf großen Sprachmodellen (LLMs) basieren. Sein ganzes Konzept besteht darin, „Chains“ (Ketten) zu erstellen. Stellen Sie es sich wie ein einfaches Fließband oder ein Rezept vor, bei dem jeder Schritt dem letzten in einer geraden, vorhersagbaren Reihenfolge folgt.

Sein Hauptzweck ist es, LLMs auf eine saubere, modulare Weise mit externen Daten wie den Dokumenten Ihres Unternehmens oder verschiedenen APIs zu verbinden. Mit der sogenannten LangChain Expression Language (LCEL) können Sie verschiedene Komponenten – einen Prompt, ein Modell, eine Datenquelle – miteinander verketten, um einen vollständigen Workflow zu erstellen. Es ist ein großartiges Werkzeug für unkomplizierte, lineare Aufgaben, bei denen Sie genau wissen, was in welcher Reihenfolge passieren muss.

Was ist LangGraph?

LangGraph ist eine Erweiterung von LangChain, aber es wurde speziell für die Erstellung fortschrittlicherer, zustandsbehafteter KI-Agenten entwickelt, die mehr Komplexität bewältigen können. Anstelle einer geraden Linie behandelt es Workflows als einen Graphen, der aus „Knoten“ (den einzelnen Aufgaben) und „Kanten“ (den Verbindungen zwischen ihnen) besteht. Dieses Setup ermöglicht Schleifen, bedingte Verzweigungen und ein viel dynamischeres, intelligenteres Verhalten.

Stellen Sie es sich weniger wie ein Fließband und mehr wie ein detailliertes Flussdiagramm vor, das seinen Kurs ändern kann. Diese Struktur ist ein großer Vorteil für Agenten, die denken, schlussfolgern und ihren Plan basierend auf neuen Informationen, Benutzerfeedback oder aufgetretenen Fehlern anpassen müssen.

Architektur und Workflow: Ketten vs. Zyklen

Der größte Unterschied zwischen LangChain und LangGraph liegt in ihrer grundlegenden Architektur. Dies ist nicht nur ein technisches Detail; es verändert die Arten von Workflows, die Sie erstellen können, und wie Sie sie verwalten, vollständig.

LangChains linearer Ansatz für einfache Aufgaben

LangChain verwendet seine Expression Language (LCEL), um Komponenten zu einem sogenannten gerichteten azyklischen Graphen (DAG) zu verketten. Das ist eine komplizierte Umschreibung dafür, dass der Prozess in eine Richtung fließt und nicht zu sich selbst zurückkehren kann. Es ist sauber, einfach und funktioniert für bestimmte Aufgaben wirklich gut.

Es eignet sich am besten für Dinge wie Retrieval-Augmented Generation (RAG) Pipelines, bei denen ein Agent Informationen abruft, um eine Frage zu beantworten, oder für einfache Bots, die nur Text zusammenfassen. Der Prozess ist vorhersagbar: Eine Eingabe geht an einem Ende hinein, durchläuft die Schritte, und eine Ausgabe kommt am anderen Ende heraus.

Aber diese Einfachheit ist auch seine größte Schwäche. In dem Moment, in dem Ihr Agent komplexere Interaktionen bewältigen muss, fühlt sich das lineare Modell einschränkend an. Was passiert, wenn Sie einen fehlgeschlagenen API-Aufruf wiederholen, dem Benutzer eine klärende Frage stellen oder eine menschliche Überprüfung abwarten müssen? Am Ende müssen Sie umständliche Umgehungslösungen bauen, die nicht natürlich in die Kettenstruktur passen.

LangGraphs dynamischer Ansatz für komplexe Agenten

LangGraph wurde entwickelt, um genau diese Probleme zu lösen. Seine zyklische Graphenstruktur gibt Ihnen die volle Kontrolle über den Workflow. Agenten können zu einem vorherigen Schritt zurückkehren, verschiedene Pfade je nach Situation wählen und einen „Zustand“ beibehalten, der den Kontext über die gesamte Interaktion hinweg trägt.

Dies macht es zur richtigen Wahl für den Aufbau von Multi-Agenten-Systemen, interaktiven Assistenten, die eine richtige Unterhaltung führen können, und Workflows, die eine „Human-in-the-Loop“-Überprüfung für Genehmigungen benötigen. Es ist für die Art von robustem, intelligentem Verhalten konzipiert, das reale Anwendungen erfordern.

Aber all diese Macht hat ihren Preis. LangGraph hat eine viel steilere Lernkurve.

Eine Alternative: Eine No-Code-Workflow-Engine für Support-Teams

Was also, wenn Sie die Leistungsfähigkeit eines dynamischen Graphen benötigen, sich aber nicht in komplexem Python-Code verheddern wollen? Hier kann eine integrierte Plattform den entscheidenden Unterschied machen.

eesel AI bietet die Vorteile einer vollständig anpassbaren Workflow-Engine, jedoch über ein einfaches Self-Service-Dashboard. Es wurde entwickelt, um Ihnen den Aufbau anspruchsvoller KI-Agenten für Ihr Support-Team zu ermöglichen, ohne ein dediziertes Entwicklerteam zu benötigen. Sie können:

-

Selektive Automatisierung einrichten: Verwenden Sie eine unkomplizierte Benutzeroberfläche, um Regeln zu erstellen, die genau definieren, welche Tickets Ihre KI bearbeiten soll. Sie können mit einfachen, sich wiederholenden Fragen beginnen und alles andere an einen Menschen eskalieren lassen, was Ihnen präzise Kontrolle gibt.

-

KI-Persönlichkeit und -Aktionen anpassen: Gehen Sie über generische Antworten hinaus. Mit einem einfachen Prompt-Editor können Sie den Tonfall Ihrer KI definieren und ihr auftragen, bestimmte Aktionen auszuführen, wie z. B. eine Bestellung in Shopify nachzuschlagen oder ein Ticket in Zendesk zu triagieren (Zendesk). Dies sind Aufgaben, die in LangGraph den Aufbau und die Wartung komplexer Knoten erfordern würden.

Anwendungsfälle und Einschränkungen: Vom Prototyp zur Produktion

Der Weg von einem einfachen Skript, das auf Ihrem Laptop läuft, zu einer skalierbaren, zuverlässigen Anwendung, auf die sich Kunden verlassen können, ist lang. LangChain und LangGraph werden oft als Werkzeuge für diese Reise angesehen, aber sie spielen sehr unterschiedliche Rollen.

Wann man LangChain verwenden sollte: Schnelles Prototyping und sequenzielle Aufgaben

LangChain ist fantastisch, um Ideen schnell auf den Weg zu bringen. Wenn Sie schnell einen Proof-of-Concept für ein Tool für Fragen und Antworten zu Dokumenten oder eine einfache Datenextraktions-Pipeline erstellen möchten, können Sie mit seinen Werkzeugen in wenigen Minuten etwas zusammenfügen.

Seine Stärke liegt in der Geschwindigkeit und Einfachheit. Allerdings wurde LangChain nicht wirklich für produktionsreife Agentensysteme entwickelt. Wichtige Funktionen wie Zustandspersistenz (Gedächtnis), robustes Monitoring und Fehlertoleranz sind nicht standardmäßig enthalten. Sie sind dafür verantwortlich, all diese Infrastruktur selbst aufzubauen, was einen schnellen Prototyp in ein langfristiges Engineering-Projekt verwandeln kann.

Wann man LangGraph verwenden sollte: Produktionsreife Agenten und zustandsbehaftete Anwendungen

LangGraph hingegen wurde für die Produktion entwickelt. Es enthält Funktionen wie Checkpointing, mit dem sich langlaufende Agenten daran erinnern können, wo sie aufgehört haben, und native Unterstützung für Streaming, was eine viel reaktionsschnellere Benutzererfahrung schafft. Es ist die richtige Wahl für den Aufbau eines KI-Assistenten, der einen komplexen Buchungsprozess verwaltet, oder für ein Team von Agenten, die zusammenarbeiten, um Code zu schreiben und zu debuggen.

Aber obwohl LangGraph Ihnen die Bausteine gibt, baut es das Haus nicht für Sie. Sie müssen immer noch die gesamte Infrastruktur und DevOps-Arbeit verwalten, die zum Hosten, Skalieren und Überwachen Ihrer Anwendung erforderlich ist. Dies ist ein riesiges Unterfangen, das spezialisiertes Fachwissen erfordert und leicht zu einem Vollzeitjob für ein Entwicklerteam werden kann.

Der eesel AI-Ansatz: Vom ersten Tag an produktionsreif

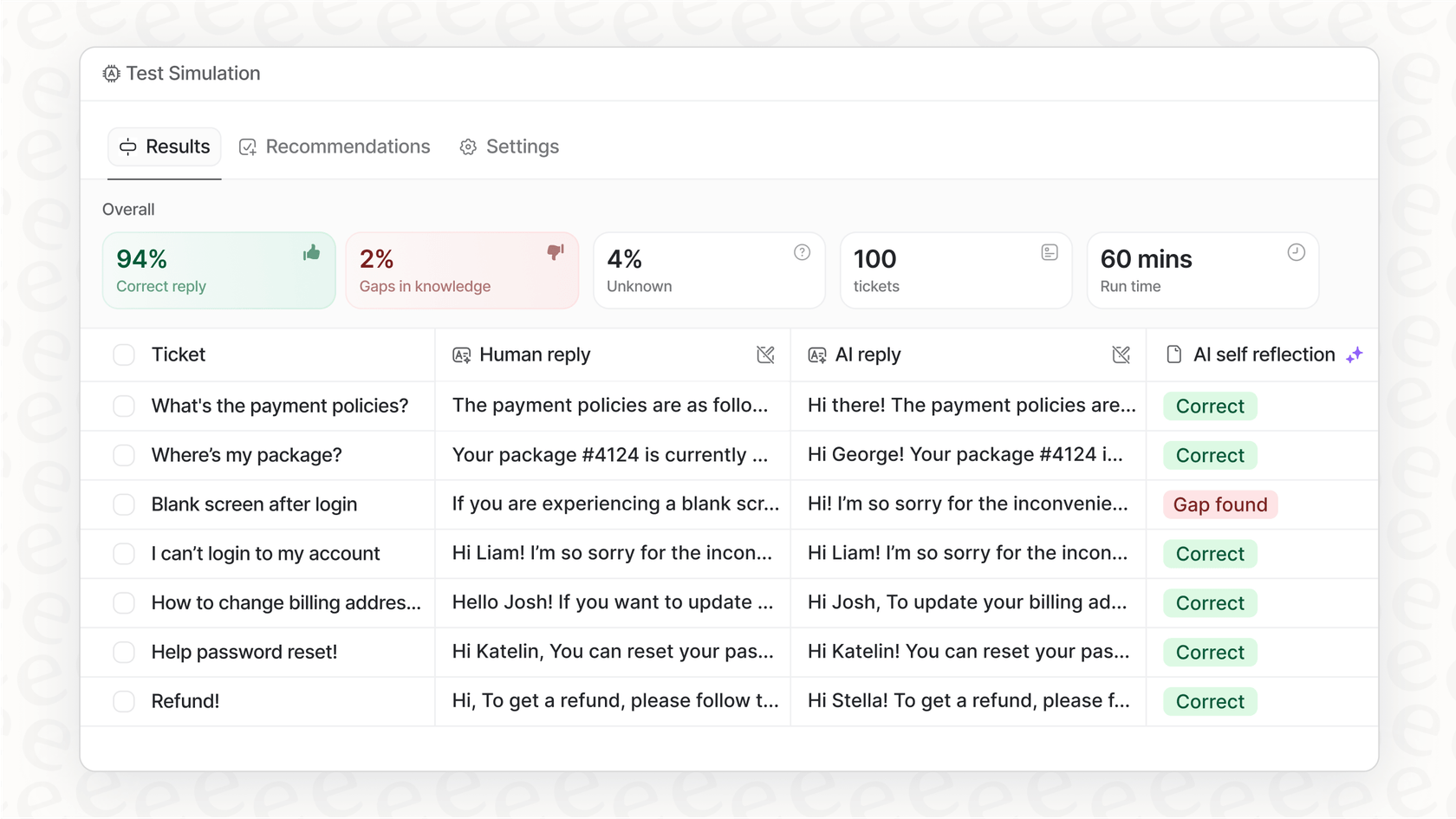

Für Support- und IT-Teams wird hier die „Build vs. Buy“-Entscheidung sehr real. eesel AI wurde entwickelt, um die Lücke zwischen einem vielversprechenden Prototyp und einem bereitgestellten, zuverlässigen System zu schließen. Es basiert auf der Idee, in Minuten live zu gehen, nicht in Monaten, und ermöglicht Ihnen, „mit Zuversicht zu testen“.

So verkürzt es den Entwicklungsprozess:

-

Helpdesk-Integration mit einem Klick: Vergessen Sie das Herumschlagen mit APIs. Sie können eesel AI sofort mit Ihrem Helpdesk verbinden, egal ob es sich um Zendesk, Freshdesk, [Intercom] oder eine andere Plattform handelt.

-

Leistungsstarker Simulationsmodus: Bevor Ihr KI-Agent jemals mit einem echten Kunden spricht, können Sie ihn sicher an Tausenden Ihrer vergangenen Tickets testen. Dies gibt Ihnen eine genaue Prognose seiner Leistung und Lösungsrate, sodass Sie ohne Rätselraten live gehen können.

Wissens- und Kontextmanagement

Ein KI-Agent ist nur so schlau wie die Informationen, auf die er zugreifen kann. Wie diese Frameworks mit Wissen umgehen, ist ein entscheidender Teil des Puzzles.

Wie Wissen gehandhabt wird

Sowohl LangChain als auch LangGraph sind beim Thema Wissen „meinungsfrei“. Sie stellen Ihnen die Werkzeuge zur Verfügung – Dokumenten-Loader, Text-Splitter, Integrationen für Vektordatenbanken –, aber Sie sind dafür verantwortlich, die gesamte RAG-Pipeline von Grund auf zu erstellen und zu verwalten.

Dieser Prozess ist technisch komplex und kann unglaublich zeitaufwändig sein. Wenn Sie mehrere Wissensquellen wie ein öffentliches Hilfe-Center, ein internes Confluence-Wiki und Ihre vergangenen Support-Tickets verbinden möchten, müssen Sie für jede Quelle benutzerdefinierten Code schreiben. Dann haben Sie die ständige Herausforderung, den Abruf zu optimieren, um sicherzustellen, dass die KI die richtigen Informationen findet, wenn sie sie benötigt.

Wissen über die Frameworks hinaus vereinheitlichen

Dies ist ein weiterer Bereich, in dem Ihnen eine verwaltete Plattform wie eesel AI monatelange Arbeit ersparen kann. Sie wurde entwickelt, um all Ihr Wissen ohne die üblichen Kopfschmerzen zusammenzuführen, indem der gesamte Prozess automatisiert und vereinfacht wird.

-

Breite Integrationen: Mit nur wenigen Klicks können Sie eesel AI mit all den Orten verbinden, an denen das Wissen Ihres Teams lebt, von Google Docs und Notion bis hin zu Slack und Ihrem Helpdesk.

-

Training an vergangenen Tickets: Hier glänzt eesel AI wirklich. Es analysiert automatisch Ihre historischen Support-Konversationen, um die einzigartige Stimme Ihrer Marke, häufige Kundenprobleme und wie erfolgreiche Lösungen aussehen zu lernen.

-

Automatisierte Erstellung von Wissensdatenbanken: eesel AI kann sogar Lücken in Ihrer Hilfe-Dokumentation aufspüren und automatisch neue Artikel entwerfen, die auf erfolgreichen Ticketlösungen basieren, und Ihnen so helfen, im Laufe der Zeit eine nützlichere Wissensdatenbank aufzubauen.

Die versteckten Kosten: Die „Build vs. Buy“-Debatte

Es ist leicht, auf Open-Source-Frameworks zu schauen und „kostenlos“ zu denken, aber das ist selten die ganze Geschichte. Die wahren Kosten jeder Lösung gehen weit über die Softwarelizenz hinaus.

Preisgestaltung: Open-Source, aber nicht kostenlos

Obwohl die LangChain- und LangGraph-Bibliotheken kostenlos heruntergeladen werden können, ist der Aufbau einer produktionsreifen Lösung mit ihnen alles andere als kostenlos. Die tatsächlichen Kosten umfassen:

-

LLM-API-Gebühren: Sie zahlen für jeden einzelnen Aufruf an Modelle von Anbietern wie OpenAI oder Anthropic.

-

Hosting-Kosten: Sie müssen für Server bezahlen, um Ihre Anwendung auszuführen, und für eine Vektordatenbank, um Ihr Wissen zu speichern.

-

Entwicklergehälter: Dies ist bei weitem der größte Kostenfaktor. Die erforderlichen Ingenieurstunden, um ein benutzerdefiniertes Agentensystem zu erstellen, zu debuggen, zu skalieren und zu warten, sind erheblich und oft unvorhersehbar.

eesel AI-Preisgestaltung: Ein alternatives Kostenmodell

eesel AI bietet ein klares, vorhersehbares Preismodell für Unternehmen. Wir glauben an transparente Preise ohne Gebühren pro gelöstem Fall. Dies ist ein wesentlicher Unterschied. Viele Wettbewerber berechnen Ihnen für jedes Ticket, das die KI löst, was bedeutet, dass Ihre Rechnung steigt, wenn Ihr Support-Volumen zunimmt. Mit eesel AI sind Ihre Kosten fest und vorhersehbar, sodass Sie nicht für den Erfolg bestraft werden.

| Tarif | Monatlich (monatl. Abrechnung) | Effektiv /Monat Jährlich | Hauptmerkmale |

|---|---|---|---|

| Team | $299 | $239 | Bis zu 1.000 KI-Interaktionen/Monat, Training auf Dokumenten, Slack-Integration. |

| Business | $799 | $639 | Bis zu 3.000 KI-Interaktionen/Monat, Training auf vergangenen Tickets, KI-Aktionen, Massensimulation. |

| Custom | Vertrieb kontaktieren | Benutzerdefiniert | Unbegrenzte Interaktionen, erweiterte Aktionen, benutzerdefinierte Integrationen. |

Das richtige Werkzeug für die Aufgabe wählen

Also, wenn es um LangChain vs. LangGraph geht, wie lautet das endgültige Urteil? Die Antwort hängt wirklich davon ab, was Sie bauen möchten. LangChain ist das perfekte Werkzeug, um schnell lineare Prototypen und einfache Workflows zu erstellen. LangGraph ist die richtige Wahl, wenn Sie ein Entwicklerteam sind, das bereit ist, einen komplexen, zustandsbehafteten KI-Agenten von Grund auf zu entwickeln und die Ressourcen hat, um das Projekt bis zum Ende durchzuziehen.

Aber für die meisten Unternehmen, die KI einfach nur für den Kundenservice, IT-Support oder interne Fragen und Antworten nutzen wollen, geht es bei der eigentlichen Wahl nicht darum, welches Framework man verwenden soll. Es geht darum, Ergebnisse zu erzielen. Sowohl LangChain als auch LangGraph erfordern eine massive Investition in die Entwicklung, um eine produktionsreife Anwendung zu erstellen, bereitzustellen und zu warten.

eesel AI bietet die Leistung eines maßgeschneiderten Agenten mit der Geschwindigkeit und Einfachheit einer Self-Service-Plattform. Es ermöglicht Ihnen, sich auf das zu konzentrieren, was wirklich zählt: die Verbesserung Ihres Kundenerlebnisses, nicht die Verwaltung der Infrastruktur.

Starten Sie noch heute mit einem produktionsreifen KI-Agenten

Bereit, monatelange komplexe Programmierung und Infrastruktureinrichtung zu umgehen? Sie können einen leistungsstarken, individuell trainierten KI-Agenten in einem Bruchteil der Zeit einsatzbereit machen.

-

Sehen Sie es in Aktion: Registrieren Sie sich kostenlos und verbinden Sie Ihre Wissensquellen, um Ihren ersten KI-Agenten in nur wenigen Minuten zu erstellen.

-

Erhalten Sie eine individuelle Prognose: Buchen Sie eine Demo, um eine kostenlose, unverbindliche Simulation mit Ihren historischen Support-Tickets durchzuführen und genau zu sehen, wie hoch Ihre potenzielle Automatisierungsrate sein könnte.

Häufig gestellte Fragen

LangChain verwendet eine lineare „Kette“ (gerichteter azyklischer Graph) für sequenzielle Prozesse, was sich für unkomplizierte Aufgaben eignet. LangGraph hingegen nutzt eine zyklische „Graphen“-Struktur, die Schleifen, bedingte Logik und Zustandsmanagement für dynamischere und komplexe Agentenverhalten ermöglicht.

Für schnelles Prototyping und einfache, lineare Workflows wie grundlegendes RAG ist LangChain aufgrund seiner Einfachheit im Allgemeinen unkomplizierter. Wenn Ihr Projekt von Anfang an komplexe, zustandsbehaftete Interaktionen, Schleifen oder dynamische Entscheidungen erfordert, sollten Sie LangGraph von Beginn an in Betracht ziehen.

LangGraph wurde mit Blick auf die Produktion entwickelt und bietet Funktionen wie Checkpointing und Streaming, die für komplexe, zustandsbehaftete Agenten unerlässlich sind. LangChain eignet sich zwar hervorragend für Prototypen, erfordert jedoch eine erhebliche Eigenentwicklung, um produktionsreife Funktionen wie Zustandspersistenz, Überwachung und Fehlertoleranz zu erreichen.

Über ihren Open-Source-Status hinaus verursachen beide Frameworks erhebliche Kosten, darunter LLM-API-Gebühren, Ausgaben für die Hosting-Infrastruktur und vor allem beträchtliche Entwicklergehälter für den kontinuierlichen Aufwand des Erstellens, Debuggens, Skalierens und Wartens eines benutzerdefinierten Agentensystems.

LangGraph ist für komplexe Kundensupport-Agenten, die dynamische Entscheidungen, Schleifen, Zustandsbehaftung und menschliches Eingreifen erfordern, aufgrund seiner graphenbasierten Architektur erheblich besser geeignet. Das lineare Modell von LangChain würde die Implementierung solcher Workflows weitaus schwieriger und umständlicher machen.

Ja, Plattformen wie eesel AI bieten eine No-Code-Workflow-Engine, die die dynamischen Fähigkeiten eines graphenbasierten Systems ohne die Notwendigkeit umfangreicher Programmierung bereitstellt. Diese verwalteten Lösungen vereinfachen die Bereitstellung, Integration und laufende Wartung erheblich und ermöglichen es, sich auf Ergebnisse statt auf die Infrastruktur zu konzentrieren.

Sowohl LangChain als auch LangGraph sind beim Wissensmanagement „meinungsfrei“. Sie bieten Werkzeuge für Retrieval-Augmented Generation (RAG) wie Dokumenten-Loader und Vektordatenbank-Integrationen, aber Sie sind dafür verantwortlich, die gesamte RAG-Pipeline von Grund auf zu erstellen und zu verwalten, einschließlich der Anbindung verschiedener Wissensquellen.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.