Les assistants de codage IA apparaissent un peu partout. On dirait qu'on ne peut plus parcourir les actualités tech sans entendre parler d'outils comme GitHub Copilot ou Codex d'OpenAI, qui promettent tous deux d'écrire, de déboguer et même de refactoriser du code à partir d'une simple instruction. C'est une période passionnante pour être développeur.

Mais soyons honnêtes. Passer d'une démo impressionnante à un outil que l'on utilise réellement au quotidien n'est pas toujours un chemin tout tracé. Bien que ces assistants soient incroyablement puissants, comprendre par où commencer ou quelles sont leurs limites dans le monde réel peut être un véritable casse-tête. Beaucoup d'entre nous veulent les tester dans un espace flexible comme Google Colab mais ne savent pas comment s'y prendre ou à quoi faire attention.

C'est la raison d'être de ce guide. Nous allons découvrir ce qu'est OpenAI Codex, le faire fonctionner dans un notebook Google Colab, puis prendre du recul pour examiner la situation dans son ensemble. Nous aborderons les promesses, les limites frustrantes des agents IA spécialisés et à quoi devrait ressembler une plateforme d'intégration d'IA vraiment utile.

Qu'est-ce qu'OpenAI Codex ?

OpenAI Codex est un modèle d'IA conçu pour transformer le langage naturel en code. Vous pouvez le voir comme un partenaire de programmation à qui vous pouvez parler. C'est un descendant direct du modèle GPT-3 et c'est la même technologie qui alimente GitHub Copilot, que vous avez probablement déjà vu en action.

Codex maîtrise plus d'une douzaine de langages de programmation, mais il est particulièrement doué avec Python. Il gère également très bien JavaScript, Go, Ruby et d'autres. Ses compétences vont au-delà de la simple écriture de code à partir de zéro. Vous pouvez également l'utiliser pour :

-

Transpilation : Traduire du code d'un langage à un autre (comme de Python à JavaScript).

-

Explication de code : Lui demander d'expliquer une fonction ou un bloc de code confus en langage simple.

-

Refactorisation : Vous aider à nettoyer ou à restructurer du code existant pour une meilleure lisibilité ou de meilleures performances.

C'est une technologie très impressionnante qui offre un aperçu de la façon dont nous pourrions développer des logiciels dans un avenir proche. Vous pouvez en savoir plus sur la page officielle d'OpenAI Codex.

Pourquoi utiliser Google Colab ?

Si vous cherchez un bon endroit pour expérimenter avec l'IA, Google Colab est difficile à battre. C'est un environnement de notebook Jupyter gratuit et basé sur le cloud, devenu le bac à sable par défaut pour des tonnes de développeurs et de data scientists.

Voici pourquoi c'est un excellent choix pour jouer avec des API comme Codex :

-

Aucune configuration requise : Il suffit d'ouvrir un nouveau notebook dans votre navigateur et vous êtes prêt à coder. Vous n'avez pas à vous soucier d'installer Python, de gérer des environnements virtuels ou des autres tracas habituels de la configuration locale.

-

Accès gratuit aux GPU : Pour les tâches d'apprentissage automatique plus lourdes, Colab offre un accès gratuit aux GPU. C'est un avantage énorme qui peut vous faire économiser beaucoup d'argent par rapport à l'exécution sur votre propre machine ou sur un service cloud payant.

-

Collaboration simple : Les notebooks Colab sont enregistrés directement dans votre Google Drive, donc les partager avec votre équipe est aussi simple que de partager un Google Doc. Vous pouvez même travailler sur le même notebook en temps réel.

C'est pratiquement l'endroit idéal pour bricoler, prototyper et partager vos expériences d'IA sans aucune friction. Vous pouvez le découvrir sur la page d'accueil de Google Colab.

Démarrer avec OpenAI Codex dans Colab

Prêt à voir Codex en action ? Le mettre en place dans Colab est étonnamment simple. Ce ne sera pas un tutoriel approfondi et exhaustif, mais il vous donnera un aperçu clair pour vous lancer.

Configuration de votre environnement

Tout d'abord, vous devez installer le package Python d'OpenAI. Ouvrez simplement une nouvelle cellule de code dans votre notebook Colab et exécutez cette commande :

!pip install openai

Ensuite, vous aurez besoin d'une clé API d'OpenAI. Une fois que vous avez votre clé, vous devez la stocker dans un endroit sûr. La coller directement dans votre notebook est une mauvaise habitude, surtout si vous prévoyez de le partager avec quelqu'un.

Effectuer votre premier appel API

Une fois votre environnement prêt, vous pouvez effectuer votre premier appel à un modèle alimenté par Codex. L'astuce consiste à lui donner du contexte. L'IA comprend les instructions à partir des commentaires dans votre code, ce qui semble un peu magique la première fois que vous le voyez.

Voici un exemple simple où nous lui demandons d'écrire une fonction de base.

import openai

from google.colab import userdata

# Récupérez votre clé API depuis les secrets de Colab

openai.api_key = userdata.get('OPENAI_API_KEY')

# Interrogez le modèle à l'aide d'un simple commentaire

prompt = """

# Fonction Python pour calculer la factorielle d'un nombre

"""

response = openai.Completion.create(

engine="code-davinci-002", # C'est un modèle de la famille Codex

prompt=prompt,

max_tokens=100

)

print(response.choices[0].text)

Dans la sortie, vous verrez la fonction Python complète, générée à la volée. C'est une petite chose, mais c'est une excellente démonstration de la façon dont le modèle peut comprendre votre intention à partir du langage naturel.

Un exemple pratique : Analyse de données avec Pandas

Très bien, essayons quelque chose d'un peu plus utile, comme une tâche que vous pourriez réellement effectuer en science des données. Vous pouvez utiliser une série de commentaires en langage naturel pour guider Codex à travers quelques étapes.

Disons que vous voulez créer un petit jeu de données avec pandas, puis le visualiser. Au lieu d'écrire tout le code vous-même, vous pouvez simplement dire à Codex ce que vous voulez accomplir.

# Créer un DataFrame pandas avec les colonnes 'Nom', 'Âge', 'Ville'

# Ajouter 5 lignes de données d'exemple au DataFrame

# Tracer un graphique à barres montrant l'âge des personnes dans le DataFrame

En fournissant ces commentaires dans le prompt, Codex peut générer tout le code pandas et Matplotlib nécessaire pour le faire. C'est là que cela commence à ressembler moins à un outil et plus à un partenaire, en particulier pour les tâches qui impliquent beaucoup de code répétitif que vous devez toujours rechercher.

Le retour à la réalité : Les principales limites

Alors, vous avez fait quelques expériences dans Colab, et il est évident que Codex est un outil puissant. Mais lorsque vous commencez à penser à utiliser quelque chose comme ça dans un véritable contexte d'équipe, des failles assez importantes commencent à apparaître. La vérité est que la plupart de ces agents IA spécialisés vivent dans des écosystèmes fermés, ce qui cause de sérieux maux de tête.

Le goulot d'étranglement de l'intégration

L'une des plus grandes frustrations que vous verrez dans les communautés de développeurs est le manque d'options d'intégration. Un rapide coup d'œil sur les forums de la communauté OpenAI révèle de nombreux développeurs bloqués parce que leurs équipes utilisent des outils en dehors de l'écosystème GitHub. En l'état actuel, Codex est étroitement lié à GitHub, ce qui le rend rédhibitoire pour le grand nombre d'équipes travaillant sur Azure DevOps, GitLab ou Bitbucket.

Un agent IA, aussi intelligent soit-il, n'est utile que s'il fonctionne là où vous travaillez. S'attendre à ce qu'une entreprise change tout son système de contrôle de version juste pour utiliser un nouvel outil est complètement irréaliste. Ce goulot d'étranglement de l'intégration signifie que pour de nombreuses entreprises, ces puissants outils d'IA restent tout simplement hors de portée.

Manque de contrôle et de personnalisation

Un autre problème courant est l'impression de « boîte noire » de ces outils. Vous pouvez guider Codex avec des prompts, bien sûr, mais vous avez très peu de contrôle sur son comportement sous-jacent. Vous ne pouvez pas vraiment définir sa personnalité, limiter ses connaissances à certains domaines, ou créer des actions personnalisées qui vont au-delà de la simple écriture de code.

Pour toute utilisation en entreprise, c'est un obstacle majeur. Vous avez besoin de la capacité de :

-

Définir la personnalité de l'IA : Voulez-vous qu'elle soit formelle et professionnelle, ou décontractée et amicale ?

-

Délimiter ses connaissances : Comment l'empêcher d'essayer de répondre à des questions sur des choses qu'elle ne devrait pas connaître ?

-

Créer des actions personnalisées : Et si vous aviez besoin qu'elle fasse plus que simplement coder ? Peut-être doit-elle créer un ticket Jira ou récupérer des informations client de votre base de données interne.

Sans ce niveau de contrôle, vous vous retrouvez avec un outil puissant mais indompté, et qui pourrait ne pas correspondre aux règles ou aux flux de travail de votre entreprise.

Le risque d'utiliser des intégrations non testées

Laisser un nouvel agent IA se déchaîner sur votre base de code de production est une idée effrayante. Comment pouvez-vous être sûr qu'il n'introduira pas de bogues subtils, ne violera pas les normes de codage de votre équipe ou ne divulguera pas accidentellement quelque chose de sensible ? Avec la plupart de ces outils, vous ne pouvez pas en être sûr.

Les entreprises ont besoin d'un moyen sûr de tester et de valider les performances d'un agent IA avant sa mise en production. Vous devriez pouvoir exécuter des simulations sur des données historiques pour voir comment il se serait comporté dans le passé. Cela vous permet de mesurer son impact potentiel, de trouver ses points faibles et de renforcer la confiance avant de le laisser s'approcher de vos clients ou de votre environnement de production. Sans un cadre de test solide, vous ne faites qu'espérer pour le mieux.

Une meilleure voie à suivre

Il est assez clair que si les agents IA spécialisés sont prometteurs, leur nature fermée les freine. L'avenir ne consiste pas à être coincé avec un outil à usage unique et inflexible. Il s'agit de construire vos propres flux de travail IA flexibles et personnalisés qui sont adaptés aux besoins spécifiques de votre équipe.

Pourquoi une approche par plateforme est judicieuse

Au lieu d'être enfermées dans le monde d'un seul fournisseur, les équipes ont besoin d'une plateforme qui leur permet de prendre les décisions. Une bonne plateforme d'IA devrait être construite sur trois idées principales :

-

Intégration ouverte : Elle doit se connecter à tous les outils sur lesquels votre équipe s'appuie déjà, que ce soit un service d'assistance, une base de connaissances interne ou un système de contrôle de version.

-

Personnalisation approfondie : Elle doit fournir un moteur de flux de travail qui vous permet de définir exactement ce que l'IA peut et ne peut pas faire, de son ton de voix aux tâches spécifiques qu'elle peut accomplir.

-

Déploiement en toute confiance : Elle doit disposer de fonctionnalités de simulation et de déploiement progressif pour que vous puissiez tester, mesurer et mettre en production sans retenir votre souffle.

Comment eesel AI permet une véritable automatisation des flux de travail

Cette vision axée sur la plateforme est exactement ce sur quoi nous nous concentrons chez eesel AI, en particulier pour les équipes de service client et de support interne. Il s'avère que les défis que les développeurs rencontrent avec les agents de codage sont les mêmes que ceux des équipes de support avec l'automatisation du support. Ils ont besoin de plus qu'un simple chatbot, ils ont besoin d'une plateforme pour construire leurs propres flux de travail IA.

Voici comment eesel AI aborde les problèmes dont nous avons parlé :

-

Soyez opérationnel en quelques minutes, pas en quelques mois : Nous nous attaquons de front au problème de l'intégration. Avec des intégrations en un clic pour des outils comme Zendesk, Slack et Confluence, vous pouvez connecter vos connaissances et systèmes existants en quelques minutes. Pas besoin de tout jeter ce que vous utilisez actuellement.

-

Vous avez le contrôle total de votre IA : Nous vous offrons un moteur de flux de travail entièrement personnalisable. Contrairement au comportement rigide et universel des autres outils, eesel AI vous permet de créer des prompts personnalisés pour définir la personnalité de l'IA et de créer des actions personnalisées pour qu'elle puisse faire des choses comme étiqueter un ticket, escalader un problème à un humain, ou rechercher des détails de commande à l'aide d'une API.

-

Testez sans risque : Notre mode de simulation est conçu pour résoudre le problème des déploiements non testés. Vous pouvez tester votre configuration d'IA sur des milliers de vos anciens tickets de support pour voir exactement comment elle se comportera. Cela vous donne une prévision réelle et basée sur des données de son efficacité avant même de l'activer pour vos clients.

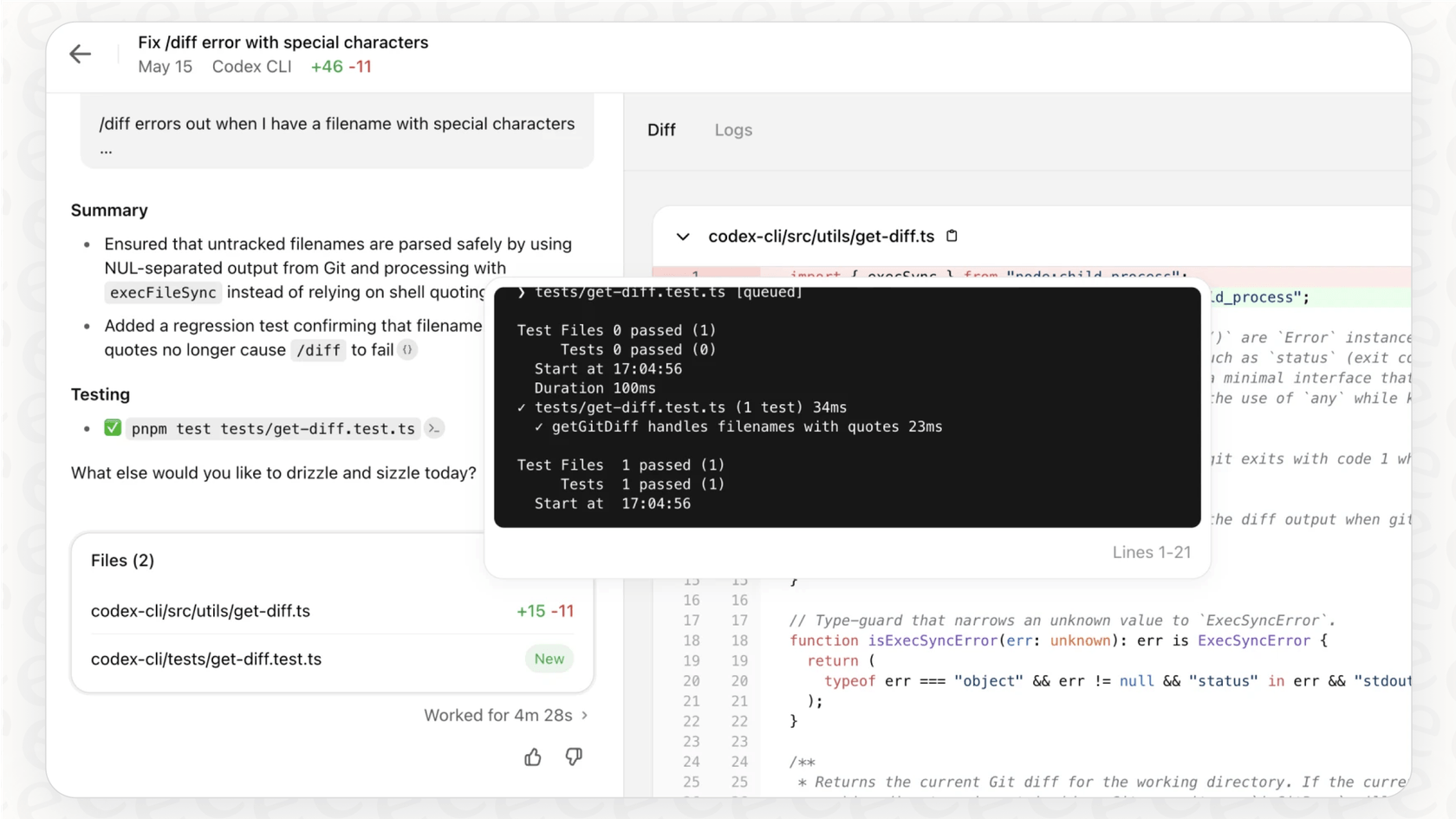

Ce guide vous explique comment configurer Google Colab avec l'API d'OpenAI pour personnaliser votre expérience de codage.

De la génération de code aux collègues IA intégrés

Expérimenter avec les intégrations d'OpenAI Codex avec Colab est un excellent moyen de voir le potentiel brut de la génération de code pilotée par l'IA. C'est une expérience révélatrice qui donne un signal clair sur la direction que prend le développement logiciel.

Mais ces expériences mettent également en évidence un besoin massif de plateformes qui vous offrent flexibilité, contrôle et sécurité. Le véritable bond en avant ne consiste pas seulement à créer des assistants IA plus intelligents capables de suggérer une ligne de code. Il s'agit de créer des « collègues IA » profondément et solidement intégrés à la manière de travailler unique de votre équipe, que vous livriez des logiciels ou aidiez des clients.

Les idées fondamentales sont les mêmes, peu importe ce que vous faites : la meilleure IA est celle que vous pouvez facilement connecter, contrôler en toute confiance et déployer en toute sécurité.

Prêt à construire des agents IA qui correspondent réellement au flux de travail de votre équipe ? Découvrez comment eesel AI permet de se lancer en quelques minutes avec une IA puissante et personnalisable pour vos équipes de support et internes. Vous pouvez démarrer un essai gratuit dès aujourd'hui.

Foire aux questions

Vous devez d'abord installer le package Python OpenAI dans un notebook Colab ("!pip install openai"). Ensuite, sécurisez votre clé API à l'aide du gestionnaire de secrets intégré de Colab et accédez-y pour effectuer votre premier appel API à un modèle Codex.

Colab est excellent car il ne nécessite aucune configuration locale, offre un accès gratuit aux GPU pour les tâches plus lourdes, et simplifie la collaboration car les notebooks sont enregistrés directement dans Google Drive. Cela le rend idéal pour le prototypage rapide et le partage d'expériences d'IA.

Vous pouvez l'utiliser pour générer du code à partir de descriptions en langage naturel, comme la création de DataFrames Pandas ou le traçage de graphiques. Codex aide également à la transpilation, à l'explication et à la refactorisation de code, ce qui en fait un partenaire de codage polyvalent.

Les principaux défis incluent les goulots d'étranglement de l'intégration, car Codex est étroitement lié à GitHub, ce qui limite son utilisation pour les équipes sur d'autres plateformes. Il y a aussi un manque de contrôle sur le comportement de l'IA et le risque de déployer du code non testé sans cadres de validation appropriés.

Il est crucial d'éviter de coller les clés API directement dans votre notebook. Utilisez plutôt le gestionnaire de secrets intégré de Colab (accessible via l'icône en forme de clé) pour stocker et récupérer en toute sécurité votre clé API OpenAI, surtout si vous prévoyez de partager votre notebook.

Le blog préconise une approche par plateforme qui offre une intégration ouverte avec les outils existants, une personnalisation approfondie pour définir la personnalité et les actions de l'IA, et un déploiement en toute confiance grâce à des fonctionnalités de simulation et de déploiement progressif. Cela permet de construire des flux de travail IA adaptés aux besoins spécifiques de l'équipe.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.