Seien wir ehrlich: KI ist in der Entwicklerwelt allgegenwärtig. Die Idee, sie an etwas wie Bitbucket anzuschließen, um Prozesse zu beschleunigen, ist keine Science-Fiction mehr. Es ist eine echte Möglichkeit, mehr zu erledigen, besseren Code zu schreiben und vielleicht sogar ein bisschen schneller zu liefern. Aber der Versuch herauszufinden, wie man das tatsächlich umsetzt, kann sich anfühlen, als würde man durch einen Sumpf von Marketing-Schlagwörtern waten.

Dieser Leitfaden soll mit diesem ganzen Lärm aufräumen. Wir werden uns ansehen, was OpenAI Codex-Integrationen mit Bitbucket sind, was Sie damit tatsächlich tun können, die verschiedenen Möglichkeiten, sie einzurichten, und die Hürden, auf die Sie mit ziemlicher Sicherheit stoßen werden.

Am Ende werden Sie ein viel klareres Bild davon haben, wie Sie diese Tools so verbinden können, dass sie echte Probleme für Ihr Entwicklungsteam lösen.

Was sind OpenAI Codex-Integrationen mit Bitbucket?

Bevor wir uns mit dem „Wie“ befassen, müssen wir uns über das „Was“ einig sein. Der KI-Bereich entwickelt sich unglaublich schnell, also lassen Sie uns unsere Definitionen klären. Das wird alles andere verständlich machen.

Was ist Bitbucket?

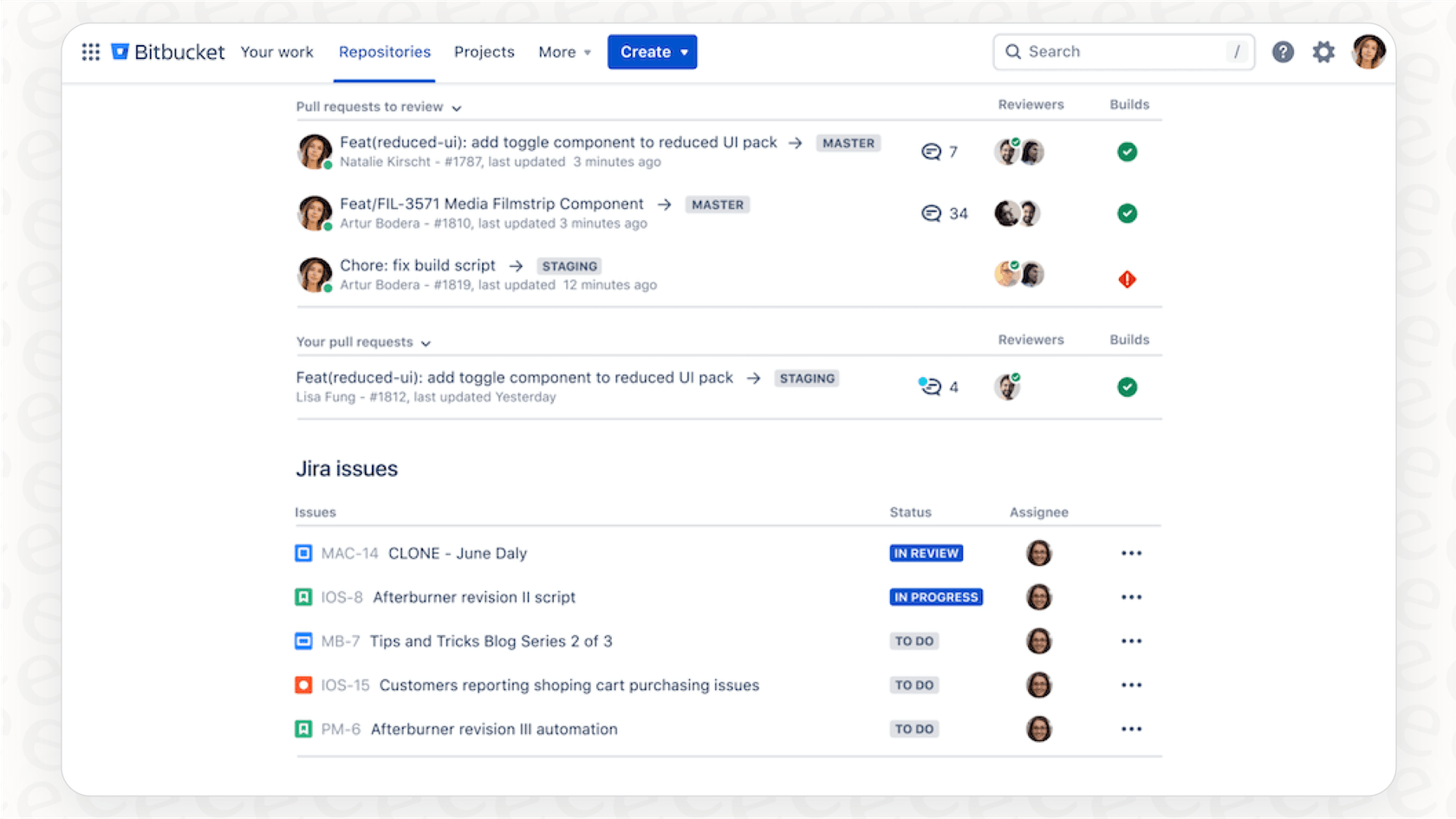

Sie kennen es wahrscheinlich schon, aber nur für den Fall: Bitbucket ist Atlassians Git-Plattform zum Hosten von und zur Zusammenarbeit an Code. Es ähnelt seinen Konkurrenten sehr, aber seine Superkraft ist, wie gut es sich in die Atlassian-Familie einfügt, insbesondere in Jira. Teams entscheiden sich oft dafür wegen seiner soliden CI/CD-Pipelines und seines Fokus auf unternehmenstaugliche Funktionen und Sicherheit.

Was ist OpenAI Codex? Eine notwendige Klarstellung

Okay, hier wird es etwas knifflig. Wenn Sie die KI schon eine Weile im Auge behalten, werden Sie sich an das ursprüngliche OpenAI Codex-Modell erinnern. Es war die Technologie hinter den frühen Versionen von GitHub Copilot und fühlte sich damals wie Magie an. Nun, dieses spezielle Modell wurde im März 2023 offiziell eingestellt.

Was bedeutet das also für uns heute?

-

OpenAI verwendet den Namen „Codex“ nun für einen neueren, ehrgeizigeren Software-Engineering-Agenten, der ganze Programmierprojekte bewältigen kann.

-

Die Fähigkeiten des ursprünglichen Codex wurden vollständig in neuere große Sprachmodelle (LLMs), wie die GPT-4-Serie, integriert und von diesen übertroffen.

Für den Rest dieses Leitfadens bedeutet „OpenAI Codex-Integrationen“ also, dass wir die neuesten und besten Sprachmodelle von OpenAI verwenden, um Programmieraufgaben innerhalb Ihres Bitbucket-Workflows zu erledigen.

Was können Sie tatsächlich mit OpenAI Codex-Integrationen mit Bitbucket tun?

Der ganze Sinn dieser Integrationen besteht darin, die langweiligen, repetitiven Teile des Entwickleralltags zu eliminieren. Wenn Sie es richtig machen, ist die Verbindung einer KI mit Ihrem Repository so, als hätten Sie einen zusätzlichen Junior-Entwickler in Ihrem Team, der rund um die Uhr arbeitet und nie müde wird. Hier sind einige der beliebtesten Dinge, die Leute damit machen:

-

Automatisierte Code-Reviews: Stellen Sie sich eine KI vor, die bei jedem Pull-Request eine erste Prüfung durchführt. Sie könnte automatisch Kommentare hinterlassen, die auf Syntaxfehler hinweisen, Optimierungen basierend auf dem Styleguide Ihres Teams vorschlagen oder Code markieren, der etwas merkwürdig erscheint. Das bedeutet nicht, dass Ihre Senior-Entwickler arbeitslos werden; es bedeutet nur, dass sie keine Zeit mit Kleinigkeiten verschwenden müssen und sich auf die große Architektur konzentrieren können.

-

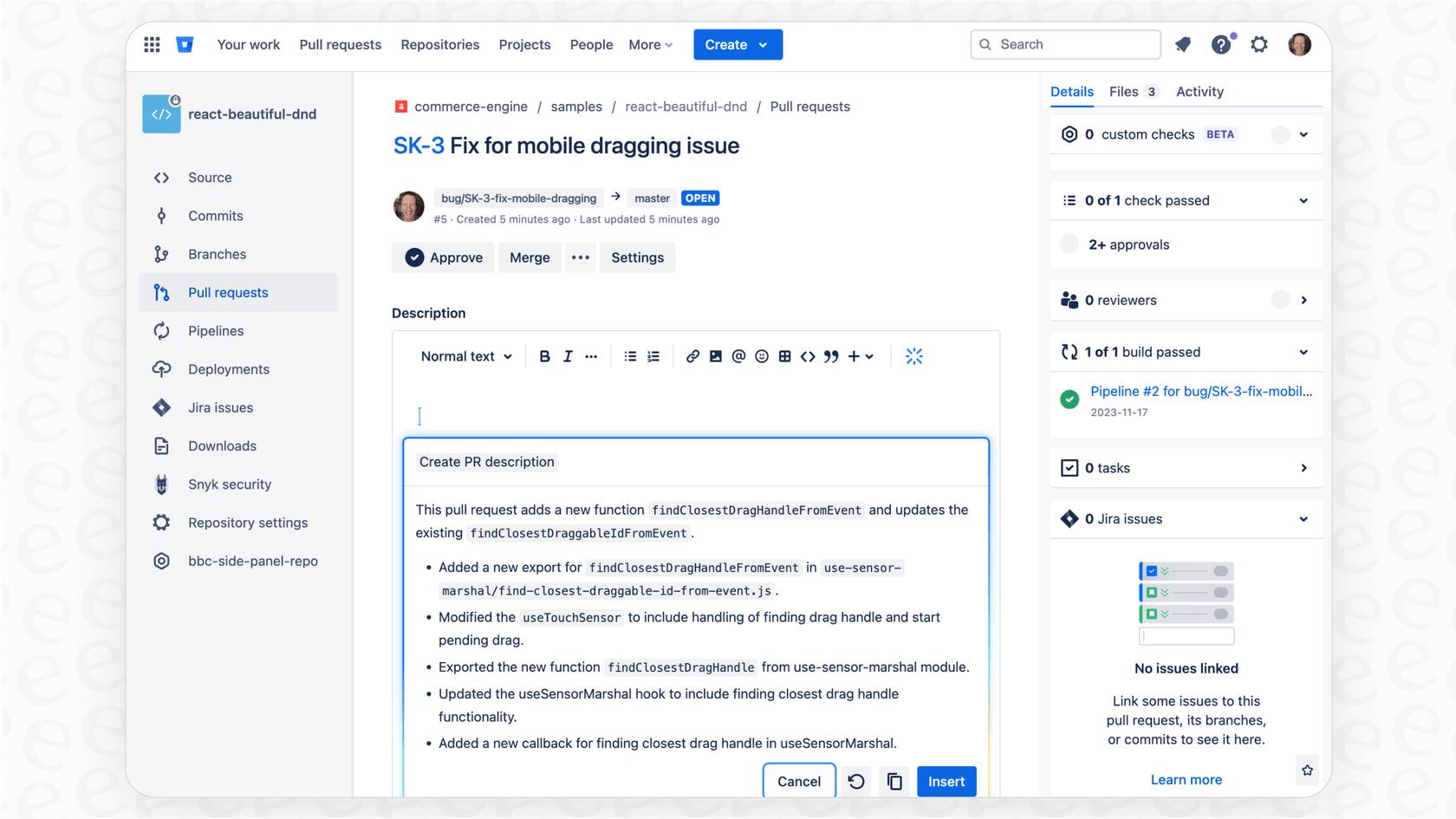

KI-generierte Zusammenfassungen von Pull-Requests: Wir alle kennen das: Man starrt auf einen PR mit einer Beschreibung, die nur „Bugfix“ lautet. Eine KI kann die Commit-Nachrichten und Code-Änderungen lesen, um eine klare Zusammenfassung dessen zu erstellen, was vor sich geht. Das spart dem Entwickler ein paar Minuten und gibt den Reviewern den Kontext, den sie brauchen, um sofort loszulegen.

-

Intelligente Code-Fragen und -Antworten: Das ist eine riesige Sache. Es ermöglicht Entwicklern, Fragen zum Code in einfachem Englisch zu stellen und sofort Antworten zu erhalten. Dinge wie: „Was hat sich in dieser PR an der Zahlungs-API geändert?“ oder „Zeig mir, wo die Benutzerauthentifizierungslogik liegt.“ Es ist, als hätte man einen Teamkollegen mit einem perfekten fotografischen Gedächtnis der gesamten Codebasis.

-

Automatisierte Dokumentation: Seien wir ehrlich, Dokumentationen sind fast immer veraltet. Eine Integration kann Ihre READMEs, internen Wikis oder API-Dokumentationen automatisch aktualisieren, wann immer sich der Code, den sie beschreiben, ändert. Dies ist ein gewaltiger Schritt, um das Problem der veralteten Dokumentation endlich zu lösen.

Aktuelle Methoden für OpenAI Codex-Integrationen mit Bitbucket

Also, wie verkabelt man das alles? Sie haben einige Optionen, jede mit ihrem eigenen Gleichgewicht aus Einfachheit, Leistung und Preis.

Atlassians native KI-Funktionen

Atlassian baut seine eigenen KI-Tools, wie Atlassian Intelligence und Rovo, direkt in Bitbucket ein. Diese sind praktisch für einfache Dinge, wie das Generieren einer PR-Beschreibung mit einem einzigen Klick.

Der Haken ist, dass Sie in Atlassians Sandkasten spielen. Diese Tools sind praktisch, aber sie haben nicht immer die volle Leistung oder Flexibilität, die man durch die direkte Nutzung von OpenAIs Modellen erhält. Wenn Sie einen spezifischen, benutzerdefinierten Workflow im Sinn haben oder eine tiefgehende Code-Analyse durchführen müssen, werden Sie die integrierten Funktionen wahrscheinlich als etwas einschränkend empfinden.

Integrationsplattformen von Drittanbietern

Eine Reihe von No-Code- und Low-Code-Plattformen sind aufgetaucht, die als Klebstoff zwischen verschiedenen Apps fungieren, wie Albato, Latenode und Autonoly. Sie sind ziemlich gut darin, einfache „Wenn dies, dann das“-Workflows zu erstellen. Zum Beispiel könnten Sie leicht eine Regel einrichten: „Wenn ein neuer Pull-Request in Bitbucket geöffnet wird, sende den Code an OpenAI und poste die Zusammenfassung als Kommentar.“

graph TD A[Neuer Pull Request in Bitbucket] --> B{Drittanbieter-Plattform}; B --> C[Code an OpenAI API senden]; C --> D{Zusammenfassung generieren}; D --> E[Zusammenfassung als Kommentar in Bitbucket posten];

Der Nachteil ist, dass diese Plattformen teuer werden können und ihre vorgefertigten Trigger oft nicht genügend Kontext über Ihr Repository haben, um wirklich tiefe Einblicke zu liefern. Ein einfacher API-Aufruf kann eine Dateiänderung zusammenfassen, aber er kann Ihnen nicht sagen, warum diese Änderung einer Entscheidung widerspricht, die Ihr Team vor sechs Monaten getroffen hat.

Benutzerdefinierte Skripte mit Bitbucket Pipelines

Dies ist die „Ärmel hochkrempeln“- und leistungsstärkste Option. Sie können ein Skript schreiben (z.B. in Python), das als Teil einer Bitbucket Pipeline läuft, wann immer ein Ereignis wie ein „git push“ stattfindet. Das Skript kann dann die OpenAI-API mit den gewünschten Anweisungen aufrufen und die Antwort verarbeiten.

Dieses Video zeigt, wie man Code-Reviews mit GenAI in Bitbucket Pipelines automatisiert, was Zeit sparen, die Sicherheit verbessern und konsistente Programmierstandards gewährleisten kann.

Der Vorteil ist die vollständige Kontrolle. Sie können Ihre Prompts anpassen, komplexe Logik aufbauen und einen Workflow erstellen, der perfekt zu Ihrem Team passt. Der offensichtliche Nachteil ist, dass es die Zeit und den Aufwand eines Entwicklers erfordert, um es zu erstellen und zu warten. Es ist mit Abstand die arbeitsintensivste Option, und diese benutzerdefinierten Skripte können manchmal fragil sein.

Die versteckten Herausforderungen (und wie man sie löst)

Zwei APIs miteinander kommunizieren zu lassen, ist normalerweise der einfache Teil. Der schwierige Teil, an dem die meisten Teams scheitern, ist, die Integration wirklich nützlich zu machen. Hier sind die echten Probleme, auf die Sie stoßen werden, und wie Sie darüber nachdenken sollten.

Die Kontextlücke: Eine KI ohne Unternehmenswissen

Das ist ohne Zweifel das größte Problem, dem Sie begegnen werden. Ein Standardaufruf an die OpenAI-API hat keine Ahnung von den Programmierstandards, Architekturentscheidungen oder der Projekthistorie Ihres Unternehmens. Sie gibt generische Ratschläge, die technisch vielleicht in Ordnung, aber für Ihre spezifische Codebasis völlig falsch sind. Sie könnte die Verwendung einer Bibliothek vorschlagen, die Sie verboten haben, oder ein Muster empfehlen, das Ihr Teamleiter aktiv ablehnt.

Alternativer Titel: Die Kontextlücke bei OpenAI Codex-Integrationen mit Bitbucket verstehen.

Hier brauchen Sie mehr als nur eine schlaue KI; Sie brauchen eine Intelligenzschicht, die Ihre Organisation versteht. Während OpenAI die Rechenleistung liefert, bietet eine Plattform wie eesel AI diesen entscheidenden Kontext. Sie verbindet sich mit dem gesamten Wissen Ihres Unternehmens, nicht nur mit dem Code. Wir sprechen von Designdokumenten in Confluence, der Projekthistorie in Jira Service Management und sogar technischen Debatten in Slack. Indem eesel AI all dies zusammenführt, hilft es Ihnen, einen Assistenten zu erstellen, der Antworten gibt, die tatsächlich relevant dafür sind, wie Ihr Team arbeitet.

Das Einrichtungskopfzerbrechen: Einfache Werkzeuge vs. komplexe Anforderungen

Sie stecken oft in einer frustrierenden Situation fest. Die No-Code-Tools sind einfach zu starten, aber nicht flexibel genug für echte Ingenieurarbeit. Die benutzerdefinierten Skripte sind leistungsstark, können aber zu einer enormen Wartungsbelastung werden. Es gibt keinen guten Mittelweg, um anspruchsvolle KI-Workflows zu erstellen, ohne ein Team für deren Verwaltung zu benötigen.

Hier kommt der „In wenigen Minuten einsatzbereit“-Ansatz von eesel AI ins Spiel. Es ist eine Self-Service-Plattform, die Ihnen die Leistung einer maßgeschneiderten Lösung ohne die ganzen Ingenieurskopfschmerzen bieten soll. Mit einfachen Integrationen für Ihre bestehenden Tools können Sie leistungsstarke KI-Agenten über ein Dashboard einrichten, was Ihnen sowohl Benutzerfreundlichkeit als auch tiefgehende Anpassungsmöglichkeiten bietet.

Das Vertrauensdefizit: Wie führt man KI sicher ein?

Das ist die große Frage: Wie können Sie einer KI vertrauen, Kommentare zu den Pull-Requests Ihres Teams abzugeben, ohne eine Menge Tests durchzuführen? Eine KI einfach so auf Ihren Kern-Workflow loszulassen, ist ein enormes Risiko. Was, wenn sie schreckliche Ratschläge gibt, Leute verwirrt oder einfach nur mehr Lärm erzeugt?

Die meisten Tools übergehen dieses Problem einfach, aber eesel AI macht es zur Priorität. Es verfügt über einen Simulationsmodus, mit dem Sie Ihren KI-Agenten an Tausenden Ihrer vergangenen PRs oder Support-Tickets in einer sicheren Sandbox-Umgebung testen können. Sie können genau sehen, wie er sich verhalten hätte, Prognosen über seine Leistung erhalten und ihn perfektionieren, bevor er mit einem einzigen Entwickler interagiert. So können Sie KI mit Vertrauen einführen, nicht nur mit Hoffnung.

Vom einfachen Anschluss zur echten Intelligenz

Die Verknüpfung von OpenAI mit Bitbucket kann eine enorme Hilfe sein, um langweilige Aufgaben zu automatisieren, die Code-Qualität zu verbessern und Ihrem Team zu helfen, schneller voranzukommen. Wie wir besprochen haben, gibt es verschiedene Wege, dies zu erreichen, von integrierten Funktionen bis hin zu vollständig benutzerdefinierten Skripten.

Aber eine großartige Integration ist mehr als nur das Verbinden von zwei APIs. Die wahre Magie entsteht, wenn Sie der KI den Kontext geben können, den sie benötigt, um das einzigartige Wissen Ihres Teams zu verstehen. Die größten Erfolge erzielen Sie, wenn Sie einen leistungsstarken Workflow haben, der dennoch einfach zu verwalten ist, und eine Möglichkeit, ihn ohne große Risiken zu testen und bereitzustellen.

Die Lösung dieser Herausforderungen in Bezug auf Kontext, Komplexität und Kontrolle ist genau das, wofür moderne KI-Plattformen entwickelt wurden. Sie verwandeln einen einfachen API-Aufruf in ein intelligentes System, das wirklich für Ihr Team arbeitet.

Vereinheitlichen Sie Ihr technisches Wissen mit eesel AI

Bereit, einen KI-Assistenten zu bauen, der Ihr Team wirklich versteht? Einen, der schwierige technische Fragen beantworten kann, indem er auf das kollektive Gehirn Ihres Teams zugreift?

Verbinden Sie Ihre Entwicklungstools wie Confluence, Jira Service Management und Slack mit eesel AI. Geben Sie Ihrem Team eine interne KI, die sofortige, genaue Antworten liefert, die auf dem eigenen Wissen Ihres Unternehmens basieren. Sie können es in Minuten einsatzbereit machen, nicht in Monaten.

Häufig gestellte Fragen

Heute sprechen wir bei OpenAI Codex-Integrationen mit Bitbucket über die Verwendung der neuesten und leistungsfähigsten Sprachmodelle von OpenAI, wie die GPT-4-Serie, für programmierbezogene Aufgaben innerhalb Ihrer Bitbucket-Workflows. Die Fähigkeiten des ursprünglichen Codex-Modells wurden übertroffen und sind nun in diese neueren, leistungsfähigeren LLMs integriert.

Diese Integrationen können die Effizienz erheblich steigern durch automatisierte Code-Reviews, die Probleme aufzeigen, KI-generierte Zusammenfassungen von Pull-Requests für ein schnelleres Verständnis und intelligente Code-Q&A für sofortige Antworten zur Codebasis. Sie können auch die Aktualisierung der Dokumentation automatisieren und so den manuellen Aufwand reduzieren.

Sie können die Integration über die nativen KI-Funktionen von Atlassian (wie Atlassian Intelligence) durchführen, Drittanbieter-Integrationsplattformen für einfachere Workflows nutzen oder benutzerdefinierte Skripte erstellen, die in Bitbucket Pipelines laufen, um maximale Kontrolle und Flexibilität zu erhalten. Jede Methode bietet unterschiedliche Stufen von Einfachheit und Leistung.

Die „Kontextlücke“ bezieht sich auf das fehlende spezifische Unternehmenswissen der KI, wie z.B. Programmierstandards, Architekturentscheidungen oder Projekthistorie. Ohne diesen Kontext könnte die KI generische Ratschläge geben, die für Ihre einzigartige Codebasis oder Team-Praktiken ungeeignet sind, was eine Intelligenzschicht erfordert, die Ihre Organisation versteht.

Um Vertrauen aufzubauen, sollten Teams Simulationsmodi nutzen, die es ermöglichen, KI-Agenten an vergangenen Daten in einer sicheren Sandbox-Umgebung zu testen. Dies hilft Ihnen, das Verhalten zu beobachten, die Leistung vorherzusagen und die KI zu verfeinern, bevor sie direkt mit den Live-Entwicklungsworkflows interagiert, wodurch Risiken minimiert werden.

Einfachere No-Code-Tools sind vielleicht leicht zu starten, aber es fehlt ihnen oft der tiefe Kontext über Ihr Repository oder die Flexibilität für komplexe Ingenieur-Workflows. Ihre vorgefertigten Trigger liefern möglicherweise nicht genügend nuancierte Informationen für wirklich aufschlussreiche oder maßgeschneiderte KI-Unterstützung.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.