Soyons réalistes : l'IA est partout dans le monde du développement. L'idée de la connecter à un outil comme Bitbucket pour accélérer les choses ne relève plus de la science-fiction. C'est un moyen concret de faire plus, d'écrire du meilleur code et peut-être même de livrer un peu plus vite. Mais essayer de comprendre comment le faire réellement peut donner l'impression de patauger dans un jargon marketing.

Ce guide est là pour y voir plus clair. Nous allons examiner ce que sont les intégrations OpenAI Codex avec Bitbucket, ce que vous pouvez réellement en faire, les différentes manières de les configurer et les obstacles que vous rencontrerez très certainement.

À la fin de ce guide, vous aurez une vision beaucoup plus claire de la manière de connecter ces outils pour résoudre les problèmes réels de votre équipe de développement.

Que sont les intégrations OpenAI Codex avec Bitbucket ?

Avant d'aborder le « comment », nous devons nous mettre d'accord sur le « quoi ». Le secteur de l'IA évolue à une vitesse folle, alors mettons nos définitions au clair. Cela permettra de tout comprendre plus facilement.

Qu'est-ce que Bitbucket ?

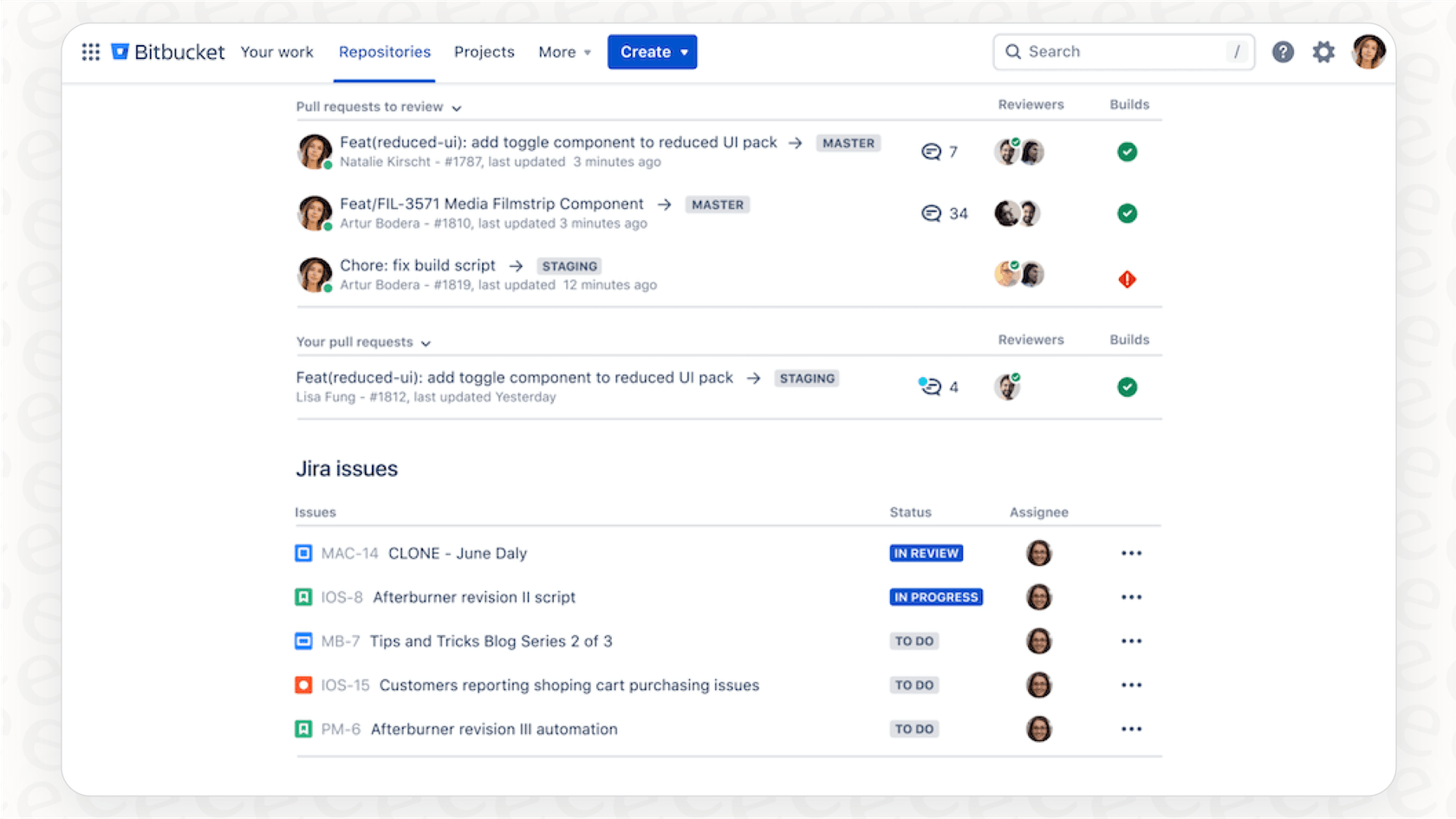

Vous le savez probablement déjà, mais au cas où : Bitbucket est la plateforme Git d'Atlassian pour héberger et collaborer sur du code. Elle ressemble beaucoup à ses concurrents, mais son super-pouvoir réside dans son intégration parfaite avec l'écosystème Atlassian, en particulier Jira. Les équipes la choisissent souvent pour ses pipelines CI/CD solides et son accent sur les fonctionnalités et la sécurité de niveau entreprise.

Qu'est-ce qu'OpenAI Codex ? Une clarification nécessaire

Bon, c'est là que les choses se compliquent un peu. Si vous suivez l'IA depuis un certain temps, vous vous souvenez du modèle OpenAI Codex original. C'était la technologie derrière les premières versions de GitHub Copilot, et à l'époque, ça tenait de la magie. Eh bien, ce modèle spécifique a été officiellement abandonné en mars 2023.

Alors, qu'est-ce que cela signifie pour nous aujourd'hui ?

-

OpenAI utilise désormais le nom « Codex » pour un agent de génie logiciel plus récent et plus ambitieux, capable de gérer des projets de codage entiers.

-

Les capacités du Codex original ont été entièrement intégrées et dépassées par des modèles de langage plus récents (LLM), comme la série GPT-4.

Ainsi, pour le reste de ce guide, lorsque nous parlons d'« intégrations OpenAI Codex », nous faisons en réalité référence à l'utilisation des modèles de langage les plus récents et les plus performants d'OpenAI pour effectuer des tâches de codage dans votre flux de travail Bitbucket.

Que pouvez-vous réellement faire avec les intégrations OpenAI Codex et Bitbucket ?

L'intérêt de configurer ces intégrations est de se débarrasser des tâches ennuyeuses et répétitives de la journée d'un développeur. Lorsque vous y parvenez, connecter une IA à votre dépôt, c'est comme avoir un développeur junior supplémentaire dans votre équipe, qui travaille 24h/24 et 7j/7 sans jamais se fatiguer. Voici quelques-unes des utilisations les plus populaires :

-

Revues de code automatisées : Imaginez une IA qui effectue une première passe sur chaque pull request. Elle pourrait automatiquement ajouter des commentaires signalant des erreurs de syntaxe, suggérant des ajustements basés sur le guide de style de votre équipe, ou signalant du code qui semble un peu suspect. Cela ne signifie pas que vos développeurs seniors sont au chômage ; cela signifie simplement qu'ils n'ont plus à perdre de temps sur les détails et peuvent se concentrer sur l'architecture globale.

-

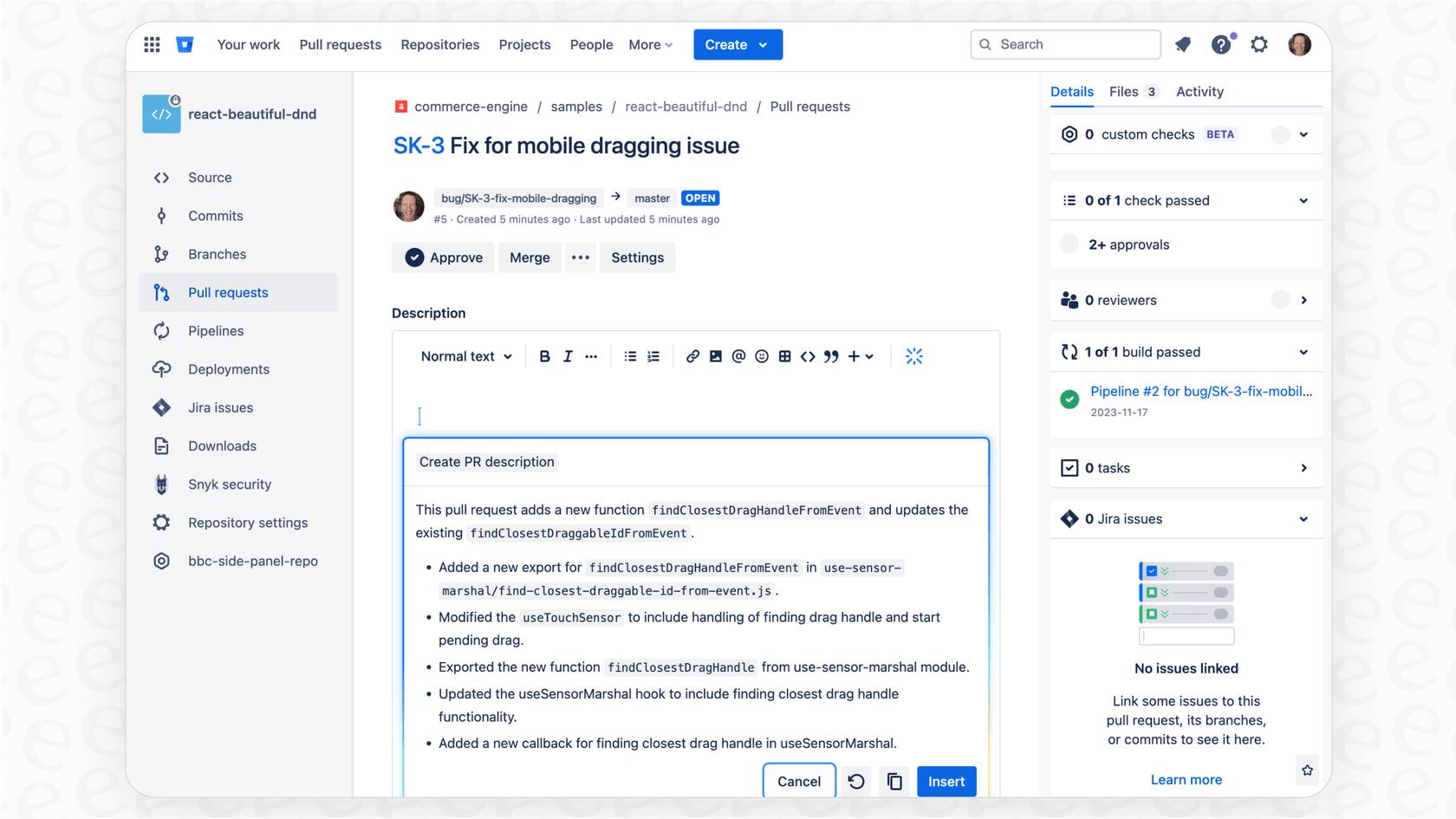

Résumés de pull requests générés par l'IA : Nous sommes tous passés par là, à regarder une PR avec une description qui dit simplement « correction de bug ». Une IA peut lire les messages de commit et les modifications de code pour rédiger un résumé clair de ce qui se passe. Cela fait gagner quelques minutes au développeur et donne aux relecteurs le contexte dont ils ont besoin pour commencer immédiatement.

-

Questions-réponses intelligentes sur le code : Ceci est un énorme atout. Cela permet aux développeurs de poser des questions en langage naturel sur le code et d'obtenir des réponses immédiates. Des questions comme « Qu'est-ce qui a changé dans l'API de paiement dans cette PR ? » ou « Montre-moi où se trouve la logique d'authentification utilisateur ». C'est comme avoir un coéquipier avec une mémoire photographique parfaite de toute la base de code.

-

Documentation automatisée : Soyons honnêtes, la documentation est presque toujours obsolète. Une intégration peut mettre à jour automatiquement vos README, vos wikis internes, ou votre documentation d'API chaque fois que le code qu'elle décrit change. C'est un grand pas en avant pour enfin résoudre le problème de la documentation obsolète.

Méthodes actuelles pour les intégrations OpenAI Codex avec Bitbucket

Alors, comment met-on tout cela en place ? Vous avez plusieurs options, chacune avec son propre équilibre entre facilité, puissance et coût.

Fonctionnalités d'IA natives d'Atlassian

Atlassian est en train d'intégrer ses propres outils d'IA, comme Atlassian Intelligence et Rovo, directement dans Bitbucket. Ils sont pratiques pour des tâches simples, comme générer une description de PR en un seul clic.

Le piège, c'est que vous jouez dans le bac à sable d'Atlassian. Ces outils sont pratiques, mais ils n'ont pas toujours toute la puissance ou la flexibilité de l'utilisation directe des modèles d'OpenAI. Si vous avez un flux de travail spécifique et personnalisé en tête ou si vous devez effectuer une analyse de code approfondie, vous trouverez probablement les fonctionnalités intégrées un peu limitantes.

Plateformes d'intégration tierces

De nombreuses plateformes no-code et low-code sont apparues pour agir comme de la colle entre différentes applications, comme Albato, Latenode et Autonoly. Elles sont assez efficaces pour créer des flux de travail simples du type « si ceci, alors cela ». Par exemple, vous pourriez facilement mettre en place une règle : « Lorsqu'une nouvelle pull request est ouverte dans Bitbucket, envoyer le code à OpenAI et publier son résumé en commentaire. »

graph TD A[Nouvelle Pull Request dans Bitbucket] --> B{Plateforme tierce}; B --> C[Envoyer le code à l'API OpenAI]; C --> D{Générer un résumé}; D --> E[Publier le résumé en commentaire dans Bitbucket];

L'inconvénient est que ces plateformes peuvent devenir coûteuses, et leurs déclencheurs préconfigurés manquent souvent de contexte sur votre dépôt pour fournir des informations vraiment pertinentes. Un simple appel API peut résumer un changement de fichier, mais il ne peut pas vous dire pourquoi ce changement va à l'encontre d'une décision prise par votre équipe il y a six mois.

Scripts personnalisés avec Bitbucket Pipelines

C'est l'option la plus puissante, celle qui demande de se retrousser les manches. Vous pouvez écrire un script (en Python, par exemple) qui s'exécute dans le cadre d'un pipeline Bitbucket chaque fois qu'un événement comme un « git push » se produit. Le script peut alors appeler l'API OpenAI avec les instructions que vous souhaitez et traiter la réponse.

Cette vidéo montre comment automatiser les revues de code avec l'IA générative dans Bitbucket Pipelines, ce qui peut faire gagner du temps, améliorer la sécurité et garantir des standards de codage cohérents.

L'avantage est un contrôle total. Vous pouvez ajuster vos prompts, construire une logique complexe et créer un flux de travail parfaitement adapté à votre équipe. L'inconvénient évident est que cela demande du temps et des efforts de développement pour la construction et la maintenance. C'est de loin l'option la plus exigeante en travail, et ces scripts personnalisés peuvent parfois être fragiles.

Les défis cachés (et comment les surmonter)

Faire communiquer deux API est généralement la partie facile. La partie difficile, celle où la plupart des équipes échouent, est de rendre l'intégration réellement utile. Voici les vrais problèmes que vous rencontrerez et comment y réfléchir.

Le manque de contexte : une IA sans connaissance de l'entreprise

C'est, sans aucun doute, le plus gros problème auquel vous serez confronté. Un appel standard à l'API OpenAI n'a aucune idée des standards de codage de votre entreprise, de ses décisions architecturales ou de l'historique du projet. Elle donne des conseils génériques qui peuvent être techniquement corrects mais totalement inadaptés à votre base de code spécifique. Elle pourrait suggérer d'utiliser une bibliothèque que vous avez bannie ou recommander un modèle que votre chef d'équipe déteste activement.

C'est là que vous avez besoin de plus qu'une simple IA intelligente ; vous avez besoin d'une couche d'intelligence qui comprend votre organisation. Tandis qu'OpenAI fournit la puissance de calcul, une plateforme comme eesel AI fournit ce contexte essentiel. Elle se connecte à toutes les connaissances de votre entreprise, pas seulement au code. Nous parlons des documents de conception dans Confluence, de l'historique des projets dans Jira Service Management, et même des débats techniques dans Slack. En rassemblant tout cela, eesel AI vous aide à créer un assistant qui donne des réponses réellement pertinentes pour la façon dont votre équipe travaille.

Le casse-tête de la configuration : outils simples contre besoins complexes

Vous vous retrouvez souvent dans une situation frustrante. Les outils no-code sont simples à prendre en main, mais pas assez flexibles pour un vrai travail d'ingénierie. Les scripts personnalisés sont puissants mais peuvent devenir un énorme fardeau en matière de maintenance. Il n'y a pas de juste milieu pour créer des flux de travail d'IA sophistiqués sans avoir besoin d'une équipe pour les gérer.

C'est là que l'approche « prêt en quelques minutes » d'eesel AI est utile. C'est une plateforme en libre-service qui vise à vous donner la puissance d'une solution sur mesure sans les maux de tête de l'ingénierie. Avec des intégrations simples pour vos outils existants, vous pouvez configurer de puissants agents IA via un tableau de bord, vous offrant à la fois facilité d'utilisation et personnalisation approfondie.

Le déficit de confiance : comment déployer l'IA en toute sécurité ?

C'est la grande question : comment pouvez-vous faire confiance à une IA pour commencer à commenter les pull requests de votre équipe sans des tonnes de tests ? Laisser une IA en liberté sur votre flux de travail principal est un risque énorme. Et si elle donnait de mauvais conseils, embrouillait les gens ou créait simplement plus de bruit ?

La plupart des outils ignorent ce problème, mais eesel AI en fait une priorité. Elle dispose d'un mode de simulation qui vous permet de tester votre agent IA sur des milliers de vos anciennes PR ou tickets de support dans un environnement sécurisé et isolé. Vous pouvez voir exactement comment il se serait comporté, obtenir des prévisions sur ses performances et l'ajuster jusqu'à ce qu'il soit parfait, tout cela avant qu'il n'interagisse avec un seul développeur. Cela vous permet de déployer l'IA avec confiance, et non avec simple espoir.

Passer d'une simple connexion à une véritable intelligence

Connecter OpenAI à Bitbucket peut être d'une grande aide pour automatiser les tâches ennuyeuses, améliorer la qualité du code et aider votre équipe à avancer plus vite. Comme nous l'avons vu, vous avez plusieurs façons de le faire, des fonctionnalités intégrées aux scripts entièrement personnalisés.

Mais une bonne intégration, c'est bien plus que de simplement relier deux API. La vraie magie opère lorsque vous pouvez donner à l'IA le contexte dont elle a besoin pour comprendre les connaissances uniques de votre équipe. Les plus grands avantages apparaissent lorsque vous disposez d'un flux de travail puissant mais simple à gérer, et d'un moyen de le tester et de le déployer sans prendre de grands risques.

Résoudre ces défis de contexte, de complexité et de contrôle est exactement ce pour quoi les plateformes d'IA modernes sont conçues, transformant un simple appel API en un système intelligent qui travaille vraiment pour votre équipe.

Unifiez vos connaissances en ingénierie avec eesel AI

Prêt à créer un assistant IA qui comprend vraiment votre équipe ? Un assistant capable de répondre à des questions techniques complexes en puisant dans le cerveau collectif de votre équipe ?

Connectez vos outils de développement comme Confluence, Jira Service Management, et Slack avec eesel AI. Donnez à votre équipe une IA interne qui fournit des réponses instantanées et précises, basées sur les connaissances propres à votre entreprise. Vous pouvez le mettre en service en quelques minutes, pas en quelques mois.

Foire aux questions

Aujourd'hui, lorsque nous discutons des intégrations OpenAI Codex avec Bitbucket, nous parlons d'utiliser les modèles de langage les plus récents et les plus performants d'OpenAI, comme la série GPT-4, pour des tâches liées au codage au sein de vos flux de travail Bitbucket. Les capacités du modèle Codex original ont été surpassées et sont désormais intégrées dans ces nouveaux LLM plus puissants.

Ces intégrations peuvent considérablement améliorer l'efficacité grâce à des revues de code automatisées qui signalent les problèmes, des résumés de pull requests générés par l'IA pour une compréhension plus rapide, et des questions-réponses intelligentes sur le code pour des réponses instantanées sur la base de code. Elles peuvent également automatiser les mises à jour de la documentation, réduisant ainsi l'effort manuel.

Vous pouvez réaliser l'intégration en utilisant les fonctionnalités d'IA natives d'Atlassian (comme Atlassian Intelligence), en tirant parti de plateformes d'intégration tierces pour des flux de travail plus simples, ou en créant des scripts personnalisés qui s'exécutent dans les pipelines Bitbucket pour un contrôle et une flexibilité maximum. Chaque méthode offre différents niveaux de facilité et de puissance.

Le « manque de contexte » fait référence à l'absence de connaissances spécifiques à l'entreprise de la part de l'IA, telles que les standards de codage, les décisions architecturales ou l'historique des projets. Sans ce contexte, l'IA pourrait fournir des conseils génériques qui ne sont pas adaptés à votre base de code ou aux pratiques de votre équipe, ce qui nécessite une couche d'intelligence qui comprend votre organisation.

Pour instaurer la confiance, les équipes doivent utiliser des modes de simulation qui permettent de tester les agents IA sur des données passées dans un environnement sécurisé et isolé. Cela vous aide à observer le comportement, à prévoir les performances et à affiner l'IA avant qu'elle n'interagisse directement avec les flux de travail de développement en direct, atténuant ainsi les risques.

Les outils plus simples, de type no-code, peuvent être faciles à prendre en main, mais ils manquent souvent du contexte approfondi de votre dépôt ou de la flexibilité nécessaire pour des flux de travail d'ingénierie complexes. Leurs déclencheurs préconfigurés peuvent ne pas fournir suffisamment d'informations nuancées pour une assistance IA vraiment pertinente ou personnalisée.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.