Se é programador, provavelmente já viu o que modelos como o GPT-4o conseguem fazer e pensou em construir algo com eles. O principal ponto de entrada é a API da OpenAI, mas trabalhar diretamente com ela significa escrever muito código repetitivo para pedidos HTTP. É aqui que entram os SDKs (Software Development Kits) da OpenAI. Basicamente, são kits de ferramentas para diferentes linguagens de programação que facilitam imenso a chamada à API.

Mas a questão é a seguinte: embora os SDKs sejam ótimos para começar, construir uma aplicação completa e pronta para produção para algo como apoio ao cliente é um desafio completamente diferente. Não se trata apenas de algumas chamadas à API. Tem de pensar no histórico de conversas, em extrair dados de diferentes locais e numa tonelada de testes. Tudo isto se traduz em muito tempo de engenharia. Por isso, vamos analisar o que são os SDKs da OpenAI, o que pode fazer com eles e algumas das complexidades do mundo real a ter em mente. Também veremos uma forma de pôr agentes de IA poderosos a funcionar muito mais rapidamente.

O que são os SDKs da OpenAI?

No fundo, a API da OpenAI é um serviço RESTful com o qual se comunica através de HTTP. Poderia construir esses pedidos por si próprio, mas é uma chatice e é fácil cometer erros. Os SDKs da OpenAI são bibliotecas oficiais que fazem o trabalho pesado por si. Fornecem-lhe funções e classes simples para usar a API diretamente a partir da sua linguagem de programação favorita.

Pense num SDK como um invólucro amigável. Em vez de se preocupar com os detalhes dos cabeçalhos de autenticação, formatação de pedidos e análise de respostas, pode simplesmente fazer uma chamada de função direta como "client.responses.create()".

OpenAI tem SDKs oficiais para várias linguagens populares:

-

Python: A escolha principal para a maioria dos trabalhos de IA e machine learning.

-

TypeScript / JavaScript (Node.js): Perfeito para aplicações web e serviços de backend.

-

.NET: Para quem trabalha no mundo do C# e da Microsoft.

-

Java: Uma escolha sólida para aplicações maiores, de estilo empresarial.

-

Go: Ótimo se precisar de velocidade e boa concorrência.

E se a sua linguagem de eleição não estiver nessa lista, a comunidade provavelmente já construiu uma biblioteca para ela. A ideia geral é sempre a mesma: instale o SDK, obtenha a sua chave de API secreta do seu painel da OpenAI e pode começar a chamar os modelos a partir do seu código.

Funcionalidades chave e casos de uso para os SDKs da OpenAI

Uma vez configurados, os SDKs abrem a porta para muitas capacidades diferentes. Aqui estão as principais coisas que as pessoas constroem com eles.

Geração de texto e respostas

Isto é o pão nosso de cada dia. Usando o endpoint responses.create, pode enviar um prompt para um modelo como o "gpt-4o" e obter uma resposta em texto. Esta é a base para tudo, desde um simples gerador de conteúdo a um chatbot conversacional completo. Para dar contexto ao modelo, pode passar uma série de mensagens no seu pedido, o que o ajuda a manter o fio da conversa.

Multimodalidade (análise de imagem, áudio e ficheiros)

Modelos mais recentes como o GPT-4o não se limitam apenas a texto; são multimodais. Os SDKs da OpenAI permitem incluir diferentes tipos de conteúdo nos seus prompts:

-

Imagens: Pode passar um URL de uma imagem ou carregar uma diretamente e pedir ao modelo para lhe dizer o que está nela, responder a perguntas sobre ela ou até mesmo extrair texto dela.

-

Áudio: Os modelos podem transcrever ficheiros de áudio para texto.

-

Ficheiros: Pode carregar documentos como PDFs e pedir ao modelo para os resumir ou responder a perguntas com base no seu conteúdo.

Estender modelos com ferramentas (chamada de funções)

É aqui que as coisas ficam realmente interessantes. A funcionalidade "ferramentas" (que costumava ser chamada de chamada de funções) permite-lhe dar ao modelo um conjunto de funções personalizadas que ele pode pedir para usar. Por exemplo, pode definir uma função chamada get_weather. Se um utilizador perguntar, "Como está o tempo em Paris?", o modelo não vai simplesmente inventar algo. Ele retornará um objeto JSON a dizer que quer chamar a sua função get_weather com o parâmetro location: "Paris".

O seu código depois executa a função, busca os dados meteorológicos reais e envia essa informação de volta para o modelo. O modelo então usa esses dados para dar ao utilizador uma resposta com som natural. É assim que se constroem aplicações que podem interagir com o mundo exterior.

Ativo 1: [Fluxo de Trabalho] , Diagrama a ilustrar o processo de chamada de funções com os SDKs da OpenAI.

Código do Gráfico Mermaid graph TD; A[Utilizador pergunta: "Como está o tempo em Paris?"] --> B{Modelo recebe o prompt}; B --> C{Modelo identifica a necessidade de uma ferramenta}; C --> D[Modelo retorna JSON para chamar 'get_weather(location: "Paris")']; D --> E[O seu código executa a função 'get_weather']; E --> F[API externa fornece dados meteorológicos]; F --> G[O seu código envia os dados de volta para o modelo]; G --> H{Modelo usa os dados para gerar uma resposta}; H --> I[Modelo responde: "O tempo em Paris está solarengo..."];

Uma dica rápida: embora possa construir as suas próprias chamadas de função para procurar dados de encomendas da sua base de dados, tem de construir e alojar toda essa lógica de backend por si mesmo. Uma alternativa é uma plataforma como a eesel AI, que lhe dá Ações de IA pré-construídas e um construtor de fluxos de trabalho visual. Pode ligar-se a ferramentas como o Shopify ou bases de dados internas sem escrever toda a canalização do zero, poupando uma tonelada de tempo de desenvolvimento.

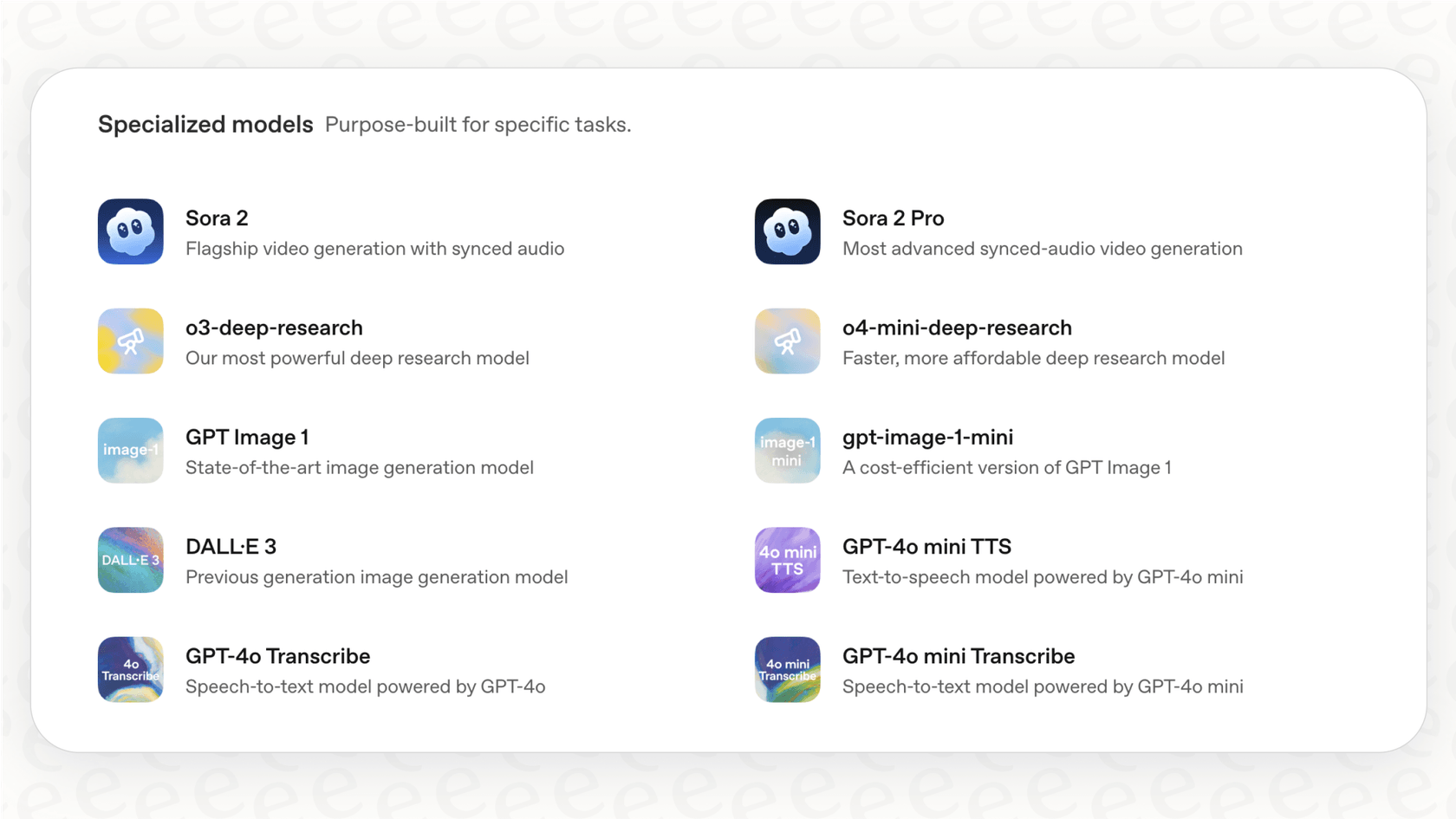

Construir agentes avançados com o Agents SDK

Para tarefas mais complexas, a OpenAI tem um Agents SDK especializado. Este serve para construir aplicações "agentes", onde uma IA pode enfrentar problemas de vários passos e até coordenar-se com outros agentes de IA. É algo poderoso, mas também representa um grande aumento de complexidade.

O Agents SDK baseia-se em algumas ideias principais:

-

Agentes: Um LLM que tem instruções específicas e um conjunto de ferramentas de funções que pode usar.

-

Transferências: Isto permite que um agente passe uma tarefa para outro, mais especializado. Pense num agente de triagem geral a passar um relatório de erro para um agente de suporte técnico.

-

Guardrails: Estas são regras que define para verificar o trabalho de um agente, garantindo que ele se mantém no tópico e não se desvia.

-

Sessões: O SDK gere automaticamente o histórico de conversas por si, mesmo quando as tarefas são passadas entre diferentes agentes.

Usar o Agents SDK permite criar uma lógica bastante sofisticada em Python ou TypeScript. Mas é uma ferramenta de muito baixo nível. Construir algo que seja suficientemente fiável para uma empresa requer um profundo conhecimento de design de agentes e uma sólida engenharia de software.

Ativo 2: [Fluxo de Trabalho] , Diagrama a mostrar como o Agents SDK lida com um problema de vários passos.

Código do Gráfico Mermaid graph TD; A[Utilizador: "A minha encomenda #123 está atrasada e quero reportar um erro."] --> B(Agente de Triagem); B --> C{A tarefa requer duas ações}; C -- Transferência --> D(Agente de Estado da Encomenda); D --> E[Verifica a base de dados de encomendas]; E --> F[Fornece ao utilizador uma atualização do envio]; C -- Transferência --> G(Agente de Relatório de Erros); G --> H[Recolhe detalhes técnicos do utilizador]; H --> I[Cria um ticket no Jira]; I --> J(Verificações de Guardrail); J --> K[Confirmação final ao utilizador];

É aqui que uma plataforma construída para o efeito se torna realmente útil. Montar um sistema de suporte multiagente por si próprio é um projeto de grande envergadura. Para necessidades empresariais como o serviço ao cliente, uma abordagem de plataforma é quase sempre mais rápida e fácil de escalar. Por exemplo, a eesel AI oferece-lhe um motor de fluxo de trabalho totalmente personalizável. Pode definir como os seus agentes de IA se devem comportar, configurar escalonamentos (que são como transferências) e escolher as suas fontes de conhecimento a partir de um painel simples. Isto permite-lhe entrar em funcionamento em minutos, não em meses.

Os custos ocultos e desafios de usar os SDKs da OpenAI

Os SDKs fazem parecer que é fácil começar, mas o caminho de um simples script para uma aplicação em produção tem alguns percalços e custos ocultos que deve conhecer.

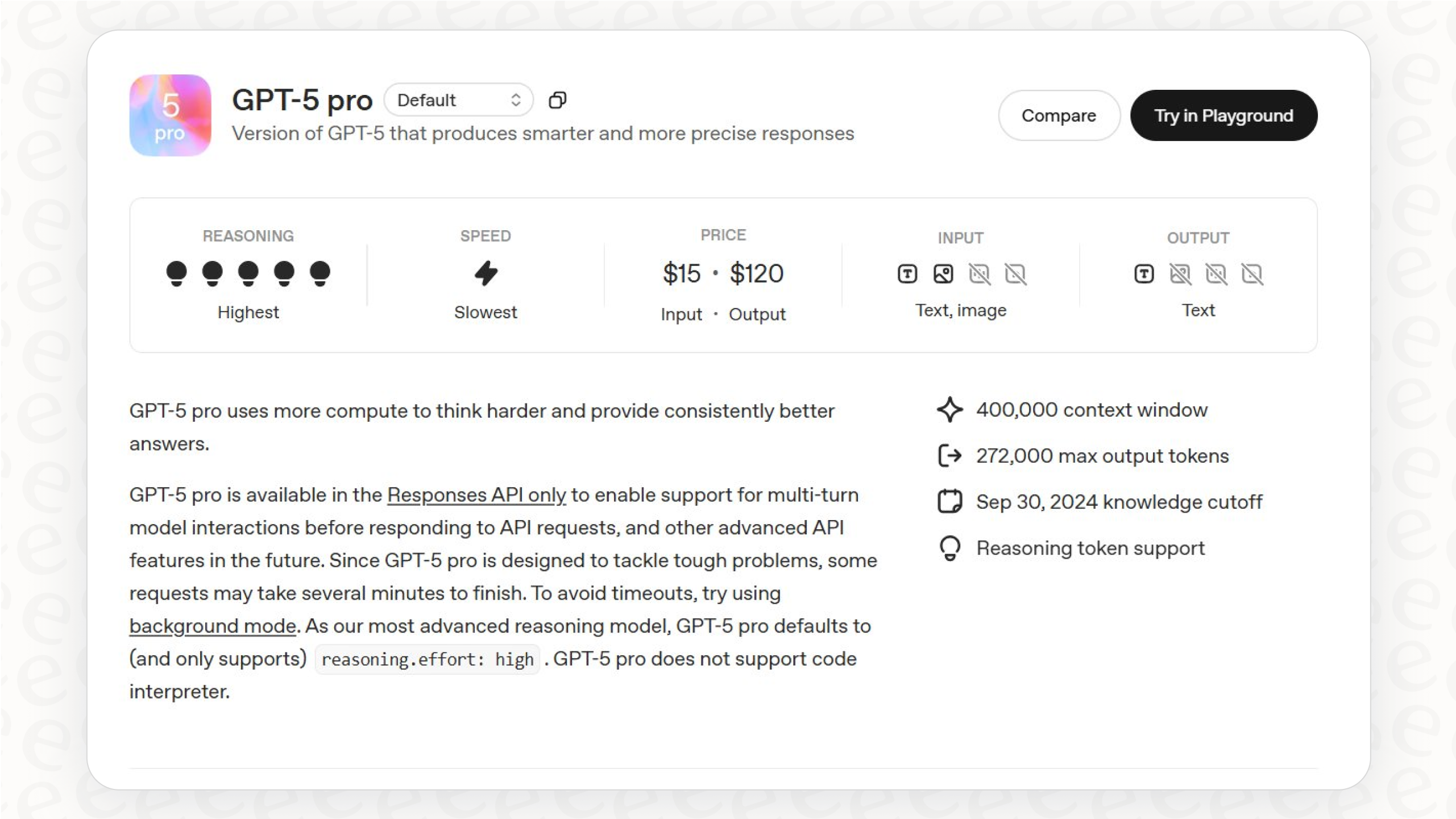

Compreender os preços da API

Os preços da OpenAI são maioritariamente do tipo "pague-conforme-usa", baseados em "tokens" (que são aproximadamente partes de palavras). Paga pelos tokens que envia no seu prompt (entrada) e pelos tokens que o modelo envia de volta (saída). Estes custos podem acumular-se sem que se dê conta, especialmente se estiver a enviar prompts longos ou a lidar com muitas conversas.

Aqui está uma rápida visão dos preços padrão para alguns modelos (por 1 milhão de tokens, a partir do final de 2025):

| Modelo | Entrada (por 1M de tokens) | Saída (por 1M de tokens) |

|---|---|---|

| gpt-4o | $2.50 | $10.00 |

| gpt-4o-mini | $0.15 | $0.60 |

| gpt-4.1 | $2.00 | $8.00 |

| gpt-5-mini | $0.25 | $2.00 |

Fonte: Preços da OpenAI. Os preços são para o nível padrão e podem mudar.

E não são apenas os modelos. Outras funcionalidades também têm custos:

-

Ferramentas: Usar ferramentas integradas como o Code Interpreter ou o File Search adiciona taxas extras por sessão ou com base no armazenamento.

-

Fine-Tuning: Se treinar um modelo personalizado, pagará pelo processo de treino e pelo uso do modelo.

Este preço por token pode tornar a sua fatura mensal imprevisível, o que não é ótimo para orçamentar. Em contraste, serviços como a eesel AI oferecem preços claros e previsíveis baseados num número fixo de interações de IA. Sabe exatamente o que está a pagar, o que facilita muito a previsão de custos.

A sobrecarga de engenharia de construir uma solução completa

Uma chamada de API é apenas uma pequena parte de uma aplicação real. Um agente de suporte de IA genuinamente útil precisa de uma grande infraestrutura por trás, a qual tem de construir e manter.

-

Gestão de Conhecimento (RAG): Para que uma IA responda a perguntas com precisão, precisa de contexto dos documentos da sua empresa. Terá de construir um sistema de Geração Aumentada por Recuperação (RAG). Isto envolve dividir os seus documentos, criar embeddings, configurar uma base de dados vetorial e construir uma forma de recuperar a informação correta.

-

Integrações: A sua IA precisa de falar com o seu helpdesk (Zendesk), as suas bases de conhecimento internas (Confluence, Google Docs) e outras ferramentas de negócio (Shopify, Jira). Cada uma dessas ligações é um mini-projeto em si.

-

Testes e Validação: Como sabe se a sua IA está realmente a ajudar ou a piorar as coisas? Precisa de construir uma estrutura de testes para a executar contra os seus tickets de suporte passados para ver o quão bem se comporta.

-

Manutenção e Melhoria: Os modelos são atualizados, os seus documentos internos mudam e as suas necessidades de negócio evoluem. Uma solução personalizada precisa de cuidados e atenção constantes para se manter eficaz.

Ativo 3: [Infográfico] , A Sobrecarga de Engenharia de Construir com os SDKs da OpenAI.

Descrição Criar um infográfico com um círculo central rotulado "Aplicação de IA em Produção". Quatro setas apontam para fora do círculo para outras quatro caixas:

-

Gestão de Conhecimento (RAG): Incluir ícones para divisão de documentos, embedding e uma base de dados vetorial.

-

Integrações: Incluir logótipos de ferramentas populares como Zendesk, Shopify, Confluence e Jira.

-

Testes e Validação: Incluir ícones que representem testes A/B, métricas de desempenho e análise de dados.

-

Manutenção e Melhoria: Incluir ícones para atualizações de modelos, ciclos de atualização de dados e monitorização contínua.

O infográfico deve representar visualmente que uma simples chamada de API é apenas a ponta do iceberg.

Estas são exatamente as dores de cabeça que plataformas como a eesel AI foram construídas para resolver. A eesel liga-se a todas as suas fontes de conhecimento com integrações de um clique, trata de todo o pipeline RAG por si e até tem um modo de simulação poderoso para testar o seu agente de IA em milhares de tickets reais antes que um único cliente fale com ele.

Um caminho mais simples para uma IA pronta para produção

Os SDKs da OpenAI são ferramentas fantásticas para programadores. São os blocos de construção essenciais para quem faz trabalho de IA profundo e personalizado.

Mas para problemas de negócio específicos, como automatizar o suporte ao cliente, otimizar helpdesks de TI ou configurar um bot interno de Perguntas e Respostas, construir do zero é muitas vezes uma jornada lenta, cara e arriscada. A questão não é apenas sobre o que é tecnicamente possível; é sobre quão rapidamente se pode obter valor, quão fiável será o produto final e qual será o custo total ao longo do tempo.

Porquê passar meses a reinventar a roda quando uma plataforma dedicada pode dar-lhe uma solução mais poderosa, integrada e testada em batalha numa fração do tempo? Ao tratar das partes complicadas como pipelines de dados, integrações e lógica de agente, plataformas como a eesel AI permitem que a sua equipa se foque no que realmente importa: criar uma ótima experiência para os seus clientes e funcionários.

Se o seu objetivo é resolver um problema de suporte hoje, e não iniciar um projeto de I&D a longo prazo, então uma abordagem baseada em plataforma é provavelmente a escolha certa.

Comece a usar o seu agente de IA em minutos

Pronto para ver o que um agente de suporte de IA de nível de produção pode fazer por si? Com a eesel AI, pode ligar o seu helpdesk e bases de conhecimento com um clique, simular o desempenho nos seus dados reais e lançar um agente de IA totalmente personalizado, copiloto ou chatbot. Tudo sem escrever uma única linha de código.

Comece hoje o seu teste gratuito e veja por si mesmo.

Perguntas frequentes

Os SDKs da OpenAI são bibliotecas oficiais para várias linguagens de programação que atuam como um invólucro (wrapper) em torno da API da OpenAI. Eles lidam com detalhes de baixo nível, como pedidos HTTP, autenticação e análise de respostas, permitindo que os programadores façam chamadas à API com simples chamadas de função específicas da linguagem.

A OpenAI fornece SDKs oficiais para várias linguagens de programação populares, incluindo Python, TypeScript/JavaScript (Node.js), .NET (C#), Java e Go. Estes SDKs servem uma vasta gama de ambientes de desenvolvimento para a construção de diferentes tipos de aplicações.

Os SDKs da OpenAI permitem capacidades multimodais ao permitir que inclua vários tipos de conteúdo, como URLs de imagens, imagens carregadas, ficheiros de áudio e documentos, diretamente nos seus prompts. Isto permite que modelos como o GPT-4o analisem e respondam a diversas entradas para além do texto.

Sim, os SDKs da OpenAI suportam totalmente a funcionalidade de "ferramentas" (anteriormente chamada de chamada de funções), que lhe permite definir funções personalizadas que o modelo pode solicitar para usar. Quando o modelo determina que uma função é relevante para o pedido de um utilizador, ele retornará um objeto JSON especificando a função e os seus parâmetros para o seu código executar.

Os principais desafios incluem uma sobrecarga significativa de engenharia para implementar a gestão de conhecimento (RAG), construir e manter integrações personalizadas e desenvolver estruturas de teste robustas. Estes aspetos exigem um tempo de desenvolvimento substancial e manutenção contínua para uma solução pronta para produção, para além dos custos da API.

O Agents SDK especializado é projetado para construir aplicações agênticas sofisticadas, fornecendo funcionalidades como transferências de agentes (handoffs), barreiras de proteção (guardrails) para comportamento controlado e gestão automática de sessões para o histórico de conversas. Facilita uma abordagem estruturada para a resolução de problemas em vários passos e a coordenação de múltiplos agentes de IA, simplificando a lógica complexa dos agentes.

Embora os SDKs da OpenAI sejam excelentes para o desenvolvimento de IA personalizado e profundo, as plataformas dedicadas como a eesel AI oferecem frequentemente um caminho mais rápido e eficiente para a produção de soluções de negócio específicas. Estas plataformas abstraem infraestruturas complexas, pipelines de dados e integrações, reduzindo significativamente a sobrecarga de engenharia e acelerando a implementação.

Compartilhe esta postagem

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.