Todos sabemos que os modelos de linguagem grandes (LLMs) são bons de conversa. Conseguem produzir e-mails, responder a perguntas de curiosidades e até criar um soneto a pedido. Mas e quanto a fazer coisas de verdade? Como fazemos para que parem de apenas falar e comecem a interagir com o mundo real, como procurar uma encomenda, atualizar um ticket de suporte ou consultar uma base de dados?

Esse é o trabalho da Chamada de Funções da OpenAI (que agora foi oficialmente renomeada para "Ferramentas"). É a peça do quebra-cabeça que conecta as habilidades de conversação de uma IA a ações do mundo real. É o que transforma um simples bot de perguntas e respostas num agente que pode realmente trabalhar com o software da sua empresa.

Neste guia, vamos analisar o que é a chamada de funções, como funciona e algumas das complexidades ocultas que encontrará se tentar construir com ela do zero. Mais importante, veremos como as plataformas modernas podem encarregar-se do trabalho pesado, permitindo-lhe construir poderosos agentes de IA sem precisar de uma equipa de engenharia dedicada a postos.

O que é a Chamada de Funções da OpenAI?

Simplificando, a Chamada de Funções da OpenAI é um recurso que lhe permite informar um LLM sobre as ferramentas que tem disponíveis. Você descreve as suas funções ao modelo, e ele pode então analisar o pedido de um utilizador e solicitar o uso de uma delas. Fá-lo ao gerar um objeto JSON bem estruturado com todos os detalhes que a sua aplicação precisa para executar a função.

Um equívoco comum é pensar que o modelo executa o código por si só. Não executa. Ele apenas diz à sua aplicação que código deve executar e que informação deve usar.

Pense no LLM como um assistente muito inteligente que conhece toda a sua caixa de ferramentas por dentro e por fora. Quando surge uma tarefa, ele não pode usar as ferramentas, mas pode entregar-lhe a correta (o nome da função) e dizer-lhe exatamente como usá-la (os argumentos). A sua aplicação é que, de facto, "põe as mãos na massa" e faz o trabalho.

Embora a OpenAI tenha começado recentemente a chamar este recurso de "Ferramentas" para capturar melhor o que ele pode fazer, a maioria das pessoas ainda usa o termo "chamada de funções" para descrever o conceito.

Como funciona o fluxo da Chamada de Funções da OpenAI?

Fazer uma IA usar uma ferramenta não é uma única chamada de API; é mais uma conversa de ida e volta entre a sua aplicação e o modelo. É uma pequena dança que segue um padrão bastante previsível.

Eis uma análise passo a passo de como tudo acontece:

-

Você mostra as suas ferramentas ao modelo. Primeiro, dá ao modelo uma lista das funções que ele pode usar. Isto inclui o nome da função, uma descrição clara do que faz e os parâmetros específicos de que precisa para funcionar (tudo disposto num formato chamado esquema JSON). A qualidade da sua descrição é tudo, é como o modelo descobre quando sugerir uma ferramenta.

-

O utilizador pede algo. Um utilizador digita um pedido em linguagem natural, como, "Qual é o estado da minha encomenda, #12345?"

-

O modelo escolhe uma ferramenta. O modelo lê o pedido. Se detetar uma correspondência com uma das descrições das suas funções, responde com uma mensagem especial a pedir à sua aplicação para chamar essa função. Também fornece os argumentos que extraiu do pedido do utilizador (por exemplo, "{"function": "get_order_status", "arguments": {"order_id": "12345"}}").

-

A sua aplicação faz o trabalho. O seu código pega nesta resposta estruturada e executa a função real "get_order_status". Pode conectar-se à sua base de dados ou a uma API externa para obter a informação, que neste caso é "Enviada."

-

Você passa o resultado de volta para o modelo. Finalmente, faz uma última chamada de API ao modelo, desta vez incluindo o resultado da função no histórico da conversa. Agora o modelo tem a peça final do quebra-cabeça e pode dar ao utilizador uma resposta amigável e natural, como, "A sua encomenda #12345 foi enviada."

Esta pequena viagem de ida e volta permite que a IA misture as suas habilidades de conversação com dados e ações em tempo real, tornando-a muito mais útil.

Casos de uso comuns para a Chamada de Funções da OpenAI

A chamada de funções é o que transforma um chatbot de uma simples novidade num agente poderoso que pode lidar com fluxos de trabalho empresariais reais. Aqui estão algumas das formas mais comuns como as pessoas a estão a utilizar.

Conectar-se aos seus dados em tempo real

Este é o caso de uso mais direto. Permite que uma IA aceda a informações em tempo real, privadas ou dinâmicas que não estavam nos seus dados de treino originais. Uma IA pode tornar-se especialista nas operações específicas do seu negócio quase instantaneamente.

Por exemplo, uma IA de apoio ao cliente poderia consultar o estado de uma encomenda numa base de dados do Shopify, verificar a disponibilidade de voos através da API de uma companhia aérea ou obter detalhes de uma conta do seu CRM interno.

Realizar tarefas noutras aplicações

Além de apenas obter informações, a chamada de funções permite que uma IA acione fluxos de trabalho e faça alterações noutros sistemas. Pode tornar-se uma parte ativa dos seus processos de negócio.

Por exemplo, um bot de suporte de TI poderia receber um pedido e criar automaticamente um novo ticket no Jira Service Management. Ou, um assistente de vendas poderia extrair detalhes de uma conversa e adicionar um novo lead ao seu CRM sem que ninguém precise de fazer a inserção manual de dados.

Transformar texto desorganizado em dados limpos

Às vezes, o objetivo não é responder a uma pergunta, mas sim extrair e formatar informações de forma fiável. A chamada de funções é ótima para isso porque pode definir os parâmetros de uma função como um modelo no qual deseja que os dados se encaixem.

Um exemplo perfeito é o processamento de um e-mail de suporte recebido. A IA pode ler um bloco de texto, extrair o nome do utilizador, a empresa, o tipo de problema e o nível de urgência, e depois formatar tudo num objeto JSON perfeito. Esse objeto pode então ser usado para criar um novo ticket, perfeitamente categorizado, na sua central de ajuda.

Os desafios ocultos de construir com a Chamada de Funções da OpenAI

Passar de uma demonstração interessante para uma aplicação pronta para produção que usa chamada de funções é um salto bastante grande. Construir diretamente com a API é poderoso, mas traz consigo algumas dores de cabeça de engenharia sérias que muitas equipas não preveem.

Desafios de orquestração

O que acontece quando uma tarefa precisa de vários passos? Para encontrar a encomenda de um cliente, pode primeiro precisar de encontrar o seu ID de cliente usando o seu e-mail, e depois usar esse ID para procurar as suas encomendas. O modelo não lida com este tipo de lógica de múltiplos passos por si só. Você tem de construir e manter uma "máquina de estados" no seu próprio código para gerir a sequência.

Fiabilidade e tratamento de erros

Os modelos nem sempre se comportam da maneira que espera. Às vezes, podem "alucinar" argumentos que não existem, chamar a função errada ou simplesmente não chamar uma quando é obviamente necessário. Isto significa que a sua equipa tem de escrever uma tonelada de validação, verificação de erros e lógica de repetição para tornar o sistema fiável.

Alguns programadores chegam ao ponto de praticamente gritar com o modelo nas suas mensagens de sistema, escrevendo coisas como "NÃO ASSUMA VALORES PARA OS PARÂMETROS" em maiúsculas, apenas para que ele se comporte. Dificilmente essa é uma forma escalável de construir um sistema de produção.

Encadeamento de funções: Um ponto fraco conhecido

Mesmo com os melhores prompts, os modelos muitas vezes têm dificuldade em planear e executar uma tarefa que requer várias chamadas de função diferentes numa ordem específica. São bastante bons a escolher a próxima melhor ferramenta para um único passo, mas podem perder-se num fluxo de trabalho mais complexo. Novamente, isto significa que tem de escrever código personalizado, muitas vezes complicado, para gerir o fluxo e guiar o modelo de um passo para o outro.

O desenvolvimento e a manutenção podem ser um verdadeiro fardo

Definir esquemas de função em JSON é um trabalho tedioso e é fácil cometer um erro de sintaxe. Sempre que quiser adicionar uma nova ferramenta ou atualizar uma antiga, tem de mergulhar de volta no código. Manter este código sincronizado com as suas ferramentas reais, gerir diferentes versões e simplesmente acompanhar as frequentes alterações na API da OpenAI torna-se um dreno constante no tempo de engenharia.

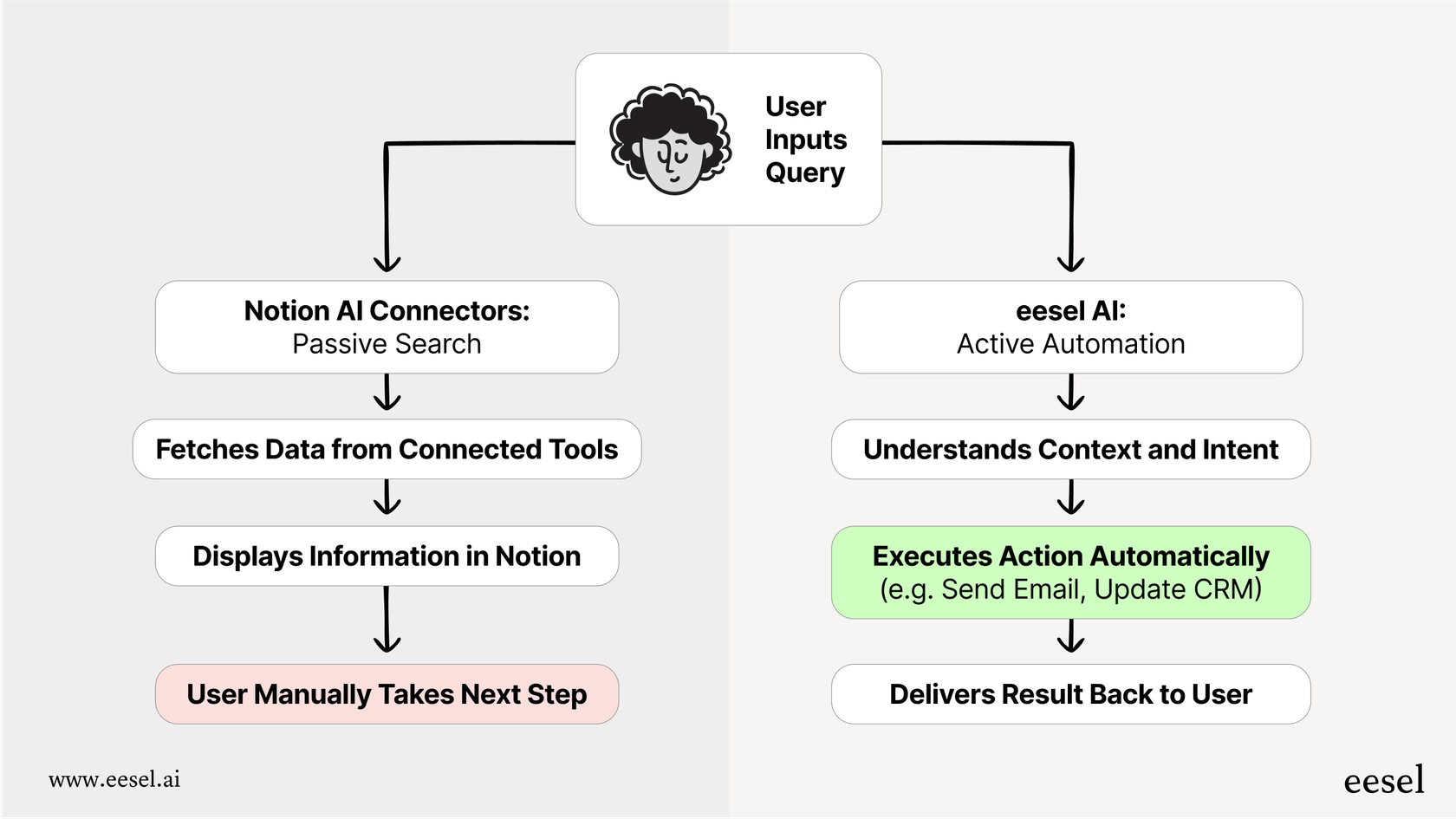

Uma forma mais simples de criar agentes de IA

A abordagem DIY (faça você mesmo) para a chamada de funções é poderosa, mas não é prática para a maioria das equipas de suporte e TI que precisam de soluções fiáveis sem uma equipa de engenharia dedicada. É aqui que plataformas como o eesel AI podem fazer uma enorme diferença. O eesel AI trata de todo o trabalho complicado nos bastidores da chamada de funções através de uma interface intuitiva, transformando um desafio de programação difícil num fluxo de trabalho simples.

De código complexo a um motor de fluxo de trabalho sem código

Em vez de escrever scripts Python e máquinas de estado para gerir chamadas de função, o eesel AI oferece-lhe um construtor de fluxos de trabalho visual. Pode configurar regras, caminhos de escalonamento e sequências de ações sem escrever uma única linha de código. Isto dá-lhe controlo total sobre o comportamento da sua IA, permitindo-lhe projetar fluxos de trabalho sofisticados que funcionam de forma fiável todas as vezes. Você decide exatamente quais tickets a IA deve tratar e o que deve fazer, passo a passo.

Ações pré-construídas e conexões personalizadas fáceis

O eesel AI vem com uma biblioteca de ações prontas a usar para centrais de ajuda populares como Zendesk e Freshdesk. Tarefas comuns como "etiquetar ticket," "adicionar nota interna," ou "fechar ticket" estão a apenas um clique de distância.

Precisa de se conectar a uma ferramenta personalizada ou a uma API interna? O eesel AI também simplifica isso. Pode facilmente configurar ações personalizadas para consultar informações ou acionar fluxos de trabalho em qualquer sistema externo, tratando de toda a tediosa criação de esquemas JSON por si. É assim que as equipas podem entrar em funcionamento em minutos, não em meses.

Teste a sua implementação com confiança antes de lançar

Uma das maiores preocupações com a abordagem DIY é a incerteza. O agente funcionará realmente como esperado em problemas reais de clientes? O eesel AI resolve isto com o seu modo de simulação. Em vez de implementar código e cruzar os dedos, pode executar o seu agente de IA em milhares dos seus tickets passados num ambiente seguro. Pode ver exatamente como teria respondido, que ações teria tomado e qual seria a sua taxa de automação. Isto permite-lhe ajustar tudo e testar com confiança antes que ele interaja com um cliente real.

Vá além da conversa e comece a agir

A Chamada de Funções da OpenAI é o motor que permite à IA fazer trabalho real, mas a API bruta é, na verdade, apenas uma caixa de peças. Construir um agente de IA fiável e de nível de produção do zero dá-lhe a máxima flexibilidade, mas tem um custo elevado em termos de complexidade, falta de fiabilidade e manutenção contínua.

Plataformas como o eesel AI oferecem todo o poder da chamada de funções sem a dor de cabeça da engenharia. Dão às equipas a capacidade de implementar agentes de IA capazes e personalizados que estão firmemente integrados com as suas ferramentas de negócio, finalmente preenchendo a lacuna entre apenas falar e realmente fazer.

Pronto para criar um agente de IA que toma ações reais?

Se está pronto para construir um agente de IA que se conecta às suas ferramentas e automatiza o seu suporte, inscreva-se gratuitamente no eesel AI e lance o seu primeiro agente de IA em minutos. Não é necessário programar.

Perguntas Frequentes

A Chamada de Funções da OpenAI (agora frequentemente chamada de "Ferramentas") é um recurso que permite descrever as suas funções disponíveis para um LLM. Resolve o problema de conectar as habilidades de conversação de uma IA a ações do mundo real, permitindo-lhe pedir à sua aplicação para realizar tarefas como consultar dados ou atualizar sistemas.

Não, o LLM não executa o seu código. Ele simplesmente analisa o pedido de um utilizador e, se apropriado, responde com um objeto JSON estruturado a indicar qual função a sua aplicação deve executar e que argumentos usar. A sua aplicação, então, executa essa função.

O processo envolve a sua aplicação a descrever primeiro as suas ferramentas ao modelo. Quando um utilizador faz um pedido, o modelo sugere uma função e os seus argumentos. A sua aplicação, então, executa essa função e, finalmente, você passa o resultado de volta para o modelo para que ele possa formular uma resposta em linguagem natural para o utilizador.

As empresas usam-na comummente para conectar IAs a dados em tempo real, como consultar o estado de encomendas numa base de dados ou detalhes de contas num CRM. Também é usada para acionar ações noutras aplicações, como criar um ticket no Jira, ou para extrair e formatar dados específicos de texto desorganizado.

Os principais desafios incluem orquestrar fluxos de trabalho de múltiplos passos, garantir a fiabilidade com um tratamento de erros robusto e a dificuldade do modelo em encadear múltiplas funções. Existem também sobrecargas significativas de desenvolvimento e manutenção devido à definição manual do esquema JSON e às alterações na API.

Plataformas como o eesel AI fornecem construtores de fluxos de trabalho visuais e ações pré-construídas, abstraindo a codificação complexa, a orquestração e o tratamento de erros. Elas simplificam a definição de ferramentas personalizadas e oferecem modos de simulação para testar os agentes com confiança antes da implementação.

Compartilhe esta postagem

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.