O mundo da IA move-se a uma velocidade estonteante. Num minuto, ouve-se falar de um novo modelo e, no seguinte, já parece notícia velha. Para quem está a tentar construir algo com IA, escolher o modelo de linguagem grande (LLM) certo pode parecer menos uma escolha estratégica e mais uma tentativa de apanhar um comboio em alta velocidade.

Quando precisa de construir algo real, tem de ignorar o hype e descobrir o que realmente funciona. Dois dos maiores pesos-pesados do momento são o Gemini da Google e a Mistral AI. Vêm de lugares muito diferentes e têm ideias distintas sobre como construir IA poderosa. Este guia irá guiá-lo pelo debate Gemini vs. Mistral, comparando o seu desempenho, custo e como se posicionam para o uso empresarial diário.

Gemini vs. Mistral: O que são o Google Gemini e a Mistral AI?

Antes de entrarmos nos pormenores, vamos ter uma noção rápida destes dois concorrentes. Eles não são apenas cérebros de IA intercambiáveis; têm origens e objetivos diferentes.

Google Gemini: A potência

O Gemini é a criação da Google e tem o apoio total de uma das maiores empresas de tecnologia do mundo. É um modelo multimodal, que é apenas uma forma técnica de dizer que foi projetado desde o início para entender texto, código, imagens e vídeo, tudo ao mesmo tempo. Encontrará o Gemini a alimentar ferramentas como o Gemini Advanced e integrado no ecossistema da Google, desde o Workspace até à plataforma de nível empresarial Vertex AI.

A principal atração do Gemini é a sua escala. Tem acesso aos enormes conjuntos de dados da Google e demonstra uma habilidade impressionante em tarefas que exigem raciocínio complexo e de várias etapas. Foi construído para ser uma IA que faz tudo e que consegue lidar com praticamente qualquer coisa que lhe apresente.

Recurso 1: [Captura de ecrã] , O painel do Google Vertex AI a mostrar os modelos Gemini disponíveis para programadores.

Título alt: Painel do Google Vertex AI para comparação Gemini vs Mistral.

Texto alt: Uma captura de ecrã da plataforma Google Vertex AI a mostrar a seleção de modelos Gemini disponíveis, relevante para uma análise Gemini vs Mistral.

Mistral AI: O desafiador

Do outro lado, temos a Mistral AI, uma empresa sediada em Paris que alcançou a fama ao focar-se na eficiência e em modelos de código aberto. Embora ofereçam modelos comerciais pagos, são bem conhecidos pelos seus modelos de "pesos abertos" como o Mistral 7B e o Mixtral. Isto significa que eles disponibilizam os ficheiros centrais do modelo, permitindo que os programadores os ajustem, afinem e executem nos seus próprios servidores.

A Mistral construiu uma sólida reputação entre os programadores por criar modelos que superam largamente a sua categoria. Eles oferecem um desempenho forte sem exigir um armazém cheio de GPUs. As suas respostas são frequentemente descritas como concisas e diretas, o que os torna favoritos para fluxos de trabalho empresariais onde apenas precisa de uma resposta fiável, sem conversas desnecessárias.

Gemini vs. Mistral: Desempenho e capacidades

Então, como é que eles se saem na prática? O "melhor" modelo depende realmente do que está a tentar alcançar. Uma IA que é brilhante a escrever um e-mail de marketing criativo pode não ser a mais adequada para gerar código limpo e pronto para produção.

Gemini vs. Mistral: Raciocínio, precisão e o "fator enrolação"

Passe cinco minutos em qualquer fórum de programadores e notará um tema comum: as pessoas falam muito sobre a vibe das respostas. Os utilizadores dizem frequentemente que os modelos Mistral vão diretos ao assunto. Dão-lhe uma resposta sem os aquecimentos de conversação como "Essa é uma ótima pergunta!" ou outro preenchimento que por vezes pode sobrecarregar as respostas de modelos maiores. Para muitos usos empresariais, este estilo direto e "sem enrolação" parece mais previsível e confiável.

Claro que qualquer modelo pode "alucinar" ou inventar coisas, mas a concisão da Mistral pode fazê-la parecer mais fiável para tarefas diretas. O Gemini, por outro lado, geralmente dá respostas mais detalhadas e abrangentes. Isto pode ser ótimo para brainstorming ou quando precisa de um mergulho profundo num assunto complicado, mas também pode significar que tem de ler mais texto para encontrar a resposta principal.

Também vale a pena lembrar que o desempenho pode mudar drasticamente dependendo da tarefa. Por exemplo, uma comparação direta na precisão de OCR descobriu que o Gemini Flash 2.0 foi consideravelmente mais preciso do que o modelo OCR da Mistral num conjunto variado de documentos. É um bom lembrete de que os benchmarks divulgados pelas próprias empresas nem sempre refletem o desempenho no mundo real. Tem de testar por si mesmo.

Pontos fortes específicos por tarefa

Vejamos como estes modelos se saem em algumas tarefas empresariais comuns.

-

Programação: Ambos os modelos são bastante úteis para gerar código. No entanto, encontrará muitos programadores a inclinarem-se para o Mistral para cenários de produção. O seu output é frequentemente mais limpo e consistente, o que facilita a sua integração em fluxos de trabalho automatizados. A Mistral também tem modelos especializados como o Codestral, que são ajustados especificamente para programação.

-

Escrita e Criatividade: É aqui que o Gemini muitas vezes brilha. O seu estilo conversacional e completo é adequado para escrita criativa, brainstorming de textos de marketing e geração de texto que soa humano. O tom padrão da Mistral tende a ser mais profissional e factual, o que é perfeito para relatórios ou resumos, mas talvez não para a sua próxima grande campanha publicitária.

-

Análise de Documentos e Dados: O Gemini tem uma enorme vantagem aqui devido à sua gigantesca janela de contexto. A janela de contexto é basicamente a quantidade de informação que o modelo consegue manter na sua memória de curto prazo de uma só vez. Com o Gemini 1.5 Pro capaz de lidar com até 2 milhões de tokens (cerca de 1,5 milhões de palavras), ele consegue processar documentos incrivelmente longos, bases de código inteiras ou horas de vídeo. Os modelos da Mistral, como o Mistral Large com a sua janela de 32.000 tokens, são muito mais limitados aqui.

Recurso 1: [Infográfico] , Uma comparação visual das janelas de contexto do Gemini 1.5 Pro e do Mistral Large.

Título alt: Comparação da janela de contexto Gemini vs Mistral.

Texto alt: Um infográfico a comparar visualmente a enorme janela de contexto de 2 milhões de tokens do Gemini 1.5 Pro com a janela de 32.000 tokens do Mistral Large no debate Gemini vs Mistral.

Uma tabela de comparação direta

Aqui está um resumo rápido das suas diferenças qualitativas.

| Característica | Google Gemini | Mistral AI | Vencedor |

|---|---|---|---|

| Estilo de Resposta | Mais conversacional e abrangente, pode ser longo. | Conciso, direto e ao ponto; menos "enrolação". | Depende do Caso de Uso |

| Programação | Fortes capacidades de programação de uso geral. | Altamente conceituado para geração de código limpo e estável; modelos especializados. | Mistral (para produção) |

| Tarefas Criativas | Frequentemente preferido para brainstorming e escrita semelhante à humana. | Tom mais factual e profissional por defeito. | Gemini |

| Análise de Documentos | Excelente devido à enorme janela de contexto (até 2M de tokens). | Limitado por uma janela de contexto menor (ex: 32K tokens). | Gemini |

| Confiança Percebida | Por vezes pode parecer excessivamente cauteloso ou recusar questões políticas. | A frontalidade é frequentemente percebida como mais estável e fiável para negócios. | Mistral (para negócios) |

Gemini vs. Mistral: Especificações técnicas e funcionalidades

Para quem está realmente a construir com estes modelos, os detalhes técnicos são onde a porca torce o rabo. Veja como eles se comparam.

Famílias de modelos e variantes

Tanto a Google como a Mistral oferecem um menu de modelos projetados para diferentes necessidades, permitindo equilibrar desempenho, velocidade e custo.

-

Gemini: As duas principais opções disponíveis através da sua API são o Gemini 1.5 Pro, o seu modelo poderoso e de topo, e o Gemini 1.5 Flash, que é construído para velocidade e eficiência em situações de alto volume.

-

Mistral: A sua linha tem mais níveis:

- Modelos de pesos abertos: Mistral 7B e Mixtral 8x7B são as escolhas preferidas para programadores que querem alojar os modelos por conta própria ou afiná-los com os seus próprios dados.

- Modelos comerciais: Mistral Small, Mistral Medium e Mistral Large 2 são os seus modelos otimizados que pode aceder via API, oferecendo uma boa combinação de preço e poder.

- Modelos especializados: Eles também criam modelos específicos como o Codestral, que é focado a laser na geração e completação de código.

Recurso 1: [Fluxo de trabalho] , Um fluxograma mermaid a mostrar as diferentes famílias de modelos para o Gemini e o Mistral.

Título alt: Árvore de decisão para escolher um modelo na comparação Gemini vs Mistral.

Texto alt: Um diagrama de fluxograma a ilustrar as opções de modelo disponíveis da Google Gemini (Pro, Flash) e Mistral AI (Pesos abertos, Comercial, Especializado) para ajudar os utilizadores a decidir na escolha entre Gemini e Mistral.

Gemini vs. Mistral: Janela de contexto e limite de conhecimento

A janela de contexto é uma das maiores diferenças técnicas entre eles. Como mencionámos, a capacidade do Gemini 1.5 Pro de processar até 2 milhões de tokens é um grande trunfo para quem trabalha com grandes volumes de informação. A janela de 32.000 tokens do Mistral Large ainda é muito útil, mas simplesmente não está no mesmo patamar.

Outra coisa a ter em mente é o limite de conhecimento, que é a data de "validade" dos dados de treino do modelo. Alguns dos modelos da Mistral têm um limite ligeiramente mais antigo, mas isto está a tornar-se menos problemático. Ambas as empresas oferecem agora modelos que podem realizar pesquisas na web em tempo real para lhe fornecer a informação mais recente.

API e ecossistemas de programadores

Ambas as plataformas proporcionam uma experiência bastante fluida para os programadores. A Vertex AI da Google é uma plataforma massiva, pronta para empresas, com uma enorme caixa de ferramentas, muitas integrações e documentação detalhada para construir com o Gemini.

A API da Mistral, que eles chamam de "la Plateforme", recebe muitos elogios por ser simples e fácil de trabalhar, o que se encaixa na sua atitude de programador em primeiro lugar. Foi projetada para ser simples de começar, para que possa estar a funcionar rapidamente.

Gemini vs. Mistral: Preços e aplicação empresarial

No final do dia, a decisão muitas vezes resume-se a dinheiro e valor de negócio. Vamos ver como os seus preços se comparam e como pode realmente usar estes modelos no seu negócio sem contratar uma equipa de engenharia inteiramente nova.

Uma análise dos modelos de preços

Ambas as empresas usam principalmente um modelo de pagamento por token para as suas APIs. É cobrado pela quantidade de texto que envia para o modelo (input) e pela quantidade de texto que o modelo devolve (output).

- Gemini (via Vertex AI): O preço da Google é bastante competitivo, especialmente para o seu rápido modelo Flash.

Fonte: Página de Preços do Google Cloud

| Modelo | Preço de Input / 1M tokens | Preço de Output / 1M tokens |

|---|---|---|

| Gemini 1.5 Pro | $3.50 | $10.50 |

| Gemini 1.5 Flash | $0.35 | $1.05 |

- Mistral: Os preços da API da Mistral também são competitivos, e os seus modelos menores e eficientes são particularmente económicos.

Fonte: Website da Mistral AI

| Modelo | Preço de Input / 1M tokens | Preço de Output / 1M tokens |

|---|---|---|

| Mistral Large 2 | $3.00 | $9.00 |

| Mistral Small | $0.50 | $1.50 |

| Codestral | $1.00 | $3.00 |

A Mistral também tem uma subscrição "Le Chat Pro" por cerca de 15 dólares por mês, destinada a indivíduos e pequenas equipas que queiram usar o seu chatbot sem mexer na API.

Aplicar modelos de IA no seu negócio: A maneira fácil

Escolher um modelo e pagar pelo acesso à API é apenas o primeiro passo. O verdadeiro trabalho é transformar esse poder bruto numa ferramenta de negócio útil, como um agente de apoio ao cliente que realmente ajuda as pessoas. Isto geralmente envolve uma configuração muito complicada:

-

Tem de conectar o modelo a todo o conhecimento da sua empresa, que pode estar espalhado por um help desk, wikis internos, Google Docs e conversas antigas.

-

Precisa de construir um motor de fluxo de trabalho que saiba quando escalar um ticket, como o etiquetar corretamente, ou quando fazer coisas personalizadas como procurar o estado de uma encomenda.

-

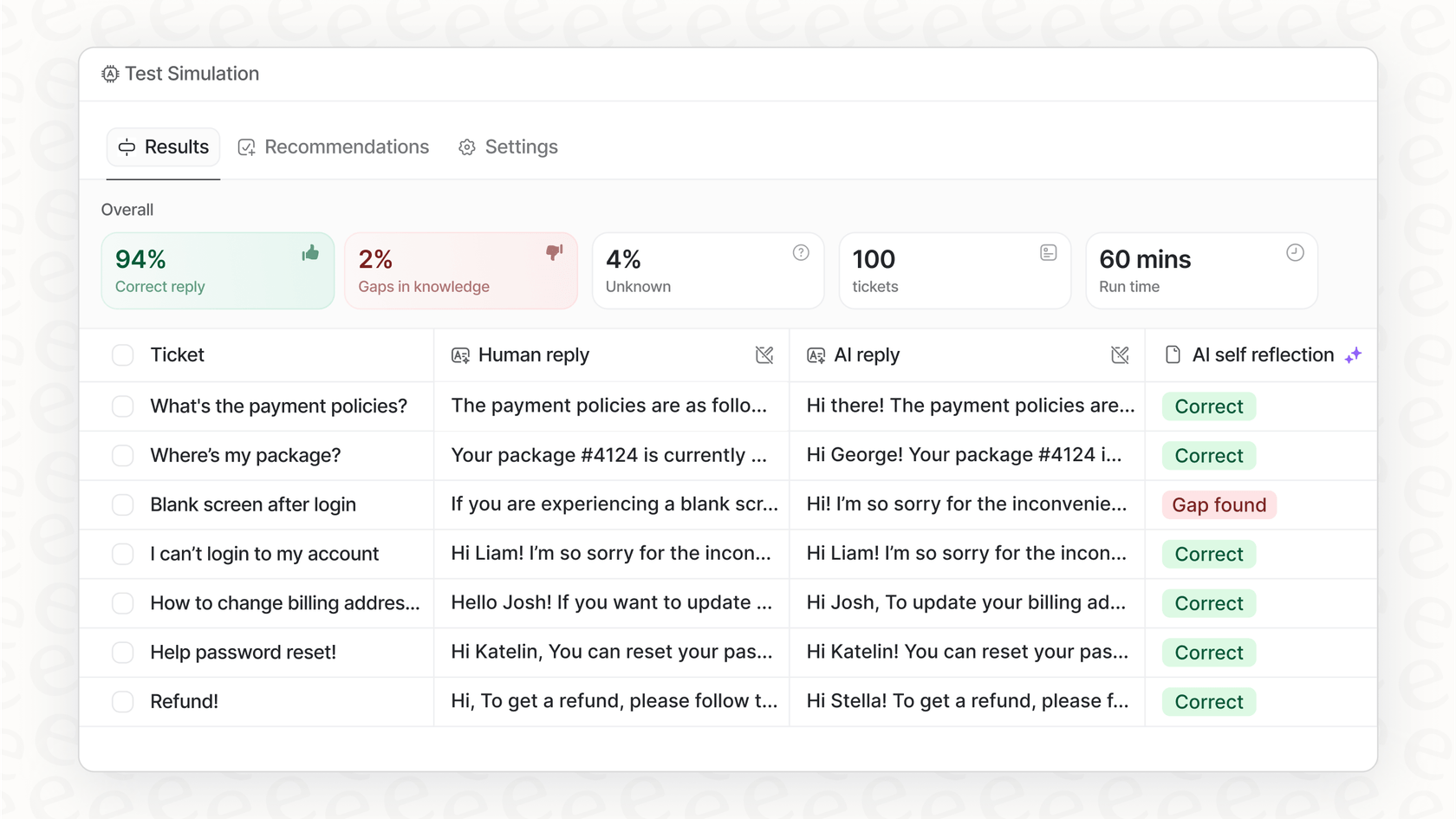

Precisa de uma forma segura de testar tudo nos seus próprios dados antes de o deixar falar com um cliente real.

Isso é um trabalho enorme, e é exatamente o problema que uma plataforma como a eesel AI foi construída para resolver. Em vez de passar meses a construir toda esta infraestrutura do zero, a eesel AI oferece-lhe uma solução self-service que faz o trabalho pesado por si. Ela atua como uma camada inteligente sobre modelos poderosos da Google e da Mistral, tornando-os úteis para o seu negócio desde o primeiro momento.

- Unificação instantânea de conhecimento: A eesel AI conecta-se a todas as suas ferramentas com integrações de um clique para plataformas como Zendesk e Confluence. Ela aprende com o seu centro de ajuda, os seus documentos e até com os seus tickets de suporte passados para se familiarizar com o seu negócio desde o primeiro dia.

Fazer a escolha certa para as suas necessidades

Então, qual é o veredito final no confronto Gemini vs. Mistral? Honestamente, não há um único vencedor. Tudo se resume ao que precisa de fazer. Aqui está uma cábula rápida:

-

Escolha o Gemini se a sua principal tarefa é analisar documentos ou conjuntos de dados enormes, se já está integrado no ecossistema Google Cloud, ou se precisa de escrita criativa de alta qualidade e funcionalidades multimodais.

-

Escolha o Mistral se se preocupa mais com a eficiência, o custo e a flexibilidade de ter modelos de código aberto que pode alojar por si mesmo. É também provavelmente a melhor escolha se precisa de uma IA que lhe dê respostas concisas e prontas para o negócio, sem a enrolação extra.

O melhor modelo é sempre aquele que se adapta ao trabalho que precisa de fazer. Mas lembre-se, o modelo em si é apenas uma peça do puzzle. A verdadeira magia acontece quando o integra e utiliza dentro dos seus fluxos de trabalho para resolver problemas de negócio reais.

Pronto para transformar o poder destes modelos de IA de topo em resultados de negócio reais? A eesel AI oferece-lhe a plataforma completa para construir, simular e lançar agentes de IA para apoio ao cliente e conhecimento interno, tudo em poucos cliques. Comece hoje o seu teste gratuito.

Este vídeo oferece um útil teste frente a frente para ver como o Gemini e a Mistral AI se comportam em várias tarefas.

Perguntas frequentes

Os modelos Mistral são frequentemente preferidos pela sua frontalidade e respostas "sem enrolação", tornando-os ideais para fluxos de trabalho empresariais que necessitam de respostas fiáveis e concisas, sem preenchimento de conversação extra.

O Gemini 1.5 Pro tem uma vantagem clara aqui devido à sua enorme janela de contexto de 2 milhões de tokens, permitindo-lhe ingerir e analisar uma quantidade de informação muito superior à das ofertas atuais da Mistral.

Os modelos mais pequenos e eficientes da Mistral oferecem preços competitivos para tarefas de alto volume. O modelo 1.5 Flash do Gemini também oferece uma opção muito económica para velocidade e eficiência.

A Mistral AI é bem conhecida pelos seus modelos de pesos abertos como o Mistral 7B e o Mixtral, que proporcionam aos programadores a flexibilidade de hospedar, modificar e afinar os modelos nos seus próprios servidores.

O Gemini brilha frequentemente em tarefas criativas, oferecendo um estilo mais conversacional e completo, adequado para textos de marketing, brainstorming e geração de texto que soa matizado e humano.

Embora ambos ofereçam APIs, a integração eficaz de modelos como Gemini ou Mistral requer frequentemente um desenvolvimento significativo. Plataformas como a eesel AI simplificam este processo ao fornecer uma camada inteligente para unificar conhecimento e lançar agentes de IA rapidamente, independentemente do modelo subjacente.

Compartilhe esta postagem

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.