Vamos ser honestos, a IA generativa parece um pouco mágica. Você digita um comando e, alguns segundos depois, tem um e-mail, um pedaço de código ou até mesmo um site inteiro. É tudo muito fluido. Mas essa sensação de "sem esforço" esconde um grande segredo: a máquina por trás da cortina é incrivelmente faminta por energia, e seu apetite está crescendo loucamente.

Com o lançamento de modelos mais novos como o GPT-5 no horizonte, os pesquisadores estão começando a soar o alarme sobre o quanto de energia essas coisas consomem. Isso não é apenas um problema ambiental abstrato, está rapidamente se tornando uma questão real de negócios. Os custos ocultos de operar esses modelos massivos, que fazem de tudo, estão ficando grandes demais para serem ignorados.

Neste artigo, vamos revelar o "o quê" e o "porquê" das demandas energéticas da IA. Vamos analisar o verdadeiro impacto ambiental e mostrar uma maneira mais inteligente para sua empresa adotar IA que seja sustentável e muito mais eficaz.

Qual é o uso de energia do ChatGPT?

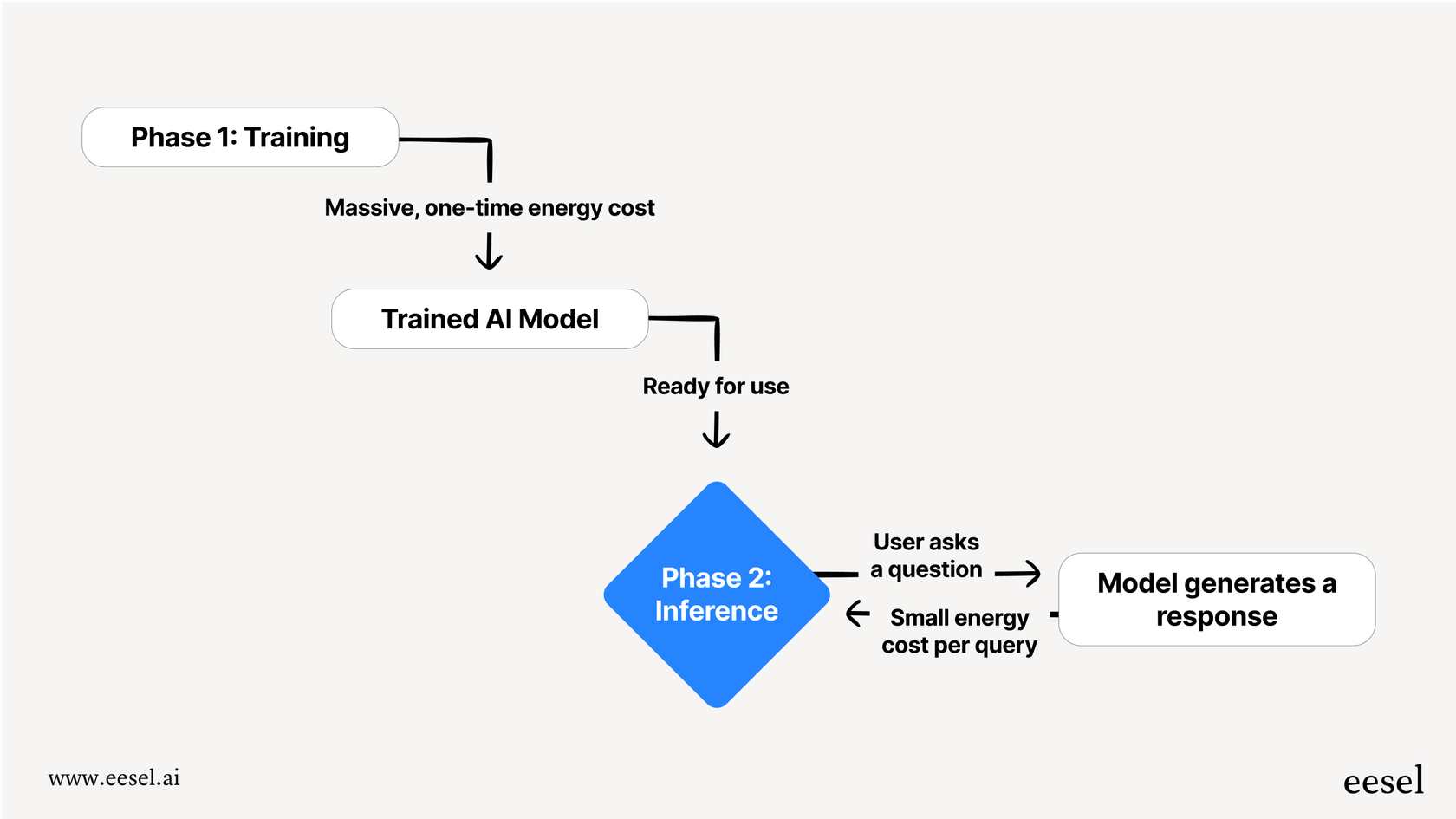

Quando falamos de uma IA consumindo energia, não é apenas uma coisa. O processo é dividido em duas fases principais: treinamento e inferência. A maneira mais fácil de pensar nisso é como uma IA indo para a escola e depois uma IA realmente indo trabalhar.

Treinamento Esta é a fase de "escolaridade" da IA, e é incrivelmente intensa. Envolve alimentar um modelo com uma quantidade colossal de dados, muitas vezes uma grande fatia da internet, para que ele possa aprender padrões, linguagem e conceitos. Isso requer uma quantidade massiva de poder computacional funcionando 24/7 por semanas ou até meses. É um enorme custo energético único que precisa ser pago para cada nova versão de um modelo.

Inferência Inferência é o que acontece quando você realmente usa a IA, como perguntar algo ao ChatGPT. O modelo usa o que aprendeu durante o treinamento para "inferir" a melhor resposta. Embora uma única consulta use uma fração minúscula da energia necessária para o treinamento, é o volume absoluto que é impressionante. Para uma ferramenta que lida com bilhões de solicitações por dia, o total de energia gasto em inferência ao longo de sua vida útil pode facilmente ultrapassar o custo inicial de treinamento.

Um olhar mais atento ao surpreendente uso de energia do ChatGPT

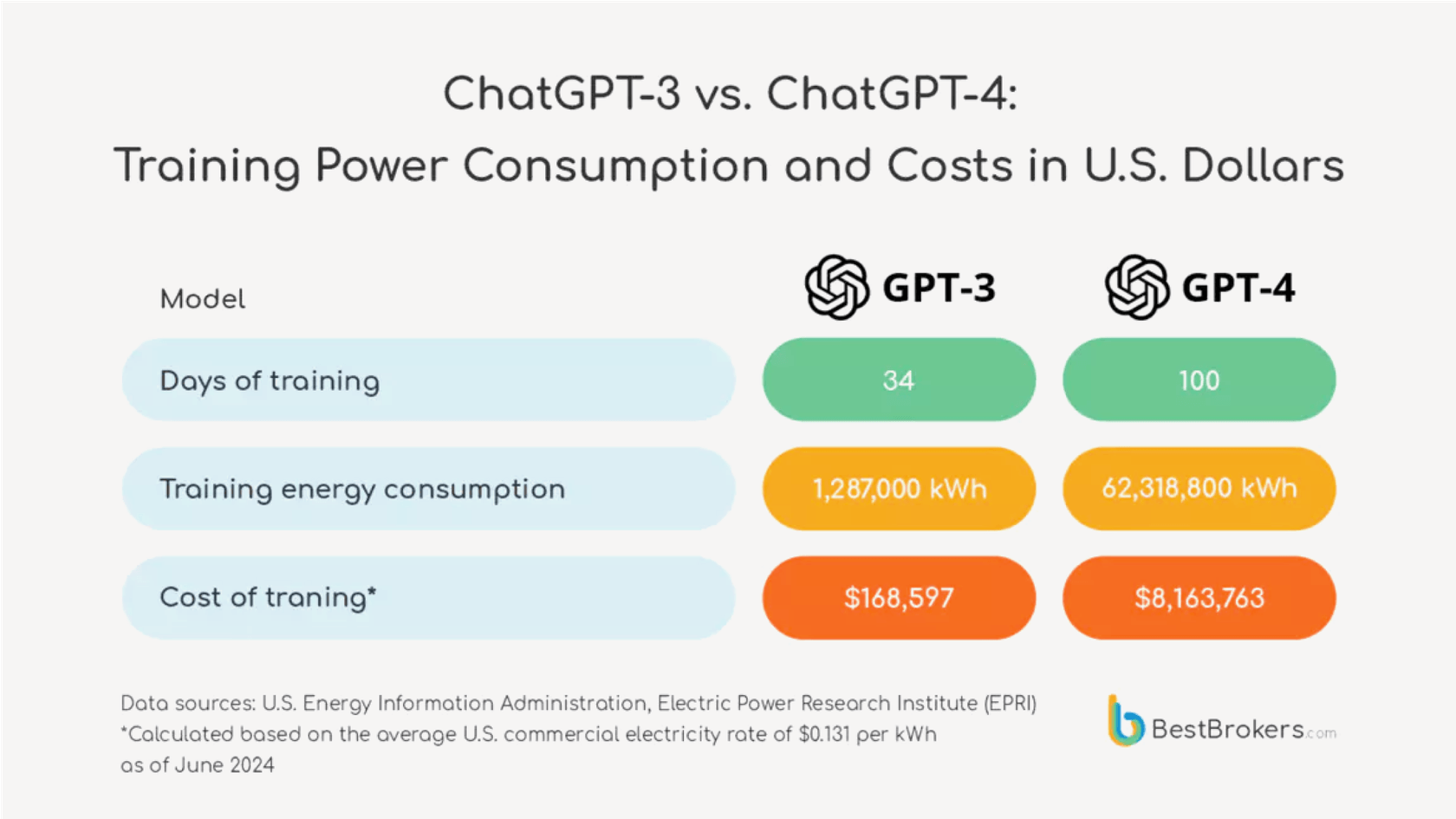

O salto na demanda de energia de uma geração de modelo para a próxima não é um pequeno passo, é um salto gigante.

Vamos colocar alguns números reais nisso. Em meados de 2023, pedir a um modelo como o ChatGPT uma receita simples poderia ter usado cerca de 2 watt-horas de eletricidade. Agora, avançando para o próximo GPT-5. Pesquisadores do laboratório de IA da Universidade de Rhode Island estimam que o novo modelo poderia usar uma média de 18 watt-horas para uma resposta de comprimento médio, e às vezes até 40 watt-horas.

Uma comparação visual lado a lado.

- À esquerda, sob o título "GPT-4 (2023)", um ícone de uma pequena lâmpada com o texto "2 Watt-horas por consulta" ao lado. Abaixo disso, o texto diz: "Suficiente para alimentar uma lâmpada por 2 minutos."

- À direita, sob o título "GPT-5 (Estimado)", um ícone de uma lâmpada muito maior e mais brilhante com o texto "18 Watt-horas por consulta" ao lado. Abaixo disso, o texto diz: "Suficiente para alimentar a mesma lâmpada por 18 minutos."

- Uma grande seta apontando da esquerda para a direita mostra um "Aumento de 9x" no consumo de energia. O design geral deve ser limpo e fácil de ler, enfatizando o aumento drástico na demanda de energia.

Esse é um aumento enorme. Mostra que cada nova geração desses modelos que fazem de tudo está se tornando exponencialmente mais faminta por energia.

Para dar um pouco de perspectiva, 18 watt-horas é suficiente para alimentar uma lâmpada incandescente antiga por 18 minutos. Agora, pense no quadro maior. O ChatGPT supostamente lida com cerca de 2,5 bilhões de solicitações por dia. Se todas essas fossem tratadas pelo GPT-5, o consumo total diário de energia poderia ser suficiente para alimentar 1,5 milhão de lares nos EUA. De repente, aquela resposta de IA "sem esforço" não parece tão gratuita, não é?

| Versão do Modelo | Energia Média por Consulta (Watt-horas) | Equivalente no Mundo Real |

|---|---|---|

| Era GPT-4 (2023) | ~2 Wh | Alimentar uma lâmpada incandescente por 2 minutos |

| GPT-4o | ~0.34 Wh (figura de Altman) | Uma lâmpada de alta eficiência por alguns minutos |

| GPT-5 (Estimado) | ~18 Wh | Alimentar uma lâmpada incandescente por 18 minutos |

Segredos e custos ocultos do uso de energia do ChatGPT

Tentar descobrir o verdadeiro custo ambiental da IA é um negócio surpreendentemente obscuro, principalmente porque as empresas que constroem esses modelos são incrivelmente secretas sobre quantos recursos elas usam.

Onde estão os dados oficiais sobre o uso de energia do ChatGPT?

A OpenAI e seus concorrentes não divulgaram números oficiais de energia específicos do modelo desde que o GPT-3 foi lançado em 2020. O CEO da OpenAI, Sam Altman, compartilhou em seu blog que uma consulta usa cerca de 0,34 watt-horas, mas esses números vieram sem qualquer contexto sobre qual modelo ele estava falando ou qualquer dado para respaldá-los, tornando-os praticamente impossíveis de verificar.

Essa falta de transparência é um grande problema. Como um especialista em clima apontou, "É incrível que você possa comprar um carro e saber quantas milhas por galão ele consome, mas usamos todas essas ferramentas de IA todos os dias e não temos absolutamente nenhuma métrica de eficiência." Sem dados claros, é difícil para qualquer empresa tomar uma decisão informada sobre o verdadeiro custo das ferramentas que estão usando.

Uso de energia do ChatGPT: É sobre mais do que apenas eletricidade

O preço ambiental vai muito além da conta de eletricidade. Existem alguns outros custos ocultos que não são falados o suficiente.

- É um trabalho sedento: Os centros de dados ficam incrivelmente quentes, e resfriá-los requer uma quantidade chocante de água fresca. Apenas treinar o GPT-3 foi estimado ter usado mais de 700.000 litros de água. À medida que os modelos ficam maiores, sua sede por água cresce, colocando uma verdadeira pressão sobre os recursos locais.

- Hardware e lixo eletrônico: A IA generativa funciona em processadores especializados e famintos por energia (GPUs). Fazer esses chips tem sua própria pegada ambiental, desde a mineração de matérias-primas até a energia usada para construí-los. A corrida constante por hardware mais poderoso também significa que chips mais antigos são descartados mais rapidamente, aumentando um enorme problema de lixo eletrônico.

- Feito para ser substituído: O mundo da IA se move em velocidade relâmpago. Novos modelos são lançados a cada poucos meses, tornando os antigos obsoletos quase da noite para o dia. Isso significa que a enorme quantidade de energia que foi gasta para treinar um modelo que é substituído tão rapidamente é essencialmente desperdiçada.

Um caminho mais inteligente: Eficiência além do alto uso de energia do ChatGPT

A estratégia atual de apenas construir modelos de IA maiores e maiores de propósito geral é uma abordagem de força bruta. Não é sustentável, e para a maioria das empresas, nem é a melhor ferramenta para o trabalho.

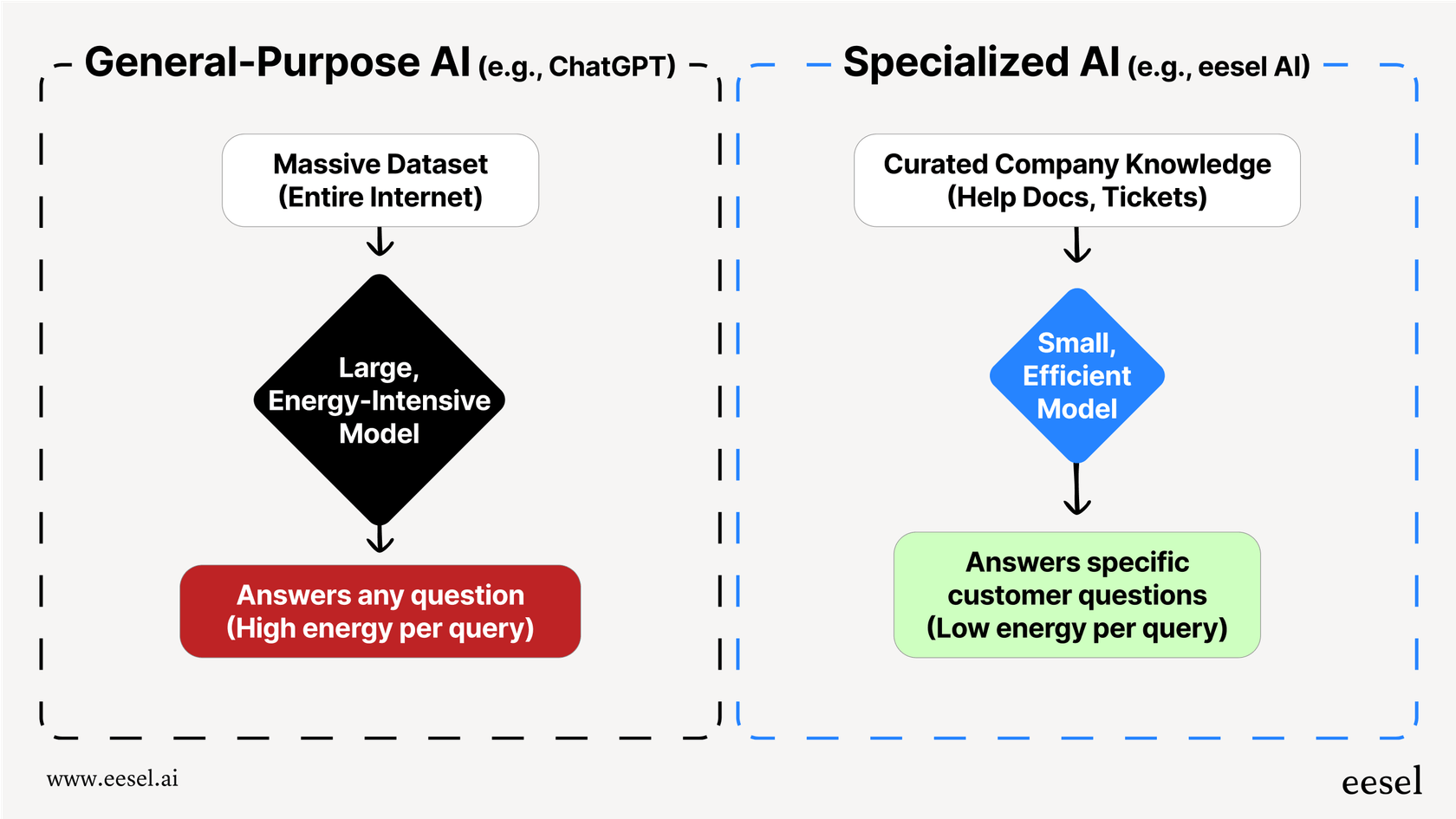

O problema é que modelos como o ChatGPT são projetados para saber um pouco sobre tudo, desde sonetos de Shakespeare até física quântica. Para fazer isso, eles precisam ser enormes, o que os torna incrivelmente intensivos em energia. Mas se você só precisa responder a uma pergunta de um cliente sobre sua política de envio, usar uma IA geral massiva é um completo exagero. É como usar um supercomputador para fazer matemática básica, simplesmente não é eficiente.

Há uma maneira muito mais inteligente de fazer isso: usar modelos de IA menores e especializados que são treinados apenas nos dados de que precisam para fazer seu trabalho. Essa abordagem é muito mais eficiente por design. Treinar uma IA em um conjunto selecionado de artigos de ajuda da sua empresa, tickets de suporte passados e documentos de produtos consome uma fração minúscula da energia necessária para treiná-la em toda a internet.

O resultado não é apenas uma IA mais sustentável, é uma melhor. Uma IA especializada dá respostas mais precisas, consistentes e perfeitamente alinhadas com a marca porque não está se distraindo com informações irrelevantes de sites públicos.

Essa é a ideia por trás do que fazemos na eesel AI. Em vez de pedir que você substitua seus sistemas existentes por uma única IA faminta por energia, a eesel se conecta diretamente ao seu help desk e fontes de conhecimento. Ela aprende com seu conteúdo nas ferramentas que você já usa, como Zendesk, Confluence e Google Docs, para criar um agente de suporte de IA eficiente e preciso. Isso permite que você evite o enorme consumo de energia e as dores de cabeça operacionais de um modelo de propósito geral, enquanto oferece respostas melhores e mais relevantes aos seus clientes.

Sua estratégia de IA e o impacto do uso de energia do ChatGPT

O consumo de energia de grandes modelos de IA não é mais apenas um tópico para pesquisadores, é uma questão real de negócios. Com cada nova geração, modelos como o GPT-5 estão se tornando exponencialmente mais famintos por energia, e seu verdadeiro custo está escondido atrás de um muro de segredo e inclui muito mais do que apenas eletricidade.

Para a maioria das necessidades empresariais, especialmente em atendimento ao cliente ou suporte interno, usar uma IA gigante de propósito geral não é a escolha mais eficaz ou responsável. É ineficiente, caro e muitas vezes dá respostas menos precisas para seu caso de uso específico.

Uma abordagem especializada e integrada é uma alternativa muito mais sustentável, econômica e precisa. Ao treinar uma IA no seu próprio conhecimento, você pode construir um sistema que é tanto poderoso quanto eficiente.

Se você está pronto para construir um sistema de suporte de IA poderoso e eficiente sem a enorme conta de energia, veja como a eesel AI funciona com suas ferramentas existentes para fornecer respostas precisas e alinhadas com a marca. Inicie um teste gratuito ou agende uma demonstração hoje.

Perguntas frequentes

A alta demanda de energia sinaliza ineficiência. Usar um modelo massivo e de propósito geral para uma tarefa específica de negócios é como usar um supercomputador para cálculos simples, é exagero e muitas vezes leva a resultados menos precisos e mais lentos para suas necessidades específicas.

É muito mais do que apenas eletricidade. A pegada ambiental total inclui um consumo massivo de água para resfriar os data centers, os recursos necessários para fabricar hardware especializado e um problema crescente de lixo eletrônico à medida que a tecnologia mais antiga é rapidamente substituída.

Sim, o aumento é significativo. Estimativas sugerem que modelos mais novos podem ser exponencialmente mais consumidores de energia, com algumas consultas usando quase dez vezes a eletricidade das versões anteriores. Essa tendência de "maior é melhor" não é sustentável.

As grandes empresas de IA são muito secretas sobre seu consumo de recursos, tratando isso como um segredo comercial. Essa falta de transparência dificulta para empresas e consumidores entenderem os verdadeiros custos ambientais e financeiros das ferramentas que usam.

Absolutamente. Um modelo especializado é treinado apenas com os dados relevantes da sua empresa, o que requer uma fração mínima de energia. Isso resulta em um sistema muito mais eficiente que não só é sustentável, mas também fornece respostas mais precisas e relevantes para o seu caso de uso específico.

Embora o treinamento seja incrivelmente intensivo em energia, o volume absoluto de consultas diárias (inferência) pode facilmente superar o custo inicial de treinamento ao longo da vida útil do modelo. Para uma ferramenta com bilhões de usuários diários, a energia acumulada gasta na inferência torna-se o fator dominante.

Compartilhe esta postagem

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.