チャットボットに質問を打ち込むのは、今ではごく当たり前のことになりましたよね?しかし、AIにおける次の大きな波は、タイピングではなく「話す」ことです。私たちは今、リアルタイムで対話型の音声AIが私たちの話を理解し、必要に応じて割り込み、まるで人間のように応答してくれる時代の幕開けにいます。これは、テクノロジーとの関わり方をはるかに自然なものにすることでしょう。

この進化を後押ししているのが、OpenAI Realtime APIのようなツールです。このAPIは、開発者が流れるような音声中心の体験を構築するための基盤を提供します。しかし、ここが重要な点です。テクノロジー自体は素晴らしいものですが、それを洗練された実用的なビジネスツールに変えるのは全く別の話です。それには通常、高度な技術的ノウハウ、多くの開発時間、そしてかなりの忍耐力が必要です。

それでは、OpenAI Realtime APIの全貌を明らかにし、その機能と、それを使って何かを構築するために何が必要なのかを率直に見ていきましょう。

OpenAI Realtime APIとは?

OpenAI Realtime APIの核心は、開発者が低遅延の音声対音声(speech-to-speech)の会話が可能なアプリケーションを作成するためのツールであるということです。ChatGPTの高度な音声モードを使ったことがあるなら、まさにあの種の対話を実現するエンジンがこれであり、今では誰でも利用できるようになりました。

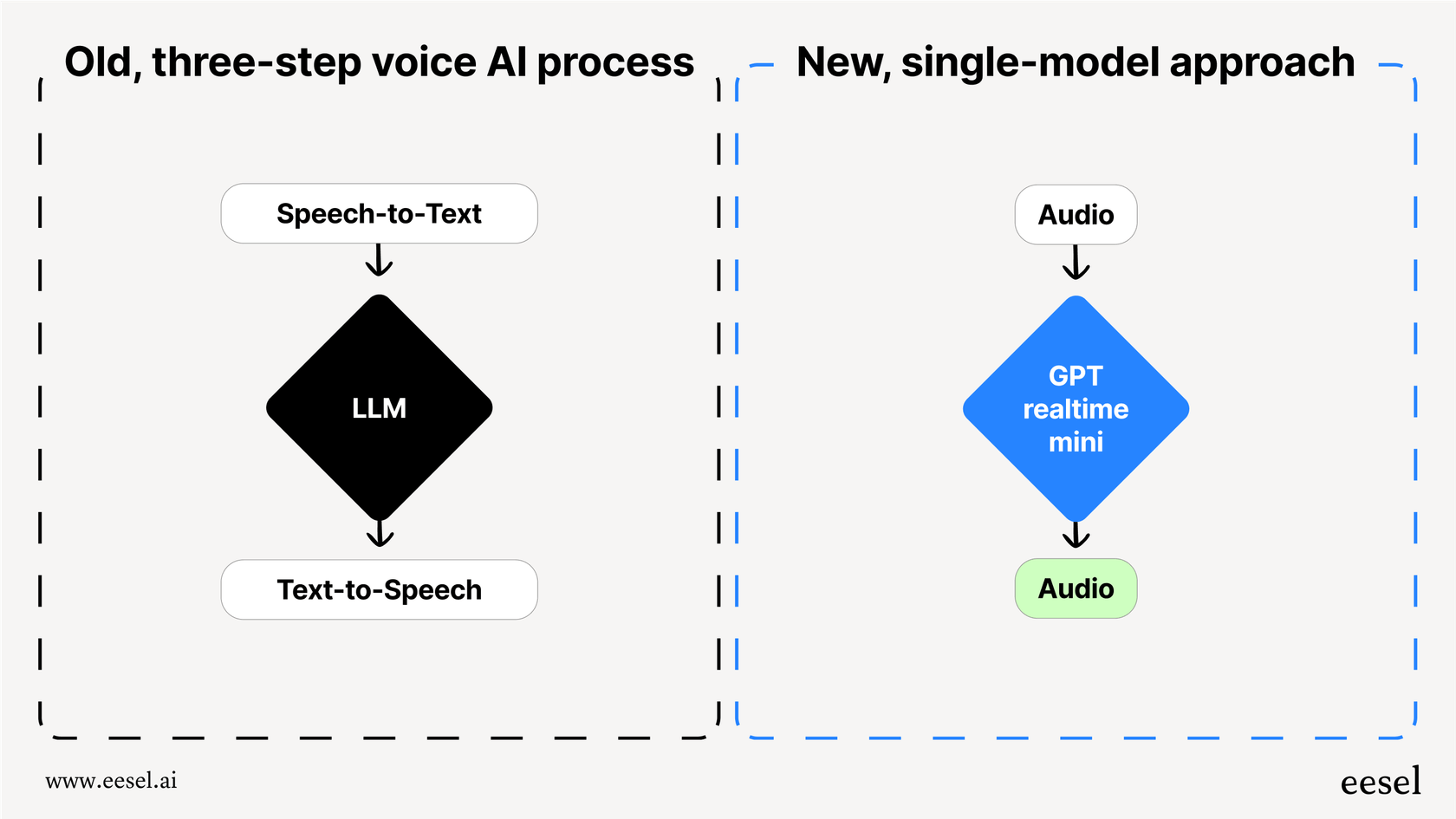

このAPIが登場する前は、音声エージェントの構築は、面倒で複数のステップを要する頭の痛い作業でした。複数の異なるAPIを連携させる必要があったのです。

-

音声認識(STT): まず、WhisperのようなAPIを使ってユーザーの話し言葉をテキストに変換します。

-

大規模言語モデル(LLM): 次に、そのテキストをGPT-4のようなAPIに送り、返答内容を生成します。

-

音声合成(TTS): 最後に、別のAPIを使ってテキストの返答を音声に変換します。

この一連の流れは機能はしましたが、遅かったのです。各ステップでの受け渡しが少しずつ遅延を生み、会話がぎこちなく不自然に感じられる気まずいラグを生み出していました。さらに重要なことに、これにより人間の話し言葉のニュアンスがすべて失われてしまいました。声のトーン、感情、強調といった要素は、音声がテキストになった瞬間に失われ、平坦でロボットのような対話しかできませんでした。

Realtime APIは、「gpt-realtime」のような単一の統合モデルを使用することで、この状況を根本から変えます。このモデルは、最初から最後まで音声を直接処理します。音声を聴き、直接音声の応答を生成するのです。これにより遅延が大幅に削減され、音声の豊かさが保たれるため、より速く、表現力豊かで、真に対話的なAIへの道が開かれます。

OpenAI Realtime APIの仕組み

このAPIは単に音声だけのものではありません。低遅延でマルチモーダルなコミュニケーションのために設計されています。これは、AIが一度にさまざまな種類の情報を処理できるということを格好良く言ったもので、これにより構築するエージェントはより賢く、周囲の状況をよりよく認識できるようになります。

OpenAI Realtime APIのマルチモーダル機能

Realtime APIは、GPT-4oのような「ネイティブにマルチモーダル」なモデル上で動作します。こう考えてみてください。AIは単にテキストを読むように教えられたのではありません。音声、画像、テキストを組み合わせて理解し処理するように、最初からトレーニングされているのです。これにより、単純な音声のみのエージェントでは到底実現不可能な、はるかにダイナミックな対話が可能になります。

接続方法

そのリアルタイムの速度を実現するためには、APIへの常時接続を維持する必要があります。OpenAIはいくつかの接続方法を提供しており、どれを選択するかは、何を構築しているのか、そしてチームの技術スタックに大きく依存します。

| 接続方法 | 最適なユースケース | 技術的オーバーヘッド |

|---|---|---|

| WebRTC | 絶対的な低遅延を必要とするブラウザおよびクライアントサイドのアプリ。 | 高(ピア接続とSDPオファー/アンサーの管理が必要)。 |

| WebSocket | 低遅延が依然として優先されるサーバーサイドのアプリ。 | 中(WebRTCよりはシンプルだが、永続的な接続の管理は必要)。 |

| SIP | VoIP電話システム(コールセンターなど)との統合。 | 高(テレフォニープロトコルとインフラに関する知識が必要)。 |

適切な接続方法を選んで設定するだけでも、簡単な作業ではありません。それにはかなりの技術的な計画と開発努力が必要で、カスタム音声エージェントを構築しようとするチームが最初にぶつかるハードルの1つになることがよくあります。

OpenAI Realtime APIの主な機能

そのコア設計に加えて、Realtime APIには、開発者にとって強力なツールキットとなる一連の機能が含まれています。これらは、賢くダイナミックな音声エージェントを作成するために使用する要素です。

音声対音声の対話

これがメインの機能です。「gpt-realtime」のようなモデルは音声を直接扱うため、笑い声、皮肉、感情の変化など、テキストベースのシステムでは常に見逃されてしまう微妙な手がかりを拾うことができます。そして、より自然で表現力豊かな応答を生成できます。APIの一般公開に伴い、OpenAIはMarinとCedarという2つの新しい音声を追加しました。これらはこのAPI限定で利用でき、驚くほどリアルに聞こえます。

発話区間検出(VAD)

発話区間検出は、AIとの会話を単なるトランザクションではなく、本物のチャットのように感じさせる機能です。これは、誰かが話し始めたり、話し終えたりしたことをAIに知らせる機能です。自然な会話のターン(順番交代)には不可欠です。ユーザーが会話に割り込んで話題を変えたい場合、ただ話し始めればよいのです。エージェントはそれを認識し、話を続けたり気まずい間を待ったりするのではなく、状況に適応します。

Function callingとツール

音声エージェントは、実際に実行できてこそ役立ちます。Realtime APIはFunction callingをサポートしており、これによりエージェントは外部のツールやデータソースに接続して情報を取得したり、タスクを完了したりすることができます。例えば、サポートエージェントがFunction callingを使って、システム内の顧客の注文状況を調べたり、その場で返金処理を行ったりできます。これは非常に強力ですが、これらのツール連携を一つひとつ構築、接続、維持するのは開発者であるあなた次第です。

画像とテキストの入力

APIはマルチモーダルであるため、ユーザーは音声だけに縛られません。会話に他の情報を追加できます。例えば、顧客がサポートエージェントと通話中にエラーメッセージのスクリーンショットを送り、「これは何ですか?」と尋ねることができます。エージェントは画像を見て文脈を理解し、役立つ口頭での回答を返すことができます。

OpenAI Realtime APIの一般的なユースケースと限界

低遅延音声AIの可能性は非常に大きいですが、いくつかのユースケースが急速に人気を集めています。また、これらのアプリケーションをゼロから構築する際に直面するであろう障害について、現実的に考えることも重要です。

ユースケース

-

カスタマーサポートエージェント: 電話の着信応対、よくある質問への対応、より複雑な問題の適切な担当者への転送。

-

パーソナルアシスタント: スケジュール管理、リマインダー設定、ハンズフリーでの情報取得の支援。

-

言語学習アプリ: ユーザーが新しい言語を話す練習をするためのリアルな会話パートナーの作成。

-

教育ツール: 複雑なトピックを口頭で説明し、学生の質問に答えることができるインタラクティブなチューターの構築。

自社開発(DIY)アプローチの限界

生のAPIを使って音声エージェントを構築するのは魅力的に聞こえるかもしれませんが、それは単にエンドポイントを呼び出すだけでは済まない、大規模なエンジニアリングプロジェクトです。

-

開発の負担が非常に大きい: APIを接続するだけでなく、アプリケーション全体を構築することになります。これには、インフラの管理、会話の状態の処理、ロジックの設計、そしてシステム全体の信頼性と拡張性の確保が含まれます。

-

ビジネスワークフローが含まれていない: APIはエンジンを提供しますが、車は自分で作らなければなりません。チケットのトリアージ、適切なチームへのエスカレーション、やり取りの追跡、パフォーマンスのレポートなど、ビジネス固有のロジックはすべてゼロから構築する必要があります。

-

分析やテスト機能が組み込まれていない: 構築したエージェントが実際に優れているかどうかをどうやって知るのでしょうか?専用のツールがなければ、過去の会話でエージェントをテストしたり、その精度を測定したり、ナレッジベースのどこが不足しているかを把握したりする簡単な方法はありません。

ここで、古典的な「自社開発か購入か(build vs. buy)」という議論が生まれます。開発に数ヶ月も待つことなく本番環境で使えるAIサポートソリューションを必要とするチームにとって、eesel AIのようなプラットフォームは、はるかに直接的な解決策を提供します。ノーコードのワークフローエンジン、ワンクリックのヘルプデスク連携、強力なシミュレーションツールを提供し、数ヶ月ではなく数分で本番稼働できます。

OpenAI Realtime APIの価格

このAPIは、テキストトークンとは異なる方法で計算されるオーディオトークンに基づいて価格設定されています。モデルに送信する音声(入力)と、モデルが返信する音声(出力)の両方に対して課金されます。各会話の長さや複雑さによってコストが変動するため、コストの予測が難しくなることがあります。

プレビュー版より20%安価な「gpt-realtime」モデル(標準ティア)の価格の概要は以下の通りです。

| トークンタイプ | 100万トークンあたりの価格 |

|---|---|

| 音声入力 | $32.00 |

| キャッシュされた音声入力 | $0.40 |

| 音声出力 | $64.00 |

(価格情報はOpenAIの価格ページに基づいています。)

トークンベースの価格設定は、実験段階の開発者にとっては柔軟性がありますが、大量のサポートチャネルを持つ企業にとっては、予測不可能な請求額につながる可能性があります。ある忙しい月には驚くほど高額な請求書が届く可能性があり、効果的な予算編成が難しくなります。

OpenAI Realtime APIのよりシンプルな代替案:eesel AIによるAIサポートエージェント

OpenAI Realtime APIを直接使って構築することは、全く新しいアプリケーションをゼロから作成する開発者にとって素晴らしい選択肢です。しかし、カスタマーサポートの自動化やITサービス管理(ITSM)の改善、社内Q&Aの強化を目指す企業にとっては、専用プラットフォームを利用する方が、ほとんどの場合、より速く、コスト効率が高く、導入後すぐに強力な機能を利用できる選択肢となります。

eesel AIは、Realtime APIの背後にあるような高度なモデルの力を活用した完全なAIサポートプラットフォームですが、連携やワークフロー管理のために一行のコードも書く必要がありません。

自社開発(DIY)アプローチの課題に、eesel AIは次のように対応します。

-

数分で本番稼働: WebSocketやインフラと数ヶ月格闘する代わりに、Zendesk、Freshdesk、[REDACTED]などのヘルプデスクやナレッジソースをワンクリックで接続できます。AIエージェントは、過去のチケット、ヘルプセンターの記事、社内ドキュメントからすぐに学習を開始できます。

-

自信を持ってテスト: eesel AIのシミュレーションモードを使えば、安全な環境で何千もの実際の過去のチケットを使ってエージェントをテストできます。エージェントがどのように応答したかを確認し、その挙動を調整し、実際の顧客と対話する前に解決率やコスト削減に関する正確な予測を得ることができます。

-

完全なコントロールとカスタマイズ: シンプルなプロンプトエディターとノーコードのワークフローエンジンにより、AIがどのチケットを処理し、どのようなアクションを取れるかを正確に決定できます。複雑な問題をエスカレーションしたり、チケットを自動的にタグ付けしたり、外部APIを呼び出して注文情報を取得したりするルールを設定できます。

-

予測可能な価格設定: eesel AIのプランは、月間のAIインタラクションの固定数に基づいており、解決ごとの追加料金は発生しません。これにより、変動の大きいトークンベースモデルに伴う当て推量をなくし、予算をシンプルかつ透明に保つことができます。

OpenAI Realtime APIに関する最終的な考察

OpenAI Realtime APIは、実に素晴らしいテクノロジーです。人間と機械の対話のギャップを埋め、音声中心のAIが完全に自然に感じられる未来への道を切り開いています。開発者が素晴らしいものを構築するための、信じられないほど強力なエンジンを提供します。

しかし、APIキーを手に入れてから、信頼性が高く本番環境で使えるビジネスツールを完成させるまでの道のりは長く、技術的な課題に満ちています。ほとんどの企業、特にカスタマーサービスやITサポートに重点を置く企業にとっては、その特定の目的のために構築されたプラットフォームの方が、より迅速かつ確実に価値を提供します。基盤となるAIのすべての力を手に入れながら、それはまさにあなたが必要とする業務のために設計された一連のツールに包まれています。

専用に構築されたAIサポートエージェントがもたらす効果を体験してみませんか?eesel AIの無料トライアルを開始して、最前線のサポートを数分で自動化しましょう。

よくある質問

OpenAI Realtime APIは、開発者が低遅延の音声対音声(speech-to-speech)会話をサポートするアプリケーションを構築できるように設計されています。単一の統合モデルを利用して音声を直接処理し、流れるような自然な音声中心の体験を可能にします。

従来の複数ステップのアプローチとは異なり、OpenAI Realtime APIは最初から最後まで音声を処理するため、遅延が大幅に削減され、声のトーンや感情といった微妙なニュアンスが保たれます。この統合された処理により、はるかに自然で表現力豊かなAIとの対話が実現します。

リアルタイムの速度を確保するため、OpenAI Realtime APIは複数の接続方法をサポートしています。これには、ブラウザベースのアプリケーション向けのWebRTC、サーバーサイドでの使用向けのWebSocket、VoIP電話システムとの統合向けのSIPが含まれます。

はい、OpenAI Realtime APIはFunction callingをサポートしており、これによりAIエージェントは外部のツールやデータソースに接続できます。特定のタスクや情報検索を可能にするための連携機能の構築、接続、維持は開発者の責任となります。

OpenAI Realtime APIは、入力と出力の両方のオーディオトークンに基づいて価格設定されているため、コストの予測が難しい場合があります。使用量の多い企業にとっては、このトークンベースのモデルは変動が大きく、月々の請求額が高額になる可能性があります。

OpenAI Realtime APIは、GPT-4oのようなネイティブにマルチモーダルなモデルで動作するため、音声、画像、テキストを組み合わせて処理できます。これにより、ユーザーはスクリーンショットなどの視覚的なコンテキストを口頭での質問と合わせて提供し、より豊かで包括的な対話を行うことができます。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.