独自ドキュメントをOpenAIのモデルに読み込ませたい、とお考えですか?これは非常によくある目標です。例えば、ヘルプドキュメントの内容を正確に把握したカスタマーサポートボットを構築したり、企業のプライベートデータでモデルをファインチューニングしたりする場合などです。OpenAI Files APIは、それを実現するための重要な鍵となります。

しかし、ここには落とし穴があります。APIを直接扱うのは、水を流すためだけに大量の配管工事をするような感覚になりがちです。コード中心のプロセスで、多くのステップ、処理の待ち時間、そしてトリッキーなファイル管理が伴います。

このガイドでは、基本的なAPI呼び出しから開発者が直面しがちな一般的な問題まで、そのすべてを解説します。自力でファイルをアップロード、管理、使用する方法をカバーし、その後、単に目的を達成したい企業にとってのはるかにシンプルな方法を探ります。

OpenAI Files APIとは?

OpenAI Files APIは、OpenAIのサーバー上でファイルをアップロード、管理、削除できるツール群です。AIアプリケーションで使いたいドキュメント専用のクラウドドライブのようなものだと考えてください。

ファイルをアップロードする際には、「目的(purpose)」を指定する必要があります。これは、そのファイルをどのように使用する予定かをOpenAIに伝えるためのものです。主な目的は以下の通りです。

-

"assistants": Assistants APIにドキュメントを提供するためのものです。以前は「retrieval」と呼ばれていた「file_search」ツールと共によく使われ、アシスタントがファイル内の情報を検索して質問に答えられるようにします。

-

"fine-tune": カスタムのファインチューニングモデルを作成するために、トレーニングデータを提供する際に使用します。

-

"vision": ご想像の通り、GPT-4oのようなモデルが分析するための画像をアップロードする際に使用します。

-

"batch": Batch APIに入力ファイルを供給するためのものです。リアルタイムで待つことなく、大規模なジョブを実行するのに便利です。

基本的に、Files APIは、公開されているインターネットの情報だけでなく、より多くの知識を持つAIを構築するための第一歩です。

OpenAI Files APIの使い方(開発者向けのヘビーな方法)

APIを直接利用すると完全なコントロールが可能になりますが、すべてを管理するためのコードを自分で書く責任も伴います。いくつかの一般的なシナリオで、それがどのようなものか見ていきましょう。

プログラムによるファイルのアップロードと管理

APIの中核は、いくつかの主要なコマンドに集約されます。始める前に、使用する言語のOpenAI SDKが必要です。Pythonの場合は、「pip install openai」を実行するだけです。

では、実際にコードを書いてみましょう。基本的なワークフローは次のようになります。

- ファイルのアップロード: まず、コンピュータからファイルを開き、その目的をOpenAIに伝えてアップロードします。

from openai import OpenAI

client = OpenAI()

# "assistants"目的でファイルをアップロード

file = client.files.create(

file=open("my-knowledge-base.pdf", "rb"),

purpose="assistants"

)

print(file.id)

- ファイルの一覧表示: アップロードしたすべてのファイルを確認したい場合は、組織内の全ファイルのリストを取得できます。

all_files = client.files.list()

print(all_files)

- ファイルの確認: ファイルをアップロードした後、そのメタデータを確認してステータスを見ることができます。ステータスは「uploaded」、「processed」、または「error」のいずれかです。

file_info = client.files.retrieve("YOUR_FILE_ID")

print(file_info.status)

- ファイルの削除: ファイルが不要になった場合は、削除してストレージを整理できます。

client.files.delete("YOUR_FILE_ID")

これらのステップは、1つか2つのファイルであれば簡単に見えます。しかし、数百、数千のファイルがある場合はどうでしょうか?APIには一括操作機能がないため、すべてのファイルをループ処理する独自のスクリプトを構築する必要があります。このあたりから、開発者主導のアプローチが本当に面倒な作業に感じられ始めます。

Assistants APIとファイル検索での利用

ここからは、多段階の複雑な手順になるので、しっかりとついてきてください。アシスタントがアップロードしたファイルを使って質問に答えられるようにするには、Vector Stores(ベクトルストア)というものを扱う必要があります。ベクトルストアとは、基本的には高速検索に最適化された、処理済みでインデックス化されたファイルのコレクションです。

ゼロから構築する必要がある典型的なワークフローは以下の通りです。

-

Files APIを使ってファイルをアップロードする。

-

ベクトルストアを作成する。

-

アップロードしたファイルを新しいベクトルストアに追加する。

-

待つ。そして、ファイルが完全に処理されるまでステータスを確認し続ける(「ポーリング」する)。

-

アシスタントを作成し、「file_search」ツールを有効にする。

-

作成したベクトルストアをアシスタントにアタッチする。

-

会話を開始するためにスレッドを作成する。

-

ユーザーの質問をスレッドに追加する。

-

アシスタントに質問を処理させるために「Run」を作成する。

-

Runのステータスが最終的に「completed」になるまでポーリングする。

-

そして最後に、スレッドからアシスタントの回答を取得できる。

ポーリングの多さにお気づきでしょうか?ファイルをベクトルストアに追加した後、すぐに使えるわけではありません。アプリケーションはAPIに対して「まだ終わらない?」と繰り返し尋ね続ける必要があります。これにより複雑さが増し、安定して動作させるためには堅牢なエラーハンドリングと状態管理を構築しなければならなくなります。

専任のAIエンジニアがいないチームにとって、このシステム全体を構築・維持するのはかなり大きな負担です。開発者コミュニティでもこれはよくある不満点で、「自分のドキュメントから質問に答える」という単純に聞こえることを実現するのに、どれだけ多くの作業が必要になるかに驚く人が多いです。

OpenAI Files APIの価格と制限

開発を始める前に、コストと制限について知っておくのが賢明です。

OpenAI Files APIの利用料金は?

Files APIを使用する場合、モデルのトークン料金だけでなく、ファイルが占有するストレージに対しても課金されます。

-

ストレージコスト: OpenAIは、ファイルとそのインデックス化されたバージョンをベクトルストアに保存するための料金を請求します。現在のレートは**1日あたり1GBにつき0.10ドル**ですが、最初の1GBは無料です。

-

トークンコスト: アシスタントが「file_search」を使って回答を見つける際、ドキュメントの関連部分がモデルのコンテキストウィンドウに挿入されます。これによりプロンプトトークンが消費され、その分が請求されます。

この2部構成の価格設定は、保存するデータ量とアシスタントがそれをどのくらいの頻度で使用するかによって月々の請求額を予測するのを難しくする可能性があります。

よくある課題と制限

生のAPIは強力ですが、開発の速度を低下させる可能性のあるいくつかの癖があります。

-

一括処理ができない: APIは複数のファイルの同時アップロードや削除をサポートしていません。一つずつループ処理するスクリプトを書く必要があり、これは非常に時間がかかることがあります。

-

ビジュアルインターフェースがない: ダッシュボードにログインしてアップロードしたすべてのファイルを確認したり、ステータスをチェックしたり、どのアシスタントがそれらを使用しているかを把握したりすることはできません。これにより、管理とデバッグが非常に面倒になります。

-

待って…確認して…さらに待つ必要がある: 前述の通り、ファイル処理は非同期です。コードはAPIに常に問い合わせてファイルの準備ができたかを確認する必要があり、これがロジックを複雑にし、遅延を引き起こす可能性があります。

-

ナレッジマネジメントが煩雑になる: 特定のファイルを特定のアシスタントに接続するには、「Vector Store」IDと「tool_resources」オブジェクトをやりくりする必要があります。「この3つのドキュメントだけを使ってこの質問に答えて」と簡単に指示する方法は、慎重なコーディングなしには存在しません。

これらの制限は、最初は単純に見えたプロジェクトが、大規模なエンジニアリング作業に膨れ上がることが多いことを意味します。実際のアプリケーション開発よりも、基本的なファイル管理ツールの構築に多くの時間を費やすことになってしまいます。

もっと簡単な方法:統合プラットフォームでナレッジを管理する

OpenAI Files APIですべてを自作するのは柔軟性がありますが、膨大な時間の浪費です。ほとんどの企業、特にカスタマーサポートやIT部門にとっては、そうした複雑さをすべて隠してくれる既製のプラットフォームの方がはるかに適しています。

ここでeesel AIのようなソリューションが役立ちます。これは、APIコードを一行も書くことなく、企業の既存ナレッジをAIエージェントに接続するために構築されています。

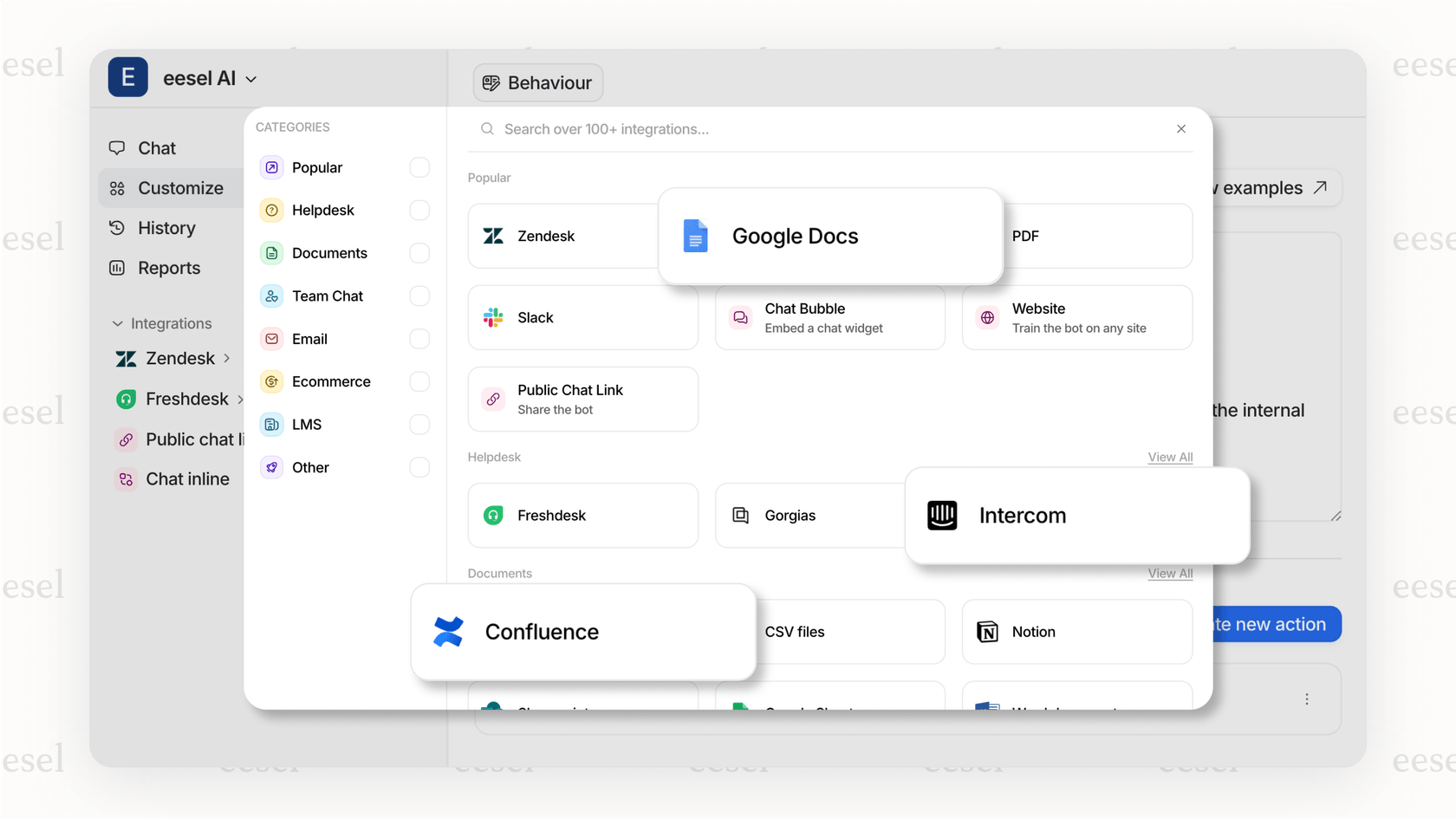

ワンクリック連携で数分で稼働開始

ファイルを一つずつアップロードするためにスクリプトと格闘する代わりに、eesel AIは普段お使いのツールとの簡単な連携機能を提供します。ヘルプデスク(ZendeskやFreshdeskなど)、ナレッジベース(ConfluenceやNotionなど)、共有ドキュメント(Google Docsなど)を数クリックで接続できます。eesel AIが裏側でファイルの同期、処理、インデックス作成をすべて行います。

手作業なしですべてのナレッジを統合

OpenAI Files APIでは、すべてのドキュメントを個別にアップロードし、整理する必要があります。eesel AIを使えば、ナレッジは最初から統合されています。チームの過去のサポートチケットから学習し、ブランドのトーンや顧客の共通の問題を把握することさえできます。つまり、何千ものファイルを手動で準備してアップロードすることなく、AIエージェントは初日からあなたのビジネス特有のコンテキストでトレーニングされるのです。

リリース前に自信を持ってテスト

生のAPIで構築する上で最も不安なことの一つは、実際の質問に対してAIがどのように機能するかわからないことです。eesel AIのシミュレーションモードは、AIエージェントを過去何千ものサポートチケットでテストすることで、その問題を解決します。AIがどのように応答したかを確認でき、解決可能なチケット数や節約できる金額について確かな予測を得ることができます。まずは特定のカテゴリのチケットだけを自動化し、そこから拡大していくことも可能で、常に完全なコントロールを保てます。

最終的な考察

OpenAI Files APIは、独自のデータを理解するAIを作成するためのパズルの基本的なピースです。完全にカスタムなものを構築する必要がある開発者にとっては、望む限りのパワーとコントロールを提供します。

しかし、ほとんどの企業にとっての目標は、APIオーケストレーションの専門家になることではありません。繰り返し発生する質問からサポートチームを解放するなど、問題を解決することです。ファイルの管理、ステータスのポーリングの複雑さ、そしてユーザーインターフェースの欠如は、直接APIを利用する方法を困難な道にしています。

eesel AIのようなプラットフォームは、その面倒な作業をすべて代行し、ナレッジを接続してサポートを自動化するための非常にシンプルでセルフサービスな方法を提供します。インフラ構築に何ヶ月も費やす代わりに、数分でソリューションを稼働させ、本当に重要なこと、つまり顧客を満足させることに集中できます。

エンジニアリングの手間をかけずに、会社のナレッジを活用する準備はできましたか?eesel AIを無料で始める。

よくある質問

OpenAI Files APIは、OpenAIのサーバー上で直接ファイルをアップロード、管理、削除できるように設計されています。これらのファイルは、アシスタント機能、モデルのファインチューニング、大規模なバッチ処理など、様々なAIアプリケーションのデータソースとして機能します。

AIアシスタント用にドキュメントをアップロードするには、client.files.createコマンドを使用し、purpose="assistants"と指定します。アップロード後、Vector Storeを作成し、そこにファイルを追加し、そのVector Storeをアシスタントにアタッチして「file_search」機能を利用可能にする必要があります。

いいえ、OpenAI Files APIはネイティブではファイルの一括アップロードや削除操作をサポートしていません。開発者は、ファイルを一つずつループ処理して管理するためのカスタムスクリプトを作成する必要があり、大規模なデータセットの場合は時間がかかることがあります。

OpenAI Files APIの利用コストには、ストレージとトークン使用量の両方が含まれます。ファイルストレージに対して1日あたり1GBにつき0.10ドルが課金され(最初の1GBは無料)、アシスタントが「file_search」を使ってドキュメントにアクセスする際に消費されるプロンプトトークンに対しても課金されます。

一般的な制限としては、一括操作機能の欠如、ビジュアル管理インターフェースの不在、そして常にポーリングを必要とするファイル処理の非同期性が挙げられます。さらに、特定のファイルをアシスタントにリンクさせるナレッジ管理も複雑になりがちです。

現在、OpenAI Files API経由でアップロードされたファイルを管理するための直接的なビジュアルインターフェースやダッシュボードはOpenAIから提供されていません。ファイルの管理、アップロード、一覧表示、ステータス確認、削除はすべてAPI呼び出しを通じてプログラム的に行う必要があります。

はい、eesel AIのような統合プラットフォームは、直接的なAPIの複雑さを抽象化することで、プロセスを大幅に簡素化します。既存のナレッジソースとのワンクリック連携、ファイル同期とインデックス作成の自動処理、そして手動でのAPIコーディングなしでテストやデプロイを行うためのツールを提供します。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.