正直に言うと、生成AIは少し魔法のように感じます。プロンプトを入力すると、数秒後にはメールやコードの一部、さらにはウェブサイト全体が手に入ります。それはシームレスです。しかし、その「手間いらず」の感覚はかなり大きな秘密を隠しています。カーテンの裏にある機械は非常に電力を消費し、その食欲は急速に増しています。

GPT-5のような新しいモデルのリリースが間近に迫る中、研究者たちはこれらがどれほどのエネルギーを消費するかについて警鐘を鳴らし始めています。これは単なる抽象的な環境問題ではなく、急速に現実のビジネス問題になりつつあります。これらの巨大で万能なモデルを運用する隠れたコストは無視できないほど大きくなっています。

この記事では、AIのエネルギー需要の「何」と「なぜ」を明らかにします。真の環境への影響を見て、持続可能でより効果的なAIの導入方法をビジネスに示します。

ChatGPTのエネルギー使用とは?

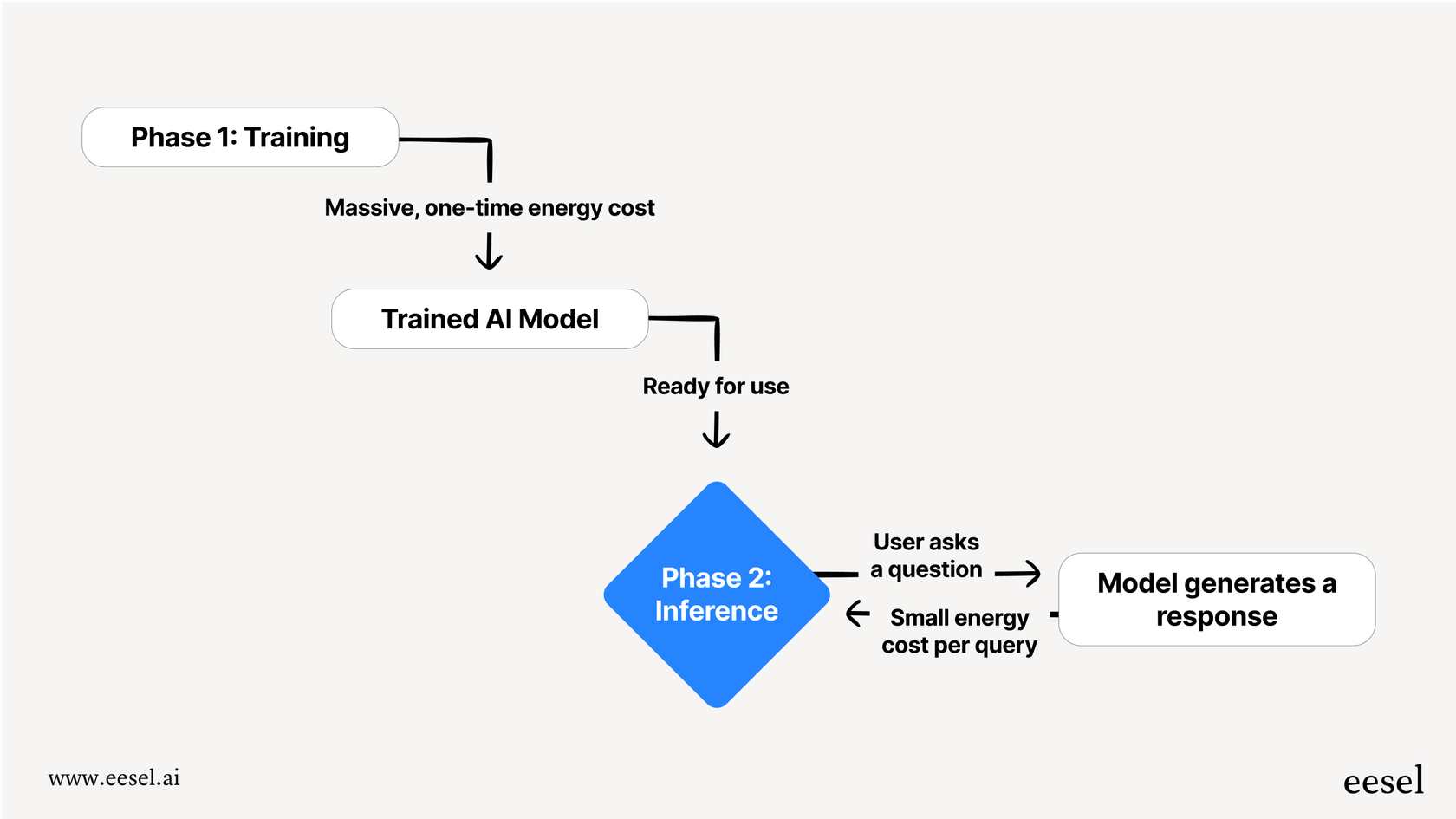

AIがエネルギーを大量に消費するという話をするとき、それは単なる一つのことではありません。このプロセスは、トレーニングと推論の2つの主要なフェーズに分かれています。最も簡単に考える方法は、AIが学校に行くのと、実際に仕事をするのと同じようなものです。

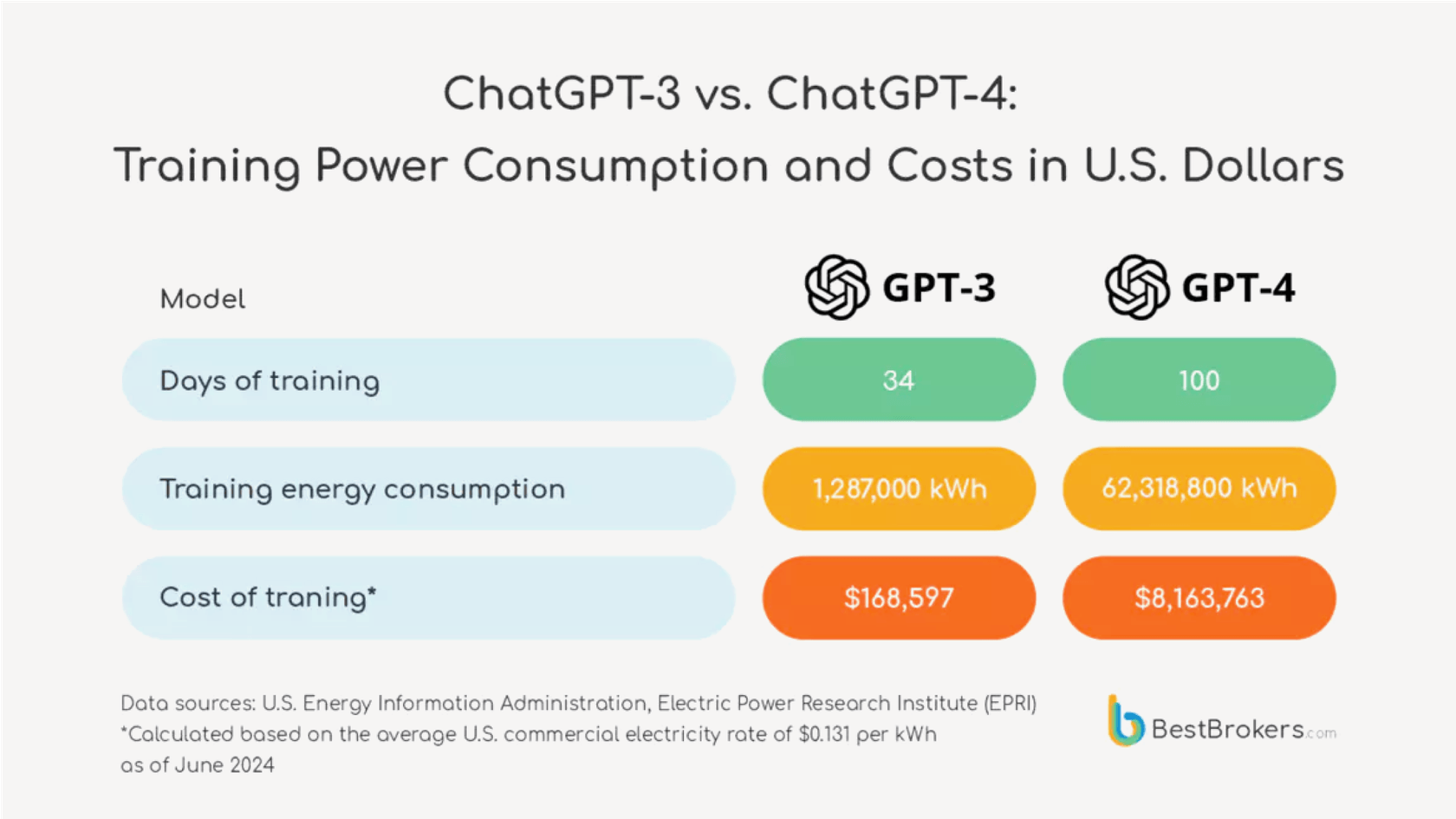

トレーニング これはAIの「学習」フェーズであり、非常に集中的です。モデルに膨大な量のデータ、しばしばインターネットの大部分を与えて、パターン、言語、概念を学習させます。これは、24時間365日、数週間または数か月にわたって膨大な計算能力を必要とします。これは、新しいバージョンのモデルごとに支払わなければならない一度きりの巨大なエネルギーコストです。

推論 推論は、実際にAIを使用する際に起こることです。例えば、ChatGPTに質問をするような場合です。モデルはトレーニング中に学んだことを使って、最適な答えを「推論」します。単一のクエリはトレーニングに必要なエネルギーのごく一部を使用しますが、その量が驚異的です。1日に数十億のリクエストを処理するツールにとって、その生涯にわたる推論に費やされる総エネルギーは、初期のトレーニングコストを簡単に超えることができます。

驚くべきChatGPTのエネルギー使用を詳しく見る

モデルの世代が進むごとに電力需要の増加は小さなステップアップではなく、巨大な飛躍です。

これに実際の数字を当てはめてみましょう。2023年中頃、ChatGPTのようなモデルにシンプルなレシピを尋ねると、約2ワット時の電力を使用していたかもしれません。今、GPT-5が登場する未来を見てみましょう。ロードアイランド大学のAIラボの研究者たちは、新しいモデルが中程度の長さの応答に平均18ワット時を使用する可能性があると推定しており、時には40ワット時にも達することがあります。

サイドバイサイドのビジュアル比較。

- 左側には「GPT-4 (2023)」の見出しの下に、小さな電球のアイコンとその横に「1クエリあたり2ワット時」と書かれています。その下には「電球を2分間点灯させるのに十分」と書かれています。

- 右側には「GPT-5 (推定)」の見出しの下に、はるかに大きく明るい電球のアイコンとその横に「1クエリあたり18ワット時」と書かれています。その下には「同じ電球を18分間点灯させるのに十分」と書かれています。

- 左から右に向かって大きな矢印が「9倍の増加」を示しています。全体のデザインは、電力需要の劇的な増加を強調し、読みやすくクリーンであるべきです。

これは大きな増加です。これにより、これらの万能モデルの各新世代が指数関数的に電力を消費するようになっていることが示されています。

少し視点を変えてみましょう。18ワット時は、古いタイプの白熱電球を18分間点灯させるのに十分です。今、より大きな絵を考えてみてください。ChatGPTは1日に約25億件のリクエストを処理していると報告されています。もしこれらすべてがGPT-5で処理された場合、1日の総エネルギー消費は150万の米国の家庭を賄うのに十分かもしれません。突然、その「手間いらず」のAI応答はそれほど無料ではないように思えませんか?

| モデルバージョン | クエリあたりの平均エネルギー(ワット時) | 現実世界の相当量 |

|---|---|---|

| GPT-4時代 (2023) | ~2 Wh | 白熱電球を2分間点灯 |

| GPT-4o | ~0.34 Wh (Altmanの数値) | 高効率電球を数分間点灯 |

| GPT-5 (推定) | ~18 Wh | 白熱電球を18分間点灯 |

ChatGPTのエネルギー使用の秘密と隠れたコスト

AIの真の環境コストを把握するのは驚くほど不透明なビジネスです。主に、これらのモデルを構築している企業が使用するリソースについて非常に秘密主義であるためです。

ChatGPTのエネルギー使用に関する公式データはどこにあるのか?

OpenAIやその競合他社は、GPT-3が2020年に登場して以来、公式のモデル固有のエネルギー数値を公開していません。OpenAIのCEOであるSam Altmanは、自身のブログでクエリが約0.34ワット時を使用すると述べましたが、どのモデルについて話しているのか、またそれを裏付けるデータがないため、ほとんど検証不可能です。

この透明性の欠如は大きな問題です。ある気候専門家が指摘したように、"車を買うときにはガロンあたりの走行距離を知ることができるのに、毎日使っているこれらのAIツールには全く効率指標がないのは驚きです。" 明確なデータがなければ、企業が使用しているツールの真のコストについて情報に基づいた決定を下すのは難しいです。

ChatGPTのエネルギー使用:電力だけの問題ではない

環境コストは電気代を超えています。あまり語られない隠れたコストがいくつかあります。

- 水を大量に消費する: データセンターは非常に熱くなり、それを冷やすためには驚くほど多くの新鮮な水が必要です。GPT-3のトレーニングだけで70万リットル以上の水を使用したと推定されています。モデルが大きくなるにつれて、水の需要も増え、地域の資源に大きな負担をかけます。

- ハードウェアと電子廃棄物: 生成AIは特殊で電力を大量に消費するプロセッサ(GPU)で動作します。これらのチップを作ること自体が環境に影響を与えます。原材料の採掘から製造に使用されるエネルギーまで。より強力なハードウェアを求める競争は、古いチップがより早く廃棄されることを意味し、巨大な電子廃棄物問題を引き起こします。

- 置き換えられるために作られている: AIの世界は非常に速く進化します。新しいモデルは数か月ごとにリリースされ、古いものはほぼ一夜にして時代遅れになります。これにより、すぐに置き換えられるモデルのトレーニングに費やされた膨大なエネルギーが事実上無駄になります。

より賢い未来への道:高いChatGPTエネルギー使用を超えた効率

現在の戦略は、単により大きな汎用AIモデルを構築するという力任せのアプローチです。これは持続可能ではなく、ほとんどのビジネスにとって最適なツールでもありません。

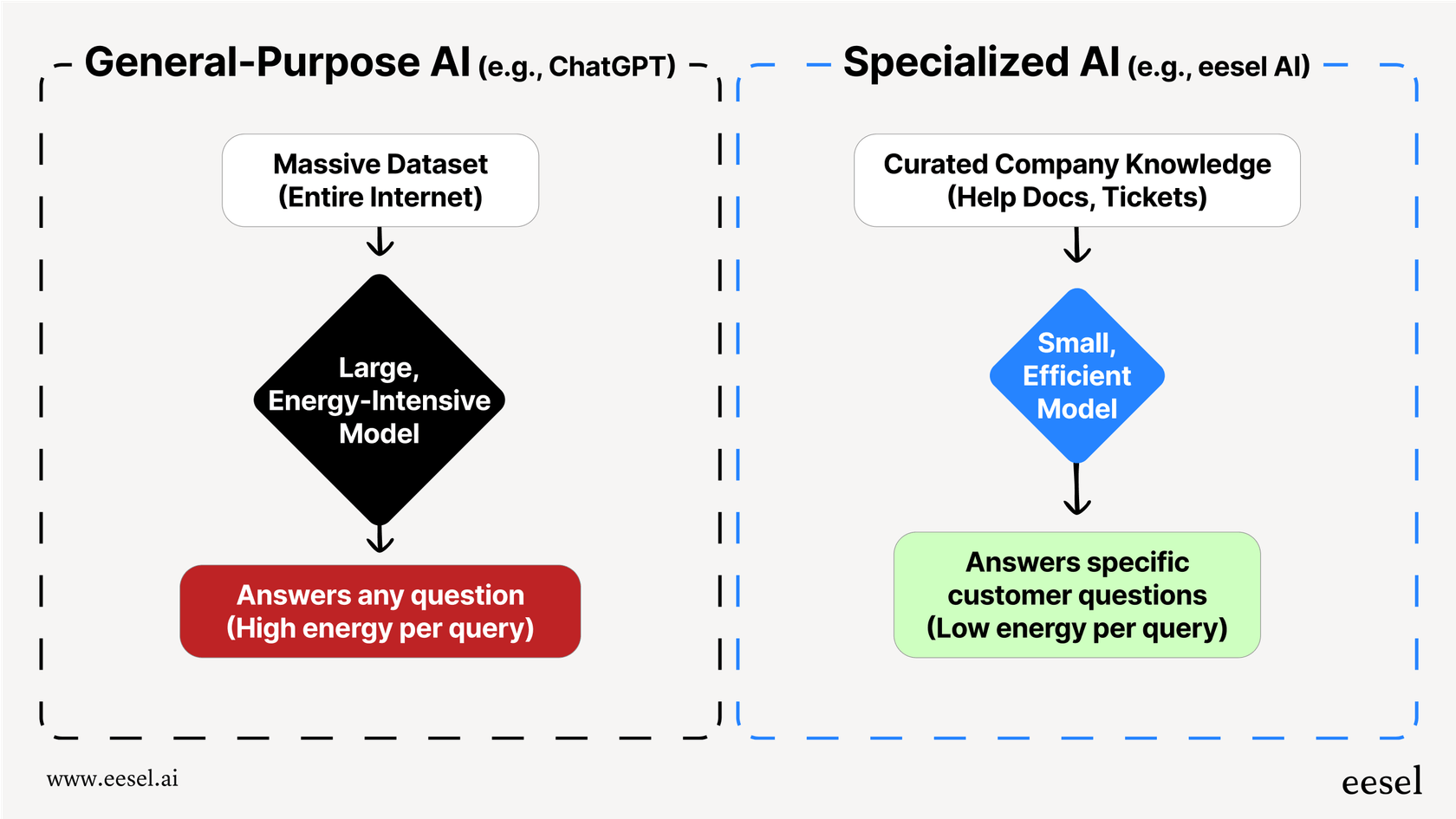

問題は、ChatGPTのようなモデルがシェイクスピアのソネットから量子物理学まで、すべてについて少し知っているように設計されていることです。それを実現するためには、非常に巨大である必要があり、それが非常にエネルギー集約的になります。しかし、顧客の配送ポリシーについての質問に答えるだけなら、巨大な汎用AIを使うのは完全に過剰です。スーパーコンピュータを使って基本的な計算をするようなもので、効率的ではありません。

これを行うためのはるかに賢い方法があります。それは、小さく、専門的なAIモデルを使用することです。これらは、必要なデータだけでトレーニングされます。このアプローチは、設計上、はるかに効率的です。会社のヘルプ記事、過去のサポートチケット、製品ドキュメントの厳選されたセットでAIをトレーニングすることは、インターネット全体でトレーニングするのに必要なエネルギーのごく一部です。

その結果は、より持続可能なAIだけでなく、より優れたAIです。専門的なAIは、公共のウェブサイトからの無関係な情報に気を取られることなく、より正確で一貫性があり、ブランドにぴったりの回答を提供します。

これが、eesel AIで行っていることの全体的な考え方です。既存のシステムを取り除いて、単一の電力を大量に消費するAIに置き換えるのではなく、eeselは直接あなたのヘルプデスクや知識源に接続します。それは、Zendesk、Confluence、Google Docsなど、すでに使用しているツールのコンテンツから学び、効率的で正確なAIサポートエージェントを作成します。これにより、汎用モデルの大規模なエネルギー消費と運用上の頭痛を回避しながら、顧客により良く、より関連性のある回答を提供できます。

あなたのAI戦略とChatGPTのエネルギー使用の影響

大規模なAIモデルのエネルギー消費は、もはや研究者だけの話題ではなく、現実のビジネス問題です。新しい世代ごとに、GPT-5のようなモデルは指数関数的に電力を消費するようになり、その真のコストは秘密の壁の背後に隠されており、電力だけではありません。

ほとんどのビジネスニーズ、特にカスタマーサービスや内部サポートにおいて、巨大な汎用AIを使用することは最も効果的でも責任ある選択でもありません。それは非効率的で高価であり、特定のユースケースに対してはしばしば正確性に欠けます。

専門的で統合されたアプローチは、はるかに持続可能で、コスト効果が高く、正確な代替手段です。AIを自社の知識でトレーニングすることで、強力で効率的なシステムを構築できます。

大規模なエネルギー請求書なしで強力で効率的なAIサポートシステムを構築する準備ができたら、eesel AIが既存のツールとどのように連携して正確でブランドに合った回答を提供するかをご覧ください。無料トライアルを開始するか、デモを予約してください。

よくある質問

高いエネルギー需要は非効率性を示しています。特定のビジネスタスクに対して巨大な汎用モデルを使用することは、単純な計算にスーパーコンピュータを使うようなもので、過剰であり、しばしば特定のニーズに対しては精度が低く、遅い結果をもたらします。

それは電気だけではありません。全体的な環境負荷には、データセンターの冷却のための大量の水消費、特殊なハードウェアの製造に必要な資源、そして古い技術が急速に置き換えられることによる電子廃棄物問題が含まれます。

はい、その増加は顕著です。新しいモデルは、以前のバージョンのほぼ10倍の電力を使用するクエリもあり、指数関数的に電力を消費する可能性があると推定されています。この「大きいほど良い」というトレンドは持続可能ではありません。

主要なAI企業は、リソース消費を企業秘密のように扱い、非常に秘密主義です。この透明性の欠如は、企業や消費者が使用するツールの真の環境的および財政的コストを理解するのを難しくしています。

もちろんです。特化したモデルは、関連する会社のデータのみでトレーニングされるため、必要なエネルギーはごくわずかです。これにより、持続可能であるだけでなく、特定のユースケースに対してより正確で関連性の高い回答を提供する、はるかに効率的なシステムが実現します。

トレーニングは非常にエネルギー集約的ですが、日々のクエリ(推論)の膨大な量は、モデルの寿命を通じて初期のトレーニングコストを容易に上回ることがあります。何十億もの日々のユーザーを持つツールにとって、推論に費やされる累積的なエネルギーが支配的な要因となります。

この記事を共有

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.