Poser des questions à un chatbot en les tapant au clavier est devenu tout à fait normal, n'est-ce pas ? Mais la prochaine grande avancée de l'IA ne se fera pas par écrit, mais par la parole. Nous sommes sur le point d'avoir une IA vocale conversationnelle en temps réel, capable de nous comprendre, de nous interrompre si nécessaire et de répondre exactement comme le ferait un autre être humain. C'est une évolution qui promet une manière bien plus naturelle d'interagir avec la technologie.

Cette évolution est rendue possible par des outils comme l'API Realtime d'OpenAI, qui fournit aux développeurs les briques de base pour créer ces expériences fluides et axées sur la voix. Mais voilà le hic : si la technologie elle-même est incroyable, la transformer en un outil professionnel abouti et prêt à l'emploi est une tout autre histoire. C'est un parcours qui exige généralement de solides connaissances techniques, de nombreuses heures de développement et une bonne dose de patience.

Alors, levons le voile sur l'API Realtime d'OpenAI, découvrons ce qu'elle peut faire et parlons franchement de ce que représente le développement avec cet outil.

Qu'est-ce que l'API Realtime d'OpenAI ?

Fondamentalement, l'API Realtime d'OpenAI est un outil qui permet aux développeurs de créer des applications offrant des conversations de parole à parole à faible latence. Si vous avez déjà utilisé le mode vocal avancé de ChatGPT, c'est le moteur qui rend ce type d'interaction possible, mais il est désormais accessible à tous.

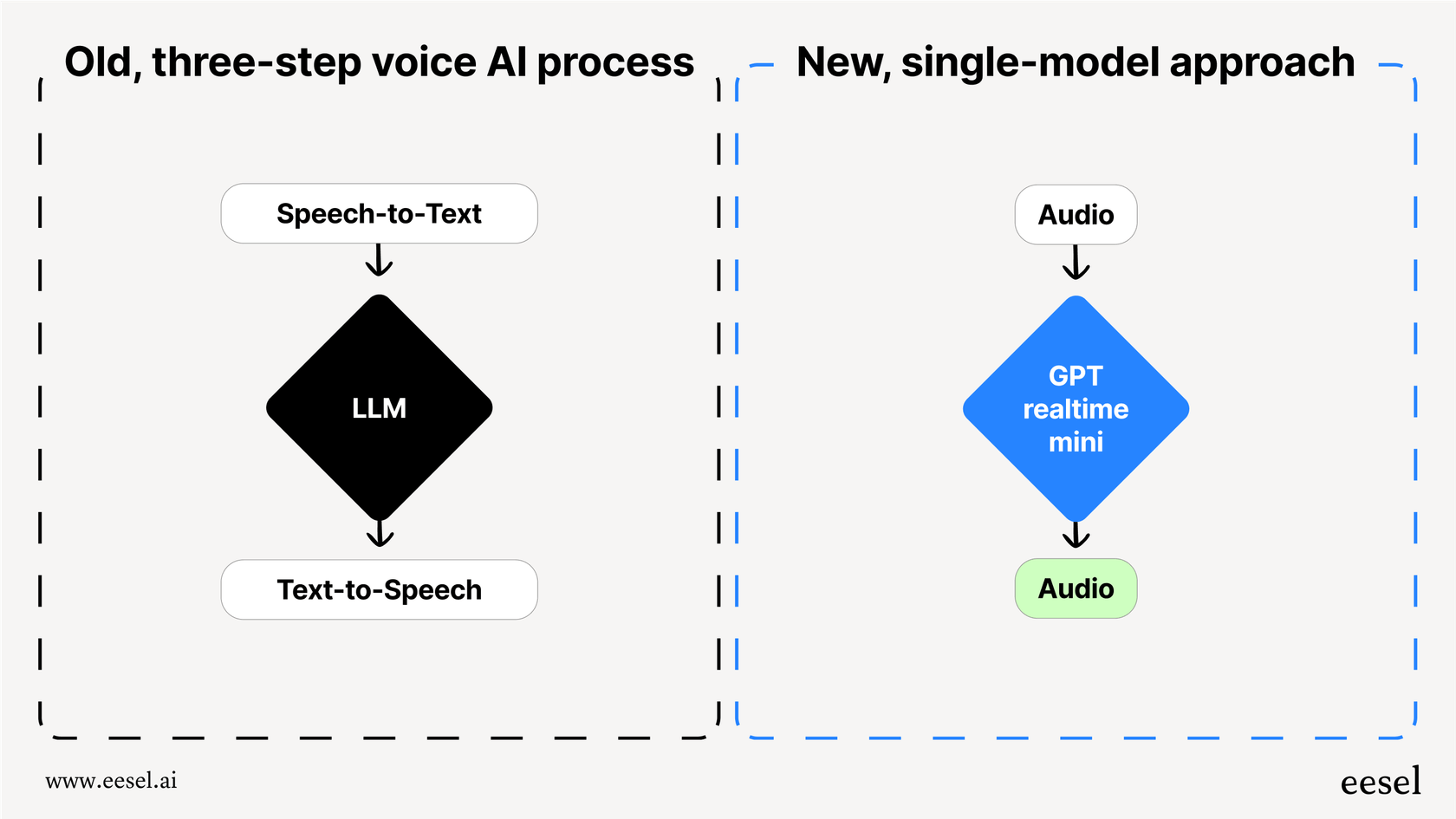

Avant l'arrivée de cette API, créer un agent vocal était un véritable casse-tête, un processus lourd en plusieurs étapes. Il fallait enchaîner plusieurs API différentes :

-

Parole-Texte (STT) : D'abord, on utilisait une API comme Whisper pour convertir les paroles de l'utilisateur en texte.

-

Grand modèle de langage (LLM) : Ensuite, on envoyait ce texte à une API comme GPT-4 pour déterminer la réponse à formuler.

-

Texte-Parole (TTS) : Enfin, on utilisait une autre API pour reconvertir la réponse textuelle en audio.

Cet enchaînement fonctionnait, mais il était lent. Chaque transition ajoutait un petit délai, créant une latence gênante qui rendait les conversations rigides et peu naturelles. Plus important encore, cela supprimait toute la nuance du langage humain. Des éléments comme le ton, l'émotion et l'intonation étaient perdus dès que l'audio devenait du texte, ne laissant qu'une interaction plate et robotique.

L'API Realtime change complètement la donne en utilisant un modèle unique et unifié (comme « gpt-realtime ») qui gère l'audio du début à la [REDACTED]. Elle écoute l'audio et génère une réponse audio directement. Cela réduit considérablement la latence et préserve la richesse de la parole, ouvrant la voie à une IA plus rapide, plus expressive et véritablement conversationnelle.

Comment fonctionne l'API Realtime d'OpenAI

L'API ne se limite pas à la voix ; elle est conçue pour une communication multimodale à faible latence. C'est une manière élégante de dire qu'elle peut jongler avec différents types d'informations simultanément, ce qui rend les agents que vous créez bien plus intelligents et conscients de leur environnement.

Capacités multimodales de l'API Realtime d'OpenAI

L'API Realtime s'appuie sur des modèles comme GPT-4o, qui sont « nativement multimodaux ». Voyez les choses ainsi : l'IA n'a pas seulement appris à lire du texte. Elle a été entraînée dès le départ à comprendre et à traiter un mélange d'audio, d'images et de texte simultanément. Cela permet des interactions bien plus dynamiques que ce qu'un simple agent vocal pourrait jamais gérer.

Méthodes de connexion

Pour atteindre cette vitesse en temps réel, il faut maintenir une connexion constante et ouverte avec l'API. OpenAI propose quelques méthodes de connexion, et le bon choix dépend vraiment de ce que vous construisez et de la stack technique de votre équipe.

| Méthode de connexion | Cas d'usage idéal | Charge technique |

|---|---|---|

| WebRTC | Applications navigateur et côté client nécessitant la latence la plus faible possible. | Élevée (Implique la gestion des connexions pair-à-pair et des offres/réponses SDP). |

| WebSocket | Applications côté serveur où une faible latence reste une priorité. | Moyenne (Plus simple que WebRTC mais nécessite tout de même la gestion d'une connexion persistante). |

| SIP | Intégration avec des systèmes de téléphonie VoIP (comme dans un centre d'appels). | Élevée (Nécessite une connaissance des protocoles et de l'infrastructure de téléphonie). |

Le simple fait de choisir et de configurer la bonne méthode de connexion n'est pas une mince affaire. Cela demande une bonne dose de planification technique et d'efforts de développement, et c'est souvent l'un des premiers obstacles que les équipes rencontrent en essayant de créer un agent vocal personnalisé.

Fonctionnalités clés de l'API Realtime d'OpenAI

Au-delà de sa conception fondamentale, l'API Realtime inclut un ensemble de fonctionnalités qui en font une boîte à outils puissante pour les développeurs. Ce sont les éléments que vous utiliserez pour créer des agents vocaux intelligents et dynamiques.

Interaction de parole à parole

C'est l'attraction principale. Comme un modèle tel que « gpt-realtime » travaille directement avec l'audio, il peut capter des indices subtils que les systèmes basés sur le texte manquent toujours, comme le rire, le sarcasme ou les changements d'émotion. Il peut alors générer une réponse qui semble beaucoup plus naturelle et expressive. Avec la sortie générale de l'API, OpenAI a même ajouté deux nouvelles voix, Marin et Cedar, qui sont disponibles exclusivement ici et semblent incroyablement réalistes.

Détection d'activité vocale (VAD)

La détection d'activité vocale est ce qui fait qu'une conversation avec une IA ressemble moins à une transaction et plus à une véritable discussion. C'est la fonctionnalité qui permet à l'IA de savoir quand quelqu'un a commencé ou arrêté de parler. C'est absolument essentiel pour un tour de parole naturel. Si un utilisateur veut intervenir et changer de sujet, il lui suffit de commencer à parler. L'agent le reconnaîtra et s'adaptera au lieu de continuer sur sa lancée ou d'attendre une pause gênante.

Appels de fonction et outils

Un agent vocal n'est utile que s'il peut réellement faire des choses. L'API Realtime prend en charge les appels de fonction, ce qui permet à l'agent de se connecter à des outils externes et des sources de données pour récupérer des informations ou accomplir des tâches. Par exemple, un agent de support pourrait utiliser une fonction pour rechercher le statut de la commande d'un client dans votre système ou traiter un remboursement sur-le-champ. Bien que cela soit incroyablement puissant, c'est à vous, le développeur, de construire, connecter et maintenir chacune de ces intégrations d'outils.

Entrées d'images et de texte

Comme l'API est multimodale, les utilisateurs ne sont pas limités à leur seule voix. Ils peuvent ajouter d'autres informations à la conversation. Un client pourrait être en appel avec un agent de support, envoyer une capture d'écran d'un message d'erreur et demander : « Qu'est-ce que je suis en train de regarder ? ». L'agent peut voir l'image, comprendre le contexte et donner une réponse vocale utile.

Cas d'usage courants et limites de l'API Realtime d'OpenAI

Le potentiel de l'IA vocale à faible latence est immense, mais quelques cas d'usage sont rapidement devenus les plus populaires. Il est également important d'être réaliste quant aux obstacles que vous rencontrerez en construisant ces applications de A à Z.

Cas d'usage

-

Agents de support client : Répondre aux appels entrants, traiter les questions courantes et acheminer les problèmes plus complexes vers le bon agent humain.

-

Assistants personnels : Aider à la planification, définir des rappels et obtenir des informations en mode mains libres.

-

Applications d'apprentissage des langues : Créer des partenaires de conversation réalistes pour aider les utilisateurs à s'entraîner à parler une nouvelle langue.

-

Outils pédagogiques : Concevoir des tuteurs interactifs capables d'expliquer verbalement des sujets complexes et de répondre aux questions des étudiants.

Limites de l'approche « fait maison » (DIY)

Construire un agent vocal avec l'API brute peut sembler passionnant, mais c'est un projet d'ingénierie colossal qui va bien au-delà d'un simple appel à un point de terminaison.

-

L'effort de développement est énorme : Vous ne vous contentez pas de brancher une API ; vous construisez une application entière. Cela signifie gérer l'infrastructure, l'état de la conversation, concevoir la logique et s'assurer que l'ensemble du système est fiable et évolutif.

-

Aucun workflow métier inclus : L'API vous donne le moteur, mais c'est à vous de construire la voiture. Toute la logique métier spécifique pour trier les tickets, les escalader à la bonne équipe, suivre les interactions et générer des rapports sur les performances doit être construite de zéro.

-

Pas d'outils d'analyse ou de test intégrés : Comment savoir si votre agent est vraiment efficace ? Sans outils dédiés, il n'y a aucun moyen simple de tester votre agent sur des conversations passées, de mesurer sa précision ou de déterminer où votre base de connaissances est défaillante.

C'est là qu'intervient le débat classique « construire ou acheter ». Pour les équipes qui ont besoin d'une solution de support IA prête pour la production sans attendre des mois de développement, une plateforme comme eesel AI offre une voie beaucoup plus directe. Elle fournit un moteur de workflow sans code, des intégrations en un clic avec les services d'assistance et de puissants outils de simulation, vous permettant d'être opérationnel en quelques minutes, pas en quelques mois.

Tarifs de l'API Realtime d'OpenAI

L'API est tarifée en fonction des jetons audio, qui sont calculés différemment des jetons de texte. Vous êtes facturé à la fois pour l'audio que vous envoyez au modèle (entrée) et pour l'audio que le modèle vous renvoie (sortie). Il peut donc être difficile de prévoir les coûts, car ils dépendent de la durée et de la complexité de chaque conversation.

Voici un aperçu rapide des tarifs du modèle « gpt-realtime » (niveau standard), qui est 20 % moins cher que la version préliminaire :

| Type de jeton | Prix par million de jetons |

|---|---|

| Entrée audio | 32,00 $ |

| Entrée audio en cache | 0,40 $ |

| Sortie audio | 64,00 $ |

(Informations tarifaires basées sur la page des tarifs d'OpenAI.)

Si la tarification par jeton est flexible pour les développeurs qui ne font que des expériences, elle peut générer des factures imprévisibles pour les entreprises ayant des canaux de support à fort volume. Un mois chargé pourrait se traduire par une facture étonnamment élevée, ce qui complique la budgétisation efficace.

L'alternative plus simple à l'API Realtime d'OpenAI : les agents de support IA avec eesel AI

Développer directement avec l'API Realtime d'OpenAI est une option fantastique pour les développeurs qui créent de toutes nouvelles applications à partir de zéro. Cependant, pour les entreprises qui cherchent à automatiser le support client, à améliorer leur gestion des services informatiques ou à alimenter un service de questions-réponses interne, une plateforme dédiée est presque toujours le choix le plus rapide, le plus rentable et le plus puissant dès le départ.

eesel AI est une plateforme complète de support IA qui exploite la puissance de modèles avancés comme ceux qui sous-tendent l'API Realtime, mais elle vous évite d'avoir à écrire la moindre ligne de code pour les intégrations ou la gestion des workflows.

Voici comment elle répond aux défis de l'approche « fait maison » :

-

Soyez opérationnel en quelques minutes : Au lieu de passer des mois à vous battre avec les WebSockets et l'infrastructure, vous pouvez connecter votre service d'assistance (comme Zendesk, Freshdesk ou [REDACTED]) et vos sources de connaissances en un seul clic. Votre agent IA peut commencer à apprendre immédiatement à partir de vos anciens tickets, des articles de votre centre d'aide et de vos documents internes.

-

Testez en toute confiance : Le mode de simulation d'eesel AI vous permet de tester votre agent sur des milliers de vos tickets historiques réels dans un environnement sécurisé. Vous pouvez voir comment il aurait répondu, ajuster son comportement et obtenir des prévisions précises sur les taux de résolution et les économies de coûts avant même qu'il n'interagisse avec un client réel.

-

Contrôle total et personnalisation : Avec un simple éditeur de prompt et un moteur de workflow sans code, vous décidez exactement quels tickets votre IA traite et quelles actions elle peut entreprendre. Vous pouvez configurer des règles pour escalader les problèmes complexes, étiqueter automatiquement les tickets ou même appeler des API externes pour obtenir des informations de commande.

-

Tarification prévisible : Les forfaits d'eesel AI sont basés sur un nombre fixe d'interactions IA mensuelles, sans frais de résolution surprise. Votre budget est ainsi simple et transparent, ce qui élimine les incertitudes liées à un modèle variable basé sur les jetons.

Dernières réflexions sur l'API Realtime d'OpenAI

L'API Realtime d'OpenAI est une technologie véritablement impressionnante. Elle comble le fossé entre la façon dont les humains et les machines communiquent, ouvrant la voie à un avenir où l'IA vocale semblera totalement naturelle. Elle offre aux développeurs un moteur incroyablement puissant pour créer des choses extraordinaires.

Cependant, le chemin entre une clé API et un outil professionnel fiable et prêt pour la production est long et semé d'embûches techniques. Pour la plupart des entreprises, en particulier celles axées sur le service client et le support informatique, une plateforme conçue pour cet usage spécifique apporte de la valeur plus rapidement et de manière plus fiable. Vous bénéficiez de toute la puissance de l'IA sous-jacente, mais dans une suite d'outils conçus pour la tâche précise que vous devez accomplir.

Prêt à voir ce qu'un agent de support IA spécialisé peut faire pour vous ? Commencez votre essai gratuit avec eesel AI et automatisez votre support de première ligne en quelques minutes.

Foire aux questions

L'API Realtime d'OpenAI est conçue pour permettre aux développeurs de créer des applications qui prennent en charge des conversations de parole à parole à faible latence. Elle utilise un modèle unique et unifié pour traiter l'audio directement, permettant des expériences vocales fluides et naturelles.

Contrairement aux approches précédentes en plusieurs étapes, l'API Realtime d'OpenAI gère l'audio du début à la [REDACTED], ce qui réduit considérablement la latence et préserve les indices subtils comme le ton et l'émotion. Ce traitement unifié conduit à des interactions IA beaucoup plus naturelles et expressives.

Pour garantir une vitesse en temps réel, l'API Realtime d'OpenAI prend en charge plusieurs méthodes de connexion. Celles-ci incluent WebRTC pour les applications basées sur un navigateur, les WebSockets pour une utilisation côté serveur et SIP pour l'intégration avec les systèmes de téléphonie VoIP.

Oui, l'API Realtime d'OpenAI prend en charge les appels de fonction, ce qui permet à l'agent IA de se connecter à des outils et sources de données externes. Les développeurs sont responsables de la création, de la connexion et de la maintenance de ces intégrations pour permettre des tâches spécifiques ou la récupération d'informations.

La tarification de l'API Realtime d'OpenAI est basée sur les jetons audio pour l'entrée et la sortie, ce qui peut rendre la prévision des coûts difficile. Pour les entreprises à fort volume d'utilisation, ce modèle basé sur les jetons peut entraîner des factures mensuelles variables et potentiellement élevées.

L'API Realtime d'OpenAI fonctionne sur des modèles nativement multimodaux comme GPT-4o, ce qui lui permet de traiter un mélange d'audio, d'images et de texte. Cela signifie que les utilisateurs peuvent fournir un contexte visuel, comme une capture d'écran, en plus de leurs questions orales pour des interactions plus riches et plus complètes.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.