Nous savons tous que les grands modèles de langage (LLM) ont la tchatche. Ils peuvent rédiger des e-mails à la chaîne, répondre à des questions de culture générale et même composer un sonnet sur commande. Mais qu'en est-il de leur capacité à faire des choses concrètes ? Comment les amener à cesser de simplement parler pour commencer à interagir avec le monde réel, comme rechercher une commande, mettre à jour un ticket d'assistance ou interroger une base de données ?

C'est le rôle de la fonctionnalité OpenAI Function Calling (qu'ils ont maintenant officiellement rebaptisée « Outils »). C'est la pièce du puzzle qui relie les compétences conversationnelles d'une IA à des actions concrètes. C'est ce qui transforme un simple bot de questions-réponses en un agent capable de travailler réellement avec vos logiciels d'entreprise.

Dans ce guide, nous allons voir ce qu'est l'appel de fonction, comment il fonctionne, et certaines des complexités cachées que vous rencontrerez si vous essayez de l'utiliser à partir de zéro. Plus important encore, nous verrons comment les plateformes modernes peuvent prendre en charge le gros du travail, vous permettant de créer de puissants agents IA sans avoir besoin d'une équipe d'ingénieurs dédiée en permanence.

Qu'est-ce que l'OpenAI Function Calling ?

En termes simples, l'OpenAI Function Calling est une fonctionnalité qui vous permet d'informer un LLM des outils dont vous disposez. Vous décrivez vos fonctions au modèle, et il peut alors analyser la demande d'un utilisateur et demander à en utiliser une. Pour ce faire, il génère un objet JSON bien propre avec tous les détails dont votre application a besoin pour exécuter la fonction.

Une erreur fréquente est de penser que le modèle exécute le code lui-même. Ce n'est pas le cas. Il se contente de dire à votre application quel code elle doit exécuter et quelles informations utiliser.

Imaginez le LLM comme un assistant très intelligent qui connaît votre boîte à outils sur le bout des doigts. Lorsqu'une tâche se présente, il ne peut pas utiliser les outils lui-même, mais il peut vous tendre le bon (le nom de la fonction) et vous dire exactement comment l'utiliser (les arguments). C'est votre application qui se met réellement les mains dans le cambouis et fait le travail.

Bien qu'OpenAI ait récemment commencé à appeler cette fonctionnalité « Outils » pour mieux décrire ses capacités, la plupart des gens utilisent encore le terme « appel de fonction » pour décrire le concept.

Comment fonctionne le flux de l'OpenAI Function Calling ?

Faire en sorte qu'une IA utilise un outil ne se résume pas à un seul appel d'API ; c'est plutôt une conversation en va-et-vient entre votre application et le modèle. C'est une petite danse qui suit un schéma assez prévisible.

Voici un aperçu étape par étape de son déroulement :

-

Vous présentez vos outils au modèle. D'abord, vous donnez au modèle une liste des fonctions qu'il peut utiliser. Cela inclut le nom de la fonction, une description claire de ce qu'elle fait, et les paramètres spécifiques dont elle a besoin pour fonctionner (le tout présenté dans un format appelé schéma JSON). La qualité de votre description est essentielle, c'est ainsi que le modèle détermine quand suggérer un outil.

-

L'utilisateur demande quelque chose. Un utilisateur tape une requête en langage naturel, comme : « Quel est le statut de ma commande n°12345 ? »

-

Le modèle choisit un outil. Le modèle lit la requête. S'il détecte une correspondance avec l'une de vos descriptions de fonction, il répond avec un message spécial demandant à votre application d'appeler cette fonction. Il fournit également les arguments qu'il a extraits de la demande de l'utilisateur (par exemple,

{"function": "get_order_status", "arguments": {"order_id": "12345"}}). -

Votre application fait le travail. Votre code récupère cette réponse structurée et exécute la fonction réelle

get_order_status. Il peut se connecter à votre base de données ou à une API externe pour obtenir l'information, qui dans ce cas est « Expédiée ». -

Vous renvoyez le résultat au modèle. Enfin, vous faites un dernier appel d'API au modèle, cette fois en incluant le résultat de la fonction dans l'historique de la conversation. Le modèle dispose maintenant de la dernière pièce du puzzle et peut donner à l'utilisateur une réponse conviviale et naturelle, comme : « Votre commande n°12345 a été expédiée. »

Ce petit aller-retour permet à l'IA de combiner ses compétences conversationnelles avec des données et des actions en temps réel, ce qui la rend beaucoup plus utile.

Cas d'usage courants de l'OpenAI Function Calling

L'appel de fonction est ce qui fait passer un chatbot du statut de simple gadget à celui d'un agent puissant capable de gérer de véritables flux de travail métier. Voici quelques-unes des manières les plus courantes dont les gens l'utilisent.

Se connecter à vos données en temps réel

C'est le cas d'usage le plus simple. Il permet à une IA d'accéder à des informations en temps réel, privées ou dynamiques qui ne figuraient pas dans ses données d'entraînement initiales. Une IA peut devenir une experte de vos opérations commerciales spécifiques quasi instantanément.

Par exemple, une IA de support client pourrait rechercher le statut d'une commande dans une base de données Shopify, vérifier la disponibilité d'un vol via l'API d'une compagnie aérienne, ou extraire les détails d'un compte de votre CRM interne.

Effectuer des tâches dans d'autres applications

Au-delà de la simple récupération d'informations, l'appel de fonction permet à une IA de déclencher des flux de travail et d'apporter des modifications dans d'autres systèmes. Elle peut devenir un participant actif de vos processus métier.

Par exemple, un bot de support informatique pourrait recevoir une demande et créer automatiquement un nouveau ticket dans Jira Service Management. Ou, un assistant commercial pourrait prendre les détails d'une conversation et ajouter un nouveau prospect à votre CRM sans que personne n'ait à effectuer de saisie manuelle de données.

Transformer du texte brut en données structurées

Parfois, l'objectif n'est pas de répondre à une question, mais d'extraire et de formater des informations de manière fiable. L'appel de fonction est excellent pour cela car vous pouvez définir les paramètres d'une fonction comme un modèle auquel vous voulez que les données se conforment.

Un exemple parfait est le traitement d'un e-mail de support entrant. L'IA peut lire un long texte, en extraire le nom de l'utilisateur, l'entreprise, le type de problème et le niveau d'urgence, puis formater le tout en un objet JSON parfait. Cet objet peut ensuite être utilisé pour créer un nouveau ticket, parfaitement catégorisé, dans votre service d'assistance.

Les défis cachés de la création avec l'OpenAI Function Calling

Passer d'une démo sympa à une application prête pour la production qui utilise l'appel de fonction est un grand pas. Créer directement avec l'API est puissant, mais cela s'accompagne de sérieux casse-têtes techniques que de nombreuses équipes n'anticipent pas.

Défis d'orchestration

Que se passe-t-il lorsqu'une tâche nécessite plusieurs étapes ? Pour trouver la commande d'un client, vous pourriez d'abord avoir besoin de trouver son identifiant client en utilisant son e-mail, puis utiliser cet identifiant pour rechercher ses commandes. Le modèle ne gère pas ce genre de logique multi-étapes par lui-même. Vous devez créer et maintenir une « machine à états » dans votre propre code pour gérer la séquence.

Fiabilité et gestion des erreurs

Les modèles ne se comportent pas toujours comme vous l'attendez. Ils peuvent parfois « halluciner » des arguments qui n'existent pas, appeler la mauvaise fonction, ou simplement ne pas en appeler une alors que c'est manifestement nécessaire. Cela signifie que votre équipe doit écrire une tonne de logique de validation, de vérification des erreurs et de tentatives pour rendre le système fiable.

Certains développeurs en viennent même à pratiquement crier sur le modèle dans leurs messages système, en écrivant des choses comme « NE PAS SUPPOSER DE VALEURS POUR LES PARAMÈTRES » en majuscules, juste pour qu'il se comporte correctement. Ce n'est guère une manière évolutive de construire un système de production.

Enchaînement de fonctions : un point faible connu

Même avec les meilleures instructions, les modèles ont souvent du mal à planifier et à exécuter une tâche qui nécessite plusieurs appels de fonction différents dans un ordre spécifique. Ils sont assez bons pour choisir le meilleur outil suivant pour une seule étape, mais peuvent se perdre dans un flux de travail plus complexe. Encore une fois, cela signifie que vous devez écrire du code personnalisé, souvent compliqué, pour gérer le flux et guider le modèle d'une étape à l'autre.

Le développement et la maintenance peuvent être un vrai fardeau

Définir des schémas de fonction en JSON est un travail fastidieux et il est facile de faire une erreur de syntaxe. Chaque fois que vous voulez ajouter un nouvel outil ou en mettre un à jour, vous devez replonger dans le code. Garder ce code synchronisé avec vos outils réels, gérer différentes versions et simplement suivre les changements fréquents de l'API d'OpenAI devient une perte de temps constante pour les ingénieurs.

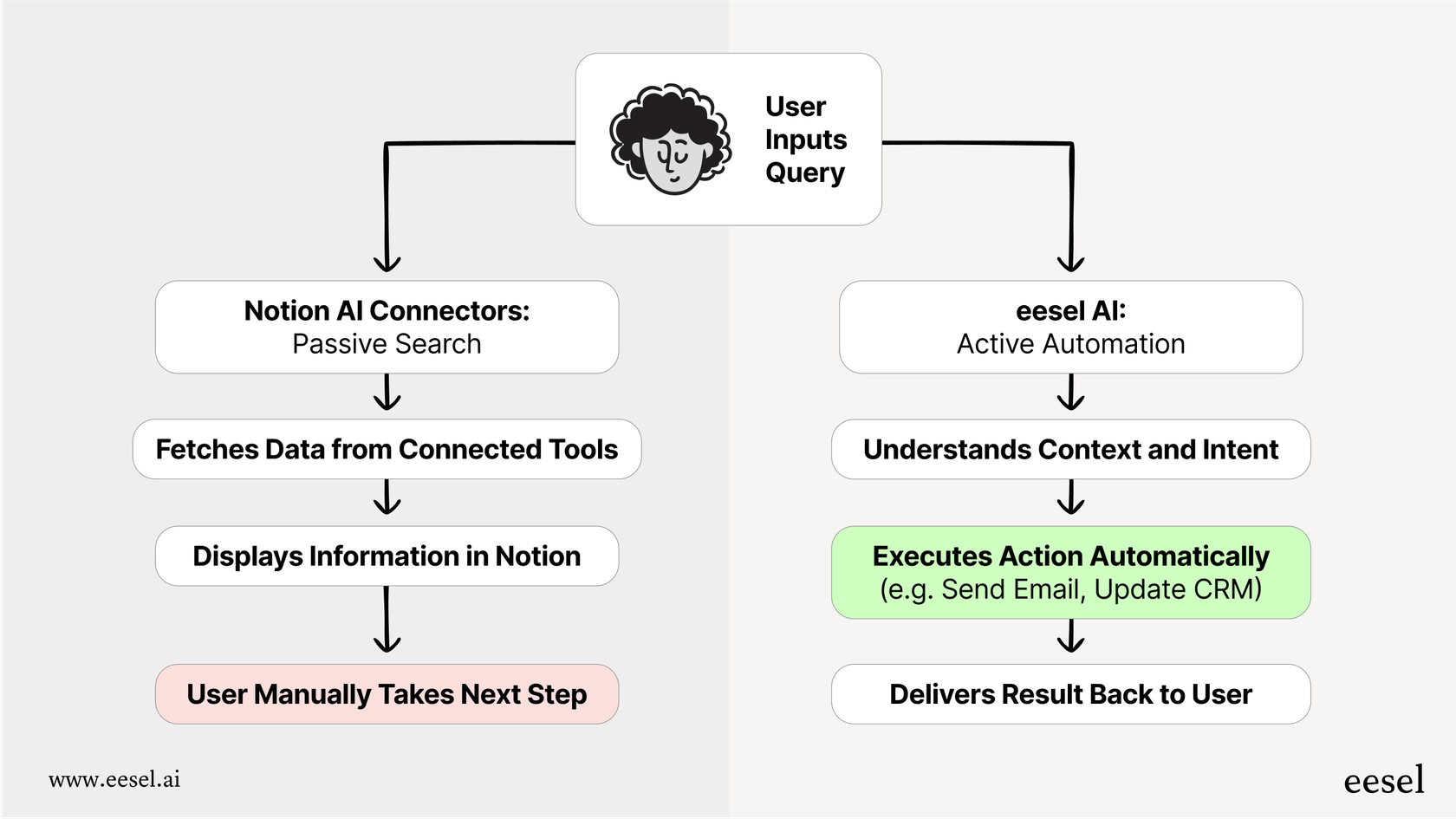

Une manière plus simple de créer des agents IA

L'approche « fait maison » de l'appel de fonction est puissante, mais elle n'est pas pratique pour la plupart des équipes de support et d'informatique qui ont besoin de solutions fiables sans une équipe d'ingénieurs dédiée. C'est là que des plateformes comme eesel AI peuvent faire une énorme différence. eesel AI gère tout le travail complexe en coulisses de l'appel de fonction via une interface intuitive, transformant un défi de codage difficile en un simple flux de travail.

Du code complexe à un moteur de workflow no-code

Au lieu d'écrire des scripts Python et des machines à états pour gérer les appels de fonction, eesel AI vous offre un générateur de flux de travail visuel. Vous pouvez configurer des règles, des chemins d'escalade et des séquences d'actions sans écrire une seule ligne de code. Cela vous donne un contrôle total sur le comportement de votre IA, vous permettant de concevoir des flux de travail sophistiqués qui s'exécutent de manière fiable à chaque fois. Vous décidez exactement quels tickets l'IA doit traiter et ce qu'elle doit faire, étape par étape.

Actions préconfigurées et connexions personnalisées faciles

eesel AI est livré avec une bibliothèque d'actions prêtes à l'emploi pour les services d'assistance populaires comme Zendesk et Freshdesk. Les tâches courantes comme « étiqueter le ticket », « ajouter une note interne » ou « fermer le ticket » sont à portée de clic.

Besoin de vous connecter à un outil personnalisé ou à une API interne ? eesel AI simplifie également cela. Vous pouvez facilement configurer des actions personnalisées pour rechercher des informations ou déclencher des flux de travail dans n'importe quel système externe, en s'occupant pour vous de toute la création fastidieuse de schémas JSON. C'est ainsi que les équipes peuvent être opérationnelles en quelques minutes, pas en quelques mois.

Testez votre implémentation en toute confiance avant le lancement

L'une des plus grandes inquiétudes avec l'approche « fait maison » est l'incertitude. L'agent fonctionnera-t-il réellement comme prévu sur de vrais problèmes clients ? eesel AI résout ce problème avec son mode de simulation. Au lieu de déployer du code et de croiser les doigts, vous pouvez exécuter votre agent IA sur des milliers de vos anciens tickets dans un environnement sécurisé. Vous pouvez voir exactement comment il aurait répondu, quelles actions il aurait entreprises et quel serait votre taux d'automatisation. Cela vous permet de tout peaufiner et de tester en toute confiance avant qu'il n'interagisse avec un client réel.

Allez au-delà de la conversation et passez à l'action

L'OpenAI Function Calling est le moteur qui permet à l'IA d'effectuer un travail réel, mais l'API brute n'est en réalité qu'une boîte de pièces détachées. Construire un agent IA fiable et de qualité production à partir de zéro vous offre une flexibilité ultime, mais cela coûte cher en termes de complexité, de manque de fiabilité et de maintenance continue.

Des plateformes comme eesel AI offrent toute la puissance de l'appel de fonction sans les maux de tête techniques. Elles donnent aux équipes la capacité de déployer des agents IA compétents et personnalisés qui sont étroitement intégrés à leurs outils métier, comblant enfin le fossé entre simplement parler et réellement faire.

Prêt à créer un agent IA qui passe vraiment à l'action ?

Si vous êtes prêt à créer un agent IA qui se connecte à vos outils et automatise votre support, inscrivez-vous gratuitement à eesel AI et lancez votre premier agent IA en quelques minutes. Aucune programmation requise.

Foire aux questions

L'OpenAI Function Calling (maintenant souvent appelé « Outils ») est une fonctionnalité qui vous permet de décrire vos fonctions disponibles à un LLM. Il résout le problème de connecter les capacités conversationnelles d'une IA à des actions du monde réel, lui permettant de demander à votre application d'effectuer des tâches comme la recherche de données ou la mise à jour de systèmes.

Non, le LLM n'exécute pas votre code. Il analyse simplement la requête d'un utilisateur et, le cas échéant, répond avec un objet JSON structuré indiquant quelle fonction votre application doit exécuter et quels arguments utiliser. Votre application exécute ensuite cette fonction.

Le processus implique que votre application décrive d'abord ses outils au modèle. Lorsqu'un utilisateur fait une demande, le modèle suggère une fonction et ses arguments. Votre application exécute alors cette fonction, et enfin, vous renvoyez le résultat au modèle afin qu'il puisse formuler une réponse en langage naturel à l'utilisateur.

Les entreprises l'utilisent couramment pour connecter les IA à des données en direct, comme la recherche du statut des commandes dans une base de données ou les détails d'un compte dans un CRM. Il est également utilisé pour déclencher des actions dans d'autres applications, comme créer un ticket Jira, ou pour extraire et formater des données spécifiques à partir d'un texte brut.

Les principaux défis incluent l'orchestration de flux de travail en plusieurs étapes, la garantie de la fiabilité avec une gestion robuste des erreurs, et la difficulté du modèle à enchaîner plusieurs fonctions. Il y a aussi des frais de développement et de maintenance importants en raison de la définition manuelle des schémas JSON et des modifications de l'API.

Des plateformes comme eesel AI fournissent des générateurs de flux de travail visuels et des actions préconfigurées, faisant abstraction du codage complexe, de l'orchestration et de la gestion des erreurs. Elles simplifient la définition d'outils personnalisés и offrent des modes de simulation pour tester les agents en toute confiance avant leur déploiement.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.